综合介绍

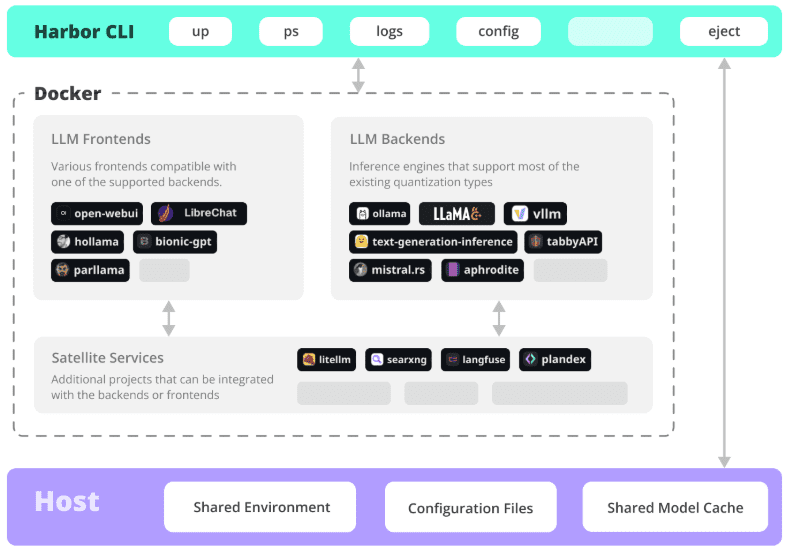

Harbor是一个革新性的容器化LLM工具集,专注于简化本地AI开发环境的部署和管理。它通过简洁的命令行界面(CLI)和配套应用程序,让开发者能够一键启动和管理包括LLM后端、API接口、前端界面在内的所有AI服务组件。作为一个开源项目,Harbor特别适合需要快速搭建和实验LLM应用的开发者。它不仅支持主流的AI模型和服务,还提供了灵活的配置选项和完整的工具链,让开发者能够专注于应用开发而不是环境配置。Harbor采用Apache 2.0开源协议,拥有活跃的社区支持,目前在GitHub上已获得超过770颗星标,受到众多开发者的认可和使用。

功能列表

- 一键部署:通过单一命令启动完整的LLM服务环境

- 容器管理:集成Docker和Docker Compose实现服务编排

- 多后端支持:兼容多种LLM引擎和模型格式(GGUF、SafeTensors等)

- 服务集成:预配置API服务和前端界面的协同工作

- 开发工具:提供完整的本地开发工具链

- 配置灵活:支持自定义服务组件和配置选项

- SSL证书:内置Certbot支持,轻松配置HTTPS访问

- 环境迁移:支持配置导出,便于迁移到生产环境

- 监控管理:提供服务状态监控和日志查看功能

- 版本控制:支持不同版本AI服务组件的管理

使用帮助

1. 环境准备

1.1 系统要求

- 操作系统:支持Linux、MacOS或Windows WSL2

- Docker Engine 20.10+

- Docker Compose 1.18.0+

- Node.js 16+ (可选,用于npm安装方式)

1.2 安装Harbor

# 方式1:使用npm安装

npm install -g @avlab/harbor

# 方式2:使用curl安装

curl -sfL https://get.harbor.ai | sh

2. 基础使用

2.1 启动服务

# 初始化Harbor环境

harbor init

# 启动所有服务

harbor up

# 查看服务状态

harbor ps

2.2 服务配置

# 配置模型路径

harbor config set models.path /path/to/models

# 启用特定服务

harbor enable chatui

harbor enable api

# 禁用服务

harbor disable service-name

3. 高级功能

3.1 SSL证书配置

# 设置环境变量

export NGINX_SSL_CERT_FILENAME=fullchain.pem

export NGINX_SSL_CERT_KEY_FILENAME=privkey.pem

export CERTBOT_DOMAIN=your_domain.com

export CERTBOT_EMAIL=your@email.com

# 获取证书

harbor ssl setup

3.2 自定义配置

# 导出配置

harbor eject

# 修改配置文件

vim harbor.yaml

# 使用自定义配置启动

harbor up -c custom-config.yaml

4. 常见操作流程

4.1 部署新服务

- 检查服务列表:

harbor list - 启用所需服务:

harbor enable <service-name> - 配置服务参数:

harbor config set <param> <value> - 启动服务:

harbor up - 验证服务状态:

harbor ps

4.2 问题排查

# 查看服务日志

harbor logs <service-name>

# 检查服务状态

harbor status

# 重启服务

harbor restart <service-name>

5. 最佳实践

- 定期备份配置文件

- 使用版本控制管理自定义配置

- 监控服务资源使用情况

- 及时更新Harbor和相关组件

- 使用项目预设加速部署流程

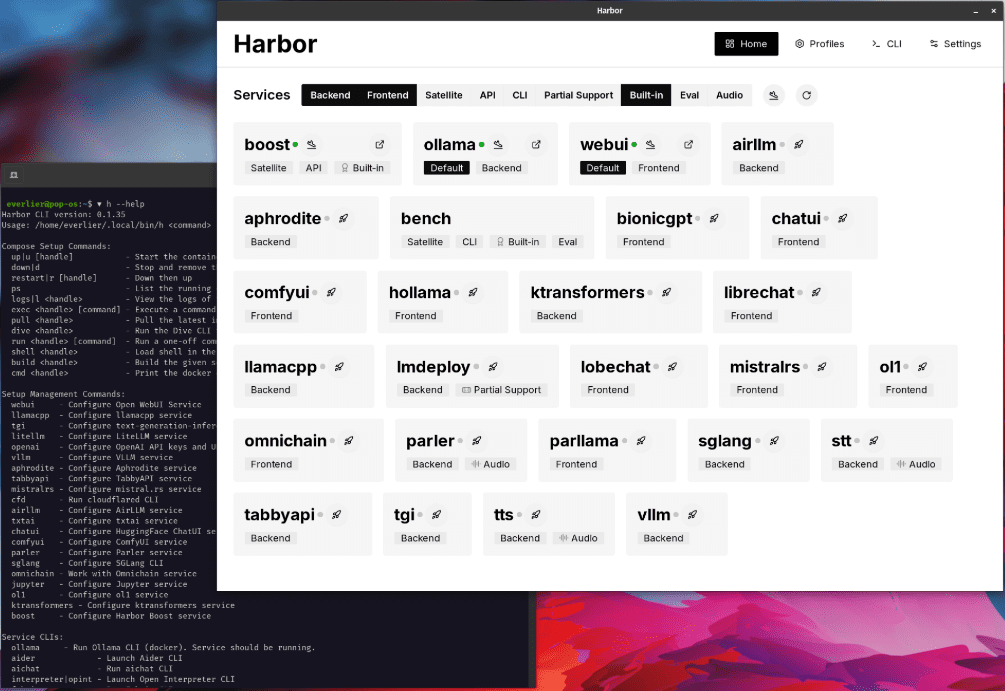

可安装的AI服务

用户界面

Open WebUI ⦁︎ ComfyUI ⦁︎ LibreChat ⦁︎ HuggingFace ChatUI ⦁︎ Lobe Chat ⦁︎ Hollama ⦁︎ parllama ⦁︎ BionicGPT ⦁︎ AnythingLLM ⦁︎ Chat Nio

后端服务

Ollama ⦁︎ llama.cpp ⦁︎ vLLM ⦁︎ TabbyAPI ⦁︎ Aphrodite Engine ⦁︎ mistral.rs ⦁︎ openedai-speech ⦁︎ faster-whisper-server ⦁︎ Parler ⦁︎ text-generation-inference ⦁︎ LMDeploy ⦁︎ AirLLM ⦁︎ SGLang ⦁︎ KTransformers ⦁︎ Nexa SDK

扩展工具

Harbor Bench ⦁︎ Harbor Boost ⦁︎ SearXNG ⦁︎ Perplexica ⦁︎ Dify ⦁︎ Plandex ⦁︎ LiteLLM ⦁︎ LangFuse ⦁︎ Open Interpreter ⦁ ︎cloudflared ⦁︎ cmdh ⦁︎ fabric ⦁︎ txtai RAG ⦁︎ TextGrad ⦁︎ Aider ⦁︎ aichat ⦁︎ omnichain ⦁︎ lm-evaluation-harness ⦁︎ JupyterLab ⦁︎ ol1 ⦁︎ OpenHands ⦁︎ LitLytics ⦁︎ Repopack ⦁︎ n8n ⦁︎ Bolt.new ⦁︎ Open WebUI Pipelines ⦁︎ Qdrant ⦁︎ K6 ⦁︎ Promptfoo ⦁︎ Webtop ⦁︎ OmniParser ⦁︎ Flowise ⦁︎ Langflow ⦁︎ OptiLLM

请参阅 服务文档 获取每项服务的简要概述。

使用Harbor安装Open WebUI的详细步骤

1. 前置准备

- 确保已安装Docker和Docker Compose

- 确保已正确安装Harbor CLI

- 确保系统满足基本要求(建议8GB以上内存)

2. 初始化Harbor环境

# 初始化Harbor环境

harbor init

# 验证Harbor环境

harbor doctor

3. 安装和配置Open WebUI

3.1 启用WebUI服务

# 启用Open WebUI服务

harbor enable webui

3.2 配置基本参数(可选)

# 配置WebUI版本(如果需要指定特定版本)

harbor webui version <version>

# 配置WebUI端口(默认为8080)

harbor config set webui.port <port_number>

4. 启动服务

# 启动所有已启用的服务,包括WebUI

harbor up

# 或者仅启动WebUI服务

harbor up webui

5. 验证安装

- 访问 http://localhost:8080 (或你设置的其他端口)

- 检查服务状态:

harbor ps

6. 常用管理命令

查看服务状态

# 查看所有运行中的服务

harbor ps

# 查看WebUI日志

harbor logs webui

服务管理

# 停止WebUI服务

harbor stop webui

# 重启WebUI服务

harbor restart webui

# 更新WebUI版本

harbor webui version latest

harbor restart webui

7. 集成Ollama(可选)

如果你想使用WebUI连接Ollama:

# 启用Ollama服务

harbor enable ollama

# 重启服务

harbor restart

8. 常见问题排查

检查服务健康状态

harbor doctor

查看具体错误信息

harbor logs webui

端口冲突解决

如果8080端口被占用:

# 修改WebUI端口

harbor config set webui.port 8081

harbor restart webui

9. 配置文件位置

- 主配置文件:

~/.harbor/.env - WebUI配置:

~/.harbor/open-webui/

10. 备份建议

# 导出当前配置

harbor eject > harbor-backup.yaml

注意事项:

- 确保系统有足够的资源运行服务

- 首次启动可能需要一些时间来下载镜像

- 如果遇到权限问题,检查Docker权限设置

- 建议定期备份配置文件

- 保持Harbor和相关服务更新到最新版本

开始使用:

1. 完成安装后,打开浏览器访问 http://localhost:8080

2. 首次访问时会要求进行基本设置

3. 可以开始使用Open WebUI进行AI对话了

需要帮助时可以使用:

```bash

harbor help webui© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...