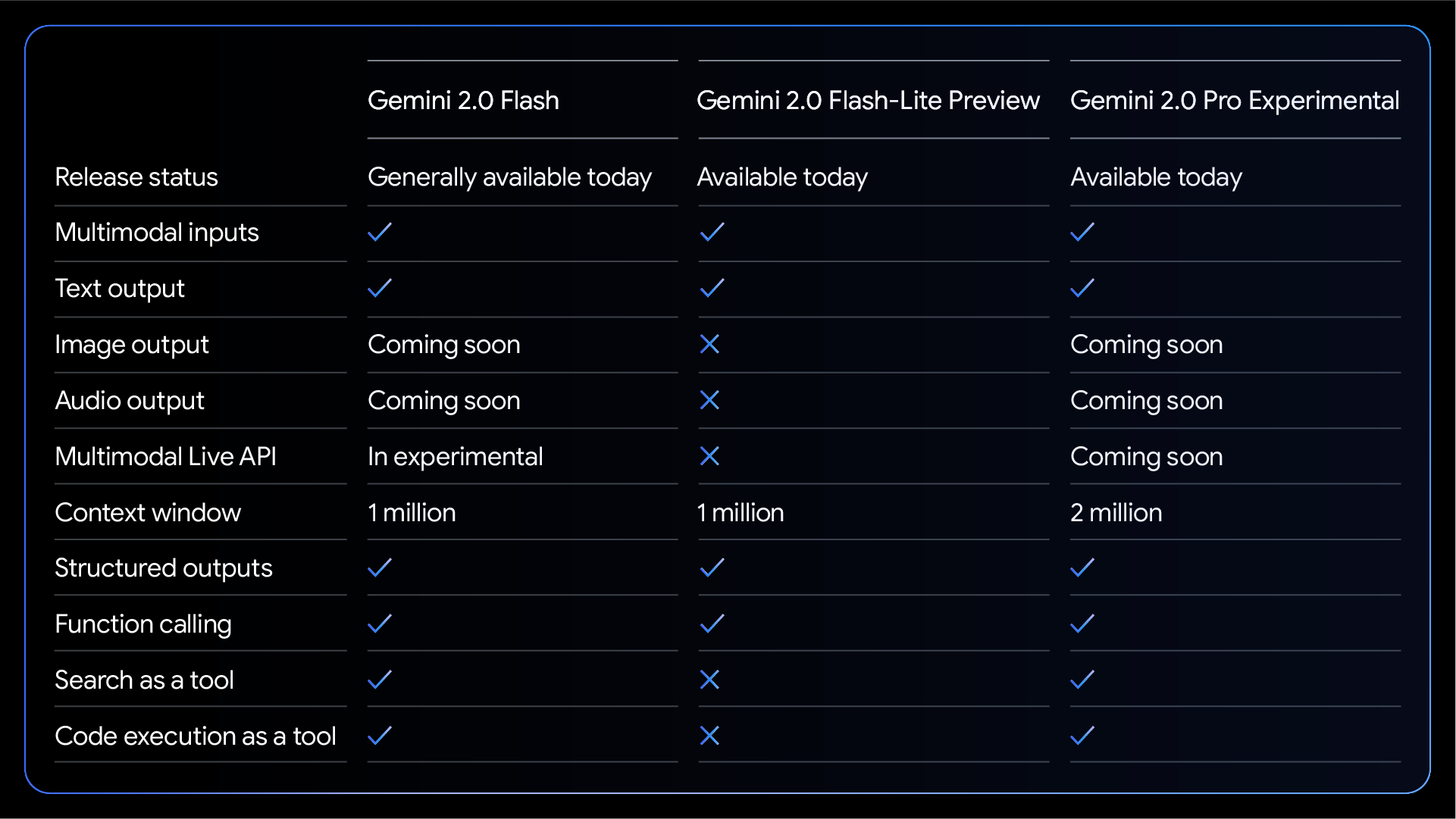

Google 发布 Gemini 2.0 Flash 系列新模型,包括 Gemini 2.0 Flash、Flash-Lite 和 Pro 三款全新模型,旨在为开发者提供更快速、更经济、更强大的生成式 AI 解决方案。 Gemini 2.0 Flash 现已全面可用,拥有更高的速率限制和更强的性能;Flash-Lite 则是更具成本效益的选择;而 Pro 版本则为编码和复杂任务进行了优化。 新系列模型均支持百万 Token 上下文窗口,并提供原生工具使用和多模态输入等强大功能,助力开发者构建更强大的 AI 应用。 此外,Gemini 2.0 Flash 系列还大幅降低了定价,并提供便捷的开发工具和免费层级,让开发者能够轻松上手并快速扩展应用规模。

Gemini 2.0 系列为开发者提供更多选择

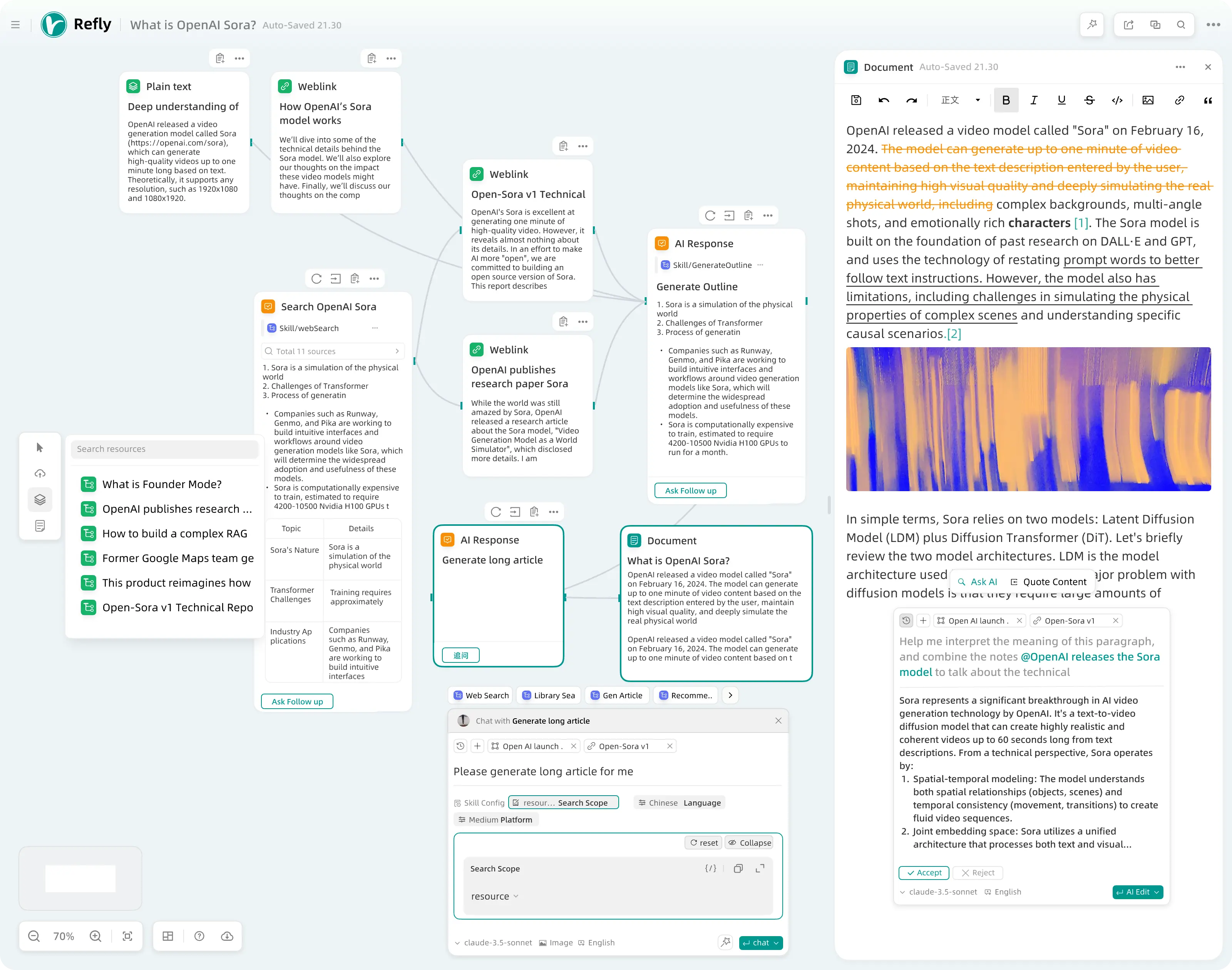

Google 今天 宣布了激动人心的更新 ,旨在使 Gemini 2.0 可供更多开发者使用并投入生产。据称,以下模型现已通过 Google AI Studio 和 Vertex AI 在 Gemini API 中提供:

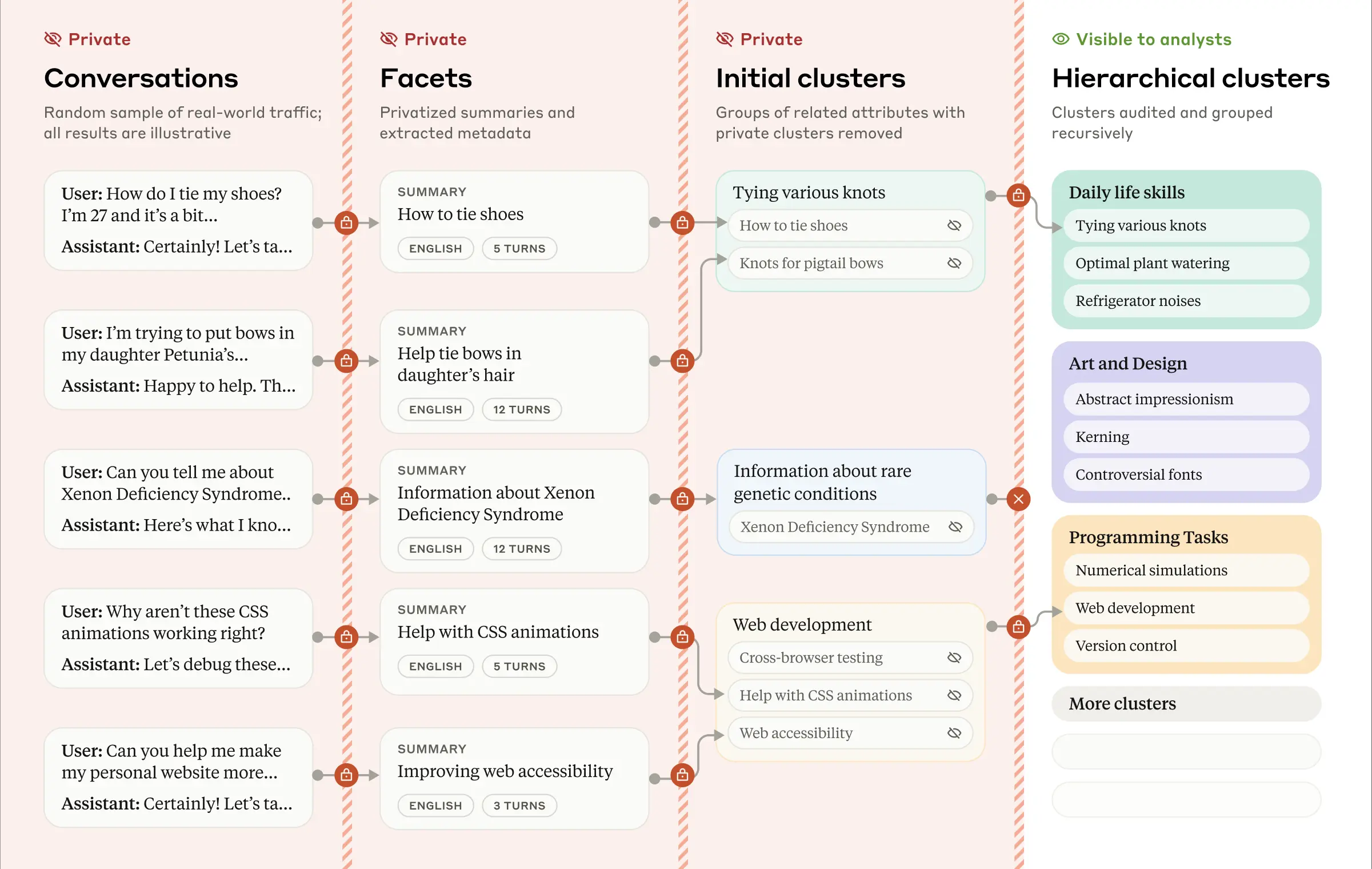

- Gemini 2.0 Flash 现已全面上市,具有更高的速率限制、更强的性能和更简化的定价。

- Gemini 2.0 Flash-Lite ,这是一个新的变体,也是 Google 迄今为止最具成本效益的模型,现已公开发布预览版。

- Gemini 2.0 Pro,这是 Google 迄今为止用于编码和复杂提示的最佳模型的实验性更新,现已发布。

除了最近发布的 Gemini 2.0 Flash Thinking Experimental,这是一款先推理后回答的 Flash 变体之外,这些新版本使得 Gemini 2.0 的功能能够应用于更广泛的用例和应用场景。

模型特性

Gemini 2.0 Flash 提供了一套全面的特性,包括原生工具使用、100 万 Token 上下文窗口和多模态输入。目前,它支持文本输出,而图像和音频输出功能以及多模态 Live API 计划在未来几个月内全面推出。Gemini 2.0 Flash-Lite 经过成本优化,适用于大规模文本输出用例。

模型性能

Gemini 2.0 模型在各种基准测试中,相较于 Gemini 1.5 实现了显著的性能提升。

与 之前的模型 类似,Gemini 2.0 Flash 默认采用简洁风格,这使其更易于使用并降低了成本。此外,它还可以通过 提示 来使用更详尽的风格,从而在面向聊天的用例中获得更出色的结果。

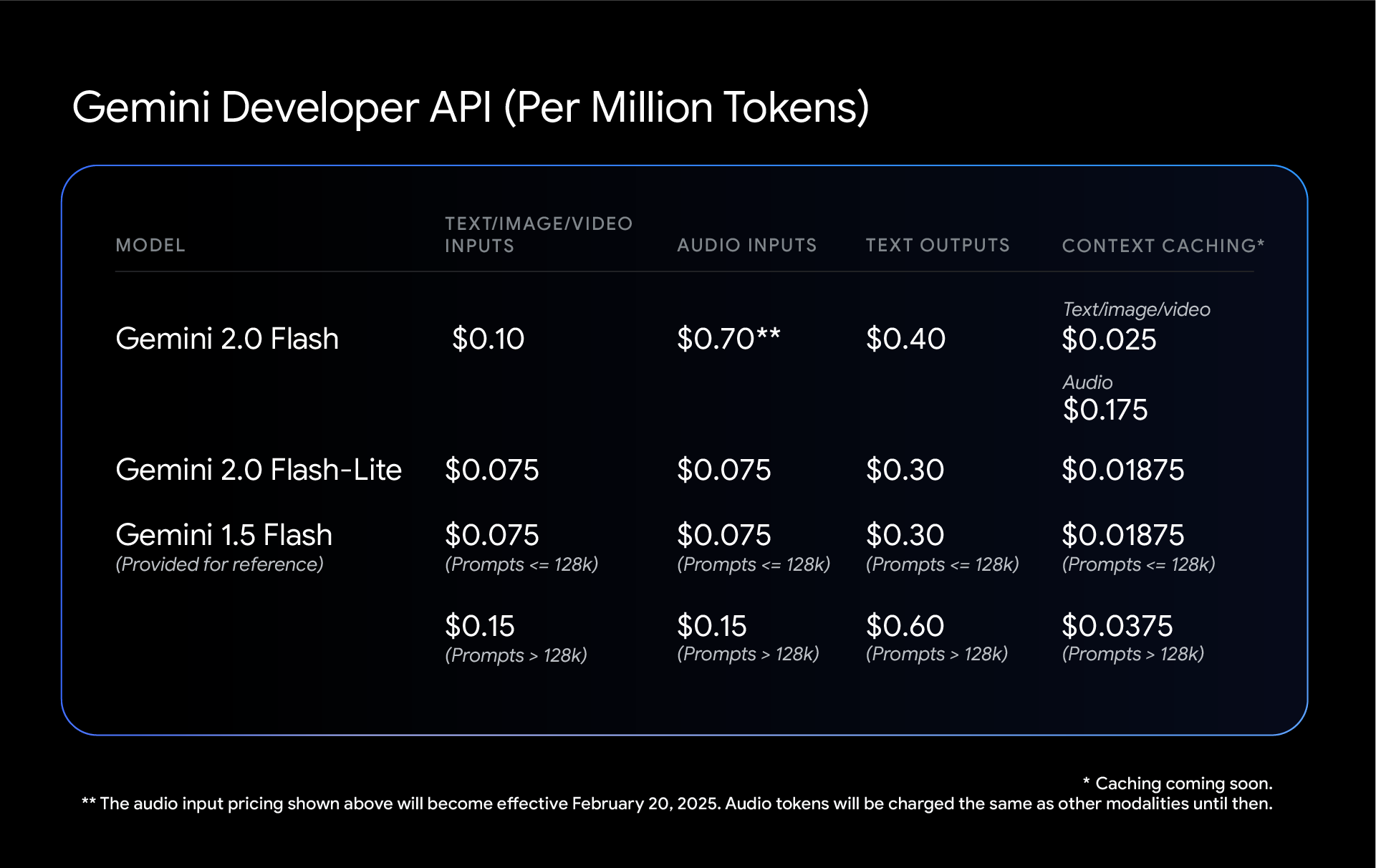

Gemini 定价

Google 持续 通过 Gemini 2.0 Flash 和 2.0 Flash-Lite 降低成本。这两款模型都对每种输入类型采用单一价格,取消了 Gemini 1.5 Flash 在短上下文请求和长上下文请求之间所做的区分。这意味着,尽管 2.0 Flash 和 Flash-Lite 都带来了性能提升,但在混合上下文工作负载下,它们的成本可能比 Gemini 1.5 Flash 更低。

注:对于 Gemini 模型,一个 tonkes 大约相当于 4 个字符。100 个词元大约相当于 60-80 个英语单词。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...