让我们以激动人心的方式开启新的一年

- 可能由 GPT-5 生成

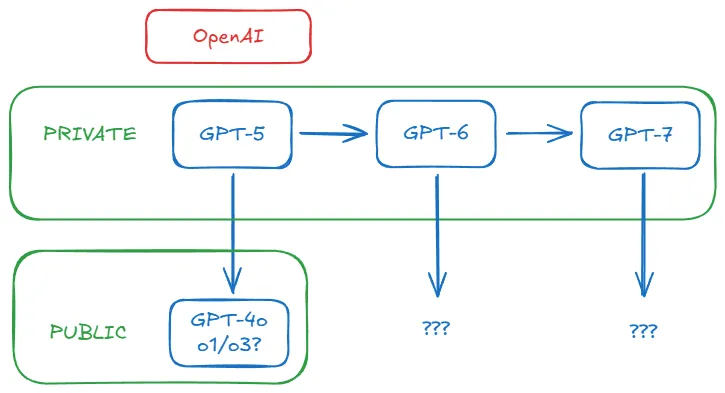

如果我告诉你 GPT-5 是真实存在的。不仅是真实的,而且已经在你看不见的地方塑造世界。这里有个假设:OpenAI 已经开发了 GPT-5 但将其保留在内部,因为其投资回报率远高于将其开放给数百万 ChatGPT 用户。更重要的是,他们获得的 ROI 不是金钱 而是其他东西。如你所见,这个想法足够简单;挑战在于串联起指向它的蛛丝马迹。本文深入探讨为何我认为这些线索最终都能串联起来。

事先声明:这纯粹是推测。证据都是公开的,但没有泄露信息或内部传闻能证实我的正确性。实际上,我正在通过本文构建这个理论,而不仅仅是分享它。我没有特权信息——即使有,我也受保密协议约束。这个假设之所以令人信服,因为它 合乎逻辑 。说实话,要启动这个传闻机器,我还需要什么呢?

是否相信由你决定。即使我错了——我们终将知晓答案——我认为这是个有趣的侦探游戏。我邀请你在评论区参与推测,但请保持建设性和深思熟虑。请务必先通读全文。除此之外,欢迎所有辩论。

I. Opus 3.5 的神秘消失

在探讨 GPT-5 之前,我们不得不提及它同样失踪的远房表亲:Anthropic 的 Claude Opus 3.5。

如你所知,三大 AI 实验室——OpenAI、Google DeepMind 和 Anthropic——都提供覆盖价格/延迟与性能谱系的模型组合。OpenAI 有 GPT-4o、GPT-4o mini 以及 o1 和 o1-mini;Google DeepMind 提供 Gemini Ultra、Pro 和 Flash;Anthropic 则有 Claude Opus、Sonnet 和 Haiku。目标很明确:覆盖尽可能多的客户画像。有人追求顶尖性能不计成本,有人需要经济实惠的够用方案。这些都很合理。

但 2024 年 10 月发生了件怪事。当所有人都期待 Anthropic 发布 Claude Opus 3.5 作为对 GPT-4o 的回应(后者于 2024 年 5 月发布)时,他们却在 10 月 22 日发布了更新版的 Claude Sonnet 3.5(人们开始称之为 Sonnet 3.6)。Opus 3.5 就此消失,使 Anthropic 失去了与 GPT-4o 直接竞争的产品。很奇怪吧?以下是关于 Opus 3.5 的时间线梳理:

- 10 月 28 日,我在周评文章中写道:"[有] 传闻称 Sonnet 3.6 是...备受期待的 Opus 3.5 训练失败过程中产生的中间检查点。"同日,r/ClaudeAI 子论坛出现帖子:"Claude 3.5 Opus 已被废弃",链接指向Anthropic 模型页面——至今仍无 Opus 3.5 的踪影。有人推测此举是为在新一轮融资前维持投资者信心。

- 11 月 11 日,Anthropic CEO Dario Amodei 在 Lex Fridman 播客中放弃 Opus 3.5:"虽然不能给出确切日期,但我们仍计划推出 Claude 3.5 Opus。" 措辞谨慎暧昧,但确有效力。

- 11 月 13 日,彭博社证实早期传闻:"训练完成后,Anthropic 发现 3.5 Opus 在评估中优于旧版,但考虑到模型规模和构建运行成本,提升幅度未达预期。" Dario 未给出日期,似乎是因为尽管 Opus 3.5 训练未失败,但成果不尽如人意。注意重点是 成本与性能比 而非单纯性能。

- 12 月 11 日,半导体专家 Dylan Patel 及其 Semianalysis 团队带来最终转折,提出解释:"Anthropic 完成 Claude 3.5 Opus 训练且表现良好...但未发布。因为他们转而 使用 Claude 3.5 Opus 生成合成数据 ,通过奖励建模显著提升 Claude 3.5 Sonnet。"

简言之,Anthropic 确实训练了 Claude Opus 3.5。他们弃用该名称是因成果不够理想。Dario 相信通过不同训练流程可改进结果,故回避具体日期。彭博证实其优于现有模型但推理成本(用户使用模型的成本)难以承受。Dylan 团队揭示了 Sonnet 3.6 与失踪的 Opus 3.5 的关联:后者被用于内部生成提升前者性能的合成数据。

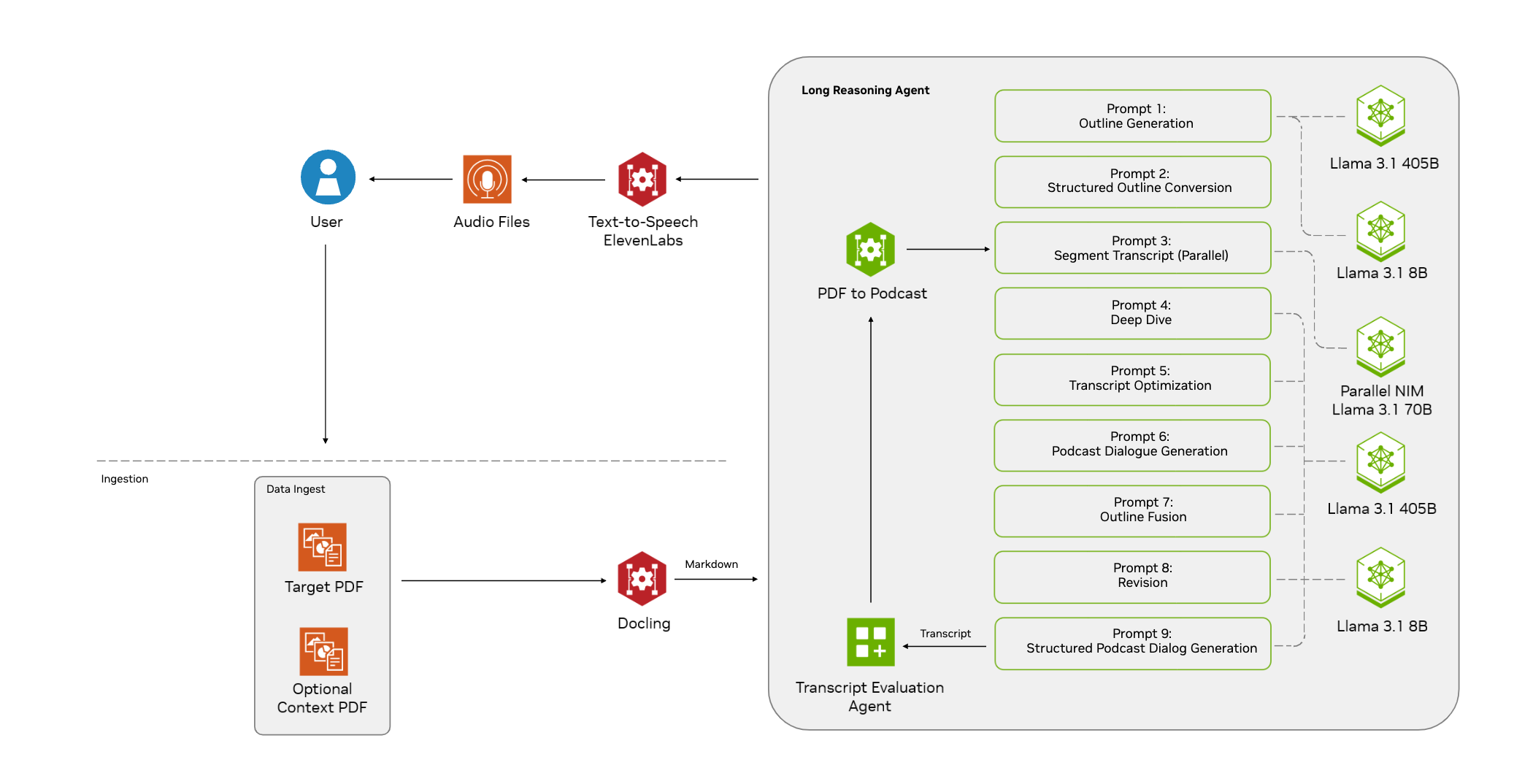

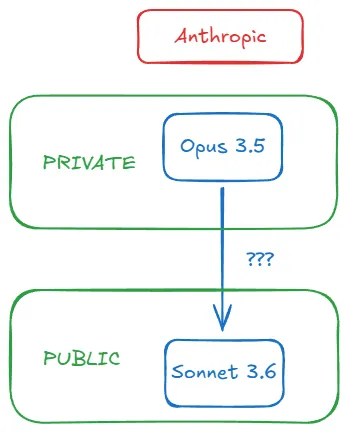

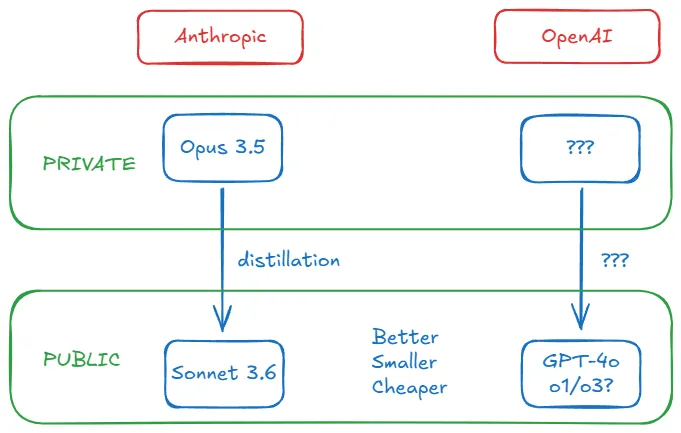

整个过程可图示如下:

II. 更优且更小更便宜?

使用强大而昂贵的模型生成数据来增强稍弱但更经济的模型,这个过程称为蒸馏(distillation)。这是常见做法。该技术使 AI 实验室能突破仅靠预训练的局限,提升小模型性能。

蒸馏有不同方法,但我们不深入探讨。关键要记住:作为"教师"的强模型能将"学生"模型从[小、便宜、快速] + 弱 转变为[小、便宜、快速] + 强大 。蒸馏将强模型变为金矿。Dylan 解释为何这对 Anthropic 的 Opus 3.5-Sonnet 3.6 组合有意义:

(新 Sonnet 相比旧版的)推理成本未显著变化,但模型性能提升了。既然通过 3.5 Opus 进行后训练就能获得 3.5 Sonnet,从成本角度考量何必发布 3.5 Opus?

回归成本问题:蒸馏在提升性能的同时控制推理开支。这直接解决了彭博报道的核心问题。Anthropic 选择不发布 Opus 3.5 不仅因效果欠佳,更因其内部价值更高。(Dylan 指出这也是开源社区快速追赶 GPT-4 的原因——他们直接从 OpenAI 的金矿中取金。)

最惊人的启示?Sonnet 3.6 不仅优秀——它达到了 业界顶尖水平 。超越 GPT-4o。Anthropic 的中端模型通过 Opus 3.5 的蒸馏(可能还有其他原因,五个月在 AI 领域已足够长),击败了 OpenAI 的旗舰产品。突然之间,高成本作为高性能代名词的认知开始崩塌。

"越大越好"的时代怎么了?OpenAI CEO Sam Altman 警告那个时代已结束。我也撰文讨论。当顶尖实验室开始保密,他们停止分享参数数量。参数规模不再可靠,我们明智地转向关注基准表现。OpenAI 最后公开的参数规模是 2020 年 GPT-3 的 1750 亿。2023 年 6 月传闻称 GPT-4 是约1.8 万亿参数的混合专家模型。Semianalysis 后续详细评估确认 GPT-4 有 1.76 万亿参数,当时是 2023 年 7 月。

直到 2024 年 12 月——一年半后——专注 AI 未来影响的组织 EpochAI 研究员 Ege Erdil 估计,包括 GPT-4o 和 Sonnet 3.6 在内的前沿模型参数规模明显小于 GPT-4(尽管两者基准测试均优于 GPT-4):

...当前前沿模型如初代 GPT-4o 和 Claude 3.5 Sonnet 可能比 GPT-4 小一个数量级,4o 约 2000 亿参数,3.5 Sonnet 约 4000 亿...尽管估算方式粗糙可能导致误差达两倍。

他深入解释如何在实验室未公布架构细节的情况下得出该数字,但这对我们不重要。关键在于迷雾渐散:Anthropic 和 OpenAI 似乎遵循相似轨迹。他们的最新模型不仅更优,还比前代更小更便宜。我们已知 Anthropic 通过蒸馏 Opus 3.5 实现。但 OpenAI 做了什么?

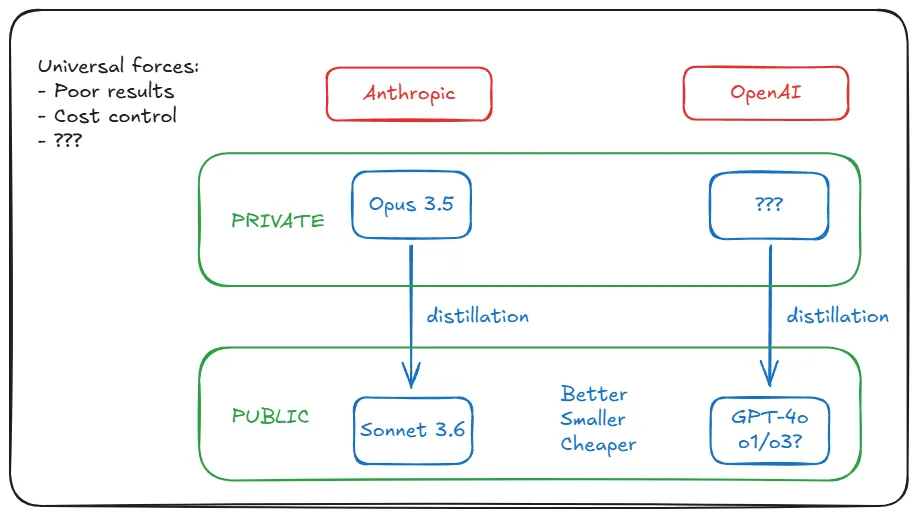

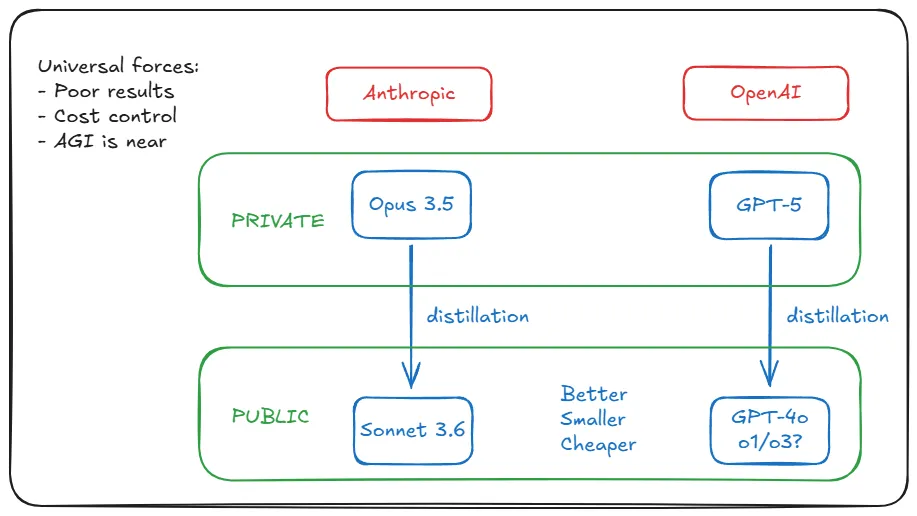

III. AI 实验室的驱动力是普适的

可能有人认为 Anthropic 的蒸馏策略源于特殊情境——即 Opus 3.5 训练结果欠佳。但现实是 Anthropic 的处境并不独特。Google DeepMind 和 OpenAI 的最新训练结果同样不尽如人意。(注意欠佳不等同于 模型更差 。)原因对我们不重要:数据不足导致的收益递减、Transformer 架构的固有局限、预训练扩展定律的平台期等。无论如何,Anthropic 的特殊情境其实具有普适性。

但记住彭博的报道:性能指标的好坏取决于成本。这是否是另一共享因素?是的,Ege 解释了原因:ChatGPT/GPT-4 热潮后的需求激增。生成式 AI 的普及速度让实验室难以承受持续扩大的亏损。这迫使它们降低推理成本(训练只需一次,推理成本随用户量和用量增长)。如果每周有 3 亿用户使用产品,运营开支可能突然致命。

驱动 Anthropic 用蒸馏提升 Sonnet 3.6 的因素,正以数倍强度影响 OpenAI。蒸馏之所以有效,是因它将这两个普适挑战转化为优势:通过提供小模型解决推理成本问题,同时不发布大模型避免公众对平庸表现的反弹。

Ege 认为 OpenAI 可能选择替代方案:过度训练(overtraining)。即在非计算最优状态下用小模型训练更多数据:"当推理成为模型支出的主要部分时,最好...用小模型训练更多 token。"但过度训练已不可行。AI 实验室已耗尽高质量预训练数据。Elon Musk 和 Ilya Sutskever 最近都承认这点。

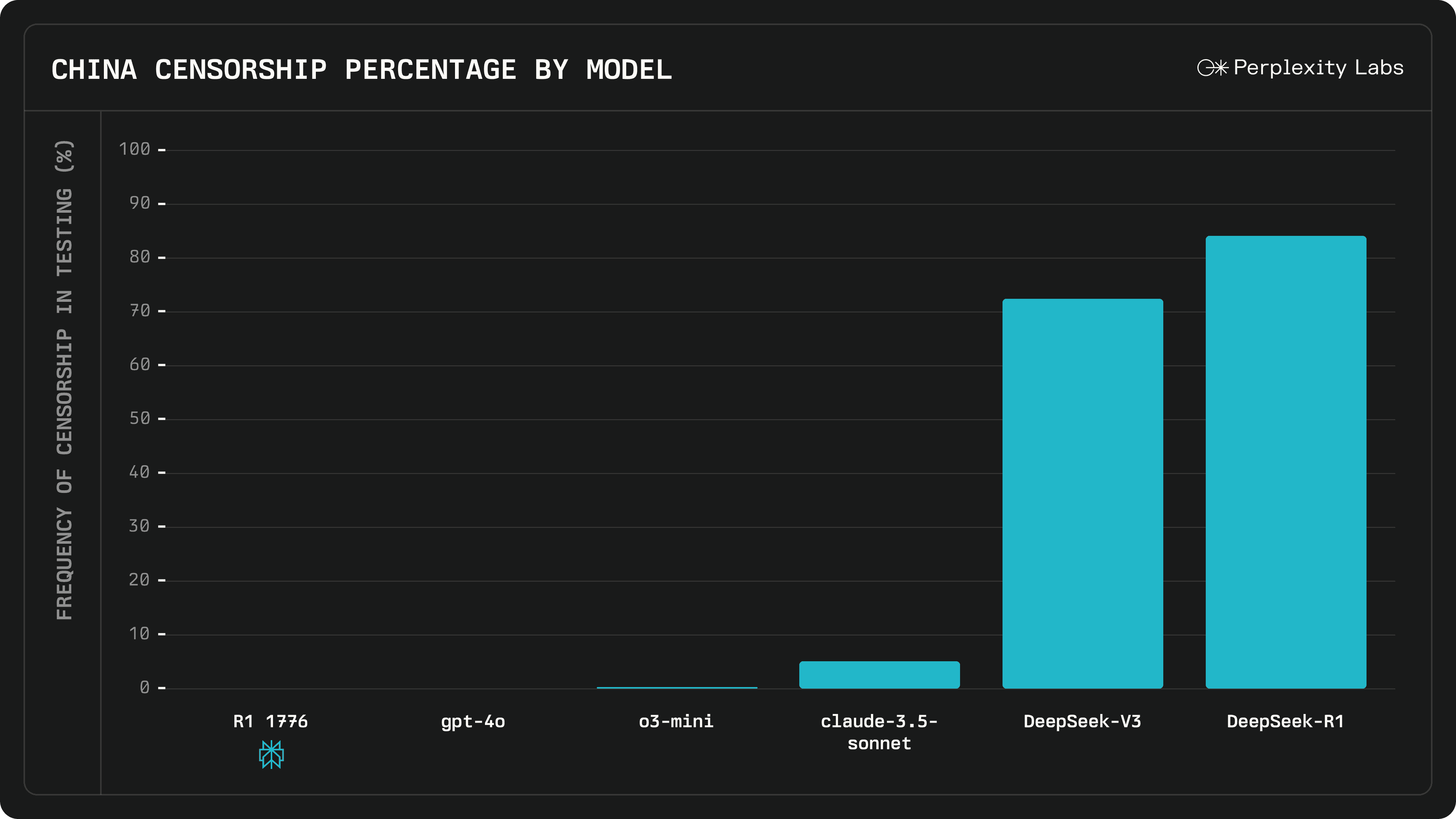

回到蒸馏。Ege 总结:"我认为 GPT-4o 和 Claude 3.5 Sonnet 很可能都经大模型蒸馏而来。"

至此所有线索表明,OpenAI 正以同样方式(蒸馏)和同样原因(效果欠佳/成本控制)做着 Anthropic 对 Opus 3.5 所做之事(训练并隐藏)。这是个发现。但问题是:Opus 3.5 仍 被隐藏。OpenAI 的对应模型在哪?是否藏在公司地下室?敢猜它的名字吗...

IV. 先驱者必须扫清道路

我通过研究 Anthropic 的 Opus 3.5 事件开启分析,因其信息更透明。然后将蒸馏概念桥接到 OpenAI,解释驱动 Anthropic 的底层力量同样作用于 OpenAI。但我们的理论遇到新障碍:作为先驱者,OpenAI 可能面临 Anthropic 尚未遭遇的阻碍。

例如训练 GPT-5 的硬件需求。Sonnet 3.6 可比肩 GPT-4o,但其发布时间晚五个月。我们应假设 GPT-5 属于更高层级:更强大更庞大。不仅推理成本,训练成本也更高。可能涉及五亿美元的训练费用。用现有硬件可能实现吗?

Ege 再次解围:可以。向 3 亿用户提供这种庞然大物虽不现实,但训练没问题:

原则上,现有硬件足以支持比 GPT-4 大得多的模型:例如 50 倍于 GPT-4 的 100 万亿参数模型,推理成本约 3000 美元/百万输出 token,输出速度 10-20 token/秒。但要使这可行,大模型必须为客户创造巨大经济价值。

但即使微软、谷歌或亚马逊(分别是 OpenAI、DeepMind 和 Anthropic 的金主)也无法承受这种推理开支。解决方法很简单:若计划向公众提供数万亿参数模型,必须"创造巨大经济价值"。所以他们不这样做。

他们训练模型。发现"比现有产品表现更好"。但必须接受"其进步程度不足以证明维持运行的巨额成本"。(这措辞耳熟吗?《华尔街日报》一个月前报道 GPT-5 时用词与彭博对 Opus 3.5 的报道惊人相似。)

他们报告平庸结果(可灵活调整叙事)。将其作为教师模型内部保留以蒸馏学生模型。然后发布后者。我们获得 Sonnet 3.6 和 GPT-4o、o1 等产品,并为它们的廉价优质而欣喜。对 Opus 3.5 和 GPT-5 的期待保持完整,即使我们愈发不耐。他们的金矿继续闪耀。

V. 当然,你还有更多的理由,Altman先生!

V. 当然,你还有更多理由,Altman 先生!

当我调查到这一步时,我仍然没有完全信服。确实,所有证据都表明这对 OpenAI 来说是完全合理的,但“合理”甚至“可能”与“真实”之间仍有差距。我不会为你填补这个差距——毕竟这只是推测。但我可以进一步强化这个论点。

是否有更多证据表明 OpenAI 是以这种方式运作的?除了表现不佳和不断增加的亏损之外,他们是否有更多理由推迟发布 GPT-5?我们能从 OpenAI 高管关于 GPT-5 的公开声明中提取出什么信息?他们一再推迟模型的发布,难道不是在冒着损害声誉的风险吗?毕竟,OpenAI 是 AI 革命的门面,而 Anthropic 则在其阴影下运作。Anthropic 可以承受这些操作,但 OpenAI 呢?或许不能毫无代价。

谈到钱,让我们挖掘一些关于 OpenAI 与 Microsoft 合作的相关细节。首先,众所周知的事实是:AGI 条款。在 OpenAI 关于其结构的博客文章 中,他们有五个治理条款,规定了其运作方式、与非营利组织的关系、与董事会的关系以及与 Microsoft 的关系。第五条款将 AGI 定义为“一个高度自主的系统,能够在大多数经济价值高的工作中超越人类”,并确定一旦 OpenAI 董事会宣布 AGI 已经实现,“该系统将被排除在与 Microsoft 的知识产权许可和其他商业条款之外,这些条款仅适用于 AGI 之前的技术。”

不用说,两家公司都不希望合作关系破裂。OpenAI 设定了这一条款,但会尽一切努力避免不得不遵守它。其中一种方式是推迟发布可能被标记为 AGI 的系统。“但 GPT-5 肯定不是 AGI,”你会说。而我会说,这里有第二个事实,几乎没有人知道:OpenAI 和 Microsoft 有一个关于 AGI 的秘密定义,尽管这对科学目的无关紧要,但在法律上定义了他们的合作关系:AGI 是一个“能够产生至少 1000 亿美元利润”的 AI 系统。

如果 OpenAI 假设以 GPT-5 尚未准备好为借口推迟发布,他们除了控制成本和防止公众反弹之外,还能实现另一件事:他们将避免宣布它是否达到了被归类为 AGI 的门槛。虽然 1000 亿美元的利润是一个惊人的数字,但没有什么能阻止雄心勃勃的客户在此基础上赚取这么多利润。另一方面,让我们明确一点:如果 OpenAI 预测 GPT-5 每年能带来 1000 亿美元的经常性收入,他们不会介意触发 AGI 条款并与 Microsoft 分道扬镳。

大多数公众对 OpenAI 不发布 GPT-5 的反应都是基于一个假设,即他们不发布是因为它不够好。即使这是真的,也没有怀疑者停下来思考,OpenAI 可能有一个比外部使用更好的内部用例。创建一个优秀的模型与创建一个可以廉价服务于 3 亿人的优秀模型之间存在巨大差异。如果你做不到,你就不会做。但同样,如果你 不需要 做,你也不会做。他们过去向我们提供他们最好的模型,是因为他们需要我们的数据。现在不再那么需要了。他们也不再追逐我们的钱。那是 Microsoft 的事,而不是他们的事。他们想要 AGI,然后是 ASI。他们想要留下遗产。

VI. 为什么这改变了一切

我们接近尾声了。我相信我已经提出了足够的论据来建立一个坚实的论点:OpenAI 很可能在内部已经拥有了 GPT-5,就像 Anthropic 拥有 Opus 3.5 一样。甚至有可能 OpenAI 永远不会发布 GPT-5。公众现在以 o1/o3 来衡量性能,而不仅仅是 GPT-4o 或 Claude Sonnet 3.6。随着 OpenAI 探索测试时的扩展定律,GPT-5 需要跨越的门槛不断提高。他们怎么可能发布一个真正超越 o1、o3 以及即将推出的 o 系列模型的 GPT-5,尤其是在他们以如此快的速度推出这些模型的情况下?此外,他们不再需要我们的钱或数据了。

训练新的基础模型——GPT-5、GPT-6 及以后的版本——对 OpenAI 内部来说总是有意义的,但不一定作为产品。那可能已经结束了。现在对他们来说唯一重要的目标是继续为下一代模型生成更好的数据。从今以后,基础模型可能在后台运作,赋能其他模型实现它们自己无法实现的壮举——就像一个隐居的老者从秘密的山洞中传递智慧,只不过这个山洞是一个巨大的数据中心。无论我们是否见到他,我们都会体验到他的智慧带来的后果。

即使 GPT-5 最终发布,这一事实突然显得几乎无关紧要。如果 OpenAI 和 Anthropic 真的启动了 递归自我改进 的操作(尽管仍有人类参与),那么他们公开给我们什么将不再重要。他们将越来越领先——就像宇宙膨胀得如此之快,以至于遥远星系的光再也无法到达我们。

也许这就是 OpenAI 在 短短三个月内 从 o1 跳到 o3 的原因。也是他们将跳到 o4 和 o5 的原因。这可能就是为什么他们最近在社交媒体上如此兴奋。因为他们已经实施了一种新的改进的操作模式。

你真的认为接近 AGI 意味着你将能够使用越来越强大的 AI 吗?他们会发布每一个进步供我们使用吗?当然,你不会相信这一点。他们当初说他们的模型将把他们推得太远,以至于其他人无法追赶时,他们是认真的。每一代新模型都是一个逃逸速度的引擎。从平流层中,他们已经挥手告别。

他们是否会回来,还有待观察。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...