摘要

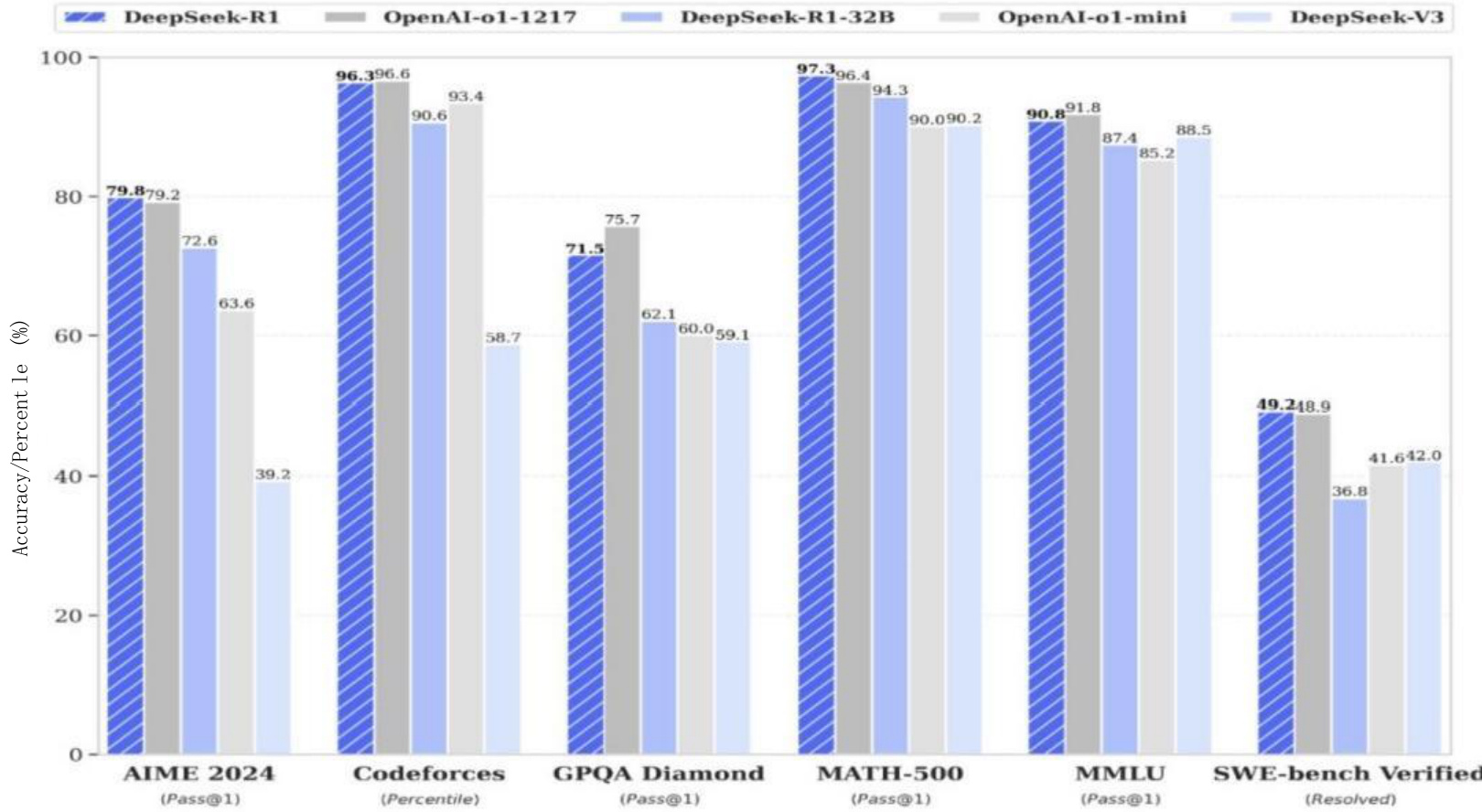

信息检索系统对于有效访问大型文档集合至关重要。最近的方法利用大型语言模型(LLMs)通过查询增强来提高检索性能,但通常依赖于昂贵的监督学习或蒸馏技术,这些技术需要大量的计算资源和手工标注的数据。在本文中,我们介绍了DeepRetrieval,这是一种新颖的基于强化学习的方法,通过试错直接训练LLMs进行查询增强,而无需监督数据。通过使用检索召回率作为奖励信号,我们的系统学会了生成有效的查询,以最大化文档检索性能。我们的初步结果表明,DeepRetrieval在出版物搜索任务上达到了60.82%的召回率,在试验搜索任务上达到了70.84%的召回率,同时使用的模型更小(3B vs. 7B参数),并且不需要任何监督数据。这些结果表明,我们的强化学习方法为信息检索提供了一种更高效、更有效的范式,可能会改变文档检索系统的格局。

作者:彭程江(UIUC 计算机科学系)

原文:https://arxiv.org/pdf/2503.00223

代码地址:https://github.com/pat-jj/DeepRetrieval

1. 引言

信息检索(IR)系统在帮助用户在大规模文档集合中找到相关文档方面起着至关重要的作用。传统的IR方法依赖于关键词匹配和统计方法,这些方法通常难以理解用户查询背后的语义含义。最近,大型语言模型(LLMs)的进步在解决这些局限性方面显示出希望,通过查询增强(Bonifacio等人,2022),LLMs扩展或重新制定用户查询,以更好地捕捉相关文档。

然而,当前的基于LLM的查询增强方法通常采用监督学习或蒸馏技术,这些技术有几个显著的局限性:

- 它们需要昂贵的计算资源来生成训练数据,通常花费数千美元。

- 增强查询的质量取决于监督数据的质量。

- 它们依赖于较大的模型来为较小的模型生成数据,这引入了潜在的偏差和局限性。

在这项工作中,我们介绍了DeepRetrieval,这是一种新颖的方法,它使用强化学习(RL)来训练LLMs进行查询增强。与依赖监督数据的方法不同,DeepRetrieval允许模型通过直接试错来学习,使用检索召回率作为奖励信号。这种方法有几个关键优势:

- 无需昂贵的监督数据生成

图1:DeepRetrieval:LLM生成增强查询,用于检索文档。计算召回率并用作奖励来更新模型。

图1:DeepRetrieval:LLM生成增强查询,用于检索文档。计算召回率并用作奖励来更新模型。

- 直接针对最终目标(召回性能)进行优化

- 能够无需人工演示即可学习有效策略

我们的初步结果表明,DeepRetrieval显著优于现有的最先进方法,包括最近的LEADS系统(Wang等人,2025),在出版物搜索任务上达到了60.82%的召回率,在试验搜索任务上达到了70.84%的召回率。值得注意的是,这些结果是在使用较小的模型(3B参数)的情况下获得的,与LEADS(7B参数)相比,并且不需要任何监督数据,这突出了我们方法的效率和有效性。

2. 方法

我们的DeepRetrieval方法建立在最近在LLMs的强化学习方面的进展之上,将这种范式应用于信息检索的特定任务——查询增强。我们的方法直接受到DeepSeek-R1-Zero(DeepSeek-AI等人,2025)的启发,该方法证明了RL可以用来训练具有高级推理能力的模型,而无需依赖监督数据。图1展示了我们系统的整体架构。

2.1 问题表述

设 D 为文档集合,q 为用户查询。信息检索系统的目标是返回与 q 相关的文档子集 Dq⊂D 。在查询增强中,原始查询 q 被转换为增强查询 q',该查询在检索相关文档方面更有效。

传统上,这种增强过程是通过监督学习来学习的,其中 (q,q') 对作为训练数据提供。相比之下,我们的方法使用强化学习,模型通过试错学习生成有效的增强查询,类似于DeepSeek-R1-Zero如何学习解决推理问题。

2.2 强化学习框架

我们将查询增强任务表述为一个强化学习问题:

- 状态:用户的原始查询 q

- 动作:模型生成的增强查询 q'

- 奖励:使用 q' 检索文档时实现的召回率

模型被训练以最大化预期奖励,即生成实现高召回率的增强查询。这种直接优化最终目标的方法与监督方法不同,后者优化与人工生成或更大模型生成的增强相似。

2.3 模型架构和输出结构

我们使用Qwen-2.5-3B-Instruct(Yang等人,2024)作为我们系统的基线LLM。该模型将用户查询作为输入,并生成增强查询。该模型的结构首先在部分生成推理步骤,然后在部分以JSON格式生成最终的增强查询。这种结构化的生成允许模型考虑查询的各个方面,并在最终确定其响应之前探索不同的增强策略。

在我们的初步实验中,我们专注于使用基于PICO框架的专业提示进行医学文献检索(详见附录A)。为了与搜索系统兼容,JSON格式需要使用布尔运算符(AND, OR)和适当的括号进行分组。然而,我们的方法是通用的,可以通过适当修改提示和查询格式应用于传统的IR数据集。

2.4 奖励机制

我们的奖励函数旨在直接优化检索性能。过程如下:

- 模型响应PICO框架查询生成增强查询。

- 针对文档集合(PubMed或ClinicalTrials.gov)执行增强查询。

- 计算召回率作为检索到的相关文档的比例。

- 根据以下内容计算综合奖励:

- 格式正确性(JSON结构,适当的标签)

- 检索召回率,召回率越高,奖励越高。

具体来说,我们的奖励函数使用基于召回率的层级评分系统,如表1所示。

| 召回率 | ≥ 0.7 | ≥ 0.5 | ≥ 0.4 | ≥ 0.3 | ≥ 0.1 | ≥ 0.05 | < 0.05 |

|---|---|---|---|---|---|---|---|

| 奖励 | +5.0 | +4.0 | +3.0 | +1.0 | +0.5 | +0.1 | -3.5 |

表1:根据召回率表现的奖励层级。较高的召回率值获得显著更大的奖励,激励模型生成更有效的查询。

此外,正确的格式将获得+1分,而错误的格式将获得-4分。重要的是,如果格式不正确(缺少标签,不正确的JSON结构等),则根本不计算答案奖励,仅产生格式惩罚。这种奖励结构强烈鼓励模型生成格式良好的查询,在遵守所需输出格式的同时,最大化召回率。

2.5 训练过程

我们的训练过程遵循以下步骤:

- 使用预训练的权重初始化模型。

- 对于训练集中的每个查询:

- 生成增强查询。

- 针对搜索系统执行查询。

- 计算召回率(检索到的相关文档的比例)。

- 使用基于召回率的奖励来更新模型。

- 重复直到收敛。

这个过程允许模型直接从检索性能中学习有效的查询增强策略,而无需明确的监督。模型逐渐提高其将PICO框架查询转换为有效的搜索术语的能力,以最大化相关医学文献的召回率。

3. 实验

3.1 数据集

我们在两个医学文献检索任务上评估我们的方法:

- 出版物搜索:根据用户以PICO框架表达的查询,从PubMed中检索相关的医学出版物。

- 试验搜索:根据类似的PICO框架查询,从ClinicalTrials.gov中检索相关的临床试验。

这些数据集对于信息检索系统来说尤其具有挑战性,因为医学文献中的专业术语和复杂关系。对于每个查询,我们有一组基础事实相关的文档(由其PMID标识),这些文档应该由增强查询理想地检索。

3.2 评估指标

我们使用召回率作为我们的主要评估指标,它衡量检索到的相关文档的比例。具体来说,我们报告:

- 召回率(出版物搜索):检索到的相关出版物的比例。

- 召回率(试验搜索):检索到的相关临床试验的比例。

3.3 基线

我们将我们的方法与几个基线进行比较:

- GPT-4o:各种配置(零样本、少样本、ICL、ICL+少样本)。

- GPT-3.5:各种配置(零样本、少样本、ICL、ICL+少样本)。

- Haiku-3:各种配置(零样本、少样本、ICL、ICL+少样本)。

- Mistral-7B(Jiang等人,2023):零样本配置。

- LEADS(Wang等人,2025):一种使用Mistral-7B进行蒸馏训练的最新医学文献检索方法。

3.4 实现细节

我们使用VERL框架1实现了DeepRetrieval,这是HybridFlow RLHF框架的开源实现(Sheng等人,2024)。

我们的训练配置使用近端策略优化(PPO),以下是关键参数:

- 基线模型:Qwen-2.5-3B-Instruct(Yang等人,2024)。

图2:DeepRetrieval的训练动态。召回率计算基于训练期间的PubMed检索。

图2:DeepRetrieval的训练动态。召回率计算基于训练期间的PubMed检索。

- PPO小批量大小:16。

- PPO微批量大小:8。

- 学习率:演员1e-6,评论家1e-5。

- KL系数:0.001。

- 最大序列长度:提示和响应均为500个令牌。

我们在两个NVIDIA A100 80GB PCIe上使用FSDP策略训练模型,并启用了梯度检查点以优化内存使用。训练过程运行了5个周期。

如图2所示,训练动态显示,随着训练的进行,性能指标稳步提高。平均奖励(左上)显示出持续上升的趋势,从负值开始,但很快变为正值,并在整个训练过程中持续改善。同时,错误答案比率(中间顶部)和格式错误比率(右上)大幅下降,表明模型正在学习生成结构良好的查询,以检索相关文档。

最显著的进步是所有召回率阈值的一致提高。达到高召回率值的查询比例(≥0.5, ≥0.7)稳步增加,最高召回率层级(≥0.7)从接近零增长到训练结束时的约0.25。中等召回率比率(≥0.4, ≥0.3)显示出更强的增长,达到约0.6-0.7,而较低召回率阈值(≥0.1, ≥0.05)迅速接近并稳定在0.8-0.9附近。这种进展清楚地表明,强化学习如何通过直接优化检索性能,逐步增强模型生成有效查询增强的能力。

4. 结果

4.1 主要结果

表2展示了实验的主要结果。DeepRetrieval在出版物搜索任务上达到了60.82%的召回率,在试验搜索任务上达到了70.84%的召回率,显著优于所有基线,包括最先进的技术LEADS系统。

4.2 分析

我们的结果中出现了几个关键观察:

- 卓越的性能:DeepRetrieval在出版物搜索任务上比LEADS高出很大一部分(60.82%对24.68%),在试验搜索任务上(70.84%对32.11%),尽管使用较小的模型(3B对7B参数)。

- 成本效益:与LEADS不同,LEADS需要昂贵的蒸馏(估计超过10,000美元用于训练数据生成),DeepRecallal不需要监督数据,这使其在成本效益上显著更高。

- 通用性:在出版物和试验搜索任务上的持续性能表明,我们的方法在不同检索场景中具有良好的通用性。

- 结构化生成的效率:使用/结构,模型能够在最终确定其响应之前,通过复杂的查询进行推理,从而提高整体质量。

5. 讨论

5.1 为什么强化学习有效

DeepRetrieval的卓越性能可以归因于几个因素:

- 直接优化:通过直接优化召回率,模型学会了生成对检索有效的查询,而不是匹配某些预定义模式的查询。

- 探索:强化学习框架允许模型探索广泛的查询增强策略,可能会发现可能不在监督数据中存在的有效方法。

- 自适应学习:模型可以根据查询和文档集合的具体特征调整其增强策略,而不是采用一刀切的方法。

- 结构化推理:使用分开的思考和回答组件的两阶段生成方法允许模型在提交最终查询之前,通过问题空间进行工作。

5.2 限制和未来工作

虽然我们的初步结果很有希望,但仍有一些限制和未来的工作方向:

- 在经典IR数据集上的评估:我们目前的实验集中在使用PICO框架的医学文献检索上。一个关键的下一个步骤是在标准IR基准测试(如MS MARCO、TREC和BEIR)上评估DeepRecallal,以测试其在更通用检索场景中的有效性。

- 与更先进方法的比较:与最近的查询增强方法的额外比较将进一步验证我们的发现。

- 模型扩展:研究性能如何随更大模型而变化,可以深入了解模型大小与检索性能之间的权衡。

- 奖励工程:探索更复杂的奖励函数,结合除召回率之外的其它指标(例如,精确度、nDCG),可能会带来进一步的改进。

- 与检索管道的集成:探索如何将DeepRecallal集成到现有的检索管道中,包括结合神经和传统检索方法的混合方法。

6. 结论

在本文中,我们介绍了DeepRecallal,这是一种新颖的基于强化学习的查询增强方法,用于信息检索。通过训练一个3B参数的语言模型直接优化检索召回率,我们在医学文献检索任务上达到了最先进的性能,显著优于依赖监督学习或蒸馏的现有方法。

我们方法的关键创新在于其能够通过试错学习有效的查询增强策略,而无需昂贵的监督数据。这使得DeepRecallal不仅更有效,而且比现有方法更具成本效益。

我们的结果表明,强化学习为信息检索提供了一种有前途的范式,可能会改变文档检索系统的格局。我们相信,这种方法可以扩展到其他信息检索任务和领域,为提高各种应用的检索性能提供了一个通用框架。

附录 A PICO 提示

在我们的医学文献检索实验中,我们使用了以下专业输入提示:

Assistant 是一名临床专家。他正在进行研究并开展医学文献综述。他的任务是创建查询词,用于搜索 URL,以在 PubMed 或 ClinicalTrials.gov 上找到相关文献。

研究是基于 PICO 框架定义的:

P:患者、问题或人群 - 研究对象是谁或是什么?

I:干预措施 - 主要考虑的干预措施或暴露因素是什么?

C:对照 - 干预措施与什么进行比较?

O:结果 - 相关的研究结果或测量的效果是什么?

Assistant 应该在 <think> </think> 标签内展示他的思考过程。

Assistant 应该在 <answer> </answer> 标签内返回最终答案,并使用 JSON 格式,例如:

<think>

[思考过程]</think>

<answer>

{

"query": "...."

}

</answer>

注意:查询应使用布尔运算符(AND、OR)以及括号来适当地分组术语。

此专业输入提示专门用于医学文献检索,但可以通过修改任务描述和查询结构指导,适用于其他信息检索(IR)领域。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...