综合介绍

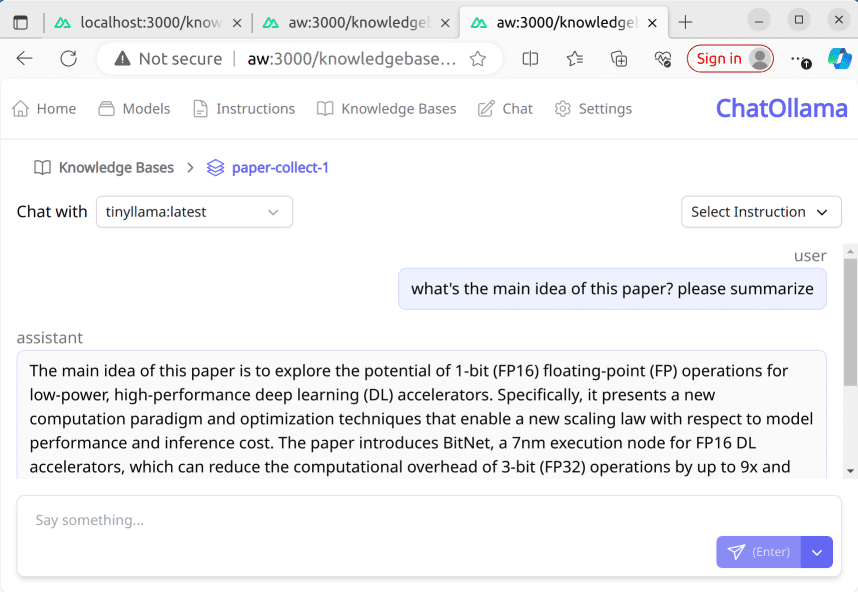

ChatOllama是一个基于大型语言模型(LLM)的开源在线聊天应用项目,支持众多语言模型和知识库管理。用户可以通过该平台进行模型管理(列表展示、下载、删除)、与模型聊天等功能。项目运用了Nuxt 3框架,并提供了详尽的设置指南与开发服务器指引,适合对聊天机器人开发感兴趣的开发者浏览和贡献。

功能列表

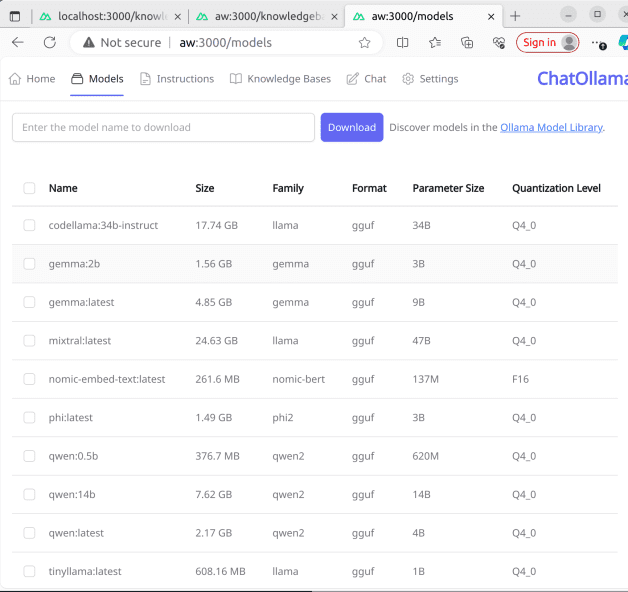

模型管理:包括模型列表查看、下载和删除

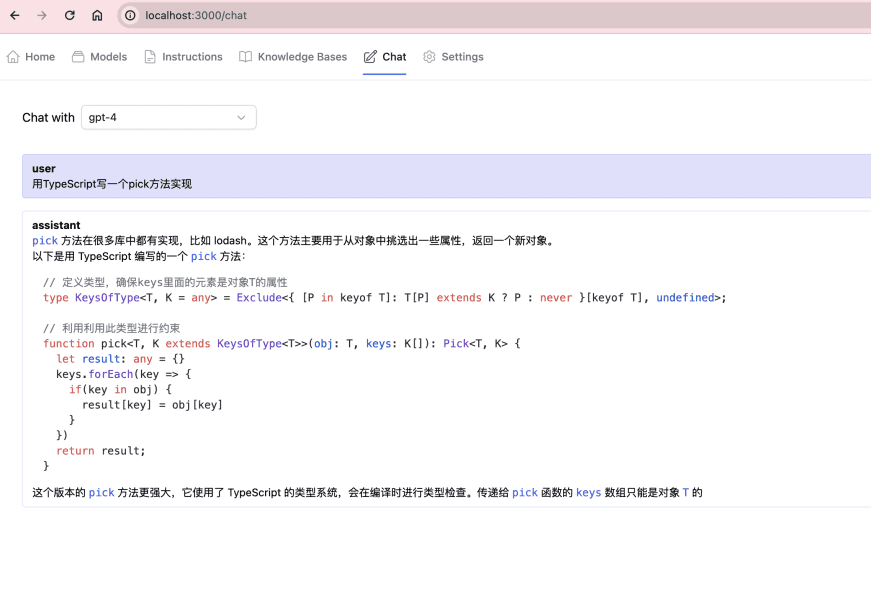

与聊天模型互动的能力

支持多种语言模型和知识库管理(知识库基于LangChain)

基于Nuxt 3开发,使用Vue和TypeScript编写

使用帮助

先安装依赖:npm install,pnpm install,yarn install或bun install

确保有运行的Ollama服务器,本地环境默认运行在http://localhost:11434

在http://localhost:3000上启动开发服务器:npm run dev

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...