综合介绍

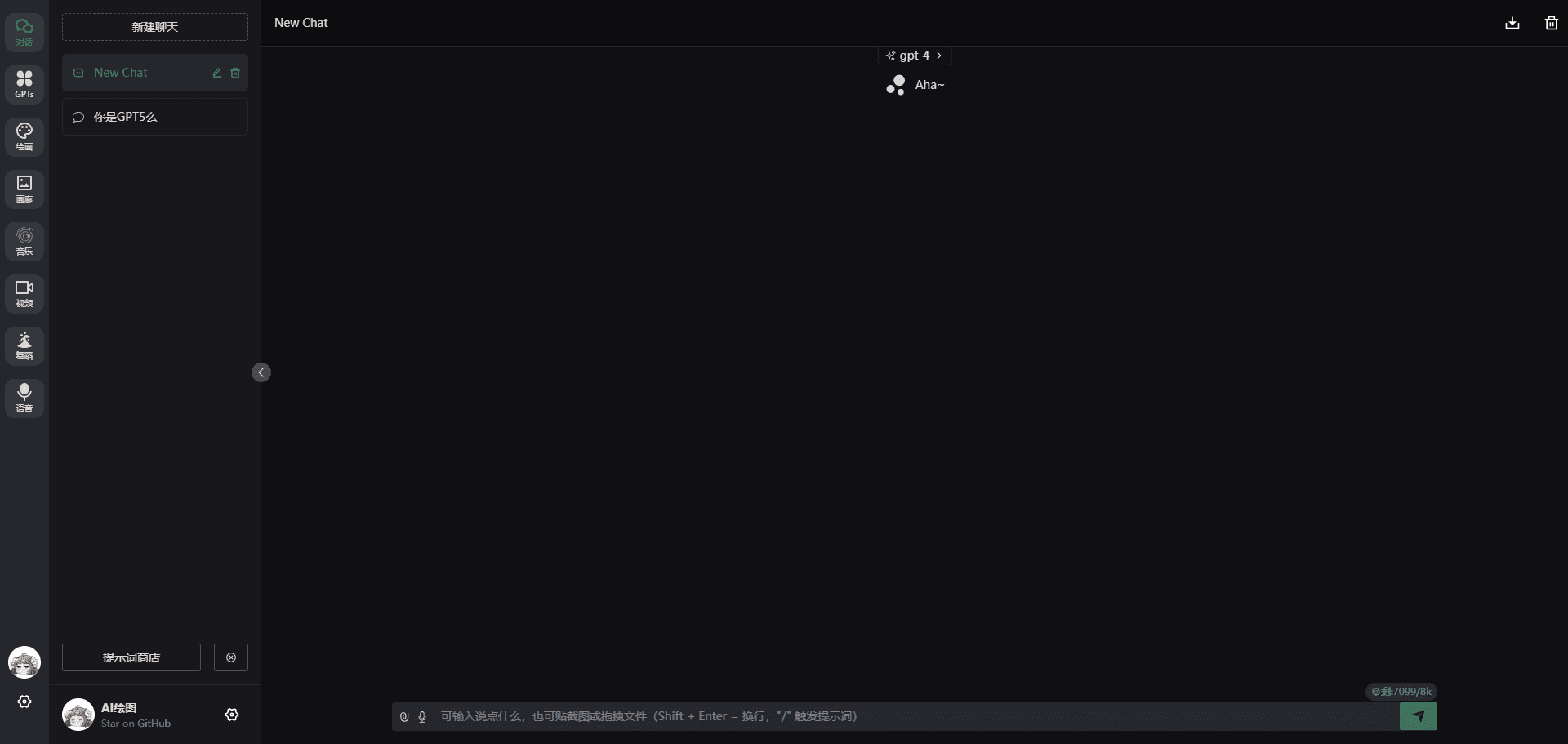

ChatGPT Web Midjourney Proxy 是一个开源项目,该项目在 ChatGPT-Web 的基础上进行二次开发,旨在整合多种AI工具于一体,提供统一的用户界面。该项目由Dooy开发,基于MIT协议发布,支持多平台(Web / PWA / Linux / Win / MacOS)。使用 Midjourney-proxy 和 Suno-API 等作为后端,用户可以通过该平台体验ChatGPT、Midjourney、GPTs、Suno、Luma、Runway、Viggle、Flux、Ideogram、Realtime、Pika、Udio等多种AI工具,方便快捷地进行文本生成、图像生成、视频生成等操作。

本开源是在 ChenZhaoYu 基础上做二次开发 ;使用 midjourney-proxy 或者 trueai(代理 MidJourney 的discord频道,实现api形式调用AI绘图) 、 Suno-API、Luma-API(逆向) 作为后端API而形成的。

功能列表

- 支持 ChatGPT 文本生成

- 支持 Midjourney 图像生成,包括文生图、垫图+文生图、图变等操作

- 支持 Suno 音乐生成,提供歌词调整和曲风调整功能

- 支持 Luma 视频生成,支持文生视频和图生视频

- 支持多种 AI 模型的自定义和切换

- 支持多平台(Web / PWA / Linux / Win / MacOS)

- 支持 Docker 部署和 Vercel 一键部署

- 支持多种语言界面(包括中文、英文、法语、韩语等)

使用帮助

安装流程

- Windows安装包:下载最新版本的安装包,选择适合你的操作系统版本。

- Docker 安装:

- 下载最新版本的 Docker 镜像:

docker pull ydlhero/chatgpt-web-midjourney-proxy - 运行 Docker 容器:

docker run --name chatgpt-web-midjourney-proxy -d -p 6015:3002 \ -e OPENAI_API_KEY=sk-xxxxx \ -e OPENAI_API_BASE_URL=https://api.openai.com \ -e MJ_SERVER=https://your-mj-server:6013 \ -e MJ_API_SECRET=your-mj-api-secret \ -e LUMA_SERVER=https://your-luma-server:8000 \ -e LUMA_KEY=your-luma-key \ -e SUNO_SERVER=https://your-suno-server:8000 \ -e SUNO_KEY=your-suno-key \ ydlhero/chatgpt-web-midjourney-proxy

- 下载最新版本的 Docker 镜像:

- Vercel 部署:

- 在 Vercel 平台上创建一个新项目,并连接到 GitHub 仓库。

- 配置环境变量:

OPENAI_API_KEY:OpenAI API 密钥OPENAI_API_BASE_URL:OpenAI API 接口地址MJ_SERVER:Midjourney 代理服务器地址MJ_API_SECRET:Midjourney API 密钥LUMA_SERVER:Luma API 服务器地址LUMA_KEY:Luma API 密钥SUNO_SERVER:Suno API 服务器地址SUNO_KEY:Suno API 密钥

- 部署完成后,即可访问 Vercel 提供的 URL 进行使用。

- 一键部署地址

使用流程

- 文本生成:

- 进入 ChatGPT 模块,输入需要生成的文本内容,点击生成按钮,即可获得 AI 生成的文本。

图像生成:

图像生成:- 进入 Midjourney 模块,选择文生图或垫图+文生图模式,输入描述文字或上传垫图,点击生成按钮,即可获得 AI 生成的图像。

- 支持图变、局部重绘、变焦、高清等多种操作。

音乐生成:

音乐生成:- 进入 Suno 模块,输入歌词或选择曲风,点击生成按钮,即可获得 AI 生成的音乐。

- 支持歌词调整和曲风调整功能。

视频生成:

视频生成:- 进入 Luma 模块,选择文生视频或图生视频模式,输入描述文字或上传图片,点击生成按钮,即可获得 AI 生成的视频。

自定义模型:

自定义模型:- 在设置中选择自定义模型,输入模型名称和 API 地址,即可切换到自定义的 AI 模型进行生成。

高级设置

- API自定义:在设置页面,你可以自定义API接口,输入你的API Key和Base URL,以便使用你自己的AI模型。

- 多平台支持:该应用支持Web、PWA、Linux、Windows和MacOS平台,你可以在不同设备上无缝切换使用。

- 实时交互:通过OpenAI实时交互功能,你可以与AI进行即时对话,获取实时反馈和建议。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...

图像生成:

图像生成: 音乐生成:

音乐生成: 视频生成:

视频生成: 自定义模型:

自定义模型: