综合介绍

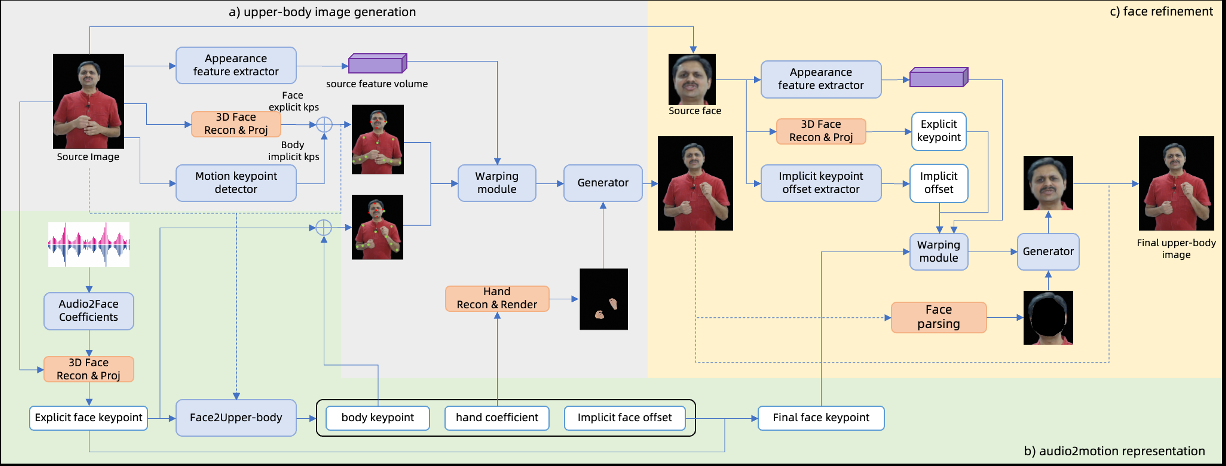

ChatAnyone 是 HumanAIGC 团队开发的一个创新项目。它利用人工智能技术,从单张照片和音频输入生成带有上半身动作的数字人肖像视频。这个项目基于层次运动扩散模型,能生成头部动作、手势和表情,适用于展示虚拟形象或数字人动画。ChatAnyone 的特点是高效生成,支持 512×768 分辨率和 30 帧每秒的视频输出。目前项目在 GitHub 上展示技术细节,但尚未完全开源,吸引了许多对数字人生成技术感兴趣的用户关注。

功能列表

- 照片生成视频:从单张照片和音频输入生成带有上半身动作的数字人视频。

- 动作控制:支持生成头部、手势和表情的自然动作。

- 音频同步:唇部动作与音频匹配,提升真实感。

- 高效性能:在 4090 GPU 上支持 512×768 分辨率、30 帧每秒的输出。

- 技术展示:通过 GitHub 页面分享成果,供用户了解和探讨。

使用帮助

ChatAnyone 目前是一个技术展示项目,未完全开源,因此无法直接下载或安装。以下内容基于官方信息,详细介绍其功能和操作逻辑,帮助用户理解项目并期待未来可能的开放使用。

主要功能操作

1. 从照片生成视频

- 操作逻辑:用户提供一张肖像照片和一段音频(如说话或歌唱录音),系统会生成带有上半身动作的数字人视频。视频包括头部转动、手势等动作。

- 效果:输出视频分辨率最高为 512×768,帧率 30 帧每秒。数字人动作与音频节奏匹配,适合展示虚拟形象。

- 使用方式:目前通过官方展示视频或文档了解功能,未来可能开放测试版本。

2. 动作控制

- 操作逻辑:系统能根据音频生成自然的上半身动作,包括头部和手的动态。用户可通过示例了解动作范围。

- 效果:生成的数字人可以呈现不同动作风格,如点头、手势变化,增强表现力。

- 使用方式:此功能在展示阶段,用户可通过 GitHub 页面查看效果。

3. 音频同步

- 操作逻辑:输入清晰音频后,系统生成与声音节奏一致的唇部动作。

- 效果:唇部与音频高度同步,适用于虚拟主播或动画展示。

- 使用方式:目前通过官方样例视频体验,未来可能支持用户测试。

如何获取更多信息

- 访问官方页面:前往

https://github.com/HumanAIGC/chat-anyone,查看项目说明和展示视频。 - 关注更新:项目尚未开源,但团队可能在未来发布代码或工具。建议定期检查 GitHub 仓库。

- 联系团队:如有合作需求,可通过 GitHub 留言或寻找官方联系方式。

注意事项

- ChatAnyone 目前是技术展示项目,无法直接使用。

- 生成需要高性能硬件(如 4090 GPU),普通用户难以本地体验。

- 项目未来可能开源,届时会有更详细指南。

应用场景

- 虚拟形象展示

用户可以用照片生成数字人视频,展示个性化虚拟形象。 - 动画内容制作

创作者可利用生成的半身数字人视频,制作短片或演示内容。 - 技术研究

研究者可以通过项目了解音频驱动的数字人生成技术。

QA

- ChatAnyone 可以实时聊天吗?

目前不行。它专注于从照片和音频生成视频,不是实时聊天工具。 - 支持哪些类型的照片?

官方展示以人像照片为主,具体要求可参考未来文档。 - 视频能商用吗?

目前没有明确许可,需等待开源后查看协议。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...