综合介绍

AgenticSeek 是一个完全本地运行的开源AI助手,基于 Deepseek R1 模型开发。它不需要云端API,也不产生每月数百美元的费用。它的目标是成为类似电影中“贾维斯”的智能助手,能在用户电脑上完成代码编写、文件管理、网页浏览等任务,同时保证数据隐私。开发者 Martin Legrand 将其定位为 Manus AI 的本地替代品,强调100%本地运行。截至2025年3月,GitHub 上已有181个星标和16次分叉,社区持续活跃,欢迎贡献者加入。

功能列表

- 完全本地运行:无需联网,所有计算在用户设备上完成,数据不外泄。

- 语音交互:支持语音输入指令和语音回复,提升操作便利性。

- 文件系统操作:通过 Bash 浏览和处理本地文件。

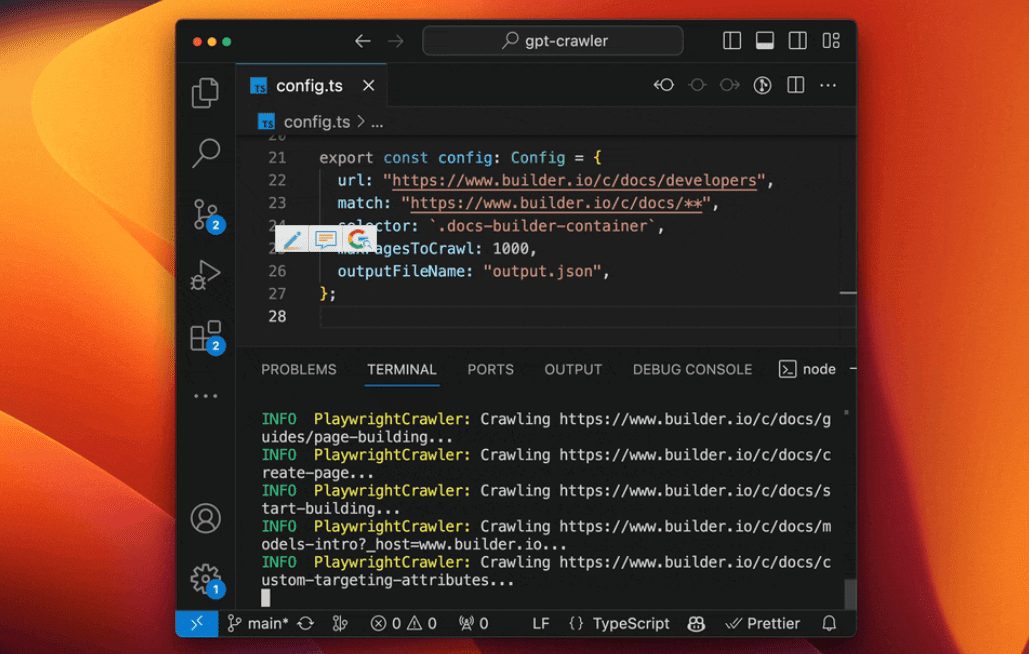

- 代码编写与调试:支持 Python、C、Golang 等语言的代码生成和错误修复。

- 自主纠错:遇到命令失败或代码出错时,AI 会自动重试并修复。

- 智能任务分配:根据任务类型自动选择合适的功能模块。

- 多代理协作:复杂任务可拆分,由多个代理规划和执行。

- 工具支持:内置搜索、文件探索等实用工具。

- 记忆功能:保留对话历史和用户偏好,支持长上下文交流。

- 网页浏览:可自主导航网页并提取信息。

使用帮助

AgenticSeek 的安装和使用需要一些技术基础,但步骤清晰。以下是详细指南,确保你能快速上手。

安装流程

- 环境准备

- 确保电脑支持 Python 3,推荐至少8GB内存,GPU 需8GB以上显存(14B 模型建议12GB)。

- 安装 Git,用于下载代码。

- 下载并安装 Ollama(本地模型运行工具),这是核心依赖。访问 Ollama 官网 获取。

- 下载 AgenticSeek

- 打开终端(Windows 用 CMD 或 PowerShell,Mac/Linux 用 Terminal)。

- 输入命令克隆项目:

git clone https://github.com/Fosowl/agenticSeek.git - 进入项目目录:

cd agenticSeek

- 创建虚拟环境

- 输入命令创建独立环境:

python3 -m venv agentic_seek_env - 激活环境:

- Windows:

agentic_seek_env\Scripts\activate - Mac/Linux:

source agentic_seek_env/bin/activate

- Windows:

- 输入命令创建独立环境:

- 安装依赖

- 激活环境后,运行:

pip install -r requirements.txt - 或使用自动安装脚本(Mac/Linux):

./install.sh

- 激活环境后,运行:

- 配置并下载模型

- 确保 Ollama 已安装,启动服务:

ollama serve - 下载 Deepseek R1 模型(推荐 14B,7B 适用于低配置设备):

ollama pull deepseek-r1:14b - 编辑

config.ini,设置本地运行:[MAIN] is_local = True provider_name = ollama provider_model = deepseek-r1:14b

- 确保 Ollama 已安装,启动服务:

- 启动 AgenticSeek

- 输入:

python main.py - 看到终端提示即表示成功运行。

- 输入:

功能操作流程

语音交互

- 开启方法:在

config.ini中设置speak = True和listen = True。 - 使用:启动后说“开始语音模式”,然后用语音提问,比如“帮我写代码”。

- 细节:AI 会用语音回答,确保麦克风和扬声器正常。

- 注意:首次使用可能需调整音量,低端设备可能有延迟。

文件系统操作

- 设置目录:在

config.ini中指定work_dir,如/Users/你的用户名/文档。 - 使用:输入“列出所有文本文件”,AI 会返回结果。

- 高级功能:说“分析这个文件内容”,它会提取关键信息。

- 技巧:支持 Bash 命令,比如“创建新文件夹”。

代码编写与调试

- 操作方法:输入“写一个 Python 排序算法”,AI 会生成代码。

- 调试:如果代码出错,说“修复这个错误”,AI 会分析并修改。

- 支持语言:目前包括 Python、C、Golang,后续会扩展。

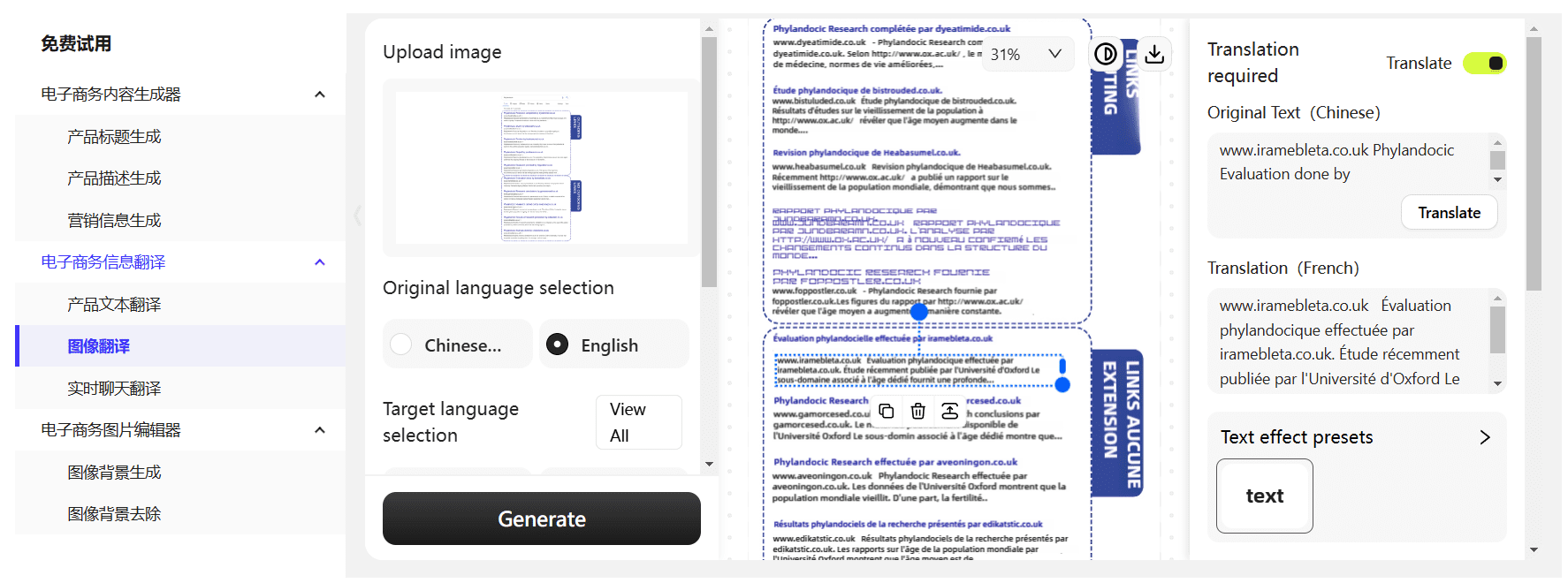

网页浏览

- 使用:输入“查找最新AI新闻”,AI 会导航网页并整理信息。

- 限制:目前只提取文本,不支持图片或视频解析。

- 技巧:可指定关键词,如“搜索 Deepseek R1 更新”。

自主纠错

- 操作方法:无需特别设置。若命令失败,AI 自动尝试修复。

- 示例:输入错误指令“打开文件X”,AI 会提示文件不存在并建议替代方案。

远程运行(可选)

- 场景:如果本地设备性能不足,可用服务器运行模型。

- 步骤:

- 在服务器上启动 Ollama 并获取 IP(如

192.168.1.100)。 - 运行服务器脚本:

python server_ollama.py - 本地修改

config.ini:[MAIN] is_local = False provider_name = server provider_model = deepseek-r1:14b provider_server_address = 192.168.1.100:5000 - 本地运行:

python main.py

- 在服务器上启动 Ollama 并获取 IP(如

注意事项

- 硬件要求:7B 模型需8GB显存,14B 需12GB(如 RTX 3060),32B 需24GB+。

- 调试:若启动失败,检查 Ollama 是否运行,或查看终端错误日志。

- 更新:定期运行

git pull获取最新功能。 - 许可:项目使用 GPL-3.0 协议,开源且免费。

应用场景

- 编程辅助

你在写代码时卡住,比如调试复杂逻辑。AgenticSeek 能生成代码并修复错误,还能解释代码细节。 - 文件管理

电脑文件杂乱无章。设置目录后,AI 能列出文件、提取内容,甚至执行批量操作。 - 学习支持

学生可以用它分析文档、搜索资料,通过语音交互记笔记,提高效率。 - 隐私任务

处理敏感数据时,AgenticSeek 本地运行不联网,确保信息安全。

QA

- 真的100%本地运行吗?

是的,使用 Ollama 或 Server 模式时,所有处理都在本地,非本地选项(如 OpenAI)仅为备选。 - 硬件不够怎么办?

用 7B 模型,或通过远程服务器运行更高模型。 - 出错怎么办?

确保 Ollama 运行,检查config.ini配置。若仍失败,可在 GitHub 提交 issue。 - 比 Manus AI 好在哪?

它专注本地运行和隐私保护,适合不愿用云服务的用户。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...