综合介绍

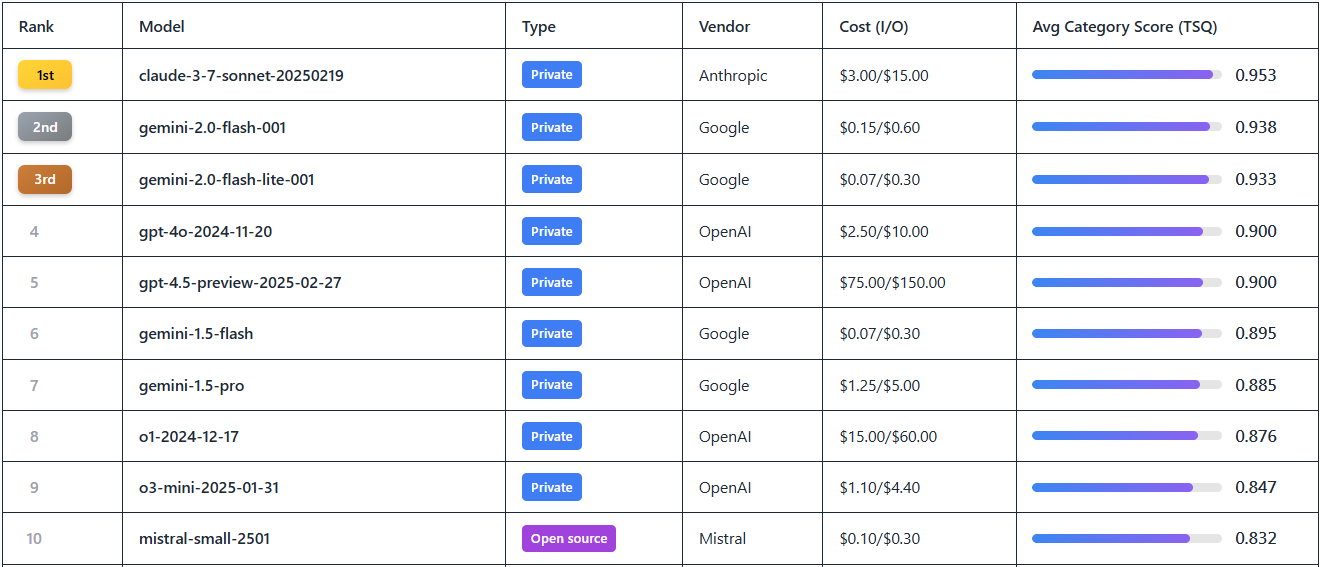

Agent Leaderboard 是由 Galileo AI 在 Hugging Face 平台上推出的一个专注于 AI 代理性能评估的在线工具。它通过综合多个权威数据集(如 BFCL、τ-bench、xLAM 和 ToolACE),对 17 种领先的大型语言模型(LLM)进行测试,涵盖从简单 API 调用到复杂多工具交互的场景。网站旨在回答“AI 代理在真实业务场景中的表现如何”,帮助开发者和企业选择适合自身需求的模型。排行榜每月更新,支持查看模型排名、得分、成本等信息,适用于需要构建高效 AI 代理系统的团队。无论是开源模型还是私有模型,用户都能在这里直观对比其性能。查看分析报告:Hugging Face 推出 Agent 智能体排行榜: 谁是工具调用领域的领导者?

功能列表

- 模型性能排名: 显示 17 种主流 LLM 的排名,如 Gemini-2.0 Flash、GPT-4o 等,基于工具选择质量(TSQ)评分。

- 多维度评估数据: 提供跨领域测试结果,覆盖数学、零售、航空、API 交互等 390 多个场景。

- 成本与效率对比: 展示每种模型的每百万 token 成本(如 Gemini-2.0 Flash $0.15 vs GPT-4o $2.5),便于性价比分析。

- 筛选与查看工具: 支持按供应商、开源/私有状态、得分等条件筛选模型,快速定位所需信息。

- 数据集开源访问: 提供测试数据集下载链接,方便开发者研究和验证。

- 动态更新机制: 每月更新排行榜,同步最新模型发布和性能数据。

使用帮助

如何访问与使用

Agent Leaderboard 是一个无需安装的在线工具,用户只需打开浏览器,访问 https://huggingface.co/spaces/galileo-ai/agent-leaderboard 即可使用。页面加载后,映入眼帘的是一个直观的排行榜表格,无需注册或登录即可浏览所有公开数据。如果需要更深入参与(如下载数据集或提出建议),可以注册 Hugging Face 账户。

操作流程

- 浏览排行榜

- 打开网页后,首页默认展示当前排名前 17 的 LLM 模型。

- 表格列包括“排名(Rank)”、“模型名称(Model)”、“供应商(Vendor)”、“得分(Score)”、“成本(Cost)”和“类型(开源/私有)”。

- 示例:排名第一的 Gemini-2.0 Flash,得分 0.9+,成本 $0.15/百万 token。

- 筛选与对比模型

- 点击表格上方的筛选框,可以选择“供应商”(如 Google、OpenAI)、“类型”(开源或私有)或“得分区间”。

- 例如,输入“OpenAI”后,页面会过滤出 GPT-4o、o1 等模型,方便对比其性能。

- 若想查看成本效益,可按“Cost”列排序,找到价格最低的选项。

- 查看详细评估数据

- 点击任一模型名称(如 Gemini-1.5-Pro),会弹出具体性能报告。

- 报告包括模型在不同数据集上的表现,例如在 τ-bench 的零售场景得分、在 ToolACE 的 API 交互得分等。

- 数据以图表形式展示,直观呈现模型在多工具任务或长上下文场景中的强弱。

- 下载开源数据集

- 页面底部有“Dataset”链接,点击跳转至

https://huggingface.co/datasets/galileo-ai/agent-leaderboard。 - 用户可下载完整测试数据集(如 BFCL 的数学题库、xLAM 的跨领域数据),用于本地分析或二次开发。

- 下载前需登录 Hugging Face 账户,若无账户,可点击页面右上角“Sign Up”注册,过程简单,仅需邮箱验证。

- 页面底部有“Dataset”链接,点击跳转至

- 获取更新动态

特色功能操作详解

- 工具选择质量(TSQ)评分解读

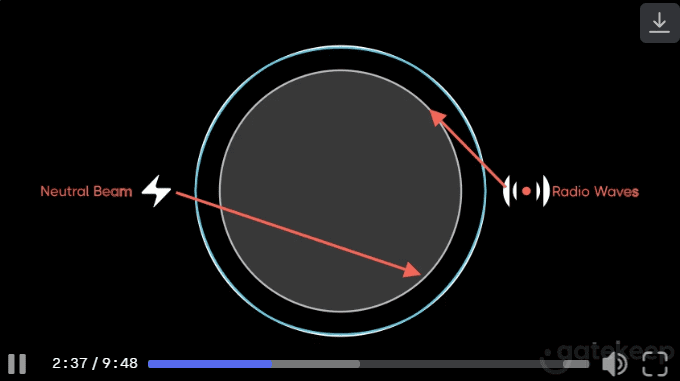

- TSQ 是 Agent Leaderboard 的核心评估指标,衡量模型在工具使用中的准确性。

- 操作示例:选择 GPT-4o,查看其 TSQ 得分 0.9,细项显示它在多工具协同任务中表现优异,但在长上下文场景稍弱。

- 使用建议:如果你的项目涉及复杂工作流,选择 TSQ 高于 0.85 的模型。

- 多领域测试结果分析

- 点击“Evaluation Details”,可查看模型在 14 个基准测试中的表现。

- 示例:Gemini-2.0 Flash 在 BFCL(数学与教育)得分 0.92,在 ToolACE(API 交互)得分 0.89。

- 使用场景:需要处理航空数据的团队可参考 τ-bench 结果,挑选擅长该领域的模型。

- 成本优化决策

- 在表格“Cost”列查看每百万 token 的输入/输出价格。

- 操作示例:筛选“Cost < $1”,结果显示 Mistral-small-2501($0.5/百万 token),适合预算有限的项目。

- 小贴士:结合得分和成本,平衡性能与开支。

注意事项

- 数据更新时间: 当前数据截至 2025 年 2 月,建议定期访问以获取最新排名。

- 社区反馈: 若需新模型(如 Grok 3),可在 Hugging Face 页面留言,官方会根据 API 可用性响应。

- 技术要求: 网页对网络要求低,但下载数据集需稳定连接,建议使用桌面端操作。

通过以上步骤,用户可以快速上手 Agent Leaderboard,无论是寻找高性能模型,还是研究 AI 代理的技术细节,这个工具都能提供实用支持。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...