摘要

大型语言模型(LLMs),如OpenAI的GPT-4、Google的PaLM和Meta的LLaMA,通过实现类人文本生成和自然语言理解,极大地改变了人工智能(AI)。然而,它们对静态训练数据的依赖限制了其响应动态、实时查询的能力,导致输出过时或不准确。检索增强生成(RAG)作为一种解决方案应运而生,通过整合实时数据检索来增强LLMs,从而提供上下文相关且及时响应的能力。尽管RAG前景广阔,但传统的RAG系统在静态工作流程和缺乏适应多步骤推理和复杂任务管理所需的灵活性方面受到限制。

代理式检索增强生成(Agentic RAG)通过将自主AI代理嵌入RAG流程,克服了这些限制。这些代理利用代理式设计模式——反思、规划、工具使用和多代理协作——动态管理检索策略,迭代完善上下文理解,并适应工作流程以满足复杂任务的要求。这种集成使Agentic RAG系统能够在各种应用中提供无与伦比的灵活性、可扩展性和上下文感知能力。

本综述全面探讨了Agentic RAG,从其基础原理和RAG范式的演变开始。它详细介绍了Agentic RAG架构的分类,突出了其在医疗、金融和教育等行业的关键应用,并探讨了实际实施策略。此外,它还讨论了扩展这些系统、确保道德决策和优化现实应用性能的挑战,同时提供了实施Agentic RAG的框架和工具的详细见解。

关键词: 大型语言模型(LLMs)·人工智能(AI)·自然语言理解·检索增强生成(RAG)·代理式RAG·自主AI代理·反思·规划·工具使用·多代理协作·代理式模式·上下文理解·动态适应性·可扩展性·实时数据检索·Agentic RAG分类·医疗应用·金融应用·教育应用·道德AI决策·性能优化·多步骤推理

1 引言

大型语言模型(LLMs)[1, 2] [3],如OpenAI的GPT-4、Google的PaLM和Meta的LLaMA,通过生成类人文本和执行复杂的自然语言处理任务,极大地改变了人工智能(AI)。这些模型推动了对话领域的创新[4],包括对话代理、自动化内容创作和实时翻译。最近的进展将它们的能力扩展到多模态任务,如文本到图像和文本到视频生成[5],能够根据详细的提示创建和编辑视频和图像[6],这扩大了生成式AI的潜在应用范围。

尽管取得了这些进展,LLMs由于依赖静态预训练数据,仍然面临重大限制。这种依赖性通常会导致信息过时、产生幻觉式的响应[7]以及无法适应动态的现实世界场景。这些挑战强调了需要能够整合实时数据并动态完善响应的系统,以保持上下文相关性和准确性。

检索增强生成(RAG)[8, 9]作为解决这些挑战的有前途的解决方案应运而生。RAG通过将LLMs的生成能力与外部检索机制[10]相结合,增强了响应的相关性和及时性。这些系统从知识库[11]、API或网络等来源检索实时信息,有效地弥合了静态训练数据与动态应用需求之间的差距。然而,传统的RAG工作流程仍然受到其线性和静态设计的限制,这限制了其执行复杂的多步骤推理、整合深度上下文理解以及迭代完善响应的能力。

代理[12]的演变进一步增强了AI系统的能力。现代代理,包括基于LLM和移动代理[13],是能够感知、推理和自主执行任务的智能实体。这些代理利用代理式工作流程模式,如反思[14]、规划[15]、工具使用和多代理协作[16],使它们能够管理动态工作流程并解决复杂问题。

RAG与代理智能的融合催生了代理式检索增强生成(Agentic RAG)[17],这是一种将代理集成到RAG流程中的范式。Agentic RAG实现了动态检索策略、上下文理解和迭代完善[18],允许自适应和高效的信息处理。与传统的RAG不同,Agentic RAG采用自主代理来编排检索、过滤相关信息和完善响应,在需要精确性和适应性的场景中表现出色。

本综述探讨了Agentic RAG的基础原理、分类和应用。它提供了RAG范式的全面概述,如简单RAG、模块化RAG和图RAG[19],以及它们向Agentic RAG系统的演变。主要贡献包括详细的Agentic RAG框架分类、在医疗[20, 21]、金融和教育[22]等领域的应用,以及对实施策略、基准和道德考虑的见解。

本文的结构如下:第2节介绍RAG及其演变,强调传统方法的局限性。第3节详细阐述了代理智能和代理模式的原则。第4节提供了Agentic RAG系统的分类,包括单代理、多代理和基于图的框架。第5节考察了Agentic RAG的应用,而第6节讨论了实施工具和框架。第7节侧重于基准和数据集,第8节以Agentic RAG系统的未来方向结束。

2 检索增强生成的基础

2.1 检索增强生成(RAG)概述

检索增强生成(RAG)代表了人工智能领域的一项重大进步,它结合了大型语言模型(LLMs)的生成能力与实时数据检索。虽然LLMs在自然语言处理方面表现出非凡的能力,但它们对静态预训练数据的依赖性通常会导致响应过时或不完整。RAG通过从外部来源动态检索相关信息并将其纳入生成过程,解决了这一局限性,从而能够生成上下文准确且及时响应的输出。

2.2 RAG的核心组成部分

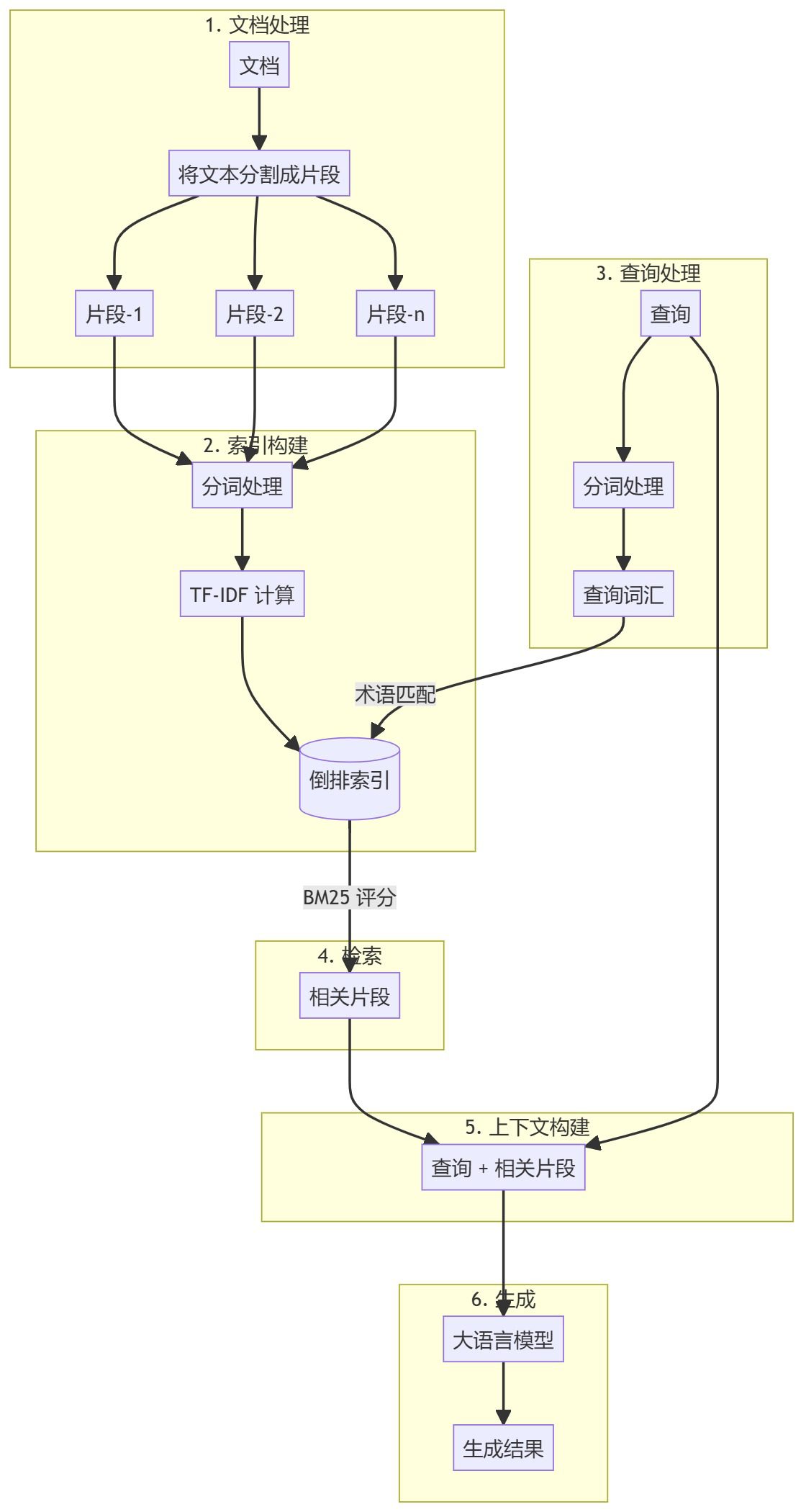

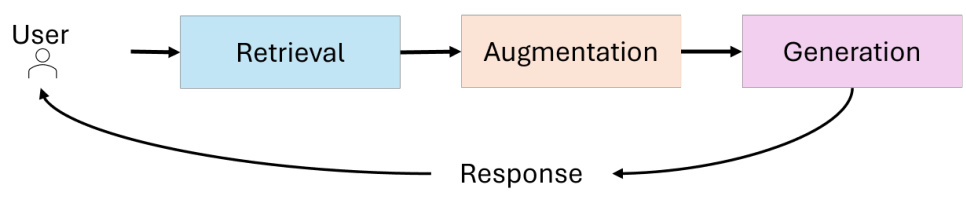

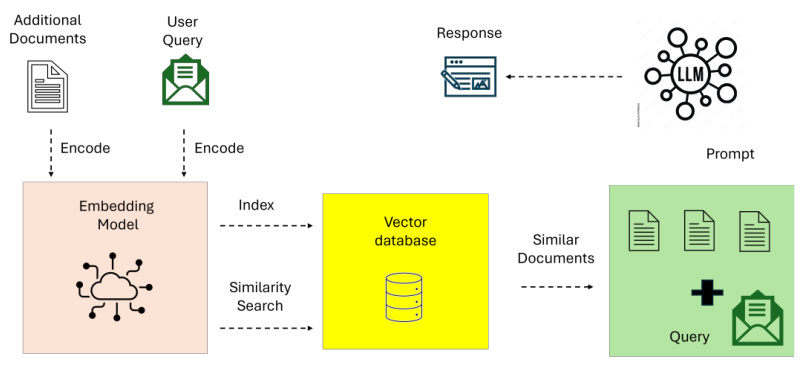

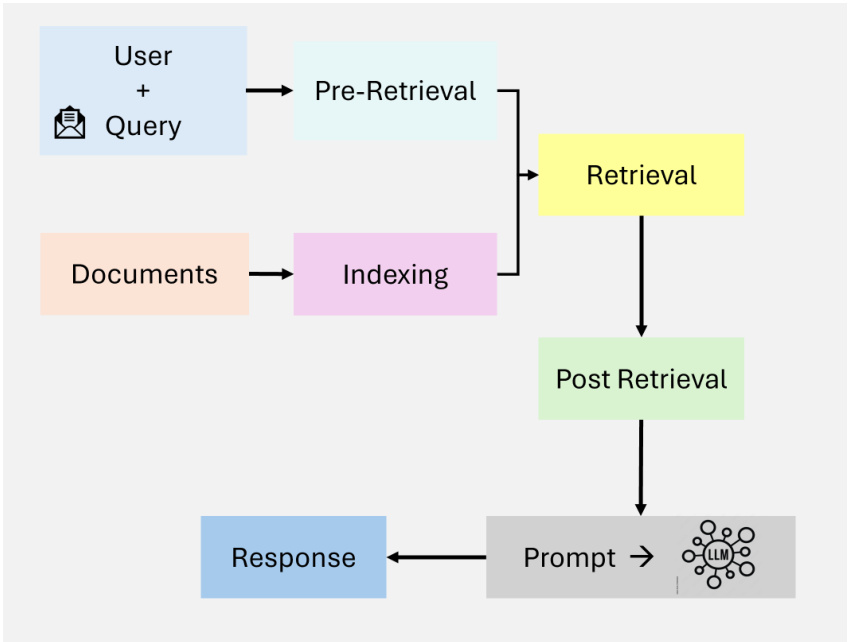

RAG系统的架构集成了三个主要组件(见图1):

- 检索:负责查询外部数据源,如知识库、API或向量数据库。先进的检索器利用密集向量搜索和基于Transformer的模型来提高检索精度和语义相关性。

- 增强:处理检索到的数据,提取并总结与查询上下文最相关的信息。

- 生成:将检索到的信息与LLM的预训练知识相结合,生成连贯的、上下文适当的响应。

Figure 1: Core Components of RAG

2.3 RAG范式的演变

检索增强生成(RAG)领域已经取得了重大进展,以应对现实世界应用中日益增加的复杂性,在这些应用中,上下文准确性、可扩展性和多步骤推理至关重要。从简单的基于关键词的检索开始,它已经转变为能够整合各种数据源和自主决策过程的复杂、模块化和自适应系统。这种演变凸显了RAG系统高效有效地处理复杂查询的日益增长的需求。

本节考察了RAG范式的演变,介绍了发展的关键阶段——简单RAG、高级RAG、模块化RAG、图RAG和代理式RAG,以及它们的定义特征、优势和局限性。通过了解这些范式的演变,读者可以欣赏在检索和生成能力方面取得的进展,以及它们在各个领域的应用。

2.3.1 简单RAG

简单RAG[23]代表了检索增强生成的基础实现。图2说明了简单检索-读取工作流程的简单RAG,侧重于基于关键词的检索和静态数据集。这些系统依赖于简单的基于关键词的检索技术,如TF-IDF和BM25,从静态数据集中获取文档。然后使用检索到的文档来增强语言模型的生成能力。

Figure 2: An Overview of Naive RAG.

简单RAG的特点是简单易实施,适合处理涉及基于事实的查询且上下文复杂性最小的任务。然而,它存在几个局限性:

- 缺乏上下文感知:检索到的文档通常无法捕捉查询的语义细微差别,因为它们依赖于词汇匹配而不是语义理解。

- 输出碎片化:缺乏高级预处理或上下文整合通常会导致不连贯或过于通用的响应。

- 可扩展性问题:基于关键词的检索技术在处理大型数据集时往往表现不佳,通常无法识别最相关的信息。

尽管存在这些局限性,简单RAG系统为将检索与生成相结合提供了关键的概念验证,为更复杂的范式奠定了基础。

2.3.2 高级RAG

高级RAG[23]系统建立在简单RAG的局限性之上,通过整合语义理解和增强的检索技术。图3突出显示了高级RAG在检索中的语义增强和迭代的、上下文感知的流程。这些系统利用密集检索模型,如密集段落检索(DPR)和神经排名算法来提高检索精度。

Figure 3: Overview of Advanced RAG

高级RAG的关键特性包括:

- 密集向量搜索:查询和文档在高位向量空间中表示,从而使用户查询和检索到的文档之间更好地语义对齐。

- 上下文重新排序:神经模型重新排序检索到的文档,以优先考虑最具上下文相关性的信息。

- 迭代检索:高级RAG引入了多跳检索机制,能够对复杂查询进行跨多个文档的推理。

这些进步使高级RAG适用于需要高精确度和细致理解的应用,如研究综合和个性化推荐。然而,计算开销和有限的可扩展性问题仍然存在,特别是在处理大型数据集或多步骤查询时。

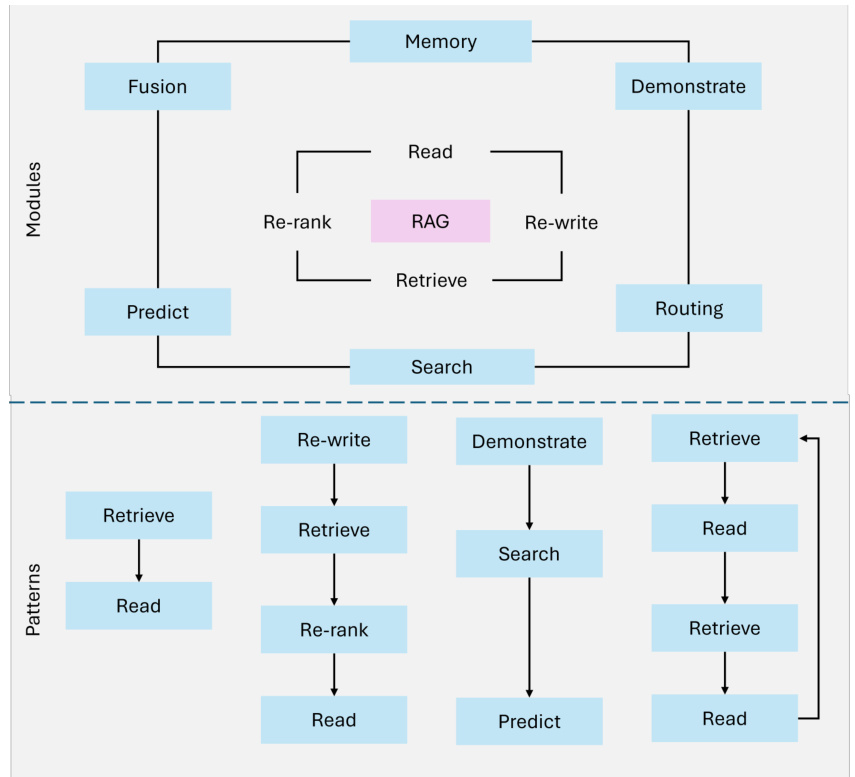

2.3.3 模块化RAG

模块化RAG[23]代表了RAG范式的最新发展,强调灵活性和定制化。这些系统将检索和生成流程分解为独立的、可重用的组件,从而实现特定领域的优化和任务适应性。图4展示了模块化架构,展示了混合检索策略、可组合的流程和外部工具集成。

模块化RAG的关键创新包括:

- 混合检索策略:结合稀疏检索方法(例如,稀疏编码器-BM25)和密集检索技术(例如,DPR - 密集段落检索)以最大化不同查询类型的准确性。

- 工具集成:整合外部API、数据库或计算工具来处理特定任务,例如实时数据分析或特定领域的计算。

- 可组合的流程:模块化RAG使检索器、生成器和其他组件能够被替换、增强或重新配置,独立地允许高度适应特定用例。

例如,一个为金融分析设计的模块化RAG系统可能会通过API检索实时股票价格,使用密集检索分析历史趋势,并通过定制的语言模型生成可操作的投资见解。这种模块化和定制化使模块化RAG非常适合复杂、多领域的任务,既提供了可扩展性又提供了精确性。

Figure 4: Overview of Modular RAG

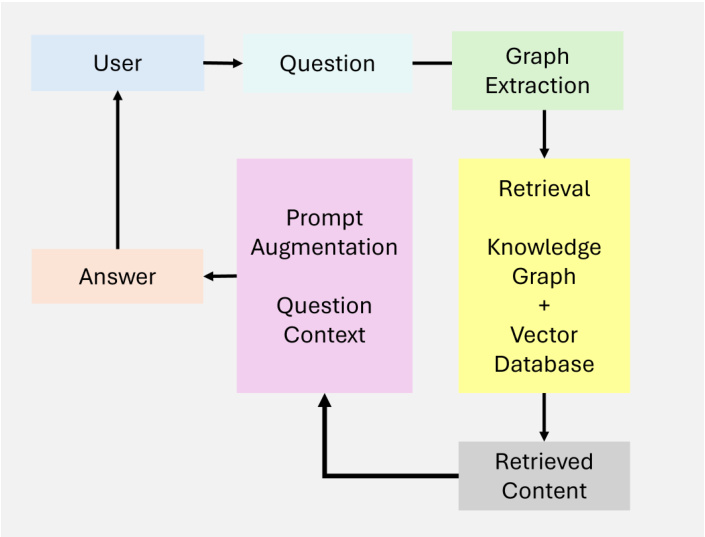

2.3.4 图RAG

图RAG[19]通过整合基于图的数据结构扩展了传统的检索增强生成系统,如图5所示。这些系统利用图数据中的关系和层次结构来增强多跳推理和上下文增强。通过整合基于图的检索,图RAG能够生成更丰富、更准确的生成输出,特别是对于需要关系理解的任务。

图RAG的特点是其能够:

- 节点连通性:捕捉并推理实体之间的关系。

- 层次化知识管理:通过图层次结构处理结构化和非结构化数据。

- 上下文增强:通过利用图路径添加关系理解。

然而,图RAG也有一些局限性:

- 可扩展性有限:对图结构的依赖可能会限制可扩展性,特别是对于广泛的数据源。

- 数据依赖性:高质量的图数据对于有意义的输出至关重要,这限制了其在对非结构化或注释不佳的数据集的应用。

- 集成复杂性:将图数据与无结构检索系统集成增加了设计和实现的复杂性。

图RAG非常适合医疗诊断、法律研究等领域的应用,在这些领域中,对结构化关系的推理至关重要。

Figure 5: Overview of Graph RAG

2.3.5 代理式RAG

代理式RAG代表了一种范式转变,它引入了能够进行动态决策和工作流程优化的自主代理。与静态系统不同,代理式RAG采用迭代完善和自适应检索策略来应对复杂、实时和多领域的查询。这种范式利用了检索和生成过程的模块化,同时引入了基于代理的自主性。

代理式RAG的关键特性包括:

- 自主决策:代理根据查询复杂性独立评估和管理检索策略。

- 迭代完善:整合反馈循环以提高检索准确性和响应相关性。

- 工作流程优化:动态编排任务,使实时应用更有效率。

尽管取得了这些进步,代理式RAG也面临一些挑战:

- 协调复杂性:管理代理之间的交互需要复杂的协调机制。

- 计算开销:使用多个代理会增加复杂工作流程的资源需求。

- 可扩展性限制:尽管可扩展,但系统的动态性可能会对高查询量造成压力。

代理式RAG在客户支持、金融分析和自适应学习平台等领域的应用表现出色,在这些领域中,动态适应性和上下文精确性至关重要。

2.4 传统RAG系统的挑战和局限性

传统的检索增强生成(RAG)系统通过整合实时数据检索,极大地扩展了大型语言模型(LLMs)的能力。然而,这些系统仍然面临一些关键挑战,阻碍了它们在复杂现实应用中的有效性。最显著的局限性集中在上下文整合、多步骤推理以及可扩展性和延迟问题。

2.4.1 上下文整合

即使RAG系统成功检索到相关信息,它们通常也很难将信息无缝地整合到生成的响应中。检索流程的静态性和有限的上下文感知导致输出碎片化、不一致或过于通用。

示例:一个查询如,“阿尔茨海默病研究的最新进展及其对早期治疗的启示”,可能会产生相关的科研论文和医疗指南。然而,传统的RAG系统通常无法将这些发现综合成连贯的解释,将新疗法与特定的患者场景联系起来。同样,对于一个查询如,“小型农业在干旱地区有哪些最佳可持续实践”,传统系统可能会检索关于一般农业方法的文件,但忽略了针对干旱环境的至关重要的可持续实践。

Table 1: Comparative Analysis of RAG Paradigms

| Paradigm | Key Features | Strengths |

|---|---|---|

| Naïve RAG | - Keyword-based retrieval (e.g., TF-IDF, BM25) | - Simple and easy to implement - Suitable for fact-based queries |

| Advanced RAG | - Dense retrieval models (e.g., DPR) - Neural ranking and re-ranking - Multi-hop retrieval | - High precision retrieval - Improved contextual relevance |

| Modular RAG | - Hybrid retrieval (sparse and dense) - Tool and API integration - Composable, domain-specific pipelines | - High flexibility and customization - Suitable for diverse applications - Scalable |

| Graph RAG | - Integration of graph-based structures - Multi-hop reasoning - Contextual enrichment via nodes | - Relational reasoning capabilities - Mitigates hallucinations - Ideal for structured data tasks |

| Agentic RAG | - Autonomous agents - Dynamic decision-making - Iterative refinement and workflow optimization | - Adaptable to real-time changes - Scalable for multi-domain tasks - High accuracy |

2.4.2 多步骤推理

许多现实世界的查询需要迭代或多跳推理——检索并综合多个步骤的信息。传统的RAG系统在根据中间洞察或用户反馈完善检索方面往往准备不足,导致响应不完整或不连贯。

示例:一个复杂的查询如,“欧洲可再生能源政策的经验教训可以应用于发展中国家,以及潜在的经济影响是什么?”需要协调多种信息,包括政策数据、对发展中地区的背景化以及经济分析。传统的RAG系统通常无法将这些不同的元素连接成一个连贯的响应。

2.4.3 可扩展性和延迟问题

随着外部数据源的数量增加,查询和排名大型数据集变得越来越计算密集。这导致了显著的延迟,从而破坏了系统在实时应用中提供及时响应的能力。

示例:在金融分析或实时客户支持等对时间敏感的环境中,由于查询多个数据库或处理大型文档集而造成的延迟可能会削弱系统整体效用。例如,在高频交易中检索市场趋势的延迟可能会导致错失机会。

2.5 代理式RAG:一个范式转变

传统的RAG系统,由于其静态的工作流程和有限的适应性,往往难以处理动态、多步骤推理和复杂的现实任务。这些局限性促使了代理智能的整合,从而产生了代理式RAG。通过整合能够进行动态决策、迭代推理和自适应检索策略的自主代理,代理式RAG在保持早期范式的模块化的同时,克服了它们固有的局限性。这种演变使得解决更复杂、多领域的任务成为可能,并增强了精确性和上下文理解,将代理式RAG定位为下一代AI应用的基础。特别是,代理式RAG系统通过优化的工作流程减少延迟,并逐步完善输出,解决了长期以来阻碍传统RAG可扩展性和有效性的挑战。

3 代理智能的核心原则和背景

代理智能构成了代理式检索增强生成(RAG)系统的基础,使它们能够超越传统RAG的静态和反应性质。通过整合能够进行动态决策、迭代推理和协作工作流程的自主代理,代理式RAG系统展现出更强的适应性和精确性。本节探讨了支撑代理智能的核心原则。

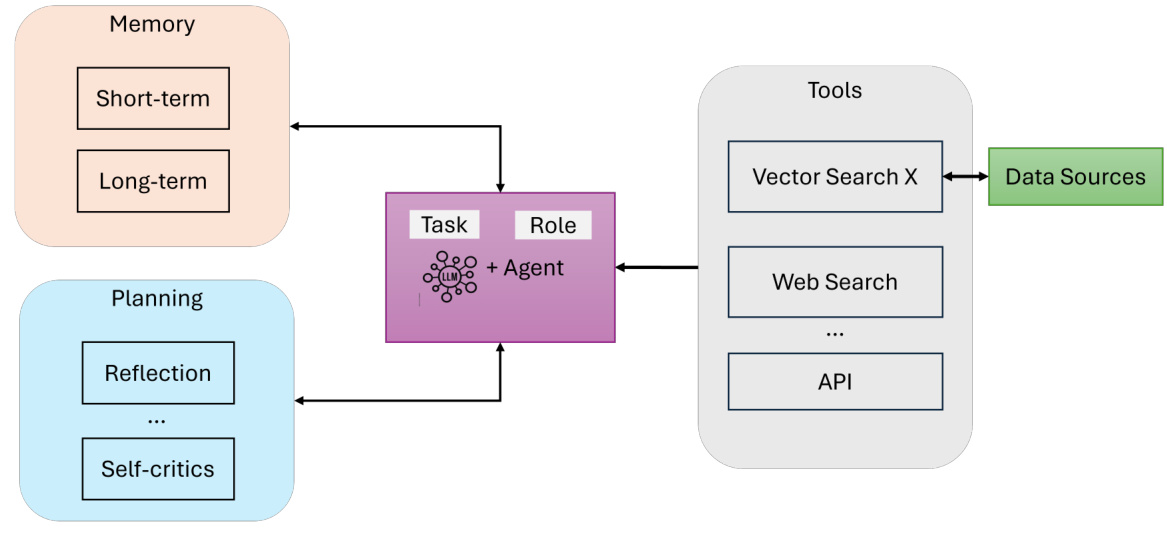

AI代理的组成部分。本质上,一个AI代理包括(见图6):

- LLM(具有定义的角色和任务):作为代理的主要推理引擎和对话接口。它解释用户查询,生成响应,并保持连贯性。

- 记忆(短期和长期):在交互过程中捕捉上下文和相关数据。短期记忆[25]跟踪即时的对话状态,而长期记忆[25]存储积累的知识和代理经验。

- 规划(反思和自我批评):通过反思、查询路由或自我批评[26]指导代理的迭代推理过程,确保复杂任务被有效分解[15]。

- 工具(向量搜索、网络搜索、API等):扩展代理的能力,使其超越文本生成,能够访问外部资源、实时数据或专业计算。

Figure 6: An Overview of AI Agents

3.1 代理模式

代理模式[27, 28]提供了结构化的方法,指导代理在代理式检索增强生成(RAG)系统中的行为。这些模式使代理能够动态适应、规划和协作,确保系统能够精确和可扩展地处理复杂的现实任务。四种关键模式构成了代理工作流程的基础:

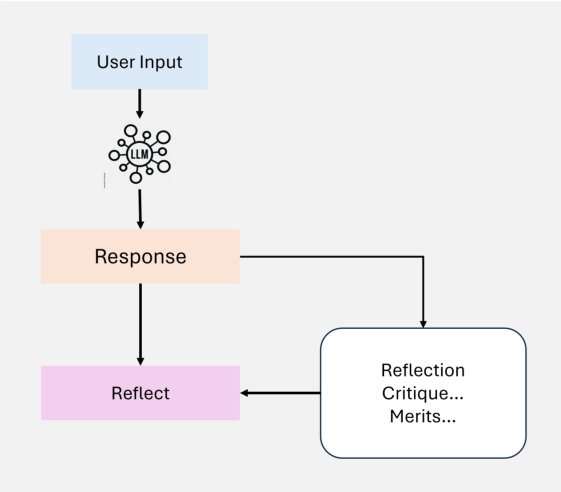

3.1.1 反思

反思是代理工作流程中的基础设计模式,它使代理能够迭代地评估和完善其输出。通过整合自我反馈机制,代理可以识别并解决错误、不一致和需要改进的地方,从而提高代码生成、文本生成和问答等任务的性能(如图7所示)。在实践中,反思涉及提示代理对其输出进行正确性、风格和效率方面的批评,然后将这种反馈纳入后续迭代中。外部工具,如单元测试或网络搜索,可以进一步增强这一过程,通过验证结果和突出差距来增强这一过程。

Figure 7: An Overview of Agentic Self- Reflection

在多代理系统中,反思可以涉及不同的角色,例如,一个代理生成输出,而另一个代理对其进行批评,从而促进协作改进。例如,在法律研究中,代理可以迭代地完善响应,通过重新评估检索到的案例法,确保准确性和全面性。在自我完善(Self-Refine)[29]、反思(Reflexion)[30]和CRITIC[26]等研究中,反思已显示出显著的性能提升。

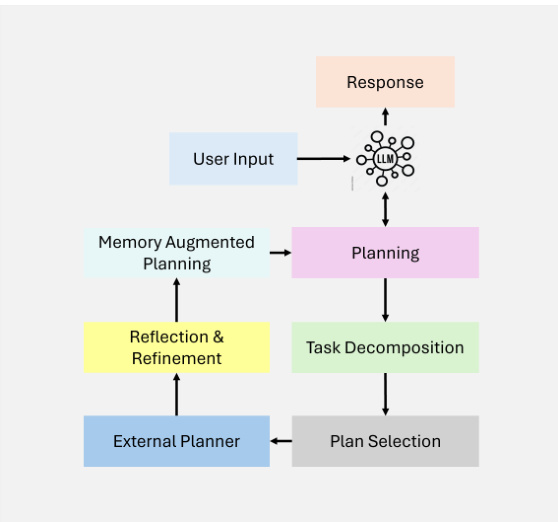

3.1.2 规划

规划[15]是代理工作流程中的关键设计模式,它使代理能够自主地将复杂任务分解为更小、更易管理的子任务。这一能力对于在动态和不确定场景中进行多跳推理和迭代问题解决至关重要(如图8所示)。

Figure 8: An Overview of Agentic Planning

通过利用规划,代理可以动态地确定完成更大目标所需的步骤顺序。这种适应性使代理能够处理无法预先定义的任务,确保决策的灵活性。虽然强大,但与反思等确定性工作流程相比,规划可能会产生较不可预测的结果。规划特别适合需要动态适应的任务,在这些任务中,预定义的工作流程是不够的。随着技术的成熟,其推动跨领域创新应用的潜力将继续增长。

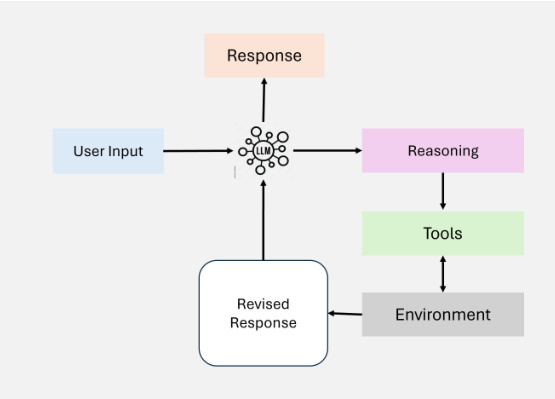

3.1.3 工具使用

工具使用使代理能够通过与外部工具、API或计算资源交互来扩展其能力,如图9所示。这种模式允许代理收集信息、执行计算和操作数据,超出了其预训练知识的范围。通过动态地将工具整合到工作流程中,代理可以适应复杂任务,并提供更准确和上下文相关的输出。

Figure 9: An Overview of Tool Use

现代代理工作流程将工具使用整合到各种应用中,包括信息检索、计算推理和与外部系统接口。该模式的实施随着GPT-4的功能调用能力和能够管理对众多工具访问的系统的发展而发生了重大演变。这些发展促进了复杂的代理工作流程,代理可以自主选择并执行给定任务的最相关的工具。

尽管工具使用极大地增强了代理工作流程,但在优化工具的选择方面仍然存在挑战,特别是在有大量可用选项的情况下。已经提出了受检索增强生成(RAG)启发的技术,例如基于启发式的选择,以解决这一问题。

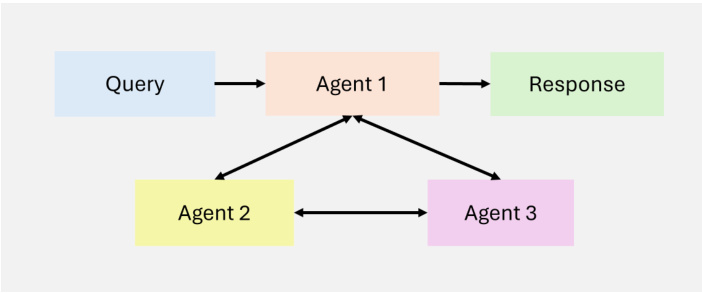

3.1.4 多代理

多代理协作[16]是代理工作流程中的关键设计模式,它实现了任务专业化和并行处理。代理之间相互通信并共享中间结果,确保整体工作流程保持高效和连贯。通过将子任务分配给专门的代理,这种模式提高了复杂工作流程的可扩展性和适应性。多代理系统允许开发人员将复杂的任务分解为更小、更易管理的子任务,分配给不同的代理。这种方法不仅提高了任务性能,还为管理复杂的交互提供了一个强大的框架。每个代理都有自己的记忆和工作流程,可以包括使用工具、反思或规划,从而实现动态和协作的问题解决(见图10)。

Figure 10: An Overview of MultiAgent

尽管多代理协作提供了巨大的潜力,但它是一个比反思和工具使用等更成熟的工作流程更不可预测的设计模式。尽管如此,像AutoGen、Crew AI和LangGraph等新兴框架正在为实施有效的多代理解决方案提供新的途径。

这些模式是代理式RAG系统成功的基石,使它们能够动态地适应检索和生成工作流程,以满足多样化、动态环境的需求。通过利用这些模式,代理可以处理迭代的、上下文感知的任务,超出了传统RAG系统的能力。

4 代理式RAG系统的分类

代理式检索增强生成(RAG)系统可以根据其复杂性和设计原则划分为不同的架构框架。这些包括单代理架构、多代理系统和层次代理架构。每个框架都旨在解决特定挑战并优化不同应用中的性能。本节提供了这些架构的详细分类,突出了它们的特性、优势和局限性。

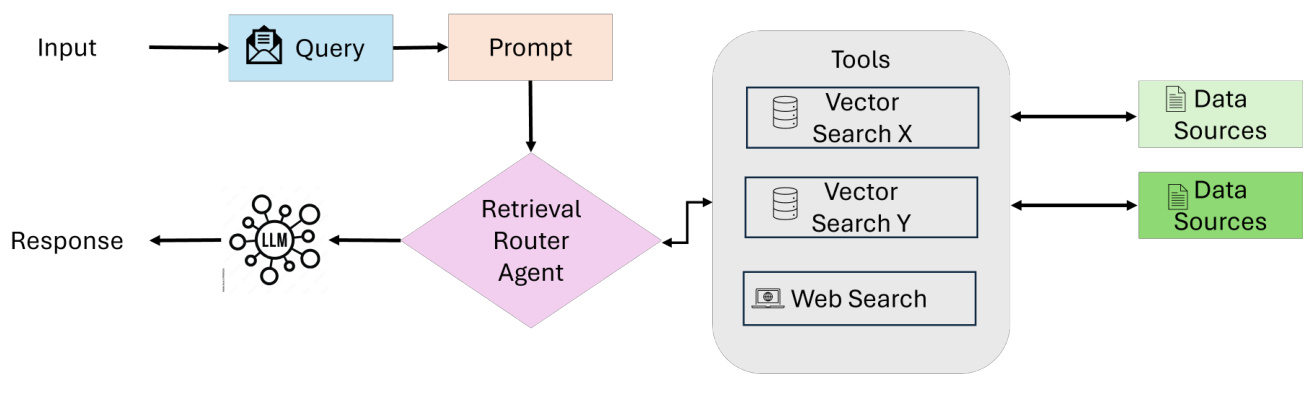

4.1 单代理代理式RAG:路由器

单代理代理式RAG[31]作为一个集中决策系统,一个代理管理检索、路由和信息整合(如图11所示)。这种架构通过将这些任务合并为一个统一的代理,简化了系统,使其特别适用于工具或数据源数量有限的环境。

工作流程

- 查询提交和评估:当用户提交查询时,流程开始。一个协调代理(或主检索代理)接收查询并分析它,以确定最合适的信息来源。

- 知识源选择:根据查询的类型,协调代理从各种检索选项中选择:

- 结构化数据库:对于需要访问表格数据的查询,系统可以使用与PostgreSQL或MySQL等数据库交互的Text-to-SQL引擎。

- 语义搜索:在处理非结构化信息时,它使用基于向量的检索来检索相关文件(例如,PDF、书籍、组织记录)。

- 网络搜索:对于实时或广泛的上下文信息,系统利用网络搜索工具来访问最新的在线数据。

- 推荐系统:对于个性化或上下文查询,系统会利用推荐引擎提供量身定制的建议。

- 数据整合和LLM合成:一旦从选定的来源检索到相关数据,它将被传递给大型语言模型(LLM)。LLM将收集到的信息整合在一起,将多个来源的见解整合成连贯且上下文相关的响应。

- 输出生成:最后,系统生成一个全面的、面向用户的答案,回答原始查询。响应以可操作的、简洁的格式呈现,并且可以选择包括对所用来源的引用或引用。

主要特点和优势

- 集中式简单性:单个代理处理所有检索和路由任务,使架构易于设计、实施和维护。

- 效率与资源优化:由于代理较少,协调更简单,系统需要的计算资源更少,并且可以更快地处理查询。

- 动态路由:代理实时评估每个查询,选择最合适的知识来源(例如,结构化数据库、语义搜索、网络搜索)。

- 跨工具的多功能性:支持多种数据来源和外部API,能够同时支持结构化和非结构化工作流程。

- 适合简单的系统:适用于任务定义明确或集成要求有限的应用(例如,文件检索、基于SQL的工作流程)。

Figure 11: An Overview of Single Agentic RAG

使用案例:客户支持

提示:能告诉我我订单的交货状态吗?

系统流程(单代理工作流程):

- 查询提交和评估:

- 用户提交查询,由协调代理接收。

- 协调代理分析查询,确定最合适的信息来源。

- 知识源选择:

- 从订单管理数据库中检索跟踪详细信息。

- 从快递公司的API中获取实时更新。

- 可选择进行网络搜索,以识别影响交货的当地条件,如天气或物流延误。

- 数据整合和LLM合成:

- 将相关数据传递给LLM,LLM将信息整合成连贯的响应。

- 输出生成:

- 系统生成一个可操作且简洁的响应,提供实时跟踪更新和可能的替代方案。

响应:

综合响应:您的包裹目前正在运输中,预计明天晚上到达。UPS的实时跟踪显示它位于区域配送中心。

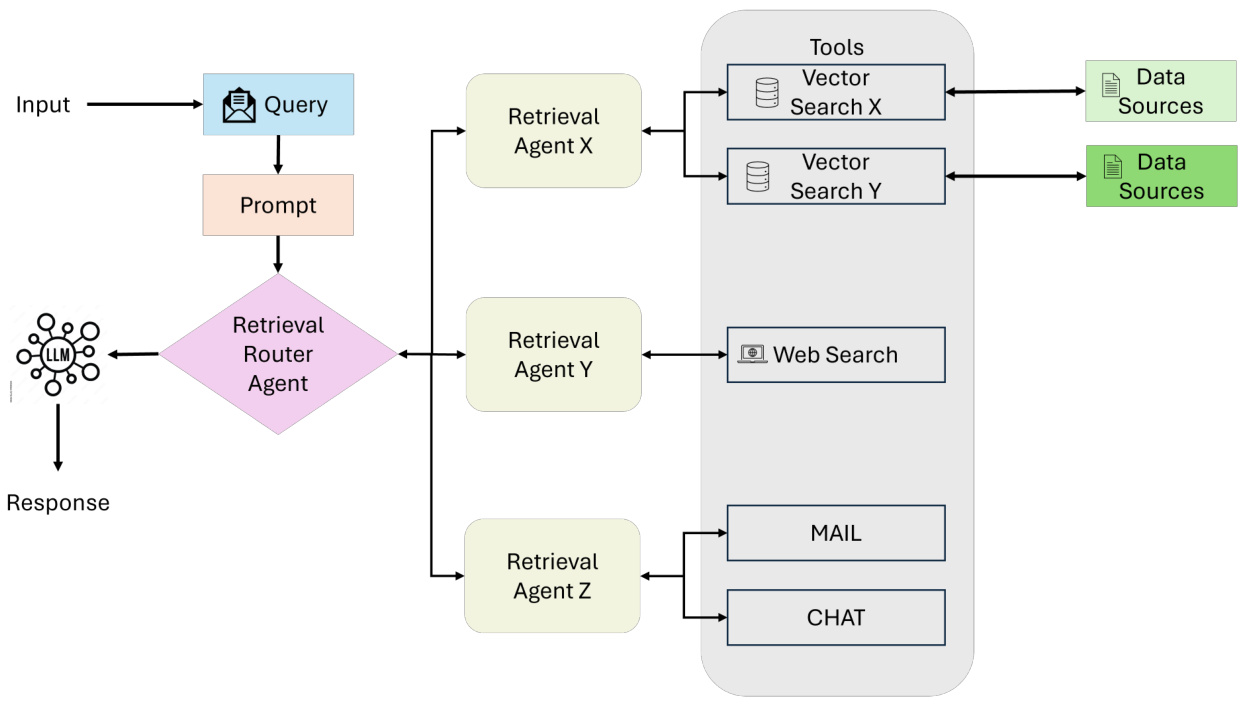

4.2 多代理代理式RAG系统

多代理RAG[31]代表了单代理架构的模块化和可扩展性演变,旨在通过利用多个专门的代理来处理复杂的流程和多样化的查询类型(如图12所示)。与依靠单个代理来管理所有任务——推理、检索和响应生成——不同,该系统将职责分配给多个代理,每个代理都针对特定的角色或数据源进行了优化。

工作流程

- 查询提交:流程从用户查询开始,由协调代理或主检索代理接收。这个代理充当中央协调者,根据查询的要求将查询委托给专门的检索代理。

Figure 12: An Overview of Multi-Agent Agentic RAG Systems

- 专门检索代理:查询被分配给多个检索代理,每个代理专注于特定类型的数据来源或任务。例如:

- 代理1:处理结构化查询,例如与基于SQL的数据库(如PostgreSQL或MySQL)交互。

- 代理2:管理语义搜索,以检索来自PDF、书籍或内部记录等来源的非结构化数据。

- 代理3:专注于从网络搜索或API检索实时公共信息。

- 代理4:专门从事推荐系统,根据用户行为或配置文件提供上下文相关的建议。

- 工具访问和数据检索:每个代理将查询路由到其领域内的适当工具或数据来源,例如:

- 向量搜索:用于语义相关性。

- 文本到SQL:用于结构化数据。

- 网络搜索:用于实时公共信息。

- API:用于访问外部服务或专有系统。

检索过程并行执行,从而实现对不同查询类型的有效处理。

- 数据整合和LLM合成:检索完成后,所有代理的数据都被传递给大型语言模型(LLM)。LLM将检索到的信息整合成连贯且上下文相关的响应,无缝整合多个来源的见解。

- 输出生成:系统生成一个全面的响应,以可操作的、简洁的格式交付回用户。

主要特点和优势

- 模块化:每个代理独立运作,允许根据系统要求无缝添加或移除代理。

- 可扩展性:多个代理的并行处理使系统能够高效处理高查询量。

- 任务专业化:每个代理都针对特定类型的查询或数据来源进行了优化,提高了准确性和检索相关性。

- 效率:通过将任务分配给专门的代理,系统最大限度地减少了瓶颈,并增强了复杂工作流程的性能。

- 多功能性:适用于跨多个领域的应用,包括研究、分析、决策和客户支持。

挑战

- 协调复杂性:管理代理间通信和任务委托需要复杂的协调机制。

- 计算开销:多个代理的并行处理可能会增加资源使用。

- 数据整合:将来自不同来源的输出整合成连贯的响应并非易事,需要高级LLM能力。

使用案例:多领域研究助手

提示:欧洲可再生能源采纳的经济和环境影响是什么?

系统流程(多代理工作流程):

- 代理1:使用SQL查询从经济数据库中检索统计数据。

- 代理2:使用语义搜索工具搜索相关学术论文。

- 代理3:进行网络搜索,获取有关可再生能源的最新新闻和政策更新。

- 代理4:咨询推荐系统,建议相关内容,如报告或专家评论。

响应:

综合响应:“过去十年间,欧洲采纳可再生能源已导致温室气体排放量减少了20%,根据欧盟政策报告。在经济方面,可再生能源投资已创造了大约120万个就业岗位,太阳能和风能领域增长显著。近期学术研究还强调了电网稳定性和能源存储成本方面的潜在权衡。”

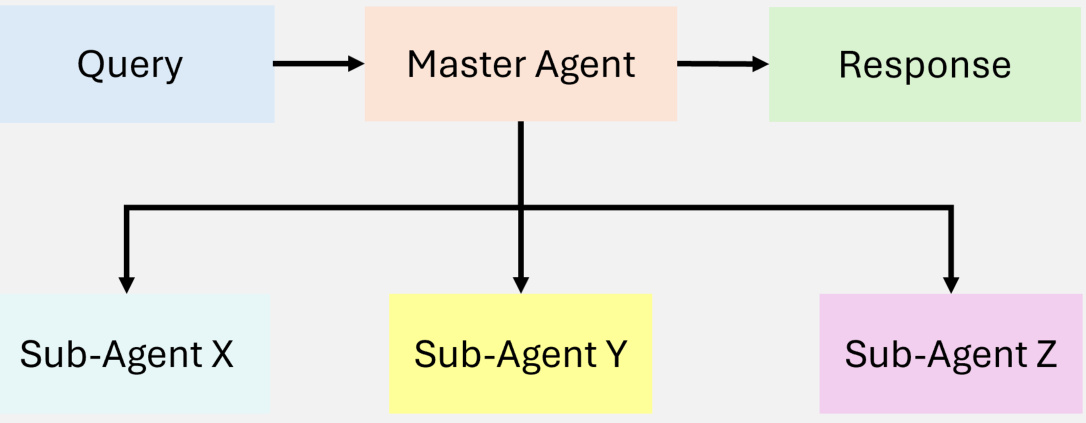

4.3 层次代理式RAG系统

层次代理式RAG[17]系统采用结构化的、多层次的方法进行信息检索和处理,提高了效率和战略决策能力(如图13所示)。代理被组织成层次结构,高层代理监督和指导低层代理。这种结构实现了多层次决策,确保查询由最合适的资源处理。

Figure 13: An illustration of Hierarchical Agentic RAG

工作流程

- 查询接收:用户提交查询,由顶层代理接收,负责初步评估和委托。

- 战略决策:顶层代理评估查询的复杂性,并决定优先考虑哪些下属代理或数据来源。根据查询的领域,某些数据库、API或检索工具可能被认为更可靠或更相关。

- 委托给下属代理:顶层代理将任务分配给专门从事特定检索方法的低层代理(例如,SQL数据库、网络搜索或专有系统)。这些代理独立执行其分配的任务。

- 聚合和合成:高层代理收集并整合来自下属代理的结果,将信息整合成连贯的响应。

- 响应交付:最终的、合成后的答案被返回给用户,确保响应既全面又具有上下文相关性。

主要特点和优势

- 战略优先化:顶层代理可以根据查询复杂性、可靠性或上下文优先考虑数据来源或任务。

- 可扩展性:将任务分配到多个代理层次能够处理高度复杂或多方面的查询。

- 增强的决策能力:高层代理应用战略监督,提高整体准确性和响应一致性。

挑战

- 协调复杂性:跨多个层次的维护强大的代理间通信可能会增加协调开销。

- 资源分配:在避免瓶颈的情况下,在层次之间高效分配任务并非易事。

使用案例:金融分析系统

提示:根据当前的市场趋势, renewable energy的投资选择有哪些?

系统流程(层次代理工作流程):

- 顶层代理:评估查询的复杂性,并优先考虑可靠的金融数据库和经济指标,而不是验证程度较低的数据来源。

- 中层代理:从专有API和结构化SQL数据库中检索实时市场数据(例如,股票价格、行业表现)。

- 低层代理:进行网络搜索,获取最近的公告和政策,并咨询推荐系统,跟踪专家意见和新闻分析。

- 聚合和合成:顶层代理汇总结果,将定量数据与政策见解整合在一起。

响应:

综合响应:“根据当前市场数据,过去一个季度, renewable energy的股票增长了15%,主要受到支持性政府政策和投资者兴趣高涨的推动。分析师认为,风能和太阳能领域可能持续保持增长势头,而新兴技术如绿色氢能则存在中等风险,但可能带来高回报。”

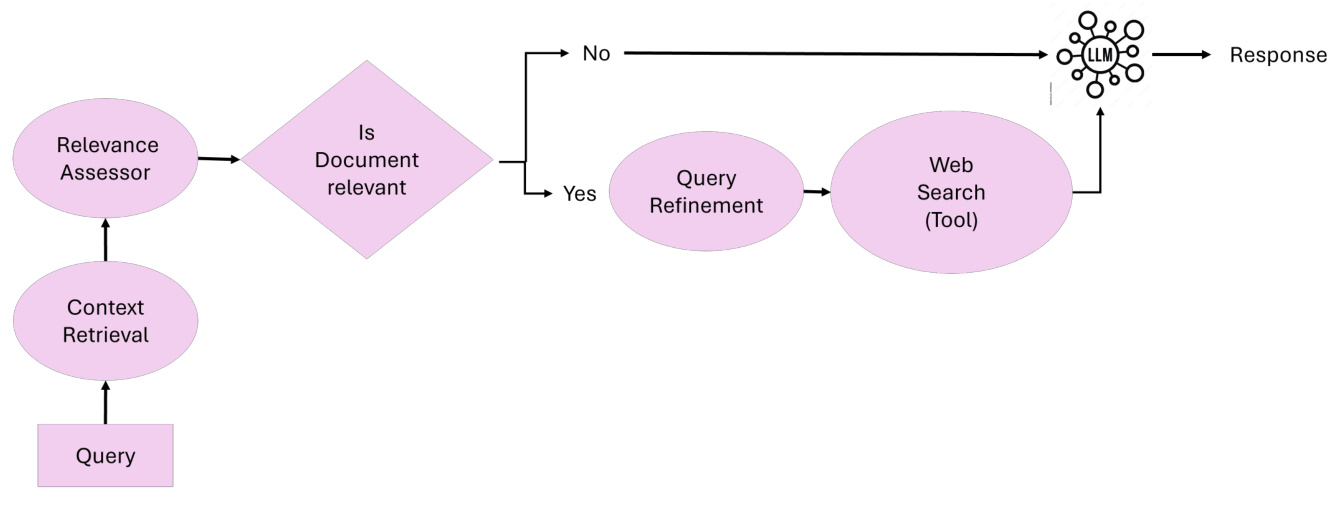

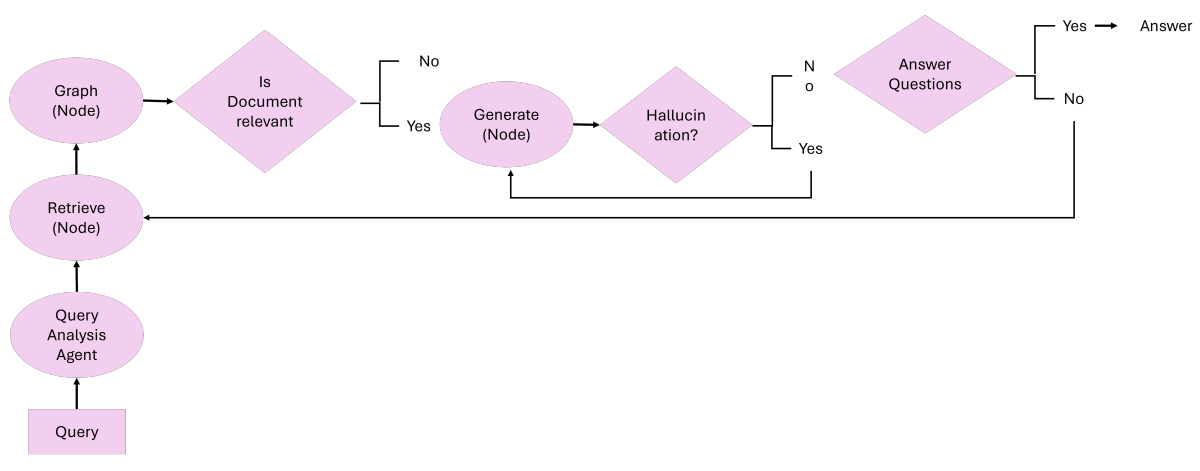

4.4 代理式纠正RAG

纠正RAG[32] [33]引入了自我纠正检索结果的功能,增强了文档利用,提高了响应生成质量(如图14所示)。通过将智能代理嵌入工作流程中,纠正RAG[32] [33]确保了对上下文文档和响应的迭代完善,从而最大限度地减少错误并最大限度地提高相关性。

Figure 14: Overview of Agentic Corrective RAG

纠正RAG的核心思想:纠正RAG的核心原则在于其能够动态地评估检索到的文档,执行纠正动作,并完善查询,以提高生成响应的质量。纠正RAG调整其方法如下:

- 文档相关性评估:检索到的文档由相关性评估代理进行评估。低于相关性阈值的文档会触发纠正步骤。

- 查询完善和增强:查询由查询完善代理完善,该代理利用语义理解来优化检索以获得更好的结果。

- 动态检索自外部来源:当上下文不足时,外部知识检索代理执行网络搜索或访问替代数据来源以补充检索到的文档。

- 响应合成:所有经过验证和完善的信息都传递给响应合成代理进行最终响应生成。

工作流程:纠正RAG系统建立在五个关键代理之上:

- 上下文检索代理:负责从向量数据库中检索初始上下文文档。

- 相关性评估代理:评估检索到的文档的相关性,并标记任何不相关或模糊的文档以进行纠正动作。

- 查询完善代理:重写查询以提高检索效率,利用语义理解来优化结果。

- 外部知识检索代理:当上下文文档不足时,执行网络搜索或访问替代数据来源。

- 响应合成代理:将所有经过验证的信息整合成连贯准确的响应。

主要特点和优势:

- 迭代纠正:通过动态识别和纠正不相关或模糊的检索结果,确保高响应准确性。

- 动态适应性:整合实时网络搜索和查询完善以提高检索精度。

- 代理式模块化:每个代理执行专门的任务,确保高效和可扩展的操作。

- 事实性保证:通过验证所有检索和生成的内容,纠正RAG最大限度地降低了产生幻觉或错误信息的风险。

使用案例:学术研究助手

提示: generative AI研究的最新发现是什么?

系统流程(纠正RAG工作流程):

- 查询提交:用户向系统提交查询。

- 上下文检索:

- 上下文检索代理从已发表的关于 generative AI的论文数据库中检索初始文档。

- 检索到的文档被传递到下一步进行评估。

- 相关性评估:

- 相关性评估代理评估文档与查询的匹配度。

- 将文档分类为相关、模糊或无关。无关文档被标记以进行纠正动作。

- 纠正动作(如果需要):

- 查询完善代理重写查询以提高特异性。

- 外部知识检索代理进行网络搜索,从外部来源获取额外的论文和报告。

- 响应合成:

- 响应合成代理将验证后的文档整合成全面而详细的摘要。

响应:

综合响应: “近期 generative AI的研究成果包括扩散模型、强化学习在文本到视频任务中的应用,以及大规模模型训练优化技术的进步。更多细节请参见2024年NeurIPS和2025年AAAI上发表的研究。”

4.5 自适应代理式RAG

自适应检索增强生成(Adaptive RAG)[34]通过根据传入查询的复杂性动态调整查询处理策略,增强了大型语言模型(LLMs)的灵活性和效率。与静态检索工作流程不同,自适应RAG[35]采用分类器来分析查询复杂性,确定最合适的做法,从单步检索到多步推理,甚至对于简单的查询完全绕过检索,如图15所示。

Figure 15: An Overview of Adaptive Agentic RAG

自适应RAG的核心思想 自适应RAG的核心原则在于其能够根据查询的复杂性动态调整检索策略。自适应RAG调整其方法如下:

- 简单查询: 对于需要额外检索的事实性问题(例如,“水的沸点是多少?”),系统直接使用预先存在的知识生成答案。

- 简单查询: 对于需要最小上下文的中等复杂任务(例如,“我最近的电费账单状态如何?”),系统执行单步检索来获取相关细节。

- 复杂查询: 对于需要迭代推理的多层次查询(例如,“过去十年间,城市X的人口变化如何,以及有哪些促成因素?”),系统采用多步检索,逐步完善中间结果以提供全面答案。

工作流程: 自适应RAG系统建立在三个主要组件上:

- 分类器角色:

- 一个较小的语言模型分析查询以预测其复杂性。

- 分类器使用自动标注的数据集进行训练,这些数据集来自过去的模型结果和查询模式。

- 动态策略选择:

- 对于简单查询,系统避免不必要的检索,直接利用LLM生成响应。

- 对于简单查询,它采用单步检索过程来获取相关上下文。

- 对于复杂查询,它激活多步检索,以确保迭代完善和增强推理。

- LLM集成:

- LLM将检索到的信息整合成连贯的响应。

- LLM与分类器之间的迭代交互允许对复杂查询进行完善。

主要特点和优点:

- 动态适应性: 根据查询复杂性调整检索策略,优化计算效率和响应准确性。

- 资源效率: 对简单查询最大限度地减少不必要的开销,同时确保对复杂查询的彻底处理。

- 增强的准确性: 迭代完善确保复杂查询以高精度解决。

- 灵活性: 可以扩展以整合额外的路径,例如特定领域的工具或外部API。

使用案例: 客户支持助手

提示: 为什么我的包裹延迟了,我有哪些选择?

系统流程(自适应RAG工作流程):

- 查询分类:

- 分类器分析查询,并确定它是一个复杂查询,需要多步推理。

- 动态策略选择:

- 系统根据复杂性分类激活多步检索过程。

- 多步检索:

- 从订单数据库中检索跟踪详细信息。

- 从快递公司API中获取实时状态更新。

- 进行网络搜索,查找外部因素,如天气条件或当地中断。

- 响应合成:

- LLM整合所有检索到的信息,合成一个全面且可操作的响应。

响应:

综合响应: “您的包裹因您所在地区恶劣的天气条件而延迟。它目前位于当地配送中心,预计2天内送达。另外,您可以选择从设施中自提。”

4.6 基于图的代理式RAG

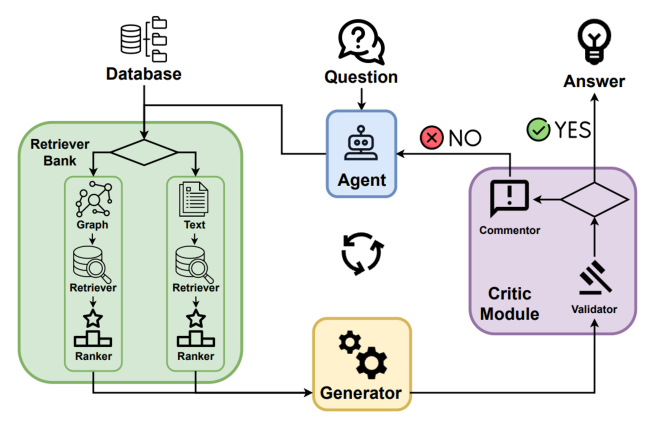

4.6.1 Agent-G: 图RAG的代理式框架

Agent-G[8]引入了将图知识库与无结构文档检索相结合的创新代理式架构。通过结合结构化和无结构数据来源,这个框架增强了检索增强生成(RAG)系统的推理和检索准确性。它采用模块化检索器库、动态代理交互和反馈循环,以确保高质量的输出,如图16所示。

Figure 16: An Overview of Agent-G: Agentic Framework for Graph RAG

Agent-G的核心思想 Agent-G的核心原则在于其能够动态地将检索任务分配给专门的代理,利用图知识库和文本文件。Agent-G调整其检索策略如下:

- 图知识库: 使用结构化数据提取关系、层次结构和连接(例如,医疗领域的疾病到症状映射)。

- 无结构文档: 传统的文本检索系统提供上下文信息以补充图数据。

- 批评模块: 评估检索到的信息的相关性和质量,确保与查询对齐。

- 反馈循环: 通过迭代验证和重新查询,完善检索和合成。

工作流程: Agent-G系统建立在四个主要组件上:

- 检索器库:

- 一组模块化代理专门从事检索基于图或无结构数据。

- 代理根据查询的要求动态选择相关来源。

- 批评模块:

- 验证检索到的数据的相关性和质量。

- 标记低置信度的结果以进行重新检索或完善。

- 动态代理交互:

- 任务特定的代理合作整合不同类型的数据。

- 确保在图和文本来源之间进行协调的检索和合成。

- LLM集成:

- 将验证后的数据合成一个连贯的响应。

- 来自批评模块的迭代反馈确保与查询意图对齐。

主要特点和优点:

- 增强的推理: 结合图中的结构化关系和来自无结构文档的上下文信息。

- 动态适应性: 根据查询要求动态调整检索策略。

- 提高准确性: 批评模块减少了响应中不相关或低质量数据的风险。

- 可扩展的模块化: 支持添加新代理以执行专门任务,提高可扩展性。

使用案例: 医疗诊断

提示: 2型糖尿病的常见症状有哪些,它们与心脏病有什么关系?

系统流程(Agent-G工作流程):

- 查询接收和分配: 系统接收查询,并确定需要同时使用图结构和无结构数据来全面回答问题。

- 图检索器:

- 从医疗知识图谱中提取2型糖尿病与心脏病之间的关系。

- 通过探索图层次结构和关系,识别肥胖和高血压等共同风险因素。

- 文档检索器:

- 从医学文献中检索2型糖尿病症状的描述(例如,口渴增加,频繁排尿,疲劳)。

- 添加上下文信息以补充基于图的见解。

- 批评模块:

- 评估检索到的图数据和文档数据的相关性和质量。

- 标记低置信度的结果以进行完善或重新查询。

- 响应合成: LLM将来自图检索器和文档检索器的验证数据整合成一个连贯的响应,确保与查询意图对齐。

响应:

综合响应: “2型糖尿病的症状包括口渴增加、频繁排尿和疲劳。研究表明,糖尿病与心脏病之间存在50%的相关性,主要是通过共同的风险因素,如肥胖和高血压。”

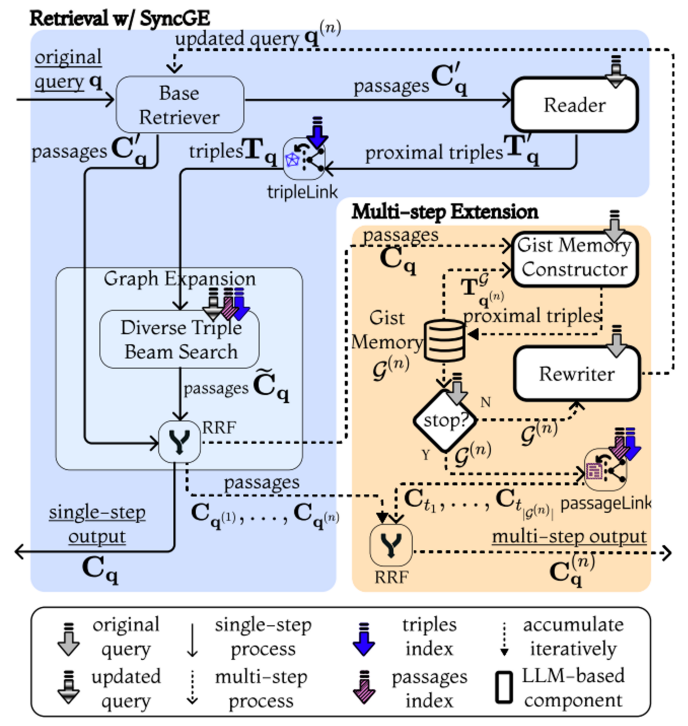

4.6.2 GeAR: 图增强代理用于检索增强生成

GeAR[36]引入了增强传统检索增强生成(RAG)系统的代理式框架,通过整合基于图的检索机制。通过利用图扩展技术和基于代理的架构,GeAR解决了多跳检索场景中的挑战,提高了系统处理复杂查询的能力,如图17所示。

Figure 17: An Overview of GeAR: Graph-Enhanced Agent for Retrieval-Augmented Generation[36]

- 图扩展: 通过将检索过程扩展到包括图结构的数据,增强了传统的基线检索器(例如,BM25),使系统能够捕捉实体间复杂的关系和依赖关系。

- 代理框架: 整合了基于代理的架构,利用图扩展来更有效地管理检索任务,允许在检索过程中进行动态和自主决策。

工作流程: GeAR系统通过以下组件运作:

- 图扩展模块:

- 将基于图的数据整合到检索过程中,使系统能够在检索过程中考虑实体间的关系。

- 通过将搜索空间扩展到包括连接实体,增强基线检索器处理多跳查询的能力。

- 基于代理的检索:

- 采用代理框架来管理检索过程,使代理能够根据查询的复杂性动态选择和组合检索策略。

- 代理可以自主决定利用图扩展的检索路径,以提高检索信息的关联性和准确性。

- LLM整合:

- 将检索到的信息与图扩展的优势相结合,与大型语言模型(LLM)的功能结合起来,生成连贯且上下文相关的响应。

- 这种整合确保了生成过程既受到非结构化文档和结构化图数据的启发。

主要特点和优点:

- 增强的多跳检索: GeAR的图扩展使系统能够处理需要推理多个相互关联的信息片段的复杂查询。

- 代理式决策: 代理框架使动态和自主选择检索策略成为可能,提高了效率和相关。

- 提高准确性: 通过整合结构化图数据,GeAR提高了检索信息的精确度,从而生成更准确、更具上下文适当的响应。

- 可扩展性: 代理框架的模块化性质允许根据需要整合额外的检索策略和数据来源。

使用案例: 多跳问答

提示: 谁影响了J.K. 罗琳的导师?

系统流程(GeAR工作流程):

- 顶层代理: 评估查询的多跳性质,并确定需要结合图扩展和文档检索来回答问题。

- 图扩展模块:

- 确定J.K. 罗琳的导师是查询中的关键实体。

- 通过探索文学关系图结构数据,追寻导师的文学影响。

- 基于代理的检索:

- 一个代理自主选择图扩展的检索路径,以收集有关导师的影响的相关信息。

- 通过查询文本数据来源,为导师及其影响的无结构细节整合额外上下文。

- 响应合成: 使用LLM结合图和文档检索过程的见解,生成一个准确反映查询中复杂关系的响应。

响应:

综合响应: “J.K. 罗琳的导师,[导师姓名],深受[作者姓名]的影响,[作者姓名]以其[著名作品或类型]而闻名。这种联系凸显了文学史上层层叠叠的关系,在那里,有影响力的想法通常通过多代作家传递。”

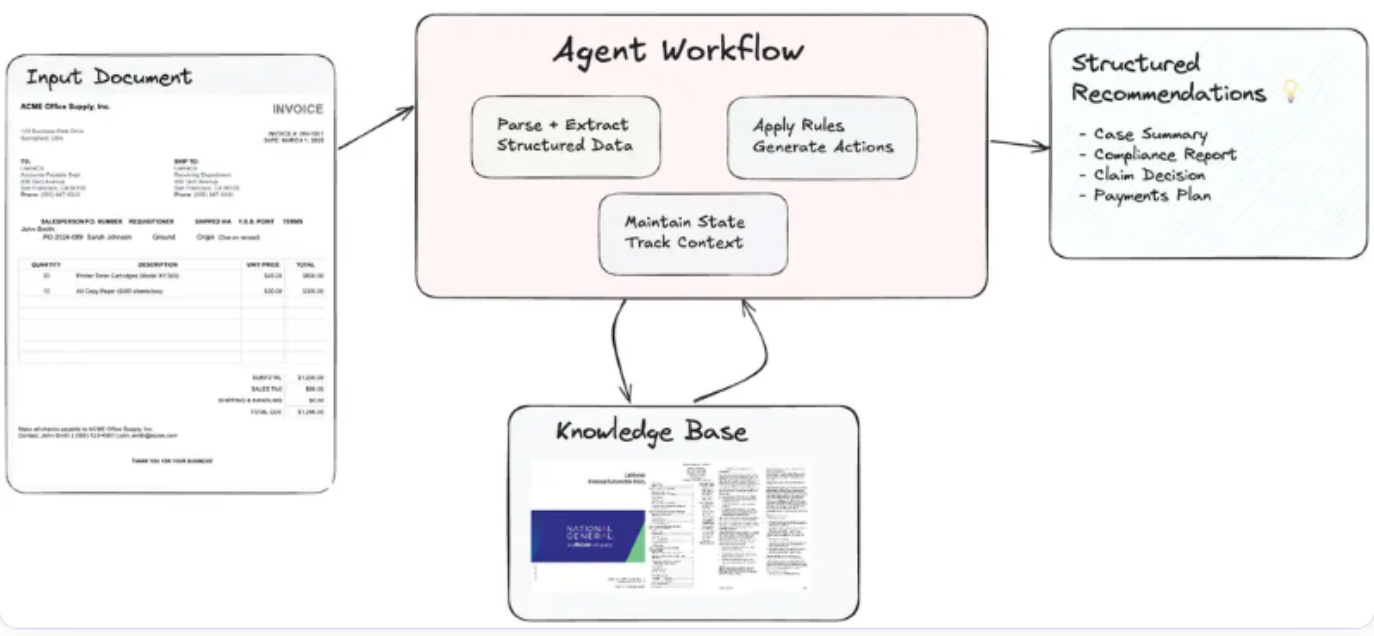

4.7 代理式文档工作流程在代理式RAG中的应用

Agentic Document Workflows(ADW)[37] 扩展了传统的检索增强生成(RAG)范式,通过实现端到端的知识工作自动化。这些工作流编排了复杂的以文档为中心的流程,将文档解析、检索、推理和结构化输出与智能代理集成(见图 18)。ADW 系统通过保持状态、协调多步工作流,并对文档应用特定领域逻辑,来解决智能文档处理(IDP)和 RAG 的局限性。

工作流程

- 文档解析和信息结构化:

- 使用企业级工具(例如,LlamaParse)解析文档,以提取相关数据字段,如发票号码、日期、供应商信息、条目和付款条件。

- 将结构化数据组织起来,以便后续处理。

- 跨流程状态维护:

- 系统维护有关文档上下文的状态,确保在多步骤工作流程中的一致性和相关性。

- 跟踪文档在各个处理阶段的进展。

- 知识检索:

- 从外部知识库(例如,LlamaCloud)或向量索引中检索相关参考资料。

- 检索实时、领域特定的指南,以增强决策能力。

- 代理式编排:

- 智能代理应用业务规则,执行多跳推理,并生成可操作的建议。

- 编排解析器、检索器等组件和外部API,以实现无缝集成。

- 可操作输出生成:

- 输出以结构化格式呈现,针对特定用例量身定制。

- 将建议和提取的见解综合成简洁、可操作的报告。

Figure 18: An Overview of Agentic Document Workflows (ADW) [37]

使用案例:发票支付工作流程

提示:根据提交的发票和相关供应商合同条款,生成一份支付建议报告。

系统流程(ADW工作流程):

- 解析发票以提取关键细节,如发票号码、日期、供应商信息、条目和付款条件。

- 检索相应的供应商合同,以验证付款条件,并确定任何适用的折扣或合规要求。

- 生成一份支付建议报告,包括原始应付金额、可能的提前付款折扣、预算影响分析和战略性支付行动。

响应:综合响应:“发票INV-2025-045,金额为$15,000.00,已处理。如果在2025-04-10之前付款,可享受2%的提前付款折扣,将应付金额减少至$14,700.00。由于小计超过$10,000.00,已应用5%的批量订单折扣。建议批准提前付款,以节省2%的费用,并确保为即将到来的项目阶段及时分配资金。”

主要特点和优势

- 状态维护:跟踪文档上下文和工作流程阶段,确保跨流程的一致性。

- 多步骤编排:处理涉及多个组件和外部工具的复杂工作流程。

- 领域特定智能:应用量身定制的业务规则和指南,以实现精确的建议。

- 可扩展性:支持大规模文档处理,具有模块化和动态的代理集成。

- 提高生产力:自动化重复性任务,同时增强人类在决策中的专业知识。

4.8 代理型 RAG 框架的对比分析

表2提供了三种架构框架的全面比较分析:传统RAG、代理式RAG和代理式文档工作流程(ADW)。该分析突出了它们各自的优势、劣势和最佳适用场景,为在不同用例中的应用提供了宝贵的见解。

表2:比较分析:传统RAG与代理式RAG与代理式文档工作流程(ADW)

| 特性 | 传统RAG | 代理式RAG | 代理式文档工作流程(ADW) |

|---|---|---|---|

| 重点 | 孤立的检索和生成任务 | 多代理协作和推理 | 以文档为中心的端到端工作流程 |

| 上下文维护 | 有限 | 通过记忆模块实现 | 在多步骤工作流程中维护状态 |

| 动态适应性 | 最小 | 高 | 根据文档工作流程量身定制 |

| 工作流程编排 | 缺失 | 编排多代理任务 | 整合多步骤文档处理 |

| 使用外部工具/API | 基本集成(例如,检索工具) | 通过工具(如API和知识库)扩展 | 与业务规则和领域特定工具深度集成 |

| 可扩展性 | 限于小型数据集或查询 | 可扩展的多代理系统 | 可扩展的多领域企业工作流程 |

| 复杂推理 | 基础(例如,简单问答) | 使用代理的多步骤推理 | 结构化推理跨文档 |

| 主要应用 | 问答系统,知识检索 | 多领域知识和推理 | 合同审查,发票处理,索赔分析 |

| 优势 | 简单,快速设置 | 高准确性,协作推理 | 端到端自动化,领域特定智能 |

| 挑战 | 上下文理解差 | 协调复杂性 | 资源开销,领域标准化 |

比较分析强调了从传统RAG到代理式RAG再到代理式文档工作流程(ADW)的演变轨迹。虽然传统RAG为基本任务提供了简单性和易于部署的优势,但代理式RAG通过多代理协作引入了增强的推理能力和可扩展性。ADW在这些进步的基础上,通过提供强大的、以文档为中心的工作流程,促进了端到端的自动化和与领域特定流程的整合。了解每个框架的优势和局限性对于选择最适合特定应用需求和运营需求的架构至关重要。

5 代理式RAG的应用

代理式检索增强生成(RAG)系统在各种领域展示了变革性的潜力。通过结合实时数据检索、生成能力和自主决策,这些系统解决了复杂、动态和多模态的挑战。本节探讨了代理式RAG的关键应用,详细介绍了这些系统如何塑造客户支持、医疗、金融、教育、法律工作流程和创意产业等领域。

5.1 客户支持和虚拟助手

代理式RAG系统正在通过实现实时、上下文感知的查询解决来革新客户支持。传统的聊天机器人和虚拟助手通常依赖于静态知识库,导致通用或过时的响应。相比之下,代理式RAG系统动态检索最相关的信息,适应用户的上下文,并生成个性化的响应。

使用案例:Twitch广告销售增强 [38]

例如,Twitch利用亚马逊Bedrock上的代理式工作流程与RAG来简化广告销售。该系统动态检索广告商数据、历史广告活动表现和受众统计数据,以生成详细的广告提案,显著提高了运营效率。

主要好处:

- 提高响应质量:个性化和上下文相关的回复增强了用户参与度。

- 运营效率:通过自动化复杂查询,减少了人工支持代理的工作量。

- 实时适应性:动态整合不断发展的数据,例如实时服务中断或定价更新。

5.2 医疗和个性化医学

在医疗领域,将患者特定数据与最新的医学研究相结合对于做出明智的决策至关重要。代理式RAG系统通过检索实时临床指南、医学文献和患者病史来帮助临床医生进行诊断和治疗规划,从而实现这一点。

使用案例:患者病例摘要 [39]

代理式RAG系统已被应用于生成患者病例摘要。例如,通过整合电子健康记录(EHR)和最新的医学文献,该系统为临床医生生成综合摘要,以便他们做出更快、更明智的决策。

主要好处:

- 个性化护理:根据个别患者的需求调整建议。

- 时间效率:简化相关研究的检索,为医疗提供者节省宝贵的时间。

- 准确性:确保建议基于最新的证据和患者特定的参数。

5.3 法律和合同分析

代理式RAG系统正在重新定义法律工作流程的执行方式,提供用于快速文档分析和决策的工具。

使用案例:合同审查 [40]

一个法律代理式RAG系统可以分析合同,提取关键条款,并识别潜在风险。通过结合语义搜索能力和法律知识图谱,它自动化了合同审查的繁琐过程,确保合规并减轻风险。

主要好处:

- 风险识别:自动标记偏离标准条款的条款。

- 效率:减少合同审查过程所花费的时间。

- 可扩展性:同时处理大量合同。

5.4 金融和风险分析

代理式RAG系统正在通过提供实时洞察力用于投资决策、市场分析和风险管理来转变金融业。这些系统整合实时数据流、历史趋势和预测建模,以生成可操作的输出。

使用案例:汽车保险索赔处理 [41]

在汽车保险中,代理式RAG可以自动化索赔处理。例如,通过检索保单详细信息并将其与事故数据相结合,它生成索赔建议,同时确保遵守监管要求。

主要好处:

- 实时分析:根据实时市场数据提供洞察力。

- 风险缓解:使用预测分析和多步骤推理识别潜在风险。

- 增强的决策能力:结合历史和实时数据,制定全面的策略。

5.5 教育

教育是代理式RAG系统取得重大进展的另一领域。这些系统通过生成解释、学习材料和反馈,适应学习者的进步和偏好,从而实现适应性学习。

使用案例:研究论文生成 [42]

在高等教育中,代理式RAG已被用来协助研究人员,通过综合多个来源的关键发现。例如,研究人员查询“量子计算的最新进展是什么?”会收到一个简明的摘要,并附有参考文献,从而提高他们工作的质量和效率。

主要好处:

- 量身定制的学习路径:根据个别学生的需求和表现水平调整内容。

- 吸引人的互动:提供互动解释和个性化反馈。

- 可扩展性:支持大规模部署,适用于各种教育环境。

5.6 多模态工作流程中的图增强应用

图增强代理式RAG(GEAR)结合了图结构和检索机制,在多模态工作流程中特别有效,在这些工作流程中,相互连接的数据来源至关重要。

使用案例:市场调查生成

GEAR能够综合文本、图像和视频,用于营销活动。例如,查询“环保产品的新兴趋势是什么?”会生成一份详细的报告,其中包括客户偏好、竞争对手分析和多媒体内容。

主要好处:

- 多模态能力:整合文本、图像和视频数据,实现综合输出。

- 增强的创造力:为营销和娱乐生成创新的想法和解决方案。

- 动态适应性:适应不断变化的市场趋势和客户需求。

代理式RAG系统的应用范围广泛,展示了其多功能性和变革潜力。从个性化的客户支持到适应性教育和图增强的多模态工作流程,这些系统解决了复杂、动态和知识密集型挑战。通过整合检索、生成和代理智能,代理式RAG系统正在为下一代AI应用铺平道路。

6 代理式RAG的工具和框架

代理式检索增强生成(RAG)系统代表了在结合检索、生成和代理智能方面的重大演变。这些系统通过整合决策、查询重构和自适应工作流程,扩展了传统RAG的能力。以下工具和框架为开发代理式RAG系统提供了强大的支持,解决了现实应用中的复杂要求。

关键工具和框架:

- LangChain和LangGraph:LangChain[43]提供了构建RAG管道的模块化组件,无缝整合检索器、生成器和外部工具。LangGraph通过引入支持循环、状态持久性和人机交互的基于图的流程,补充了这一功能,使代理系统中能够进行复杂的编排和自我纠正机制。

- LlamaIndex:LlamaIndex的[44]代理式文档工作流程(ADW)实现了文档处理、检索和结构化推理的端到端自动化。它引入了一个元代理架构,其中子代理管理较小的文档集,通过顶级代理协调任务,如合规分析和上下文理解。

- Hugging Face Transformers和Qdrant:Hugging Face[45]提供用于嵌入和生成任务的预训练模型,而Qdrant[46]通过自适应向量搜索能力增强了检索工作流程,使代理能够通过动态切换稀疏和密集向量方法优化性能。

- CrewAI和AutoGen:这些框架强调多代理架构。CrewAI[47]支持层次化和顺序过程、强大的记忆系统和工具集成。AG2[48](以前称为AutoGen[49, 50])在多代理协作方面表现出色,具有高级代码生成、工具执行和决策支持。

- OpenAI Swarm Framework:一个教育框架,旨在实现符合人体工程学、轻量级的多代理编排[51],强调代理自主性和结构化协作。

- 使用Vertex AI的代理式RAG:由Google开发的Vertex AI[52]与代理式检索增强生成(RAG)无缝集成,提供了一个平台,用于构建、部署和扩展机器学习模型,同时利用高级AI能力,实现强大、上下文感知的检索和决策工作流程。

- 亚马逊Bedrock用于代理式RAG:亚马逊Bedrock[38]提供了一个强大的平台,用于实施代理式检索增强生成(RAG)工作流程。

- IBM Watson和代理式RAG:IBM的watsonx.ai[53]支持构建代理式RAG系统,例如,使用Granite-3-8B-Instruct模型,通过整合外部信息来回答复杂查询并提高响应准确性。

- Neo4j和向量数据库:Neo4j,一个著名的开源图数据库,在处理复杂关系和语义查询方面表现出色。除了Neo4j,像Weaviate、Pinecone、Milvus和Qdrant这样的向量数据库提供了高效的相似性搜索和检索能力,构成了高性能代理式检索增强生成(RAG)工作流程的支柱。

7 基准和数据集

当前的基准和数据集为评估检索增强生成(RAG)系统,包括那些具有代理式和图增强的系统,提供了宝贵的见解。虽然有些是专门为RAG设计的,但其他一些则被调整以测试在各种场景中的检索、推理和生成能力。数据集对于测试RAG系统的检索、推理和生成组件至关重要。表3根据下游任务讨论了一些关键数据集,用于RAG评估。

基准在标准化RAG系统的评估方面发挥着关键作用,通过提供结构化任务和指标。以下基准特别相关:

- BEIR(信息检索基准测试):一个多功能的基准,旨在评估嵌入模型在各种信息检索任务上的表现,涵盖了跨生物信息学、金融和问答等领域的17个数据集[54]。

- MS MARCO(微软机器阅读理解):专注于段落排名和问答,这个基准被广泛用于RAG系统中的密集检索任务[55]。

- TREC(文本检索会议,深度学习赛道):提供用于段落和文档检索的数据集,强调检索管道中排名模型的质量[56]。

- MuSiQue(多跳顺序提问):一个用于多跳推理跨多个文档的基准,强调检索和综合来自不连续上下文的信息的重要性[57]。

- 2WikiMultihopQA:一个为跨两篇维基百科文章的多跳QA任务设计的数据集,侧重于连接多个来源知识的能力[58]。

- AgentG(用于知识融合的代理式RAG):专门为代理式RAG任务量身定制的基准,评估跨多个知识库动态信息综合[8]。

- HotpotQA:一个多跳QA基准,需要在相互关联的上下文中进行检索和推理,适合评估复杂的RAG工作流程[59]。

- RAGBench:一个大规模、可解释的基准,包含100,000个跨行业领域的示例,并具有TRACe评估框架,用于可操作的RAG指标[60]。

- BERGEN(检索增强生成基准测试):一个用于系统地基准测试RAG系统的库,具有标准化的实验[61]。

- FlashRAG工具包:实现了12种RAG方法,并包括32个基准数据集,支持高效和标准化的RAG评估[62]。

- GNN-RAG:这个基准评估基于图的RAG系统在节点级和边级预测任务上的表现,重点关注检索质量和知识图谱问答(KGQA)中的推理性能[63]。

表3:RAG评估的下游任务和数据集(改编自[23])

| 类别 | 任务类型 | 数据集和参考文献 |

|---|---|---|

| 问答(QA) | 单跳QA | 自然问题(NQ)[64],TriviaQA[65],SQuAD[66],网络问题(WebQ)[67],PopQA[68],MS MARCO[55] |

| 多跳QA | HotpotQA[59],2WikiMultiHopQA[58],MuSiQue[57] | |

| 长篇问答 | ELI5[69],NarrativeQA(NQA)[70],ASQA[71],QMSum[72] | |

| 领域特定QA | Qasper[73],COVID-QA[74],CMB/MMCU Medical[75] | |

| 多选QA | QuALITY[76],ARC(无参考文献),CommonSenseQA[77] | |

| 图QA | GraphQA[78] | |

| 基于图的问答 | 事件论元抽取 | WikiEvent[79],RAMS[80] |

| 开放域对话 | 维基百科的巫师(WoW)[81] | |

| 对话 | 个性化对话 | KBP[82],DuleMon[83] |

| 任务导向对话 | CamRest[84] | |

| 个性化内容 | 亚马逊数据集(玩具,运动,美容)[85] | |

| 推荐推理 | HellaSwag[86],CommonSenseQA[77] | |

| 常识推理 | CoT推理 | CoT Reasoning[87],CSQA[88] |

| 其他 | 复杂推理 | MMLU(无参考文献),WikiText-103[64] |

| 语言理解 | ||

| 事实核查/验证 | FEVER[89],PubHealth[90] | |

| 摘要 | 策略QA文本摘要 | StrategyQA[91] |

| 文本摘要 | WikiASP[92],XSum[93] | |

| 文本生成 | 长篇摘要 | NarrativeQA(NQA)[70],QMSum[72] |

| 文本分类 | 传记 | 传记数据集(无参考文献),SST-2[94] |

| 情感分析一般分类 | ||

| 代码搜索 | 编程搜索 | VioLens[95],TREC[56],CodeSearchNet[96] |

| 鲁棒性 | 检索鲁棒性 | NoMIRACL[97] |

| 语言建模鲁棒性 | WikiText-103[98] | |

| 数学 | 数学推理 | GSM8K[99] |

| 机器翻译 | 翻译任务 | JRC-Acquis[100] |

8 结论

代理式检索增强生成(RAG)代表了人工智能的一项变革性进步,通过整合自主代理,克服了传统RAG系统的局限性。通过利用代理智能,这些系统引入了动态决策、迭代推理和协作工作流程的能力,使它们能够以更高的精确性和适应性解决复杂的现实任务。

本综述探讨了RAG系统的演变,从最初的实施到高级范式,如模块化RAG,突出了每个范式的贡献和局限性。将代理整合到RAG流程中已成为一个关键的发展,导致了克服静态工作流程和有限的上下文适应性的代理式RAG系统的出现。跨医疗、金融、教育和创意产业的应用展示了这些系统的变革潜力,展示了它们提供个性化、实时和上下文感知的解决方案的能力。

尽管前景广阔,代理式RAG系统也面临着挑战,需要进一步的研究和创新。多代理架构中的协调复杂性、可扩展性和延迟问题,以及道德考虑,必须得到解决,以确保强大和负责任的部署。此外,缺乏专门用于评估代理能力的基准和数据集也构成了一个重大障碍。开发评估方法以捕捉代理式RAG独特方面,如多代理协作和动态适应性,对于推进该领域至关重要。

展望未来,检索增强生成与代理智能的融合有潜力重新定义AI在动态和复杂环境中的作用。通过解决这些挑战并探索未来方向,研究人员和从业人员可以释放代理式RAG系统的全部潜力,为跨行业和领域的变革性应用铺平道路。随着AI系统不断发展,代理式RAG作为创建适应性、上下文感知和影响力的解决方案的基石,满足了快速变化世界的需求。

参考文献

[1] Shervin Minaee, Tomas Mikolov, Narjes Nikzad, Meysam Chenaghlu, Richard Socher, Xavier Amatriain, andJianfeng Gao. Large language models: A survey, 2024.

[2] Aditi Singh. Exploring language models: A comprehensive survey and analysis. In 2023 International Conference on Research Methodologies in Knowledge Management, Artificial Intelligence and Telecommunication

Engineering (RMKMATE), pages 1–4, 2023.

[3] Wayne Xin Zhao, Kun Zhou, Junyi Li, Tianyi Tang, Xiaolei Wang, Yupeng Hou, Yingqian Min, Beichen Zhang,

Junjie Zhang, Zican Dong, Yifan Du, Chen Yang, Yushuo Chen, Zhipeng Chen, Jinhao Jiang, Ruiyang Ren,

Yifan Li, Xinyu Tang, Zikang Liu, Peiyu Liu, Jian-Yun Nie, and Ji-Rong Wen. A survey of large language

models, 2024.

[4] Sumit Kumar Dam, Choong Seon Hong, Yu Qiao, and Chaoning Zhang. A complete survey on llm-based ai

chatbots, 2024.

[5] Aditi Singh. A survey of ai text-to-image and ai text-to-video generators. In 2023 4th International Conference

on Artificial Intelligence, Robotics and Control (AIRC), pages 32–36, 2023.

[6] Aditi Singh, Abul Ehtesham, Gaurav Kumar Gupta, Nikhil Kumar Chatta, Saket Kumar, and Tala Talaei Khoei.

Exploring prompt engineering: A systematic review with swot analysis, 2024.

[7] Lei Huang, Weijiang Yu, Weitao Ma, Weihong Zhong, Zhangyin Feng, Haotian Wang, Qianglong Chen, Weihua

Peng, Xiaocheng Feng, Bing Qin, and Ting Liu. A survey on hallucination in large language models: Principles,

taxonomy, challenges, and open questions. ACM Transactions on Information Systems, November 2024.

[8] Meng-Chieh Lee, Qi Zhu, Costas Mavromatis, Zhen Han, Soji Adeshina, Vassilis N. Ioannidis, Huzefa Rangwala,

and Christos Faloutsos. Agent-g: An agentic framework for graph retrieval augmented generation, 2024.

[9] Penghao Zhao, Hailin Zhang, Qinhan Yu, Zhengren Wang, Yunteng Geng, Fangcheng Fu, Ling Yang, Wentao

Zhang, Jie Jiang, and Bin Cui. Retrieval-augmented generation for ai-generated content: A survey, 2024.

[10] Zhengbao Jiang, Frank F. Xu, Luyu Gao, Zhiqing Sun, Qian Liu, Jane Dwivedi-Yu, Yiming Yang, Jamie Callan,

and Graham Neubig. Active retrieval augmented generation, 2023.

[11] Yikun Han, Chunjiang Liu, and Pengfei Wang. A comprehensive survey on vector database: Storage and retrieval

technique, challenge, 2023.

[12] Lei Wang, Chen Ma, Xueyang Feng, Zeyu Zhang, Hao Yang, Jingsen Zhang, Zhiyuan Chen, Jiakai Tang,

Xu Chen, Yankai Lin, Wayne Xin Zhao, Zhewei Wei, and Jirong Wen. A survey on large language model based

autonomous agents. Frontiers of Computer Science, 18(6), March 2024.

[13] Aditi Singh, Saket Kumar, Abul Ehtesham, Tala Talaei Khoei, and Deepshikha Bhati. Large language modeldriven immersive agent. In 2024 IEEE World AI IoT Congress (AIIoT), pages 0619–0624, 2024.

[14] Matthew Renze and Erhan Guven. Self-reflection in llm agents: Effects on problem-solving performance, 2024.

[15] Xu Huang, Weiwen Liu, Xiaolong Chen, Xingmei Wang, Hao Wang, Defu Lian, Yasheng Wang, Ruiming Tang,

and Enhong Chen. Understanding the planning of llm agents: A survey, 2024.

[16] Taicheng Guo, Xiuying Chen, Yaqi Wang, Ruidi Chang, Shichao Pei, Nitesh V. Chawla, Olaf Wiest, and

Xiangliang Zhang. Large language model based multi-agents: A survey of progress and challenges, 2024.

[17] Chidaksh Ravuru, Sagar Srinivas Sakhinana, and Venkataramana Runkana. Agentic retrieval-augmented

generation for time series analysis, 2024.

[18] Jie Huang and Kevin Chen-Chuan Chang. Towards reasoning in large language models: A survey, 2023.

[19] Boci Peng, Yun Zhu, Yongchao Liu, Xiaohe Bo, Haizhou Shi, Chuntao Hong, Yan Zhang, and Siliang Tang.

Graph retrieval-augmented generation: A survey, 2024.

[20] Aditi Singh, Abul Ehtesham, Saifuddin Mahmud, and Jong-Hoon Kim. Revolutionizing mental health care

through langchain: A journey with a large language model. In 2024 IEEE 14th Annual Computing and

Communication Workshop and Conference (CCWC), pages 0073–0078, 2024.

[21] Gaurav Kumar Gupta, Aditi Singh, Sijo Valayakkad Manikandan, and Abul Ehtesham. Digital diagnostics: The

potential of large language models in recognizing symptoms of common illnesses, 2024.

[22] Aditi Singh, Abul Ehtesham, Saket Kumar, Gaurav Kumar Gupta, and Tala Talaei Khoei. Encouraging responsible

use of generative ai in education: A reward-based learning approach. In Tim Schlippe, Eric C. K. Cheng, and

Tianchong Wang, editors, Artificial Intelligence in Education Technologies: New Development and Innovative

Practices, pages 404–413, Singapore, 2025. Springer Nature Singapore.

[23] Yunfan Gao, Yun Xiong, Xinyu Gao, Kangxiang Jia, Jinliu Pan, Yuxi Bi, Yi Dai, Jiawei Sun, Meng Wang, and

Haofen Wang. Retrieval-augmented generation for large language models: A survey, 2024.

[24] Vladimir Karpukhin, Barlas Oguz, Sewon Min, Patrick Lewis, Ledell Wu, Sergey Edunov, Danqi Chen, and Wen ˘

tau Yih. Dense passage retrieval for open-domain question answering, 2020.

[25] Zeyu Zhang, Xiaohe Bo, Chen Ma, Rui Li, Xu Chen, Quanyu Dai, Jieming Zhu, Zhenhua Dong, and Ji-Rong

Wen. A survey on the memory mechanism of large language model based agents, 2024.

[26] Zhibin Gou, Zhihong Shao, Yeyun Gong, Yelong Shen, Yujiu Yang, Nan Duan, and Weizhu Chen. Critic: Large

language models can self-correct with tool-interactive critiquing, 2024.

[27] Aditi Singh, Abul Ehtesham, Saket Kumar, and Tala Talaei Khoei. Enhancing ai systems with agentic workflows

patterns in large language model. In 2024 IEEE World AI IoT Congress (AIIoT), pages 527–532, 2024.

[28] DeepLearning.AI. How agents can improve llm performance. https://www.deeplearning.ai/the-batch/

how-agents-can-improve-llm-performance/?ref=dl-staging-website.ghost.io, 2024. Accessed: 2025-01-13.

[29] Aman Madaan, Niket Tandon, Prakhar Gupta, Skyler Hallinan, Luyu Gao, Sarah Wiegreffe, Uri Alon, Nouha

Dziri, Shrimai Prabhumoye, Yiming Yang, Shashank Gupta, Bodhisattwa Prasad Majumder, Katherine Hermann,

Sean Welleck, Amir Yazdanbakhsh, and Peter Clark. Self-refine: Iterative refinement with self-feedback, 2023.

[30] Noah Shinn, Federico Cassano, Edward Berman, Ashwin Gopinath, Karthik Narasimhan, and Shunyu Yao.

Reflexion: Language agents with verbal reinforcement learning, 2023.

[31] Weaviate Blog. What is agentic rag? https://weaviate.io/blog/what-is-agentic-rag#:~:text=is%

20Agentic%20RAG%3F-,%E2%80%8B,of%20the%20non%2Dagentic%20pipeline. Accessed: 2025-01-14.

[32] Shi-Qi Yan, Jia-Chen Gu, Yun Zhu, and Zhen-Hua Ling. Corrective retrieval augmented generation, 2024.

[33] LangGraph CRAG Tutorial. Langgraph crag: Contextualized retrieval-augmented generation tutorial. https:

//langchain-ai.github.io/langgraph/tutorials/rag/langgraph_crag/. Accessed: 2025-01-14.

[34] Soyeong Jeong, Jinheon Baek, Sukmin Cho, Sung Ju Hwang, and Jong C. Park. Adaptive-rag: Learning to adapt

retrieval-augmented large language models through question complexity, 2024.

[35] LangGraph Adaptive RAG Tutorial. Langgraph adaptive rag: Adaptive retrieval-augmented generation tutorial. https://langchain-ai.github.io/langgraph/tutorials/rag/langgraph_adaptive_rag/.

Accessed: 2025-01-14.

[36] Zhili Shen, Chenxin Diao, Pavlos Vougiouklis, Pascual Merita, Shriram Piramanayagam, Damien Graux, Dandan

Tu, Zeren Jiang, Ruofei Lai, Yang Ren, and Jeff Z. Pan. Gear: Graph-enhanced agent for retrieval-augmented

generation, 2024.

[37] LlamaIndex. Introducing agentic document workflows. https://www.llamaindex.ai/blog/

introducing-agentic-document-workflows, 2025. Accessed: 2025-01-13.

[38] AWS Machine Learning Blog. How twitch used agentic workflow with rag on amazon

bedrock to supercharge ad sales. https://aws.amazon.com/blogs/machine-learning/

how-twitch-used-agentic-workflow-with-rag-on-amazon-bedrock-to-supercharge-ad-sales/,

2025. Accessed: 2025-01-13.

[39] LlamaCloud Demo Repository. Patient case summary workflow using llamacloud. https:

//github.com/run-llama/llamacloud-demo/blob/main/examples/document_workflows/

patient_case_summary/patient_case_summary.ipynb, 2025. Accessed: 2025-01-13.

[40] LlamaCloud Demo Repository. Contract review workflow using llamacloud. https://github.com/

run-llama/llamacloud-demo/blob/main/examples/document_workflows/contract_review/

contract_review.ipynb, 2025. Accessed: 2025-01-13.

[41] LlamaCloud Demo Repository. Auto insurance claims workflow using llamacloud. https:

//github.com/run-llama/llamacloud-demo/blob/main/examples/document_workflows/auto_

insurance_claims/auto_insurance_claims.ipynb, 2025. Accessed: 2025-01-13.

[42] LlamaCloud Demo Repository. Research paper report generation workflow using llamacloud.

https://github.com/run-llama/llamacloud-demo/blob/main/examples/report_generation/

research_paper_report_generation.ipynb, 2025. Accessed: 2025-01-13.

[43] LangGraph Agentic RAG Tutorial. Langgraph agentic rag: Nodes and edges tutorial. https://langchain-ai.

github.io/langgraph/tutorials/rag/langgraph_agentic_rag/#nodes-and-edges. Accessed:

2025-01-14.

[44] LlamaIndex Blog. Agentic rag with llamaindex. https://www.llamaindex.ai/blog/

agentic-rag-with-llamaindex-2721b8a49ff6. Accessed: 2025-01-14.

[45] Hugging Face Cookbook. Agentic rag: Turbocharge your retrieval-augmented generation with query reformulation and self-query. https://huggingface.co/learn/cookbook/en/agent_rag. Accessed: 2025-01-14.

[46] Qdrant Blog. Agentic rag: Combining rag with agents for enhanced information retrieval. https://qdrant.

tech/articles/agentic-rag/. Accessed: 2025-01-14.

[47] crewAI Inc. crewai: A github repository for ai projects. https://github.com/crewAIInc/crewAI, 2025.

Accessed: 2025-01-15.

[48] AG2AI Contributors. Ag2: A github repository for advanced generative ai research. https://github.com/

ag2ai/ag2, 2025. Accessed: 2025-01-15.

[49] Qingyun Wu, Gagan Bansal, Jieyu Zhang, Yiran Wu, Beibin Li, Erkang Zhu, Li Jiang, Xiaoyun Zhang, Shaokun

Zhang, Jiale Liu, Ahmed Hassan Awadallah, Ryen W White, Doug Burger, and Chi Wang. Autogen: Enabling

next-gen llm applications via multi-agent conversation framework. 2023.

[50] Shaokun Zhang, Jieyu Zhang, Jiale Liu, Linxin Song, Chi Wang, Ranjay Krishna, and Qingyun Wu. Training

language model agents without modifying language models. ICML’24, 2024.

[51] OpenAI. Swarm: Lightweight multi-agent orchestration framework. https://github.com/openai/swarm.

Accessed: 2025-01-14.

[52] LlamaIndex Documentation. Agentic rag using vertex ai. https://docs.llamaindex.ai/en/stable/

examples/agent/agentic_rag_using_vertex_ai/. Accessed: 2025-01-14.

[53] IBM Granite Community. Agentic rag: Ai agents with ibm granite models. https://github.com/

ibm-granite-community/granite-snack-cookbook/blob/main/recipes/AI-Agents/Agentic_

RAG.ipynb. Accessed: 2025-01-14.

[54] Nandan Thakur, Nils Reimers, Andreas Rücklé, Abhishek Srivastava, and Iryna Gurevych. Beir: A heterogenous

benchmark for zero-shot evaluation of information retrieval models, 2021.

[55] Payal Bajaj, Daniel Campos, Nick Craswell, Li Deng, Jianfeng Gao, Xiaodong Liu, Rangan Majumder, Andrew

McNamara, Bhaskar Mitra, Tri Nguyen, Mir Rosenberg, Xia Song, Alina Stoica, Saurabh Tiwary, and Tong

Wang. Ms marco: A human generated machine reading comprehension dataset, 2018.

[56] Nick Craswell, Bhaskar Mitra, Emine Yilmaz, Daniel Campos, Jimmy Lin, Ellen M. Voorhees, and Ian Soboroff.

Overview of the trec 2022 deep learning track. In Text REtrieval Conference (TREC). NIST, TREC, March 2023.

[57] Harsh Trivedi, Niranjan Balasubramanian, Tushar Khot, and Ashish Sabharwal. Musique: Multihop questions

via single-hop question composition, 2022.

[58] Xanh Ho, Anh-Khoa Duong Nguyen, Saku Sugawara, and Akiko Aizawa. Constructing a multi-hop qa dataset

for comprehensive evaluation of reasoning steps, 2020.

[59] Zhilin Yang, Peng Qi, Saizheng Zhang, Yoshua Bengio, William W. Cohen, Ruslan Salakhutdinov, and Christopher D. Manning. Hotpotqa: A dataset for diverse, explainable multi-hop question answering, 2018.

[60] Robert Friel, Masha Belyi, and Atindriyo Sanyal. Ragbench: Explainable benchmark for retrieval-augmented

generation systems, 2024.

[61] David Rau, Hervé Déjean, Nadezhda Chirkova, Thibault Formal, Shuai Wang, Vassilina Nikoulina, and Stéphane

Clinchant. Bergen: A benchmarking library for retrieval-augmented generation, 2024.

[62] Jiajie Jin, Yutao Zhu, Xinyu Yang, Chenghao Zhang, and Zhicheng Dou. Flashrag: A modular toolkit for efficient

retrieval-augmented generation research, 2024.

[63] Costas Mavromatis and George Karypis. Gnn-rag: Graph neural retrieval for large language model reasoning,

2024.

[64] Tom Kwiatkowski, Jennimaria Palomaki, Olivia Redfield, Michael Collins, Ankur Parikh, Chris Alberti, Danielle

Epstein, Illia Polosukhin, Jacob Devlin, Kenton Lee, Kristina Toutanova, Llion Jones, Matthew Kelcey, Ming-Wei

Chang, Andrew M. Dai, Jakob Uszkoreit, Quoc Le, and Slav Petrov. Natural questions: A benchmark for question

answering research. Transactions of the Association for Computational Linguistics, 7:452–466, 2019.

[65] Mandar Joshi, Eunsol Choi, Daniel S. Weld, and Luke Zettlemoyer. Triviaqa: A large scale distantly supervised

challenge dataset for reading comprehension, 2017.

[66] Pranav Rajpurkar, Jian Zhang, Konstantin Lopyrev, and Percy Liang. Squad: 100,000+ questions for machine

comprehension of text, 2016.

[67] Jonathan Berant, Andrew K. Chou, Roy Frostig, and Percy Liang. Semantic parsing on freebase from questionanswer pairs. In Conference on Empirical Methods in Natural Language Processing, 2013.

[68] Alex Mallen, Akari Asai, Victor Zhong, Rajarshi Das, Daniel Khashabi, and Hannaneh Hajishirzi. When not to

trust language models: Investigating effectiveness of parametric and non-parametric memories. In Anna Rogers,

Jordan Boyd-Graber, and Naoaki Okazaki, editors, Proceedings of the 61st Annual Meeting of the Association for

Computational Linguistics (Volume 1: Long Papers), pages 9802–9822, Toronto, Canada, July 2023. Association

for Computational Linguistics.

[69] Angela Fan, Yacine Jernite, Ethan Perez, David Grangier, Jason Weston, and Michael Auli. Eli5: Long form

question answering, 2019.

[70] Tomáš Kociský, Jonathan Schwarz, Phil Blunsom, Chris Dyer, Karl Moritz Hermann, Gábor Melis, and Edward ˇ

Grefenstette. The narrativeqa reading comprehension challenge. 2017.

[71] Ivan Stelmakh, Yi Luan, Bhuwan Dhingra, and Ming-Wei Chang. Asqa: Factoid questions meet long-form

answers, 2023.

[72] Ming Zhong, Da Yin, Tao Yu, Ahmad Zaidi, Mutethia Mutuma, Rahul Jha, Ahmed Hassan Awadallah, Asli

Celikyilmaz, Yang Liu, Xipeng Qiu, and Dragomir Radev. QMSum: A new benchmark for query-based

multi-domain meeting summarization. pages 5905–5921, June 2021.

[73] Pradeep Dasigi, Kyle Lo, Iz Beltagy, Arman Cohan, Noah A. Smith, and Matt Gardner. A dataset of informationseeking questions and answers anchored in research papers. In Kristina Toutanova, Anna Rumshisky, Luke

Zettlemoyer, Dilek Hakkani-Tur, Iz Beltagy, Steven Bethard, Ryan Cotterell, Tanmoy Chakraborty, and Yichao

Zhou, editors, Proceedings of the 2021 Conference of the North American Chapter of the Association for

Computational Linguistics: Human Language Technologies, pages 4599–4610, Online, June 2021. Association

for Computational Linguistics.

[74] Timo Möller, Anthony Reina, Raghavan Jayakumar, and Malte Pietsch. COVID-QA: A question answering

dataset for COVID-19. In ACL 2020 Workshop on Natural Language Processing for COVID-19 (NLP-COVID),

2020.

[75] Xidong Wang, Guiming Hardy Chen, Dingjie Song, Zhiyi Zhang, Zhihong Chen, Qingying Xiao, Feng Jiang,

Jianquan Li, Xiang Wan, Benyou Wang, and Haizhou Li. Cmb: A comprehensive medical benchmark in chinese,

2024.

[76] Richard Yuanzhe Pang, Alicia Parrish, Nitish Joshi, Nikita Nangia, Jason Phang, Angelica Chen, Vishakh

Padmakumar, Johnny Ma, Jana Thompson, He He, and Samuel R. Bowman. Quality: Question answering with

long input texts, yes!, 2022.

[77] Alon Talmor, Jonathan Herzig, Nicholas Lourie, and Jonathan Berant. CommonsenseQA: A question answering

challenge targeting commonsense knowledge. In Jill Burstein, Christy Doran, and Thamar Solorio, editors,

Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational

Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers), pages 4149–4158, Minneapolis,

Minnesota, June 2019. Association for Computational Linguistics.

[78] Xiaoxin He, Yijun Tian, Yifei Sun, Nitesh V. Chawla, Thomas Laurent, Yann LeCun, Xavier Bresson, and Bryan

Hooi. G-retriever: Retrieval-augmented generation for textual graph understanding and question answering,

2024.

[79] Sha Li, Heng Ji, and Jiawei Han. Document-level event argument extraction by conditional generation, 2021.

[80] Seth Ebner, Patrick Xia, Ryan Culkin, Kyle Rawlins, and Benjamin Van Durme. Multi-sentence argument

linking, 2020.

[81] Emily Dinan, Stephen Roller, Kurt Shuster, Angela Fan, Michael Auli, and Jason Weston. Wizard of wikipedia:

Knowledge-powered conversational agents, 2019.

[82] Hongru Wang, Minda Hu, Yang Deng, Rui Wang, Fei Mi, Weichao Wang, Yasheng Wang, Wai-Chung Kwan,

Irwin King, and Kam-Fai Wong. Large language models as source planner for personalized knowledge-grounded

dialogue, 2023.

[83] Xinchao Xu, Zhibin Gou, Wenquan Wu, Zheng-Yu Niu, Hua Wu, Haifeng Wang, and Shihang Wang. Long time

no see! open-domain conversation with long-term persona memory, 2022.

[84] Tsung-Hsien Wen, Milica Gašic, Nikola Mrkši ´ c, Lina M. Rojas-Barahona, Pei-Hao Su, Stefan Ultes, David ´

Vandyke, and Steve Young. Conditional generation and snapshot learning in neural dialogue systems. In

Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing, pages 2153–2162,

Austin, Texas, November 2016. Association for Computational Linguistics.

[85] Ruining He and Julian McAuley. Ups and downs: Modeling the visual evolution of fashion trends with one-class

collaborative filtering. In Proceedings of the 25th International Conference on World Wide Web, WWW ’16, page

507–517, Republic and Canton of Geneva, CHE, 2016. International World Wide Web Conferences Steering

Committee.

[86] Rowan Zellers, Ari Holtzman, Yonatan Bisk, Ali Farhadi, and Yejin Choi. HellaSwag: Can a machine really

finish your sentence? In Anna Korhonen, David Traum, and Lluís Màrquez, editors, Proceedings of the 57th

Annual Meeting of the Association for Computational Linguistics, pages 4791–4800, Florence, Italy, July 2019.

Association for Computational Linguistics.

[87] Seungone Kim, Se June Joo, Doyoung Kim, Joel Jang, Seonghyeon Ye, Jamin Shin, and Minjoon Seo. The

cot collection: Improving zero-shot and few-shot learning of language models via chain-of-thought fine-tuning,

2023.

[88] Amrita Saha, Vardaan Pahuja, Mitesh M. Khapra, Karthik Sankaranarayanan, and Sarath Chandar. Complex

sequential question answering: Towards learning to converse over linked question answer pairs with a knowledge

graph. 2018.

[89] James Thorne, Andreas Vlachos, Christos Christodoulopoulos, and Arpit Mittal. FEVER: a large-scale dataset for

fact extraction and VERification. In Marilyn Walker, Heng Ji, and Amanda Stent, editors, Proceedings of the 2018

Conference of the North American Chapter of the Association for Computational Linguistics: Human Language

Technologies, Volume 1 (Long Papers), pages 809–819, New Orleans, Louisiana, June 2018. Association for

Computational Linguistics.

[90] Neema Kotonya and Francesca Toni. Explainable automated fact-checking for public health claims, 2020.

[91] Mor Geva, Daniel Khashabi, Elad Segal, Tushar Khot, Dan Roth, and Jonathan Berant. Did aristotle use a laptop?

a question answering benchmark with implicit reasoning strategies, 2021.

[92] Hiroaki Hayashi, Prashant Budania, Peng Wang, Chris Ackerson, Raj Neervannan, and Graham Neubig. Wikiasp:

A dataset for multi-domain aspect-based summarization, 2020.

[93] Shashi Narayan, Shay B. Cohen, and Mirella Lapata. Don’t give me the details, just the summary! topic-aware

convolutional neural networks for extreme summarization, 2018.

[94] Richard Socher, Alex Perelygin, Jean Wu, Jason Chuang, Christopher D. Manning, Andrew Ng, and Christopher

Potts. Recursive deep models for semantic compositionality over a sentiment treebank. In David Yarowsky,

Timothy Baldwin, Anna Korhonen, Karen Livescu, and Steven Bethard, editors, Proceedings of the 2013

Conference on Empirical Methods in Natural Language Processing, pages 1631–1642, Seattle, Washington,

USA, October 2013. Association for Computational Linguistics.

[95] Sourav Saha, Jahedul Alam Junaed, Maryam Saleki, Arnab Sen Sharma, Mohammad Rashidujjaman Rifat,

Mohamed Rahouti, Syed Ishtiaque Ahmed, Nabeel Mohammed, and Mohammad Ruhul Amin. Vio-lens: A novel

dataset of annotated social network posts leading to different forms of communal violence and its evaluation. In

Firoj Alam, Sudipta Kar, Shammur Absar Chowdhury, Farig Sadeque, and Ruhul Amin, editors, Proceedings

of the First Workshop on Bangla Language Processing (BLP-2023), pages 72–84, Singapore, December 2023.

Association for Computational Linguistics.

[96] Hamel Husain, Ho-Hsiang Wu, Tiferet Gazit, Miltiadis Allamanis, and Marc Brockschmidt. Codesearchnet

challenge: Evaluating the state of semantic code search, 2020.

[97] Nandan Thakur, Luiz Bonifacio, Xinyu Zhang, Odunayo Ogundepo, Ehsan Kamalloo, David Alfonso-Hermelo,

Xiaoguang Li, Qun Liu, Boxing Chen, Mehdi Rezagholizadeh, and Jimmy Lin. "knowing when you don’t know":

A multilingual relevance assessment dataset for robust retrieval-augmented generation, 2024.

[98] Stephen Merity, Caiming Xiong, James Bradbury, and Richard Socher. Pointer sentinel mixture models, 2016.

[99] Karl Cobbe, Vineet Kosaraju, Mohammad Bavarian, Mark Chen, Heewoo Jun, Lukasz Kaiser, Matthias Plappert,

Jerry Tworek, Jacob Hilton, Reiichiro Nakano, Christopher Hesse, and John Schulman. Training verifiers to

solve math word problems, 2021.

[100] Ralf Steinberger, Bruno Pouliquen, Anna Widiger, Camelia Ignat, Tomaž Erjavec, Dan Tufi¸s, and Dániel Varga.

The JRC-Acquis: A multilingual aligned parallel corpus with 20+ languages. In Nicoletta Calzolari, Khalid

Choukri, Aldo Gangemi, Bente Maegaard, Joseph Mariani, Jan Odijk, and Daniel Tapias, editors, Proceedings of

the Fifth International Conference on Language Resources and Evaluation (LREC‘06), Genoa, Italy, May 2006.

European Language Resources Association (ELRA).

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...