你是否想在 Obsidian 内部使用本地大语言模型(LLM),就像 ChatGPT 一样,并且完全免费?如果答案是肯定的,那么本指南正适合你!我将引导你完成在 Obsidian 中安装和使用 DeepSeek-R1 模型的详细步骤,这样你就可以在笔记软件中拥有一个由 AI 驱动的“第二大脑”。

什么是 DeepSeek LLM?

DeepSeek LLM 是一种本地大语言模型 (LLM),可让你直接在设备上运行 AI。与在线 AI 工具不同,DeepSeek 可以保护你的数据隐私,离线工作,并让你完全掌控工作流程。

DeepSeek AI R1 因其先进的推理能力和效率而备受关注。以下是它脱颖而出的原因:

- 高级推理: DeepSeek-R1 在解决复杂问题和数学推理方面表现出色,使其成为研究和技术任务的理想选择。

- 高效的资源利用: 尽管拥有约 6700 亿个参数,但它仅使用 2,000 个 NVIDIA H800 芯片进行训练,从而显著降低了成本。

- 更快的训练速度: 该模型仅用 55 天就完成了训练,成本为 560 万美元,远低于其他大规模模型。

- 开放和可定制:DeepSeek-R1 的开放权重框架允许用户针对特定需求对其进行微调和调整。

- 在本地设备上运行:与许多依赖云的 AI 模型不同,其紧凑的尺寸使其可以在个人计算机和移动设备上运行。

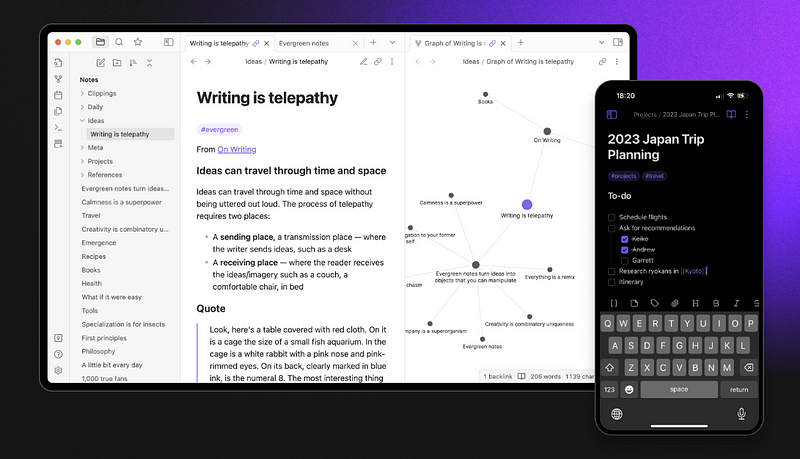

什么是 Obsidian?

如果你不知道 Obsidian 是什么。Obsidian 是一款强大的笔记和知识管理应用程序,可帮助用户使用链接的、基于图的结构来组织信息。它以基于 Markdown 的笔记、通过社区插件进行的自定义以及对本地优先、注重隐私的工作流程的支持而广受欢迎。许多用户将 Obsidian 称为“第二大脑”,因为它允许他们创建相互关联的想法网络,使其成为研究人员、作家和效率爱好者的绝佳工具。

如何在 Obsidian 中安装 DeepSeek LLM

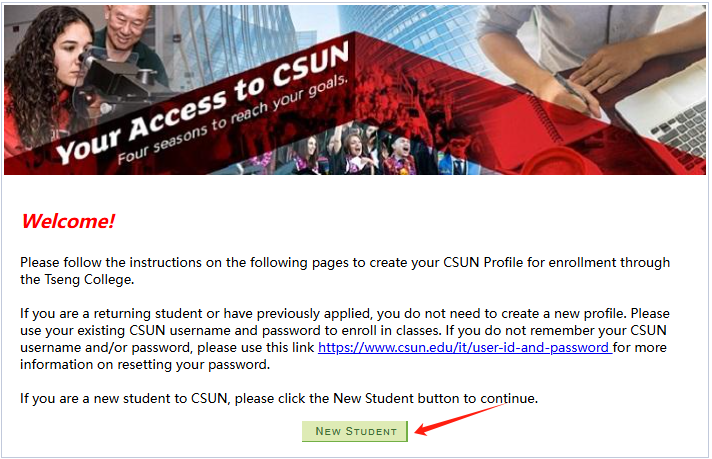

步骤 1:安装 Obsidian

如果你尚未安装 Obsidian,请从 https://obsidian.md 下载并安装。

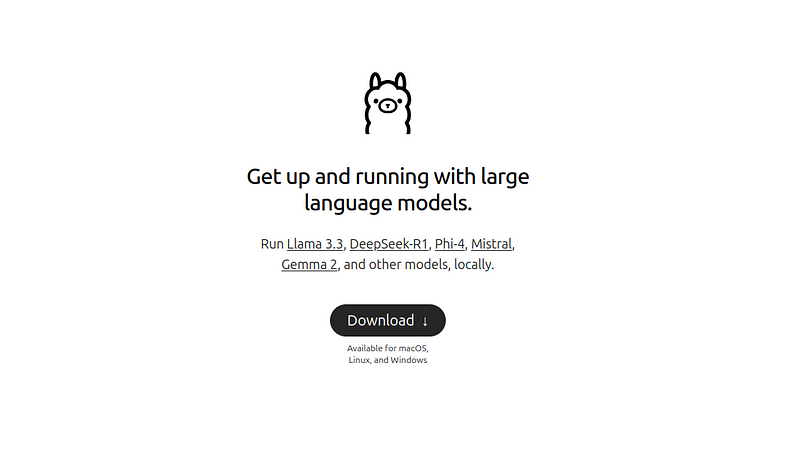

步骤 2:安装 Ollama(运行 DeepSeek 的必要条件)

DeepSeek LLM 需要一个名为 Ollama 的工具才能在本地运行。以下是安装方法:

- 访问 https://ollama.ai 并下载 Ollama。

- 选择你的操作系统(Windows、Mac 或 Linux)。Linux 的命令是

curl -fsSL https://ollama.com/install.sh | sh - 按照安装说明进行操作。

- 安装完成后,打开终端并运行以下命令进行验证:

ollama --version

如果看到版本号,则说明 Ollama 已正确安装。

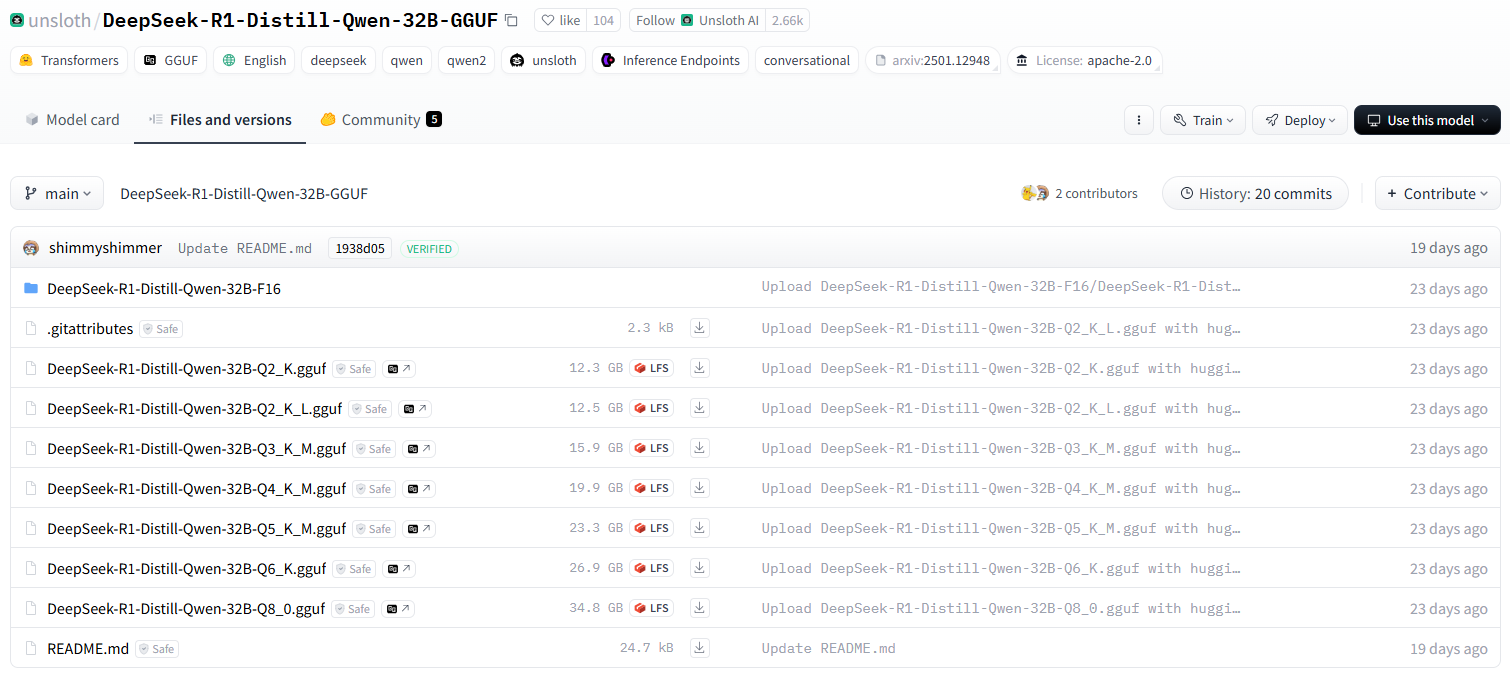

步骤 3:下载并设置 DeepSeek LLM

现在,通过在终端中运行以下命令来安装 DeepSeek-R1 模型:

ollama run deepseek-r1:8b

其他 DeepSeek 模型可以在这里找到。

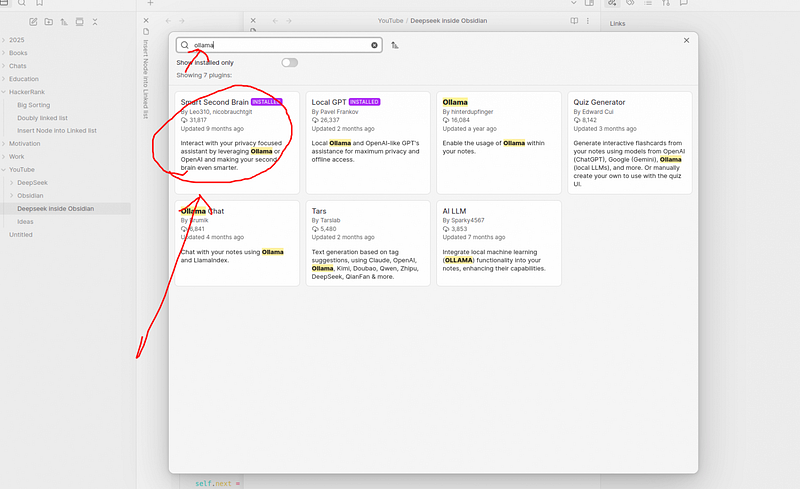

步骤 4:安装 Obsidian AI 插件

要将 DeepSeek 与 Obsidian 连接,请安装一个 AI 插件:

- 打开 Obsidian 并转到“设置”>“社区插件”。

- 点击“浏览”并搜索 Smart Second Brain 或 Obsidian AI。

- 点击“安装”,然后启用该插件。

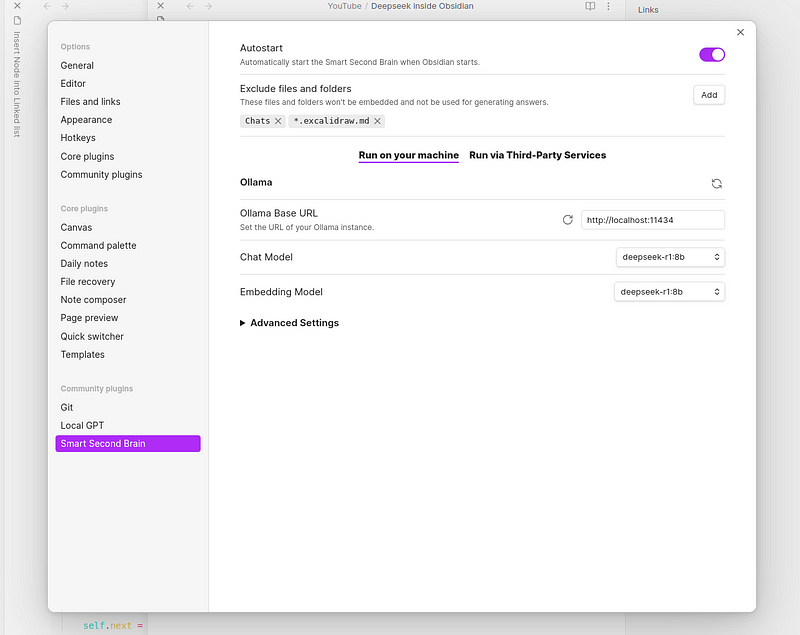

步骤 5:配置插件

安装完成后,配置插件:

- 打开“设置”>“插件设置”。

- 将 API URL 设置为 http://localhost:11434 (这是 Ollama 的默认设置)。

- 在“聊天模型”部分中,选择 deepseek。

- 保存你的设置并重启 Obsidian。

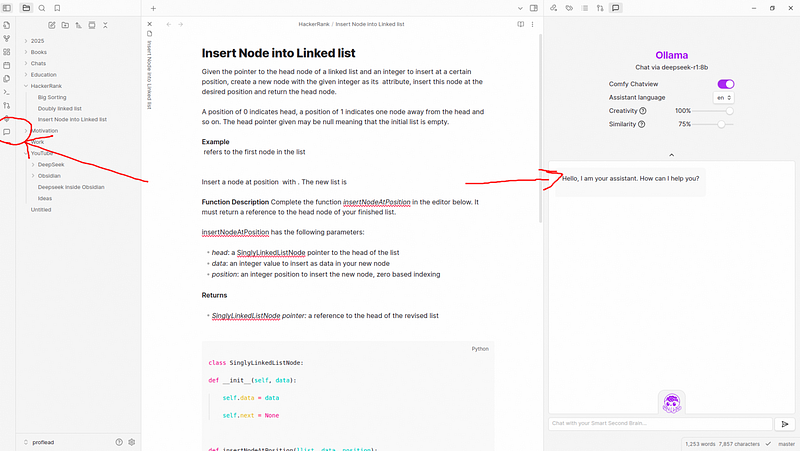

如何在 Obsidian 内部访问 DeepSeek

现在你已准备好在 Obsidian 内部使用 AI!

- 点击左侧边栏中的 AI 聊天图标。

- 在聊天框中输入你的查询,然后按 Enter 键。

- DeepSeek 将直接在 Obsidian 内部生成响应。

你可以执行以下操作:

- 生成内容 - 请求 DeepSeek 创建文本、想法或摘要。

- 总结笔记 - 选择文本,让 AI 生成快速摘要。

- 提问 - 获取有关编程、数学、语法等方面的答案。

- 翻译文本 - 使用 AI 获得多语言支持。

- 提取见解 - 从大型文档中提取要点。

- 集思广益 - 为项目或写作获得创意建议。

结论

将 DeepSeek R1 与 Obsidian 结合使用,可为你提供强大、私密和离线的 AI 助手。试用一下,并在下面的评论中告诉我你的想法!如果你觉得本指南有帮助!

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...