简介

在人工智能领域,基础模型(如大型语言模型和视觉语言模型)已经成为推动技术进步的核心力量。然而,如何有效地提升这些模型的泛化能力,使其能够适应各种复杂多变的现实场景,仍然是一个重大挑战。当前,监督微调(SFT)和强化学习(RL)是两种广泛采用的后训练方法,但它们在提升模型泛化能力方面的具体作用和效果仍不明确。

本论文通过一项深入的比较研究,系统地探讨了 SFT 和 RL 对基础模型泛化能力的影响。我们重点关注以下两个关键方面:

- 基于文本规则的泛化: 我们设计了一个名为 GeneralPoints 的算术推理卡片游戏,评估模型在不同规则变体下的表现。

- 视觉泛化: 我们采用了 V-IRL 任务,一个基于真实世界视觉输入的导航环境,测试模型在视觉输入变化下的适应能力。

通过一系列严谨的实验和分析,我们得出了以下重要结论:

- RL 在规则和视觉泛化方面均优于 SFT: RL 能够有效地学习并应用新规则,同时在视觉输入变化的情况下也能保持良好的性能。相比之下,SFT 倾向于记忆训练数据,难以适应未见过的变体。

- RL 提升了视觉识别能力: 在视觉语言模型(VLM)中,RL 不仅提高了推理能力,还增强了视觉识别能力,而 SFT 则会降低视觉识别能力。

- SFT 对 RL 训练至关重要: 当主干模型不具备良好的指令跟随能力时,SFT 是 RL 训练成功的关键因素。它能够稳定模型的输出格式,使 RL 能够充分发挥其性能优势。

- 扩大验证迭代次数可提升 RL 泛化能力: 在 RL 训练中,增加验证迭代次数可以进一步提高模型的泛化能力。

这些发现为未来的 AI 研究和应用提供了宝贵的见解,表明 RL 在复杂多模态任务中具有更大的潜力。我们的研究不仅揭示了 SFT 和 RL 的不同作用,还为如何更有效地结合这两种方法以构建更强大、更可靠的基础模型提供了新的思路。

无论您是 AI 研究人员、工程师,还是对人工智能的未来发展充满兴趣的读者,这篇论文都将为您提供深刻的见解和实用的指导。 让我们一起深入探索 SFT 和 RL 的奥秘,揭示基础模型泛化的关键路径。

原文:https://tianzhechu.com/SFTvsRL/assets/sftvsrl_paper.pdf

快速阅读

1. RL 在规则泛化方面优于 SFT

结论:

RL 能够有效地学习并泛化基于文本的规则,而 SFT 则倾向于记忆训练数据,难以适应未见过的规则变体。

示例:

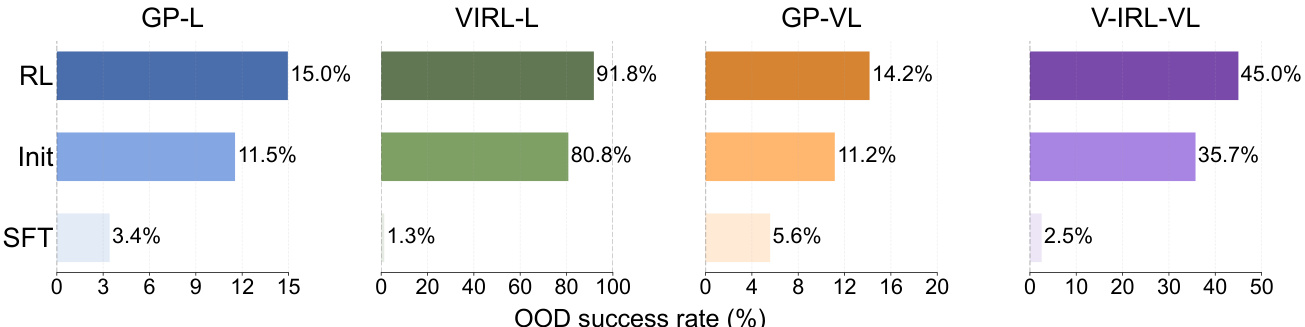

在 GeneralPoints 和 V-IRL 任务中,RL 在分布外(OOD)性能上均优于 SFT。

- GeneralPoints (GP-L):

- RL: 成功率为 15.0%,相比初始检查点的 11.5% 提高了 +3.5%。

- SFT: 成功率为 3.4%,相比初始检查点的 11.5% 下降了 -8.1%。

- V-IRL (V-IRL-L):

- RL: 每步准确率为 91.8%,相比初始检查点的 80.8% 提高了 +11.0%。

- SFT: 每步准确率为 1.3%,相比初始检查点的 80.8% 下降了 -79.5%。

图 6:对于每个子图,RL 和 SFT 使用相同的计算量进行训练,它们的共享初始检查点(标记为 Init)被设为基线。详细设置见附录 C.3。

2. RL 在视觉 OOD 任务中也能实现泛化,而 SFT 则表现不佳

结论:

即使在包含视觉模态的任务中,RL 仍然能够泛化到未见过的视觉变体,而 SFT 则会遭遇性能下降。

示例:

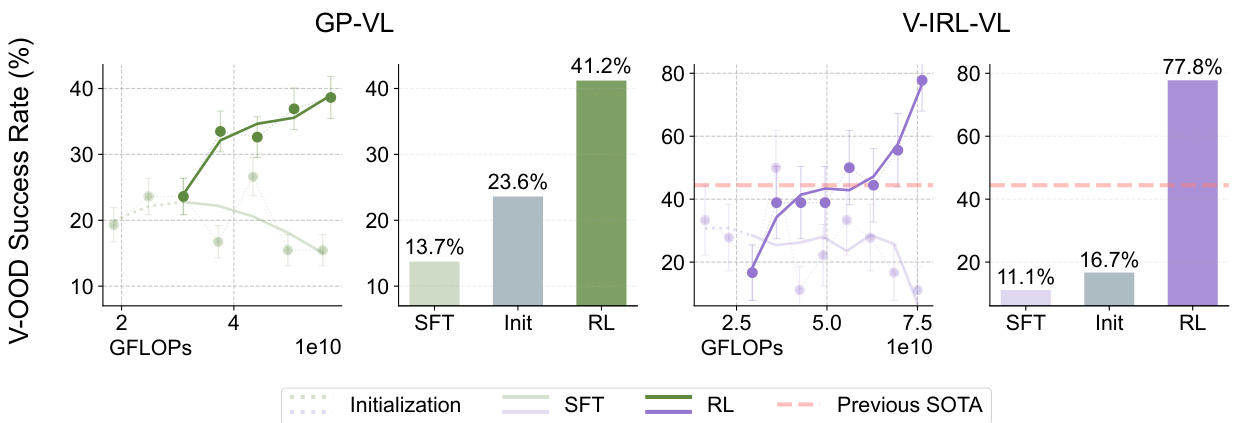

在 GeneralPoints-VI 和 V-IRL-VL 任务中:

- GeneralPoints-VI (GP-VI):

- RL: 成功率为 41.2%,相比初始检查点的 23.6% 提高了 +17.6%。

- SFT: 成功率为 13.7%,相比初始检查点的 23.6% 下降了 -9.9%。

- V-IRL-VL (V-IRL-VL):

- RL: 每步准确率为 77.8%,相比初始检查点的 16.7% 提高了 +61.1%。

- SFT: 每步准确率为 11.1%,相比初始检查点的 16.7% 下降了 -5.6%。

图 7:与图 5 和图 6 类似,我们展示了视觉分布外评估的性能动态(显示为线条)和最终性能(显示为条形)。之前在 V− IRL VLN 小型基准测试上的最先进水平(Yang 等,2024a)用橙色标记。详细评估设置(和曲线平滑)见附录 C.3。

3. RL 提高了 VLM 的视觉识别能力

结论:

RL 不仅能提高模型的推理能力,还能增强其视觉识别能力,而 SFT 则会降低视觉识别能力。

示例:

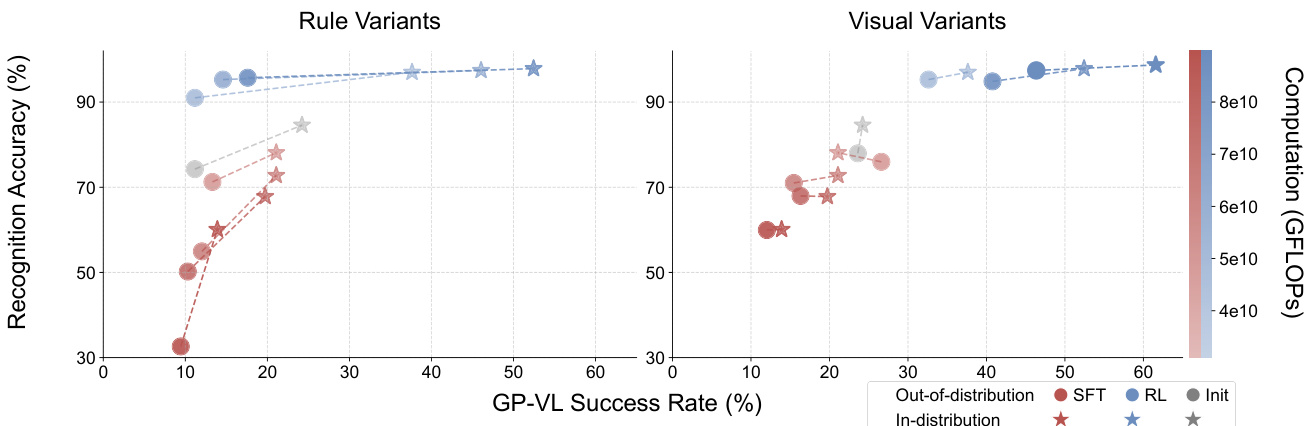

在 GeneralPoints-VI 任务中:

- RL: 随着训练计算量的增加,视觉识别准确率和整体成功率均有所提高。

- SFT: 随着训练计算量的增加,视觉识别准确率和整体成功率均有所下降。

图 8:GP-VL 不同变体下强化学习 (RL) 和监督微调 (SFT) 的识别率与成功率对比。 图中展示了识别率 (y 轴) 和单幕成功率 (x 轴) 的表现,分别对应分布内数据 (红色) 和分布外数据 (蓝色)。 数据点的透明度(颜色条)代表训练计算量。 用线条连接的 (⋆-◦) 数据对是使用相同的检查点评估的。 结果表明,随着后训练计算量的增加,强化学习 (RL) 在识别率和整体准确率上均有所提升,而监督微调 (SFT) 则呈现相反的趋势。

图 8:GP-VL 不同变体下强化学习 (RL) 和监督微调 (SFT) 的识别率与成功率对比。 图中展示了识别率 (y 轴) 和单幕成功率 (x 轴) 的表现,分别对应分布内数据 (红色) 和分布外数据 (蓝色)。 数据点的透明度(颜色条)代表训练计算量。 用线条连接的 (⋆-◦) 数据对是使用相同的检查点评估的。 结果表明,随着后训练计算量的增加,强化学习 (RL) 在识别率和整体准确率上均有所提升,而监督微调 (SFT) 则呈现相反的趋势。

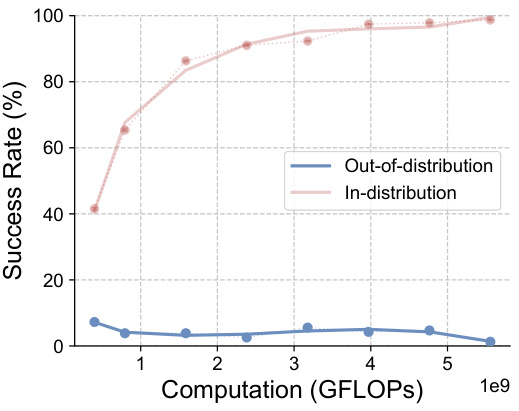

4. SFT 对于 RL 训练是必要的

结论:

当主干模型不具备良好的指令跟随能力时,SFT 对于 RL 训练是必要的。

示例:

在没有 SFT 初始化的情况下,直接应用端到端 RL 对 Llama-3.2 进行后训练的所有实验均以失败告终。

- 失败案例分析:

- 模型生成冗长、离题和无结构的响应,无法检索与 RL 训练相关的信息和奖励。

- 例如,模型尝试通过编写代码来解决 24 点游戏,但未能完成代码生成,导致验证失败。

![]()

图 20:我们使用与图 11 所示的提示相似的提示记录模型响应。结果表明,Llama-3.2-Vision-11B 无法正确遵循指令。我们省略了试图通过代码解决难题的冗长响应,但未能完成在有限上下文长度内完成。

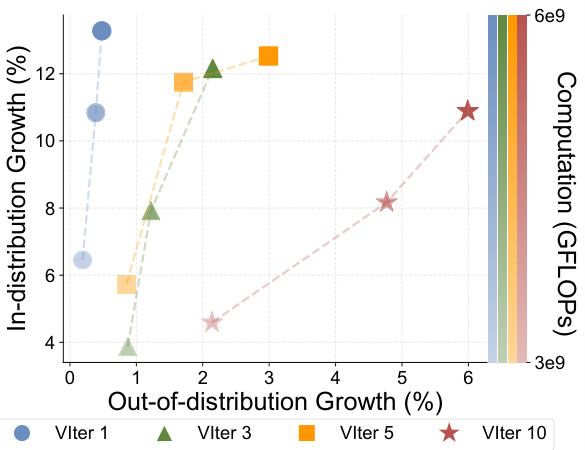

5. 扩大验证迭代次数可以提高 RL 的泛化能力

结论:

在 RL 训练中,增加验证迭代次数可以提高模型的泛化能力。

示例:

在 GeneralPoints-Language (GP-L) 任务中:

- 1 次验证迭代: OOD 性能仅提高了 +0.48%。

- 3 次验证迭代: OOD 性能提高了 +2.15%。

- 5 次验证迭代: OOD 性能提高了 +2.99%。

- 10 次验证迭代: OOD 性能提高了 +5.99%。

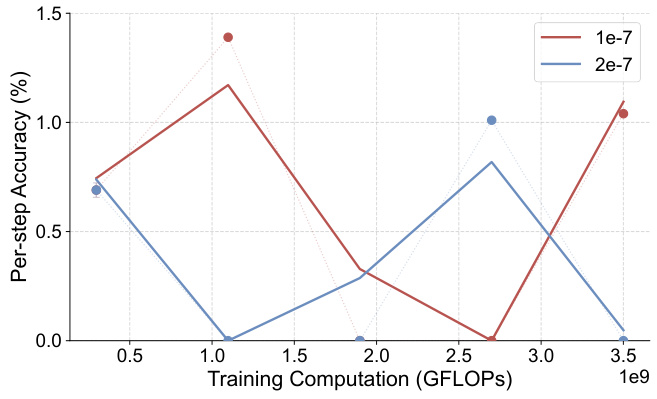

图 10:我们记录了具有不同数量的验证迭代(VIter)的 RL 实验,作为扩大训练计算量(颜色透明度度)。

6. SFT 过度拟合到推理标记,而忽略了识别标记

结论:

SFT 倾向于过度拟合到推理标记,而对识别标记的关注不足,这可能是由于推理标记的频率较高。

示例:

在 GeneralPoints-VI 任务中,SFT 无法实现与 RL 可比的分布内性能,即使在调整超参数后也是如此。

- SFT 消融研究:

- 调整学习率和其他可调组件后,SFT 的成功率均未超过 30%,且没有显示出增长趋势。

图 16:GeneralPoints-VL SFT 的消融研究。 我们对学习率进行了消融实验,并报告了所有实验的分布内单幕成功率 (%)。 所有实验的成功率都没有超过 30%,并且没有表现出增长的趋势。

7. RL 无法从过度拟合的检查点恢复 OOD 性能

结论:

当从过度拟合的检查点初始化时,RL 无法恢复模型的 OOD 性能。

示例:

在 V-IRL-VL 任务中:

- RL 从过度拟合的检查点初始化:

- 初始每步准确率低于 1%,RL 无法提高 OOD 性能。

图 19:分布外单步准确率 (%) - GFLOPs:规则变体下 V-IRL-VL 模型(使用过拟合初始检查点)。评估指标详情详见附录 C.3。

总结

本论文通过一系列实验和分析,证明了 RL 在学习可泛化知识方面的优势,以及 SFT 倾向于记忆训练数据的倾向。同时,论文也强调了 SFT 对于 RL 训练的重要性,以及扩大验证迭代次数对 RL 泛化能力的积极影响。这些发现为未来构建更强大、更可靠的基础模型提供了宝贵的见解。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...