综合介绍

VITA是一个领先的开源交互式多模态大语言模型项目,率先实现了真正的全方位多模态交互能力。该项目于2024年8月推出VITA-1.0版本,开创了首个开源交互式全模态大语言模型的先河。2024年12月,项目推出了重大升级版本VITA-1.5,在交互体验和性能方面都有显著提升。VITA模型支持图像、视频、音频等多种模态的输入和输出,具备实时交互能力,将端到端的语音交互延迟从4秒显著降低到1.5秒,极大提升了用户体验。作为一个完全开源的项目,VITA为研究人员和开发者提供了探索多模态AI的理想平台。

功能列表

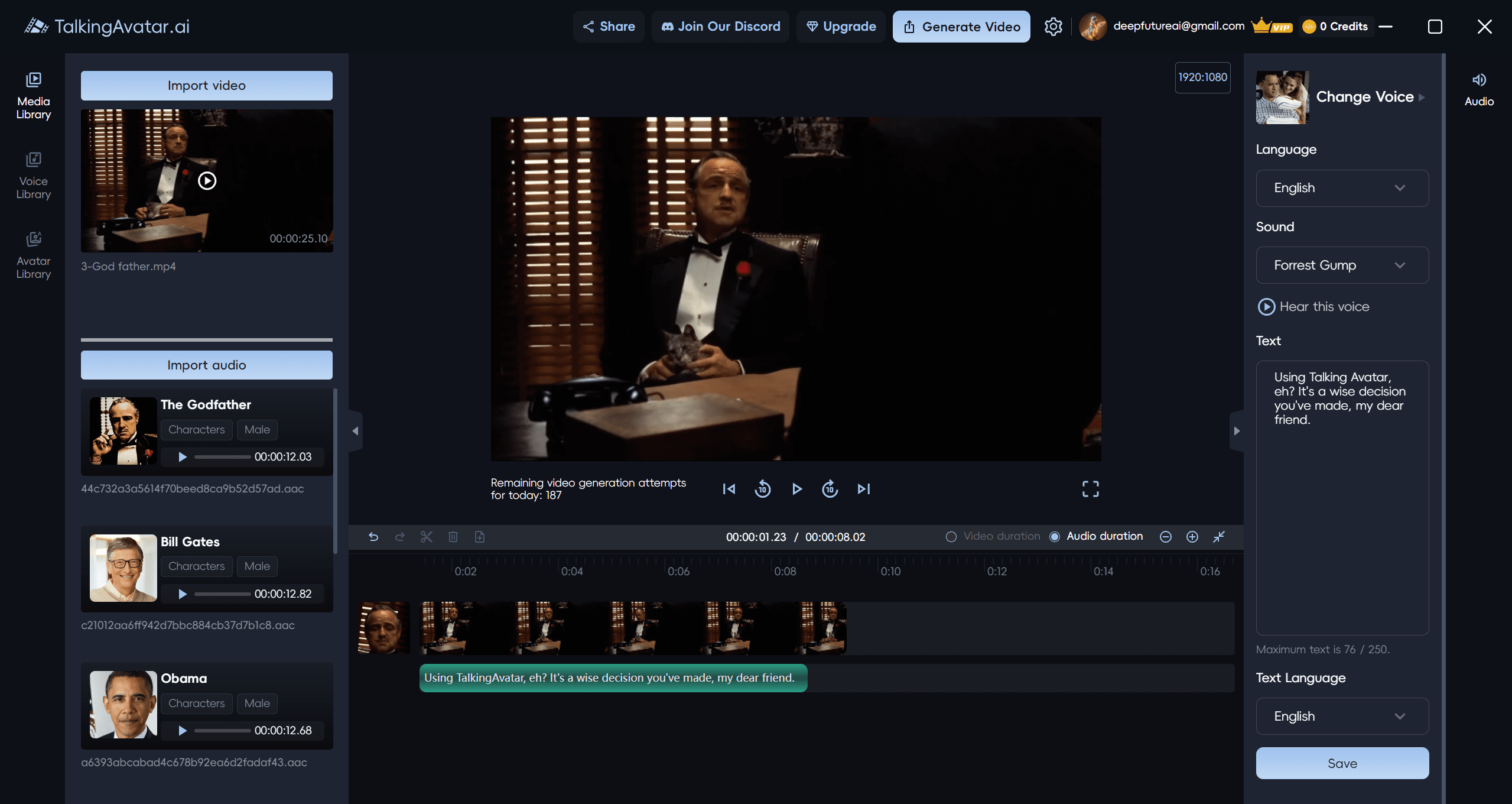

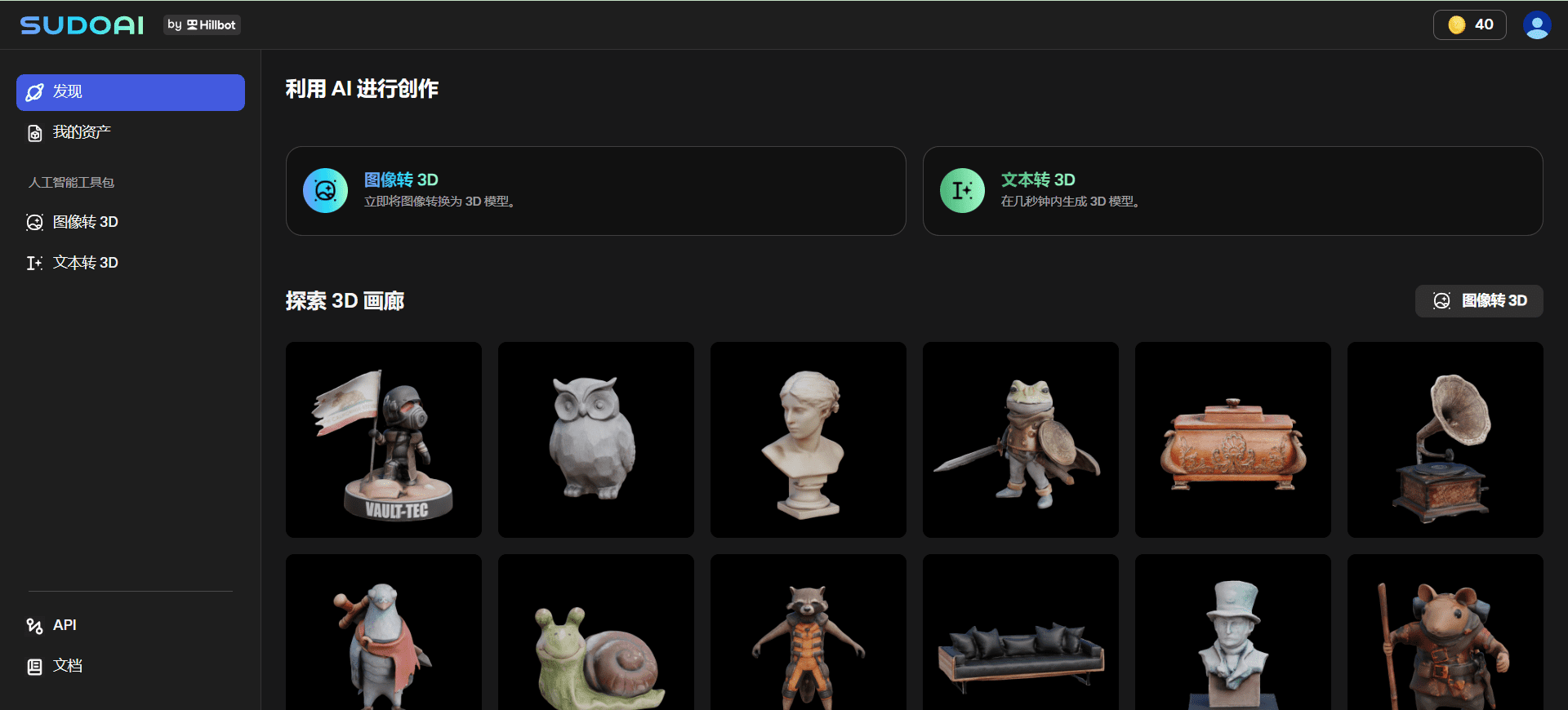

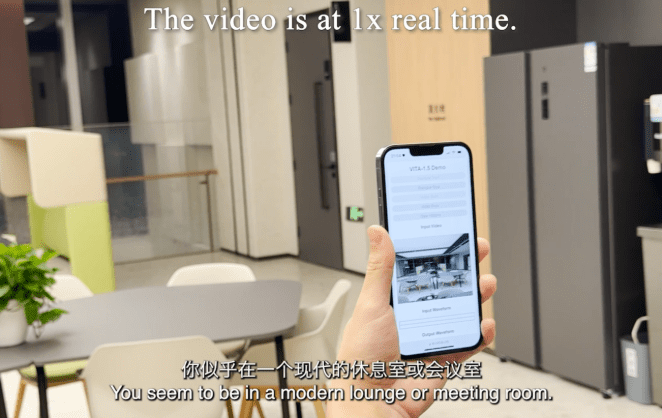

- 多模态输入处理:支持图像、视频、音频等多种形式的输入

- 实时语音交互:端到端语音交互延迟仅1.5秒

- 视觉分析能力:强大的图像和视频理解与分析功能

- 音频处理:支持语音识别和语音合成

- 跨模态理解:实现文本、图像、音频间的智能关联

- 开源代码支持:完整的训练和推理代码开放

- 预训练模型:提供多个预训练模型版本

- 灵活的部署选项:支持多种硬件平台部署

VITA-1.5 概览

在 2024 年 8 月 12 日,我们发布了 VITA-1.0,这是 首个开源的交互式全能多模态大语言模型。现在(2024 年 12 月 20 日),我们带来了 新版本 VITA-1.5!

VITA-1.5 有哪些新功能?

我们很高兴地介绍 VITA-1.5,它引入了一系列进步:

- 显著减少交互延迟。端到端语音交互延迟已从 约 4 秒 减少到 1.5 秒,实现了几乎即时的交互,大大提升了用户体验。

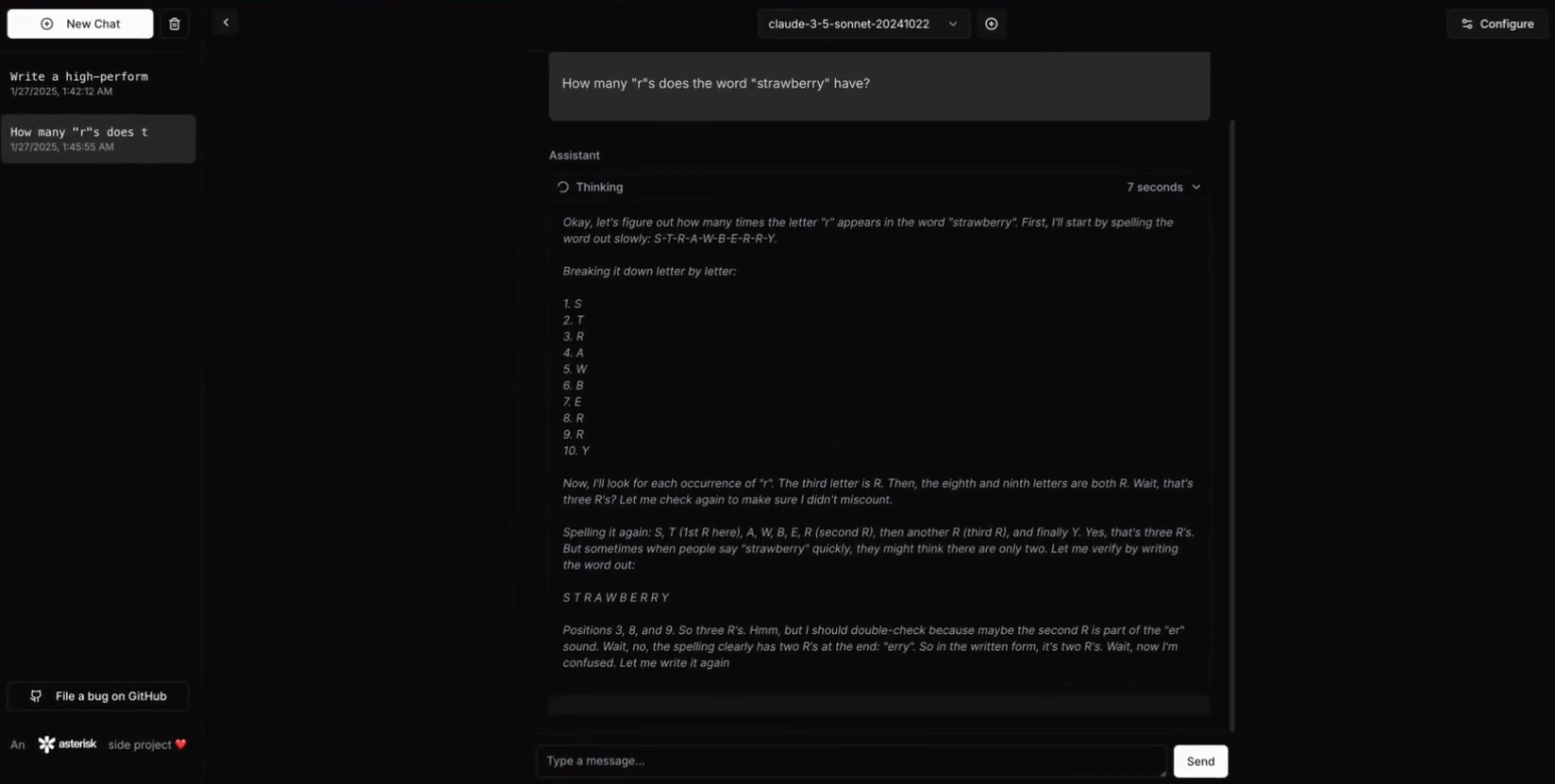

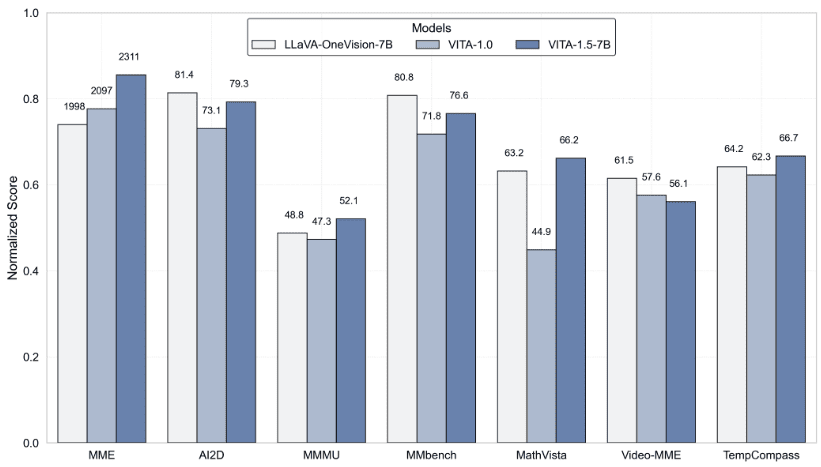

- 增强的多模态性能。在 MME、MMBench 和 MathVista 等多模态基准测试中的平均性能显著提升,从 59.8 提高到 70.8。

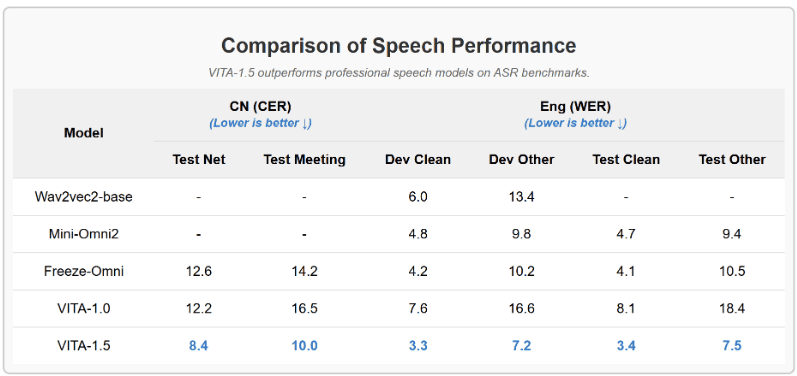

- 语音处理能力的提升。语音处理能力达到新水平,ASR WER(单词错误率,Test Other)从 18.4 降低到 7.5。此外,我们用 端到端 TTS 模块 替换了 VITA-1.0 的独立 TTS 模块,该模块接受大语言模型的嵌入作为输入。

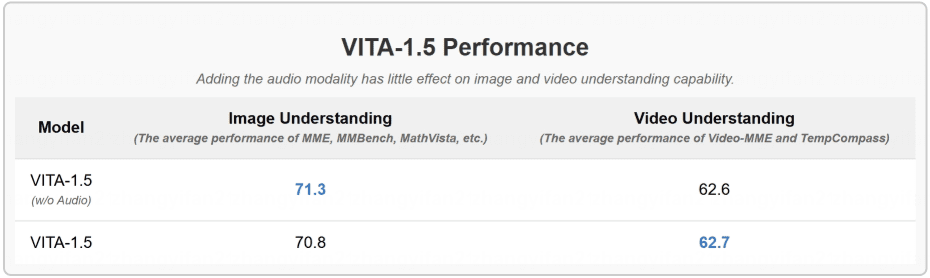

- 渐进式训练策略。通过这种方式,语音模块的加入对其他多模态性能(视觉-语言)几乎没有影响。图像理解的平均性能仅从 71.3 降低到 70.8。

实验结果

- 图像和视频理解基准测试的评估

- VITA-1.5 在 ASR 基准测试中表现优于专业语音模型

- 音频模态的加入对图像和视频理解能力几乎没有影响

使用帮助

1. 环境配置与安装

1.1 基础要求:

- Python环境

- PyTorch框架

- CUDA支持(推荐使用GPU加速)

1.2 安装步骤:

# 克隆项目仓库

git clone https://github.com/VITA-MLLM/VITA.git

cd VITA

# 安装依赖

pip install -r requirements.txt

2. 模型使用

2.1 加载预训练模型:

from vita.model.builder import load_pretrained_model

from vita.conversation import conv_templates

from vita.util.mm_utils import get_model_name_from_path

# 加载模型

model_path = 'VITA/vita'

model_name = get_model_name_from_path(model_path)

tokenizer, model, image_processor, _ = load_pretrained_model(

model_path,

None,

model_name,

model_type='mixtral-8x7b',

device_map='auto'

)

2.2 音频处理配置:

# 初始化音频编码器

audio_encoder = model.get_audio_encoder()

audio_encoder.to(dtype=torch.float16)

audio_processor = audio_encoder.audio_processor

3. 实时交互功能

- 支持实时语音输入和响应

- 集成图像识别和分析

- 支持多轮对话交互

- 提供完整的对话模板系统

4. 高级功能使用

4.1 多模态输入处理:

- 支持批量图像处理

- 视频流实时分析

- 音频流处理与合成

4.2 模型训练与微调:

- 提供完整的训练脚本

- 支持持续学习功能

- 自定义数据集训练支持

5. 评估与测试

- 支持主流多模态评测基准

- 集成VLMEvalKit评估工具

- 提供详细的性能测试指标

6. 注意事项

- 建议使用GPU进行模型推理

- 注意内存管理,特别是处理大型多模态输入时

- 定期检查项目更新以获取最新功能和优化

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...