综合介绍

TextDistiller 是一款先进的人工智能驱动工具,旨在对书籍进行逐章或整体总结,提供简洁而全面的概述。通过使用 TextDistiller,用户能够快速掌握任何书籍的核心思想和关键要点,从而节省时间,同时保持对内容的理解。该工具利用最先进的自然语言处理技术,确保生成的摘要既准确又易读,适用于需要快速获取和理解书籍信息的人群。

功能列表

- 逐章总结:提供每章详细摘要,方便用户关注特定章节内容。

- 整书概述:对于没有章节划分的书籍,提供整体内容的凝练总结。

- 自然语言处理:利用最先进的 NLP 技术,确保摘要内容的准确性和可读性。

- 用户友好界面:简洁直观的界面设计,使摘要过程变得简单易行。

使用帮助

安装流程

- 克隆仓库:

git clone https://github.com/johngai19/TextDistiller.git - 安装所需依赖:

pip install -r requirements.txt - 运行命令行界面(CLI):

python3 bsCLI.py --path <path-to-PDF-file> - 运行 Flask 服务器并更新邮件配置:

- 更新

mail.py中的sender_address和sender_pass。 - 运行

views.py:python3 views.py

- 更新

使用流程

逐章总结

- 将书籍 PDF 文件路径作为参数传递给命令行工具。

- 工具会自动将书籍按章节分块,并生成每章的详细摘要。

- 用户可以查看每章的核心内容,快速掌握书籍的主要思想。

整书概述

- 对于没有章节划分的书籍,工具会将整本书作为一个整体进行处理。

- 生成的摘要将涵盖书籍的所有重要内容,提供一个全面的概述。

主要功能操作

- 逐章总结:在命令行中运行

python3 bsCLI.py --path <path-to-PDF-file>,工具会自动处理并生成每章摘要。 - 整书概述:同样在命令行中运行上述命令,工具会根据书籍结构自动选择适当的处理方式。

- 查看摘要:生成的摘要将以文本文件的形式保存在指定目录,用户可以直接打开查看。

特色功能

- 自然语言处理技术:TextDistiller 利用 T5-small 预训练模型,通过分块、标记化、摘要生成和解码等步骤,确保生成的摘要既准确又易读。

- 用户友好界面:无论是命令行工具还是 Flask 服务器,TextDistiller 都提供了简洁直观的操作界面,用户可以轻松上手使用。

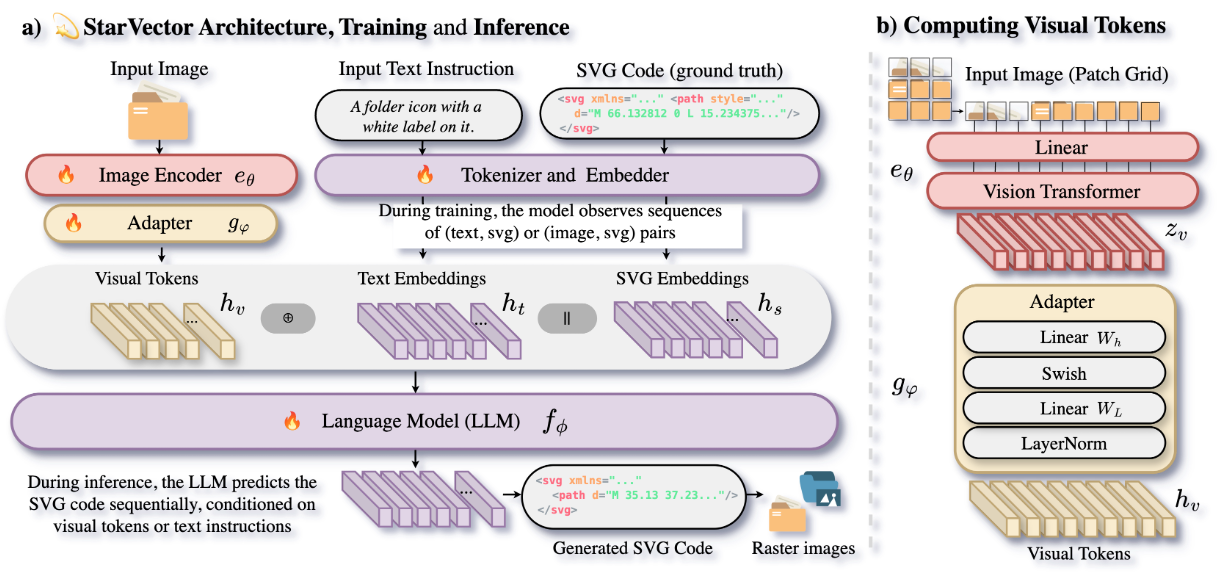

TextDistiller 的工作原理

TextDistiller 利用 HuggingFace Transformers 中的 T5-small 预训练模型来生成准确且易读的摘要。该过程包括:

- 分块:将书籍分割成若干块,可以按章节分割或作为一个整体。

- 分词:使用

T5Tokenizer对这些块进行分词,以确保与T5模型兼容。 - 摘要生成:经过分词处理的文本通过

T5ForConditionalGeneration模型生成摘要的 Token ID。 - 解码:使用

T5Tokenizer的decode()函数将摘要的 Token ID 解码为可读的文本。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...