综合介绍

StreamingT2V是Picsart AI研究团队开发的一个公开项目,专注于根据文本描述生成连贯、动态且可扩展的长视频。这项技术使用先进的自回归方式,保证了视频的时间一致性,与描述文本紧密对应,并保持高帧质量的图像。它能够产生最高达1200帧的视频,长度可达两分钟,并且有潜力扩展至更长时间。该技术的有效性不受特定的Text2Video模型限制,即模型的改进将会进一步提升视频质量。

功能列表

支持生成最长1200帧、可达两分钟的视频

保持视频的时间一致性和高帧质量图像

与文本描述紧密对应的动态视频生成

支持多种Base模型应用,提升生成视频的质量

支持Text-to-Video和Image-to-Video的转换

提供Gradio在线演示

使用帮助

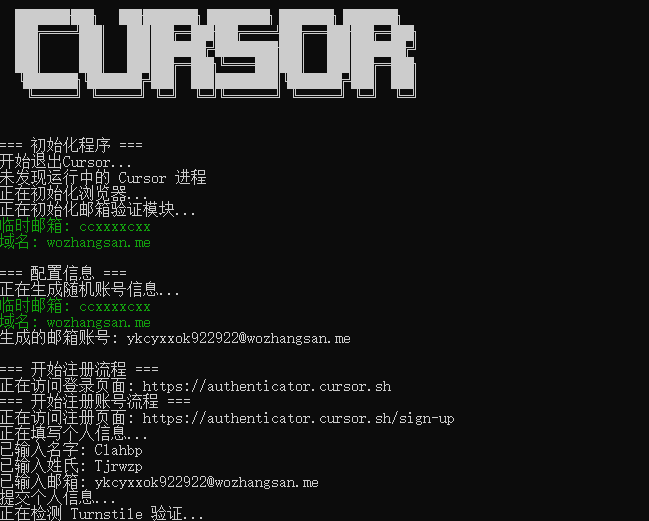

克隆项目仓库并安装所需环境

下载权重并置于正确目录

运行示例代码进行文本到视频或图像到视频的转换

查看项目页面获取详细结果和演示

推理时间

ModelscopeT2V作为基础模型

| 帧数 | 更快预览的推理时间 (256×256) | 最终结果的推理时间 (720×720) |

|---|---|---|

| 24帧 | 40秒 | 165秒 |

| 56帧 | 75秒 | 360秒 |

| 80帧 | 110秒 | 525秒 |

| 240帧 | 340秒 | 1610 秒(约 27 分钟) |

| 600帧 | 860秒 | 5128 秒(约 85 分钟) |

| 1200帧 | 1710 秒(约 28 分钟) | 10225 秒(约 170 分钟) |

AnimateDiff作为基础模型

| 帧数 | 更快预览的推理时间 (256×256) | 最终结果的推理时间 (720×720) |

|---|---|---|

| 24帧 | 50秒 | 180秒 |

| 56帧 | 85秒 | 370秒 |

| 80帧 | 120秒 | 535秒 |

| 240帧 | 350秒 | 1620 秒(约 27 分钟) |

| 600帧 | 870秒 | 5138 秒(~85 分钟) |

| 1200帧 | 1720 秒(约 28 分钟) | 10235 秒(约 170 分钟) |

SVD作为基本模型

| 帧数 | 更快预览的推理时间 (256×256) | 最终结果的推理时间 (720×720) |

|---|---|---|

| 24帧 | 80秒 | 210秒 |

| 56帧 | 115秒 | 400秒 |

| 80帧 | 150秒 | 565秒 |

| 240帧 | 380秒 | 1650 秒(约 27 分钟) |

| 600帧 | 900秒 | 5168 秒(~86 分钟) |

| 1200帧 | 1750 秒(约 29 分钟) | 10265 秒(~171 分钟) |

所有测量均使用 NVIDIA A100 (80 GB) GPU 进行。当帧数超过 80 时,采用随机混合。对于随机混合,chunk_size和 的值overlap_size分别设置为 112 和 32。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...