综合介绍

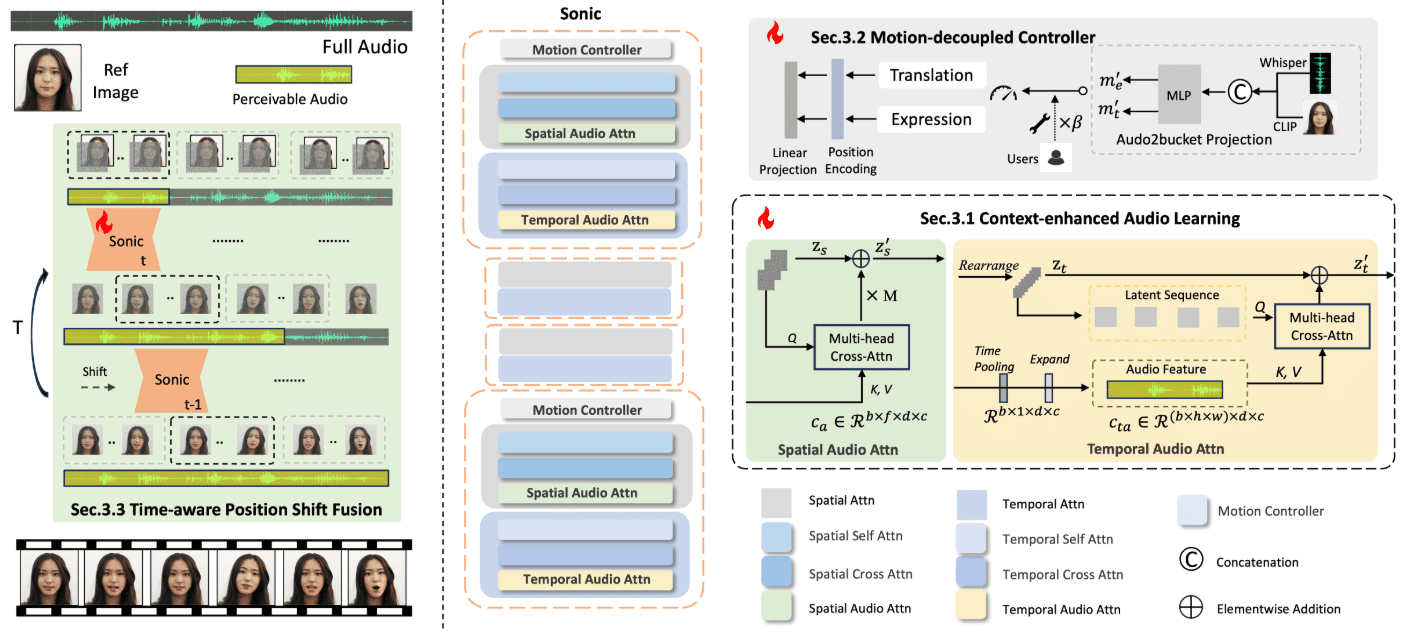

Sonic 是一个专注于全球音频感知的创新平台,旨在通过音频驱动生成生动的肖像动画。该平台由腾讯和浙江大学的研究团队开发,利用音频信息来控制面部表情和头部运动,从而生成自然流畅的动画视频。Sonic 的核心技术包括上下文增强音频学习、运动解耦控制器和时间感知位置移位融合模块。这些技术使得 Sonic 能够在不同风格的图像和各种类型的音频输入下,生成稳定且逼真的长视频。

该项目的代码和权重将在通过内部开源审核后发布(已发布),Windows用户安装说明。

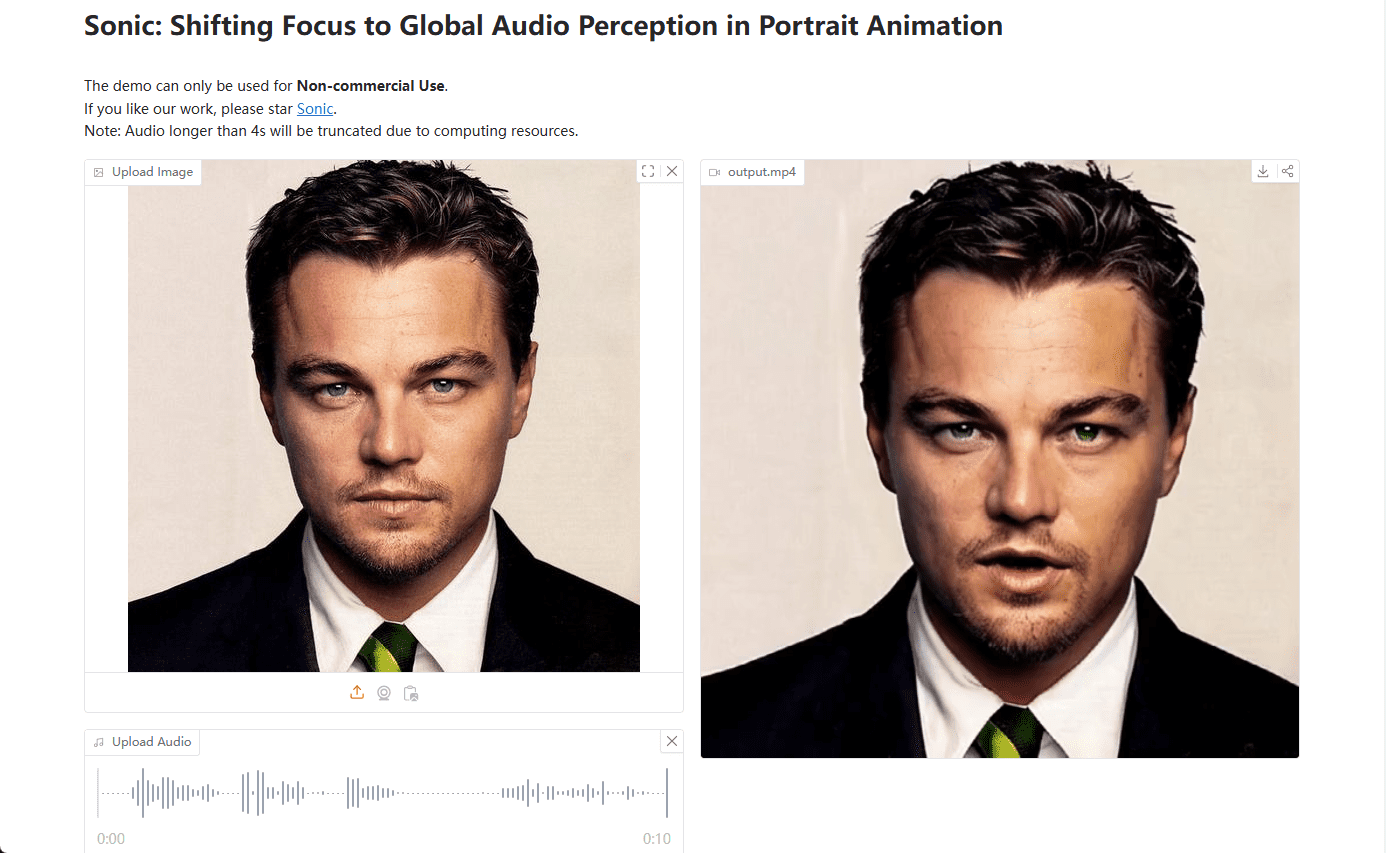

演示:https://huggingface.co/spaces/xiaozhongji/Sonic

功能列表

- 上下文增强音频学习:提取长时间片段的音频知识,提供面部表情和唇部运动的先验信息。

- 运动解耦控制器:独立控制头部和表情运动,实现更自然的动画效果。

- 时间感知位置移位融合:融合全局音频信息,生成长时间稳定的视频。

- 多样化视频生成:支持不同风格的图像和多种分辨率的视频生成。

- 与开源和闭源方法的对比:展示 Sonic 在表情丰富度和头部运动自然度上的优势。

使用帮助

安装流程

Sonic 平台目前正在进行内部开源审核,代码和权重将在审核完成后上传至 GitHub。用户可以通过以下步骤安装和使用 Sonic:

- 访问 Sonic 的 GitHub 页面。

- 克隆仓库:

git clone https://github.com/jixiaozhong/Sonic.git - 安装依赖:

pip install -r requirements.txt - 下载预训练模型权重,并将其放置在指定目录。

使用流程

- 准备输入数据:收集需要生成动画的视频图像和音频文件。

- 运行生成脚本:使用提供的脚本运行生成过程,例如:

python generate.py --image input.jpg --audio input.wav - 调整参数:根据需要调整生成脚本中的参数,以获得最佳效果。

- 查看输出:生成的视频将保存在指定的输出目录中。

详细功能操作

- 上下文增强音频学习:通过长时间片段的音频学习,Sonic 能够捕捉音频中的细微变化,从而生成更自然的面部表情和唇部运动。

- 运动解耦控制器:该控制器将头部运动和表情运动分开处理,使得生成的动画更加逼真。用户可以通过调整控制器参数,优化动画效果。

- 时间感知位置移位融合:这一模块通过融合全局音频信息,确保生成的视频在长时间内保持稳定。用户可以通过调整时间窗口参数,控制视频的平滑度和稳定性。

- 多样化视频生成:Sonic 支持不同风格的图像(如卡通、写实)和多种分辨率的视频生成。用户可以根据需求选择合适的图像和音频输入,生成符合预期的视频效果。

Sonic 一键安装包

百度:https://pan.baidu.com/share/init?surl=iCR4l4ClSRZswm1E2K_NNA&pwd=8520

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...