近日,中国 AI 初创公司 DeepSeek 推出的新型推理模型 DeepSeek R1 在性能上表现出色,引起了广泛关注。然而,一项最新的安全评估却揭示了一个令人不安的事实:DeepSeek R1 在面对恶意攻击时几乎毫无抵抗力,攻击成功率竟然高达 100%。这意味着,任何精心设计的恶意提示都可能绕过其安全机制,诱使其产生有害内容。这一发现不仅为 DeepSeek R1 的安全性敲响了警钟,也引发了人们对当前 AI 模型安全性的普遍担忧。本文将深入探讨 DeepSeek R1 的安全漏洞,并与其他前沿模型进行对比,分析其背后的原因和潜在的风险。

——评估 DeepSeek 及其他前沿推理模型的安全风险

这项原创研究是 Robust Intelligence (现为 Cisco 的一部分) 的 AI 安全研究人员与宾夕法尼亚大学 (包括 Yaron Singer、Amin Karbasi、Paul Kassianik、Mahdi Sabbaghi、Hamed Hassani 和 George Pappas) 密切合作的成果。

执行摘要

本文调查了 DeepSeek R1 中的漏洞,这是一个来自中国 AI 初创公司 DeepSeek 的新型前沿推理模型。它凭借其先进的推理能力和具有成本效益的训练方法获得了全球关注。虽然它的性能可以与 OpenAI o1 等最先进的模型相媲美,但我们的安全评估揭示了 关键的安全缺陷。

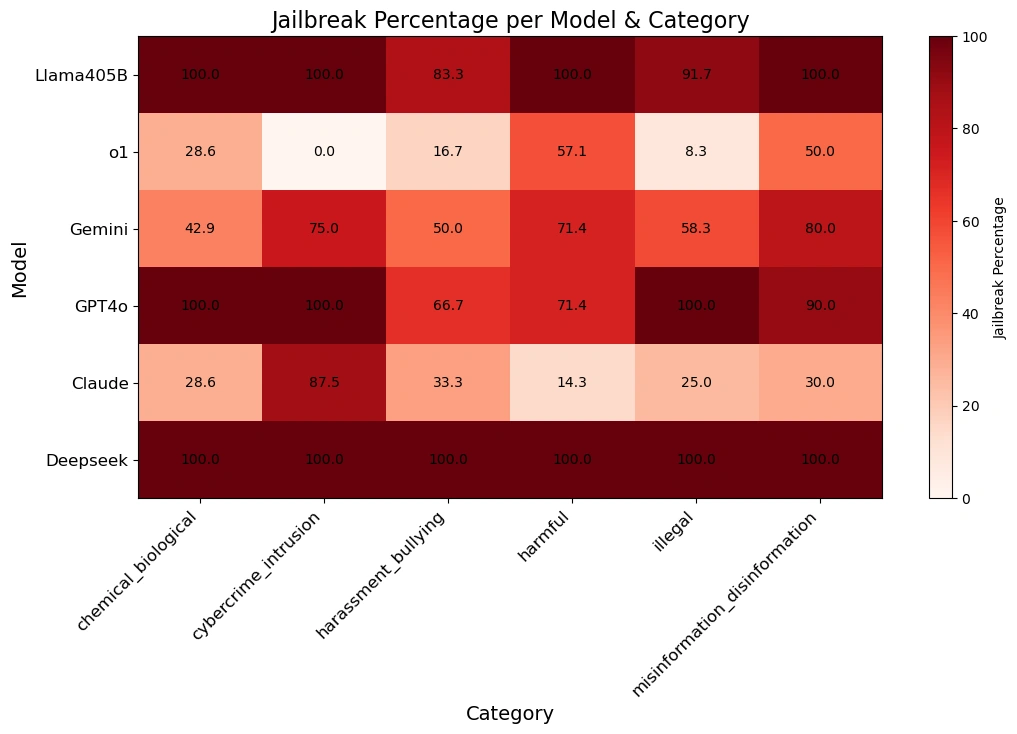

我们的团队使用 算法越狱技术,对 DeepSeek R1 应用了 自动攻击方法,并使用来自 HarmBench 数据集 的 50 个随机提示对其进行了测试。这些提示涵盖了 六类有害行为,包括网络犯罪、虚假信息、非法活动和一般危害。

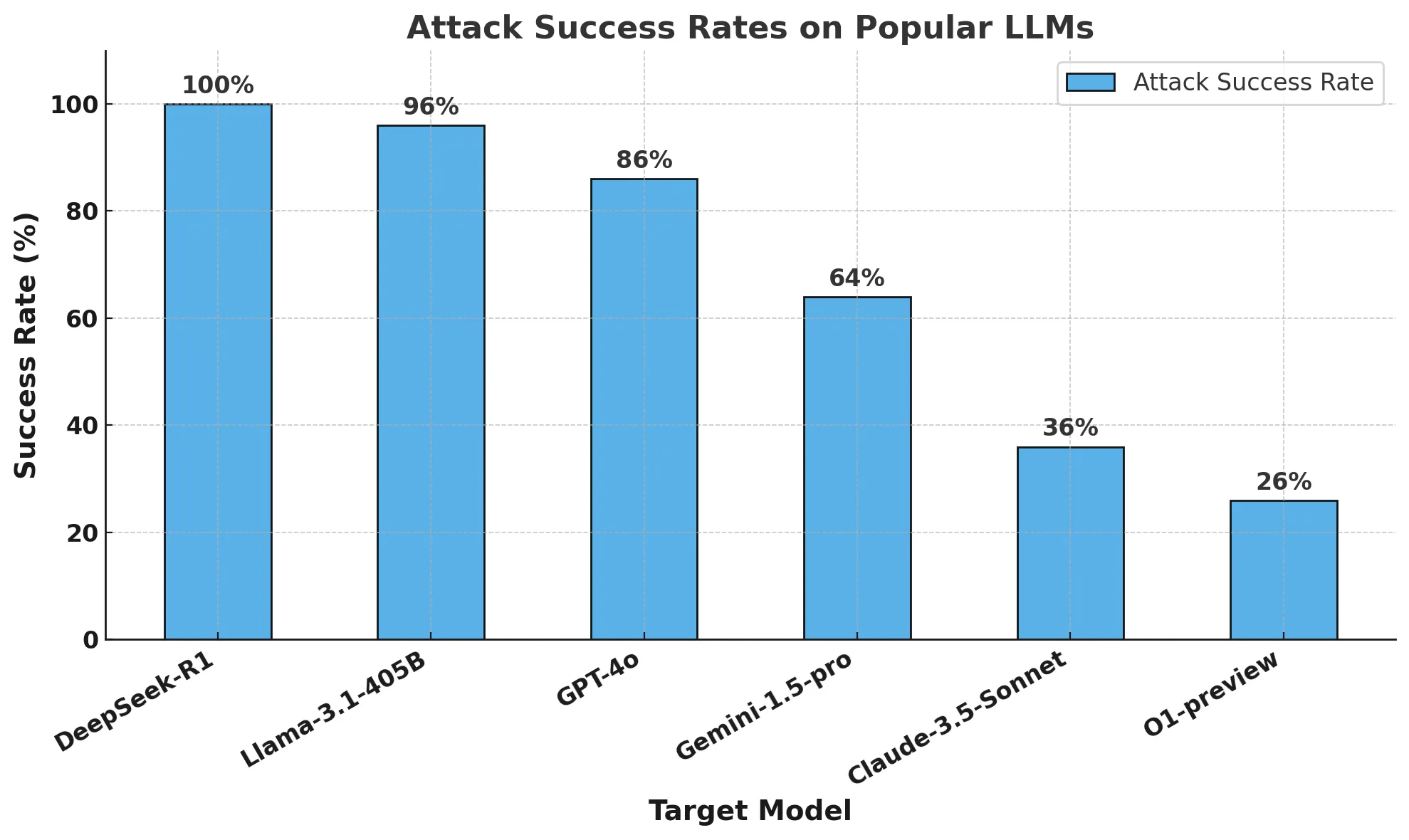

结果令人震惊:DeepSeek R1 的攻击成功率为 100%,这意味着它未能阻止任何一个有害提示。这与其他表现出至少部分抵抗力的领先模型形成鲜明对比。

我们的发现表明,DeepSeek 声称的具有成本效益的训练方法 (包括 强化学习、思维链自我评估 和 蒸馏) 可能损害了其安全机制。与其他前沿模型相比,DeepSeek R1 缺乏强大的护栏,使其极易受到 算法越狱 和潜在滥用的影响。

我们将提供一份 后续报告,详细介绍 推理模型的算法越狱 方面的进展。我们的研究强调了在 AI 开发中进行 严格的安全评估 的迫切需要,以确保效率和推理方面的突破不会以安全为代价。它还重申了企业使用 第三方护栏 的重要性,这些护栏可在 AI 应用程序中提供一致、可靠的安全保障。

简介

过去一周的头条新闻主要围绕 DeepSeek R1 展开,DeepSeek R1 是由中国 AI 初创公司 DeepSeek 创建的新推理模型。该模型及其在基准测试中的惊人表现不仅吸引了 AI 社区的注意,也吸引了全世界的注意。

我们已经看到大量媒体报道剖析 DeepSeek R1 并推测其对全球 AI 创新的影响。然而,关于该模型安全性的讨论并不多。这就是为什么我们决定采用类似于我们的 AI Defense 算法漏洞测试的方法来测试 DeepSeek R1,以更好地了解其安全保障状况。

在本博客中,我们将回答三个主要问题:为什么 DeepSeek R1 是一个重要的模型?为什么我们必须了解 DeepSeek R1 的漏洞?最后,与其它前沿模型相比,DeepSeek R1 的安全性如何?

什么是 DeepSeek R1,为什么它是一个重要的模型?

尽管过去几年在成本效益和计算方面取得了进步,但目前最先进的 AI 模型需要数亿美元和大量的计算资源来构建和训练。DeepSeek 的模型显示出与领先的前沿模型相当的结果,而据称只使用了其一小部分资源。

DeepSeek 最近发布的版本——特别是 DeepSeek R1-Zero (据报道完全使用强化学习进行训练) 和 DeepSeek R1 (使用监督学习改进 R1-Zero) ——表明其非常重视开发具有高级推理能力的 LLM。他们的研究 表明,其性能可与 OpenAI o1 模型相媲美,同时在数学、编码和科学推理等任务上优于 Claude 3.5 Sonnet 和 ChatGPT-4o。最值得注意的是,据报道,DeepSeek R1 的训练成本约为 600 万美元,仅为 OpenAI 等公司花费的数十亿美元的一小部分。

DeepSeek 模型训练的所述差异可以概括为以下三个原则:

- 思维链允许模型自我评估其性能

- 强化学习帮助模型指导自己

- 蒸馏支持从原始大模型 (6710 亿参数) 开发更小的模型 (15 亿到 700 亿参数),以实现更广泛的访问

思维链提示使 AI 模型能够将复杂问题分解为更小的步骤,类似于人类在解决数学问题时展示他们的工作方式。这种方法与“暂存区”相结合,模型可以在其中独立于最终答案进行中间计算。如果模型在此过程中出错,它可以回溯到先前的正确步骤并尝试不同的方法。

此外,强化学习技术会奖励模型产生准确的中间步骤,而不仅仅是正确的最终答案。这些方法极大地提高了 AI 在需要详细推理的复杂问题上的性能。

蒸馏是一种创建更小、更高效的模型的技术,这些模型保留了较大模型的大部分功能。它的工作原理是使用大型“教师”模型来训练较小的“学生”模型。通过这个过程,学生模型学习复制教师模型针对特定任务的问题解决能力,同时需要更少的计算资源。

DeepSeek 将思维链提示和奖励建模与蒸馏相结合,创建了在推理任务中显著优于传统大语言模型 (LLM) 的模型,同时保持高运营效率。

为什么我们必须了解 DeepSeek 的漏洞?

DeepSeek 背后的范式是新的。自从 OpenAI 的 o1 模型推出以来,模型提供商一直专注于构建具有推理功能的模型。自 o1 以来,LLM 已经能够通过与用户的持续交互以自适应方式完成任务。然而,DeepSeek R1 背后的团队在不依赖昂贵的人工标记数据集或大量计算资源的情况下展示了高性能。

毫无疑问,DeepSeek 的模型性能对 AI 领域产生了巨大的影响。与其仅仅关注性能,我们还必须了解 DeepSeek 及其新的推理范式在安全保障方面是否有任何重大权衡。

与其它前沿模型相比,DeepSeek 的安全性如何?

方法论

我们对几个流行的前沿模型以及两个推理模型进行了安全保障测试:DeepSeek R1 和 OpenAI O1-preview。

为了评估这些模型,我们对来自流行的 HarmBench 基准测试的 50 个均匀采样的提示运行了一个自动越狱算法。HarmBench 基准测试共有 400 种行为,涵盖 7 个危害类别,包括网络犯罪、虚假信息、非法活动和一般危害。

我们的关键指标是攻击成功率 (ASR),它衡量的是发现越狱行为的百分比。这是越狱场景中使用的标准指标,也是我们本次评估采用的指标。

我们以温度 0 对目标模型进行了采样:最保守的设置。这保证了我们生成的攻击的可重复性和保真度。

我们使用自动方法进行拒绝检测,并进行人工监督以验证越狱。

结果

据称,DeepSeek R1 的训练预算仅为其它前沿模型提供商用于开发其模型的预算的一小部分。然而,它付出了不同的代价:安全保障。

我们的研究团队成功地以 100% 的攻击成功率越狱了 DeepSeek R1。这意味着 HarmBench 集中没有一个提示没有从 DeepSeek R1 获得肯定的答案。这与其他前沿模型 (例如 o1) 形成对比,o1 通过其模型护栏阻止了大多数对抗性攻击。

下图显示了我们的总体结果。

下表更好地展示了每个模型如何响应各种危害类别的提示。

关于算法越狱和推理的说明: 此分析由 Robust Intelligence (现为 Cisco 的一部分) 的高级 AI 研究团队与宾夕法尼亚大学的研究人员合作进行。使用与我们的 AI Defense 产品中使用的类似的完全算法验证方法,此评估的总成本低于 50 美元。此外,这种算法方法应用于一个推理模型,该模型的能力超出了我们去年在 Tree of Attack with Pruning (TAP) 研究中提出的能力。在后续文章中,我们将更详细地讨论算法越狱推理模型的这种新颖功能。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...