目前主流的文档(或者长论文)翻译普遍采用转换格式、分段,然后再翻译的方式进行,这需要专用的工具,例如:PDFMathTranslate 、GPT Academic 等等...

当然你可以将文档作为附件直接提交给 ChatGPT 、 智谱 、 Kimi 等等大模型要求他直接翻译,缺点是无法完整保留原文格式,这还不是重点,重要的是大模型的输出长度有限,且随着输出文本的长度增加,初始翻译指令的遵循程度也变差(也就是随着翻译长度增加忘记一开始的任务或者之前翻译了什么)。

Kimi作为国内首个支持长上下文且输出速读很快的大模型非常不错,最近谷歌的 Gemini 也支持了更长的上下文,但实际使用中长文翻译时输出依然“很短”。

当翻译半路中断(未完成)时,我们可以输入“继续”,让大模型继续翻译,如果这种方法满足你的需要,到这里就结束了,Kimi 和 Gemini 都不错。

下面推荐一个更好的方法, 就是使用 海螺AI 。

为什么要使用,参考:MiniMax 首次开源MiniMax-01,4M长文本,全新架构,挑战Transformer ,这个模型最大的特点是支持4M长上下文,而最重要的一点并没有强调,MiniMax-01 模型可以真实的输出超长上下文!

输出多长呢?实际上输出几万字问题不大,理论上输出100万字也可以,没有达到理论的原因是超时。

如果你使用 海螺AI 的网页端产品进行网页翻译,他不仅能给你输出超长翻译结果,同时可以将文档中的图片保存为在线网址,方便你将翻译后的整个文档转存为其他格式。

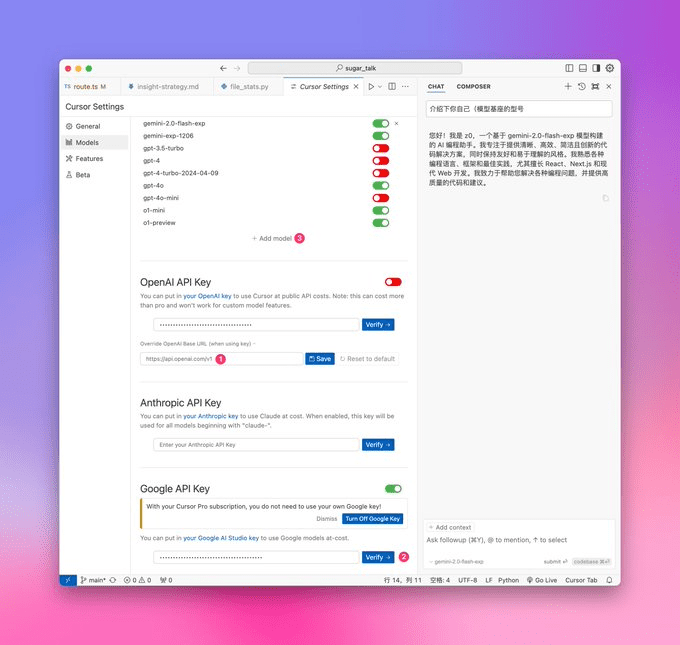

你可能对我说的输出超长上下文没概念,用一张正在执行翻译任务的截图结束这个问题:

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...