综合介绍

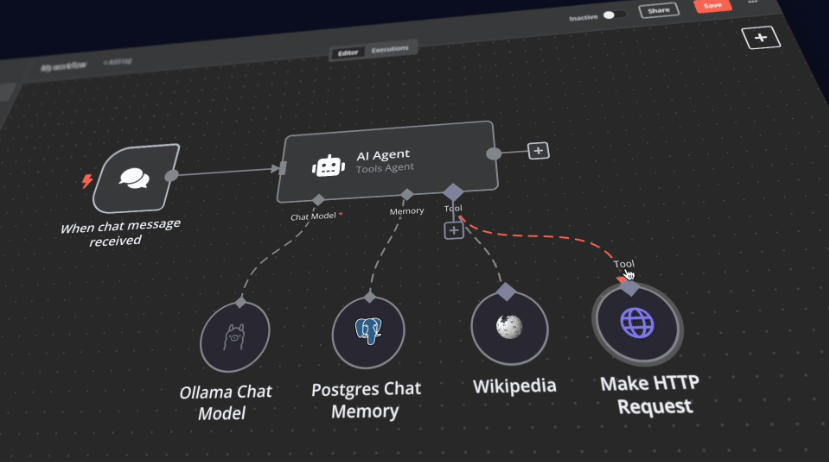

n8n自托管AI入门套件是一个开源的Docker Compose模板,旨在快速初始化一个全面的本地AI和低代码开发环境。由n8n团队精心策划,该套件结合了自托管的n8n平台和一系列兼容的AI产品和组件,帮助用户快速构建自托管的AI工作流。该套件包括n8n低代码平台、Ollama跨平台LLM平台、Qdrant高性能向量存储和PostgreSQL数据库,适用于各种AI应用场景,如智能代理、文档摘要、智能聊天机器人和私人财务文档分析等。

功能列表

- n8n低代码平台:提供超过400种集成和高级AI组件,支持快速构建工作流。

- Ollama平台:跨平台LLM平台,支持安装和运行最新的本地LLM。

- Qdrant向量存储:开源高性能向量存储,提供全面的API。

- PostgreSQL数据库:处理大量数据的可靠数据库。

- 智能代理:用于安排会议和任务的AI代理。

- 文档摘要:安全地总结公司PDF文档,防止数据泄露。

- 智能聊天机器人:增强公司沟通和IT操作的智能Slack机器人。

- 私人财务文档分析:以最低成本进行私人财务文档分析。

使用帮助

安装流程

- 克隆仓库:

bash

git clone https://github.com/n8n-io/self-hosted-ai-starter-kit.git

cd self-hosted-ai-starter-kit

- 使用Docker Compose运行n8n:

- 对于Nvidia GPU用户:

docker compose --profile gpu-nvidia up注意:如果之前没有使用过Nvidia GPU与Docker,请按照Ollama Docker的说明进行操作。

- 对于Mac/Apple Silicon用户:

- 选项1:完全在CPU上运行:

docker compose --profile cpu up - 选项2:在Mac上运行Ollama并连接到n8n实例:

docker compose up然后更改Ollama凭据,使用

http://host.docker.internal:11434/作为主机。

- 选项1:完全在CPU上运行:

- 对于其他用户:

docker compose --profile cpu up

- 对于Nvidia GPU用户:

使用指南

- 启动n8n:

- 访问

http://localhost:5678,进入n8n界面。 - 使用默认账户登录或创建新账户。

- 访问

- 创建工作流:

- 在n8n界面中,点击“新建工作流”。

- 从左侧菜单中拖动所需的节点到工作区。

- 配置每个节点的参数和连接。

- 运行工作流:

- 配置完成后,点击“运行”按钮,执行工作流。

- 查看工作流的执行结果和日志。

快速启动与使用

自托管AI入门套件的核心是一个Docker Compose文件,预配置了网络和存储设置,减少了额外安装的需求。完成安装步骤后,只需按照以下步骤开始使用:

- 打开http://localhost:5678/设置n8n。此操作只需进行一次。

- 打开包含的工作流:http://localhost:5678/workflow/srOnR8PAY3u4RSwb。

- 选择测试工作流开始运行该工作流。

- 如果这是你第一次运行该工作流,可能需要等到Ollama下载Llama3.2完成。可以查看docker控制台日志了解进展情况。

随时可以通过访问http://localhost:5678/来打开n8n。

通过你的n8n实例,你将能够访问超过400种集成以及一套基本和高级的AI节点,例如AI代理、文本分类器和信息提取器节点。确保本地运行时使用Ollama节点作为你的语言模型,并将Qdrant用作向量存储。

“注意:此入门套件旨在帮助你开始自托管AI工作流。虽然它并未针对生产环境进行全面优化,但结合了能够完美协作的强大组件,非常适合概念验证项目。你可以根据自己的需求进行定制。

”

升级说明

对于Nvidia GPU设置:

docker compose --profile gpu-nvidia pull

docker compose create && docker compose --profile gpu-nvidia up

对于Mac / Apple Silicon用户

docker compose pull

docker compose create && docker compose up

对于非GPU设置:

docker compose --profile cpu pull

docker compose create && docker compose --profile cpu up© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...