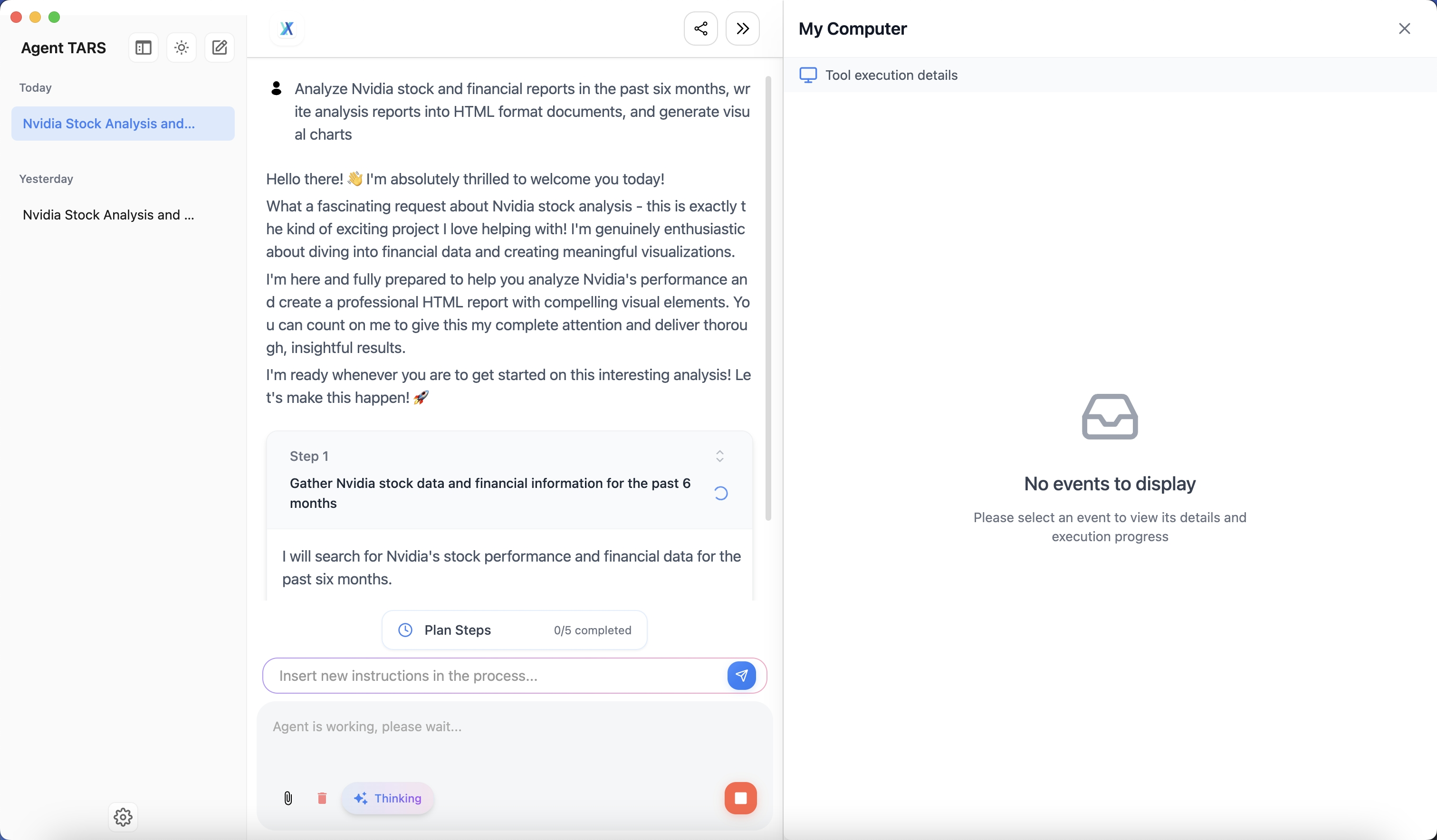

综合介绍

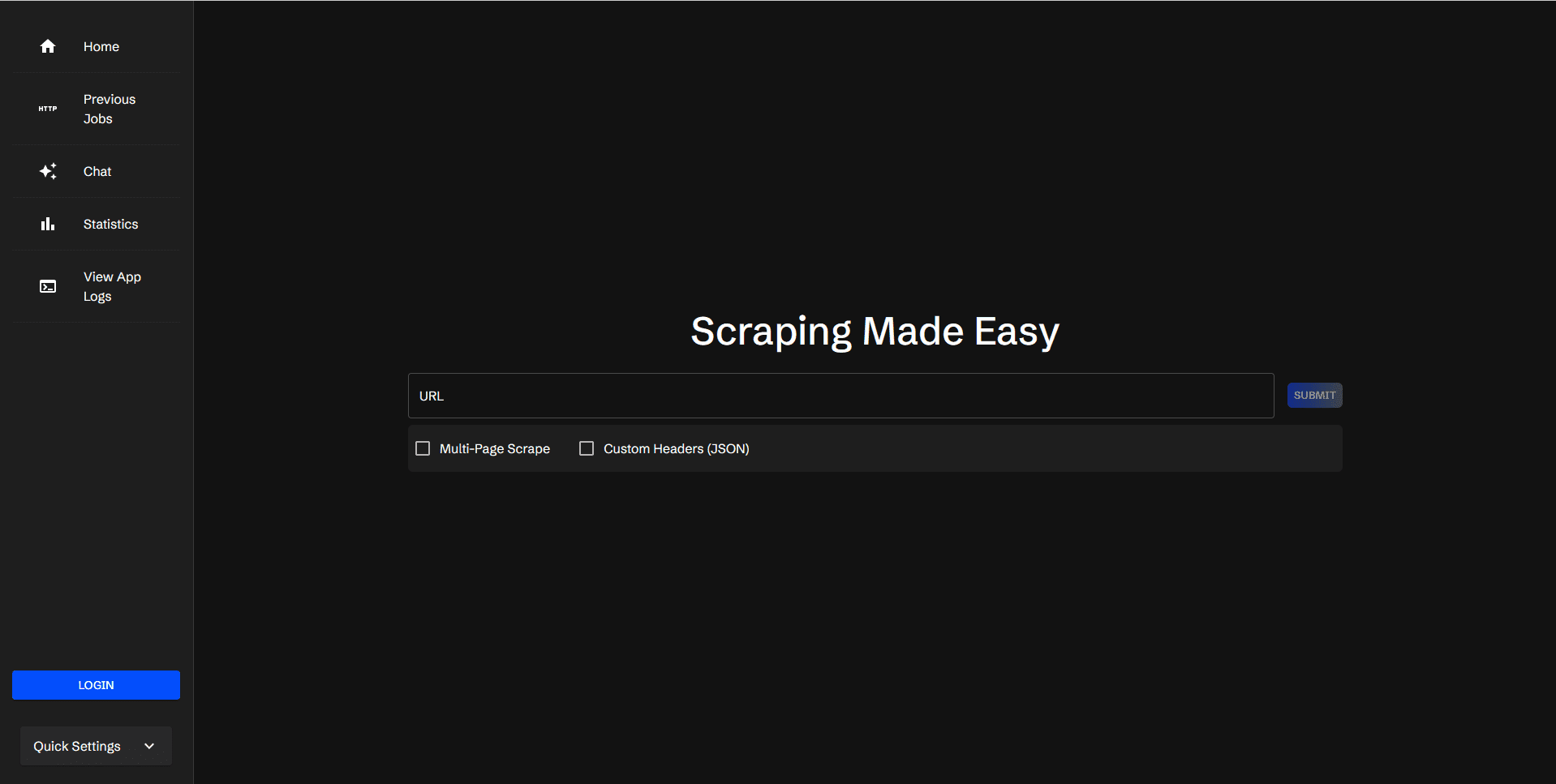

Scraperr 是一个自托管的网页数据抓取工具,用户可以通过指定 XPath 元素来抓取网页数据。用户提交 URL 和相应的抓取元素,结果将显示在表格中,并可下载为 Excel 文件。Scraperr 支持用户登录管理抓取任务,并提供日志查看和统计功能。

功能列表

- 提交和排队 URL 进行网页抓取

- 使用 XPath 添加和管理抓取元素

- 抓取同一域名下的所有页面

- 添加自定义 JSON 头部发送请求

- 显示抓取数据结果

- 下载包含结果的 CSV 文件

- 重新运行抓取任务

- 查看排队任务状态

- 收藏和查看收藏的任务

- 用户登录/注册以组织任务

- 查看应用日志

- 查看任务统计

- AI 集成,支持将抓取结果纳入对话上下文

使用帮助

安装流程

- 克隆仓库:

git clone https://github.com/jaypyles/scraperr.git - 设置环境变量和标签: 在

docker-compose.yml文件中设置环境变量和标签,例如:scraperr: labels: - "traefik.enable=true" - "traefik.http.routers.scraperr.rule=Host(`localhost`)" - "traefik.http.routers.scraperr.entrypoints=web" scraperr_api: environment: - LOG_LEVEL=INFO - MONGODB_URI=mongodb://root:example@webscrape-mongo:27017 - SECRET_KEY=your_secret_key - ALGORITHM=HS256 - ACCESS_TOKEN_EXPIRE_MINUTES=600 - 启动服务:

docker-compose up -d

使用流程

- 提交 URL 进行抓取:

- 登录 Scraperr 后,进入抓取任务页面。

- 输入要抓取的 URL 和相应的 XPath 元素。

- 提交任务后,系统会自动排队并开始抓取。

- 管理抓取元素:

- 在抓取任务页面,可以添加、编辑或删除 XPath 元素。

- 支持抓取同一域名下的所有页面。

- 查看抓取结果:

- 抓取完成后,结果将显示在表格中。

- 用户可以下载包含结果的 CSV 文件,或选择重新运行任务。

- 任务管理:

- 用户可以查看排队任务的状态,收藏和查看收藏的任务。

- 提供任务统计视图,显示已运行任务的统计数据。

- 日志查看:

- 在应用日志页面,用户可以查看系统日志,了解抓取任务的详细信息。

- AI 集成:

- 支持将抓取结果纳入对话上下文,当前支持 Ollama 和 OpenAI。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...