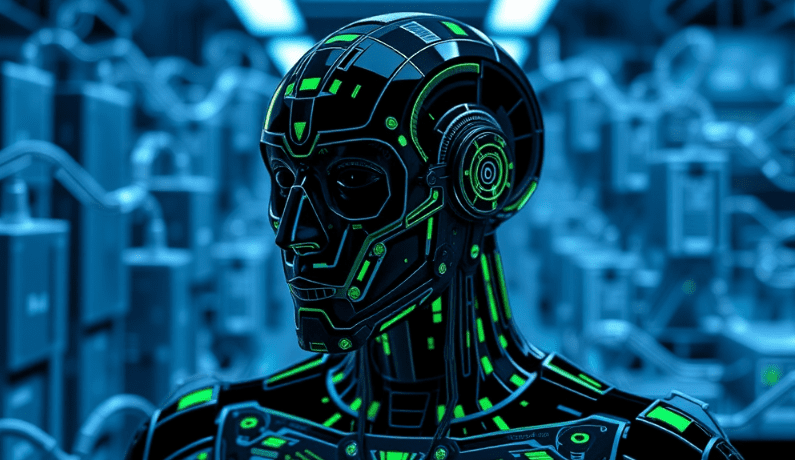

Hugging Face Launches Agent Intelligence Body Rankings: кто лидирует в области вызова инструментов?

Генеральный директор NVIDIA Дженсен Хуанг (Jen-Hsun Huang) назвал искусственный интеллект "цифровой рабочей силой", и он не единственный технологический лидер, придерживающийся такого мнения. Генеральный директор Microsoft Сатья Наделла также считает, что технология "умных тел" кардинально изменит методы работы предприятий.

Способность этих интеллектов взаимодействовать с внешними инструментами и API значительно расширила сценарии их применения. Однако ИИ-интеллекты далеки от совершенства, и оценка их эффективности в реальных приложениях представляет собой сложную задачу из-за сложности потенциальных взаимодействий.

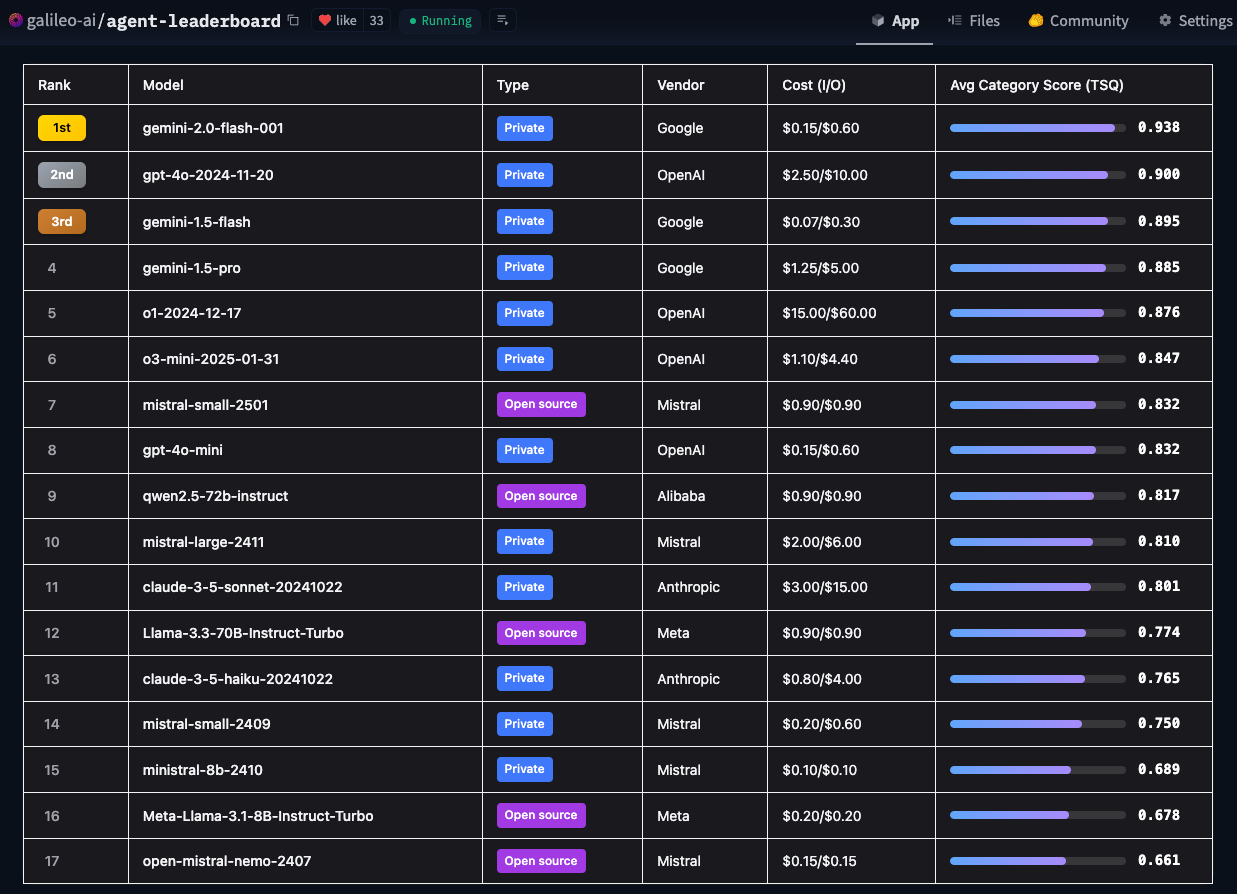

Для решения этой проблемы компания Hugging Face представила рейтинг агентов-интеллектуалов. Используя метрику Galileo's Tool Selection Quality (TSQ), рейтинг оценивает производительность различных больших языковых моделей (LLM) при взаимодействии с инструментами, предоставляя разработчикам четкие рекомендации.

- Агент "Обнимающееся лицо" Интеллектуальный рейтинг тел

Компания Hugging Face создала этот рейтинг, чтобы ответить на главный вопрос: "Насколько хорошо искусственный интеллект работает в реальной бизнес-среде?". Академические бенчмарки важны, но они сосредоточены на технических возможностях, в то время как Hugging Face больше интересует, какие модели действительно применимы в различных реальных сценариях использования.

Уникальные особенности доски лидеров оценки интеллектуального тела Hugging Face Agent

Современные системы оценки обычно ориентированы на конкретные области. Например, BFCL отлично работает в академических областях, таких как математика, развлечения и образование; τ-bench фокусируется на отраслевых сценариях, таких как розничная торговля и авиакомпании; xLAM охватывает 21 область генерации данных; а ToolACE фокусируется на взаимодействии API в 390 областях. Уникальность таблицы лидеров Hugging Face заключается в том, что она объединяет все эти наборы данных в комплексную систему оценки, предназначенную для охвата более широкого спектра доменов и реальных сценариев использования.

Благодаря интеграции विविध эталонов и тестовых сценариев, таблицы лидеров Hugging Face не только дают оценку техническим возможностям модели, но и позволяют получить практическое представление о том, как модель справляется с нестандартными ситуациями и вопросами безопасности. Hugging Face также предоставляет информацию о многочисленных факторах, таких как экономическая эффективность, рекомендации по внедрению и влияние на бизнес - все это очень важно для организаций, которые хотят внедрить интеллектуальный ИИ. С помощью этого рейтинга Hugging Face надеется помочь корпоративным командам более точно определить модели ИИ-интеллекта, которые наилучшим образом отвечают их конкретным потребностям, с учетом ограничений реальных приложений.

Учитывая частоту выхода новых Large Language Models (LLM), Hugging Face планирует ежемесячно обновлять контрольные показатели в таблице лидеров, чтобы они не отставали от быстро развивающихся технологий моделирования.

Основные выводы

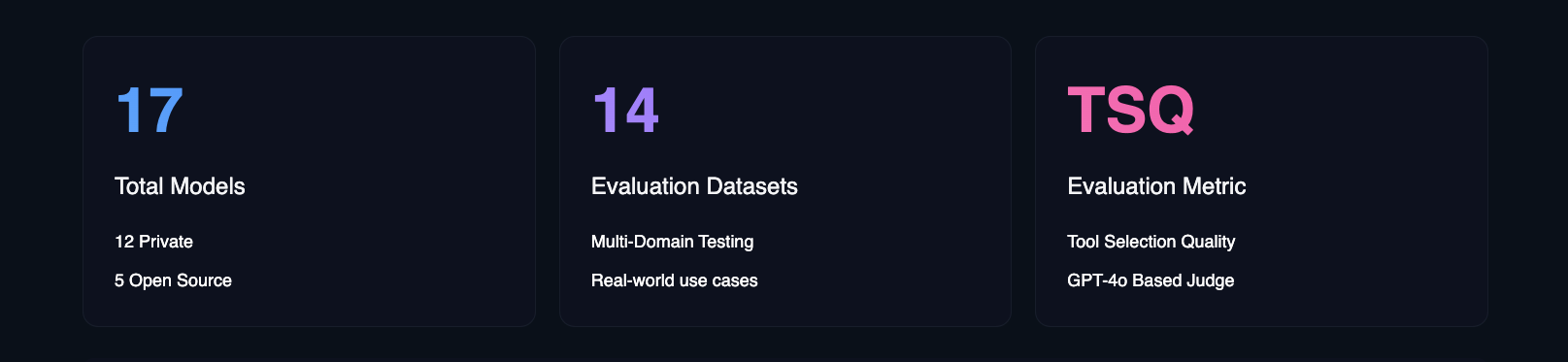

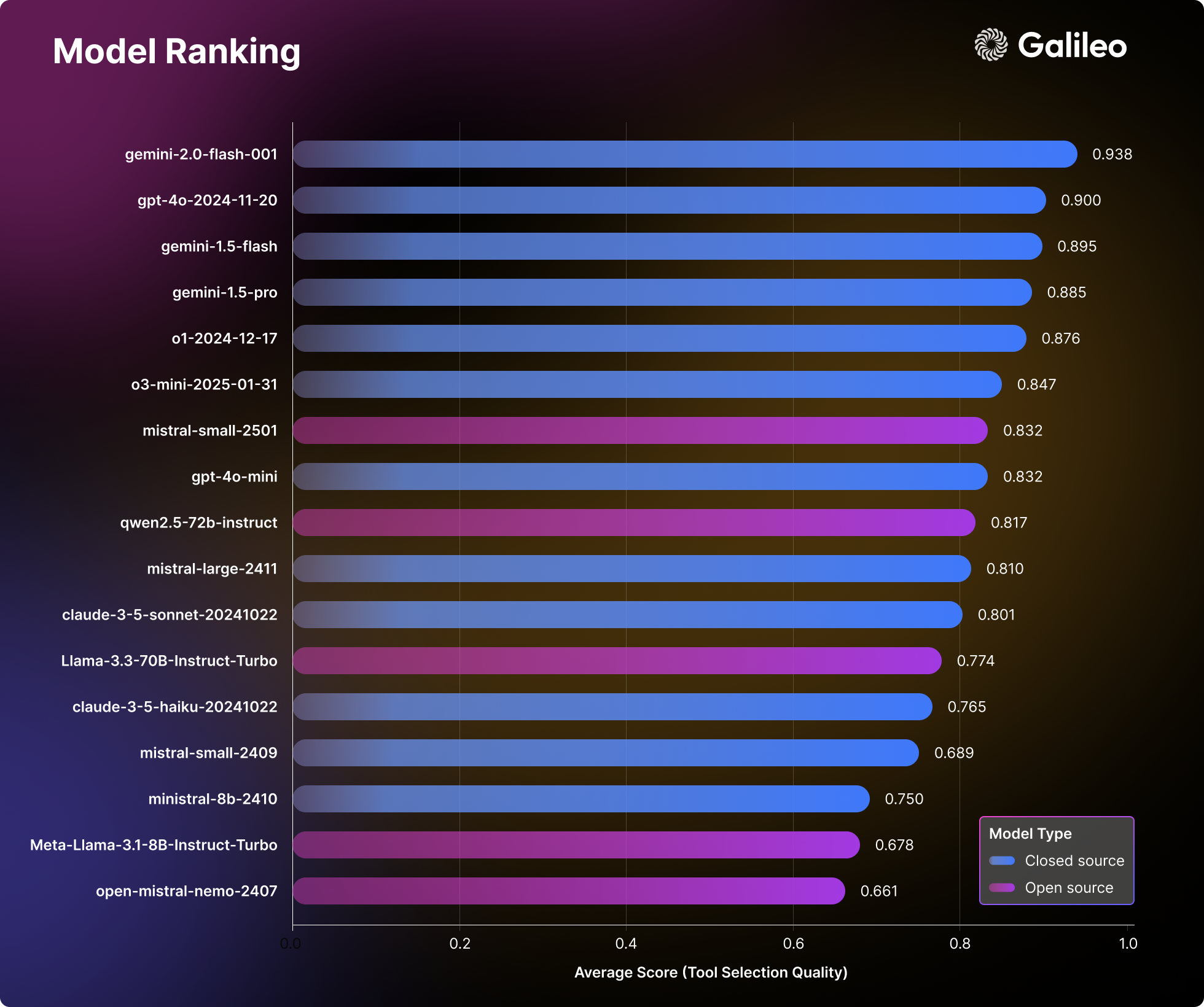

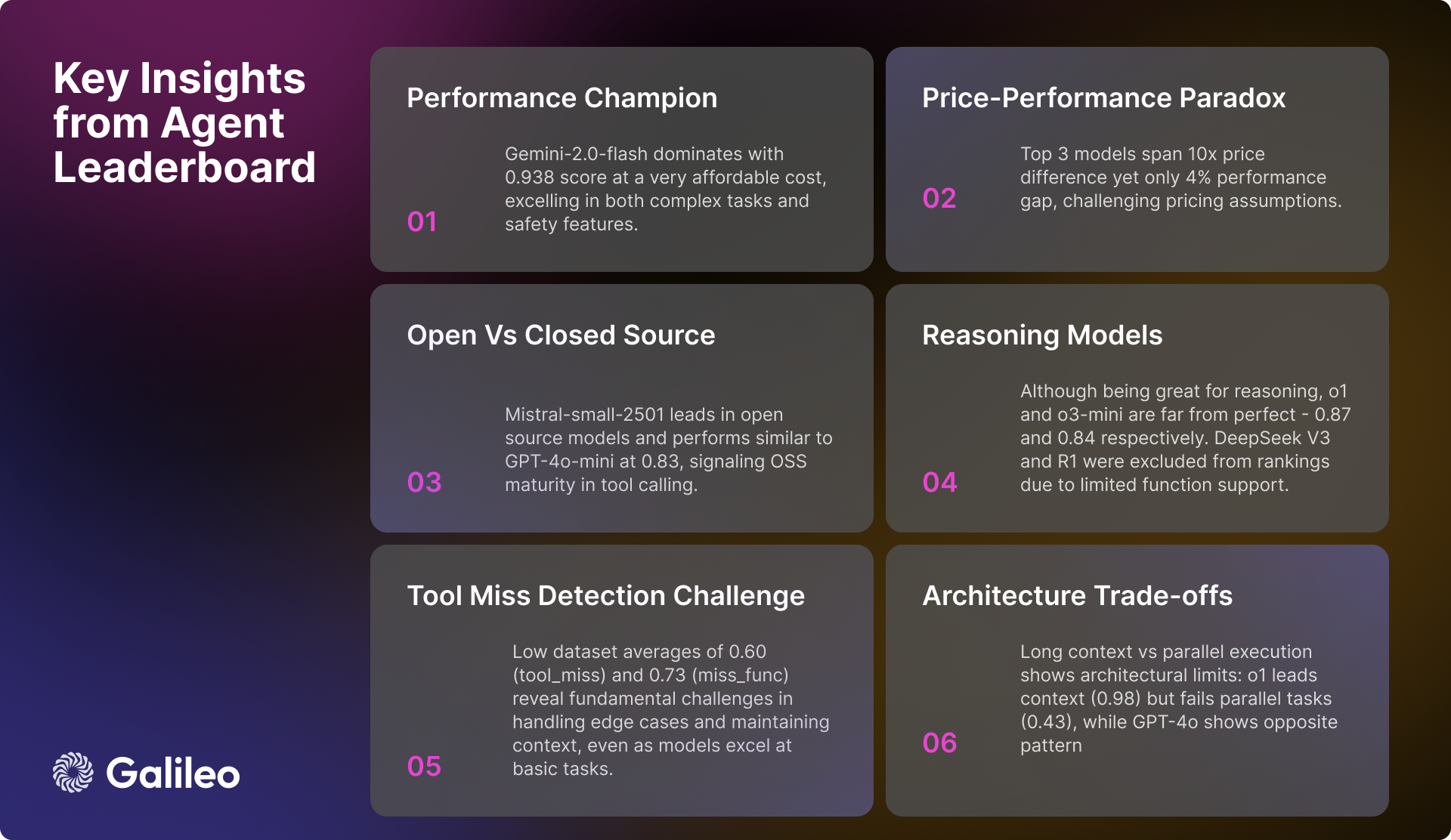

Глубокий анализ 17 ведущих больших языковых моделей (LLM), проведенный компанией Hugging Face, выявил интересные закономерности в подходе искусственного интеллекта к решению реальных задач. Hugging Face провела комплексные стресс-тесты частных моделей и моделей с открытым исходным кодом в 14 различных бенчмарках, оценивая различные параметры - от простых вызовов API до сложных взаимодействий с несколькими инструментами.

Рейтинги в области моделирования больших языков (LLM)

Результаты оценки Hugging Face опровергают традиционные представления о производительности моделей и являются ценным практическим пособием для команд, создающих искусственный интеллект.

Основные результаты рейтинга интеллектуальных тел агентов

Сложность вызовов инструментов

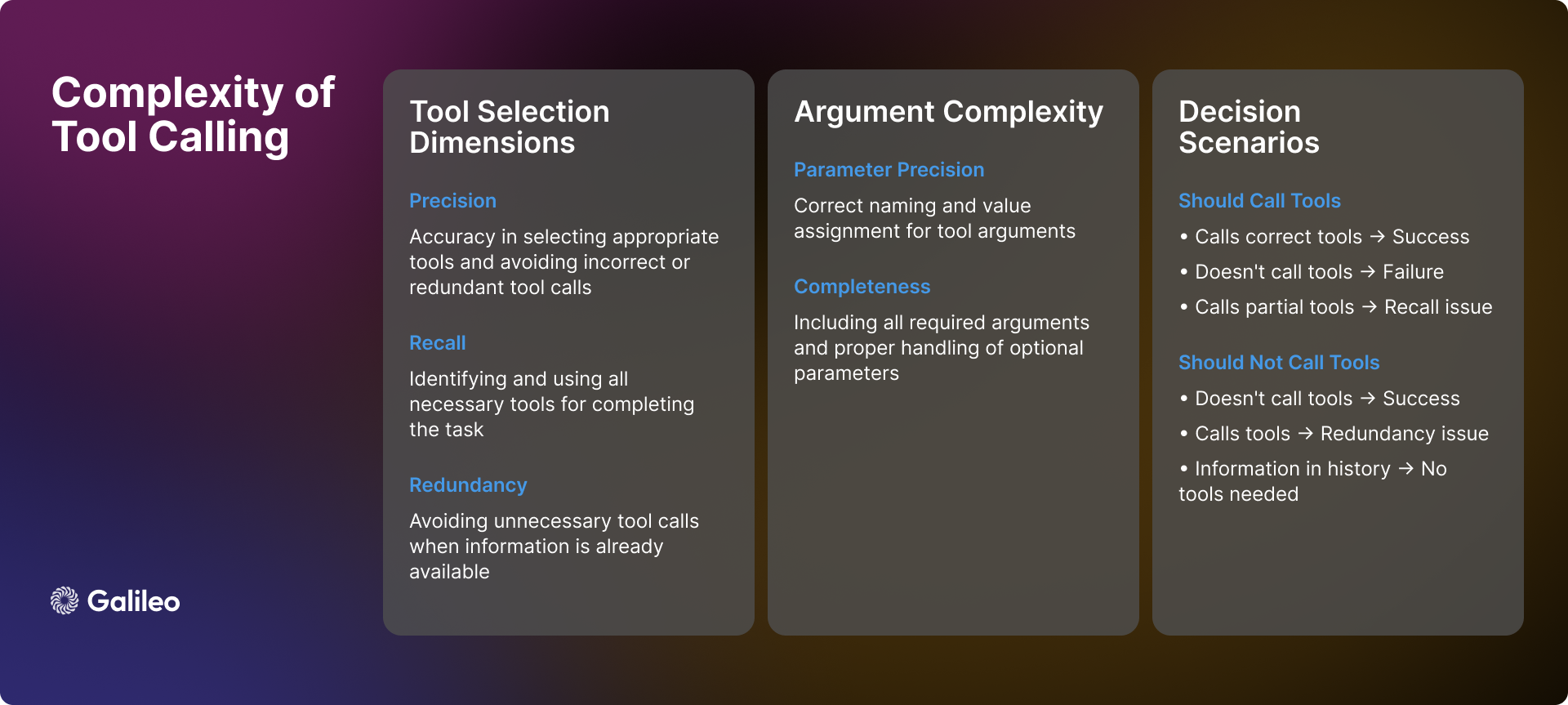

Сложность вызова инструментов выходит далеко за рамки простых вызовов API. На практике ИИ-интеллекты сталкиваются с множеством сложных сценариев и проблем при использовании инструментов, требующих принятия точных решений:

распознавание сцен

Когда интеллектуальный орган получает запрос от пользователя, его первая задача - определить, требуется ли вызов инструмента. Иногда необходимая информация может уже содержаться в истории диалога, что делает обращение к инструментам излишним. Кроме того, имеющихся инструментов может быть недостаточно для решения проблемы пользователя или они могут не иметь отношения к самой задаче. В таких случаях интеллект должен уметь признавать свои ограничения и быть честным с пользователем, а не принуждать его к использованию неподходящих инструментов.

Динамика выбора инструмента

Выбор инструмента - это не простая бинарная проблема "да" или "нет"; он включает в себя точность и отзыв. В идеале разумный организм должен уметь точно определять все необходимые инструменты, избегая при этом выбора неактуальных инструментов. Однако реальность часто оказывается сложнее. Разумный организм может правильно определить один необходимый инструмент, но пропустить другие (недостаточный отзыв), или неправильно выбрать несколько ненужных инструментов, но при этом выбрать подходящие (недостаточная точность). Хотя ни один из этих сценариев не является оптимальным, они представляют собой различные степени предвзятости выбора.

параметризация

Даже если интеллектуальный орган успешно выбирает нужный инструмент, обработка параметров все равно может привести к новым проблемам. Интеллектуальные органы должны:

- Укажите все необходимые параметры и убедитесь, что они правильно названы.

- Правильная обработка необязательных параметров.

- Убедитесь в точности значений параметров.

- Форматируйте параметры в соответствии со спецификацией инструмента.

последовательное принятие решений

Для решения многоэтапных задач интеллекту необходимо продемонстрировать более развитые способности к принятию решений:

- Определите оптимальный порядок вызова инструмента.

- Обрабатывает взаимозависимости между вызовами инструментов.

- Поддерживайте контекстуальную согласованность между несколькими операциями.

- Гибкость в реагировании на локальные успехи или неудачи.

Описанная выше сложность наглядно демонстрирует, что качество выбора инструментов не должно рассматриваться как простая метрика. Вместо этого его следует рассматривать как комплексную оценку способности интеллекта принимать сложные решения в реальных сценариях.

методология

Процесс оценки Hugging Face следует систематической методологии, которая стремится обеспечить всестороннюю и непредвзятую оценку интеллекта ИИ:

- Выбор модели: Компания Hugging Face тщательно отобрала разнообразный набор ведущих языковых моделей, как собственных, так и реализованных с открытым исходным кодом. Эта стратегия отбора направлена на то, чтобы обеспечить всестороннее представление о текущем технологическом ландшафте.

- Конфигурация кузова Smart: Hugging Face настраивает каждую модель как интеллект со стандартными системными сигналами и предоставляет им доступ к согласованному набору инструментов. Такая стандартизированная конфигурация гарантирует, что разброс производительности является истинным отражением собственных возможностей модели, а не зависит от внешних факторов, таких как разработка подсказок.

- Определение показателя: Hugging Face устанавливает качество выбора инструмента (TSQ) в качестве основной метрики оценки, фокусируясь на правильности выбора инструмента и эффективности использования параметров. Метрики TSQ разработаны с учетом реальных требований к производительности.

- Курирование массивов данных: В Hugging Face создан сбалансированный и многодоменный набор данных путем стратегической выборки из существующих эталонных наборов данных. Набор данных всесторонне тестирует возможности интеллектов, начиная от базовых вызовов функций и заканчивая сложными многораундовыми взаимодействиями, чтобы обеспечить всесторонность оценки.

- Система подсчета очков: Итоговый балл эффективности вычисляется путем расчета среднего значения равных весов по всем наборам данных. Такой подход обеспечивает сбалансированную оценку и позволяет избежать доминирования какой-либо одной способности в общих результатах оценки, что позволяет более объективно отразить всестороннюю эффективность интеллекта.

Благодаря этой структурированной методологии оценки Hugging Face стремится предоставить информацию, которая может непосредственно направлять решения о развертывании в реальном мире.

Как "Обнимая лицо" измеряет эффективность агентского интеллекта?

Как работает система оценки

Как уже говорилось выше, оценка использования инструментов требует надежных измерений в различных сценариях. Компания Hugging Face разработала метрику Tool Selection Quality для оценки эффективности использования инструментов интеллектами, обращая внимание на точность выбора инструментов и эффективность использования параметров. Система оценки предназначена для определения того, использует ли интеллект инструменты должным образом для выполнения задачи, а также для выявления ситуаций, в которых использование инструментов излишне.

В процессе оценки Hugging Face использовала модели GPT-4o и ChainPoll для оценки решений по выбору инструментов. Для каждого взаимодействия Hugging Face собирает несколько независимых оценок, а итоговый балл представляет собой долю положительных оценок. Каждое суждение содержит подробное объяснение для обеспечения прозрачности процесса оценки.

В следующем примере кода показано, как использовать метрики TSQ для оценки производительности вызова инструмента Большой языковой модели (LLM) на наборе данных:

import promptquality as pq

import pandas as pd

file_path = "path/to/your/dataset.parquet" # 替换为你的数据集文件路径

project_name = "agent-leaderboard-evaluation" # 替换为你的项目名称

run_name = "tool-selection-quality-run" # 替换为你的运行名称

model = "gpt-4o" # 你想要评估的模型名称

tools = [...] # 你的工具列表

llm_handler = pq.LLMHandler() # 初始化 LLMHandler

df = pd.read_parquet(file_path, engine="fastparquet")

chainpoll_tool_selection_scorer = pq.CustomizedChainPollScorer(

scorer_name=pq.CustomizedScorerName.tool_selection_quality,

model_alias=pq.Models.gpt_4o,

)

evaluate_handler = pq.GalileoPromptCallback(

project_name=project_name,

run_name=run_name,

scorers=[chainpoll_tool_selection_scorer],

)

llm = llm_handler.get_llm(model, temperature=0.0, max_tokens=4000)

system_msg ={

"role":"system",

"content":'Your job is to use the given tools to answer the query of human. If there is no relevant tool then reply with "I cannot answer the question with given tools". If tool is available but sufficient information is not available, then ask human to get the same. You can call as many tools as you want. Use multiple tools if needed. If the tools need to be called in a sequence then just call the first tool.',

}

outputs = []

for row in df.itertuples():

chain = llm.bind_tools(tools)

outputs.append(

chain.invoke(

[system_msg,*row.conversation],

config=dict(callbacks=[evaluate_handler])

)

)

evaluate_handler.finish()

Почему компания Hugging Face решила использовать большую языковую модель (LLM) для оценки вызовов инструмента?

Метод оценки, основанный на Большой языковой модели (LLM), позволяет всесторонне оценить различные сложные сценарии. Этот подход позволяет эффективно проверить, правильно ли интеллект справляется с ситуациями с недостаточной контекстной информацией, и определить, требуется ли дополнительная информация от пользователя перед использованием инструмента. В сценариях применения нескольких инструментов метод способен проверить, определил ли интеллектуальный организм все необходимые инструменты и вызвал ли их в правильном порядке. В длинных контекстных диалогах метод гарантирует, что интеллектуальный орган полностью учитывает релевантную информацию, полученную ранее в истории диалога. Даже в тех случаях, когда инструменты отсутствуют или неприменимы, метод оценки определяет, правильно ли интеллектуальный орган избегает вызовов инструментов и, таким образом, не допускает неуместных действий.

Чтобы превзойти показатели TSQ, искусственный интеллект должен продемонстрировать сложные возможности, включая выбор правильного инструмента при необходимости, предоставление точных параметров, эффективную координацию нескольких инструментов и выявление сценариев, в которых использование инструмента не требуется. Например, когда вся необходимая информация уже есть в истории диалога или когда нет подходящего инструмента, предпочтительнее обойтись без него.

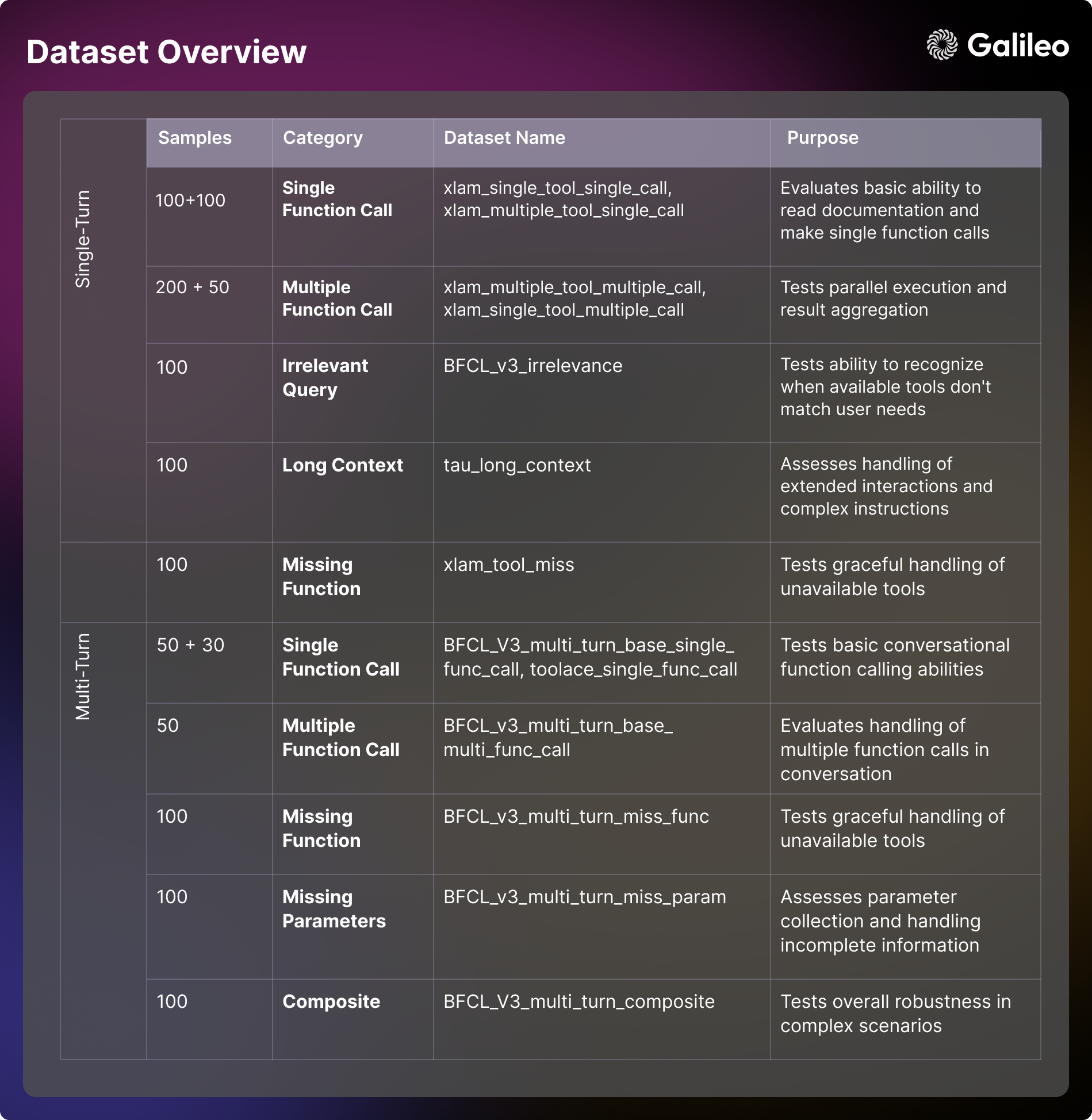

Оценка состава содержания набора данных

В системе оценки Hugging Face используется набор тщательно подобранных эталонных наборов данных, полученных из BFCL (Berkeley Вызов функции Leaderboard (Berkeley Function Call Leaderboard), τ-bench (Tau benchmark), Xlam и ToolACE. Каждый набор данных предназначен для проверки возможностей интеллекта в определенном аспекте. Понимание этих параметров оценки имеет решающее значение как для оценки моделей, так и для разработки практических приложений.

ёмкость для одного патрона

- Использование основных инструментов Сценарий: фокусируется на оценке способности интеллектуального тела понимать документацию на инструмент, параметры процесса и выполнять базовые вызовы функций. Это измерение фокусируется на изучении возможностей форматирования ответов и обработки ошибок интеллектов при непосредственном взаимодействии. Эта способность критична для простых автоматизированных задач в реальных приложениях, таких как установка напоминаний или получение базовой информации [xlam_single_tool_single_call].

- Выбор инструмента Сценарий: оценивает способность модели выбрать правильный инструмент из нескольких вариантов. В этом измерении рассматривается степень, в которой модель способна понять документацию по инструменту и принять обоснованное решение о его пригодности. Для сценариев применения в реальном мире, где создаются многоцелевые интеллекты, эта способность является критической [xlam_multiple_tool_single_call].

- параллельное выполнение Сценарий: Изучите способность модели программировать одновременную работу нескольких инструментов. Этот аспект имеет решающее значение для повышения эффективности в реальных приложениях [xlam_multiple_tool_multiple_call].

- Повторное использование инструментов Сценарий: оцените способность интеллектов эффективно обрабатывать пакетные операции и вариации параметров. Этот аспект особенно важен для сценариев пакетной обработки в реальных приложениях [xlam_single_tool_multiple_call].

Обработка ошибок и крайние случаи

- проверка на нерелевантность Сценарий: Способность тестовой модели выявлять ограничения инструментов и обоснованно сообщать, когда имеющиеся инструменты не соответствуют потребностям пользователя. Эта способность является краеугольным камнем в обеспечении пользовательского опыта и надежности системы [BFCL_v3_irrelevance].

- Обработка отсутствующих инструментов Сценарий: Изучите, насколько элегантно модель справляется с ситуацией, когда требуемый инструмент недоступен, включая способность информировать пользователя о его ограничениях и предлагать альтернативы [xlam_tool_miss, BFCL_v3_multi_turn_miss_func].

управление контекстом (вычислительная техника)

- длинный контекст Сценарий: Оцените способность модели поддерживать контекстную связность и понимать сложные инструкции в диалогах на большом расстоянии. Эта способность критична для работы со сложными рабочими процессами и длительными взаимодействиями [tau_long_context, BFCL_v3_multi_turn_long_context].

многоуровневое взаимодействие

- Основной диалог Сценарий: Проверьте способность интеллектов выполнять вызовы разговорных функций и поддерживать контекст в многораундовом диалоге. Эта базовая способность критически важна для разработки интерактивных приложений [BFCL_v3_multi_turn_base_single_func_call, toolace_single_func_call].

- сложное взаимодействие Сценарий: объедините несколько задач, чтобы всесторонне проверить общую устойчивость и способность интеллекта решать проблемы в сложных сценариях [BFCL_v3_multi_turn_base_multi_func_call, BFCL_v3_multi_turn_composite].

управление параметрами

- отсутствующий параметр Сценарий: Изучите, как модель справляется с ситуациями, когда информация неполная, и насколько эффективно она взаимодействует с пользователем для сбора необходимых параметров [BFCL_v3_multi_turn_miss_param].

Компания Hugging Face предоставила открытый доступ к набору данных, чтобы облегчить сообществу исследования и разработку приложений - Hugging Face Таблица лидеров агентов Набор данных

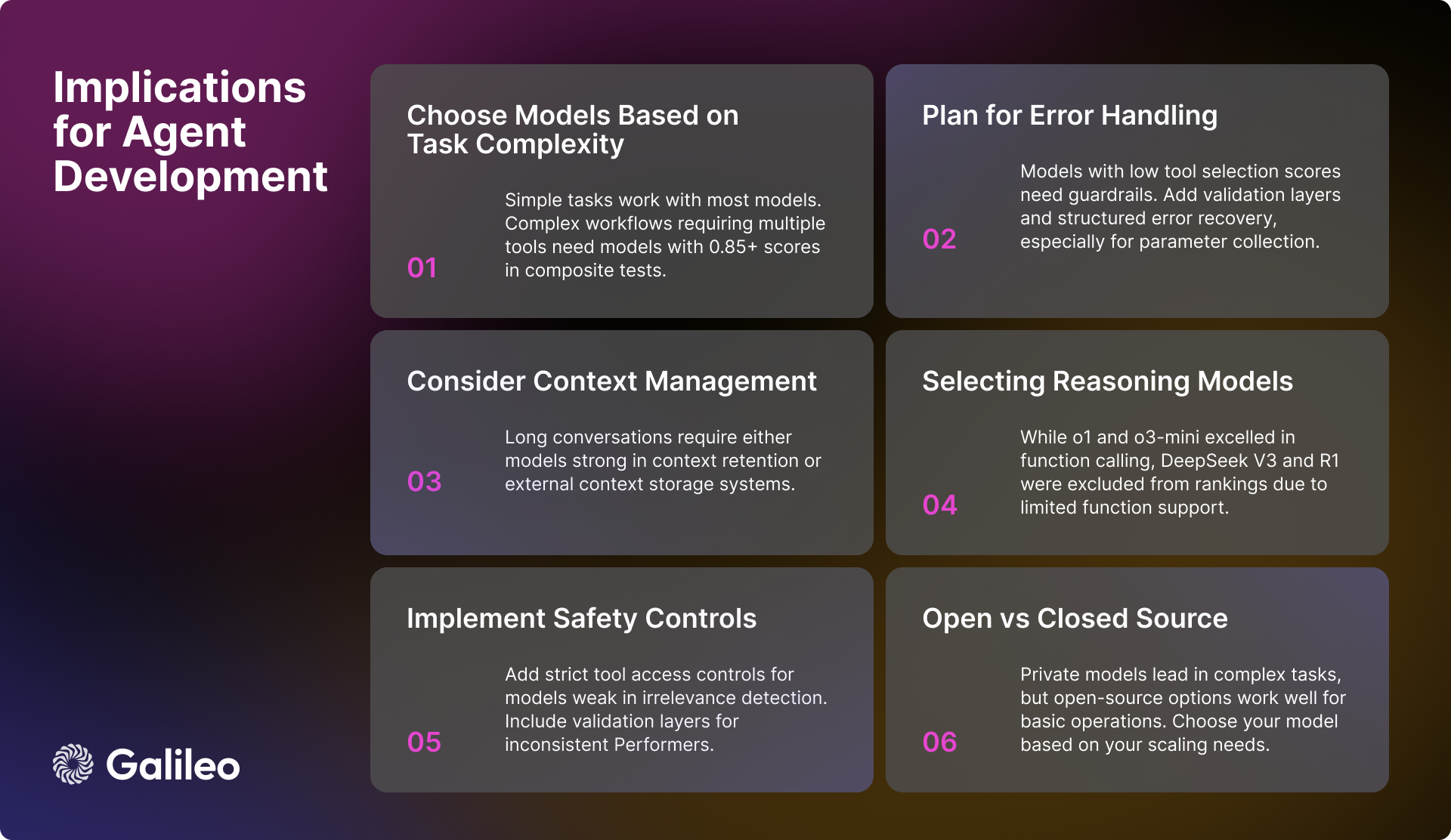

Практические последствия для инженеров ИИ

Результаты оценки Hugging Face дают много ценных сведений для инженеров ИИ при разработке искусственного интеллекта. При создании надежной и эффективной интеллектуальной системы тела необходимо учитывать следующие ключевые факторы:

Выбор модели и ее производительность

Для приложений, которые должны обрабатывать сложные рабочие процессы, очень важно выбирать высокопроизводительные модели, которые получают более 0,85 балла за выполнение составной задачи. Хотя большинство моделей способны выполнять базовые задачи вызова инструментов, при работе с параллельными операциями важнее ориентироваться на результат выполнения моделью конкретной задачи, а не полагаться только на общие показатели производительности.

Управление контекстом и ошибками

Для моделей, которые плохо работают в сценариях с длинным контекстом, очень важно реализовать эффективную стратегию обобщения контекста. Если выбираются модели с недостатками в обнаружении нерелевантности или обработке параметров, то необходимо создать надежные механизмы обработки ошибок. Для моделей, которым требуется дополнительная поддержка в сборе параметров, можно рассмотреть возможность структурированного рабочего процесса, который направляет пользователя на предоставление необходимой информации о параметрах.

Безопасность и надежность

Чтобы обеспечить безопасность и надежность системы, важно внедрить строгий контроль доступа к инструментам, особенно для моделей, которые плохо справляются с выявлением нерелевантных операций. Для моделей с недостаточной стабильностью производительности следует рассмотреть возможность добавления дополнительных уровней проверки для повышения общей надежности системы. Также очень важно иметь хорошо продуманную систему восстановления ошибок, особенно для моделей, которые с трудом справляются с отсутствующими параметрами.

Оптимизация производительности системы

При проектировании архитектуры рабочего процесса системы необходимо учитывать различия в способности разных моделей работать с параллельным выполнением и сценариями с длинным контекстом. При реализации стратегии пакетной обработки важно оценить возможности модели по повторному использованию инструментов, поскольку это напрямую влияет на общую эффективность системы.

Текущий статус разработки моделей ИИ

В то время как проприетарные модели пока еще лидируют по общим возможностям, модели с открытым исходным кодом быстро улучшают свои характеристики. В простых задачах взаимодействия инструментов все типы моделей становятся все более совершенными. Однако в сложных многораундовых взаимодействиях и сценариях с длинным контекстом модели все еще сталкиваются со многими проблемами.

Вариативность производительности моделей в различных измерениях подчеркивает важность выбора моделей на основе конкретных требований к сценариям использования. Вместо того чтобы ориентироваться только на общие показатели производительности модели, разработчики должны глубоко оценить реальную производительность модели в целевых сценариях применения.

Hugging Face надеется, что этот список Agent Intelligentsia послужит ценным справочным материалом для разработчиков.

Обзор производительности модели

модель вывода

Интересным явлением в анализе Hugging Face является производительность модели вывода. Хотя o1 ответить пением o3-mini Несмотря на то, что Hugging Face показал хорошие результаты в интеграции возможностей вызова функций, получив высокие оценки 0,876 и 0,847 соответственно, он столкнулся с некоторыми проблемами при работе с другими моделями вывода. В частности.DeepSeek V3 ответить пением Deepseek R1 Модели, хотя и впечатляющие по своим возможностям общего назначения, были исключены из списка лидеров Hugging Face из-за ограниченной поддержки вызовов функций в текущей версии.

Необходимо подчеркнуть, что это будет DeepSeek V3 ответить пением Deepseek R1 Исключение из рейтинга - это не отрицание превосходства этих моделей, а скорее взвешенное решение, принятое с полным пониманием опубликованных ограничений моделей. В Deepseek V3 и Deepseek R1 В официальном обсуждении Hugging Face разработчики дали понять, что текущие версии этих моделей пока не поддерживают вызовы функций. Hugging Face решила дождаться будущего релиза с нативной поддержкой вызовов функций, а не пытаться придумать обходные пути или представить потенциально вводящие в заблуждение показатели производительности.

Этот случай подчеркивает, что вызовы функций - это специальная функция, которой по умолчанию обладают не все высокопроизводительные языковые модели. Даже те модели, которые отлично справляются с рассуждениями, могут не поддерживать структурированные вызовы функций, если они не были специально разработаны и обучены для этого. Поэтому тщательная оценка модели для конкретного случая использования позволит вам сделать оптимальный выбор.

Производительность элитного уровня (>= 0,9)

Gemini-2.0-flash Модель продолжает лидировать в рейтинге с отличным средним баллом 0,938. Модель демонстрирует отличную стабильность и последовательность во всех категориях оценки, особенно сильные стороны в составных сценариях (0,95) и обнаружении нерелевантности (0,98). Учитывая, что в расчете на миллион жетон Ценообразование $0,15/$0,6.Gemini-2.0-flash Убедительный баланс между производительностью и экономичностью.

За ним следуют GPT-4oМодель получила высокий балл 0,900 и хорошо справилась со сложными задачами, такими как обработка с помощью нескольких инструментов (0,99) и параллельное выполнение (0,98). Хотя GPT-4o Цена значительно выше - $2,5/$10 за миллион токенов, но превосходная производительность все же оправдывает более высокую стоимость.

Высокопроизводительный диапазон (0,85 - 0,9)

Сегмент высокопроизводительных автомобилей сосредоточен на нескольких сильных моделях. Близнецы-1,5 вспышки Отличная оценка 0,895 сохраняется, особенно при выявлении некоррелированности (0,98) и выполнении одной функции (0,99). Gemini-1.5-pro Несмотря на более высокую цену в $1,25/$5 за миллион токенов, он все равно получил высокий балл 0,885, продемонстрировав значительные преимущества в комбинированных задачах (0,93) и выполнении одного инструмента (0,99).

o1 Несмотря на более высокую цену в $15/$60 за миллион токенов, модель подтверждает свою позицию на рынке, набрав 0,876 балла и лидируя в отрасли по мощности обработки длинного контекста (0,98). Развивающиеся модели o3-mini Она конкурентоспособна на уровне 0,847, превосходит конкурентов в области одиночных вызовов функций (0,975) и обнаружения нерелевантности (0,97), а также предлагает хорошо сбалансированный выбор по цене $1,1/$4,4 за миллион токенов.

Средний уровень производительности (0,8-0,85)

GPT-4o-mini сохраняет эффективность на уровне 0,832, особенно хорошо проявляя себя в параллельном использовании инструментов (0,99) и выборе инструментов. Однако в сценариях с длинным контекстом модель работает относительно плохо (0,51).

В лагере моделирования с открытым исходным кодоммистраль-малый-2501 Лидируя с показателем 0,832, модель демонстрирует значительное улучшение как в обработке длинного контекста (0,92), так и в возможностях выбора инструмента (0,99) по сравнению с предыдущей версией. Квен-72б С показателем 0,817 она следует вплотную за частной моделью, не уступая ей в определении нерелевантности (0,99) и демонстрируя сильную обработку длинного контекста (0,92). Мистраль - большой Хорошо справляется с выбором инструментов (0,97), но по-прежнему сталкивается с проблемами при интеграции задач (0,76).

Claude-sonnet достигла 0,801 балла и преуспела в инструментальном обнаружении делеций (0,92) и обработке одной функции (0,955).

Модель базового слоя (<0,8)

Модели базового уровня состояли в основном из моделей, которые демонстрировали хорошие результаты в определенных областях, но были относительно низкими по общему количеству баллов. Клод-хайку Более сбалансированная производительность с показателем 0,765 и ценой 0,8/ 4 доллара за миллион токенов демонстрирует высокую экономическую эффективность.

модель с открытым исходным кодом Llama-70B показывает потенциал 0,774, особенно в сценарии с несколькими инструментами (0,99). В то время как Мистраль - малый (0.750), Мистраль-8b (0,689) и Мистраль-немо (0,661) и другие менее масштабные варианты модели, с другой стороны, предоставляют пользователям эффективные варианты в сценариях базовых задач.

Эти наборы данных необходимы для создания системы комплексной оценки возможностей вызова инструментов языкового моделирования.

Комментарии: Рейтинг интеллектуальных тел агентов, запущенный компанией Hugging Face, точно отражает основную проблему, с которой сталкивается современное применение больших языковых моделей - как эффективно использовать инструменты. В течение долгого времени внимание индустрии было сосредоточено на возможностях самой модели, однако умение использовать инструменты - это ключ к тому, чтобы модель была действительно реализована и решала реальные проблемы. Появление этого рейтинга, несомненно, дает разработчикам ценный ориентир, который поможет им выбрать наиболее подходящие модели для конкретных сценариев применения. Отчет Hugging Face, начиная с методологии оценки, построения набора данных и заканчивая итоговым анализом эффективности, демонстрирует строгий и скрупулезный профессионализм компании, а также отражает ее активные усилия по содействию внедрению приложений ИИ. Особого одобрения заслуживает тот факт, что рейтинг не только фокусируется на абсолютной производительности моделей, но и анализирует их работу в различных сценариях, таких как длительная обработка контекста и обращение к нескольким инструментам, которые являются важнейшими факторами в реальных приложениях. Кроме того, компания Hugging Face предоставила открытый доступ к набору данных для оценки, что, несомненно, будет способствовать дальнейшим исследованиям и разработкам сообщества в области возможностей вызова инструментов. В целом, это очень своевременное и ценное начинание.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...