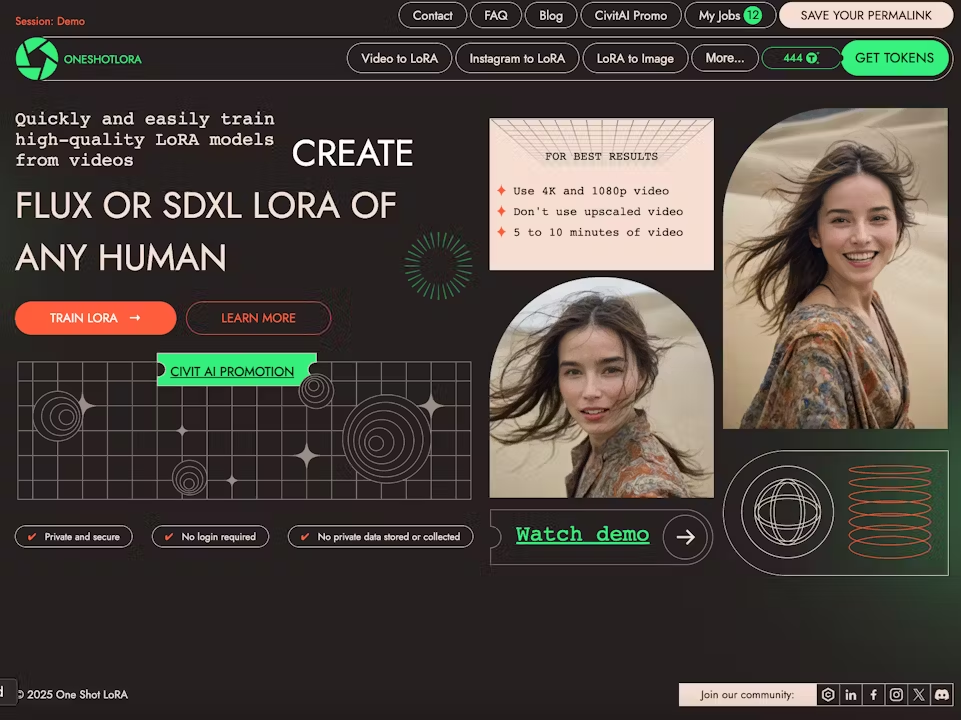

One Shot LoRA: a plataforma completa para geração rápida de modelos de LoRA em vídeo

Introdução geral O One Shot LoRA é uma plataforma voltada para a geração de modelos de LoRA de vídeo de alta qualidade a partir de vídeos. Os usuários podem treinar modelos de LoRA de boutique de forma rápida e fácil a partir de vídeos sem fazer login ou armazenar dados privados. A plataforma é compatível com Hunyua...