综合介绍

Open WebUI(原名Ollama WebUI)是一款友好的AI交互用户界面,专为LLMs(大型语言模型)设计。它具有可扩展性、丰富的功能并完全离线运行。Open WebUI突出特性包括聊天式界面设计、高响应速度、使用Docker或Kubernetes的简易设置、代码高亮显示、Markdown和LaTeX支持、本地与远程RAG集成,语音/视频通话功能、图像生成集成等多种功能,等。

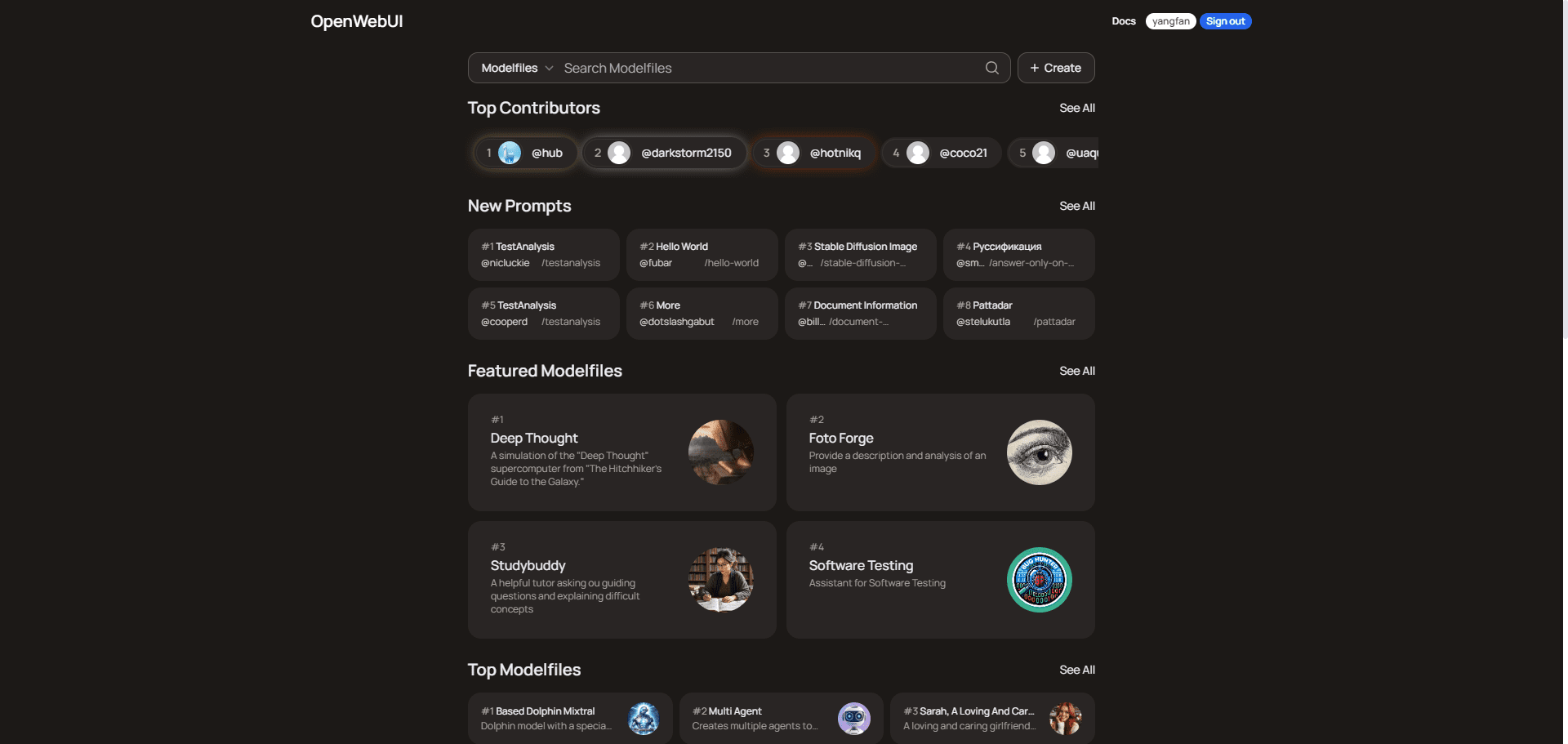

关于OpenWebUI:

OpenWebUI是一个用户社区平台,提供多种用途的模型文件,涵盖编程、写作、生产力、教育、商务和数据分析等领域。用户可以探索和下载这些模型文件以提升他们的任务和项目效率。平台已有超过15000名用户,并根据贡献者排名和共享的智能聊天日志进行交流和学习。

免费云端部署方法请参考 低配电脑部署一套个人专属的小模型聊天工具 ,其中关于 Koyeb 部署 Open WebUI 的说明。

功能列表

- 无缝安装:通过Docker或Kubernetes轻松安装,支持Ollama和CUDA标记的镜像。

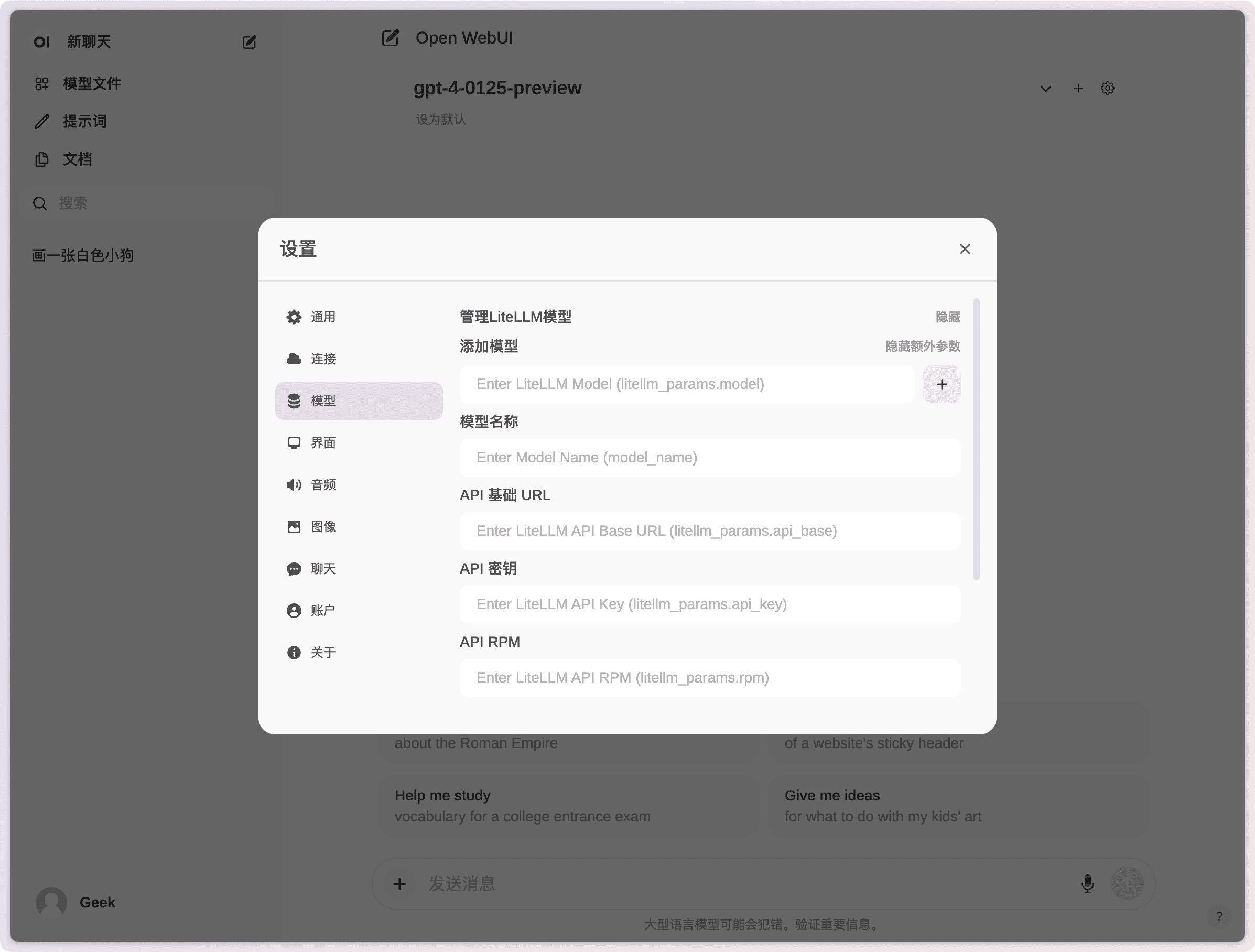

- API集成:轻松集成OpenAI兼容的API,支持多种对话模型。

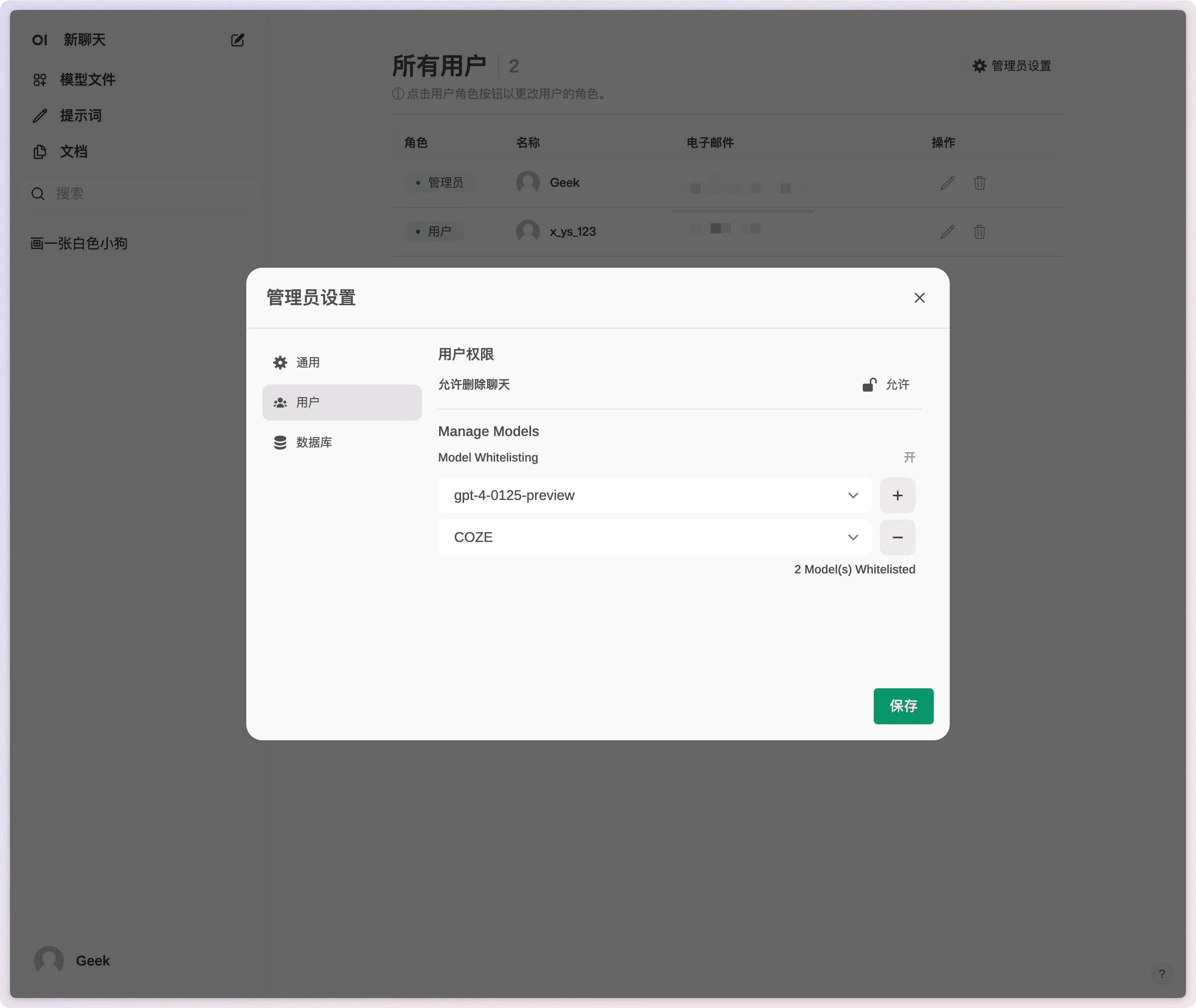

- 细粒度权限和用户组:管理员可以创建详细的用户角色和权限,确保安全的用户环境。

- 响应式设计:在桌面PC、笔记本电脑和移动设备上享受无缝体验。

- 渐进式Web应用(PWA):在移动设备上提供类似本地应用的体验,支持离线访问。

- Markdown和LaTeX支持:提供全面的Markdown和LaTeX功能,提升交互体验。

- 语音/视频通话:集成免提语音和视频通话功能,提供更动态的聊天环境。

- 模型构建器:通过Web UI轻松创建Ollama模型,添加自定义角色/代理。

- 本地RAG集成:支持检索增强生成(RAG),将文档交互无缝集成到聊天体验中。

- 图像生成集成:支持AUTOMATIC1111 API、ComfyUI和OpenAI的DALL-E,丰富聊天体验。

- 多模型对话:同时与多种模型进行交互,利用其独特优势提供最佳响应。

- 基于角色的访问控制(RBAC):确保安全访问,仅授权人员可以访问Ollama和模型创建/拉取权限。

- 多语言支持:提供国际化支持,用户可以选择自己喜欢的语言。

- 插件支持:通过Pipelines插件框架无缝集成自定义逻辑和Python库。

使用帮助

安装流程

使用Docker安装

- 拉取镜像:在终端中运行以下命令以从GitHub容器注册表中拉取最新的Open WebUI Docker镜像:

docker pull ghcr.io/open-webui/open-webui:main - 运行容器:使用默认设置运行容器,确保数据持久存储:

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main- 卷映射:确保数据持久存储,防止容器重启时数据丢失。

- 端口映射:将WebUI暴露在本地机器的3000端口。

使用Python安装

- 安装Open WebUI:确保使用Python 3.11,避免兼容性问题。在终端中运行以下命令:

pip install open-webui - 运行Open WebUI:安装完成后,执行以下命令启动Open WebUI:

open-webui serve这将启动Open WebUI服务器,您可以在http://localhost:8080访问。

功能操作指南

语音/视频通话

- 启动通话:在聊天界面中点击语音或视频通话按钮,选择联系人并开始通话。

- 通话控制:在通话过程中,可以使用界面上的控制按钮进行静音、挂断等操作。

图像生成

- 选择图像生成工具:在聊天界面中选择AUTOMATIC1111 API、ComfyUI或OpenAI的DALL-E。

- 输入描述:在输入框中输入图像描述,点击生成按钮。

- 查看结果:生成的图像将显示在聊天界面中,用户可以保存或分享。

本地RAG集成

- 加载文档:在聊天界面中使用#命令加载文档或添加文件到文档库。

- 检索信息:在聊天中输入查询,系统将自动从加载的文档中检索相关信息并生成响应。

常见问题

- 连接问题:如果遇到连接问题,请确保Docker容器能够访问Ollama服务器。使用以下命令解决:

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main - 更新Docker安装:使用Watchtower更新本地Docker安装到最新版本:

docker run --rm --volume /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower --run-once open-webui

在抱抱脸一键部署Open WebUI

https://codeberg.org/fossandroid/Open-WebUI.git

https://linux.do/t/topic/274417

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...