综合介绍

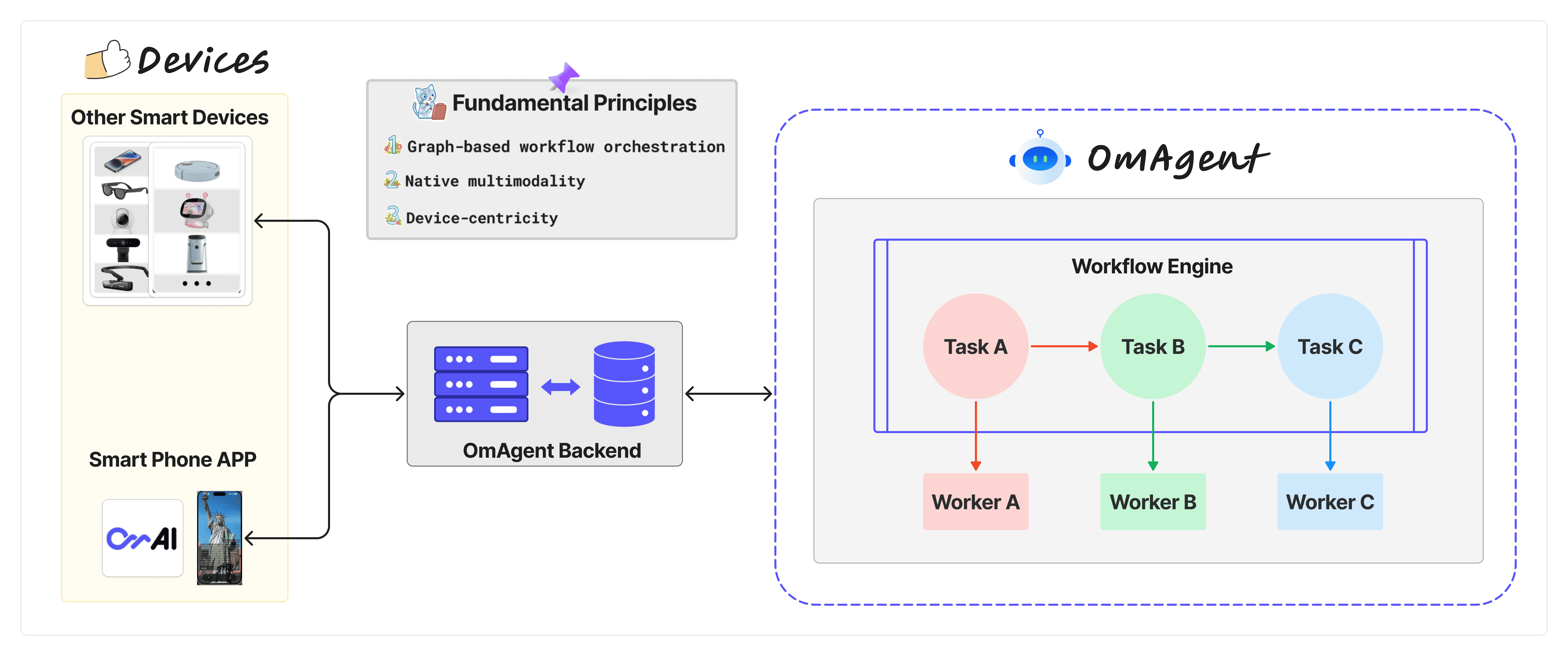

OmAgent是由Om AI Lab开发的一个多模态智能体框架,旨在为智能设备提供强大的AI驱动功能。该项目通过整合最先进的多模态基础模型和智能体算法,使开发者能够在各种智能设备上创建高效、实时的交互体验。OmAgent不仅支持文本和图像处理,还具备复杂视频理解能力,适用于从智能手机到未来机器人的广泛应用场景。其核心是优化端到端计算,确保用户与设备之间的互动自然流畅。

功能列表

- 多模态模型支持:集成商业和开源的多模态基础模型,提供强大的人工智能支持。

- 设备连接简化:简化与物理设备如手机、眼镜等的连接过程,支持开发者创建在设备上运行的应用。

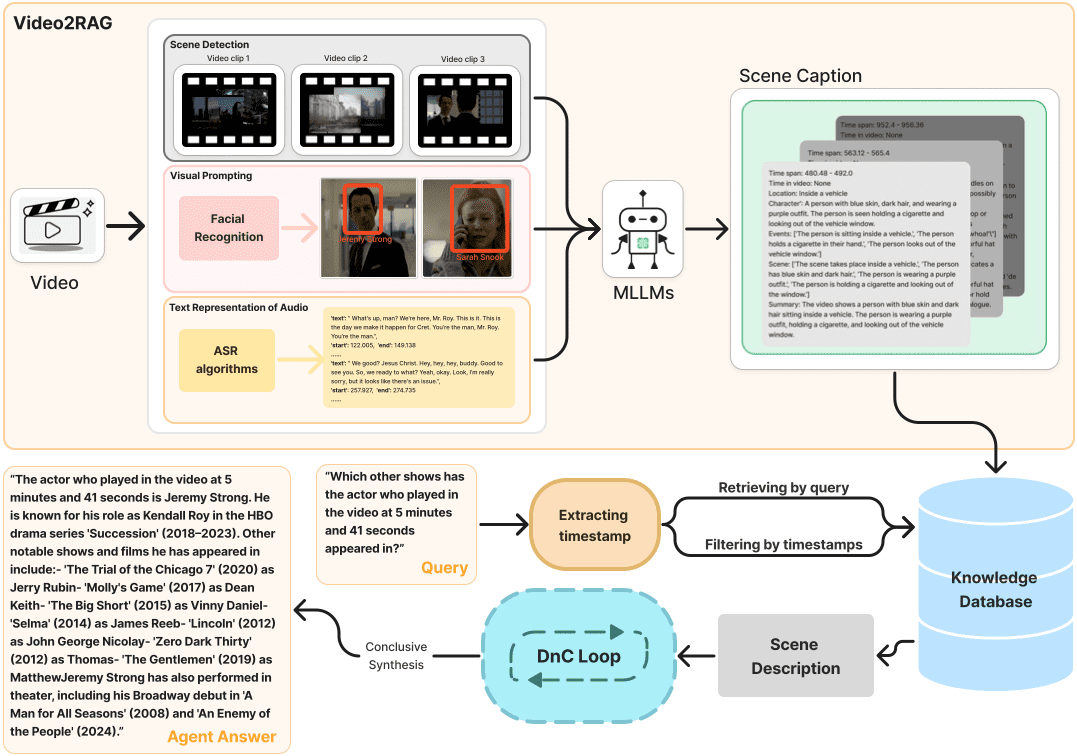

- 复杂视频理解:利用分而治之的算法,提供对视频内容的深度解析和理解。

- 工作流编排:使用Conductor工作流引擎,支持复杂的编排逻辑如循环和分支。

- 任务和工人管理:通过Task和Worker概念,实现工作流中的逻辑编排和节点执行。

- 高效的音视频处理:优化音频和视频处理,以确保实时交互体验。

使用帮助

安装流程

OmAgent是一个开源项目,托管在GitHub上,安装过程如下:

- 克隆仓库:

- 打开终端,执行以下命令来克隆OmAgent的GitHub仓库:

git clone https://github.com/om-ai-lab/OmAgent.git - 进入克隆的目录:

cd OmAgent

- 打开终端,执行以下命令来克隆OmAgent的GitHub仓库:

- 环境配置:

- 创建并激活Python环境(推荐使用conda):

conda create -n omagent python=3.10 conda activate omagent - 安装所需的依赖:

pip install -r requirements.txt - 如果需要特定的配置(如bing搜索API),请修改

configs/tools/websearch.yml文件,添加你的bing_api_key。

- 创建并激活Python环境(推荐使用conda):

使用教程

开发智能体

- 创建智能体:

- 可以从

examples目录中找到示例项目,如step1_simpleVQA,学习如何构建一个简单的多模态视觉问答智能体。 - 按照示例中的步骤,编写你自己的智能体逻辑。

- 可以从

- 连接设备:

- 通过OmAgent的app后端服务,可以将智能体部署到设备上。参考

app使用文档中关于设备连接的部分,确保设备和智能体之间的通信无缝进行。

- 通过OmAgent的app后端服务,可以将智能体部署到设备上。参考

- 视频理解:

- 使用

video_understanding示例项目,了解如何利用OmAgent处理和理解视频内容。特别注意使用分而治之的策略(Divide-and-Conquer Loop),以实现智能视频查询和分析。

- 使用

- 工作流管理:

- 通过创建和编辑

container.yaml文件来配置你的工作流。每个工作流可以包含多个节点,每个节点可以是独立的任务或复杂的逻辑分支。 - 使用Conductor作为工作流引擎,支持

switch-case、fork-join、do-while等复杂操作。

- 通过创建和编辑

- 任务与工人:

- 在开发过程中,定义

Task来管理工作流逻辑,Worker则执行具体的操作逻辑。每个SimpleTask对应一个Worker,通过这种方式可以灵活地构建和扩展智能体功能。

- 在开发过程中,定义

运行智能体

- 运行示例:

- 在克隆的项目目录中,运行示例脚本,如:

python run_demo.py - 结果将保存在

./outputs文件夹中。

- 在克隆的项目目录中,运行示例脚本,如:

- 调试与测试:

- 使用GitHub Actions进行自动化测试和部署,确保你的智能体在不同环境下都能稳定运行。

深入学习

- 查看文档:OmAgent的详细API文档和使用教程可以帮助你更深入地理解和利用这个框架。

- 社区支持:加入Om AI Lab的社区,参与讨论,获取支持和分享你的工作。

通过以上步骤,开发者可以从OmAgent的广泛功能中受益,创建能在各种智能设备上运行的复杂AI智能体,提供从简单问答到复杂视频分析等多种任务的解决方案。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...