Mistral Small 3:Apache 2.0 协议,81% MMLU,150 tokens/秒

今天,Mistral AI 推出 Mistral Small 3,这是一款延迟优化的 240 亿参数模型,并根据 Apache 2.0 协议发布。

Mistral Small 3 可以与更大的模型相媲美,例如 Llama 3.3 70B 或 Qwen 32B,并且是像 GPT4o-mini 这样不透明的专有模型的出色开源替代品。Mistral Small 3 的性能与 Llama 3.3 70B instruct 相当,但在相同的硬件上速度快 3 倍以上。

Mistral Small 3 是一个预训练和指令微调模型,旨在满足生成式 AI 任务中 ‘80%’ 的需求,这些任务需要强大的语言能力和指令遵循性能,并且具有极低的延迟。

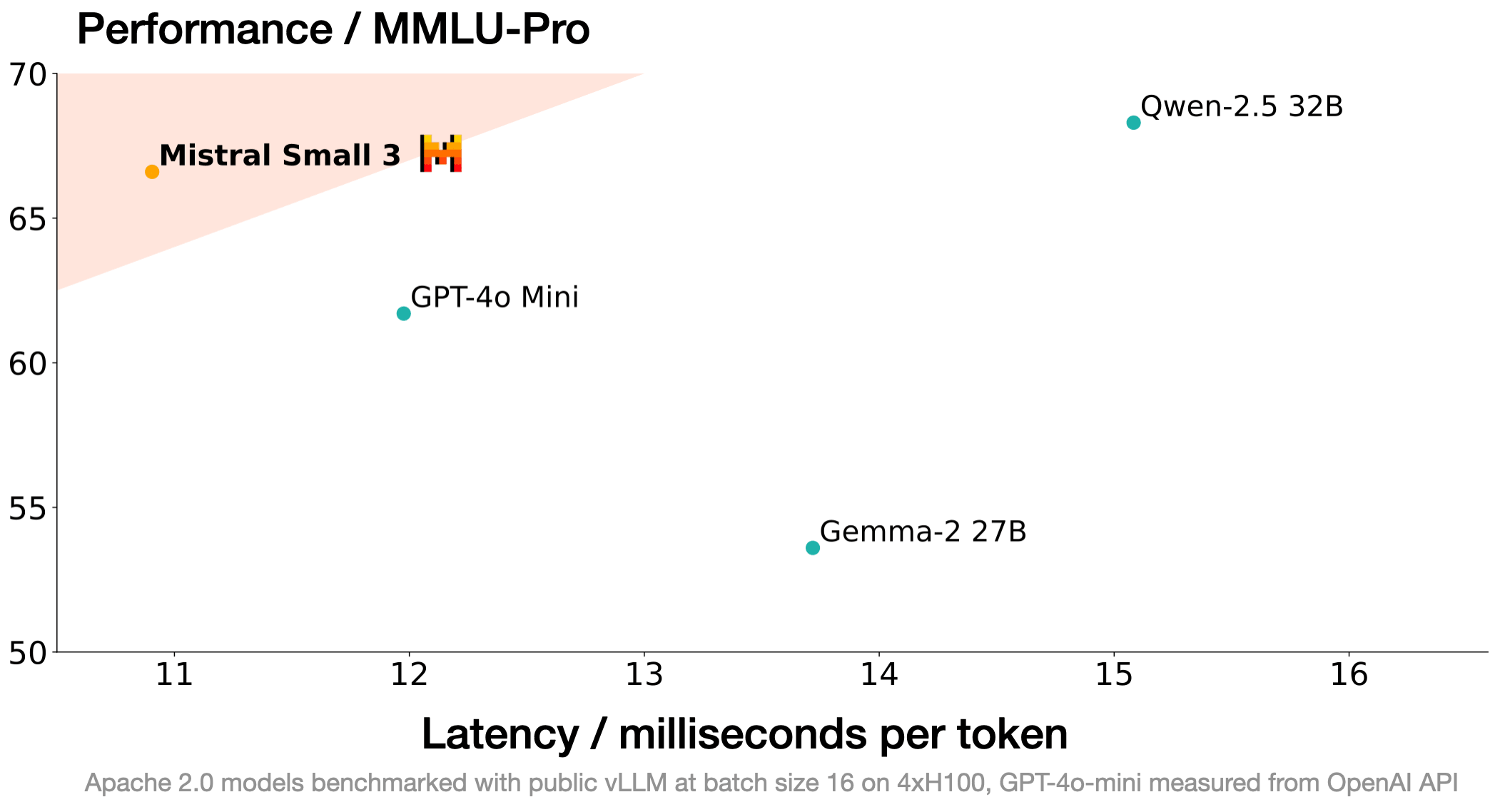

Mistral AI 设计了这款新模型,使其性能在一个适合本地部署的规模上达到饱和。特别地,Mistral Small 3 的层数远少于竞争模型,大大减少了每次前向传播的时间。Mistral Small 以超过 81% 的 MMLU 准确率和 150 tokens/秒的延迟,成为目前同类模型中最有效的模型。

Mistral AI 正在 Apache 2.0 协议下发布预训练和指令微调检查点。这些检查点可以作为加速进步的强大基础。请注意,Mistral Small 3 既没有使用强化学习(RL)也没有使用合成数据进行训练,因此在模型生产流程中比 Deepseek R1 (一个很棒且互补的开源技术!)等模型更早。它可以作为一个很好的基础模型,用于构建累积的推理能力。Mistral AI 期待看到开源社区如何采用和定制它。

性能

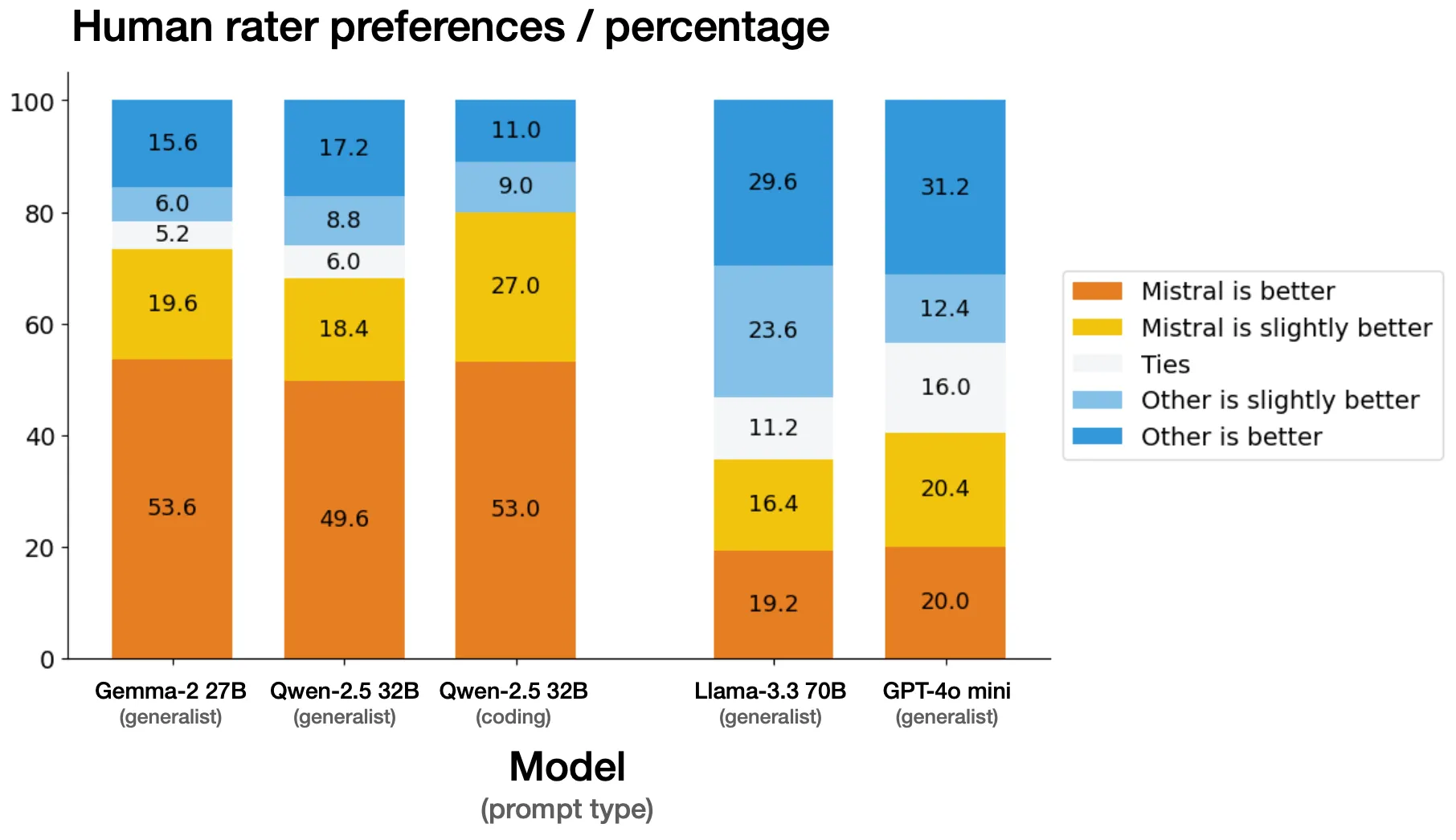

人工评估

Mistral AI 与外部第三方供应商,在一组超过 1000 个专有编码和通用提示上进行了并排评估。评估人员的任务是从 Mistral Small 3 与另一个模型生成的匿名结果中选择他们更喜欢的模型响应。Mistral AI 意识到,在某些情况下,人类判断的基准与公开的基准差异很大,但 Mistral AI 已格外谨慎地验证了评估的公平性。Mistral AI 确信以上基准是有效的。

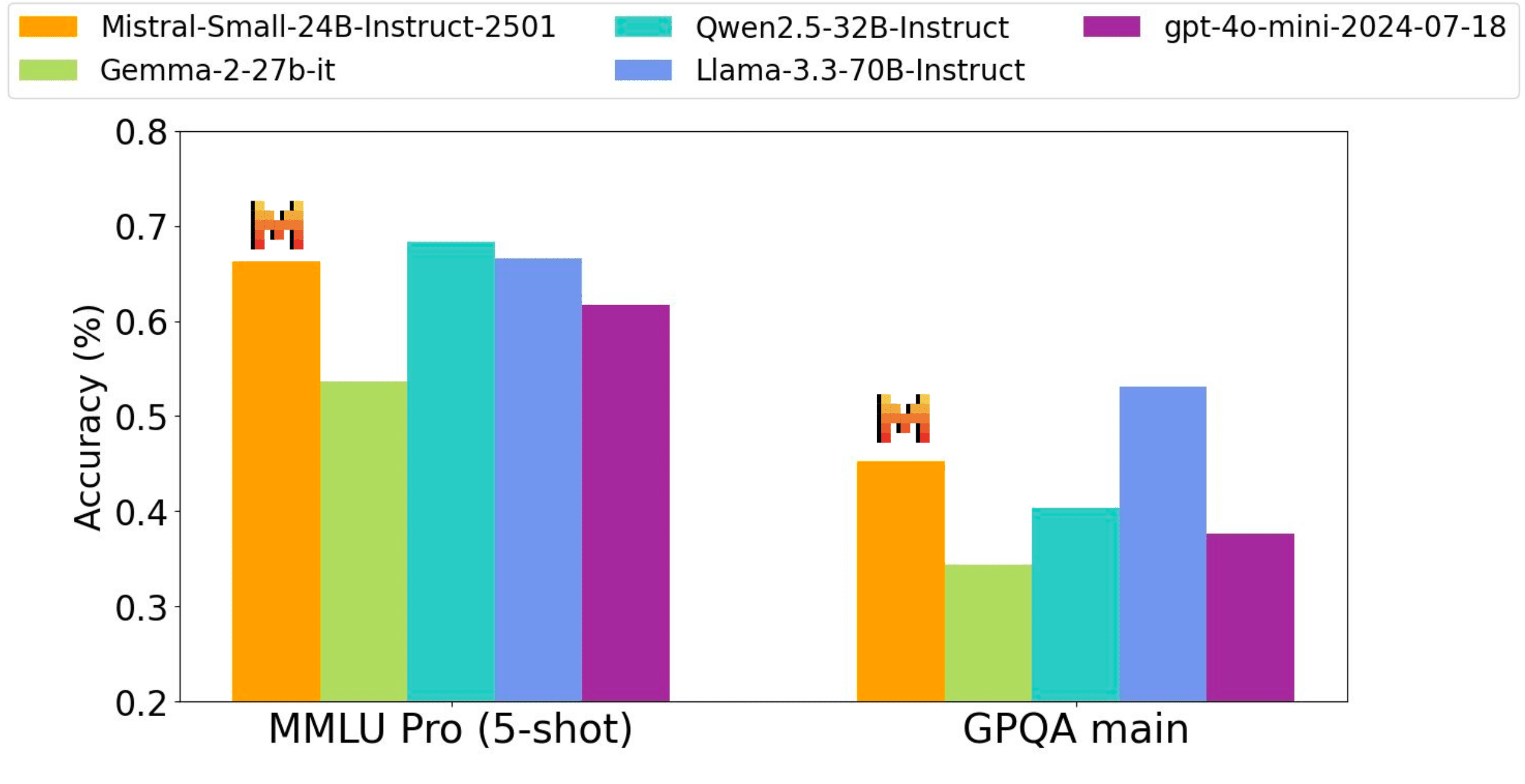

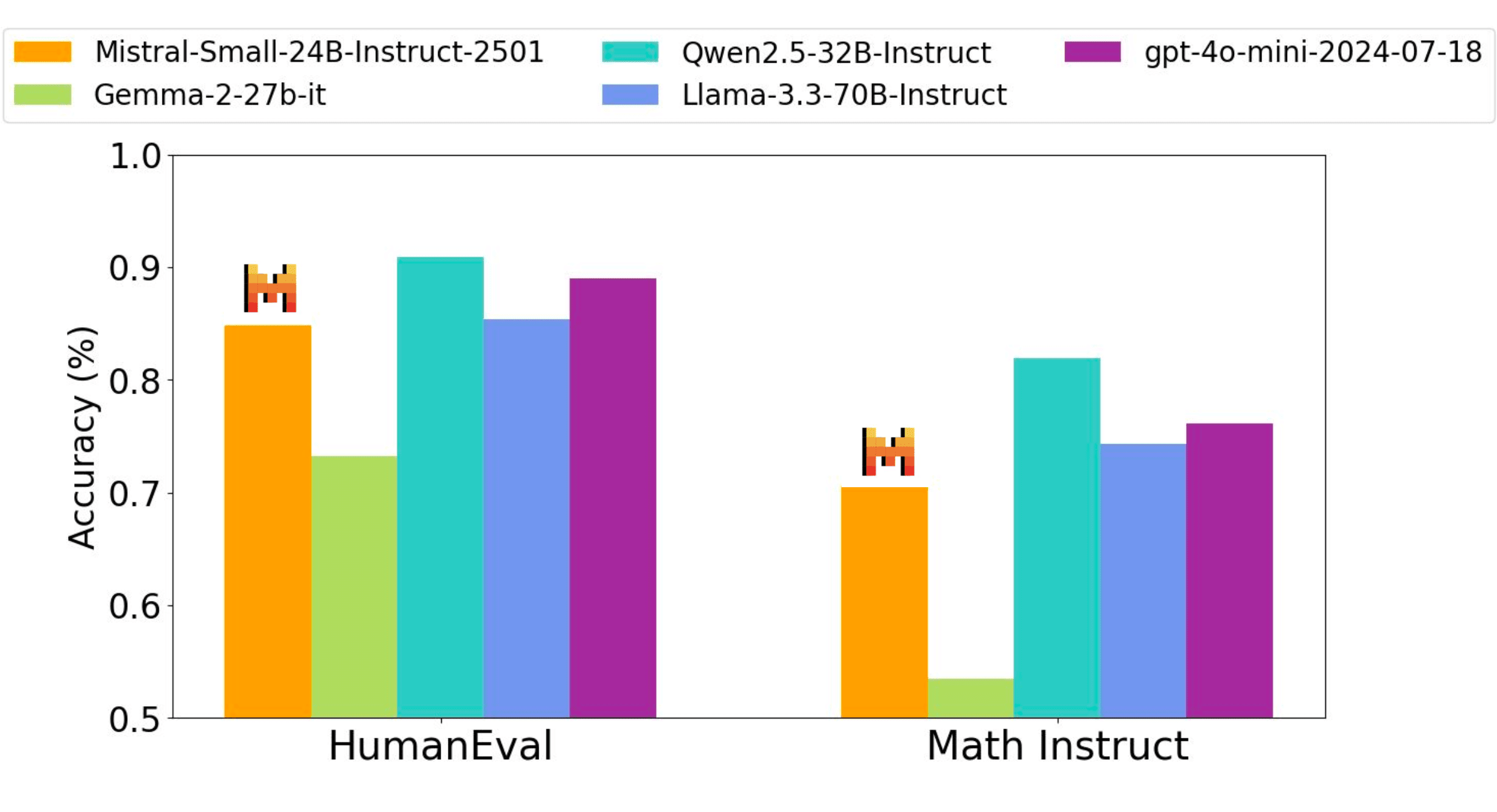

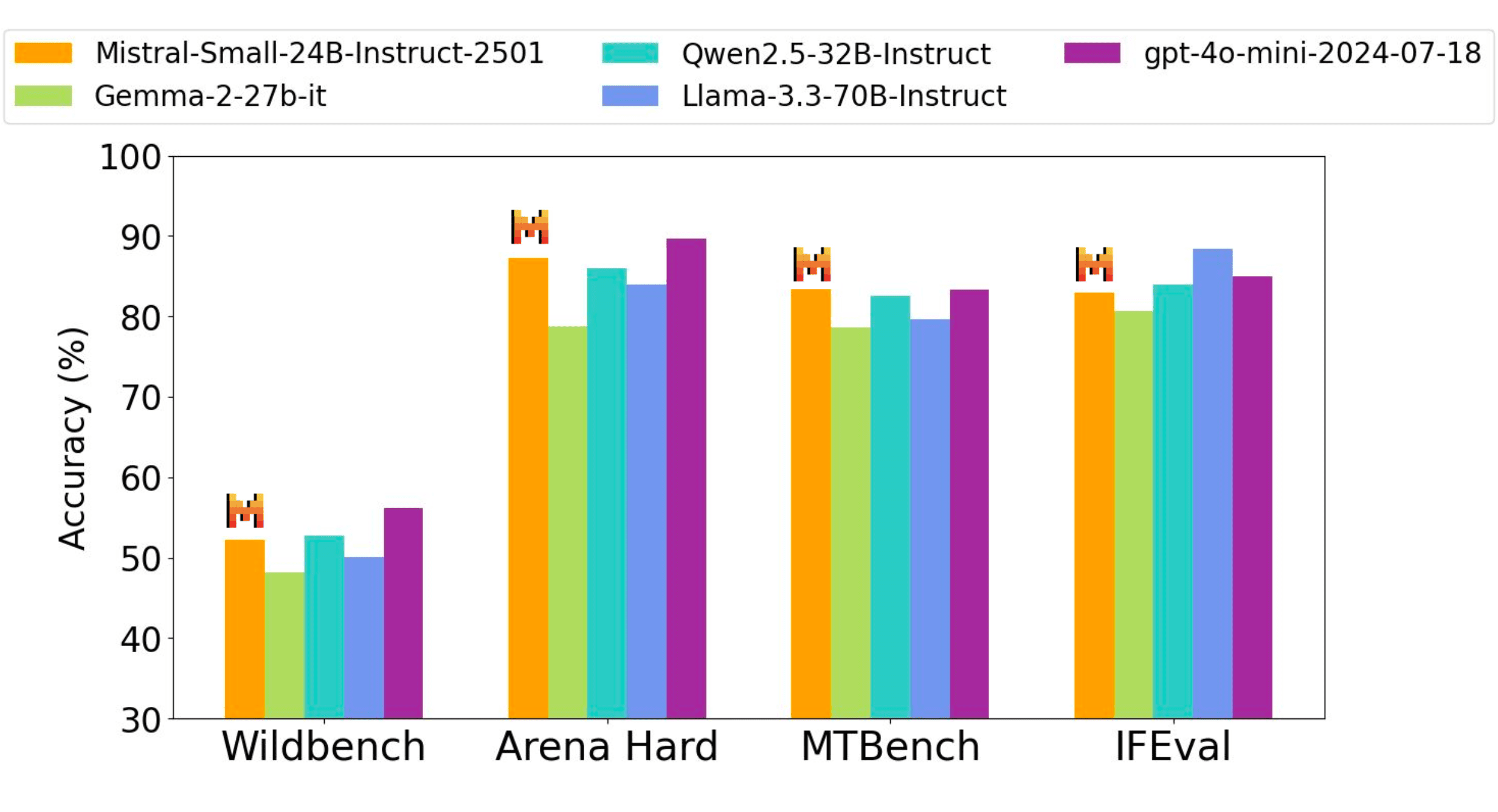

指令性能

Mistral AI 的指令微调模型在代码、数学、通用知识和指令跟随基准测试中,与比它大三倍的开源权重模型以及专有的 GPT4o-mini 模型相比,具有竞争优势。

所有基准测试的性能精度都是通过相同的内部评估流程获得的 - 因此,数字可能与之前报告的性能略有不同 (Qwen2.5-32B-Instruct, Llama-3.3-70B-Instruct, Gemma-2-27B-IT)。Wildbench、Arena hard 和 MTBench 等 Judge based evals 基于 gpt-4o-2024-05-13。

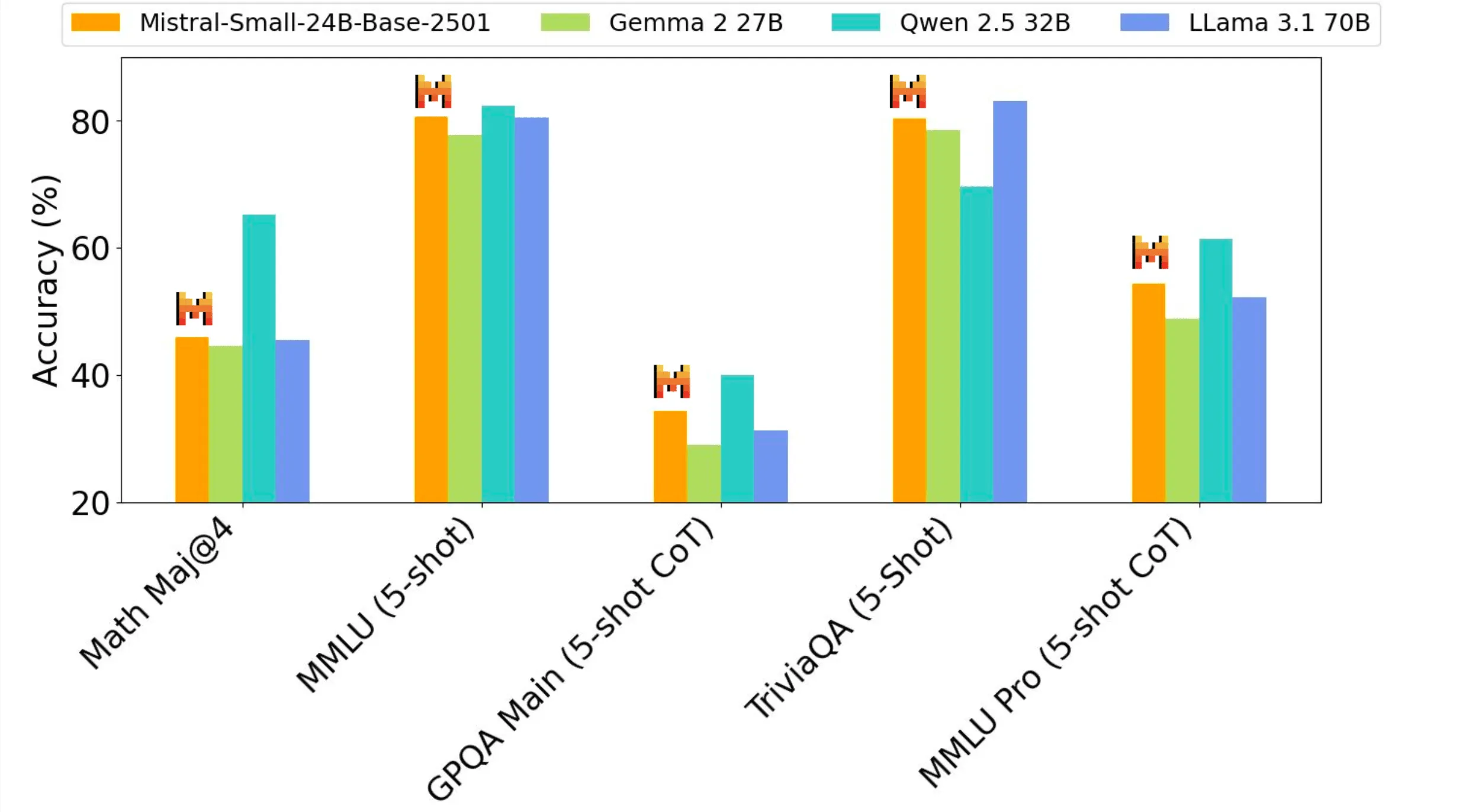

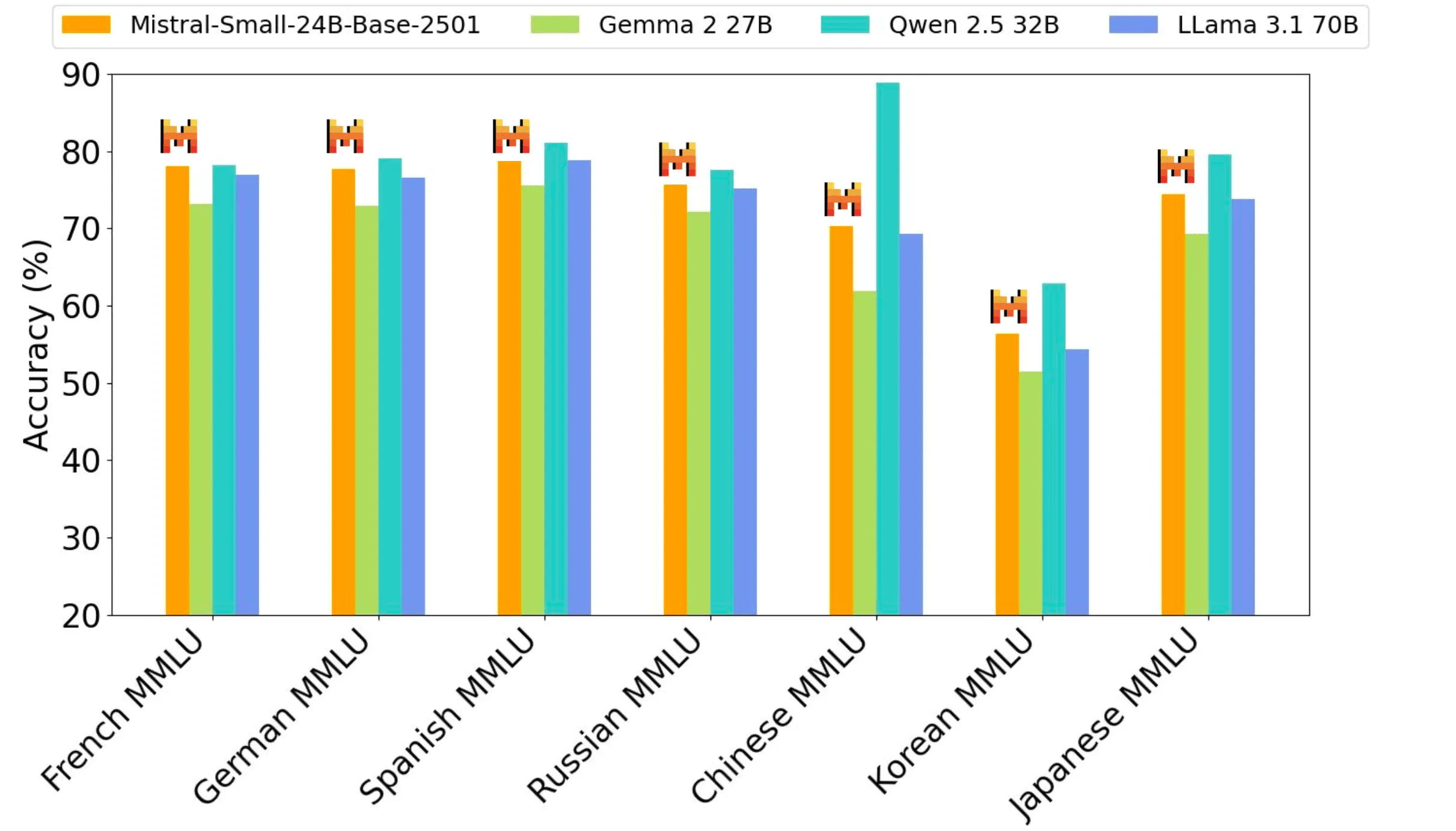

预训练性能

Mistral Small 3 作为一个 24B 模型,为其规模级别提供了最佳性能,并能与 Llama 3.3 70B 等大三倍的模型相匹敌。

何时使用 Mistral Small 3

在 Mistral AI 的客户和社区中,Mistral AI 看到这种规模的预训练模型出现了几种独特的用例:

- 快速响应的对话辅助:Mistral Small 3 在需要快速、准确响应的场景中表现出色。这包括许多用户期望即时反馈和近乎实时交互的虚拟助手场景。

- 低延迟函数调用:当 Mistral Small 3 用作自动化或代理工作流程的一部分时,它能够处理快速的函数执行。

- 微调以创建主题专家:Mistral Small 3 可以进行微调,以专注于特定领域,从而创建高度准确的主题专家。这在法律咨询、医疗诊断和技术支持等领域尤其有用,在这些领域中,特定领域的知识至关重要。

- 本地推理:特别有益于处理敏感或专有信息的业余爱好者和组织。当进行量化时,Mistral Small 3 可以在单个 RTX 4090 或具有 32GB 内存的 Macbook 上私下运行。

Mistral AI 的客户正在多个行业评估 Mistral Small 3,包括:

- 金融服务客户用于欺诈检测

- 医疗保健提供商用于客户分诊

- 机器人、汽车和制造公司用于设备上的命令和控制

- 跨客户的横向用例包括虚拟客户服务以及情绪和反馈分析。

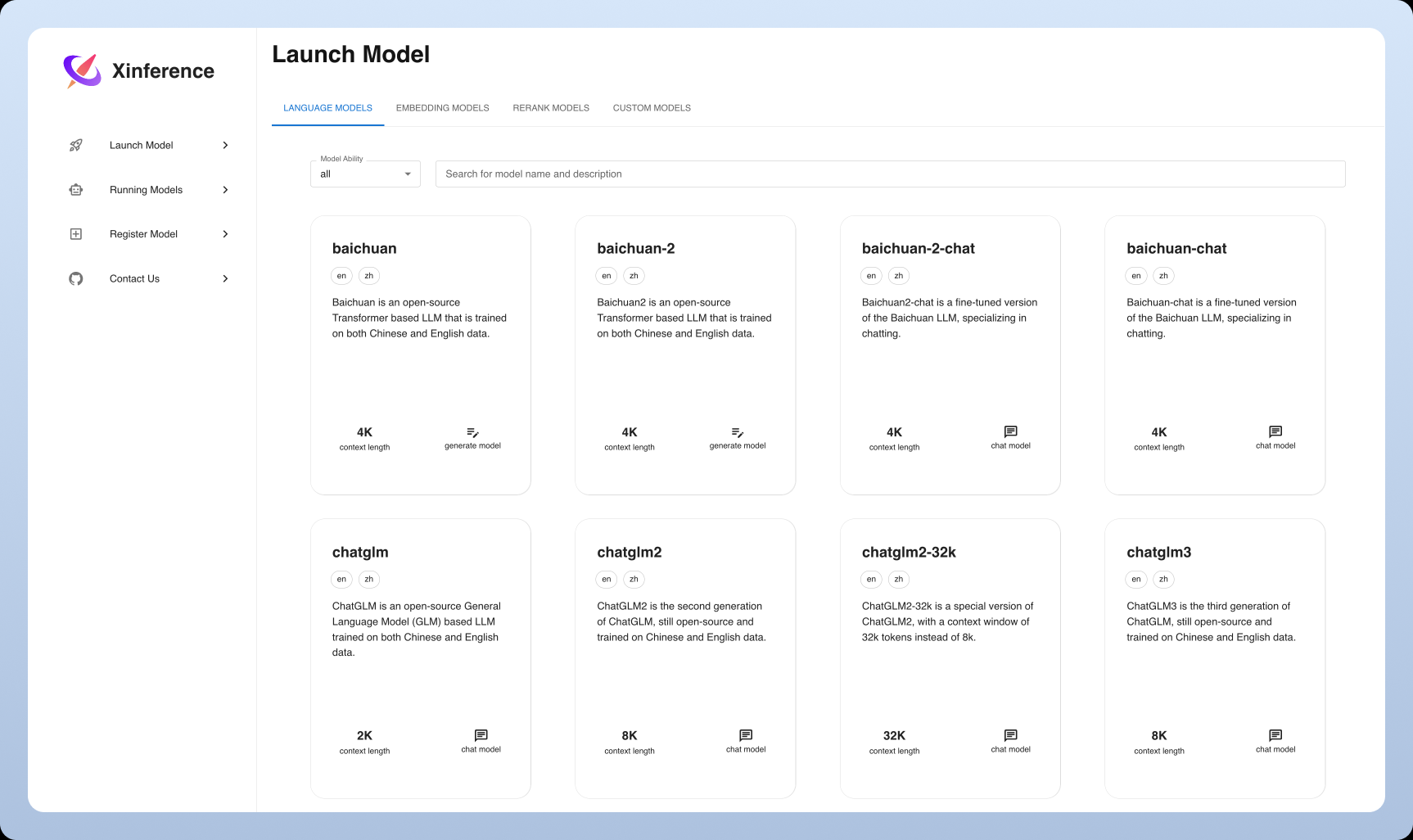

在您喜欢的技术堆栈上使用 Mistral Small 3

Mistral Small 3 现已在 la Plateforme 上以 mistral-small-latest 或 mistral-small-2501 的形式提供。请查阅 Mistral AI 的 文档,了解如何使用 Mistral AI 的模型进行文本生成。

Mistral AI 也很高兴与 Hugging Face、Ollama、Kaggle、Together AI 和 Fireworks AI 合作,从今天开始在他们的平台上提供该模型:

- Hugging Face (基础模型)

- Ollama

- Kaggle

- Together AI

- Fireworks AI

- 即将登陆 NVIDIA NIM、Amazon SageMaker、Groq、Databricks 和 Snowflake

未来的发展方向

对于开源社区来说,这真是令人兴奋的日子!Mistral Small 3 补充了像最近发布的 DeepSeek 这样的大型开源推理模型,并且可以作为强大的基础模型,使推理能力突显出来。

在众多其他事项中,期待未来几周内推出具有增强推理能力的中小型 Mistral 模型。如果您有兴趣加入 Mistral AI 的旅程 (Mistral AI 正在招聘),或者通过立即破解 Mistral Small 3 并使其变得更好来超越 Mistral AI!

Mistral 的开源模型

Mistral AI 正在重申 Mistral AI 对通用模型使用 Apache 2.0 协议的承诺,因为 Mistral AI 正在逐步放弃 MRL 许可的模型 。与 Mistral Small 3 一样,模型权重将可供下载并在本地部署,并且可以自由修改并在任何场合使用。这些模型还将通过 la Plateforme 上的无服务器 API、Mistral AI 的本地和 VPC 部署、定制和编排平台以及 Mistral AI 的推理和云合作伙伴提供。需要专门功能 (提高速度和上下文、特定领域知识、特定任务模型(如代码完成))的企业和开发人员可以依靠额外的商业模型来补充 Mistral AI 为社区贡献的内容。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...