LM Studio 综合介绍

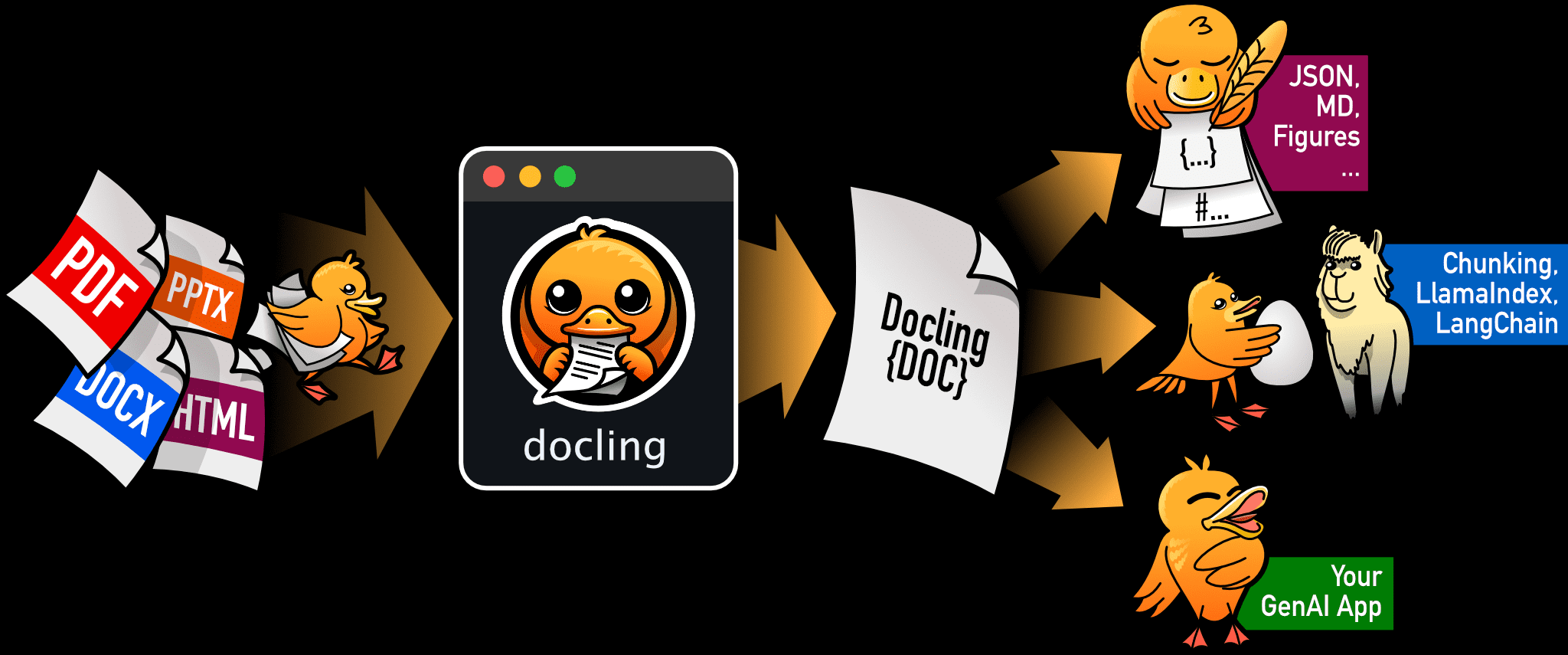

LM Studio 是一款专为在本地运行和管理大型语言模型(LLM)而设计的桌面应用。用户可以在不联网的情况下,直接在自己的电脑上运行如 Llama、Mistral、Phi 等模型。该应用支持多种操作系统,包括 macOS、Windows 和 Linux,并提供了丰富的功能,如本地文档聊天、模型下载和管理等。

它可以从Hugging Face搜索和下载LLM,一个内置的聊天用户界面,以及一个与OpenAI API兼容的本地服务器的运行时。LM Studio不是开源的,但它使用了流行的llama.cpp库。它支持与llama.cpp项目的ggml张量库兼容的各种模型,并需要16GB的RAM。LM Studio用户友好,适用于Windows和Mac,Linux版本正在开发中。

LM Studio 功能列表

- 本地运行 LLM:支持在本地电脑上运行 Llama、Mistral、Phi 等模型,确保数据隐私。

- 对话工具:通过应用内聊天界面或兼容OpenAI的本地服务器使用模型

- 文档聊天:用户可以与本地文档进行互动,获取所需信息。

- 模型下载与管理:通过应用内的发现页面,用户可以下载并管理各种模型文件。

- 兼容多种操作系统:支持 macOS(M1/M2/M3)、Windows 和 Linux 系统。

- 离线操作:无需联网即可使用,确保数据安全。

- OpenAI 兼容服务器:提供与 OpenAI 类似的本地服务器端点,方便集成。

LM Studio 使用帮助

安装步骤

- 下载应用:访问 LM Studio 官网,根据操作系统选择相应的安装包进行下载。

- 安装应用:

- macOS:下载完成后,打开安装包并按照提示进行安装。

- Windows:下载完成后,运行安装程序并按照提示完成安装。

- Linux:下载完成后,解压安装包并按照文档中的指示进行安装。

LM Studio 使用指南

- 启动应用:安装完成后,打开 LM Studio 应用。

- 下载模型:

- 进入应用内的“发现”页面,浏览并选择需要的模型。

- 点击下载按钮,等待模型下载完成。

- 运行模型:

- 在应用内选择已下载的模型,点击运行按钮。

- 用户可以通过内置的聊天界面与模型进行互动,或通过本地服务器端点进行集成。

- 文档聊天:

- 在应用内上传本地文档。

- 使用聊天界面与文档内容进行互动,获取所需信息。

- 管理模型:

- 通过应用内的管理功能,用户可以查看、更新或删除已下载的模型。

- 支持多种模型格式,如 GGUF、MLX 等。

常见问题

- LM Studio 是否收集数据? 不会。LM Studio 设计的初衷是保护用户隐私,所有数据都保存在本地。

- 最低硬件要求是什么? 需要支持 AVX2 指令集的处理器,macOS 需 M1/M2/M3 芯片,Windows 和 Linux 需 x64/ARM64 架构。

- 是否支持商业用途? 个人使用免费,商业使用请联系官方获取授权。

LM Studio 下载

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...