综合介绍

LM Speed 是一个专门为AI开发者设计的工具,同时提供在线服务网站 lmspeed.net。它的核心功能是测试和分析语言模型 API 的性能,帮助用户快速发现速度瓶颈并优化调用策略。这个工具支持 OpenAI API 等多种接口,提供实时数据监控和详细性能报告。无论是个人开发者还是团队,LM Speed 都能通过直观的数据图表和自动化测试,让用户轻松比较不同模型和供应商的表现。

功能列表

- 实时性能监控:显示多维度数据,如每秒处理 token 数(TPoS)。

- 全面性能评估:测量首 token 延迟、响应时间等核心指标。

- 数据可视化:生成丰富的图表,直观展示性能趋势。

- 自动化压力测试:连续五轮测试,确保数据可靠。

- 一键生成报告:自动创建专业测试报告,支持导出和分享。

- URL 参数快速测试:通过链接直接启动测试,无需手动输入。

- 历史数据保存:记录测试结果,支持趋势分析。

使用帮助

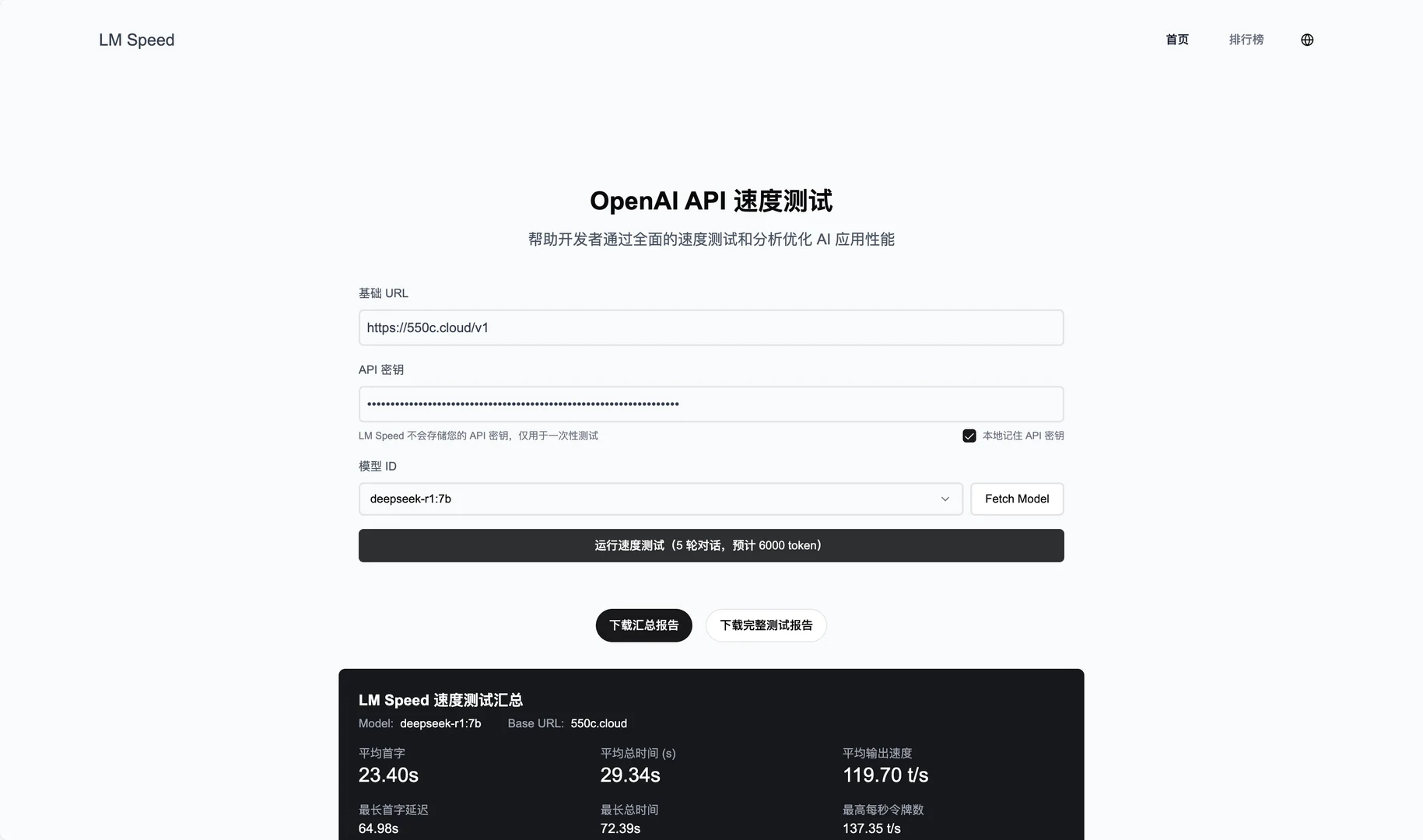

在线服务使用

- 访问网站

打开浏览器,进入 https://lmspeed.net。 - 输入测试参数

在页面表单中填写以下信息:baseUrl:API 服务地址,例如https://api.deepseek.com/v1。apiKey:你的 API 密钥。modelId:要测试的模型 ID,例如free:QwQ-32B。

- 启动测试

点击“开始测试”按钮,系统会自动运行五轮压力测试。测试过程中,你会看到实时数据更新,包括 TPoS 和响应时间。 - 查看结果

测试完成后,页面显示详细图表和指标,比如首 token 延迟和平均性能。你可以点击“生成报告”按钮,下载 PDF 或分享给团队。 - URL 参数快速测试

如果不想手动输入,可以直接用链接启动测试。例如:

https://lmspeed.net/?baseUrl=https://api.suanli.cn/v1&apiKey=sk-你的密钥&modelId=free:QwQ-32B

打开链接后,测试自动开始。注意:为安全起见,建议不要在 URL 中直接传 API 密钥。

本地部署安装流程

- 准备环境

确保电脑已安装 Git、Node.js(建议 v16 或以上)、Docker 和 Docker Compose。如果没有,请先下载安装。 - 克隆仓库

打开终端,输入以下命令下载代码:

git clone https://github.com/nexmoe/lm-speed.git

cd lm-speed

- Docker 部署

- 创建

docker-compose.yml文件,复制官方提供的代码:version: '3.8' services: app: image: nexmoe/lmspeed:latest ports: - "8650:3000" environment: - DATABASE_URL=postgresql://postgres:postgres@db:5432/nexmoe - NODE_ENV=production depends_on: - db restart: always db: image: postgres:16 restart: always environment: POSTGRES_USER: postgres POSTGRES_PASSWORD: postgres POSTGRES_DB: nexmoe volumes: - postgres_data:/var/lib/postgresql/data volumes: postgres_data: - 在终端运行:

docker-compose up -d - 部署成功后,访问

http://localhost:8650查看服务。

- 手动部署

- 安装依赖:

npm install - 复制并配置环境变量:

cp .env.example .env编辑

.env文件,填入数据库地址和 API 配置。 - 启动服务:

npm run dev - 访问

http://localhost:3000。

特色功能操作

- 实时监控

在线测试时,页面会动态显示 TPoS 和响应时间变化。你可以用鼠标悬停在图表上,查看具体数值。 - 自动化测试

点击“开始测试”后,系统自动进行五轮测试。每轮结果都会记录,最后生成平均值和波动范围,帮助你判断 API 稳定性。 - 报告导出

测试结束后,点击“导出报告”,选择 PDF 格式。报告包含测试环境、性能指标和图表,适合团队分享或存档。 - 历史数据分析

在线服务会保存你的测试记录。登录后,进入“历史记录”页面,可以查看之前的测试结果和性能趋势。

注意事项

- 确保 API 密钥有效,否则测试会失败。

- 本地部署时,检查防火墙是否开放端口(默认 3000 或 8650)。

- 如果图表加载缓慢,可能是网络问题,建议刷新页面重试。

通过以上步骤,你可以用 LM Speed 在线或本地测试语言模型 API 的性能。操作简单,结果清晰,非常实用。

应用场景

- 开发者选择 API 服务

开发者用 LM Speed 测试 DeepSeek 和 Silicon Flow 等 API 的速度和稳定性,挑选最适合项目的供应商。 - 团队优化模型调用

AI 团队用它监控 API 在高负载下的表现,调整调用策略,提升应用效率。 - 研究人员分析性能波动

- 研究人员通过五轮测试和历史数据,研究模型在不同条件下的性能变化,撰写学术报告。

QA

- LM Speed 支持哪些 API?

它主要支持 OpenAI 格式的 API,比如 DeepSeek、Suanli 等。只要 API 兼容 OpenAI SDK,就能测试。 - 测试结果不稳定怎么办?

检查网络连接是否稳定,或增加测试轮数(本地部署可修改代码)。结果波动大可能是 API 供应商的问题。 - 需要付费吗?

在线服务目前免费,但功能可能有限。本地部署完全免费,代码开源。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...