综合介绍

LLM API Engine 是一个开源项目,旨在帮助开发者快速构建和部署AI驱动的API。该项目利用大语言模型(LLM)和智能网页抓取技术,允许用户通过自然语言描述来创建自定义API。其主要特点包括自动生成数据结构、实时数据更新、结构化数据输出以及灵活的部署选项。LLM API Engine 采用模块化架构,支持在多种平台上部署API端点,如Cloudflare Workers、Vercel Edge Functions和AWS Lambda。

功能列表

- 文本到API转换:通过简单的自然语言描述生成API。

- 自动数据结构生成:使用OpenAI技术自动生成数据结构。

- 智能网页抓取:利用 Firecrawl 技术进行网页数据抓取。

- 实时数据更新:支持定时抓取和实时数据更新。

- 即时API部署:快速部署API端点。

- 结构化数据输出:通过JSON Schema验证输出数据。

- 缓存和存储架构:使用Redis进行缓存和存储。

使用帮助

安装流程

- 克隆仓库:

git clone https://github.com/developersdigest/llm-api-engine.git

cd llm-api-engine

- 安装依赖:

npm install

- 创建环境变量文件: 在项目根目录下创建

.env文件,并添加以下变量:

OPENAI_API_KEY=your_openai_key

FIRECRAWL_API_KEY=your_firecrawl_key

UPSTASH_REDIS_REST_URL=your_redis_url

UPSTASH_REDIS_REST_TOKEN=your_redis_token

NEXT_PUBLIC_API_ROUTE=http://localhost:3000

- 运行开发服务器:

npm run dev

打开浏览器访问http://localhost:3000查看应用。

功能操作流程

- 创建API端点:

- 访问应用首页,点击“创建新API”按钮。

- 输入API名称和描述,选择数据源类型(如网页抓取)。

- 使用自然语言描述所需的数据结构和抓取规则。

- 点击“生成API”按钮,系统将自动生成API端点和数据结构。

- 配置和管理API:

- 在“API管理”页面查看已创建的API列表。

- 点击某个API进入详情页面,可以编辑API配置、查看抓取日志和测试API端点。

- 使用Redis存储API配置,支持随时修改和更新。

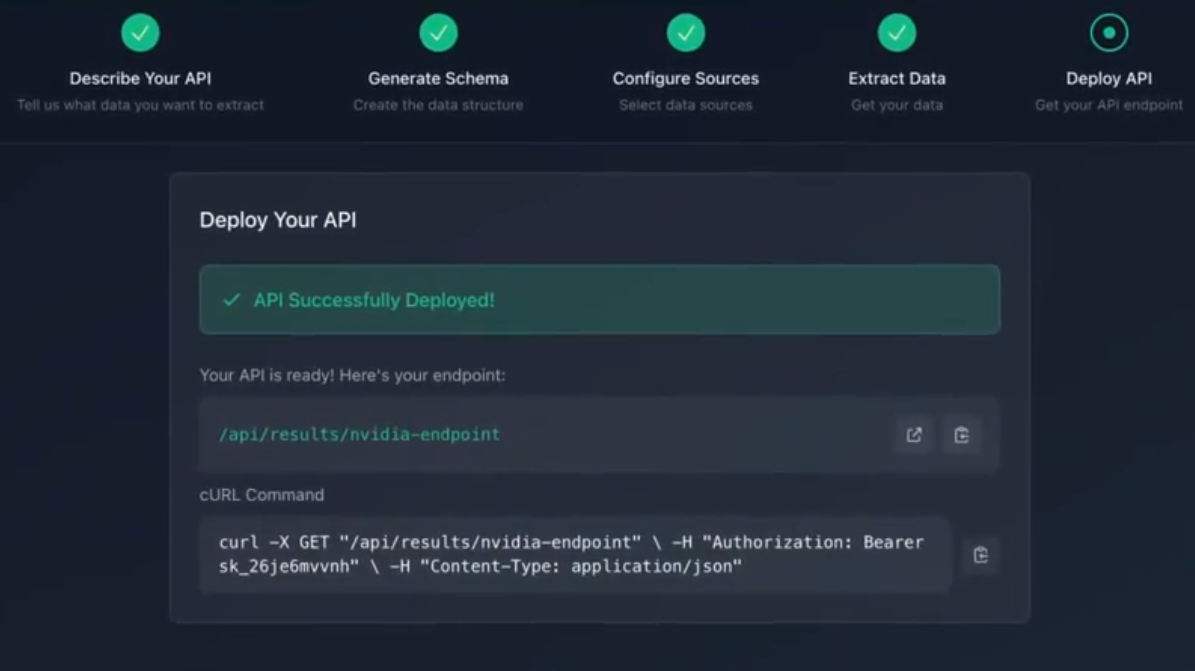

- 部署API端点:

- 选择部署平台(如Vercel、AWS Lambda等)。

- 根据平台要求配置部署参数,点击“部署”按钮。

- 部署完成后,可以在“API管理”页面查看API端点的URL和状态。

- 使用API端点:

- 在应用中调用API端点,获取结构化数据。

- 支持通过HTTP请求访问API端点,返回JSON格式的数据。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...