综合介绍

llama.cpp是一个用纯C/C++实现的库,旨在简化大语言模型(LLM)的推理过程。它支持多种硬件平台,包括Apple Silicon、NVIDIA GPU和AMD GPU,并提供多种量化选项以提高推理速度和减少内存使用。该项目的目标是通过最少的设置实现高性能的LLM推理,适用于本地和云端环境。

功能列表

- 支持多种硬件平台,包括Apple Silicon、NVIDIA GPU和AMD GPU

- 提供1.5位到8位的整数量化选项

- 支持多种LLM模型,如LLaMA、Mistral、Falcon等

- 提供REST API接口,便于集成

- 支持CPU+GPU混合推理

- 提供多种编程语言绑定,如Python、Go、Node.js等

- 提供多种工具和基础设施支持,如模型转换工具、负载均衡器等

使用帮助

安装流程

- 克隆仓库:

git clone https://github.com/ggerganov/llama.cpp.git

cd llama.cpp

- 编译项目:

make

使用指南

模型转换

llama.cpp提供了多种工具来转换和量化模型,以便在不同硬件上高效运行。例如,可以使用以下命令将Hugging Face模型转换为GGML格式:

python3 convert_hf_to_gguf.py --model <model_name>

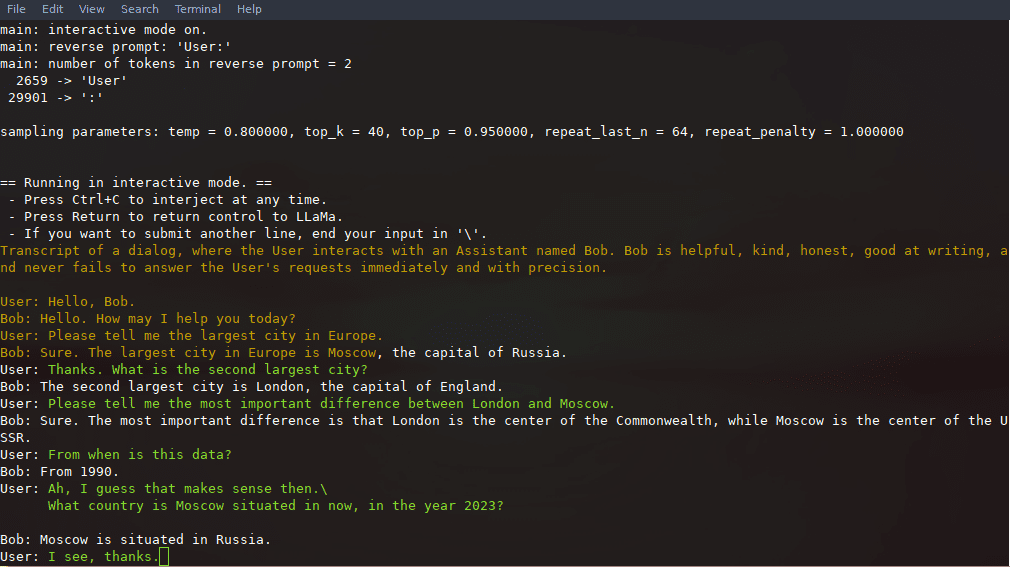

推理示例

编译完成后,可以使用以下命令进行推理:

./llama-cli -m models/llama-13b-v2/ggml-model-q4_0.gguf -p "你好,世界!"

REST API使用

llama.cpp还提供了一个兼容OpenAI API的HTTP服务器,可以用于本地模型的推理服务。启动服务器:

./llama-server -m models/llama-13b-v2/ggml-model-q4_0.gguf --port 8080

然后可以通过浏览器访问基本的Web UI或使用API进行推理请求:

curl -X POST http://localhost:8080/v1/chat -d '{"prompt": "你好,世界!"}'

详细功能操作流程

- 模型加载:首先需要将模型文件下载并放置在指定目录,然后使用命令行工具加载模型。

- 推理配置:可以通过配置文件或命令行参数设置推理的相关参数,如上下文长度、批处理大小等。

- API集成:通过REST API接口,可以将llama.cpp集成到现有的应用程序中,实现自动化推理服务。

- 性能优化:利用量化选项和硬件加速功能,可以显著提高推理速度和效率。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...