综合介绍

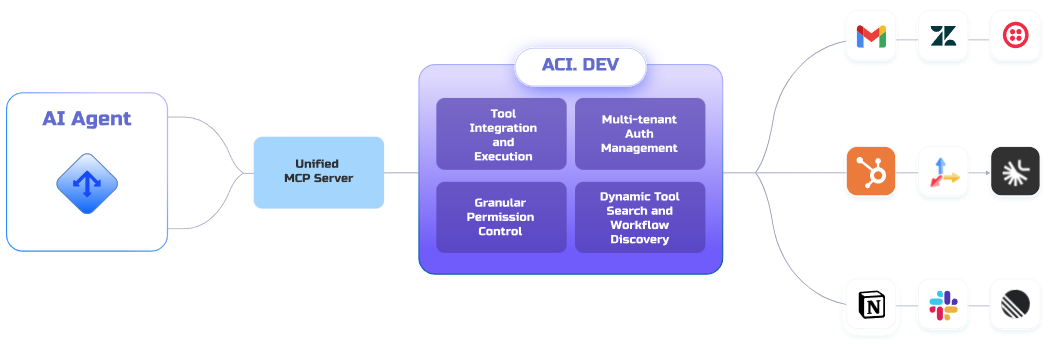

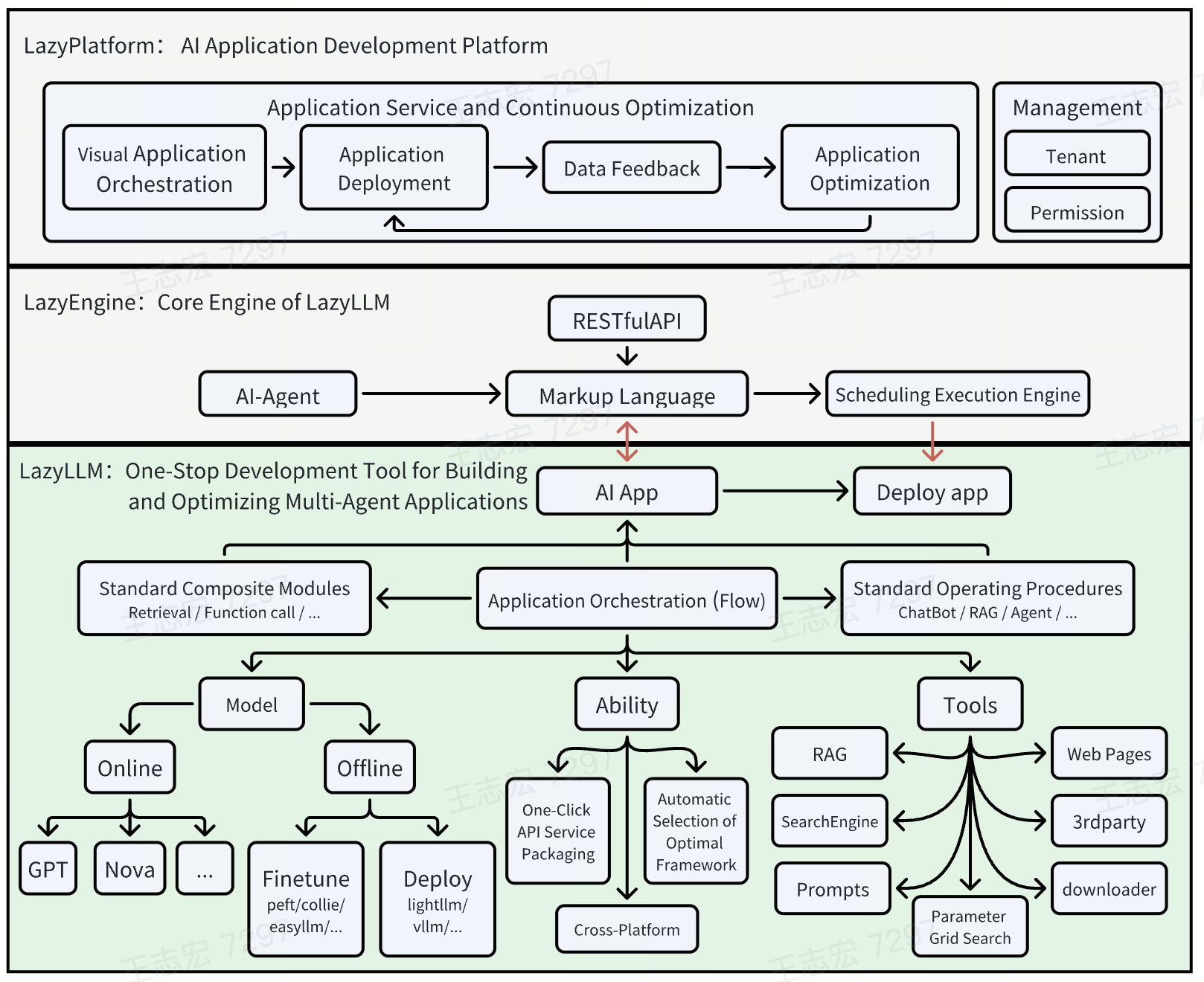

LazyLLM 是由 LazyAGI 团队开发的一款开源工具,专注于简化多智能体大模型应用的开发流程。它通过一键部署和轻量级网关机制,帮助开发者快速搭建复杂的 AI 应用,节省繁琐的工程配置时间。无论你是初学者还是资深开发者,LazyLLM 都能提供支持:新手可利用预置模块轻松上手,专家则能通过灵活的定制功能实现高级开发。工具强调高效、实用,集成优选组件,确保以最低成本构建生产环境可用的应用。目前已在 GitHub 上获得超过 1100 个星标,社区活跃,持续更新中。

功能列表

- 一键部署复杂应用:支持从原型验证到生产发布的完整流程,自动配置子模块服务。

- 跨平台兼容性:无需改动代码即可适配裸金属服务器、开发机、Slurm 集群和公有云。

- 数据流管理(Flow):提供 Pipeline、Parallel 等预定义流程,轻松组织复杂应用逻辑。

- 模块化组件:支持自定义和扩展,集成用户算法或第三方工具。

- 轻量级网关机制:简化服务启动和 URL 配置,提升开发效率。

- 支持多智能体开发:快速构建包含多个 AI 代理的应用,适配大模型任务。

使用帮助

安装流程

LazyLLM 是一个基于 Python 的开源项目,安装过程简单明了。以下是详细步骤:

环境准备

- 检查系统要求:确保你的设备安装了 Python 3.8 或以上版本。

- 安装 Git:若未安装 Git,可通过命令行工具(如

apt-get install git或brew install git)安装。 - 创建虚拟环境(可选但推荐):

python -m venv lazyllm_env source lazyllm_env/bin/activate # Linux/Mac lazyllm_env\Scripts\activate # Windows

下载与安装

- 克隆 GitHub 仓库:

git clone https://github.com/LazyAGI/LazyLLM.git cd LazyLLM - 安装依赖:

- 运行以下命令安装所需库:

pip install -r requirements.txt - 若遇到依赖冲突,可尝试升级 pip:

pip install --upgrade pip

- 运行以下命令安装所需库:

- 验证安装:

- 运行示例代码确认安装成功:

python -m lazyllm --version - 若返回版本号(如 v0.5),说明安装完成。

- 运行示例代码确认安装成功:

可选:Docker 部署

- LazyLLM 支持 Docker 一键打包镜像:

- 安装 Docker(参考官网:https://docs.docker.com/get-docker/)。

- 在项目根目录运行:

docker build -t lazyllm:latest . docker run -it lazyllm:latest

如何使用

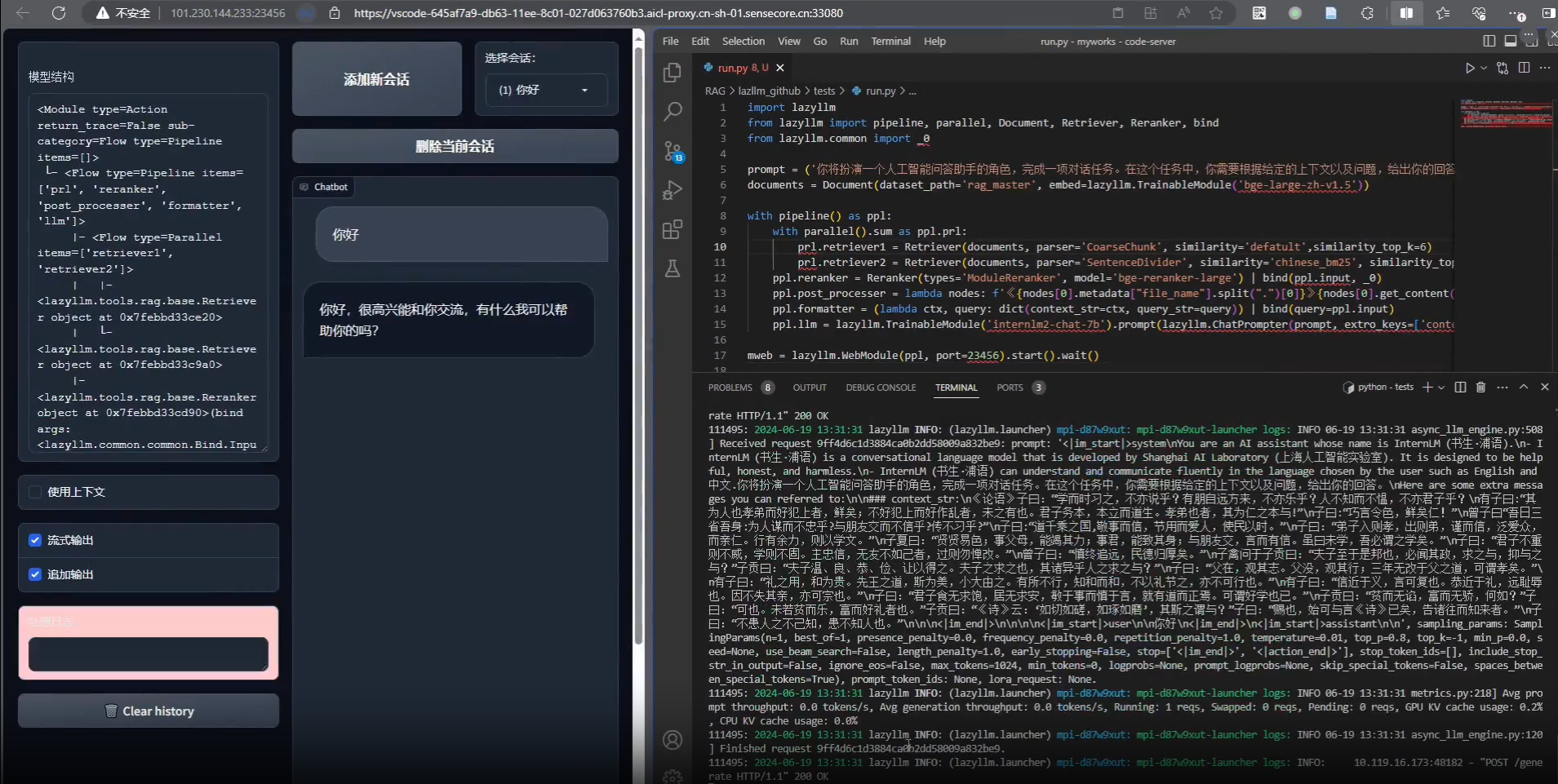

LazyLLM 的核心在于通过模块化和数据流管理快速构建 AI 应用。以下是主要功能的详细操作指南:

功能 1:一键部署复杂应用

- 操作步骤:

- 准备应用配置文件:在项目目录下创建

config.yaml,定义模块和服务。例如:modules: - name: llm type: language_model url: http://localhost:8000 - name: embedding type: embedding_service url: http://localhost:8001 - 启动服务:

python -m lazyllm deploy - 检查状态:访问日志输出,确认所有模块运行正常。

- 准备应用配置文件:在项目目录下创建

- 特色说明:此功能通过轻量级网关自动连接子模块,无需手动配置 URL,适合快速原型搭建。

功能 2:跨平台兼容性

- 操作步骤:

- 指定平台:在命令行中添加参数,例如:

python -m lazyllm deploy --platform slurm - 切换环境:无需修改代码,直接更换

--platform参数(如cloud或bare_metal)。

- 指定平台:在命令行中添加参数,例如:

- 应用场景:开发者可在本地测试后无缝迁移到云端,减少适配工作量。

功能 3:数据流管理(Flow)

- 操作步骤:

- 定义数据流:在 Python 脚本中调用预定义 Flow。例如构建一个 Pipeline:

from lazyllm import pipeline flow = pipeline( step1=lambda x: x.upper(), step2=lambda x: f"Result: {x}" ) print(flow("hello")) # 输出 "Result: HELLO" - 运行复杂流程:结合 Parallel 或 Diverter 处理多任务:

from lazyllm import parallel par = parallel( task1=lambda x: x * 2, task2=lambda x: x + 3 ) print(par(5)) # 输出 [10, 8]

- 定义数据流:在 Python 脚本中调用预定义 Flow。例如构建一个 Pipeline:

- 特色说明:Flow 提供标准化接口,减少数据转换的重复工作,支持模块间的协作开发。

功能 4:模块化组件定制

- 操作步骤:

- 注册自定义函数:

from lazyllm import register @register def my_function(input_text): return f"Processed: {input_text}" - 集成到应用:在 Flow 或部署配置中调用

my_function。

- 注册自定义函数:

- 高级用法:支持 Bash 命令注册,用于混合脚本开发。

使用技巧

- 调试:运行时添加

--verbose参数查看详细日志:python -m lazyllm deploy --verbose - 社区支持:遇到问题可在 GitHub Issues 提交反馈,团队会及时响应。

- 更新:定期拉取最新代码:

git pull origin main

通过以上步骤,你可以快速上手 LazyLLM,构建从简单原型到生产级别的大模型应用。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...