综合介绍

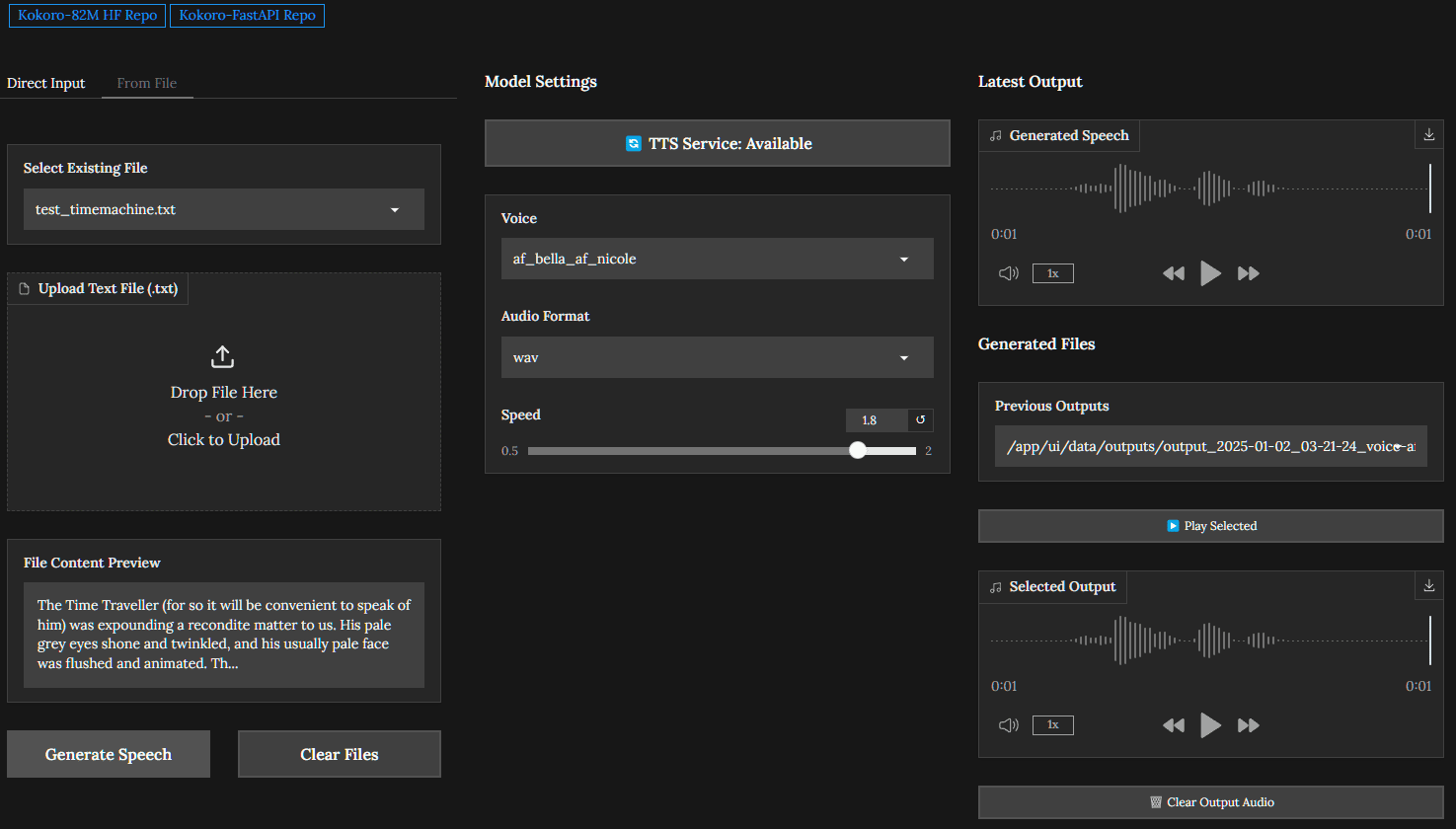

Kokoro-FastAPI是一个基于Docker的FastAPI封装,旨在为Kokoro-82M文本转语音模型提供支持。该项目支持NVIDIA GPU加速,并提供了队列处理和自动拼接功能,使得生成长文本的语音输出更加高效和连贯。项目由GitHub用户remsky开发,并在GitHub上公开。用户可以通过API接口进行文本转语音的请求,并获得高质量的语音输出,适用于各种需要语音生成的应用场景。

功能列表

- 提供Kokoro-82M文本转语音模型的API封装

- 支持NVIDIA GPU加速,提升语音生成效率

- 队列处理功能,支持并发请求

- 自动拼接功能,生成连贯的长文本语音输出

- Docker化部署,简化安装和配置

- 提供示例代码和使用文档,便于开发者上手

使用帮助

安装流程

- 确保已安装Docker和NVIDIA Docker支持。

- 克隆Kokoro-FastAPI项目仓库:

git clone https://github.com/remsky/Kokoro-FastAPI.git

- 进入项目目录并构建Docker镜像:

cd Kokoro-FastAPI docker build -t kokoro-fastapi . - 启动Docker容器:

docker run --gpus all -d -p 8000:8000 kokoro-fastapi

使用API接口

- 访问API文档:

打开浏览器,访问http://localhost:8000/docs 查看API文档和测试接口。 - 发送文本转语音请求:

使用POST请求向/generate接口发送文本数据,例如:curl -X POST "http://localhost:8000/generate" -H "accept: application/json" -H "Content-Type: application/json" -d '{"text": "你好,世界!"}' - 获取语音输出:

请求成功后,将返回生成的语音文件URL,用户可以通过下载或播放该文件。

示例代码

项目提供了示例代码,帮助开发者快速上手:

- test_openai_tts.py 示例展示了如何使用API进行文本转语音请求。

详细操作流程

- 确保系统满足硬件和软件要求,特别是NVIDIA GPU和CUDA驱动。

- 按照安装流程安装并启动Kokoro-FastAPI服务。

- 参考API文档和示例代码,发送文本转语音请求。

- 获取语音输出文件并进行后续处理和使用。

通过以上步骤,用户可以轻松部署和使用Kokoro-FastAPI,实现高效的文本转语音功能,为各种应用场景提供优质的语音生成服务。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...