위즈덤 스펙트럼은 8월 27일부터 GLM-4-Flash API를 대중에게 무료로 공개했습니다. 3일간 영어-중국어 번역 테스트를 진행한 GLM-4-Flash는 실리콘 플로우에서 제공하는 GLM-4-9b, 그리고 OpenRouter: 여러 LLM 통합을 위한 통합 인터페이스, 무료 대형 모델 인터페이스 RIP에서 제공하는 많은 무료 모델 API보다 효과적이거나 빠르지는 않습니다.

GLM-4-9b는 이전에 무료 API를 공개했습니다. 실리콘 플로우(Silicon Flow): 인류를 위한 AGI 가속화, 무료 대형 모델 인터페이스 통합 GLM-4-Flash와 GLM-4-9b는 모델 크기, 파라미터 수, 애플리케이션 시나리오 등에서 약간의 차이가 있습니다. 또한 둘 다 무료 API이며, 무료 서비스를 제공하는데 어떻게 선택해야 하나요?

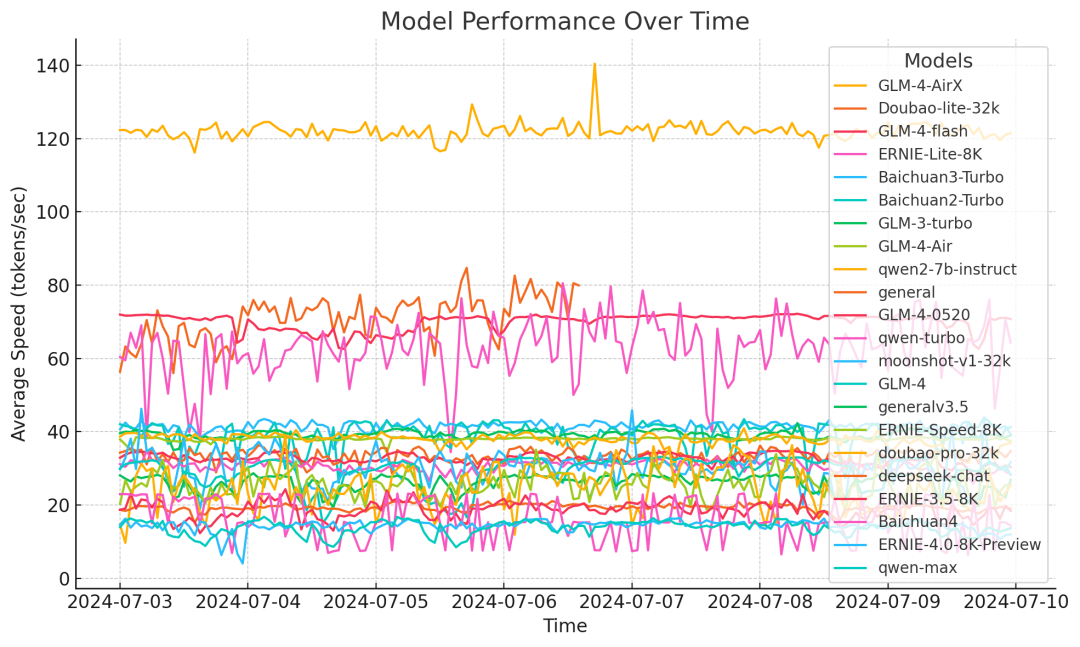

GLM-4 플래시 모델은 '속도'와 '성능' 모두에서 큰 이점을 가지고 있다고 할 수 있습니다.

모델의 추론 속도를 개선하기 위해 GLM-4-Flash는 적응형 가중치 정량화, 다중 병렬 처리 기술, 배치 처리 전략 및 추측 샘플링과 같은 여러 최적화 조치를 채택합니다. 타사 모델 속도 테스트 결과에 따르면 GLM-4-Flash의 추론 속도는 1주일 테스트 주기에서 72.14 토큰/s 정도로 안정적이며, 이는 다른 모델보다 훨씬 우수합니다.

성능 측면에서 GLM-4-Flash는 모델의 사전 학습 단계에서 최대 10T의 고품질 다국어 데이터를 사용하여 모델이 다자간 대화, 웹 검색, 도구 호출, 긴 텍스트(최대 128K의 문맥 길이 지원)에 대해 추론할 수 있도록 합니다.4K 길이 출력) 등 중국어, 영어, 일본어, 한국어, 독일어 등 26개 언어를 지원합니다.

완전 무료 개방형 GLM-4-Flash API를 기반으로 사용자가 특정 애플리케이션 시나리오에 모델을 더 잘 적용할 수 있도록 지원하기 위해 다양한 사용자의 요구를 충족하기 위해 모델 미세 조정 기능을 동시에 제공합니다. 사용을 환영합니다!

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...