AI의 급속한 발전으로 디지털 휴먼(디지털 휴먼)이 성숙해지면서 저렴한 비용으로 빠르게 생성할 수 있게 되었습니다. 광범위한 상업적 응용 시나리오로 인해 주목을 받고 있습니다. 가상현실(VR), 증강현실(AR), 영화 및 TV 제작, 게임 개발, 브랜드 홍보 등 디지털 휴먼은 중요한 역할을 담당합니다.

크게 3D 모델링(모션 캡처 포함) 디지털 피플, 정적 2D 이미지 디지털 피플(실제 사람 포함), 실제 얼굴 교체형 디지털 피플이 있습니다.

이 논문은 정적 2D 이미지 디지털 인간에 속하는 개인 이미지 복제 이미지 클래스 디지털 인간에 초점을 맞추고 있으며 실제 이미지, 음성 복제, 입 동기화의 세 가지 기본 기능 포인트를 포함합니다.

참고 1 : 일부 프로젝트에는 음성 생성 (복제) 부분이 포함되어 있지 않습니다. 이것은 요점이 아니며 별도로 배포 할 수 있으며 시장에는 우수한 제품이 많이 있습니다.AI 음성 복제 프로젝트.

참고 2: 현재 2D 정적 인물의 품질은 주로 입의 동기화 및 '동영상 움직임'의 자연스러움에 따라 달라집니다. 이를 별도로 최적화할 수 있습니다.립싱크노드.

참고 3: 얼굴 바꾸기 + 음성 복제는 디지털 인물을 빠르게 생성하는 방법으로, 공개 연설자의 이미지와 목소리를 그대로 유지하는 데 적합하며 다음 프로그램에는 포함되지 않습니다. 고급 비디오 얼굴 교체 기술은 대중화될 경우 위험할 수 있으므로 제공되지 않습니다.

AIGCPanel: 디지털 맨 통합 시스템의 오픈 소스 클론, 무료 디지털 맨 클라이언트를 원클릭으로 배포할 수 있습니다.

AigcPanel은 모든 사용자를 위한 원스톱 인공지능 디지털 휴먼 제작 시스템으로, 전자+뷰3+타입스크립트 기술 스택으로 개발되어 윈도우 시스템에서 원클릭 배포를 지원합니다. 이 시스템은 사용자 친화적으로 설계되어 기술 기반이 약한 사용자도 쉽게 익힐 수 있습니다. 주요 기능으로는 비디오 디지털 휴먼 합성, 음성 합성, 음성 복제 등이 있으며 완벽한 로컬 모델 관리 기능을 제공합니다. 이 시스템은 다국어 인터페이스(중국어 간체 및 영어 포함)를 지원하며 MuseTalk를 통합합니다, cosyvoice 및 기타 여러 성숙한 모델을 위한 원클릭 시작 패키지를 제공합니다. 특히 주목할 만한 점은 비디오 합성을 위한 비디오 프레임 및 음성 전사 매칭 기술을 지원하고 음성 합성을 위한 풍부한 사운드 파라미터 설정 옵션을 제공한다는 점입니다. 오픈 소스 프로젝트인 AigcPanel은 AGPL-3.0 프로토콜을 기반으로 출시되었으며, 규정 준수를 강조하고 불법 및 불법 비즈니스에서의 사용을 명시적으로 금지하고 있습니다.

DUIX: 실시간 상호 작용을 위한 지능형 디지털 인력, 멀티 플랫폼 원클릭 배포 지원

DUIX(대화 사용자 인터페이스 시스템)는 실리콘 인텔리전스에서 개발한 AI 기반 디지털 휴먼 인터랙션 플랫폼입니다. 오픈 소스 디지털 휴먼 인터랙션 기능을 통해 개발자는 대규모 모델, 자동 음성 인식(ASR) 및 텍스트 음성 변환(TTS) 기능을 쉽게 통합하여 디지털 휴먼과 실시간으로 상호작용할 수 있으며, DUIX는 안드로이드, iOS 등 여러 플랫폼에서 원클릭 배포를 지원하므로 모든 개발자가 다양한 산업에 적용할 수 있는 지능적이고 개인화된 디지털 휴먼 에이전트를 쉽게 만들 수 있습니다. 낮은 구축 비용, 낮은 네트워크 의존성, 다양한 기능을 갖춘 이 플랫폼은 비디오, 미디어, 고객 서비스, 금융, 라디오, TV 등 여러 산업의 요구를 충족할 수 있습니다.

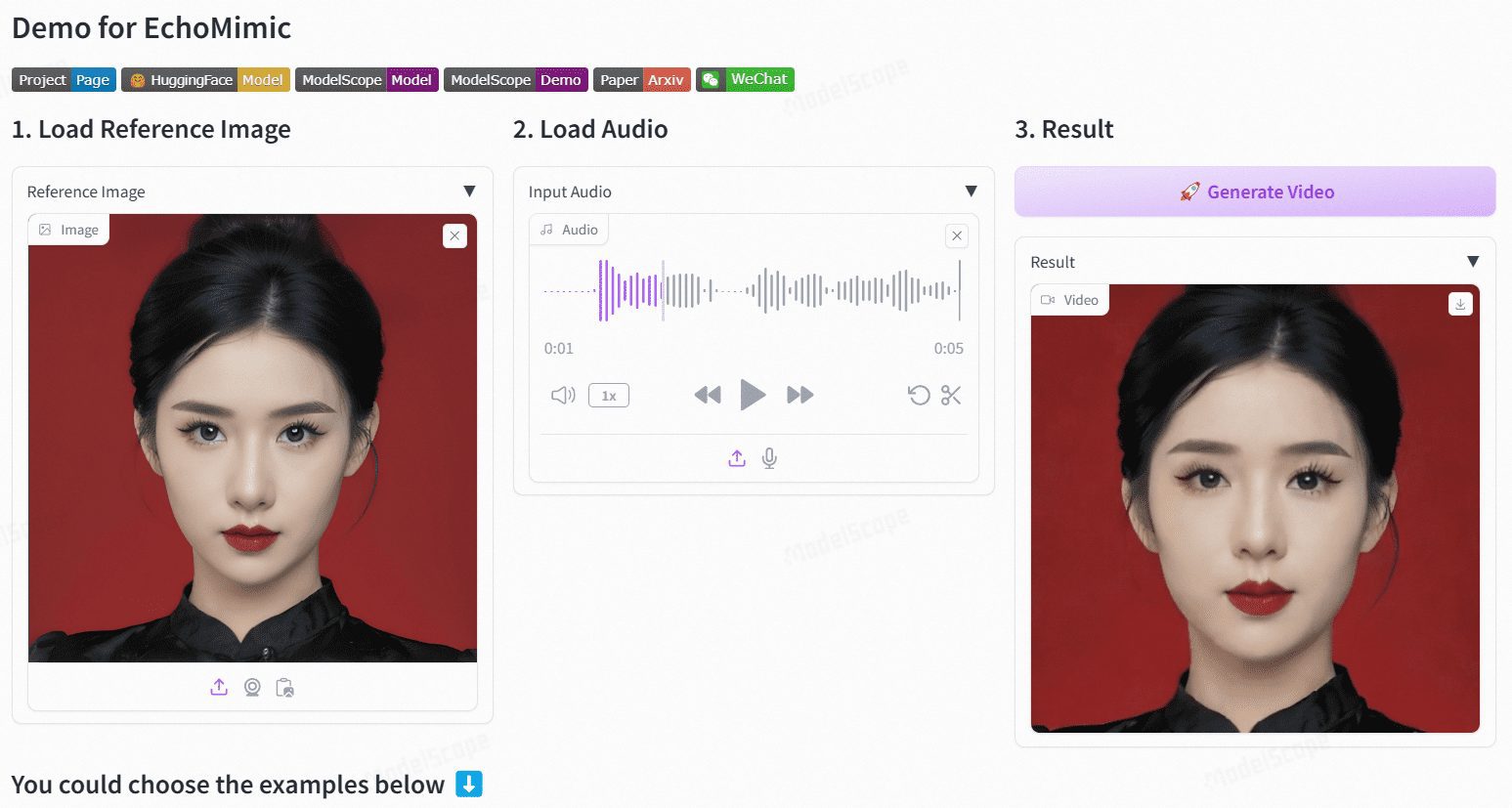

에코미믹: 오디오 기반의 사실적인 인물 애니메이션

에코미믹은 오디오로 사실적인 인물 애니메이션을 생성하는 것을 목표로 하는 오픈 소스 프로젝트입니다. 앤트 그룹의 터미널 기술 부서에서 개발한 이 프로젝트는 편집 가능한 마커 포인트 조건을 활용하여 오디오와 얼굴 마커 포인트를 결합한 역동적인 인물 동영상을 생성하며, 여러 공개 및 독점 데이터 세트에서 종합적으로 비교하여 정량적, 정성적 평가 모두에서 우수한 성능을 입증했습니다.

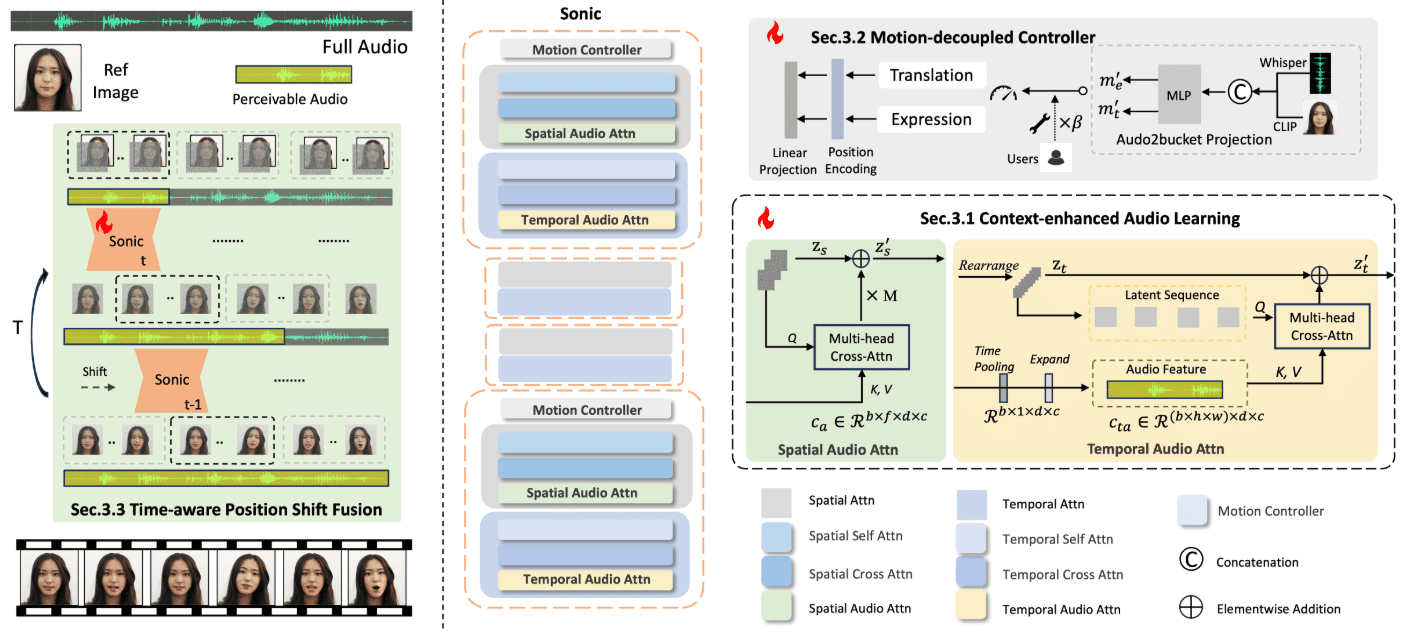

Sonic: 디지털 휴먼을 위한 새로운 오픈 소스 솔루션으로, 생생한 디지털 데모 동영상을 위한 오디오 기반 표정 생성을 지원합니다.

Sonic Sonic은 글로벌 오디오 인식에 초점을 맞춘 혁신적인 플랫폼으로, 오디오를 기반으로 생생한 인물 애니메이션을 생성하도록 설계되었습니다. 텐센트와 저장대학교 연구팀이 개발한 이 플랫폼은 오디오 정보를 사용하여 얼굴 표정과 머리 움직임을 제어하여 자연스럽고 부드러운 애니메이션 동영상을 생성하며, Sonic의 핵심 기술에는 컨텍스트 강화 오디오 학습, 모션 분리 컨트롤러, 시간 인식 위치 이동 융합 모듈이 포함되어 있습니다. 이러한 기술을 통해 Sonic은 다양한 스타일의 이미지와 다양한 유형의 오디오 입력으로 안정적이고 사실적인 롱폼 비디오를 생성할 수 있습니다.

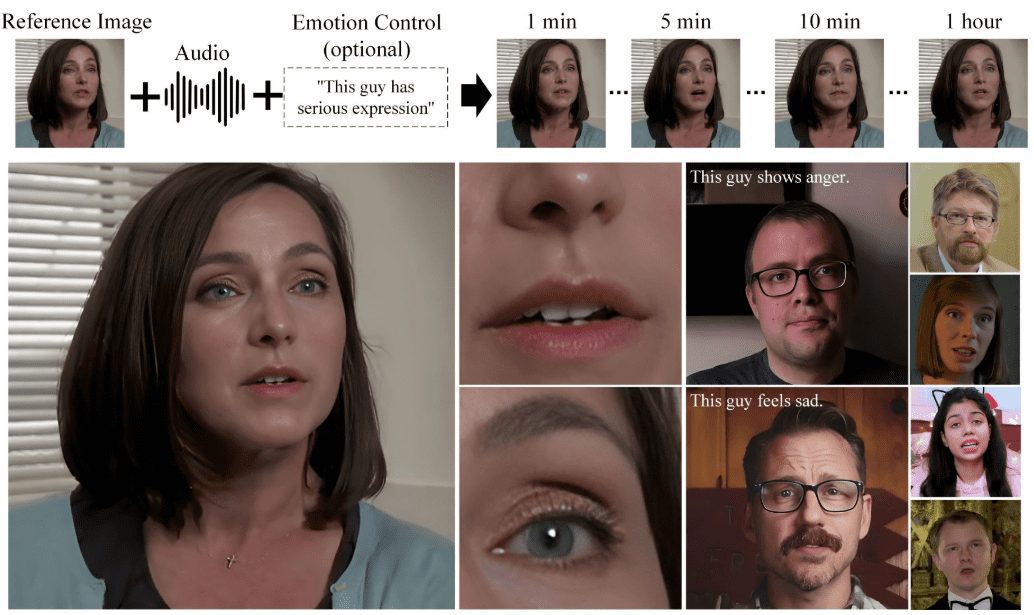

Hallo2: 오디오 기반 립싱크/표정 동기화 인물 비디오 생성(Windows 원클릭 설치 시)

Hallo2는 푸단대학교와 바이두가 오디오 기반 생성을 통해 고해상도 인물 애니메이션을 생성하기 위해 공동 개발한 오픈 소스 프로젝트입니다. 이 프로젝트는 고급 GAN(생성적 적대 신경망)과 시간적 정렬 기술을 활용하여 4K 해상도와 최대 1시간 분량의 동영상을 생성하며, 생성된 콘텐츠의 다양성과 제어 가능성을 높이기 위해 텍스트 프롬프트도 지원합니다.

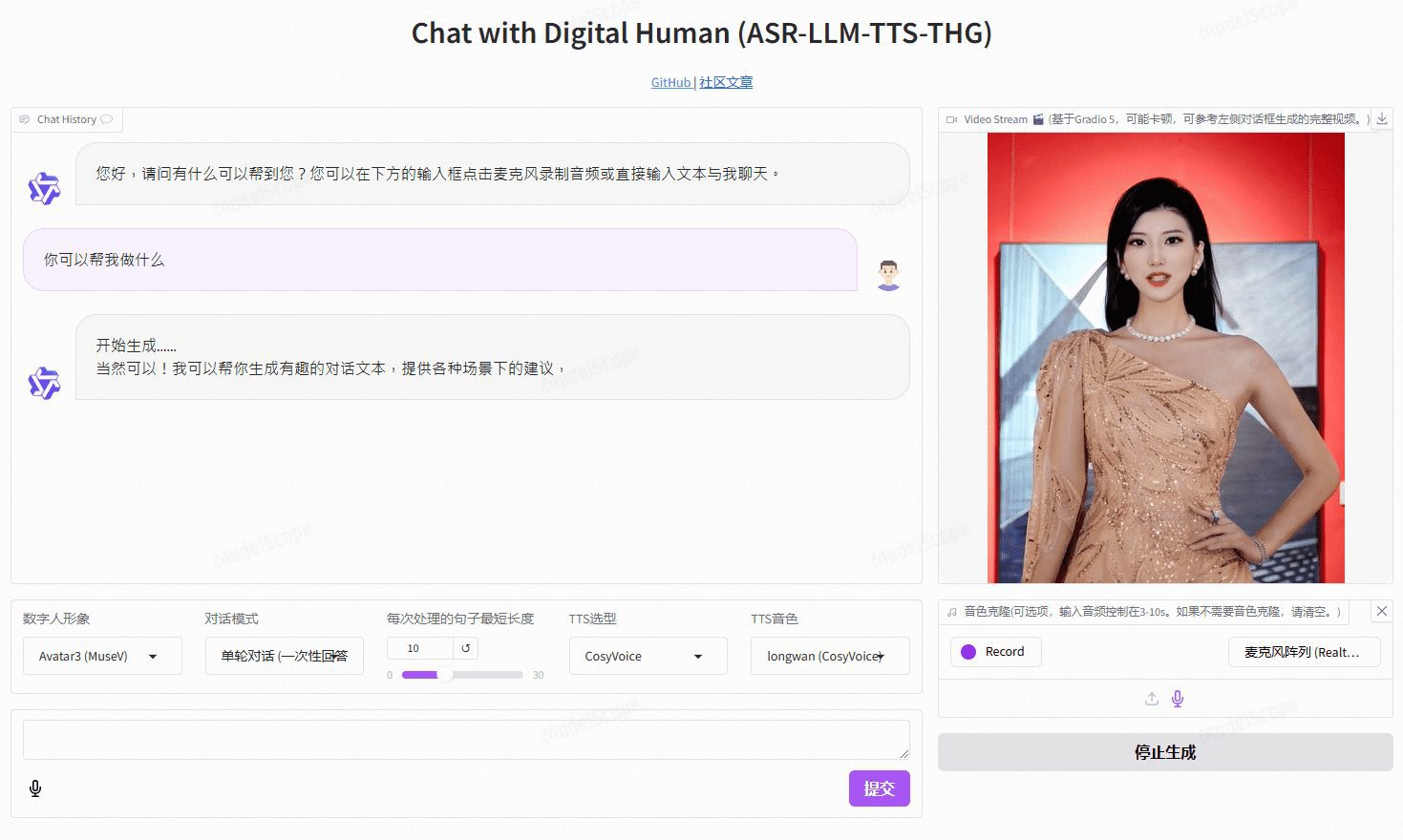

비디오챗: 사용자 지정 이미지 및 톤 복제가 가능한 실시간 음성 대화형 디지털 사람, 엔드투엔드 음성 솔루션 및 캐스케이딩 솔루션 지원

비디오챗은 오픈소스 기술을 기반으로 하는 실시간 음성 상호작용 디지털 휴먼 프로젝트로, 엔드투엔드 음성 체계(GLM-4-Voice - THG)와 캐스케이드 체계(ASR-LLM-TTS-THG)를 지원합니다. 이 프로젝트를 통해 사용자는 디지털 휴먼의 이미지와 음색을 커스터마이징할 수 있으며 음색 복제 및 립싱크, 비디오 스트리밍 출력, 3초의 낮은 첫 패킷 지연 시간을 지원합니다. 사용자는 온라인 데모를 통해 기능을 체험하거나 자세한 기술 문서를 통해 로컬에 배포하여 사용할 수 있습니다.

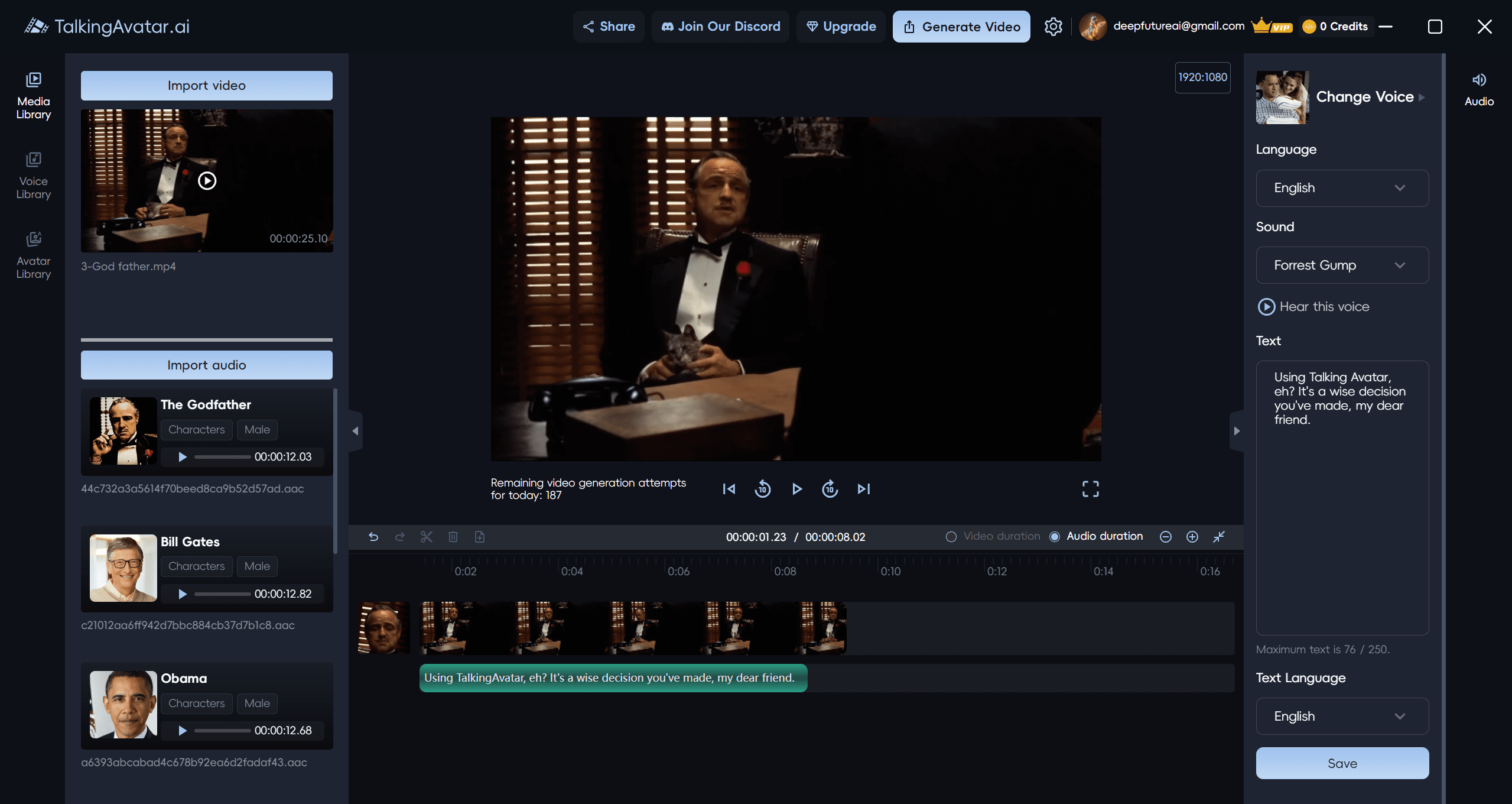

말하는 아바타: 네이티브 산술 Windows 클라이언트를 기반으로 AI 아바타를 만들고 편집하는 AI 아바타 비디오 플랫폼

말하는 아바타 는 완벽한 AI 디지털 페르소나 솔루션을 제공하는 선도적인 AI 아바타 플랫폼입니다. 사용자에게 동영상 콘텐츠를 제작, 편집 및 개인화할 수 있는 혁신적인 방법을 제공합니다. 고급 AI 기술을 통해 사용자는 손쉽게 동영상을 다시 작성하고, 목소리를 복제하고, 입술을 동기화하고, 맞춤형 동영상을 만들 수 있습니다. 기존 동영상의 더빙을 다시 하든, 처음부터 새로운 스토리를 만들든, TalkingAvatar는 모든 것을 지원합니다.

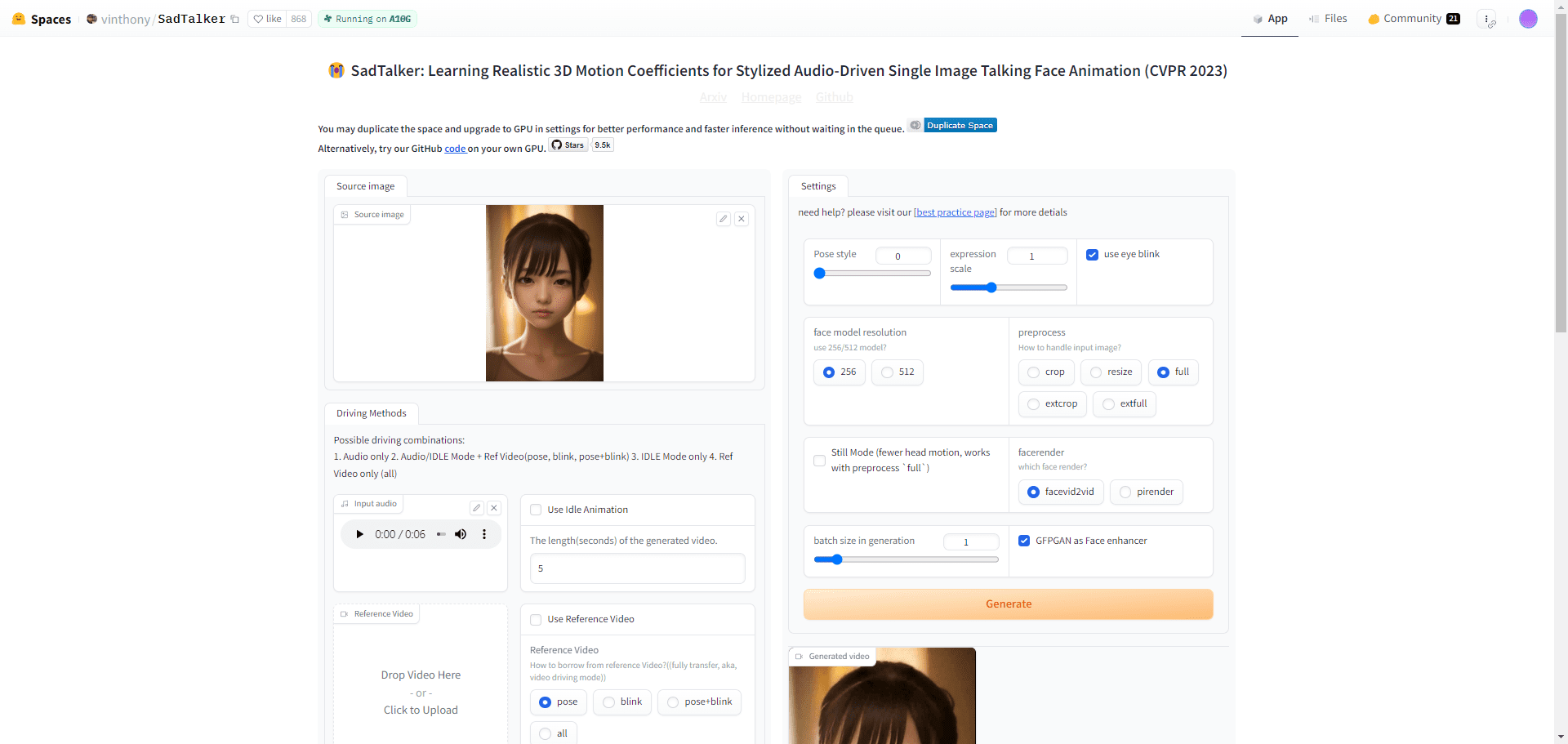

새드토커: 사진 말하기 만들기 | 입 동기화 오디오 | 합성 입 동기화 비디오 | 무료 디지털 피플

새드토커는 하나의 정지 인물 사진과 오디오 파일을 결합하여 개인화된 메시지, 교육 콘텐츠 등 다양한 시나리오에 맞는 사실적인 말하는 머리 동영상을 제작하는 오픈 소스 툴입니다. ExpNet 및 PoseVAE와 같은 혁신적인 3D 모델링 기술을 사용하여 미묘한 표정과 머리의 움직임을 포착하는 데 탁월합니다. 사용자는 메시지, 교육 또는 마케팅과 같은 개인 및 상업 프로젝트 모두에 SadTalker 기술을 사용할 수 있습니다.

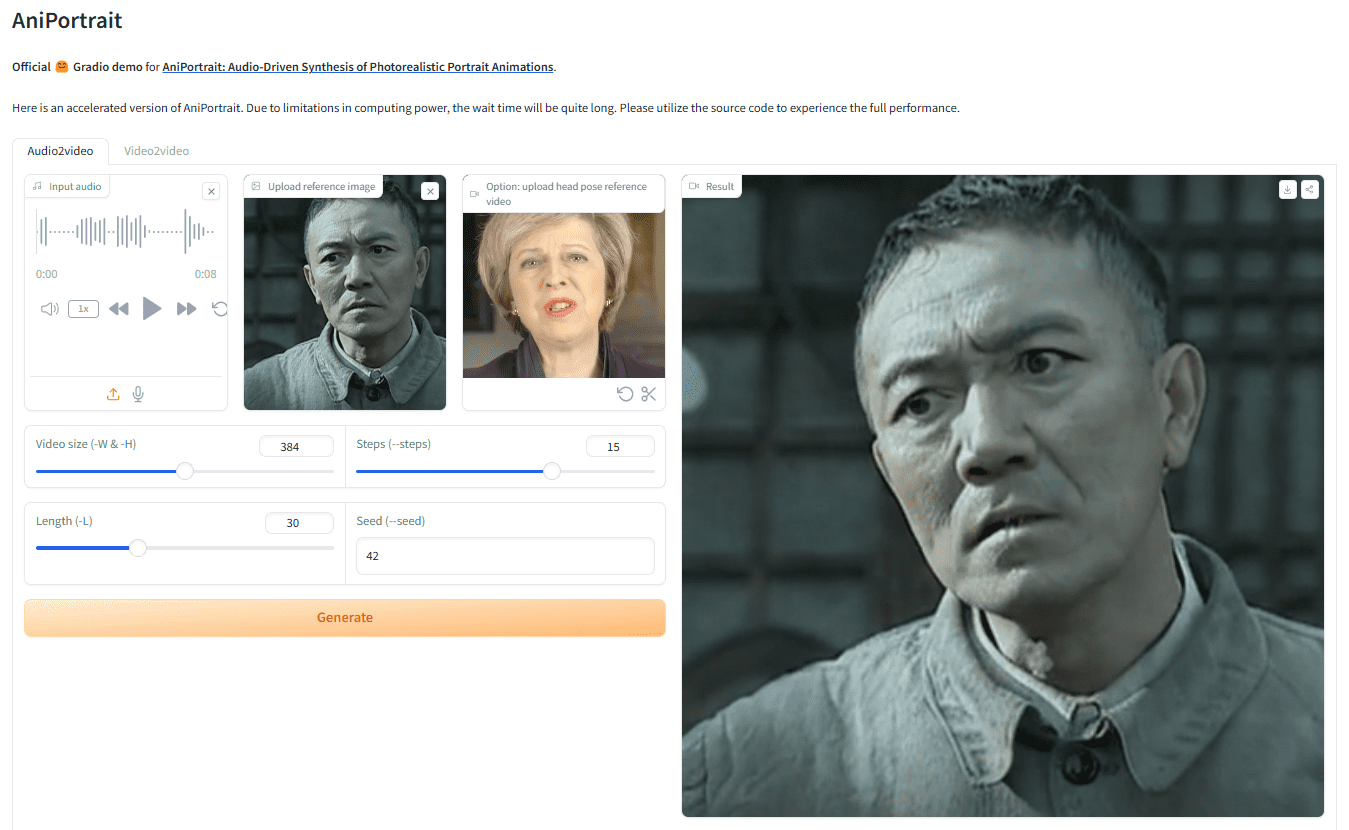

AniPortrait: 오디오 기반 사진 또는 비디오 모션으로 사실적인 디지털 사람 음성 비디오를 생성합니다.

AniPortrait는 오디오로 사실적인 초상화 애니메이션을 생성하는 혁신적인 프레임워크입니다. 화웨이, Tencent Game Know Yourself Lab의 양제준, 왕즈셩이 개발한 AniPortrait는 오디오와 참조 인물 이미지에서 고품질 애니메이션을 생성할 수 있으며, 심지어 다음과 같은 기능도 지원합니다.얼굴 재현을 위한 비디오 제공. 고급 3D 중간 표현과 2D 얼굴 애니메이션 기법을 사용하여 영화 및 TV 제작, 가상 앵커, 디지털 인물 등 다양한 응용 시나리오에 자연스럽고 부드러운 애니메이션 효과를 생성할 수 있는 프레임워크입니다.

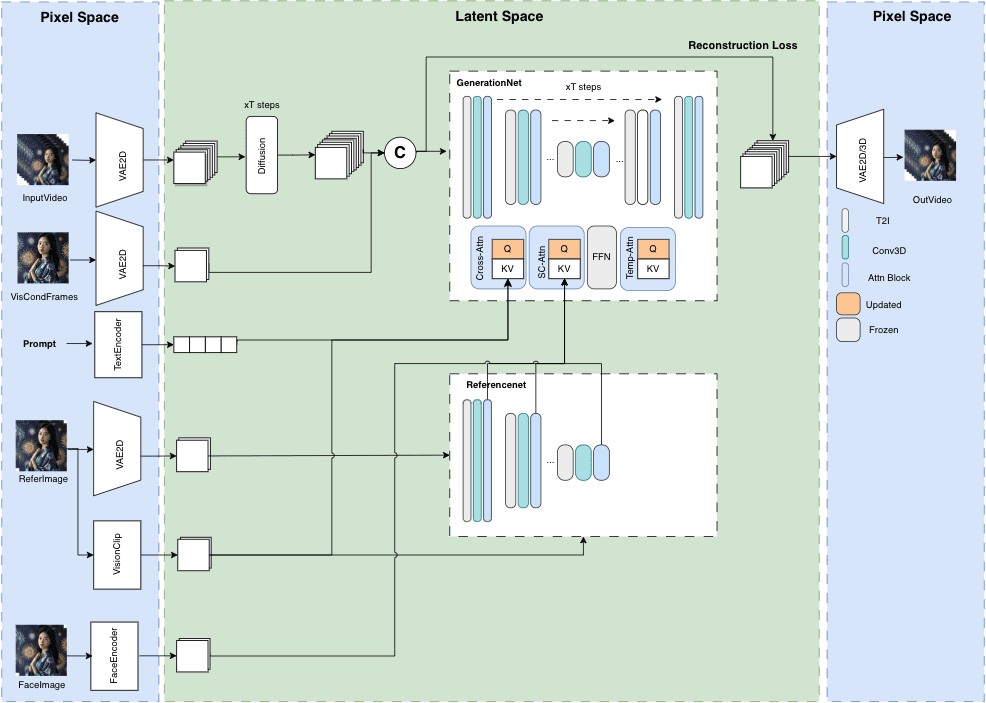

MuseV+Muse Talk: 완벽한 디지털 휴먼 비디오 생성 프레임워크 | 포트레이트에서 비디오로 | 포즈에서 비디오로 | 립싱크

MuseV는 길이에 제한이 없는 고화질의 아바타 동영상 생성을 목표로 하는 깃허브의 공개 프로젝트입니다. 디퓨전 기술을 기반으로 하며 이미지2비디오, 텍스트2이미지2비디오, 비디오2비디오 등 다양한 기능을 제공합니다. 모델 구조, 사용 사례, 빠른 시작 가이드, 추론 스크립트 및 인정에 대한 세부 정보가 제공됩니다.

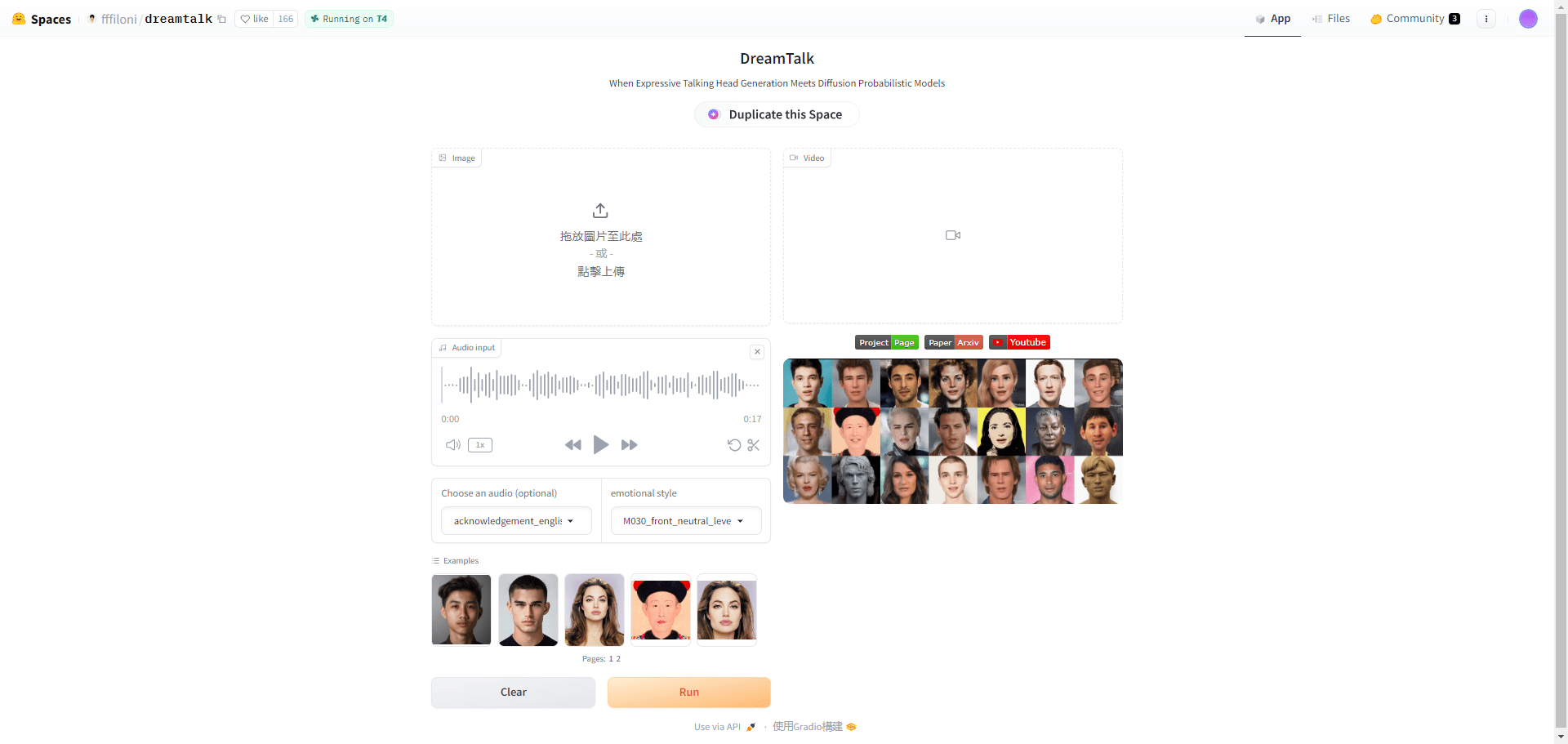

드림톡: 하나의 아바타 이미지로 표현력 있는 토킹 동영상을 생성하세요!

드림톡은 칭화대학교, 알리바바 그룹, 화중과학기술대학교가 공동으로 개발한 확산 모델 기반의 표현형 토킹 헤드 생성 프레임워크입니다. 노이즈 감소 네트워크, 스타일 인식 립 전문가, 스타일 예측기의 세 가지 주요 구성 요소로 구성되어 있으며, 오디오 입력을 기반으로 다양하고 사실적인 토킹 헤드를 생성할 수 있습니다. 이 프레임워크는 다국어와 잡음이 있는 오디오를 모두 처리할 수 있어 고품질의 얼굴 모션과 정확한 입 동기화를 제공합니다.

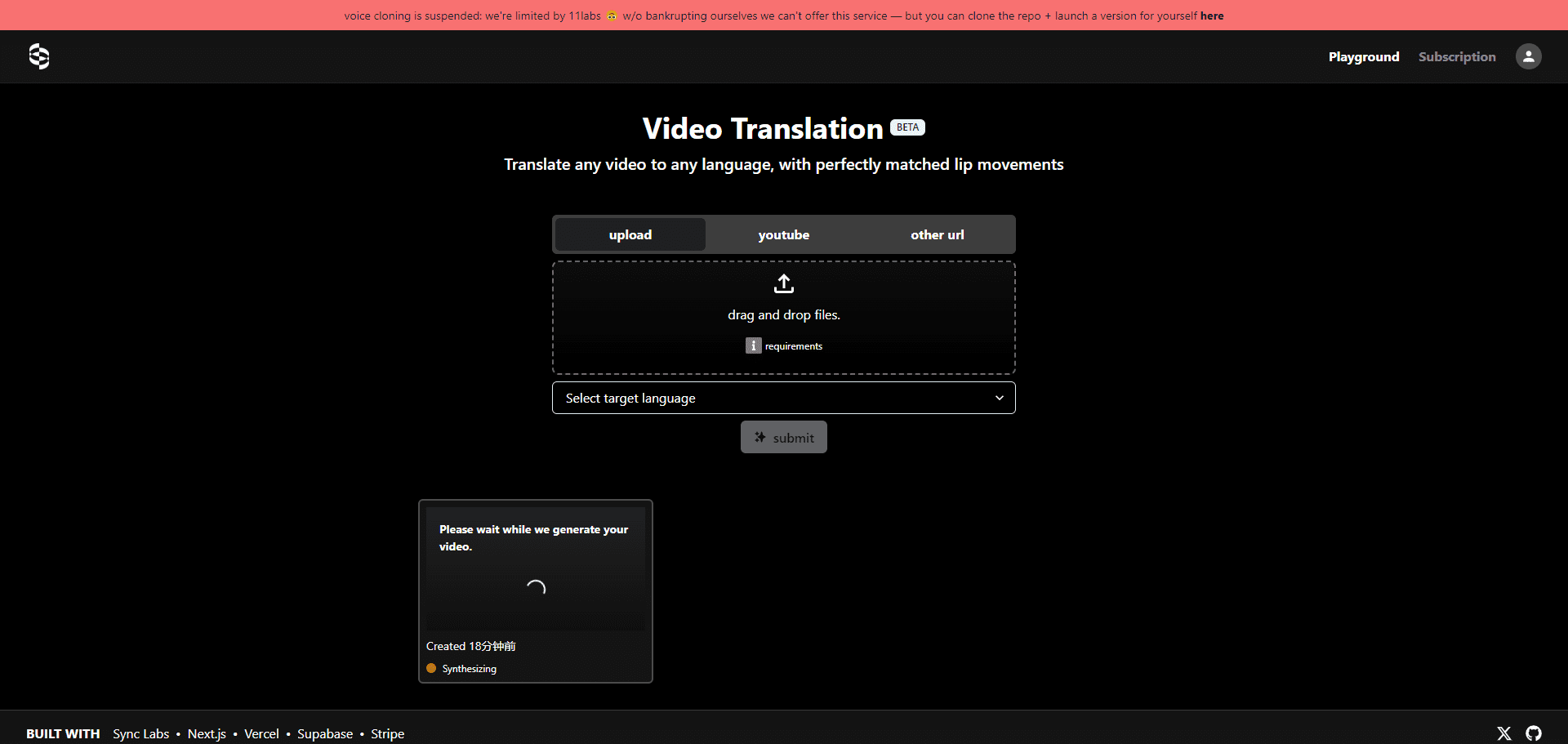

번역 스타터: 오픈 소스 비디오 콘텐츠 번역 동기화 도구 | 언어 변환 | 립싱크

번역 스타터는 개발자가 동영상 콘텐츠에 다국어 지원을 빠르게 통합할 수 있도록 Sync Labs에서 개발한 오픈 소스 프로젝트입니다. 개발자가 립싱크 기능이 있는 동영상 번역이 필요한 애플리케이션을 쉽게 만들 수 있도록 필요한 API와 설명서를 제공합니다. 싱크 랩의 퍼펙트 립싱크, Open AI의 위스퍼 번역 기술, 일레븐 랩의 사운드 합성과 같은 강력한 AI 기술을 기반으로 합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...