타이탄: 시험 시간에 암기하는 법 배우기 원본: https://arxiv.org/pdf/2501.00663v1

타이탄 아키텍처 비공식 구현: https://github.com/lucidrains/titans-pytorch

하나, 배경과 동기: 트랜스포머의 한계와 인간 기억의 영감

1. 트랜스포머의 한계: 긴 시퀀스 처리의 병목 현상

트랜스포머 이 모델은 도입 이후 강력한 성능으로 모델 개발에 크게 기여할 수 있었습니다.자기 주의 메커니즘는 자연어 처리 및 컴퓨터 비전과 같은 분야에서 혁신적인 발전을 이루었습니다. 그러나 작업의 복잡성이 증가함에 따라 Transformer는 긴 시퀀스를 처리할 때 점차 몇 가지 중요한 문제를 노출하고 있습니다:

- 높은 계산 복잡성으로 인한 모델 확장성 제한 :.

- 셀프 어텐션 메커니즘을 사용하려면 다음과 같은 계산이 필요합니다. 토큰 시퀀스의 다른 모든 토큰과 유사성, 시간 및 공간 복잡도 O(N²)어느 N 는 시퀀스 길이입니다.

- 즉, 시퀀스 길이가 증가하면 계산 및 메모리 소비가 제곱 단계로 증가하여 긴 시퀀스를 처리하는 모델의 능력이 심각하게 제한됩니다. 예를 들어 Transformer는 긴 텍스트, 동영상 이해 또는 장기 시계열 예측과 같은 작업을 처리할 때 종종 그 한계를 벗어납니다.

그림 1: 자기 주의 메커니즘의 계산 과정.

- 장거리 종속성을 캡처하기 위한 제한된 컨텍스트 창 :.

- 계산 부담을 줄이기 위해 트랜스포머는 일반적으로 고정 길이의 컨텍스트 창(예: 512 또는 1024)을 사용하므로 모델은 현재 창 내의 정보에만 집중할 수 있습니다.

- 그러나 긴 텍스트나 대화에서 문맥 정보를 이해하고, 동영상에서 서로 다른 시점의 정보를 통합하고, 과거 데이터의 장기적인 추세와 패턴을 사용하여 예측하는 등 많은 실제 작업에는 더 긴 시간 규모에 걸쳐 종속성을 파악할 수 있는 모델이 필요합니다.

2. 선형 변압기의 절충안: 효율성 대 성능

트랜스포머의 계산 병목 현상을 해결하기 위해 연구원들은 다음과 같은 방법을 제안했습니다.선형 변압기주요 개선 사항은 다음과 같습니다:

- 소프트맥스를 커널 함수로 대체하기. 자체 주의 메커니즘의 소프트맥스 계산을 커널 함수로 대체하면 계산 복잡성이 다음과 같이 줄어듭니다. O(N).

- 병렬 추론 가능. 선형 트랜스포머의 계산 프로세스는 순환 형태로 표현할 수 있어 보다 효율적인 추론이 가능합니다.

하지만 선형 트랜스포머에도 몇 가지 한계가 있습니다:

- 성능 저하.

- 커널 트릭은 모델을 선형 반복 네트워크로 저하시켜 데이터가 행렬 값 상태로 압축되므로 표준 트랜스포머보다 성능이 떨어집니다.

- 이러한 유형의 압축은 복잡한 비선형 종속성을 효과적으로 캡처하기 어렵습니다.

- 메모리 관리 문제.

- 리니어 트랜스포머는 기록 데이터를 고정 크기의 행렬로 압축하지만, 매우 긴 컨텍스트를 처리할 때 이 압축은 다음과 같은 결과를 초래합니다.메모리 오버플로모델 성능에 영향을 줍니다.

그림 2: 선형 트랜스포머의 메모리 업데이트 프로세스.

3. 인간의 기억 체계에 대한 영감: 장기 기억을 위한 더 강력한 메커니즘 구축

위의 과제를 극복하기 위해 저자는 다음과 같이 시작했습니다.인간의 기억 시스템에서 영감을 얻어

- 기억과 학습의 관계: 기억과 학습의 관계

- 이 논문은 신경심리학 문헌에서 기억과 학습에 대한 정의를 바탕으로 기억을 입력에 의해 유도되는 신경 업데이트로 보고, 학습을 목표가 주어지면 효과적이고 유용한 기억을 습득하는 과정으로 정의합니다.

- 이는 곧강력한 기억 메커니즘 없이는 효과적인 학습을 달성할 수 없습니다..

- 인간 기억의 다단계적 특성: 인간 기억은

- 인간의 기억 시스템은 단일 구조가 아니라 단기 기억, 작업 기억, 장기 기억과 같은 여러 하위 시스템으로 구성되어 있으며, 각 시스템은 서로 다른 기능과 조직 구조를 가지고 있으며 독립적으로 작동할 수 있습니다.

- 이러한 다층적 특성 덕분에 인간은 정보를 효율적으로 저장, 검색, 관리할 수 있습니다.

- 기존 모델의 단점.

- 기존의 신경망 아키텍처(홉필드 네트워크부터 LSTM, 트랜스포머까지)는 일반화, 길이 추정, 추론 등 실제의 복잡한 작업에 필수적인 기능을 처리하는 데 어려움이 있습니다.

- 이러한 아키텍처는 인간의 뇌에서 영감을 얻었지만 모두 다음과 같은 기능이 부족합니다.임시 메모리효과적인 모델링메모리 시스템의 다단계 특성시뮬레이션.

2, 핵심 혁신: 신경 장기 기억 모듈 및 타이탄 아키텍처

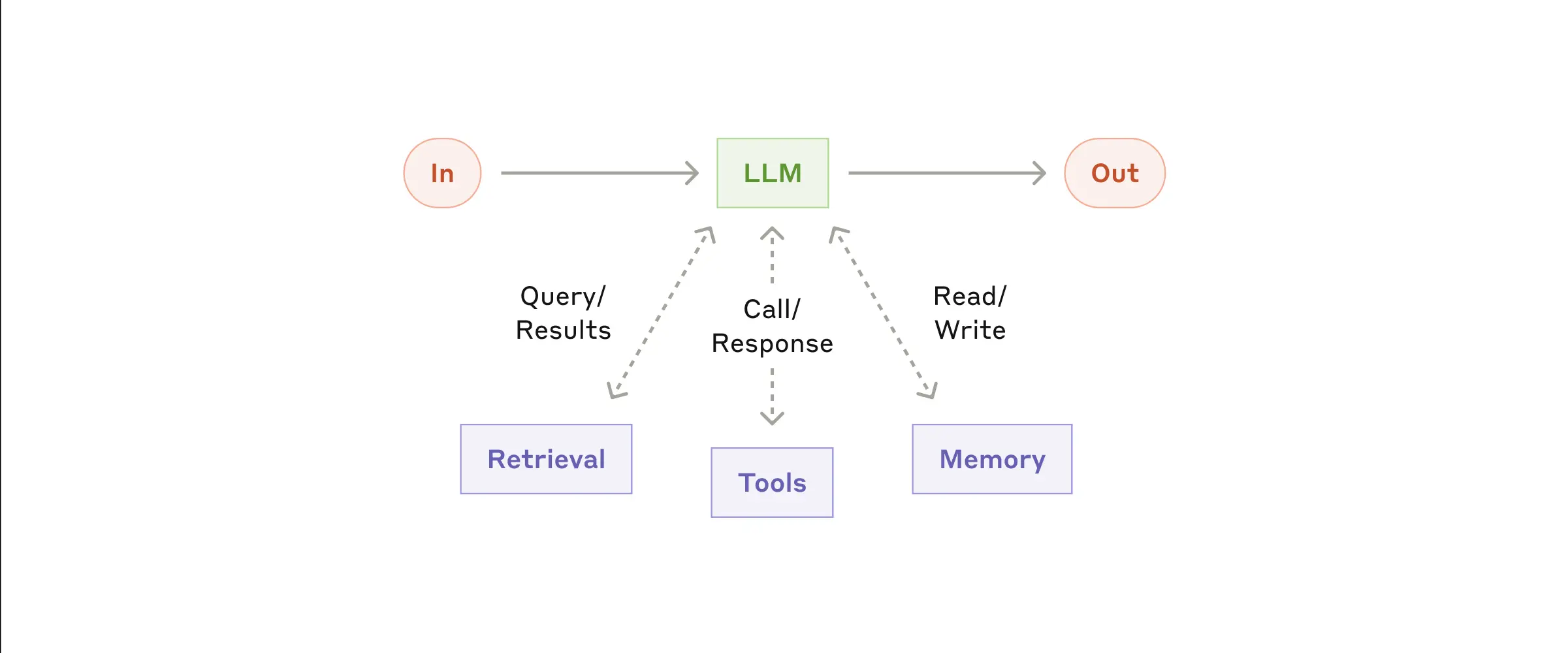

이러한 성찰을 바탕으로 저자는 다음과 같은 혁신을 제안합니다:

1. 신경 장기 기억 모듈

(1) 디자인 컨셉.

- 메타 컨텍스트 학습 메커니즘.

- 모듈은 다음과 같이 설계되었습니다.메타모델를 사용하여 테스트 중에 데이터를 매개변수로 기억/저장하는 방법을 배웁니다.

- 이런 종류의온라인 학습접근 방식을 사용하면 모델이 사전 학습 중에 고정된 메모리에 의존하지 않고 현재 입력에 맞게 메모리를 동적으로 조정할 수 있습니다.

- 서프라이즈 기반 메모리 업데이트

- 저자는 "놀라운 사건이 기억될 가능성이 더 높다"는 인간의 기억 메커니즘에 착안하여 다음과 같은 방법을 제안합니다.놀라움의 정도메모리 업데이트 메커니즘.

- 놀라움의 정도입력과 관련된 신경망을 계산하여그라데이션를 측정할 때 기울기가 클수록 입력 데이터가 과거 데이터와 더 많이 다르며 기억할 만한 가치가 있습니다.

- 이 방법은 데이터의 핵심 정보를 캡처하여 장기기억에 저장하는 데 효과적입니다.

- 반면, 선형 변환기는 현재 입력 데이터를 기반으로 선형 변환만 수행할 수 있으므로 장거리 종속성을 효과적으로 캡처하기 어렵습니다.

그림 3: 서프라이즈 기반 메모리 업데이트 메커니즘.

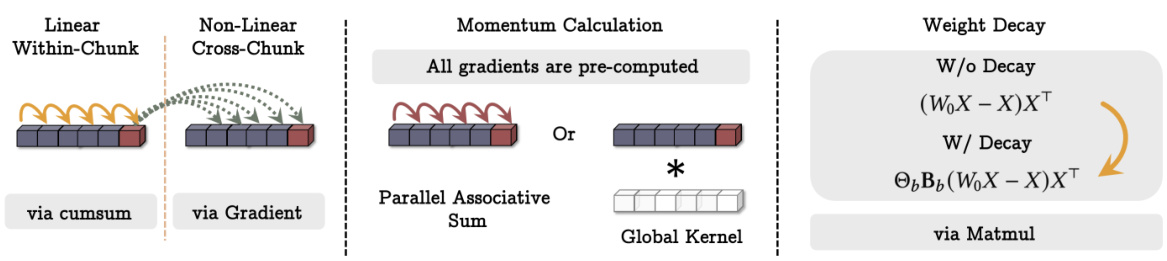

(2) 핵심 기술.

- 모멘텀 메커니즘.

- 모델이 하나의 놀라운 이벤트에 과도하게 영향을 받는 것을 방지하기 위해 저자는 다음과 같이 도입했습니다.모멘텀 메커니즘를 통해 지난 순간의 놀라움을 고려합니다.

- 즉, 모델이 현재 및 과거 입력의 놀라움을 모두 고려하여 메모리 업데이트가 더 원활하게 이루어집니다.

- 감쇠 메커니즘.

- 메모리 오버플로를 방지하기 위해 저자들은 또한붕괴 메커니즘by체중 감소중요하지 않은 정보를 서서히 잊어버리는 방법입니다.

- 이 메커니즘은 다음과 같이 볼 수 있습니다.게이팅 메커니즘를 사용하여 필요에 따라 선택적으로 메모리를 지울 수 있습니다.

- 저자들은 이 쇠퇴 메커니즘이 현대 반복 모델의 망각 메커니즘을 일반화한 것으로, 소량의 경사 하강, 운동량 및 무게 쇠퇴 하에서 메타 신경망을 최적화하는 것과 같다고 지적합니다.

(3) 메모리 구조.

- 기존의 선형 메모리 모델과 달리 저자들은멀티 레이어 퍼셉트론(MLP) 를 메모리 모듈로 사용합니다.

- MLP는 비선형 표현이 더 강력하며 복잡한 정보를 더 효율적으로 저장하고 검색할 수 있습니다.

- 반면 선형 트랜스포머는 행렬 값 상태만 사용하여 정보를 저장할 수 있으므로 복잡한 비선형 관계를 캡처하기 어렵습니다.

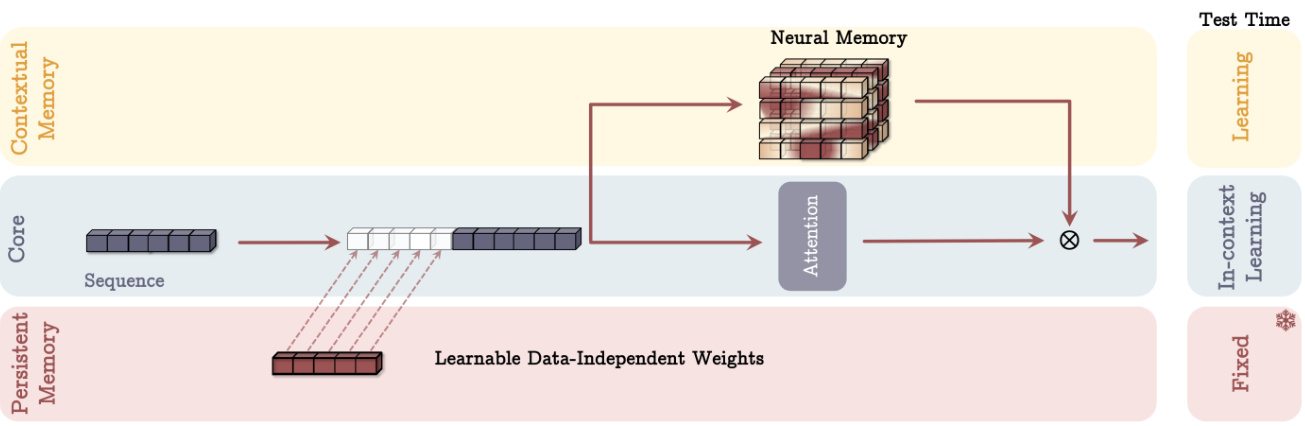

2. 타이탄 아키텍처: 장기 및 단기 메모리 통합

신경 장기 기억 모듈을 설계한 후, 저자들은 이를 딥러닝 아키텍처에 효과적으로 통합하는 방법에 대해 더 고민한 끝에 다음과 같은 주요 기능을 갖춘 타이탄 아키텍처를 제안했습니다:

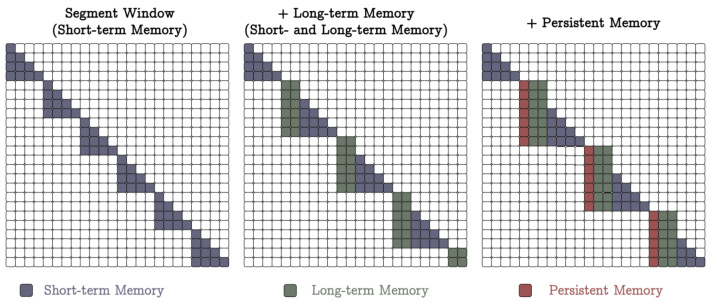

(1) 세 명의 슈퍼헤드가 함께 일하고 있습니다.

- Core.

- 단기 메모리로 구성되어 있으며 데이터를 처리하는 주요 프로세스를 담당합니다.

- 활용한정된 창 크기에 대한 주의 메커니즘슬라이딩 창 주의(SWA) 또는 완전 연결 주의(FCA)와 같은 기능을 사용할 수 있습니다.

- 단기 기억력은 다음과 같이 볼 수 있습니다.단기 기억를 사용하여 현재 컨텍스트에서 종속성을 캡처하는 데 사용됩니다.

- 장기 기억력.

- 오래 전의 정보를 저장/기억하는 역할을 담당합니다.

- 위에서 설명한 신경 장기기억 모듈이 사용됩니다.

- 장기기억은 다음과 같이 볼 수 있습니다.임시 메모리를 사용하여 장기간에 걸쳐 정보를 저장하고 검색하는 데 사용됩니다.

- 영구 메모리.

- 는 작업에 대한 선험적 지식을 인코딩하는 학습 가능하지만 데이터와 독립적인 매개변수 집합입니다.

- 트랜스포머의 완전 연결 레이어의 매개변수와 유사하지만 기능이 다릅니다.

- 영구 메모리는 다음과 같이 볼 수 있습니다.메타메모리문법 규칙, 상식 지식 등과 같은 작업 관련 지식을 저장하는 데 사용됩니다.

그림 4: 타이탄 아키텍처의 개략도(MAC 변형).

(2) 세 가지 유형의 통합.

- 컨텍스트로서의 메모리(MAC).

- 길고 지속적인 메모리를 현재 컨텍스트에 대한 추가 정보로 입력 시퀀스에 연결합니다.

- 주의력 메커니즘은 어떤 정보를 장기기억에 저장해야 하는지 결정합니다.

- 테스트 당시 지속적 기억 매개변수는 고정된 상태로 유지되었고, 주의 모듈은 맥락 학습을 위해 가중치를 부여한 반면, 장기기억 모듈은 계속해서 정보를 학습/기억했습니다.

- 이 설계를 통해 모델은 현재 입력에 따라 장기 메모리 정보를 유연하게 활용할 수 있습니다.

- 메모리 게이팅(MAG).

- 슬라이딩 창 주의력을 단기 기억으로, 신경 기억 모듈을 장기 기억으로 사용합니다.

- 학습 가능한 벡터 값 가중치를 사용하여 두 가지를 정규화한 다음 비선형 활성화 함수를 적용하는 등 게이팅 메커니즘을 통해 두 가지를 결합합니다.

- 이 디자인은 서로 다른 헤드가 서로 다른 구조로 구성된 멀티 헤드 아키텍처로 볼 수 있습니다.

그림 5: 타이탄 아키텍처의 다양한 변형(MAC 및 MAG). - 레이어로서의 메모리(MAL).

- 신경 메모리 모듈을 심층 신경망의 계층으로 사용하여 주의 모듈 이전에 과거 및 현재 컨텍스트 정보를 압축합니다.

- 이 디자인은 H3 모델과 같이 문헌에서 더 많이 볼 수 있습니다.

(3) 강점.

- 더욱 유연한 메모리 관리.

- 타이탄 아키텍처는 메모리 모듈을 컨텍스트 또는 게이트 브랜치로 사용함으로써 현재 입력에 따라 장기 메모리 정보를 동적으로 활용할 수 있습니다.

- 이는 메모리 모듈을 레이어로 사용하는 기존 방식보다 더 많은 유연성을 제공합니다.

- 더 강력한 표현.

- 타이탄 아키텍처는 세 개의 슈퍼헤드의 시너지 효과를 통해 긴 순차 데이터를 보다 효율적으로 처리하고 단기 메모리, 장기 메모리 및 영구 메모리의 이점을 통합할 수 있습니다.

- 확장성.

- 타이탄 아키텍처는 트랜스포머에 비해 긴 시퀀스를 처리할 때 확장성이 뛰어나며 더 큰 컨텍스트 창에서 높은 성능을 유지할 수 있습니다.

3, 실험 결과 및 분석: 타이탄 아키텍처 검증하기

저자들은 타이탄 아키텍처와 그 변형의 성능을 평가하기 위해 여러 작업에 대해 광범위한 실험을 수행했습니다:

1. 언어 모델링 및 상식 추론.

- 실험적 설정.

- 크기가 다른 세 가지 타이탄 모델(340M, 400M, 760M 파라미터)과 Transformer++, RetNet, GLA, 맘바, 맘바2, 델타넷, TTT 및 게이트 델타넷을 포함한 여러 기준 모델이 사용되었습니다.

- 학습 데이터에는 FineWeb-Edu 데이터 세트가 사용되었습니다.

- 주요 결과

- 혼합되지 않은 모델에서는 신경 장기 기억 모듈이 난해성 및 정확도 지표에서 모두 최고의 성능을 달성했습니다.

- 타이탄의 세 가지 변형(MAC, MAG, MAL) 모두 삼바(맘바 + 주의)와 게이트 델타넷-H2(게이트 델타넷 + 주의)보다 성능이 뛰어났습니다.

- MAC은 장거리 종속성을 처리할 때 더 나은 성능을 발휘하는 반면, MAG와 MAC은 모두 MAL 변형보다 성능이 뛰어납니다.

그림 6: 언어 모델링 및 상식적 추론 과제에서 타이탄과 기준 모델의 성능 비교.

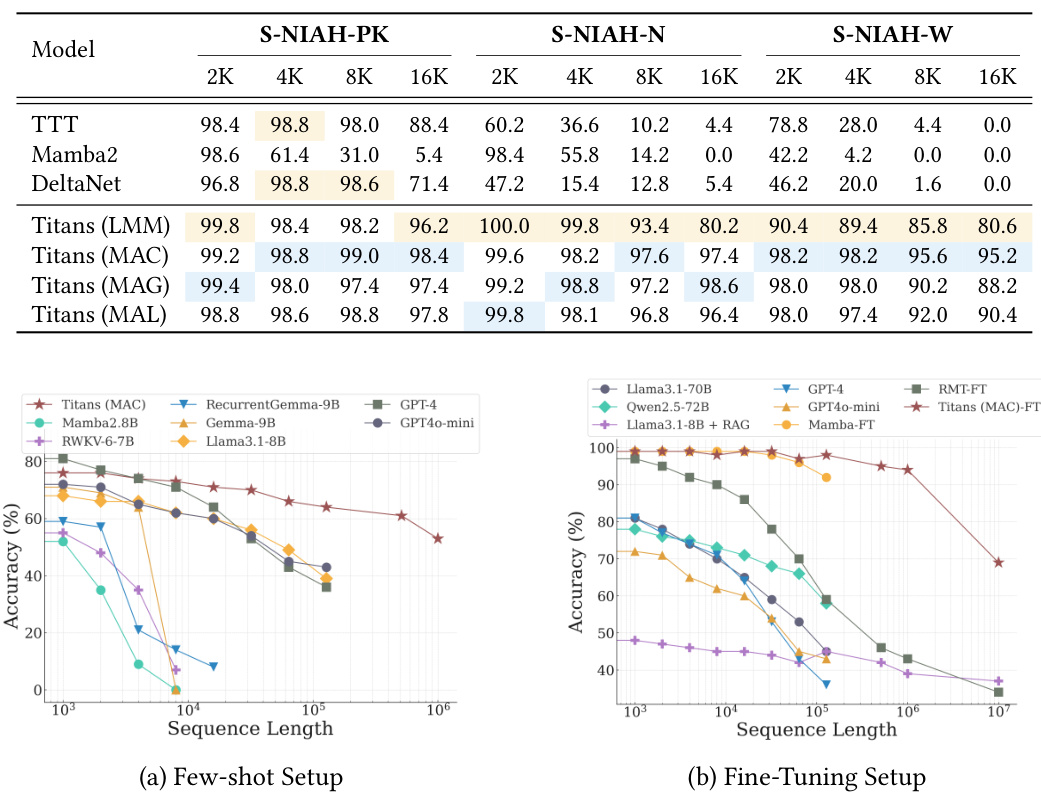

2. "건초더미 속 바늘 찾기" 미션.

- 실험적 설정.

- RULER 벤치마킹의 단일 NIAH(S-NIAH) 작업을 사용하여 2K, 4K, 8K 및 16K 길이의 시퀀스에 대해 모델의 검색 능력을 평가했습니다.

- 주요 결과

- 신경 장기기억 모듈은 세 가지 작업 모두에서 최고의 결과를 얻었습니다.

- 타이탄 버전도 우수한 성능을 보였으며, 특히 MAC 버전이 가장 우수한 성능을 보였습니다.

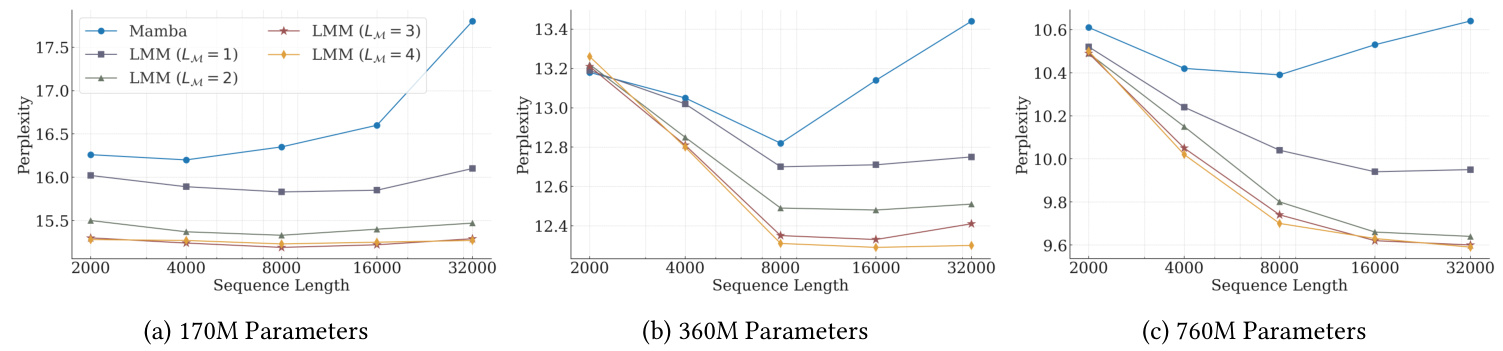

3. 바비롱 벤치마킹.

- 실험적 설정.

- 이 작업에서는 모델이 매우 긴 문서에 분산된 사실 정보를 추론해야 합니다.

- 샘플이 적은 설정과 미세 조정 설정이 있습니다.

- 주요 결과

- 샘플 수가 적은 설정에서 타이탄은 GPT-4 및 GPT4o-mini와 같이 매개변수 수가 많은 모델을 포함한 모든 기준선보다 성능이 뛰어납니다.

- 또한 타이탄은 미세 조정 설정에서 모든 모델, 심지어 GPT-4와 같은 초대형 모델보다 뛰어난 성능을 발휘합니다.

- 트랜스포머 기반 메모리 모델(RMT)에 비해 타이탄은 강력한 메모리 성능으로 인해 더 나은 성능을 보여줍니다.

그림 7: BABILong 벤치마크에서 타이탄과 기본 모델의 성능 비교.

4. 시계열 예측.

- 실험적 설정.

- Simba 프레임워크를 사용하여 맘바 모듈을 신경 장기기억 모듈로 대체했습니다.

- ETT, ECL, 교통 및 날씨 벤치마크 데이터 세트에서 평가되었습니다.

- 주요 결과

- 신경 장기 기억 모듈은 맘바, 선형 모델, 트랜스포머 기반 아키텍처를 포함한 모든 기준선보다 성능이 뛰어납니다.

5. DNA 모델링.

- 실험적 설정.

- 사전 학습된 모델의 다운스트림 작업 성능을 GenomicsBenchmarks에서 평가하세요.

- 주요 결과

- 타이탄(LMM)은 다양한 다운스트림 유전체학 작업에서 경쟁력을 갖추고 있으며 최첨단 방법과 동등한 수준입니다.

6. 효율성 분석.

- 주요 결과

- 신경 장기 기억 모듈은 다른 반복 모델에 비해 훈련 속도가 약간 느린데, 이는 더 깊은 메모리와 더 복잡한 변환 과정, 그리고 Mamba2에서 구현된 고도로 최적화된 커널 때문입니다.

- 타이탄(MAL)은 플래시어텐션의 고도로 최적화된 커널을 사용해 메모리 모듈뿐만 아니라 기준선보다 더 빠릅니다.

7. 절제 연구.

- 주요 결과

- 신경 메모리 설계의 모든 구성 요소는 성능에 긍정적으로 기여하며, 가중치 감쇠, 모멘텀, 컨볼루션 및 지속적 메모리가 가장 큰 기여를 합니다.

- 아키텍처 설계도 성능에 상당한 영향을 미치며, 언어 모델링 및 상식적인 추론 작업에서는 MAC과 MAG의 성능이 비슷하고, 긴 컨텍스트 작업에서는 MAC의 성능이 더 우수합니다.

4, 논문의 혁신적 포인트와 강점

- 새로운 신경 장기기억 모듈이 제안되었습니다.

- 놀라움, 추진력, 망각과 같은 인간 기억 메커니즘의 핵심 요소를 차용하여 보다 효율적인 메모리 업데이트 및 저장을 구현합니다.

- 심층 신경망은 메모리 모듈로 사용되어 모델에 더 큰 표현력을 부여합니다.

- 타이탄 아키텍처는 장기기억과 단기기억을 결합하도록 설계되었습니다.

- 세 가지 통합 접근 방식이 제안되어 다양한 애플리케이션 시나리오에 맞는 유연한 옵션을 제공합니다.

- 코어, 장기 메모리, 영구 메모리라는 세 가지 슈퍼헤드의 시너지 효과를 통해 모델은 긴 순차 데이터를 보다 효율적으로 처리할 수 있습니다.

- 여러 작업에 탁월합니다.

- 언어 모델링, 상식적 추론, 시계열 예측, DNA 모델링 등 Titans 아키텍처는 기존 Transformer 및 선형 루프 모델을 능가하는 강력한 성능을 보여줍니다.

- 확장성.

- 더 큰 컨텍스트 창에서 고성능을 유지할 수 있는 기능은 매우 긴 시퀀스를 처리할 수 있는 가능성을 열어줍니다.

다섯, 향후 전망

타이탄 아키텍처는 여러 측면에서 인상적인 성과를 거두었지만, 아직 더 살펴볼 필요가 있는 다음과 같은 방향이 있습니다.

- 더 복잡한 메모리 모듈 아키텍처 살펴보기: 더 복잡한 메모리 모듈 아키텍처는

- 예를 들어 계층적 메모리 구조를 도입하거나 메모리 모듈을 그래프 신경망과 같은 다른 모델과 결합할 수 있습니다.

- 메모리 업데이트 및 저장을 위한 보다 효율적인 메커니즘 개발.

- 예를 들어, 메모리 소비와 계산 비용을 줄이기 위해 희소화 기법이나 양자화 기법이 사용됩니다.

- 타이탄 아키텍처를 더 다양한 영역에 적용합니다.

- 비디오 이해, 로봇 제어, 추천 시스템 등이 그 예입니다.

- 보다 효과적인 교육 전략을 살펴보세요.

- 예를 들어, 고급 최적화 알고리즘을 도입하거나 메타 학습을 사용하여 모델 학습을 가속화하는 것입니다.

- 타이탄 아키텍처의 해석 가능성 조사.

- 타이탄이 장기 기억 정보를 저장하고 활용하는 방식을 더 깊이 이해하면 더 강력한 AI 시스템을 구축할 수 있는 새로운 아이디어를 얻을 수 있습니다.

여섯, 요약

이 백서의 핵심은 다음과 같습니다:

- 새로운 신경 장기기억 모듈이 제안되었습니다.이 디자인은 인간의 기억 시스템에서 영감을 받아 경사 하강, 운동량 및 무게 감소와 같은 딥러닝의 핵심 개념을 통합했습니다.

- 타이탄 아키텍처 구축는 장기기억과 단기기억을 유기적으로 결합하고 세 가지 통합 방법을 탐색하여 다양한 애플리케이션 시나리오에 맞는 유연한 옵션을 제공합니다.

- 타이탄의 우수한 성능은 엄격한 실험을 통해 검증되었습니다.특히 긴 컨텍스트 작업을 처리할 때 여러 작업에서 뛰어난 성능을 발휘하며 강력한 확장성과 높은 정확도를 보여줍니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...