엔비디아의 CEO 젠슨 황은 인공지능을 '디지털 인력'이라고 칭송했으며, 이러한 견해를 가진 기술 리더는 황뿐만이 아닙니다. Microsoft의 CEO 사티아 나델라 역시 지능형 신체 기술이 비즈니스 운영 방식을 근본적으로 변화시킬 것이라고 믿습니다.

이러한 인공지능이 외부 도구 및 API와 상호 작용할 수 있게 되면서 적용 시나리오가 크게 확장되었습니다. 하지만 인공지능은 완벽하지 않으며, 잠재적인 상호작용의 복잡성으로 인해 실제 애플리케이션에서 그 성능을 평가하는 것은 어려운 과제였습니다.

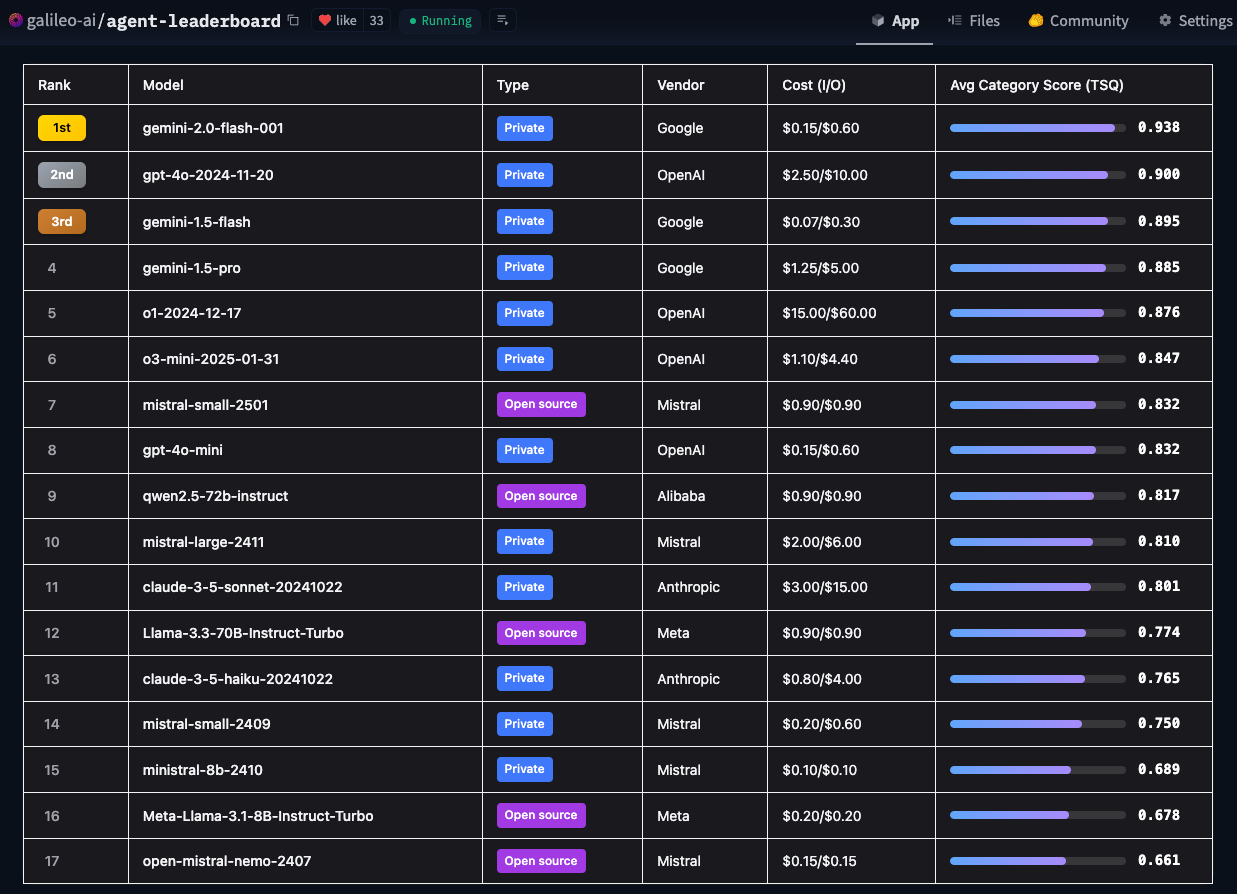

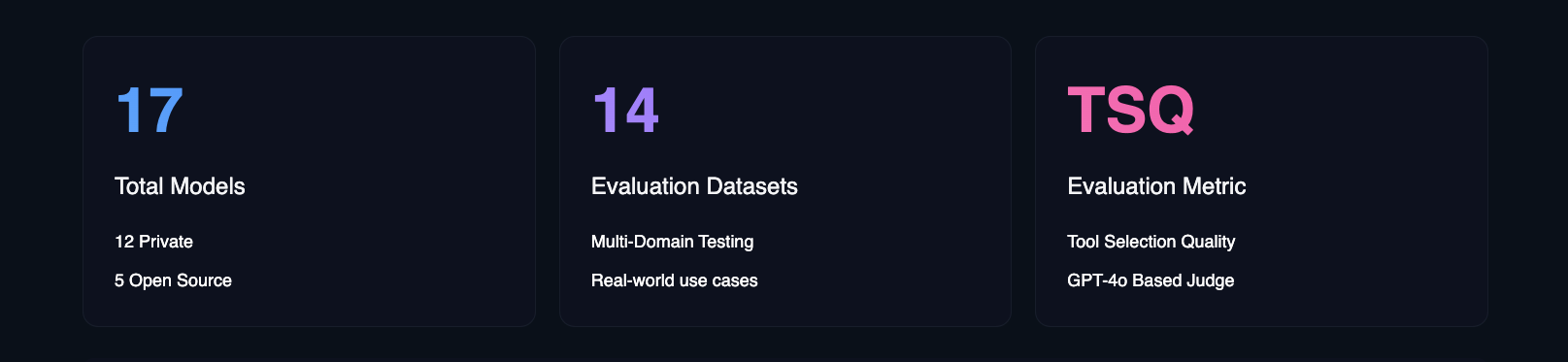

이러한 문제를 해결하기 위해 허깅 페이스는 에이전트 인텔리전스 바디 랭킹을 도입했습니다. 이 순위표는 갈릴레오의 도구 선택 품질(TSQ) 지표를 사용하여 도구 기반 상호작용을 처리하는 다양한 대규모 언어 모델(LLM)의 성능을 평가하여 개발자에게 명확한 참조를 제공합니다.

- 포옹하는 얼굴 에이전트 지능형 바디 랭킹

허깅 페이스는 "AI 인텔리전스가 실제 비즈니스 환경에서 얼마나 잘 작동하는가?"라는 핵심 질문에 답하기 위해 이 순위를 만들었습니다. 학술적 벤치마크도 중요하지만 기술적 역량에 초점을 맞추는 반면, Hugging Face는 다양한 실제 사용 사례에 실제로 어떤 모델을 적용할 수 있는지에 더 관심을 두고 있습니다.

허깅 페이스 에이전트 지능형 신체 평가 리더보드의 고유 기능

현재의 주류 평가 프레임워크는 일반적으로 특정 영역에 초점을 맞추고 있습니다. 예를 들어, BFCL은 수학, 엔터테인먼트, 교육과 같은 학문적 영역에서, τ-bench는 소매업, 항공업과 같은 산업별 시나리오에, xLAM은 21개 데이터 생성 영역을, ToolACE는 390개 영역의 API 상호작용에 초점을 맞추고 있습니다. 허깅 페이스의 리더 보드는 이러한 데이터 세트를 광범위한 도메인과 실제 사용 사례를 포괄하도록 설계된 포괄적인 평가 프레임워크에 결합한다는 점에서 독보적입니다.

विविध 벤치마크와 테스트 시나리오를 통합하여 Hugging Face의 리더보드는 모델의 기술적 역량을 평가할 뿐만 아니라 모델이 엣지 케이스와 보안 고려 사항을 처리하는 방법에 대한 실행 가능한 인사이트를 제공하는 데 중점을 둡니다. 또한 허깅 페이스는 비용 효율성, 구현 가이드라인, 비즈니스 영향과 같은 여러 요소에 대한 인사이트를 제공하며, 이는 모두 AI 인텔리전스를 배포하려는 조직에 매우 중요한 요소입니다. 허깅 페이스는 이 순위를 통해 엔터프라이즈 팀이 실제 애플리케이션의 제약을 고려하여 특정 요구 사항을 가장 잘 충족하는 AI 인텔리전스 모델을 보다 정확하게 찾아낼 수 있기를 희망합니다.

새로운 대규모 언어 모델(LLM)의 출시 빈도를 고려할 때, 허깅 페이스는 빠르게 진화하는 모델링 기술에 발맞추기 위해 매월 리더보드 벤치마크를 업데이트할 계획입니다.

주요 결과

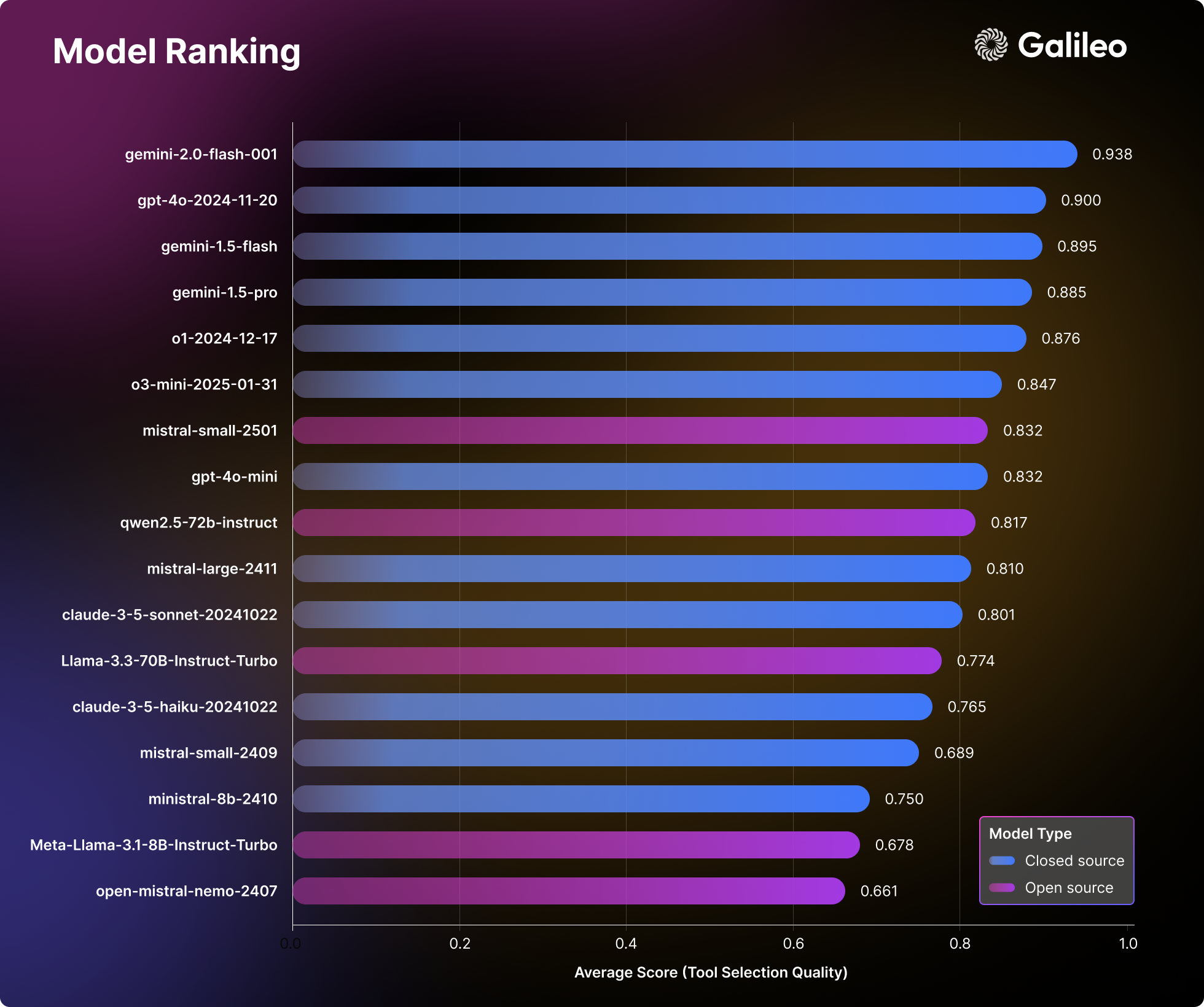

17개의 주요 대규모 언어 모델(LLM)을 심층적으로 분석한 결과, AI 지능이 실제 작업에 접근하는 방식에서 흥미로운 패턴을 발견할 수 있었습니다. 허깅 페이스는 14가지 벤치마크에 걸쳐 비공개 및 오픈 소스 모델에 대한 종합적인 스트레스 테스트를 실시하여 간단한 API 호출부터 복잡한 다중 도구 상호 작용에 이르는 다양한 차원을 평가했습니다.

대규모 언어 모델링(LLM) 순위

허깅 페이스의 평가 결과는 모델 성능에 대한 기존의 인식에 도전하며, AI 인텔리전스를 구축하는 팀에게 유용한 실용적인 참고자료를 제공합니다.

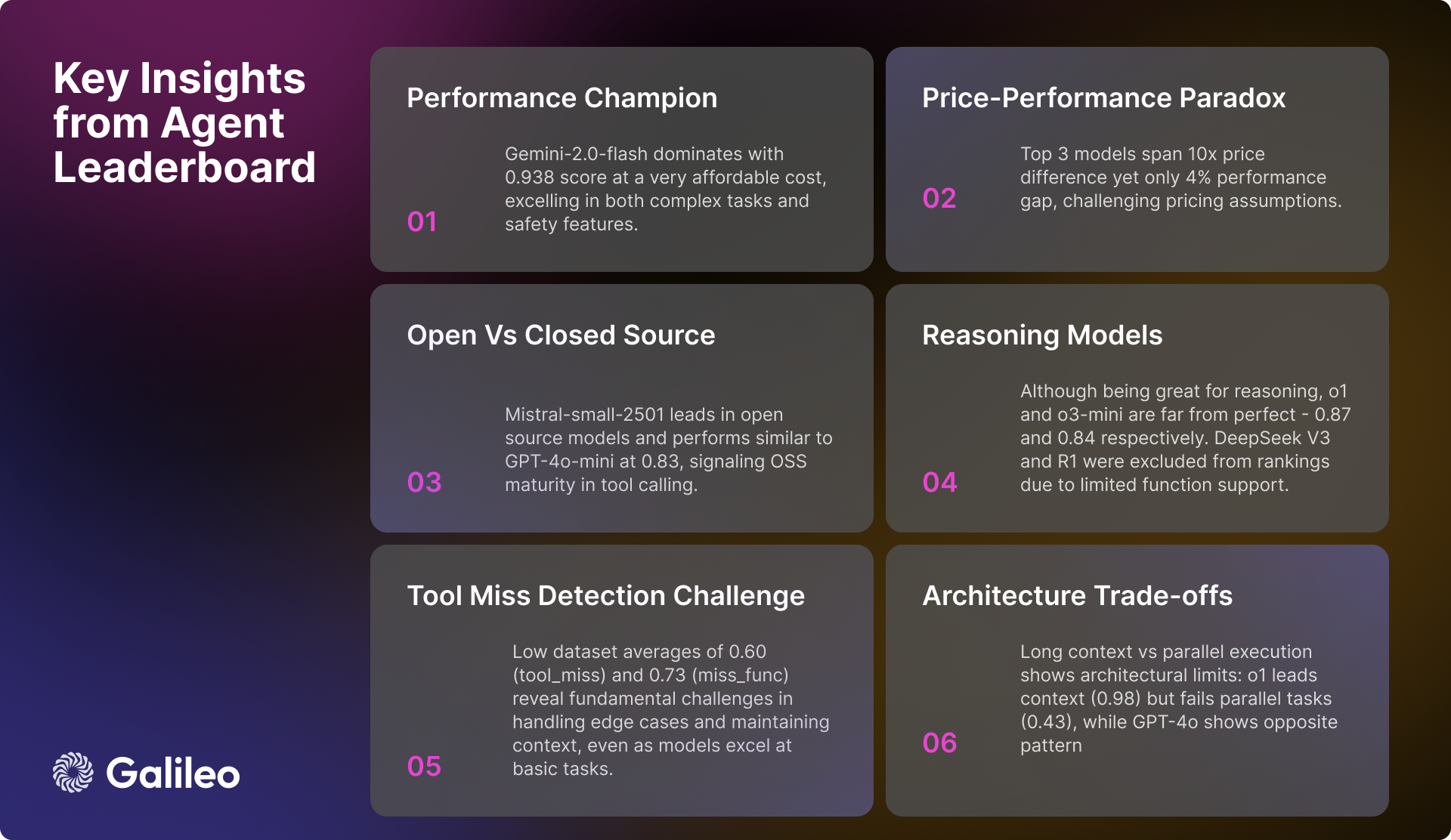

상담원 지능 순위의 주요 결과

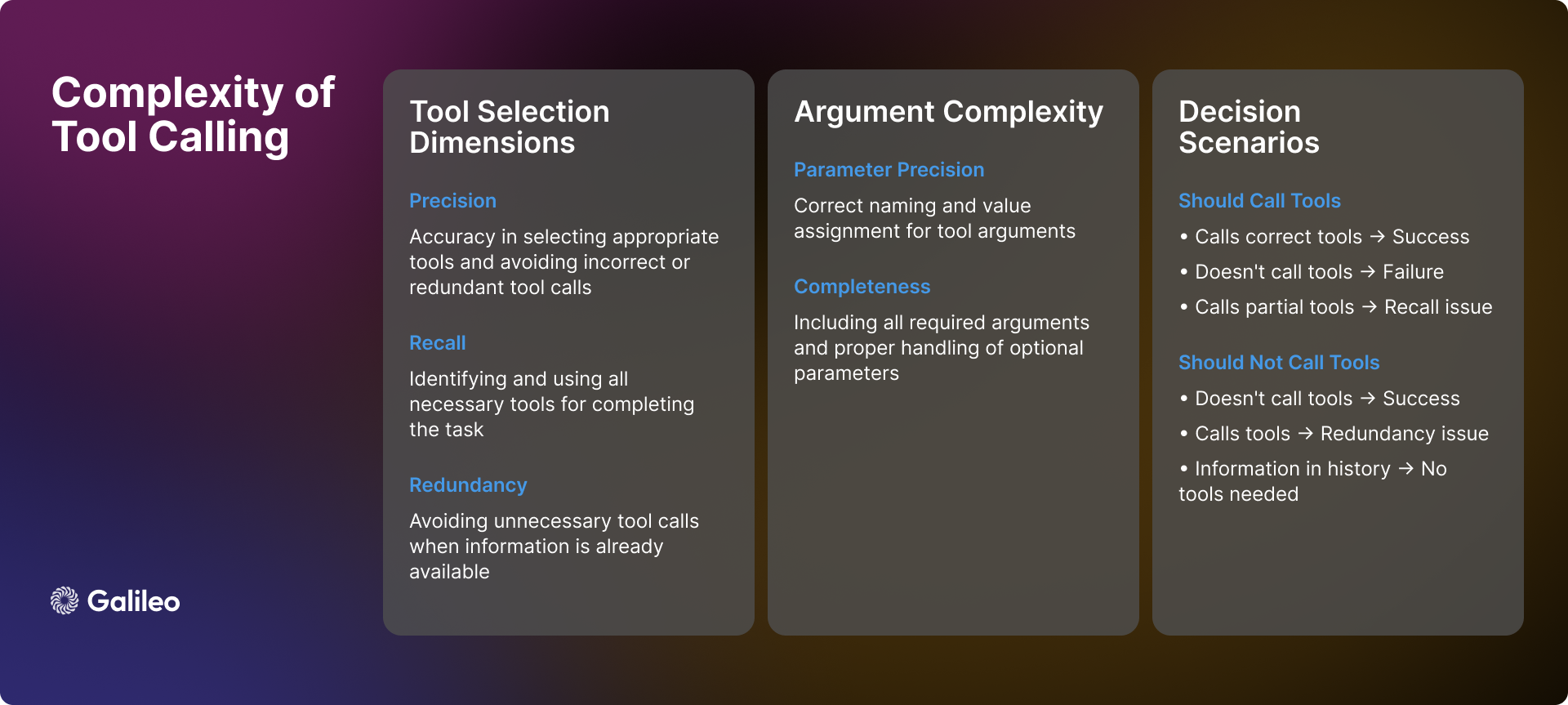

도구 호출의 복잡성

도구 호출의 복잡성은 단순한 API 호출을 훨씬 뛰어넘습니다. 실제로 인공지능은 도구 사용 시 여러 가지 복잡한 시나리오와 문제에 직면하며 정확한 의사 결정을 내려야 합니다:

장면 인식

지능형 기관이 사용자 쿼리를 받으면 가장 먼저 하는 일은 도구 호출이 필요한지 여부를 판단하는 것입니다. 때로는 필요한 정보가 대화 기록에 이미 존재하여 도구 호출이 중복될 수 있습니다. 또한 사용 가능한 도구가 사용자의 문제를 해결하기에 충분하지 않거나 작업 자체와 관련이 없을 수도 있습니다. 이러한 경우, 인공지능은 부적절한 도구의 사용을 강요하기보다는 자신의 한계를 인식하고 사용자에게 솔직하게 말할 수 있어야 합니다.

도구 선택 역학

도구 선택은 단순한 "예" 또는 "아니오"의 이분법적인 문제가 아니라 정확성과 기억력이 수반되는 문제입니다. 이상적으로는 지능이 필요한 모든 도구를 정확하게 식별하는 동시에 관련 없는 도구는 선택하지 않는 것이 좋습니다. 그러나 현실은 종종 더 복잡합니다. 지능형 객체는 필요한 도구 하나를 정확하게 식별하지만 다른 도구는 생략하거나(정확도 부족), 적절한 도구를 선택하면서 불필요한 도구를 잘못 선택할 수 있습니다(정밀도 부족). 이 두 가지 시나리오 모두 최적은 아니지만 다양한 수준의 선택 편향을 나타냅니다.

매개변수화

지능형 기관이 올바른 도구를 성공적으로 선택하더라도 매개변수 처리에는 여전히 새로운 과제가 발생할 수 있습니다. 인텔리전트 바디는 반드시 그렇습니다:

- 모든 필수 매개변수를 입력하고 이름이 올바른지 확인합니다.

- 선택적 매개변수의 적절한 처리.

- 매개변수 값의 정확성을 확인합니다.

- 도구의 특정 사양에 따라 매개변수의 형식을 지정합니다.

순차적 의사 결정

다단계 작업의 경우 인텔리전스는 보다 고급 의사 결정 능력을 입증해야 합니다:

- 최적의 도구 호출 순서를 결정합니다.

- 도구 호출 간의 상호 의존성을 처리합니다.

- 여러 작업 간에 컨텍스트 일관성을 유지하세요.

- 현지화된 성공 또는 실패에 유연하게 대응할 수 있습니다.

위에서 설명한 복잡성은 도구 선택의 품질을 단순한 지표로 간주해서는 안 된다는 것을 충분히 보여줍니다. 그 대신 실제 시나리오에서 복잡한 의사 결정을 내릴 수 있는 인텔리전스의 능력을 종합적으로 평가하는 것으로 간주해야 합니다.

방법론

허깅 페이스의 평가 프로세스는 AI 지능에 대한 포괄적이고 편견 없는 평가를 제공하기 위한 체계적인 방법론을 따릅니다:

- 모델 선택: 허깅 페이스는 독점 및 오픈 소스 구현을 포함한 다양한 선도적인 언어 모델을 신중하게 선택했습니다. 이러한 선택 전략은 현재 기술 환경에 대한 포괄적인 관점을 제공하는 것을 목표로 합니다.

- 스마트 바디 구성: 허깅 페이스는 각 모델을 표준화된 시스템 큐를 갖춘 인텔리전스로 구성하고 일관된 도구 세트에 대한 액세스 권한을 부여합니다. 이러한 표준화된 구성을 통해 성능 차이가 큐 엔지니어링과 같은 외부 요인의 영향을 받지 않고 모델 고유의 고유한 기능을 제대로 반영하도록 보장합니다.

- 지표 정의: Hugging Face는 도구 선택의 정확성과 매개변수 사용의 효과성에 초점을 맞춘 도구 선택 품질(TSQ)을 핵심 평가 지표로 설정합니다. TSQ 지표는 실제 성능 요구 사항을 염두에 두고 설계되었습니다.

- 데이터 세트 큐레이션: Hugging Face는 기존의 성숙한 벤치마크 데이터 세트에서 전략적으로 샘플링하여 균형 잡힌 멀티 도메인 데이터 세트를 구축합니다. 이 데이터 세트는 기본 함수 호출부터 복잡한 다중 라운드 상호 작용에 이르기까지 인텔리전스의 기능을 포괄적으로 테스트하여 평가의 포괄성을 보장합니다.

- 채점 시스템: 최종 성능 점수는 모든 데이터 세트에 대해 동일한 가중치의 평균을 계산하여 도출됩니다. 이 접근 방식은 균형 잡힌 평가를 보장하고 단일 기능이 전체 평가 결과를 지배하는 것을 방지하여 인텔리전스의 종합적인 성능을 보다 객관적으로 반영합니다.

이러한 구조화된 평가 방법론을 통해 허깅 페이스는 실제 배포 결정을 직접적으로 안내할 수 있는 인사이트를 제공하는 것을 목표로 합니다.

허깅 페이스는 에이전트 인텔리전스의 성능을 어떻게 측정하나요?

평가 프레임워크의 작동 방식

위에서 언급했듯이 도구 호출 평가에는 다양한 시나리오에서 신뢰할 수 있는 측정이 필요합니다. 허깅 페이스는 도구 선택의 정확성과 매개변수 사용의 효율성을 살펴보는 도구 선택 품질 지표를 개발하여 인텔리전스의 도구 호출 성능을 평가했습니다. 이 평가 프레임워크는 인텔리전스가 작업을 완료하기 위해 도구를 적절하게 사용하고 있는지 확인하고 도구 사용이 불필요한 상황을 식별하기 위해 설계되었습니다.

허깅페이스는 평가 과정에서 GPT-4o 및 ChainPoll 모델을 사용하여 도구 선택 결정을 평가했습니다. 각 상호작용에 대해 허깅페이스는 여러 개의 독립적인 판단을 수집하고 최종 점수는 긍정적인 평가의 비율을 나타냅니다. 각 판단에는 평가 과정의 투명성을 보장하기 위해 자세한 설명이 포함되어 있습니다.

다음 코드 예제는 TSQ 메트릭을 사용하여 데이터 집합에서 대규모 언어 모델(LLM)의 도구 호출 성능을 평가하는 방법을 보여 줍니다:

import promptquality as pq

import pandas as pd

file_path = "path/to/your/dataset.parquet" # 替换为你的数据集文件路径

project_name = "agent-leaderboard-evaluation" # 替换为你的项目名称

run_name = "tool-selection-quality-run" # 替换为你的运行名称

model = "gpt-4o" # 你想要评估的模型名称

tools = [...] # 你的工具列表

llm_handler = pq.LLMHandler() # 初始化 LLMHandler

df = pd.read_parquet(file_path, engine="fastparquet")

chainpoll_tool_selection_scorer = pq.CustomizedChainPollScorer(

scorer_name=pq.CustomizedScorerName.tool_selection_quality,

model_alias=pq.Models.gpt_4o,

)

evaluate_handler = pq.GalileoPromptCallback(

project_name=project_name,

run_name=run_name,

scorers=[chainpoll_tool_selection_scorer],

)

llm = llm_handler.get_llm(model, temperature=0.0, max_tokens=4000)

system_msg ={

"role":"system",

"content":'Your job is to use the given tools to answer the query of human. If there is no relevant tool then reply with "I cannot answer the question with given tools". If tool is available but sufficient information is not available, then ask human to get the same. You can call as many tools as you want. Use multiple tools if needed. If the tools need to be called in a sequence then just call the first tool.',

}

outputs = []

for row in df.itertuples():

chain = llm.bind_tools(tools)

outputs.append(

chain.invoke(

[system_msg,*row.conversation],

config=dict(callbacks=[evaluate_handler])

)

)

evaluate_handler.finish()

허깅 페이스가 도구 호출 평가에 대규모 언어 모델(LLM)을 선택한 이유는 무엇인가요?

대규모 언어 모델(LLM)에 기반한 평가 방법을 사용하면 다양하고 복잡한 시나리오를 종합적으로 평가할 수 있습니다. 이 접근 방식은 문맥 정보가 불충분한 상황을 지능이 적절하게 처리했는지 효과적으로 검증하여 도구를 사용하기 전에 사용자에게 더 많은 정보가 필요한지 여부를 결정할 수 있습니다. 여러 도구를 사용하는 시나리오에서는 이 방법을 통해 인텔리전스가 필요한 모든 도구를 식별하고 올바른 순서로 호출하는지 확인할 수 있습니다. 문맥이 긴 대화에서 이 방법은 지능형 신체가 대화 기록의 앞부분에서 관련 정보를 충분히 고려하도록 보장합니다. 도구가 누락되거나 적용 불가능한 경우에도 평가 방법은 지능형 신체가 도구 호출을 올바르게 피하여 부적절한 동작을 피하는지 여부를 결정합니다.

TSQ 지표에서 우수한 성적을 거두려면 인공지능이 필요할 때 적절한 도구를 선택하고, 정확한 매개변수를 제공하며, 여러 도구를 효율적으로 조정하고, 도구 사용이 불필요한 시나리오를 식별하는 등 정교한 기능을 보여줘야 합니다. 예를 들어 대화 기록에 필요한 모든 정보가 이미 존재하거나 적절한 도구가 없는 경우에는 도구를 사용하지 않는 것이 바람직합니다.

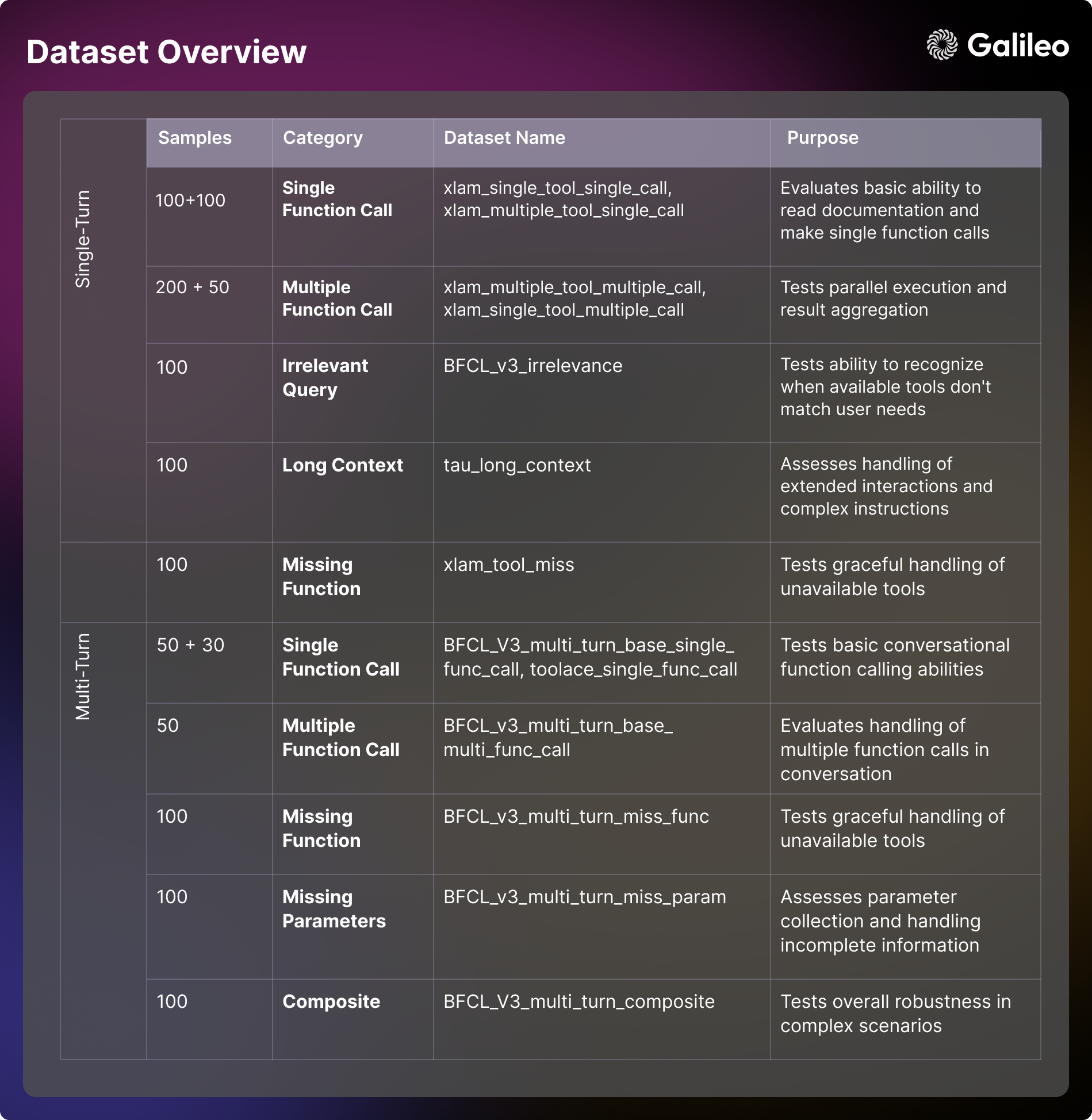

데이터 세트의 콘텐츠 구성 평가

허깅페이스의 평가 프레임워크는 BFCL(버클리 함수 호출 리더보드(버클리 함수 호출 리더보드), τ-bench(타우 벤치마크), Xlam, ToolACE. 각 데이터 세트는 특정 측면에서 인텔리전스의 기능을 테스트하기 위한 목적으로 설계되었습니다. 이러한 평가 차원을 이해하는 것은 모델 평가와 실제 애플리케이션 개발 모두에 매우 중요합니다.

단일 라운드 용량

- 기본 도구 사용 시나리오: 도구 문서, 프로세스 매개변수를 이해하고 기본 함수 호출을 수행하는 지능형 기관의 능력을 평가하는 데 중점을 둡니다. 이 차원은 직접적인 상호 작용에서 지능의 응답 형식 및 오류 처리 기능을 검사하는 데 중점을 둡니다. 이 기능은 알림 설정이나 기본 정보 가져오기[xlam_single_tool_single_call]와 같은 실제 애플리케이션에서 간단한 자동화된 작업에 매우 중요합니다.

- 도구 선택 시나리오: 여러 도구 옵션 중에서 올바른 도구를 선택할 수 있는 모델의 능력을 평가합니다. 이 차원에서는 모델이 도구 설명서를 이해하고 도구의 적합성에 대해 합리적인 결정을 내릴 수 있는 정도를 평가합니다. 다목적 인텔리전스를 구축하는 실제 애플리케이션 시나리오에서는 이 능력이 매우 중요합니다[xlam_multiple_tool_single_call].

- 병렬 실행 시나리오: 모델이 여러 도구를 동시에 함께 작동하도록 프로그래밍할 수 있는지 살펴봅니다. 이 차원은 실제 애플리케이션의 효율성을 개선하는 데 매우 중요합니다 [xlam_multiple_tool_multiple_call].

- 도구 재사용 시나리오: 배치 작업 및 매개변수 변형을 효율적으로 처리하는 인텔리전스의 능력을 평가합니다. 이 측면은 실제 애플리케이션의 일괄 처리 시나리오에서 특히 중요합니다 [xlam_single_tool_multiple_call].

오류 처리 및 에지 케이스

- 관련성 테스트 시나리오: 테스트 모델이 도구의 한계를 파악하고 사용 가능한 도구가 사용자의 요구와 일치하지 않을 때 합리적으로 소통할 수 있는 능력. 이 기능은 사용자 경험과 시스템 안정성을 확보하는 초석입니다 [BFCL_v3_irrelevance].

- 누락된 도구 처리 시나리오: 필요한 도구를 사용할 수 없는 상황을 모델이 얼마나 우아하게 처리하는지, 사용자에게 한계를 알리고 대안을 제공하는 기능[xlam_tool_miss, BFCL_v3_multi_turn_miss_func]을 포함하여 검토합니다.

컨텍스트 관리(컴퓨팅)

- 긴 컨텍스트 시나리오: 장거리 대화에서 문맥의 일관성을 유지하고 복잡한 지시를 이해하는 모델의 능력을 평가합니다. 이 능력은 복잡한 워크플로우와 긴 상호 작용을 처리하는 데 매우 중요합니다[tau_long_context, BFCL_v3_multi_turn_long_context].

다층적 상호 작용

- 기본 대화 시나리오: 대화형 함수 호출을 수행하고 다회전 대화에서 컨텍스트를 유지하는 인텔리전스의 능력을 테스트합니다. 이 기본 능력은 대화형 애플리케이션을 개발하는 데 매우 중요합니다[BFCL_v3_multi_turn_base_single_func_call, toolace_single_func_call].

- 복잡한 상호 작용 시나리오: 여러 과제를 결합하여 복잡한 시나리오에서 지능의 전반적인 견고성과 문제 해결 능력을 종합적으로 테스트합니다 [BFCL_v3_multi_turn_base_multi_func_call, BFCL_v3_multi_turn_composite].

매개변수 관리

- 누락된 매개변수 시나리오: 모델이 정보가 불완전한 상황을 처리하는 방법과 필요한 매개변수를 수집하기 위해 사용자와 얼마나 효과적으로 상호 작용하는지를 검토합니다[BFCL_v3_multi_turn_miss_param].

커뮤니티 연구와 애플리케이션 개발을 촉진하기 위해 데이터세트를 오픈소스화한 Hugging Face - Hugging Face 상담원 순위표 데이터 세트

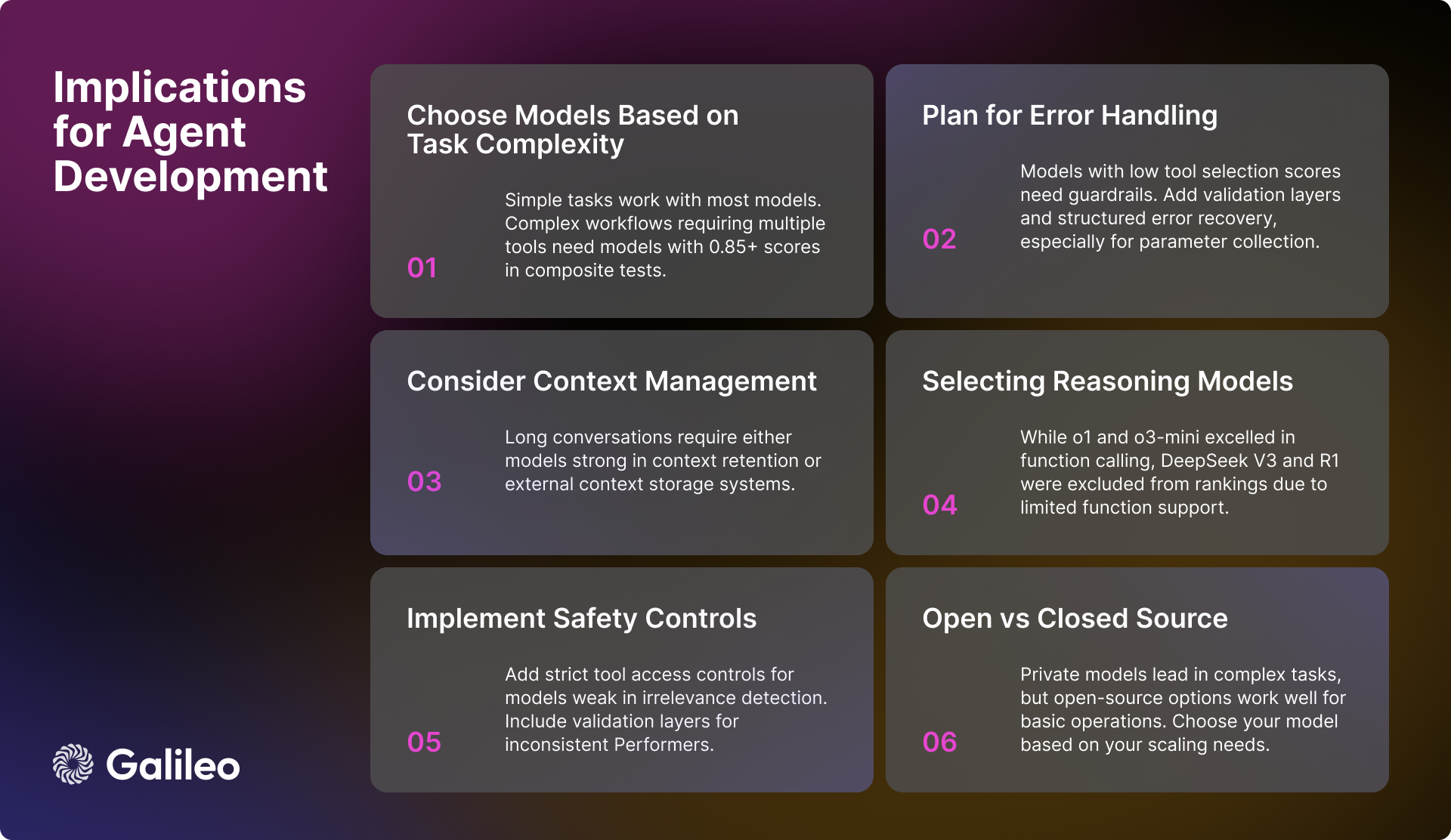

AI 엔지니어를 위한 실질적인 시사점

허깅 페이스의 평가 결과는 AI 엔지니어가 AI 지능을 개발할 때 많은 유용한 통찰력을 제공합니다. 강력하고 효율적인 지능형 신체 시스템을 구축할 때는 다음과 같은 핵심 요소를 고려해야 합니다:

모델 선택 및 성능

복잡한 워크플로우를 처리해야 하는 애플리케이션의 경우 복합 작업에서 0.85점 이상의 고성능 모델을 선택하는 것이 중요합니다. 대부분의 모델이 기본적인 도구 호출 작업을 수행할 수 있지만 병렬 작업을 처리할 때는 전체 성능 메트릭에만 의존하기보다는 특정 작업에 대한 모델의 실행 점수에 집중하는 것이 더 중요합니다.

컨텍스트 및 오류 관리

긴 컨텍스트 시나리오에서 제대로 작동하지 않는 모델의 경우 효과적인 컨텍스트 요약 전략을 구현하는 것이 중요합니다. 관련성 감지 또는 매개변수 처리에서 단점이 있는 모델을 선택한 경우에는 강력한 오류 처리 메커니즘을 구축해야 합니다. 매개변수 수집에 추가 지원이 필요한 모델의 경우 사용자가 필요한 매개변수 정보를 제공하도록 안내하는 구조화된 워크플로우를 고려할 수 있습니다.

안전 및 신뢰성

시스템의 안전성과 신뢰성을 보장하려면 특히 관련 없는 작업을 제대로 감지하지 못하는 모델의 경우 도구에 대한 엄격한 액세스 제어를 구현하는 것이 중요합니다. 성능 안정성이 불충분한 모델의 경우 시스템의 전반적인 안정성을 향상시키기 위해 추가 검증 계층을 추가하는 것을 고려하세요. 특히 누락된 매개변수를 처리하는 데 어려움을 겪는 모델의 경우 오류 복구 시스템을 잘 구축하는 것도 중요합니다.

시스템 성능 최적화

시스템 워크플로 아키텍처를 설계할 때는 병렬 실행과 긴 컨텍스트 시나리오를 처리하는 여러 모델의 능력 차이를 충분히 고려해야 합니다. 일괄 처리 전략을 구현할 때는 시스템의 전반적인 효율성에 직접적인 영향을 미치므로 모델의 도구 재사용 기능을 평가하는 것이 중요합니다.

AI 모델 개발 현황

현재는 여전히 독점 모델이 전반적인 기능을 주도하고 있지만, 오픈 소스 모델의 성능이 빠르게 향상되고 있습니다. 단순한 도구 상호 작용 작업에서는 모든 유형의 모델이 더욱 정교해지고 있습니다. 그러나 복잡한 다원적 상호작용과 긴 컨텍스트 시나리오에서 모델은 여전히 많은 과제에 직면해 있습니다.

다양한 차원에서 모델 성능의 가변성은 특정 사용 사례 요구 사항에 따라 모델을 선택하는 것의 중요성을 강조합니다. 개발자는 모델의 일반적인 성능 메트릭에만 초점을 맞추는 대신 대상 애플리케이션 시나리오에서 모델의 실제 성능을 심층적으로 평가해야 합니다.

허깅 페이스는 이 에이전트 인텔리전스 목록이 개발자에게 유용한 참고 자료가 되기를 바랍니다.

모델 성능 개요

추론 모델

허깅 페이스의 분석에서 흥미로운 현상은 추론 모델의 성능입니다. 비록 o1 노래로 응답 o3-mini 함수 호출 기능 통합에서는 각각 0.876점과 0.847점의 높은 점수를 얻으며 우수한 성능을 보였지만, 허깅 페이스는 다른 추론 모델에서 몇 가지 문제에 직면했습니다. 특히DeepSeek V3 노래로 응답 Deepseek R1 모델은 범용 기능 측면에서 뛰어난 성능을 발휘하지만 현재 버전에서 함수 호출을 제한적으로 지원하기 때문에 허깅 페이스 순위표에서 제외되었습니다.

다음과 같은 점을 강조할 필요가 있습니다. DeepSeek V3 노래로 응답 Deepseek R1 순위에서 제외된 것은 이러한 모델의 우수성을 부정하는 것이 아니라 발표된 모델의 한계를 충분히 이해한 후 내린 신중한 결정입니다. 에서 Deepseek V3 및 Deepseek R1 허깅 페이스에 대한 공식 토론에서 개발자들은 현재 버전의 모델이 아직 함수 호출을 지원하지 않는다는 점을 분명히 했습니다. 허깅 페이스는 해결 방법을 고안하거나 오해의 소지가 있는 성능 지표를 제시하기보다는 네이티브 함수 호출이 지원되는 향후 릴리스를 기다리기로 결정했습니다.

이 경우 적용됨 함수 호출은 모든 고성능 언어 모델에 기본적으로 제공되는 것은 아닌 특수한 기능입니다. 추론 능력이 뛰어난 모델이라도 특별히 설계 및 학습되지 않은 경우 구조화된 함수 호출을 기본적으로 지원하지 않을 수 있습니다. 따라서 특정 사용 사례에 맞는 모델을 철저히 평가해야 최선의 선택을 할 수 있습니다.

엘리트 티어 성능(>= 0.9)

Gemini-2.0-플래시 이 모델은 평균 0.938점의 우수한 점수로 계속해서 선두를 달리고 있습니다. 이 모델은 모든 평가 범주에서 뛰어난 안정성과 일관성을 보여주며, 특히 복합 시나리오(0.95)와 관련성 없는 탐지(0.98)에서 강점을 보였습니다. 백만 건당 토큰 0.15/$0.6 가격.Gemini-2.0-플래시 성능과 비용 효율성 사이의 매력적인 균형.

그 뒤를 이어 GPT-4o이 모델은 0.900점이라는 높은 점수를 얻었으며 다중 도구 처리(0.99) 및 병렬 실행(0.98)과 같은 복잡한 작업에서 우수한 성능을 발휘했습니다. 하지만 GPT-4o 가격은 백만 토큰당 2.5달러/10달러로 상당히 높지만, 우수한 성능은 여전히 높은 비용을 상쇄하고도 남습니다.

고성능 대역(0.85~0.9)

고성능 세그먼트는 몇 가지 강력한 모델에 집중되어 있습니다. Gemini-1.5-플래시 특히 비상관성 감지(0.98)와 단일 기능 성능(0.99)에서 0.895의 우수한 점수를 유지했습니다. Gemini-1.5-pro 백만 토큰당 1.25달러/$5의 높은 가격에도 불구하고 0.885의 높은 점수를 얻었으며, 결합 작업(0.93)과 단일 도구 실행(0.99)에서 상당한 강점을 보여주었습니다.

o1 이 모델은 백만 토큰당 $15/$60의 높은 가격에도 불구하고 0.876의 점수와 업계 최고 수준의 긴 컨텍스트 처리 능력(0.98)으로 시장에서의 입지를 증명하고 있습니다. 신흥 모델 o3-mini 0.847로 경쟁력이 있고, 단일 함수 호출(0.975)과 관련성 감지(0.97)에서 탁월하며, 백만 토큰당 1.1~4.4달러의 가격으로 균형 잡힌 선택지를 제공합니다.

중간 계층 용량(0.8~0.85)

GPT-4o-mini 은 0.832의 효율적인 성능을 유지하며, 특히 병렬 도구 사용(0.99)과 도구 선택에서 우수한 성능을 발휘합니다. 그러나 이 모델은 긴 컨텍스트 시나리오(0.51)에서는 상대적으로 성능이 떨어집니다.

오픈 소스 모델링 진영에서는mistral-small-2501 0.832점으로 선두를 차지한 이 모델은 이전 버전에 비해 긴 컨텍스트 처리(0.92)와 도구 선택 기능(0.99) 모두에서 크게 개선된 것으로 나타났습니다. Qwen-72b 0.817점으로 그 뒤를 바짝 쫓고 있으며, 관련성 없는 탐지(0.99)에서 프라이빗 모델과 일치하고 강력한 긴 컨텍스트 처리(0.92)를 보여줍니다. 미스트랄-대형 도구 선택은 잘 수행하지만(0.97), 작업 통합에는 여전히 어려움을 겪고 있습니다(0.76).

클로드 소네트 는 0.801점을 획득하여 도구 삭제 탐지(0.92)와 단일 기능 처리(0.955)에서 우수한 성적을 거두었습니다.

베이스 레이어 모델(0.8 미만)

기본 계층 모델은 주로 특정 영역에서는 우수한 성능을 보였지만 전체 점수는 상대적으로 낮은 모델로 구성되었습니다. 클로드 하이쿠 0.765의 점수로 더욱 균형 잡힌 성능을 제공하며, 백만 토큰당 0.8달러/$4의 가격으로 뛰어난 비용 효율성을 보여줍니다.

오픈 소스 모델 Llama-70B 은 0.774의 잠재력을 보여주며, 특히 멀티 툴 시나리오(0.99)에서 더욱 두드러집니다. 반면 미스트랄-스몰 (0.750), 미스트랄-8b (0.689) 및 미스트랄 네모 (0.661) 및 기타 소규모 변형 모델은 기본 작업 시나리오에서 사용자에게 효율적인 옵션을 제공합니다.

이러한 데이터 세트는 언어 모델링 도구의 호출 기능을 종합적으로 평가하기 위한 프레임워크를 구축하는 데 필수적입니다.

댓글: 허깅페이스가 출시한 에이전트 지능형 바디 랭킹은 현재 빅 데이터 언어 모델 애플리케이션의 핵심 문제인 도구를 효율적으로 사용하는 방법을 정확하게 포착하고 있습니다. 오랫동안 업계의 관심은 모델 자체의 능력에 집중되어 왔지만, 모델이 실제로 구현되고 실제 문제를 해결하기 위해서는 도구 호출 능력이 핵심입니다. 이 순위의 등장은 개발자가 특정 애플리케이션 시나리오에 가장 적합한 모델을 선택하는 데 도움이 되는 귀중한 참고 자료를 제공할 것입니다. 평가 방법론부터 데이터 세트 구축, 최종 성능 분석에 이르기까지 허깅 페이스의 보고서는 엄격하고 세심한 전문성을 보여줄 뿐만 아니라 AI 애플리케이션 구현을 촉진하기 위한 적극적인 노력을 반영하고 있습니다. 특히 모델의 절대적인 성능에만 초점을 맞춘 것이 아니라 실제 애플리케이션에서 중요한 고려 사항인 긴 컨텍스트 처리 및 다중 도구 호출과 같은 다양한 시나리오에서 모델의 성능을 분석하여 순위를 매겼다는 점은 높이 평가할 만합니다. 또한 허깅 페이스는 평가 데이터 세트를 아낌없이 오픈소스화하여 도구 호출 기능에 대한 커뮤니티의 연구 개발을 더욱 촉진할 것입니다. 전반적으로 이것은 매우 시의적절하고 가치 있는 노력입니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...