일반 소개

플로우다운 앱은 가볍고 효율적인 인공지능 대화 클라이언트로, 사용자에게 빠르고 원활한 지능형 대화 경험을 제공하기 위해 스위프트와 UIKit을 사용하는 개발자 팀이 개발했습니다. 이 앱은 표준 버전(FlowDown)과 커뮤니티 버전(FlowDown 커뮤니티)으로 나뉩니다. 플로우다운은 모든 OpenAI 호환 서비스 인터페이스를 지원하고, 사용자가 자신의 LLM(대규모 언어 모델)에 액세스할 수 있으며, 데이터 보안을 보장하기 위해 개인정보 보호를 염두에 두고 설계되었습니다. 데이터 보안을 보장합니다. FlowDown의 가장 큰 장점은 원활한 대화 환경을 위한 매우 빠른 텍스트 렌더링입니다.

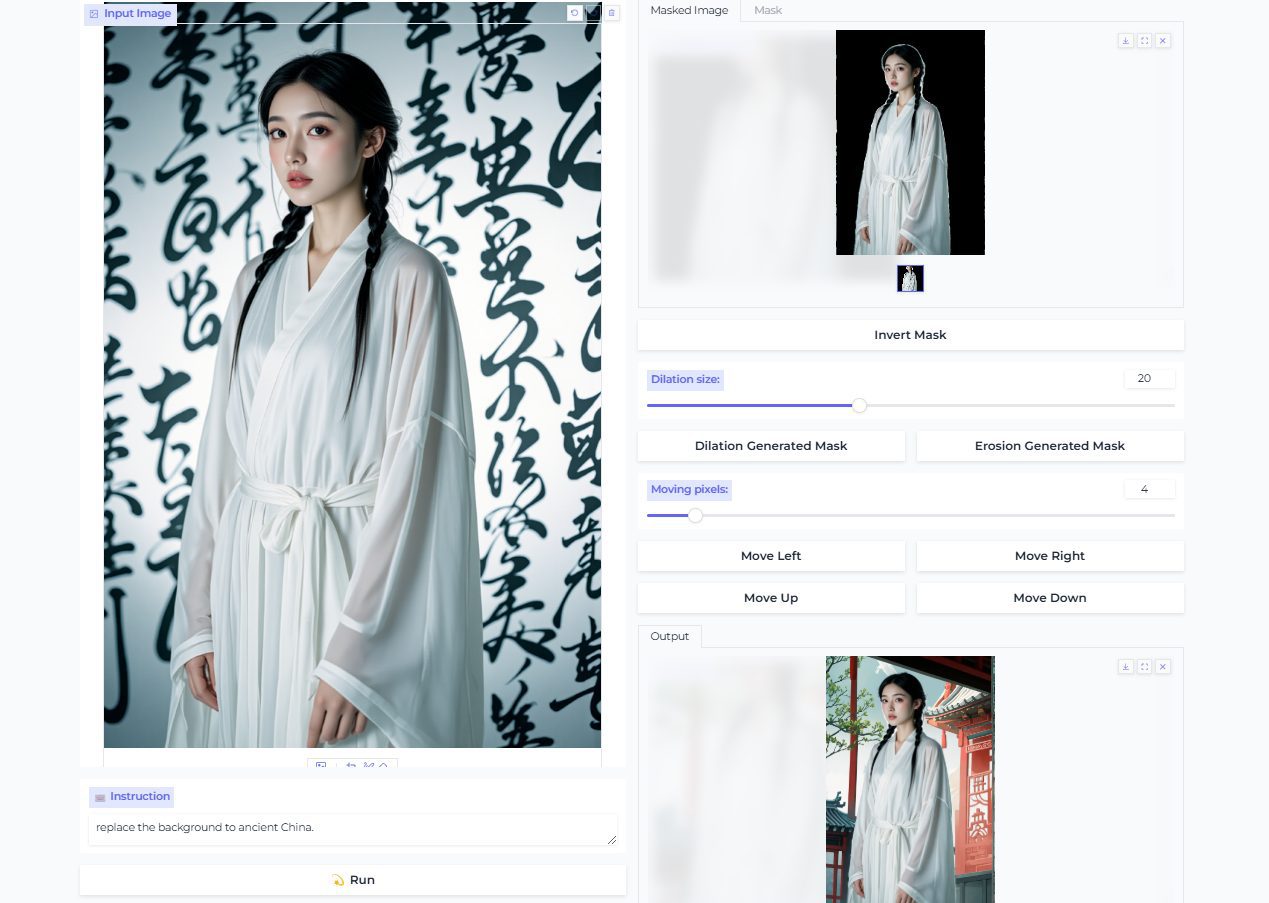

FlowDown macOS 인터페이스

FlowDown IOS 인터페이스

기능 목록

- 매우 빠른 텍스트 렌더링대화 텍스트가 거의 지연 없이 표시되어 원활한 환경을 제공합니다.

- 마크다운 지원읽기 쉽고 정리하기 쉽도록 서식 있는 텍스트 형식으로 출력합니다.

- 범용 호환성모든 OpenAI 호환 서비스 제공업체가 지원됩니다.

- 설계에 따른 개인 정보 보호사용자 데이터는 기본적으로 수집되지 않으며, 대화는 로컬에 유지됩니다.

- 자동 채팅 헤더대화 제목을 지능적으로 생성하여 관리 효율성을 개선합니다.

- LLM 지원 제공표준 버전은 오프라인 LLM(MLX 기반)과 시각적 LLM을 모두 지원합니다.

- 첨부 파일 업로드표준 버전은 AI와 상호 작용할 수 있는 파일 업로드를 지원합니다.

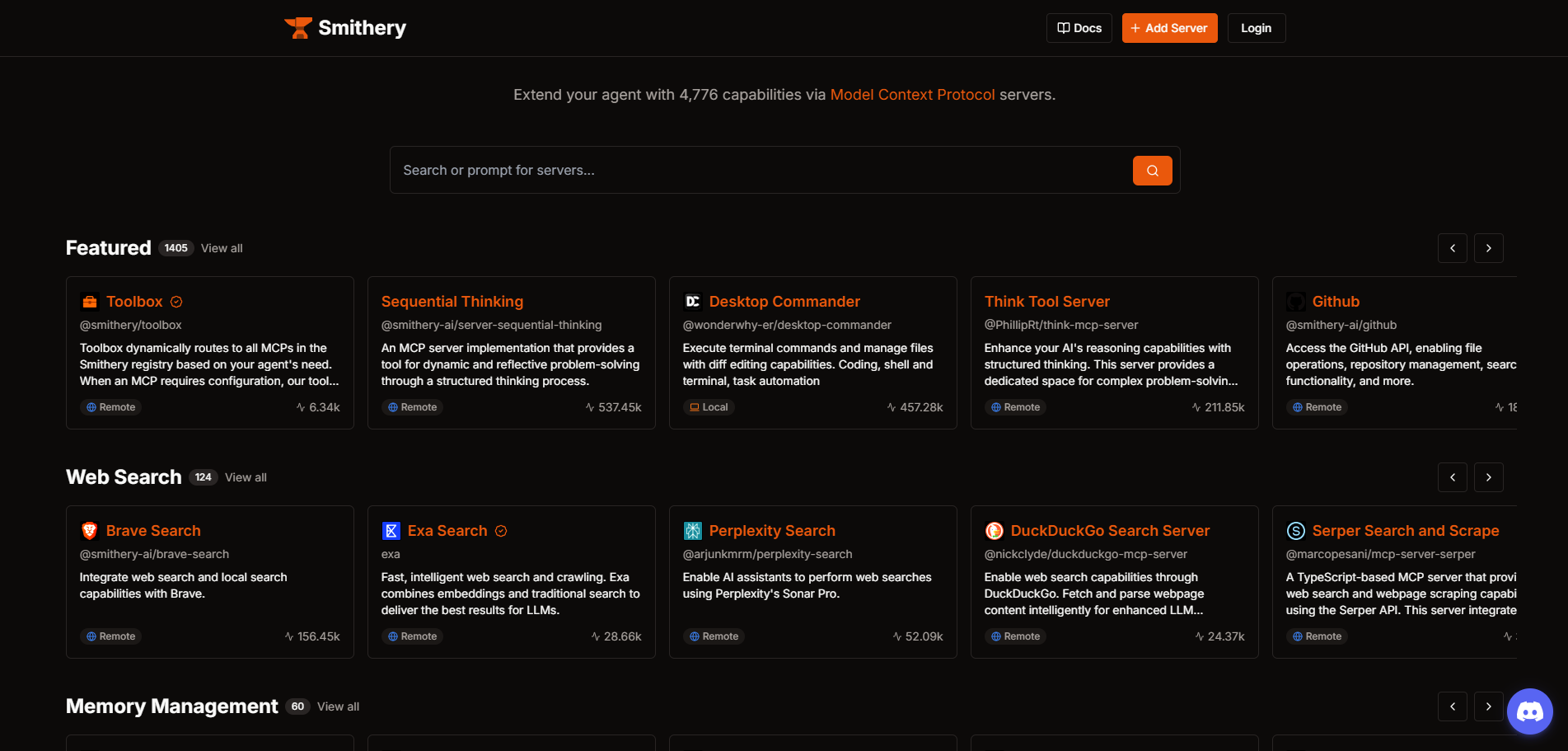

- 웹 검색표준 버전에는 정보에 대한 접근성을 높이기 위해 검색 기능이 내장되어 있습니다.

도움말 사용

설치 프로세스

FlowDown은 App Store에서 표준 버전을 다운로드하거나 GitHub에서 커뮤니티 에디션 소스 코드를 다운로드하는 두 가지 방법으로 사용할 수 있습니다. 자세한 설치 단계는 다음과 같습니다:

표준(플로우다운)

- 시스템 요구 사항::

- iOS 16.0 이상(iPhone 및 iPad 지원).

- macOS 13.0 이상.

- 앱 다운로드::

- App Store를 열고 "FlowDown"을 검색합니다.

- '받기' 버튼을 클릭하여 다운로드 및 설치를 완료합니다.

- 애플리케이션 실행::

- 설치가 완료되면 앱 아이콘을 클릭하여 열면 무료 클라우드 모델이 처음으로 자동으로 구성됩니다.

커뮤니티 에디션(플로우다운 커뮤니티)

- 시스템 요구 사항표준과 동일, 종속성은 GitHub를 참조하세요.

- 소스 코드 다운로드::

- https://github.com/Lakr233/FlowDown-App 방문하기.

- '코드' 버튼을 클릭하고 'ZIP 다운로드'를 선택하거나 Git 명령을 사용합니다:

git clone https://github.com/Lakr233/FlowDown-App.git

- 환경 준비::

- Xcode(Swift 개발용)가 설치되어 있는지 확인합니다.

- 터미널을 열고 프로젝트 디렉토리로 이동하여 종속성 설치(있는 경우)를 실행합니다:

pod install # 若使用 CocoaPods

- 빌드 및 실행::

- Xcode로 열기

.xcodeproj문서화. - 대상 기기(에뮬레이터 또는 실제 기기)를 선택하고 '실행' 버튼을 클릭하여 컴파일 및 실행합니다.

- Xcode로 열기

주요 기능

마크다운을 지원하는 매우 빠른 텍스트 렌더링

- 애플리케이션 실행플로우다운을 열고 메인 화면으로 이동합니다.

- 입력 문제: 대화 상자에 텍스트를 입력합니다(예: "마크다운 형식으로 메모 작성").

- 댓글 받기보내기를 클릭하면 AI가 반환한 마크다운 형식의 텍스트가 빠른 속도로 렌더링되며 헤드라인, 목록 등이 명확하게 렌더링됩니다.

- 디스플레이 조정하기텍스트 영역을 길게 눌러 글꼴 크기를 조정하거나 콘텐츠를 복사합니다.

사용자 지정 LLM 서비스 액세스

- 설정으로 이동::

- 오른쪽 상단의 톱니바퀴 아이콘을 클릭하여 설정 페이지로 들어갑니다.

- 서비스 추가::

- 예를 들어 AI 서비스 연결을 선택하고 OpenAI 호환 API 키와 엔드포인트를 입력합니다:

API Key: sk-xxxxxxxxxxxxxxxxxxxx Endpoint: https://api.openai.com/v1

- 예를 들어 AI 서비스 연결을 선택하고 OpenAI 호환 API 키와 엔드포인트를 입력합니다:

- 연결 테스트::

- '테스트'를 클릭하여 서비스를 사용할 수 있는지 확인한 후 저장합니다.

- 모델 전환::

- 대화 화면에서 새로 추가된 서비스를 선택하여 시작하세요.

자동 채팅 헤더

- 새 대화 시작하기::

- '새 대화' 버튼을 클릭하고 질문을 입력합니다.

- 제목 생성::

- 시스템은 '마크다운 노트 작성'과 같은 입력 내용에 따라 자동으로 제목을 생성합니다.

- 경영진 대화::

- 왼쪽 목록에서 모든 대화를 보고 제목을 클릭하면 대화 간에 빠르게 전환할 수 있습니다.

주요 기능

매우 빠른 텍스트 렌더링

- 운영 경험: 질문을 입력하면 응답 텍스트가 로드될 때까지 기다릴 필요 없이 거의 즉시 표시됩니다.

- 사용 시나리오영감에 대한 빠른 메모나 긴 대화 작업 등 실시간 상호작용이 필요한 사용자에게 이상적입니다.

- 최적화 조정설정에서 렌더링 우선순위를 조정하여 저사양 기기에서도 원활하게 작동하도록 할 수 있습니다.

설계에 따른 개인 정보 보호

- 로컬 스토리지대화 데이터는 기본적으로 디바이스에 저장되며 클라우드에 업로드되지 않습니다.

- 서비스 옵션데이터 유출을 방지하기 위해 사용자가 LLM 서비스를 수동으로 지정할 수 있습니다.

- 개인정보 취급방침 보기설정 페이지에서는 데이터 처리 방식에 대한 자세한 설명에 대한 링크를 제공합니다.

스탠다드 에디션 독점 기능: 오프라인 LLM 및 첨부 파일 업로드

- 오프라인 LLM(MLX 기반)::

- 설정에서 '로컬 모델'을 선택합니다.

- 지원되는 MLX 모델 파일을 다운로드합니다(공식 문서 필요).

- 인터넷 없이도 모델을 가져와 오프라인에서 사용할 수 있습니다.

- 첨부 파일 업로드::

- 대화 상자 옆에 있는 '+' 버튼을 클릭합니다.

- 파일(이미지, PDF 등)을 선택하고 업로드한 다음 '이 이미지 분석하기'와 같은 명령을 입력합니다.

- AI는 대화 영역에 표시되는 분석 결과를 반환합니다.

웹 검색(표준 버전)

- 검색 활성화::

- 대화 상자에 질문을 입력한 후 '검색' 아이콘을 클릭합니다.

- 결과 얻기::

- 시스템은 AI 응답에 통합된 웹 페이지 정보를 반환합니다.

- 경험 최적화::

- 설정에서 검색 우선순위를 조정하거나 이 기능을 끌 수 있습니다.

사용 권장 사항

- 네트워크 환경클라우드 기반 모델 사용 시 네트워크 안정성 유지.

- 하드웨어 요구 사항오프라인 LLM에는 고성능 장치가 필요하며, 최소 8GB의 RAM이 권장됩니다.

- 문서에 액세스문제가 발생하면 공식 가이드(https://apps.qaq.wiki/docs/flowdown/)를 참조하세요.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...