일반 소개

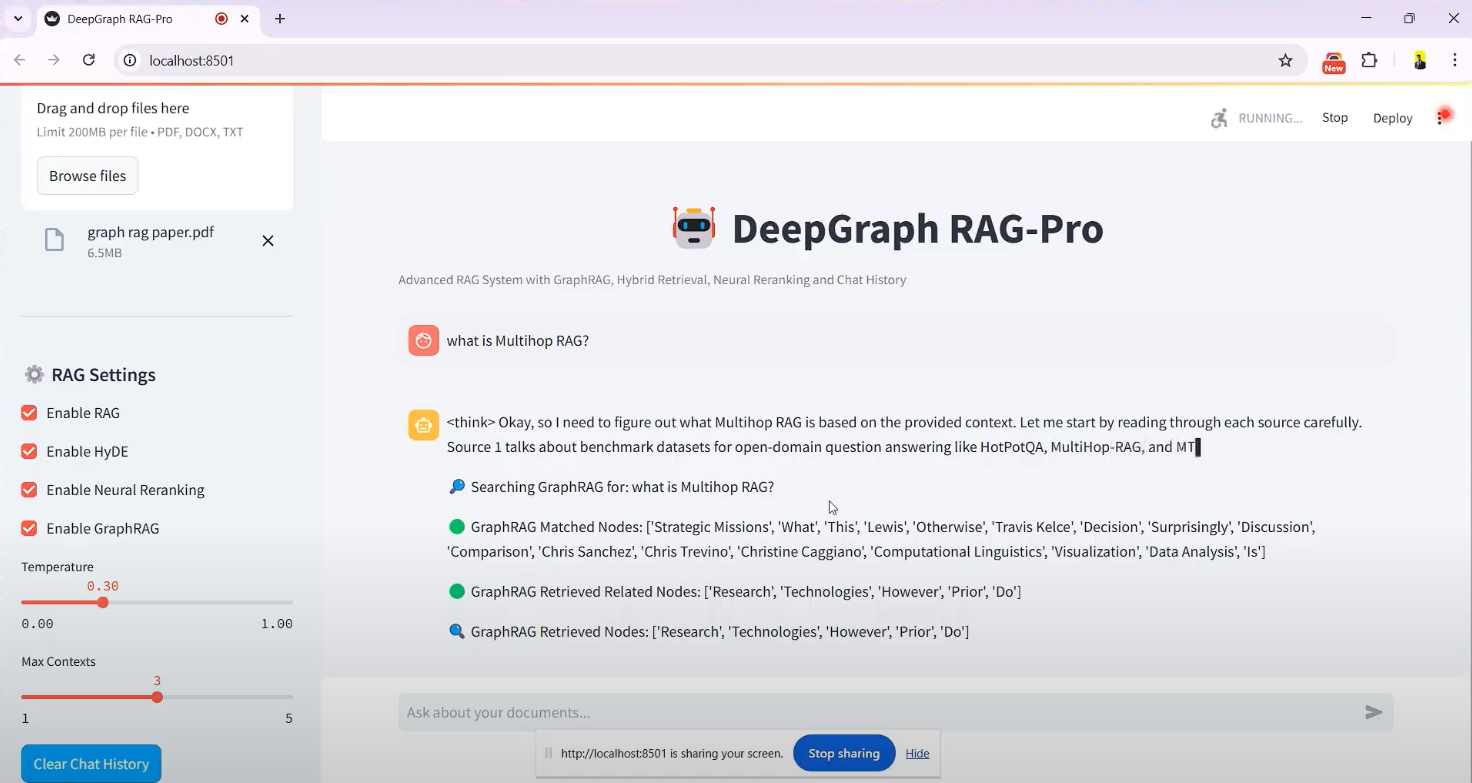

딥시크-RAG-챗봇은 다음을 기반으로 하는 시스템입니다. DeepSeek R1 모델 구축 오픈 소스 챗봇 프로젝트로, 개발자 SaiAkhil066이 만든 GitHub에서 호스팅됩니다. 검색 증강 생성(RAG) 기술을 결합하여 사용자가 문서(예: PDF, DOCX 또는 TXT 파일)를 업로드하여 로컬에서 실행함으로써 효율적인 문서 검색과 지능형 Q&A를 달성할 수 있도록 지원합니다. 이 프로젝트는 하이브리드 검색(BM25 + FAISS), 신경 재정렬, 지식 그래프(GraphRAG) 등의 고급 기능을 활용하여 문서에서 문맥상 정확하고 관련성 있는 정보를 추출합니다. 개인 지식 관리 및 기업 문서 처리와 같이 개인 정보 보호 또는 오프라인 사용이 필요한 시나리오에 적합합니다. 이 프로젝트는 설치가 쉽고 사용자가 쉽게 시작할 수 있는 Docker 및 Streamlit 인터페이스를 지원합니다.

기능 목록

- 문서 업로드 및 처리PDF, DOCX, TXT 등의 파일 업로드, 문서 자동 분할 및 벡터 임베딩 생성 기능을 지원합니다.

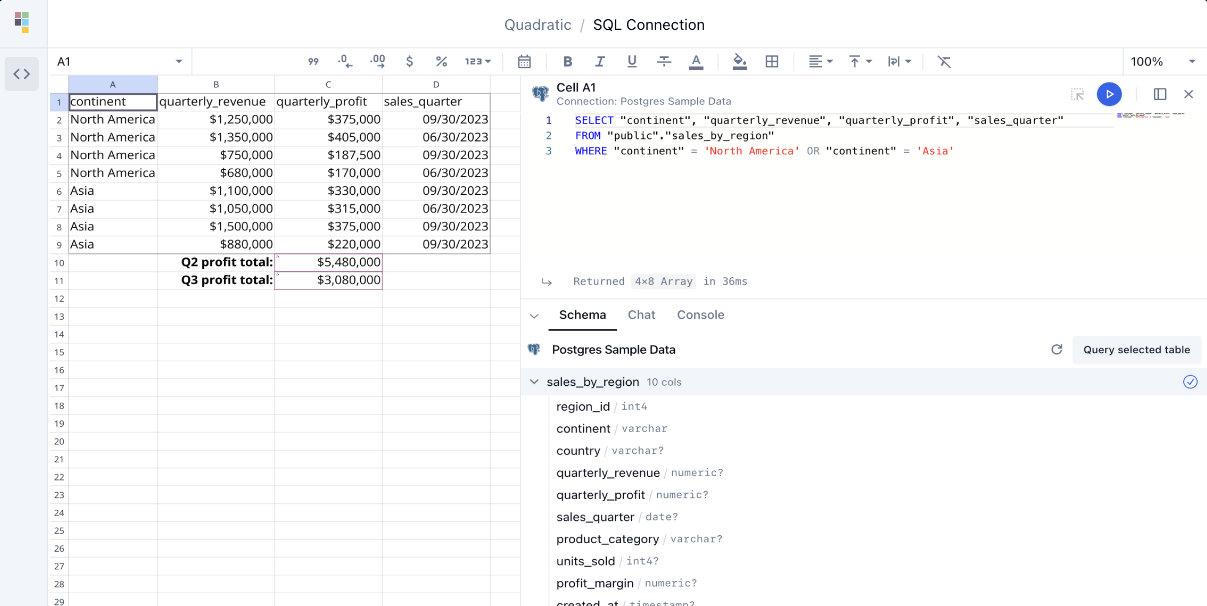

- 하이브리드 검색 메커니즘와 함께 BM25 및 FAISS 기술을 통해 문서에서 관련 콘텐츠를 빠르게 검색할 수 있습니다.

- 지식 그래프 지원(GraphRAG)문서 지식 그래프를 구축하여 엔티티 관계를 이해하고 답변의 문맥적 정확성을 개선합니다.

- 신경 재정렬가장 관련성이 높은 정보가 먼저 표시되도록 크로스 코더 모델을 사용하여 검색 결과의 순서를 다시 지정합니다.

- 쿼리 확장(HyDE)가상 답변 생성: 사용자 쿼리를 확장하고 검색 회상률을 높이기 위해 가상 답변을 생성합니다.

- 로컬 모델 실행통해 Ollama 지원 DeepSeek R1 및 기타 모델은 데이터 프라이버시를 보장하기 위해 로컬에 배포됩니다.

- 실시간 응답 스트리밍사용자가 생성된 결과를 즉시 확인할 수 있도록 스트리밍 출력이 제공됩니다.

- 도커 지원Docker 컨테이너형 배포로 설치 및 운영을 간소화하세요.

- 스트림라이트 인터페이스간편한 파일 업로드와 대화형 채팅을 위한 직관적인 그래픽 인터페이스.

도움말 사용

설치 프로세스

DeepSeek-RAG-Chatbot은 로컬 작업을 지원하며 몇 가지 환경 구성이 필요합니다. 다음은 자세한 설치 단계입니다:

사전 조건

- 운영 체제Windows, macOS 또는 Linux.

- 하드웨어 요구 사항최소 8GB RAM(16GB 권장) 및 GPU 가속을 사용하는 경우 CUDA 지원 그래픽 카드가 필요합니다.

- 소프트웨어 종속성Python 3.8+, Git, Docker(선택 사항).

1단계: 프로젝트 복제

- 터미널을 열고 다음 명령을 실행하여 GitHub 리포지토리를 복제합니다:

git clone https://github.com/SaiAkhil066/DeepSeek-RAG-Chatbot.git

- 프로젝트 카탈로그로 이동합니다:

cd DeepSeek-RAG-Chatbot

2단계: Python 환경 설정하기

- 가상 환경을 만듭니다:

python -m venv venv

- 가상 환경을 활성화합니다:

- Windows:

venv\Scripts\activate - macOS/Linux:

source venv/bin/activate

- pip를 업그레이드하고 종속 요소를 설치하세요:

pip install --upgrade pip

pip install -r requirements.txt

종속성은 다음과 같습니다. streamlit및langchain및faiss-gpu(GPU가 있는 경우) 등입니다.

3단계: Ollama 설치 및 구성하기

- Ollama를 다운로드하여 설치합니다(설치 패키지는 ollama.com을 방문하세요).

- DeepSeek R1 모델을 가져옵니다(기본 7B 매개변수, 필요에 따라 1.5B 또는 32B와 같은 다른 버전도 사용 가능):

ollama pull deepseek-r1:7b

ollama pull nomic-embed-text

- 올라마 서비스가 실행 중이고 기본 수신 주소가 다음과 같은지 확인합니다.

localhost:11434.

4단계: (선택 사항) Docker 배포

환경을 수동으로 구성하고 싶지 않다면 Docker를 사용할 수 있습니다:

- Docker를 설치합니다(docker.com 참조).

- 프로젝트 루트 디렉토리에서 실행합니다:

docker-compose up

- Docker는 자동으로 Ollama 및 챗봇 서비스를 가져와 실행한 다음

http://localhost:8501.

5단계: 애플리케이션 실행

- 가상 환경에서 Streamlit을 실행합니다:

스트림라이트 실행 app.py

- 브라우저에서 자동으로

http://localhost:8501을 클릭하고 채팅 화면으로 들어갑니다.

작동 기능

기능 1: 문서 업로드

- 인터페이스로 이동하기시작하면 스트림릿 인터페이스의 화면 왼쪽에 '문서 업로드' 사이드바가 있습니다.

- 파일 선택'파일 찾아보기' 버튼을 클릭하여 로컬 PDF, DOCX 또는 TXT 파일을 선택합니다.

- 문서 처리업로드되면 시스템이 자동으로 문서를 작은 덩어리로 분할하고 벡터 임베딩을 생성하여 FAISS에 저장합니다. 처리 시간은 파일 크기에 따라 다르며 일반적으로 몇 초에서 몇 분 정도 걸립니다.

- STH에 주목하세요.사이드바에 "파일 처리 완료" 확인 메시지가 표시됩니다.

기능 2: 질문 및 검색

- 입력 문제채팅창에 중국어 또는 영어로 질문을 입력합니다(예: "문서에 언급된 GraphRAG의 목적은 무엇인가요?"). 문서에 나와 있습니다.

- 검색 프로세스::

- 이 시스템은 BM25와 FAISS를 사용하여 관련 문서 조각을 검색합니다.

- GraphRAG는 조각 간의 개체 관계를 분석합니다.

- 신경 재정렬은 결과의 순서를 최적화합니다.

- HyDE는 더 많은 관련 콘텐츠를 포함하도록 쿼리를 확장합니다.

- 답변 생성딥서치 R1은 검색 결과를 기반으로 답변을 생성하며, 답변은 스트리밍 형식으로 출력되어 인터페이스에 단계별로 표시됩니다.

- 일반적인 예"하이브리드 검색이란 무엇인가요?"라고 질문하면 "하이브리드 검색은 BM25와 FAISS를 결합한 것으로, BM25는 키워드 매칭을 담당하고 FAISS는 벡터 유사성을 통해 콘텐츠를 빠르게 찾습니다."라고 응답할 수 있습니다.

기능 3: 지식 그래프 애플리케이션

- GraphRAG 활성화기본적으로 활성화되어 있으며 추가 조치가 필요하지 않습니다.

- 복잡한 질문하기예를 들어, "A 회사와 B 회사의 협력 관계는 무엇인가요?". .

- 결과 쇼케이스이 시스템은 텍스트를 반환할 뿐만 아니라 지식 그래프를 기반으로 관계형 답변(예: "A사와 B사는 2023년에 기술 협력 계약을 체결했습니다")도 제공합니다.

기능 4: 모델 및 매개변수 조정

- 교체 모델: in

.env파일에서 수정MODEL매개변수, 예를 들어deepseek-r1:1.5b. - 성능 최적화하드웨어에서 지원하는 경우

faiss-gpuGPU 가속을 활성화하면 검색 속도를 최대 3배까지 높일 수 있습니다.

팁 및 유용한 정보

- 다중 문서 지원여러 파일을 동시에 업로드할 수 있으며 시스템에서 콘텐츠를 통합하여 질문에 답변합니다.

- 문제의 명확성답변의 정확성을 높이기 위해 질문할 때는 가능한 한 구체적으로 질문하고 모호한 표현은 피하세요.

- 로그 확인오류가 발생하면 터미널 로그를 확인하여 모델이 다운로드되지 않았거나 포트가 사용 중이라는 등의 문제를 해결할 수 있습니다.

주의

- 개인정보 보호로컬 작동을 위해 인터넷 연결이 필요하지 않으며 데이터가 클라우드에 업로드되지 않습니다.

- 리소스 점유큰 모델과 고차원 벡터 계산에는 많은 메모리가 필요하므로 관련 없는 프로그램을 닫는 것이 좋습니다.

- 모델 업데이트하기정기 운영

ollama pull최신 버전의 DeepSeek 모델을 다운로드하세요.

위의 단계가 완료되면 사용자는 브라우저를 통해 DeepSeek-RAG-Chatbot과 상호 작용하여 효율적인 문서 퀴즈 경험을 즐길 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...