속독

경험:DeepSeek 공식 웹사이트: chat.deepseek.com DeepSeek-R1과 채팅하고 '딥씽킹' 버튼을 켭니다. 방문 OpenAI 형식과 호환되는 API .

복지:무료 GPU 성능으로 딥시크-R1 오픈 소스 모델을 온라인으로 배포하기 및100$ DeepSeek-R1 크레딧 제공및DeepSeek-R1 정식 버전을 무료로 사용하는 상위 5가지 AI 추론 플랫폼

재발:최근 재생산 시도 DeepSeek-R1에 대한 프로젝트가 꽤 많이 있으므로 다음 글을 계속 주시하세요:TinyZero: 딥시크-R1 제로의 깨달음 효과를 저렴한 비용으로 재현한 제품 및Open R1: 딥시크-R1 훈련 프로세스를 복제하는 허깅 페이스 및DeepSeek-R1 복제: 8K 수학적 예제를 통해 소규모 모델이 강화 학습을 통해 추론의 혁신을 이룰 수 있도록 지원합니다. 더 많은 기능이 있습니다:R1 오버씽커: 딥시크 R1 모델이 더 오래 생각하도록 만들기 .

요약:컨텍스트 길이: 128K, 출력 토큰 백만 개당 2.19달러(대형 모델 세계에서는 파운드 랜드), OpenAI-o1과 동등한 성능, 모든 오픈 소스 모델을 자유롭게 증류하여 상업적으로 사용, 글쓰기를 위한 상상력이 풍부한 프런트엔드 기능.

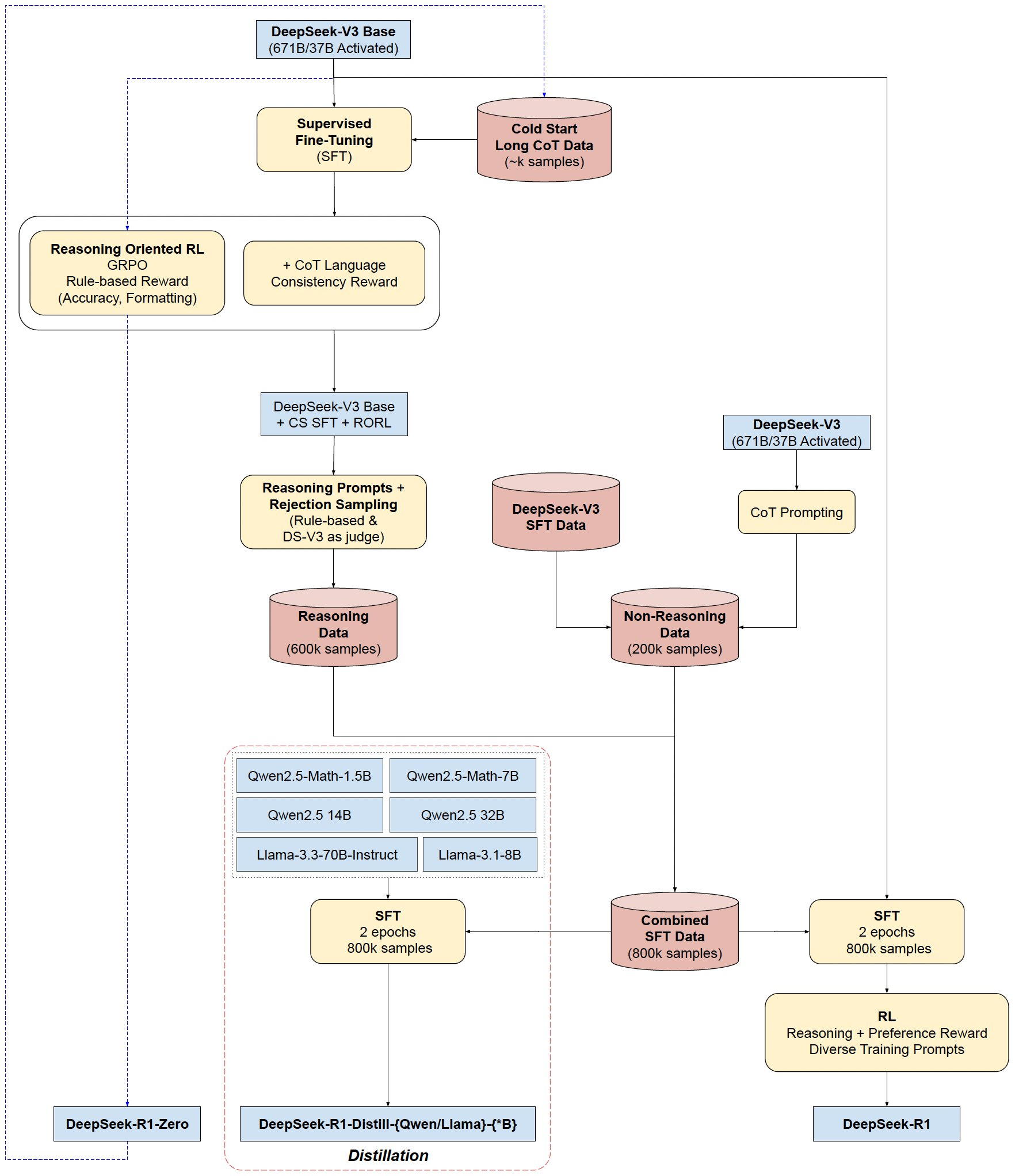

기본 모델: DeepSeek-R1-Zero와 DeepSeek-R1은 모두 DeepSeek-V3-Base를 기반으로 학습되며, DeepSeek-R1은 소량의 긴 CoT 데이터로 강화되어 보다 체계적이고 간결한 출력을 제공합니다.

증류 모델(기존 오픈 소스 미니어처 기능의 전반적인 개선): DeepSeek-R1을 여러 개의 작은 모델로 추출하여 ( Ollama (다운로드 가능)

Qwen2.5-Math-1.5B, Qwen2.5-Math-7B, Qwen2.5-14B, Qwen2.5-32B, Llama-3.1-8B, Llama-3.3-70B-Instruct

DeepSeek-R1(-Zero)의 학습 흐름

- 콜드 스타트: CoT 예제에서 미세 조정하기

- 추론 강화 학습: 언어 일관성 보상 추가하기

- 데이터 생성: 생성됨 80 10,000개의 교육 샘플

- 궁극적인 강화 학습: 혼합 피드백을 통한 균형 잡힌 역량(추론 및 일반 역량 모두) 강화

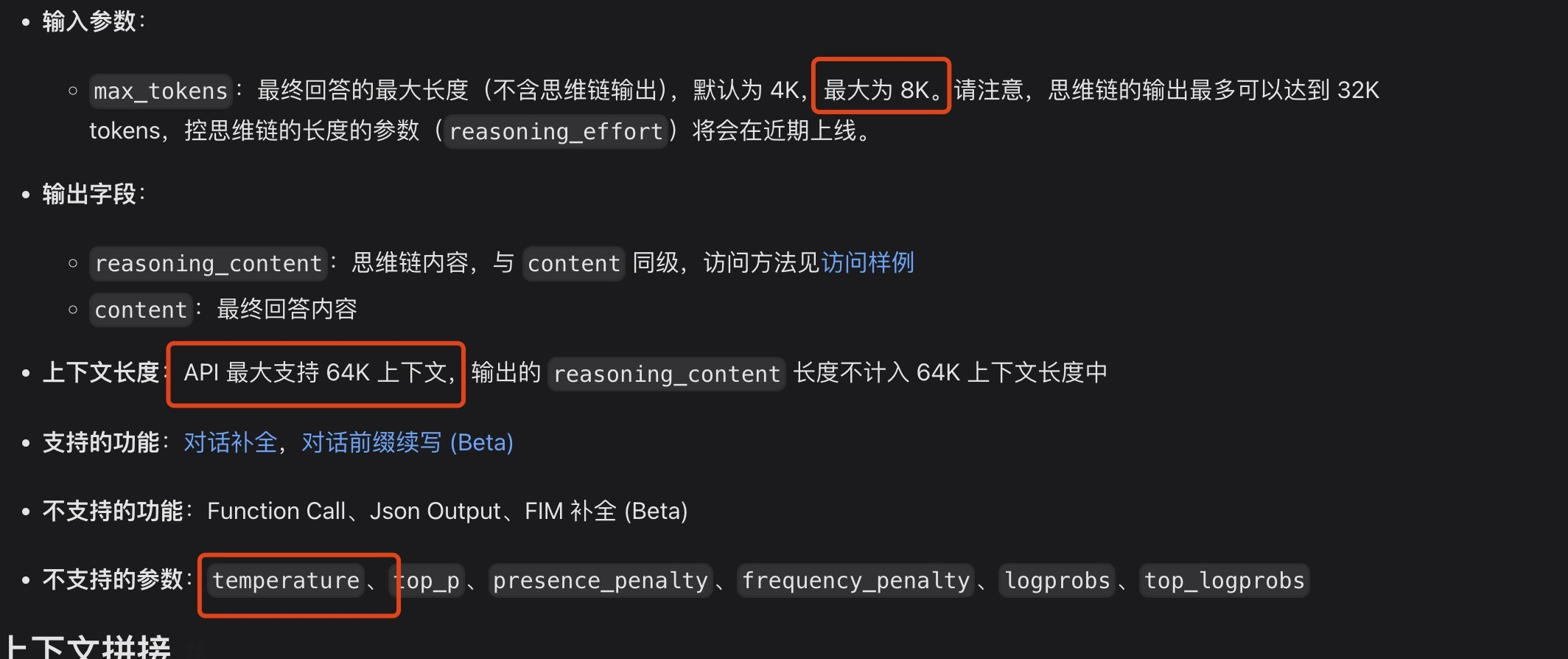

문제, API의 컨텍스트 길이가 프로그래밍에서 충분하지 않을 수 있습니다.

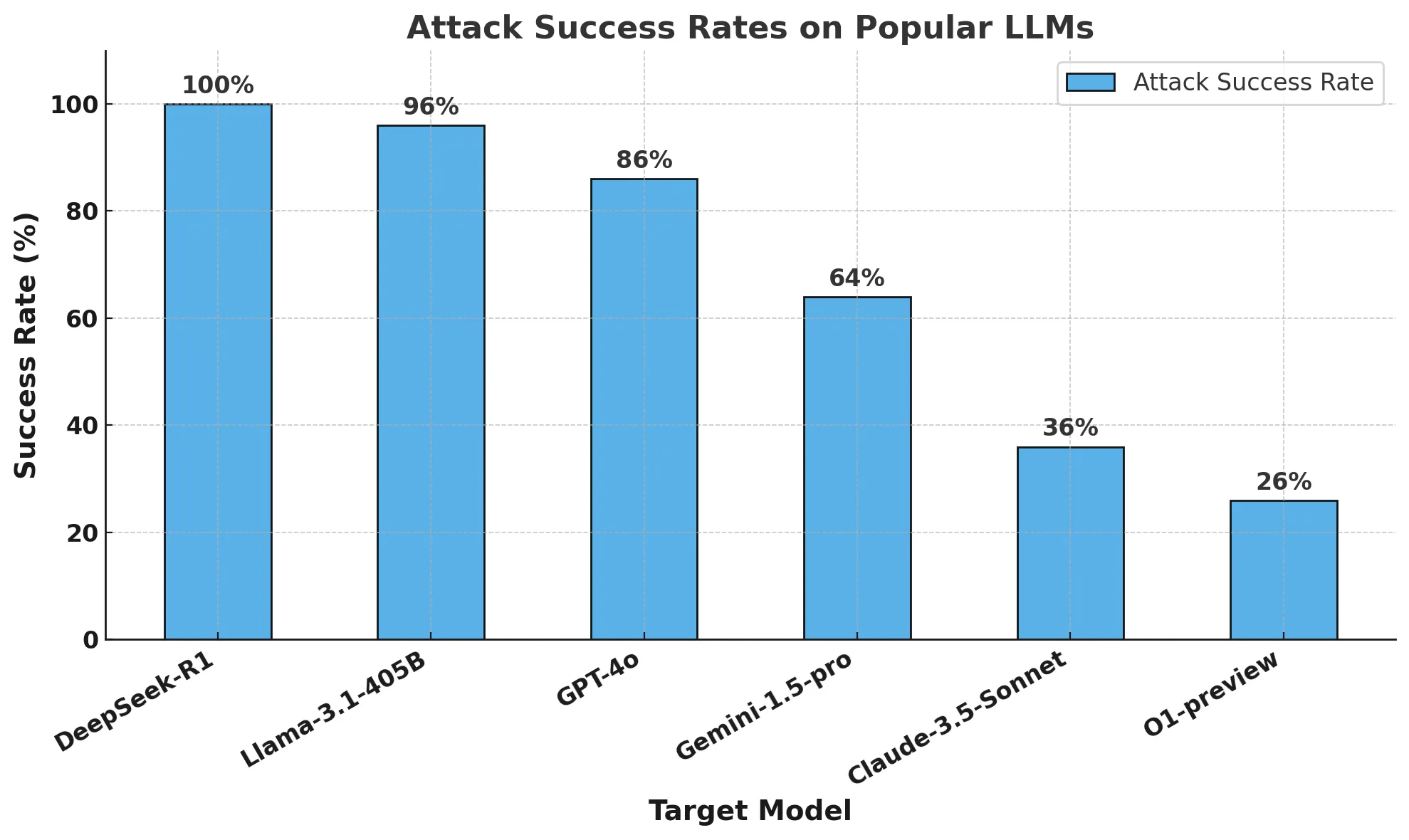

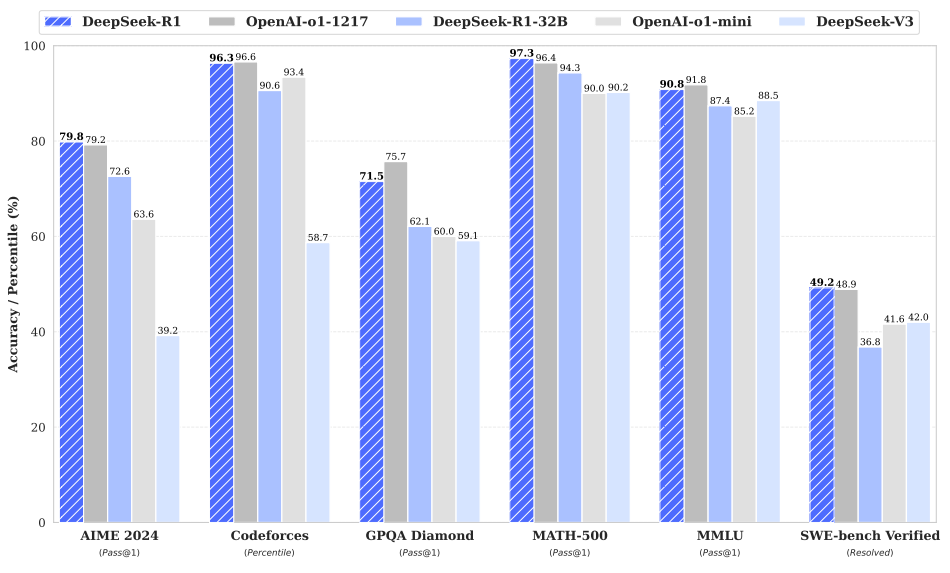

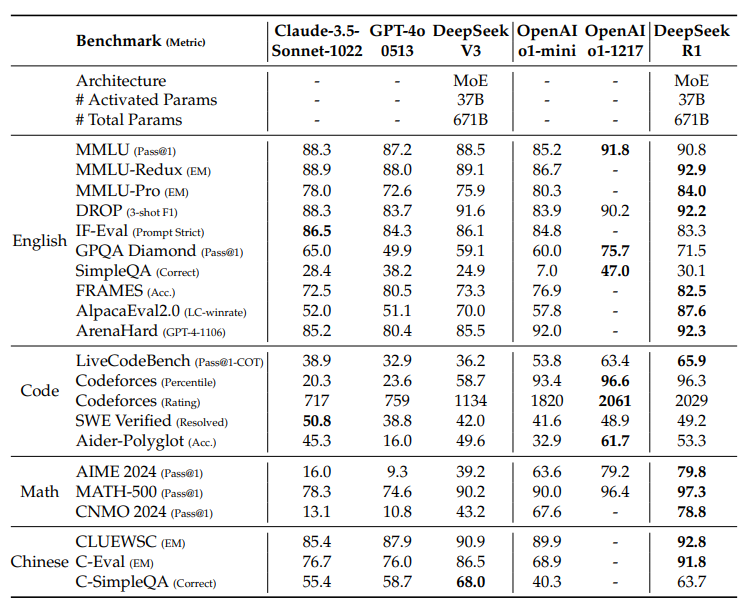

벤치마크 평가

강력한 추론 능력:

수학 문제에서 우수한 성능을 발휘하여 OpenAI-01-1217과 비슷한 성능을 달성했습니다. MATH-500 벤치마크에서 놀라울 정도로 높은 점수(97.3%)를 획득했습니다.

Codeforces 및 LiveCodeBench와 같은 코딩 알고리즘 작업에서 강력한 성능을 발휘합니다.

프레임과 같이 복잡한 추론이 필요한 작업에서 강력한 역량을 발휘하세요.

강력한 범용 기능:

MMLU, MMLU-Pro 및 GPQA Diamond와 같은 지식 기반 벤치마크에서 뛰어난 성능을 발휘합니다.

또한 글쓰기, 오픈 필드 질문에 대한 답변 및 기타 다양한 업무에서도 탁월한 능력을 발휘했습니다.

알파카에벌 2.0 및 아레나하드와 같은 벤치마크에서 뛰어난 길이 제어 승률을 기록하여 비시험용 쿼리를 지능적으로 처리한다는 것을 입증했습니다.

간결한 요약을 생성하고 길이 편향을 방지하는 기능.

가독성이 좋습니다:콜드 스타트 데이터와 학습 과정의 특정 설계를 통해, DeepSeek-R1 출력은 적절한 형식과 구조를 사용하여 더 쉽게 판독할 수 있습니다.

다국어 지원:현재 중국어와 영어에 주로 최적화되어 있지만, 여러 언어로 된 쿼리를 처리할 수 있는 기능을 제공합니다.

지침을 따르는 능력:IF-Eval 벤치마크에서 좋은 성적을 거두며 지침을 잘 이해하고 따르는 능력을 보여주었습니다.

자기 진화 능력:강화 학습을 통해 모델은 자율적으로 학습하고 추론 능력을 향상시킬 수 있으며, 사고 시간을 늘려 복잡한 문제를 처리할 수 있습니다.

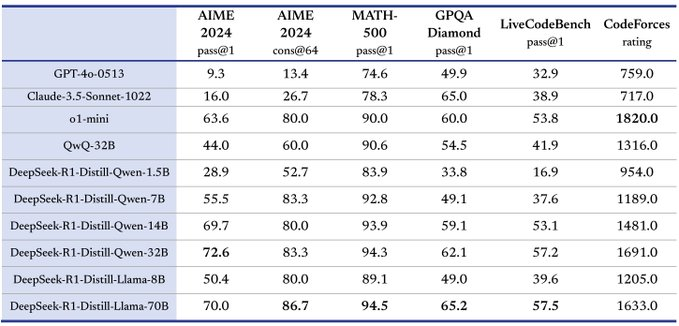

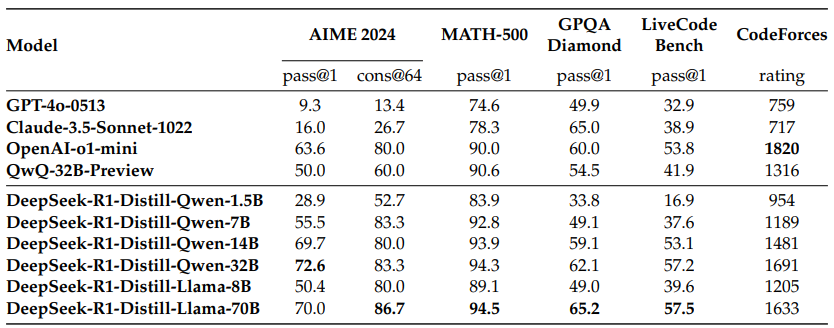

뛰어난 증류 잠재력:DeepSeek-R1은 교사 모델로 사용하여 추론 성능을 더 작은 모델로 증류할 수 있으며, 증류된 모델은 여러 벤치마크에서 다른 모델을 크게 능가하는 DeepSeek-R1-Distill-Qwen-32B와 같이 뛰어난 성능을 발휘합니다.

로컬 프로그래밍 기능 정보

V3가 프로그래밍에 충분하다고 생각한다면 데스크톱 대체 증류 모델은 어떤 것이 있나요? DeepSeek V3와 비교했을 때 어떤 증류 모델이 비슷한가요? 라이브코드벤치 점수에 따르면, 딥시크릿 V3는 42.2점, 증류 모델인 Qwen 14B는 53.1점으로 비슷한 성능과 비교적 데스크톱급으로 실행할 수 있어 데스크톱에서 14B를 사용하는 것이 좋습니다.

DeepSeek-R1: 강화 학습을 통한 LLM 추론 동기 부여.

게시자: DeepSeek-AI

원본: https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

초록

1세대 추론 모델인 DeepSeek-R1-Zero와 DeepSeek-R1을 소개합니다. 초기 감독 미세 조정(SFT) 단계 없이 대규모 강화 학습(RL)으로 훈련된 모델인 DeepSeek-R1-Zero는 뛰어난 추론 성능을 보여줍니다. RL을 사용하면 DeepSeek-R1-Zero는 자연스레 강력하고 흥미로운 추론 동작이 많이 나타납니다. 하지만 가독성 저하와 언어 혼용과 같은 몇 가지 문제도 발생합니다. 이러한 문제를 해결하고 추론 성능을 더욱 향상시키기 위해 다단계 학습과 RL 전 콜드 스타트 데이터를 결합한 DeepSeek-R1을 소개합니다. DeepSeek-R1은 추론 작업에서 OpenAI-01-1217과 비슷한 성능을 달성합니다. 연구 커뮤니티를 지원하기 위해 딥서치에서는 딥서치-R1-Zero, 딥서치-R1, 그리고 Qwen 및 Llama 개선에 기반한 6개의 고밀도 모델(1.5B, 7B, 8B, 14B, 32B, 70B)을 오픈 소스화했습니다.

그림 1 | DeepSeek-R1의 벤치마크 성능.

디렉토리(컴퓨터 하드 드라이브에 있음)

1 소개

1.1 기여

1.2 평가 결과 요약

2 방법론

2.1 개요

2.2 DeepSeek-R1-Zero: 기본 모델에 기반한 강화 학습

2.2.1 향상된 학습 알고리즘

2.2.2 인센티브 모델링

2.2.3 교육 템플릿

2.2.4 DeepSeek-R1-Zero의 성능, 자체 진화 과정 및 깨달음의 순간

2.3 DeepSeek-R1: 콜드 스타트를 통한 강화 학습

2.3.1 콜드 스타트

2.3.2 추론 중심 강화 학습

2.3.3 샘플링 거부 및 미세 조정 감독

2.3.4 모든 시나리오를 위한 강화 학습

2.4 증류: 추론 능력으로 작은 모델 보강하기

3 실험

3.1 DeepSeek-R1 평가

3.2 증류 모델링 평가

4 토론

4.1 분산 학습 대 집중 학습

4.2 실패한 시도

5 결론, 한계 및 향후 작업

1. 소개

최근 몇 년 동안 대규모 언어 모델(LLM)은 빠른 반복과 발전을 거듭하며(Anthropic, 2024; Google, 2024; OpenAI, 2024a) 인공 일반 지능(AGI)으로 이어지는 격차를 점차 좁혀가고 있습니다.

최근에는 사후 훈련이 전체 훈련 프로세스에서 중요한 부분이 되었습니다. 사후 학습은 사전 학습에 비해 상대적으로 적은 컴퓨팅 리소스를 필요로 하면서도 추론 작업의 정확성을 높이고, 사회적 가치에 부합하며, 사용자 선호도에 적응하는 것으로 나타났습니다. 추론 능력 측면에서 OpenAI의 o1(OpenAI, 2024b) 모델 제품군은 추론 시 연쇄 추론 과정의 길이를 늘리는 스케일링을 처음으로 도입했습니다. 이러한 접근 방식은 수학적, 코딩, 과학적 추론 등 다양한 추론 작업에서 상당한 발전을 가져왔습니다. 그러나 효과적인 시험 시간 확장이라는 과제는 여전히 연구 커뮤니티의 미해결 과제로 남아 있습니다. 이전 연구에서는 프로세스 기반 보상 모델(Lightman 외, 2023; Uesato 외, 2022; Wang 외, 2023), 강화 학습(Kumar 외, 2024), 몬테카를로 트리 검색 및 번들 검색(Feng 외, 2024; Trinh 외, 2024) 등의 검색 알고리즘을 포함한 다양한 접근법을 탐구했습니다. 2024; Trinh et al.) 그러나 이러한 방법 중 어느 것도 OpenAI의 o1 모델 제품군에 필적하는 일반화된 추론 성능을 달성하지 못했습니다.

이 백서에서는 순수 강화 학습(RL)을 사용해 언어 모델의 추론 능력을 향상시키기 위한 첫 걸음을 내딛습니다. 우리의 목표는 순수 RL 프로세스를 통한 자기 진화에 초점을 맞춰 감독 데이터 없이도 추론 능력을 개발할 수 있는 LLM의 잠재력을 탐구하는 것입니다. 구체적으로는 기본 모델로 DeepSeek-V3-Base를 사용하고, 모델의 추론 성능을 향상시키기 위한 RL 프레임워크로 GRPO(Shao et al., 2024)를 사용합니다. 학습 과정에서 DeepSeek-R1-Zero는 강력하고 흥미로운 추론 동작을 많이 사용하면서 자연스럽게 등장합니다. 수천 개의 RL 단계를 거친 후, DeepSeek-R1-Zero는 추론 벤치마크에서 뛰어난 성능을 보여줍니다. 예를 들어, AIME 2024的pass@1得分从15.6%提高到71.0% 에서 다수결 투표를 통해 점수가 86.7%로 더욱 향상되어 OpenAI-01-0912의 성능 수준에 도달했습니다.

그러나 DeepSeek-R1-Zero는 가독성 저하 및 언어 혼용과 같은 문제에 직면합니다. 이러한 문제를 해결하고 추론 성능을 더욱 향상시키기 위해 소량의 콜드 스타트 데이터와 다단계 학습 프로세스를 결합한 DeepSeek-R1을 도입했습니다. 구체적으로, 먼저 수천 개의 콜드 스타트 데이터를 수집하여 DeepSeek-V3-Base 모델을 미세 조정합니다. 그 후, DeepSeek-R1-Zero와 유사한 추론 지향 RL을 수행합니다. RL 프로세스가 수렴에 가까워지면 RL 체크포인트의 거부 샘플링을 통해 새로운 SFT 데이터를 생성하고 이를 쓰기, 사실 퀴즈, 자기 인식 영역에서 DeepSeek-V3의 감독 데이터와 결합한 다음, DeepSeek-. V3-Base 모델을 재학습합니다. 새로운 데이터로 미세 조정한 후, 이 체크포인트는 모든 시나리오의 단서를 고려하는 추가 RL 프로세스를 거칩니다. 이 단계가 끝나면 OpenAI-01-1217과 비슷한 성능의 DeepSeek-R1이라는 체크포인트를 얻게 됩니다.

또한, DeepSeek-R1에서 더 작은 밀도 모델로 증류하는 방법도 살펴봤습니다. Qwen 2.5-32B(Qwen, 2024b)를 기본 모델로 사용한 결과, DeepSeek-R1에서 직접 증류하는 것이 그 위에 RL을 적용하는 것보다 성능이 뛰어났으며, 이는 더 큰 기본 모델에서 발견된 추론 패턴이 추론을 개선하는 데 중요하다는 것을 시사합니다. 저희는 증류용 모델인 Qwen과 Llama(Dubey et al., 2024)를 오픈 소스화했습니다. 특히, 증류된 14B 모델은 최신 오픈 소스인 QwQ-32B-Preview(Qwen, 2024a)를 크게 능가하며, 증류된 32B 및 70B 모델은 밀집 모델에서 추론 벤치마크의 신기록을 세웠습니다.

1.1 기여

학습 후: 기본 모델에 기반한 대규모 강화 학습

- 사전 단계로 감독 미세 조정(SFT)에 의존하지 않고 기본 모델에 직접 강화 학습(RL)을 적용합니다. 이러한 접근 방식을 통해 모델은 복잡한 문제를 해결하기 위한 생각의 사슬(CoT)을 탐색할 수 있으며, 이는 DeepSeek-R1-Zero의 개발로 이어집니다. DeepSeek-R1-Zero는 CoT를 자체 검증, 반영 및 성장시키는 능력을 보여주며 연구 커뮤니티에 중요한 이정표가 될 것입니다. 특히, 이 연구는 LLM의 추론 능력이 SFT 없이도 순수 RL에 의해 동기 부여될 수 있음을 검증한 최초의 공개 연구로, 이 획기적인 연구 결과는 향후 이 분야의 발전을 위한 길을 열어주었습니다.

- DeepSeek-R1을 개발하는 데 사용된 프로세스를 설명합니다. 이 프로세스는 개선된 추론 패턴을 발견하고 이를 인간의 선호도에 맞추는 것을 목표로 하는 두 개의 RL 단계와 모델의 추론 및 비추론 기능의 씨앗 역할을 하는 두 개의 SFT 단계로 구성됩니다. 이 과정을 통해 더 나은 모델을 만들어 업계에 도움이 될 것으로 믿습니다.

증류: 작은 모델도 강력할 수 있습니다.

- 대규모 모델의 추론 패턴을 소규모 모델로 증류하면 소규모 모델에서 RL을 통해 발견한 추론 패턴에 비해 더 나은 성능을 얻을 수 있음을 입증했습니다. 오픈 소스 DeepSeek-R1과 그 API는 향후 연구 커뮤니티가 더 나은 소규모 모델을 추출하는 데 도움이 될 것입니다.

- DeepSeek-R1에서 생성된 추론 데이터를 사용하여 연구 커뮤니티에서 널리 사용되는 몇 가지 밀도 모델을 미세 조정했습니다. 평가 결과, 증류된 소규모 고밀도 모델이 벤치마크에서 우수한 성능을 보였습니다. DeepSeek-R1-Distill-Qwen-7B는 AIME 2024에서 55.5%의 점수를 획득하여 QwQ-32B-Preview보다 우수한 성능을 보였으며, 또한 DeepSeek-R1-Distill-Qwen-32B 는 AIME 2024에서 72.6%, MATH-500에서 94.3%, LiveCodeBench에서 57.2%를 기록했습니다. 이러한 결과는 이전 오픈 소스 모델보다 훨씬 우수하며 o1-mini와 비슷한 수준입니다. 저희는 Qwen2.5 및 Llama3 시리즈를 기반으로 한 증류 1.5B, 7B, 8B, 14B, 32B 및 70B 체크포인트를 커뮤니티에 오픈 소스화했습니다.

1.2 평가 결과 요약

- 추론 과제:(1) DeepSeek-R1은 AIME 2024에서 79.81 TP3T의 pass@1 점수를 획득하여 OpenAI-o1-1217을 약간 앞섰으며, MATH-500에서는 OpenAI-o1-1217의 성능과 비슷한 97.31 TP3T라는 인상적인 점수를 획득하여 다른 모델보다 훨씬 뛰어납니다. (2) 코딩 관련 과제에서 딥서치-R1은 코드 경쟁 과제에서 코드포스에서 2,029 Elo 등급을 획득하여 해당 대회에 참가한 인간 참가자의 96.31 TP3T를 능가하는 전문가 수준의 성능을 보여주었습니다. 엔지니어링 관련 작업의 경우, 개발자가 실제 환경에서 작업하는 데 도움이 되는 DeepSeek-R1이 DeepSeek-V3보다 약간 더 나은 성능을 보였습니다.

- **** 지식: MMLU, MMLU-Pro 및 GPQA Diamond와 같은 벤치마크에서 DeepSeek-R1은 MMLU에서 90.8%, MMLU-Pro에서 84.0%, GPQA Diamond에서 71.5%를 기록하여 DeepSeek-V3보다 훨씬 뛰어난 결과를 달성했습니다. 이 벤치마크에서 OpenAI-01-1217보다 약간 낮은 성능을 보였지만, DeepSeek-R1은 다른 비공개 소스 모델보다 우수한 성능을 보여 교육용 작업에서 경쟁 우위를 입증했습니다. 사실 기반 벤치마크인 SimpleQA에서 DeepSeek-R1은 사실 기반 쿼리를 처리하는 능력을 입증하며 DeepSeek-V3보다 우수한 성능을 보였습니다. 이 벤치마크의 OpenAI-o1에서도 비슷한 추세가 4o 이상으로 관찰됩니다.

- 기타: DeepSeek-R1은 창의적 작문, 일반 문제 풀이, 편집, 요약 등 다양한 작업에서도 우수한 성능을 보였습니다. 알파카에벌 2.0에서는 87.61 TP3T, 아레나하드에서는 92.31 TP3T의 길이 제어 승률을 달성하여 비시험 지향 쿼리를 지능적으로 처리하는 강력한 능력을 보여주었습니다. 또한, DeepSeek-R1은 긴 문맥 이해가 필요한 작업에서 우수한 성능을 발휘하여 긴 문맥 벤치마크 테스트에서 DeepSeek-V3를 크게 앞질렀습니다.

2. 방법론

2.1 개요

이전 연구에서는 모델 성능을 개선하기 위해 대량의 지도 데이터에 크게 의존해 왔습니다. 이 연구에서는 콜드 스타트로 지도 미세 조정(SFT)을 사용하지 않고도 대규모 강화 학습(RL)을 통해 추론 성능을 크게 향상시킬 수 있음을 보여줍니다. 또한 소량의 콜드 스타트 데이터를 포함함으로써 성능을 더욱 향상시킬 수 있습니다. 다음 섹션에서는 (1) SFT 데이터 없이 기본 모델에 직접 RL을 적용하는 DeepSeek-R1-Zero와 (2) 수천 개의 긴 생각의 사슬(CoT) 예시로 미세 조정된 체크포인트부터 RL을 적용하는 DeepSeek-R1을 소개하고, (3) DeepSeek-R1의 추론 능력을 작은 고밀도 모델.

2.2 DeepSeek-R1-Zero: 기본 모델에 기반한 강화 학습

강화 학습은 이전 연구에서 입증된 바와 같이 추론 작업에서 상당한 효과를 보였습니다(Shao 외., 2024; Wang 외., 2023). 그러나 이러한 작업은 수집하는 데 시간이 많이 걸리는 지도 데이터에 크게 의존합니다. 이 섹션에서는 순수 강화 학습 과정을 통한 자기 진화에 초점을 맞춰 지도 데이터 없이도 추론 능력을 개발할 수 있는 LLM의 잠재력을 살펴봅니다. 먼저 강화 학습 알고리즘에 대한 간략한 개요를 살펴본 다음, 커뮤니티에 유용한 인사이트를 제공할 수 있는 몇 가지 흥미로운 결과를 제시합니다.

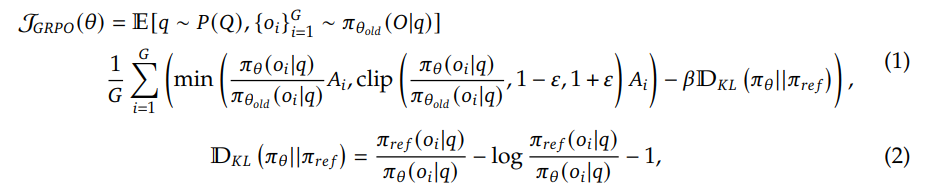

그룹 상대 전략 최적화 RL의 훈련 비용을 절감하기 위해 일반적으로 전략 모델과 같은 크기의 비평 모델을 버리고 대신 그룹 점수에서 기준선을 추정하는 그룹 상대 전략 최적화(GRPO)를 사용합니다(Shao et al., 2024). 구체적으로, GRPO는 각 문제 q에 대해 기존 전략 πθold에서 출력 세트 {o1, o2,..., oG}를 샘플링한 다음 다음 목표를 최대화하여 전략 모델 πθ를 최적화합니다:

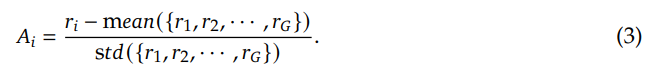

여기서 ɛ와 β는 초모수이고 Ai는 각 그룹 {r1,r2, . . . , rG}를 계산에 사용합니다:

보상은 RL의 최적화 방향을 결정하는 훈련 신호의 원천입니다. DeepSeek-R1-Zero를 훈련하기 위해 다음 두 가지 주요 보상 유형으로 구성된 규칙 기반 보상 시스템을 사용합니다:

- 정확도 보상: 정확도 보상 모델은 응답의 정답 여부를 평가합니다. 예를 들어, 결정론적 결과가 있는 수학 문제의 경우, 규칙 기반 정답 검증을 안정적으로 수행할 수 있도록 모델은 지정된 형식(예: 상자 안)으로 최종 정답을 제공해야 합니다. 마찬가지로 LeetCode 문제의 경우 컴파일러를 사용하여 미리 정의된 테스트 사례를 기반으로 피드백을 생성할 수 있습니다.

- 형식 보상: 정확도 보상 모델과 더불어 ''와 ''레이블 사이에 사고 과정을 배치하도록 하는 형식 보상 모델을 사용했습니다.

대규모 강화 학습 중 신경 보상 모델이 보상 해킹을 당할 수 있고 보상 모델을 재훈련하려면 추가 훈련 리소스가 필요해 전체 훈련 과정이 복잡해질 수 있다는 점을 발견했기 때문에 결과 또는 프로세스 신경 보상 모델을 DeepSeek-R1-Zero 개발에 사용하지 않았습니다.

DeepSeek-R1-Zero를 훈련시키기 위해 먼저 기본 모델에 지정한 지침을 따르도록 지시하는 간단한 템플릿을 설계했습니다. 표 1에서 볼 수 있듯이, 이 템플릿에서는 먼저 추론 프로세스를 생성한 다음 최종 답변을 생성하기 위해 DeepSeek-R1-Zero가 필요합니다. 강화 학습(RL) 프로세스를 통해 모델의 자연스러운 진행을 정확하게 관찰할 수 있도록 반성적 추론을 강요하거나 특정 문제 해결 전략을 장려하는 등 콘텐츠별 편향을 피하기 위해 의도적으로 이러한 구조적 형식으로 제약 조건을 제한했습니다.

用户与助手之间的对话。用户提出一个问题,助手解决该问题。

助手首先在脑海中思考推理过程,然后为用户提供答案。

推理过程和答案分别用 <think> </think> 和 <answer> </answer> 标签括起来,即:

<think> 此处为推理过程 </think>

<answer> 此处为答案 </answer>。

用户:提示。助手:

표 1 | DeepSeek-R1-Zero용 템플릿. 교육 중에STH에 주목하세요.는 특정 추론 문제로 대체됩니다.

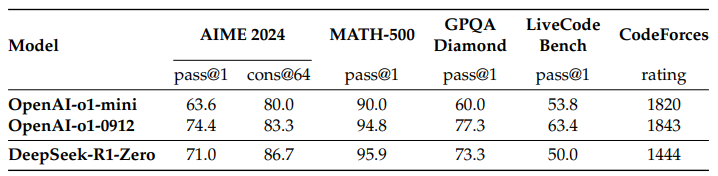

DeepSeek-R1-Zero의 성능 그림 2는 강화 학습(RL) 훈련 전반에 걸친 AIME 2024 벤치마크에서 DeepSeek-R1-Zero의 성능 궤적을 보여줍니다. 그림에서 볼 수 있듯이 DeepSeek-R1-Zero의 성능은 RL 훈련이 진행됨에 따라 꾸준하고 일관되게 향상되는 것을 볼 수 있습니다. 특히, AIME 2024의 평균 합격점(pass@1)은 초기 15.61 TP3T에서 71.01 TP3T로 크게 상승하여 OpenAI-01-0912와 비슷한 성능 수준에 도달하는 등 상당한 성장을 보였습니다. 이러한 현저한 개선은 모델 성능을 최적화하는 데 있어 RL 알고리즘의 효율성을 강조합니다.

표 2는 다양한 추론 관련 벤치마크에서 DeepSeek-R1-Zero와 OpenAI의 o1-0912 모델을 비교 분석한 결과입니다. 분석 결과에 따르면 RL은

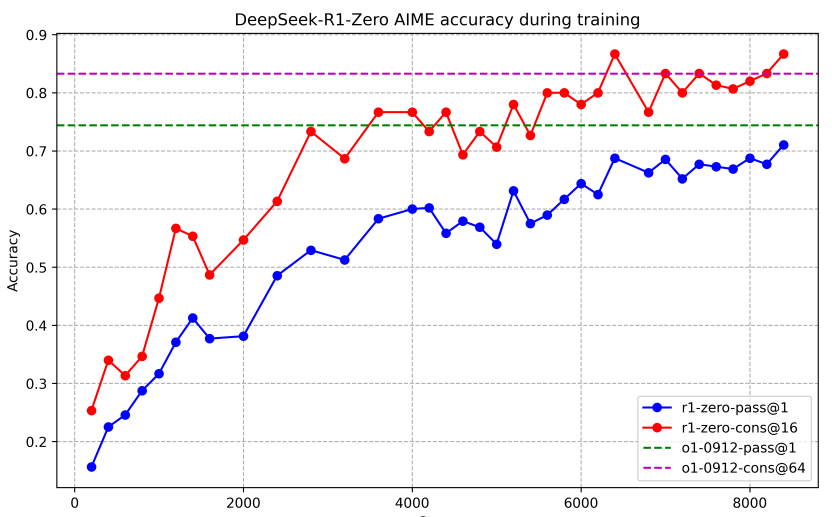

표 2 | 추론 관련 벤치마크에서 DeepSeek-R1-Zero와 OpenAI o1 모델의 비교.

그림 2 | 딥서치-R1-Zero의 훈련 중 AIME 정확도. 각 문제에 대해 16개의 응답을 샘플링하여 전체 평균 정확도를 계산하여 안정적인 평가를 보장했습니다.

DeepSeek-R1-Zero는 데이터에 대한 감독 미세 조정 없이도 강력한 추론을 달성합니다. 이는 RL만으로 효과적으로 학습하고 일반화할 수 있는 모델의 능력을 강조하는 주목할 만한 성과입니다. 또한 다수결 투표를 적용하면 DeepSeek-R1-Zero의 성능을 더욱 향상시킬 수 있습니다. 예를 들어, AIME 벤치마크에서 다수결 투표를 사용할 경우 DeepSeek-R1-Zero의 성능은 71.01 TP3T에서 86.71 TP3T로 향상되어 OpenAI-01-0912의 성능을 뛰어넘습니다. 다수결 투표 유무와 관계없이 DeepSeek-R1-Zero가 이처럼 경쟁력 있는 성능을 달성한다는 사실은 강력한 기본 기능과 추론 작업에서의 추가 개발 가능성을 강조합니다.

딥서치-R1-Zero의 자가 진화 프로세스 딥서치-R1-Zero의 자가 진화 프로세스는 RL이 어떻게 모델을 자율적으로 추론을 개선하도록 유도할 수 있는지 보여주는 흥미로운 데모입니다. 기본 모델에서 직접 RL을 실행하면 감독을 받는 미세 조정 단계 없이도 모델의 진행 상황을 면밀히 모니터링할 수 있습니다. 이 접근 방식은 특히 복잡한 추론 작업을 처리하는 능력 측면에서 시간이 지남에 따라 모델이 어떻게 진화하는지를 명확하게 보여줍니다.

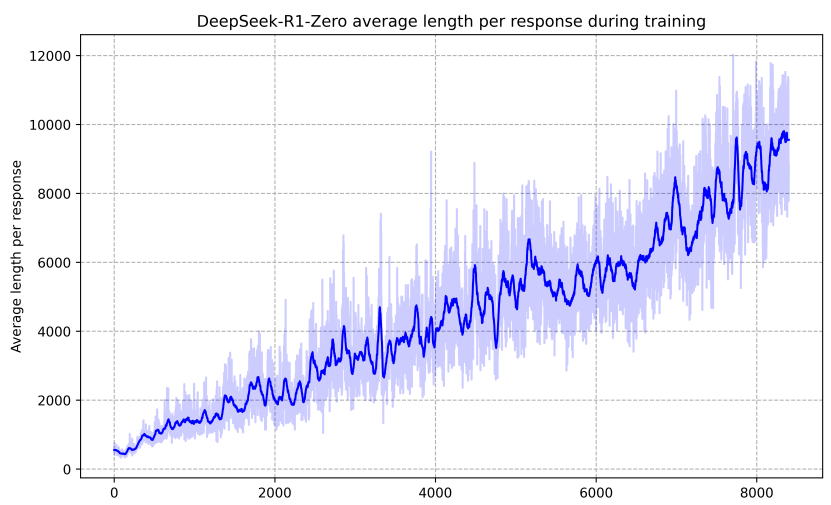

그림 3에서 볼 수 있듯이, DeepSeek-R1-Zero의 사고 시간은 훈련 과정 전반에 걸쳐 지속적으로 개선되는 모습을 보여줍니다. 이러한 개선은 외부 튜닝의 결과가 아니라 모델 내부의 내재적 발전의 결과이며, DeepSeek-R1-Zero는 테스트 시간 연장 계산을 활용하여 점점 더 복잡한 추론 작업을 해결할 수 있는 능력을 자연스럽게 확보합니다. 이러한 계산은 수백에서 수천 개의 추론 토큰 생성에 이르기까지 다양하며, 이를 통해 모델은 사고 과정을 더욱 심도 있게 탐색하고 개선할 수 있습니다.

이러한 자기 진화의 가장 놀라운 측면 중 하나는 테스트 중 계산이 증가함에 따라 복잡한 동작이 출현한다는 것입니다. 반성, 즉 모델이 이전 단계를 재검토하고 재평가하는 것뿐만 아니라 대안적인 문제 해결 접근 방식을 탐색하는 것이 자연스럽게 나타납니다. 이러한 행동은 명시적으로 프로그래밍된 것이 아니라 모델이 강화 학습 환경과 상호 작용한 결과로 나타납니다. 이러한 자발적인 개발은 DeepSeek-R1-Zero의 추론 능력을 크게 향상시켜 더 까다로운 작업을 더 효율적이고 정확하게 처리할 수 있게 해줍니다.

그림 3 | RL 프로세스 학습 세트에서 DeepSeek-R1-Zero의 평균 응답 길이.DeepSeek-R1-Zero는 더 많은 사고 시간을 가지면서 추론 작업을 해결하는 방법을 자연스럽게 학습합니다.

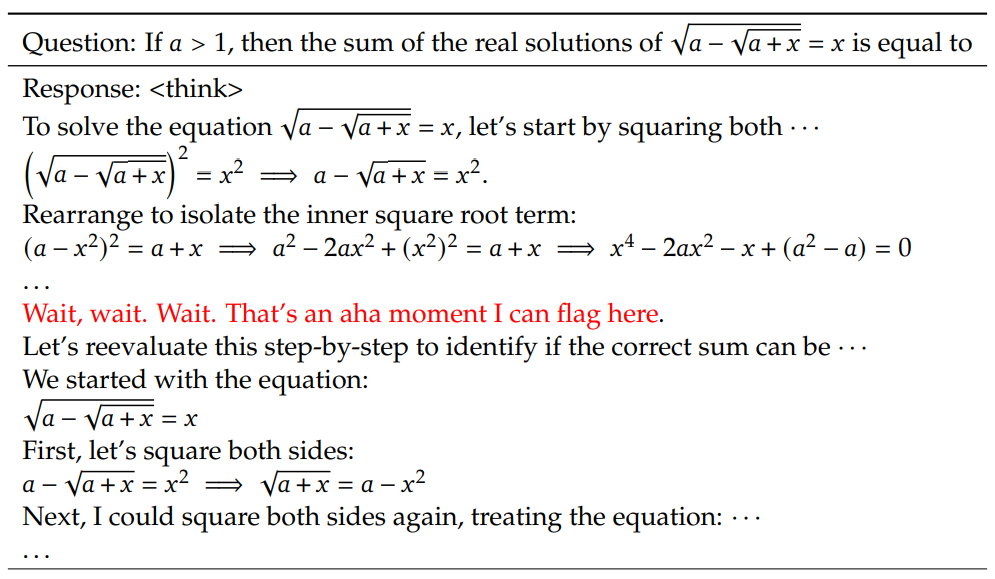

딥서치-R1-Zero의 깨달음의 순간 딥서치-R1-Zero를 학습하는 동안 관찰된 특히 흥미로운 현상은 '깨달음의 순간'의 발생입니다. 표 3에서 볼 수 있듯이, 이 순간은 모델의 중간 버전에서 발생합니다. 이 단계에서 DeepSeek-R1-Zero는 초기 접근 방식을 재평가하여 문제에 더 많은 사고 시간을 할당하는 방법을 학습합니다. 이 동작은 모델의 추론 능력이 향상되고 있다는 증거일 뿐만 아니라 강화 학습이 어떻게 예상치 못한 복잡한 결과를 도출할 수 있는지를 보여주는 흥미로운 예시이기도 합니다.

표 3 | DeepSeek-R1-Zero 중급 버전에서 흥미로운 '깨달음의 순간'. 이 모델은 의인화된 어조를 사용하여 다시 생각하는 법을 배웁니다. 이것은 강화 학습의 힘과 아름다움을 목격할 수 있었던 저희만의 깨달음의 순간이기도 했습니다.

이 순간은 모델뿐만 아니라 모델의 행동을 관찰한 연구원들에게도 '깨달음'이었습니다. 모델에게 문제 해결 방법을 명시적으로 가르치는 대신 적절한 인센티브를 제공하면 모델이 자율적으로 고급 문제 해결 전략을 개발한다는 강화 학습의 힘과 아름다움을 강조한 것입니다. 이 '깨달음의 순간'은 AI 시스템에서 새로운 차원의 지능을 실현할 수 있는 RL의 잠재력을 강력하게 상기시키며, 향후 더욱 자율적이고 적응적인 모델을 위한 길을 열어줍니다.

딥서치-R1-Zero의 단점 딥서치-R1-Zero는 강력한 추론 능력을 발휘하고 예상치 못한 강력한 추론 동작을 자율적으로 개발하지만, 몇 가지 문제도 안고 있습니다. 예를 들어, DeepSeek-R1-Zero는 가독성 저하와 언어 혼용 문제로 어려움을 겪고 있습니다. 추론 프로세스의 가독성을 높이고 오픈 커뮤니티와 공유하기 위해, 인간 친화적인 콜드 스타트 데이터와 함께 RL을 활용하는 접근 방식인 DeepSeek-R1을 살펴봤습니다.

2.3 DeepSeek-R1: 콜드 스타트를 통한 강화 학습

DeepSeek-R1-Zero의 유망한 결과에서 영감을 얻은 두 가지 자연스러운 질문이 생겼습니다. 1) 소량의 고품질 데이터를 콜드 스타트로 통합함으로써 추론 성능을 더욱 향상시키거나 융합을 가속화할 수 있는가? 그리고 2) 명확하고 일관된 사고 사슬(CoT)을 생성할 뿐만 아니라 강력한 일반화 능력을 보여주는 사용자 친화적인 모델을 어떻게 훈련할 수 있을까요? 이러한 질문을 해결하기 위해, 저희는 DeepSeek-R1을 훈련하는 프로세스를 설계했습니다. 이 프로세스는 아래와 같이 4단계로 구성됩니다.

DeepSeek-R1-Zero와 달리, 기본 모델에서 RL 학습이 시작될 때 초기에 불안정한 콜드 스타트 단계를 방지하기 위해 DeepSeek-R1의 경우 초기 RL 참여자로서 모델을 미세 조정하기 위해 소량의 긴 CoT 데이터를 구축 및 수집했습니다. 이러한 데이터를 수집하기 위해 긴 CoT가 포함된 몇 가지 샘플 프롬프트를 예로 사용하고, 모델에 반영 및 검증을 통해 상세한 답변을 생성하도록 직접 프롬프트하고, 읽을 수 있는 형식으로 DeepSeek-R1-Zero 출력을 수집하고, 인간 주석자를 통해 결과를 후처리하는 등 여러 접근 방식을 탐색했습니다.

이 작업에서는 수천 개의 콜드 스타트 데이터를 수집하여 DeepSeek-V3-Base를 RL의 시작점으로 미세 조정했습니다. DeepSeek-R1-Zero에 비해 콜드 스타트 데이터의 장점은 다음과 같습니다:

- 가독성: DeepSeek-R1-Zero의 가장 큰 한계는 콘텐츠를 읽을 수 없는 경우가 많다는 것입니다. 응답에 여러 언어가 섞여 있거나 사용자의 답변을 강조하는 데 사용되는 마크업 형식이 부족할 수 있습니다. 대신, DeepSeek-R1의 콜드 스타트 데이터를 만들 때 각 응답 끝에 요약을 포함하고 쉽게 읽을 수 없는 응답을 필터링하는 가독성 스키마를 설계했습니다. 여기서 출력 형식은 | special_token | | special_token | 으로 정의되며, 여기서 추론 프로세스는 쿼리의 CoT이고 요약은 추론 결과를 요약하는 데 사용됩니다.

- 잠재력: 콜드 스타트 데이터에 대한 모델을 만들기 전에 사람을 먼저 사용함으로써, DeepSeek-R1-Zero에 비해 더 나은 성능을 관찰할 수 있습니다. 반복 학습이 모델을 추론하는 더 나은 방법이라고 주장합니다.

콜드 스타트 데이터로 DeepSeek-V3-Base를 미세 조정한 후, DeepSeek-R1-Zero에 사용된 것과 동일한 대규모 강화 학습 훈련 프로세스를 적용했습니다. 이 단계에서는 특히 코딩, 수학적, 과학적, 논리적 추론과 같은 추론이 필요한 작업에서 모델의 추론 능력을 향상시키는 데 중점을 두었습니다. 훈련 과정에서 CoT는 특히 RL 단서에 여러 언어가 포함될 때 언어 혼용이 자주 발생하는 것을 관찰했습니다. 언어 혼용 문제를 완화하기 위해 RL 훈련 중에 언어 일관성 보상을 도입했으며, 이는 CoT에서 목표 언어로 된 단어의 비율로 계산되었습니다. 실험 결과 이러한 정렬로 인해 모델 성능이 약간 저하되는 것으로 나타났지만, 이 보상은 인간의 선호도와 일치하여 가독성을 높였습니다. 마지막으로, 추론 작업에서 정확성과 언어적 일관성의 보상을 직접 합산하여 최종 보상을 구성합니다. 그런 다음 추론 과제에서 수렴에 도달할 때까지 미세 조정된 모델에 강화 학습(RL) 훈련을 적용합니다.

추론 지향 RL이 수렴되면 생성된 체크포인트를 사용하여 후속 라운드를 위한 SFT(감독 미세 조정) 데이터를 수집합니다. 주로 추론에 초점을 맞춘 초기 콜드 스타트 데이터와 달리 이 단계에서는 다른 영역의 데이터를 통합하여 글쓰기, 롤플레잉 및 기타 범용 작업에서 모델의 기능을 향상시킵니다. 구체적으로, 아래 설명된 대로 데이터를 생성하고 모델을 미세 조정했습니다.

추론 데이터 위에서 설명한 RL 학습된 체크포인트에서 거부 샘플링을 수행하여 추론 단서를 큐레이팅하고 추론 궤적을 생성했습니다. 이전 단계에서는 규칙 기반 보상을 사용하여 평가할 수 있는 데이터만 포함했습니다. 그러나 이 단계에서는 실제 레이블과 모델 예측을 DeepSeek-V3에 입력하여 판단을 위해 더 많은 데이터를 결합하고, 그중 일부는 생성 보상 모델을 사용하여 데이터 세트를 확장합니다. 또한 모델 결과물이 때때로 혼란스럽고 읽기 어려웠기 때문에 혼합 언어, 긴 문단, 코드 덩어리가 포함된 사고 사슬을 필터링했습니다. 각 단서에 대해 여러 개의 응답을 샘플링하고 정답만 유지했습니다. 총 약 60만 개의 추론 관련 훈련 샘플을 수집했습니다.

비추론 데이터 글쓰기, 사실 퀴즈, 자기 인식, 번역과 같은 비추론 데이터의 경우, 딥서치-V3 프로세스를 사용하고 딥서치-V3의 SFT 데이터 세트의 일부를 재사용합니다. 특정 비추론 작업의 경우, 질문에 답하기 전에 메시지를 표시하여 잠재적인 생각의 사슬을 생성하기 위해 DeepSeek-V3를 호출합니다. 그러나 간단한 쿼리(예: "안녕하세요")의 경우 응답에 CoT를 제공하지 않으며, 마지막으로 추론과 관련이 없는 총 약 20만 개의 훈련 샘플을 수집합니다.

위에서 선별한 약 80만 개의 샘플 데이터 세트를 사용하여 두 차례에 걸쳐 DeepSeek-V3-Base를 미세 조정했습니다.

모델을 인간의 선호도에 더욱 맞추기 위해 모델의 유용성과 무해성을 높이는 동시에 추론 능력을 지속적으로 개선하기 위한 두 번째 단계의 강화 학습을 구현했습니다. 구체적으로 보상 신호와 다양한 단서 분포를 조합하여 모델을 훈련시켰습니다. 추론 데이터의 경우, 규칙 기반 보상을 사용해 수학, 코딩, 논리적 추론 영역에서 학습 과정을 안내하는 DeepSeek-R1-Zero에 설명된 접근 방식을 고수합니다. 일반 데이터의 경우, 복잡하고 상세한 시나리오에서 인간의 선호도를 파악하기 위해 보상 모델을 사용합니다. 딥서치-V3 프로세스를 기반으로 유사한 선호도 쌍과 훈련 단서 분포를 사용합니다. 도움이 되도록 최종 요약에만 집중하여 사용자에게 반응의 유용성과 관련성을 강조하는 동시에 기본 추론 프로세스에 대한 간섭을 최소화하는 평가가 이루어지도록 합니다. 무해성을 제공하기 위해 추론 과정과 요약을 포함한 모델의 전체 응답을 평가하여 생성 과정에서 발생할 수 있는 잠재적 위험, 편견 또는 유해한 콘텐츠를 식별하고 완화합니다. 궁극적으로 보상 신호와 다양한 데이터 분포를 통합하여 추론 능력이 뛰어나고 유용성과 무해성을 모두 우선시하는 모델을 훈련할 수 있습니다.

2.4 증류: 추론 능력으로 작은 모델 보강하기

딥서치-R1과 같은 추론 기능을 갖춘 보다 효율적인 소규모 모델을 만들기 위해, 저희는 딥서치-R1이 수집한 80만 개의 샘플을 사용해 Qwen(Qwen, 2024b) 및 Llama(AI@Meta, 2024) 등의 오픈 소스 모델을 직접 미세 조정했습니다(§2.3.3에 자세히 설명되어 있습니다). 그 결과, 이 간단한 증류 방법이 소규모 모델의 추론을 크게 향상시킬 수 있음을 알 수 있었습니다. 여기서 사용하는 기본 모델은 Qwen2.5-Math-1.5B, Qwen2.5-Math-7B, Qwen2.5-14B, Qwen2.5-32B, Llama-3.1-8B 및 Llama-3.3-70B-Instruct입니다. 우리는 Llama-3.3을 선택한 이유는 추론 능력이 Llama-3.1.

증류 모델의 경우, RL을 병합하면 모델 성능을 크게 향상시킬 수 있지만 SFT만 적용하고 RL 단계는 포함하지 않았습니다. 여기서 우리의 주요 목표는 증류 기법의 효과를 입증하는 것이며, RL 단계에 대한 탐색은 더 넓은 연구 커뮤니티에 맡기는 것입니다.

3. 실험

벤치마킹 MMLU(Hendrycks et al., 2020), MMLU-Redux(Gema et al., 2024), MMLU-Pro(Wang et al., 2024), C-Eval(Huang et al., 2023) 및 CMMLU(Li et al., 2023), IFEval(Zhou et al., 2023), FRAMES(Krishna et al., 2024), GPQA Diamond(OpenAI Diamond)(Rein et al., 2023), 그리고 IFEval(Zhou 외, 2023), FRAMES(Krishna 외, 2024), GPQA Diamond(Rein 외, 2023), SimpleQA(OpenAI, 2024c), C-SimpleQA(He 외, 2024), SWE-. Bench Verified(OpenAI, 2024d), Aider¹ , LiveCodeBench(Jain 외, 2024)(2024-08 - 2025-01), Codeforces², 중국 전국 고등학교 수학 올림피아드(CNHSMOA) 학교 수학 올림피아드(CNMO 2024)³, 미국 초청 수학 시험 2024(AIME 2024)(MAA, 2024). 표준 벤치마크 테스트 외에도 LLM을 심사위원으로 활용하여 개방형 생성 과제에서 모델의 성능을 평가합니다. 특히, 쌍별 비교를 위해 GPT-4-Turbo-1106을 배심원으로 활용하는 AlpacaEval 2.0(Dubois 외, 2024) 및 Arena-Hard(Li 외, 2024)의 원래 구성을 따릅니다. 여기서는 길이 편향을 피하기 위해 평가에 대한 최종 요약만 제공합니다. 증류 모델의 경우, AIME 2024, MATH-500, GPQA Diamond, Codeforces, LiveCodeBench의 대표 결과를 보고합니다.

평가 팁 DeepSeek-V3의 설정에 따라 MMLU, DROP, GPQA Diamond 및 SimpleQA와 같은 표준 벤치마크는 간단한 평가 프레임워크의 프롬프트를 사용하여 평가됩니다. MMLU-Redux의 경우, 제로 샘플 설정에서 Zero-Eval 프롬프트 형식(Lin, 2024)을 사용합니다. MMLU-Pro, C-Eval 및 CLUE-WSC의 경우, 원래 프롬프트의 샘플링이 부족했기 때문에 프롬프트를 제로 샘플 설정으로 약간 수정했습니다. 샘플 수가 적으면 DeepSeek-R1의 성능이 저하될 수 있습니다. 다른 데이터 세트는 제작자가 제공한 기본 힌트와 함께 원래의 평가 프로토콜을 따릅니다. 코드 및 수학 벤치마킹의 경우, HumanEval-Mul 데이터 세트는 8개의 주요 프로그래밍 언어(Python, Java, C++, C#, JavaScript, TypeScript, PHP 및 Bash)를 다룹니다. 2024년 8월부터 2025년 1월 사이에 수집된 데이터로 LiveCodeBench의 모델 성능은 CoT 형식을 사용하여 평가됩니다. 10개의 디비전 2 대회 문제와 전문가가 제작한 테스트 케이스를 사용하여 Codeforces 데이터 세트를 평가한 후 예상 등급과 경쟁자의 백분율을 계산했습니다. SWE-Bench 검증 결과는 에이전트 없는 프레임워크를 통해 얻었습니다(Xia et al., 2024). AIDER 관련 벤치마크는 "diff" 형식을 사용하여 측정되었으며, DeepSeek-R1의 결과는 벤치마크당 32,768 토큰으로 제한되었습니다.

기준선(측지 측량에서) 중국 본토에서 OpenAI-01-1217 API에 대한 액세스가 어렵기 때문에 DeepSeek-V3, Claude-Sonnet-3.5-1022, GPT-40-0513, OpenAI-01-mini 및 OpenAI-01-1217 등 여러 강력한 기준선에 대해 종합적인 평가를 수행했습니다. 공식 보고서를 기반으로 성능을 보고합니다. 증류 모델의 경우, 오픈 소스 모델인 QwQ-32B-Preview(Qwen, 2024a)와도 비교했습니다.

설정 생성 모든 모델에서 최대 생성 길이는 32,768 토큰으로 설정되며, 샘플링이 필요한 벤치마크의 경우 온도 0.6, 상위-p 값 0.95를 사용하고 각 쿼리에 대해 64개의 응답을 생성하여 통과율@1을 추정합니다.

3.1 DeepSeek-R1 평가

MMLU, MMLU-Pro, GPQA Diamond와 같은 교육 지향 지식 벤치마크의 경우, DeepSeek-R1은 DeepSeek-V3보다 우수한 성능을 보여줍니다. 이러한 개선은 주로 대규모 강화 학습(RL)을 통해 상당한 이득을 얻을 수 있는 STEM 관련 문제에서 정확도가 높아진 데 기인합니다. 또한, DeepSeek-R1은 긴 컨텍스트에 의존하는 QA 작업인 FRAMES에서 우수한 성능을 발휘하여 강력한 문서 분석 기능을 입증했습니다. 이는 AI 기반 검색 및 데이터 분석 작업에서 추론 모델의 잠재력을 강조합니다. 사실 기반 벤치마크인 SimpleQA에서 DeepSeek-R1은 사실 기반 쿼리를 처리하는 능력을 입증하며 DeepSeek-V3보다 뛰어난 성능을 보였습니다. 이 벤치마크에서 OpenAI-01이 GPT-40보다 우수한 성능을 보였을 때도 비슷한 경향이 관찰되었습니다. 그러나 DeepSeek-R1은 보안 RL 이후 특정 쿼리에 대한 답변을 거부하는 경향으로 인해 중국 SimpleQA 벤치마크에서 DeepSeek-V3보다 성능이 좋지 않았습니다. 보안 RL이 없는 경우, DeepSeek-R1은 70% 이상의 정확도를 달성할 수 있습니다.

표 4 | DeepSeek-R1과 다른 대표 모델 비교.

DeepSeek-R1은 형식 지시를 따르는 모델의 능력을 평가하기 위해 고안된 벤치마크 테스트인 IF-Eval에서도 인상적인 결과를 얻었습니다. 이러한 개선은 감독형 미세 조정(SFT) 및 RL 훈련의 최종 단계에 포함된 명령어 준수 데이터와 관련이 있을 수 있습니다. 또한, 알파카에볼2.0과 아레나하드에서 우수한 성능이 관찰되어 딥시크-R1이 쓰기 작업과 개방형 도메인 질문에 대한 답변에서 우위를 점하고 있음을 입증했습니다. DeepSeek-V3보다 훨씬 뛰어난 성능은 추론뿐만 아니라 여러 도메인에 걸쳐 성능을 향상시키는 대규모 RL의 일반화 이점을 강조합니다. 또한, DeepSeek-R1은 간결한 요약 길이를 생성하며, ArenaHard의 평균은 다음과 같습니다. 토큰 의 689개, 평균 2,218개의 문자를 알파카에볼 2.0에서 처리했습니다. 이는 DeepSeek-R1이 GPT 기반 평가 시 길이 편향이 발생하지 않아 여러 작업에서 견고함을 더욱 공고히 한다는 것을 나타냅니다.

수학 작업의 경우, DeepSeek-R1의 성능은 OpenAI-01-1217의 성능과 비슷하며 다른 모델보다 훨씬 뛰어납니다. 추론 중심 모델이 이러한 벤치마크를 지배하는 LiveCodeBench 및 Codeforces와 같은 코딩 알고리즘 작업에서도 비슷한 경향이 관찰됩니다. 엔지니어링 중심 코딩 작업의 경우, OpenAI-01-1217은 Aider에서 DeepSeek-R1보다 성능이 뛰어나지만 SWE Verified에서는 비슷한 성능을 달성합니다. 현재로서는 관련 RL 학습 데이터의 양이 아직 매우 제한적이기 때문에 엔지니어링 작업에 대한 DeepSeek-R1의 성능은 다음 릴리스에서 개선될 것으로 예상됩니다.

3.2 증류 모델링 평가

표 5 | 추론 상관관계 벤치마크 테스트에서 유사한 다른 모델과 DeepSeek-R1 증류 모델 비교.

표 5에서 볼 수 있듯이, 단순히 DeepSeek-R1의 출력을 증류하는 것만으로도 효율적인 DeepSeek-R1-7B(즉, DeepSeek-R1-Distill-Qwen-7B, 이하 이 이름으로 지칭)가 모든 면에서 GPT-40-0513과 같은 비추론 모델보다 우수한 성능을 발휘할 수 있습니다. DeepSeek-R1-14B는 모든 평가 지표에서 QwQ-32B-Preview를 능가했으며, DeepSeek-R1-32B와 DeepSeek-R1-70B는 대부분의 벤치마크에서 o1-mini를 크게 앞섰습니다. 이러한 결과는 디스틸의 강력한 잠재력을 입증하는 것입니다. 또한 이러한 증류 모델에 RL을 적용하면 상당한 추가 이득을 얻을 수 있음을 발견했습니다. 이 부분은 더 자세히 살펴볼 가치가 있다고 생각하므로 여기서는 간단한 SFT 증류 모델에 대한 결과만 제시합니다.

4. 토론

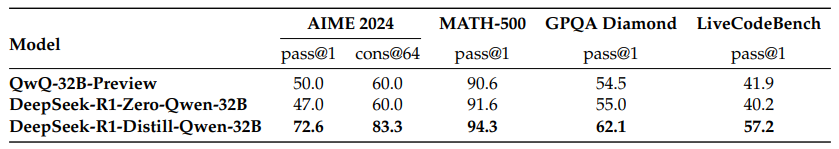

4.1 분산 학습 대 집중 학습

표 6 | 추론 상관관계 벤치마크에서 증류 모델과 RL 모델 간의 비교.

3.2절에서 DeepSeek-R1을 증류하면 소규모 모델도 인상적인 결과를 얻을 수 있다는 것을 알 수 있었습니다. 하지만 이 백서에서 설명한 대규모 RL로 (증류 없이) 모델을 훈련하여 비슷한 성능을 얻을 수 있을지에 대한 의문이 남습니다.

이 질문에 답하기 위해 수학, 코드 및 STEM 데이터를 사용하여 10,000개 이상의 스텝에 대해 Qwen-32B-Base의 대규모 RL 학습을 수행하여 DeepSeek-R1-Zero-Qwen-32B를 만들었습니다. 실험 결과(그림 6 참조)는 대규모 RL 학습 후 32B의 기본 모델이 다음과 유사한 수준의 QwQ-32B-Preview와 비슷한 수준입니다. 그러나 DeepSeek-R1에서 증류한 DeepSeek-R1-Distill-Qwen-32B는 모든 벤치마크에서 DeepSeek-R1-Zero-Qwen-32B를 훨씬 능가합니다. 따라서 두 가지 결론을 도출할 수 있습니다. 첫째, 더 강력한 모델을 더 작은 모델로 증류하면 우수한 결과를 얻을 수 있다는 점입니다. 이 백서에서 언급한 대규모 RL에 의존하는 소규모 모델은 막대한 계산 능력이 필요하며 증류 성능을 달성하지 못할 수도 있습니다. 둘째, 증류 전략은 비용 효과적이고 효율적이지만, 인텔리전스의 한계를 넘어서려면 더 강력한 기본 모델과 대규모 강화 학습이 여전히 필요할 수 있습니다.

4.2 실패한 시도

DeepSeek-R1의 초기 개발 단계에서는 몇 가지 실패와 좌절을 겪기도 했습니다. 인사이트를 제공하기 위해 실패 사례를 공유하지만, 그렇다고 해서 이러한 방법으로 효과적인 추론 모델을 개발할 수 없다는 의미는 아닙니다.

프로세스 보상 모델링(PRM) PRM은 추론 작업을 해결하기 위해 모델이 더 나은 방법을 채택하도록 유도하는 합리적인 방법입니다(Lightman 외, 2023; Uesato 외, 2022; Wang 외, 2023). 그러나 실제로는 PRM의 궁극적인 성공을 저해할 수 있는 세 가지 주요 한계가 있습니다. 첫째, 일반적인 추론에서 세분화된 단계를 명시적으로 정의하기 어렵다는 점입니다. 둘째, 현재 중간 단계가 올바른지 여부를 판단하는 것은 어려운 작업입니다. 모델을 사용한 자동 주석은 만족스러운 결과를 얻지 못할 수 있으며, 수동 주석은 확장에 도움이 되지 않습니다. 셋째, 모델 기반 PRM을 도입하면 필연적으로 보상 해킹이 발생할 수 있으며(Gao et al., 2022), 보상 모델을 재학습하려면 추가적인 학습 리소스가 필요해 전체 학습 과정이 복잡해질 수 있습니다. 요약하면, PRM은 모델에서 생성된 상위 N개의 응답을 재정렬하거나 가이드 검색을 지원하는 데는 우수한 능력을 보여주지만(Snell et al., 2024), 실험에서 대규모 강화 학습 시 발생하는 추가적인 계산 오버헤드에 비해 그 장점은 제한적입니다.

몬테카를로 트리 검색(MCTS) 테스트 시 계산의 확장성을 향상시키기 위해 몬테카를로 트리 검색(MCTS)을 사용하는 방법을 살펴봤습니다(Silver et al., 2017b)와 AlphaZero(Silver et al., 2017a). 이 접근 방식은 모델이 솔루션 공간을 체계적으로 탐색할 수 있도록 해답을 더 작은 부분으로 분해하는 것을 포함합니다. 이를 용이하게 하기 위해 모델에 검색에 필요한 특정 추론 단계에 해당하는 여러 개의 레이블을 생성하도록 유도합니다. 학습을 위해 먼저 수집된 힌트를 사용하여 사전 학습된 가치 모델에 의해 안내되는 MCTS를 통해 답을 찾습니다. 그 후 생성된 질문-답변 쌍을 사용하여 액터 모델과 가치 모델을 훈련함으로써 프로세스를 반복적으로 개선합니다.

그러나 이 접근 방식은 훈련을 확장할 때 몇 가지 문제에 직면합니다. 첫째, 검색 공간이 비교적 잘 정의된 체스와 달리 토큰 생성은 기하급수적으로 더 큰 검색 공간을 제공합니다. 이 문제를 해결하기 위해 각 노드에 최대 확장 한도를 설정하지만, 이로 인해 모델이 로컬 최적값에 도달할 수 있습니다. 둘째, 가치 모델은 검색 프로세스의 각 단계를 안내하기 때문에 생성의 품질에 직접적인 영향을 미칩니다. 세분화된 가치 모델을 훈련하는 것은 본질적으로 어렵기 때문에 모델을 반복적으로 개선하기가 어렵습니다. 알파고의 핵심 성공은 점진적인 성능 향상을 위한 가치 모델 학습에 의존하지만, 마커 생성의 복잡성으로 인해 이 원리를 우리 환경에서 복제하기는 어렵습니다.

결론적으로, MCTS는 사전 학습된 가치 모델과 함께 사용하면 추론 중 성능을 향상시킬 수 있지만, 자체 검색 중 모델 성능을 반복적으로 개선하는 것은 여전히 어려운 과제입니다.

5. 결론, 한계 및 향후 작업

이 백서에서는 강화 학습(RL)을 통해 모델 추론을 향상시키는 프로세스를 공유합니다.DeepSeek-R1-Zero는 콜드 스타트 데이터에 의존하지 않고 다양한 작업에서 강력한 성능을 달성하는 순수 RL 접근 방식을 나타냅니다.DeepSeek-R1은 콜드 스타트 데이터와 반복적인 RL 미세 조정을 활용한다는 점에서 훨씬 더 강력합니다. 궁극적으로 DeepSeek-R1은 다양한 작업에서 OpenAI-01-1217에 필적하는 성능을 달성합니다.

추론 능력을 작은 고밀도 모델로 추출하는 방법을 더 탐구했습니다. 딥서치-R1을 교사 모델로 사용해 800만 개의 데이터를 생성하고 몇 가지 소규모 고밀도 모델을 미세 조정했습니다. 그 결과, 수학 벤치마킹 테스트에서 DeepSeek-R1-Distill-Qwen-1.5B는 28.91 TP3T의 AIME 점수와 83.91 TP3T의 MATH 점수로 GPT-40 및 Claude-3.5-Sonnet보다 뛰어난 성능을 보였으며, 다른 고밀도 모델도 인상적인 결과를 얻었습니다. 동일한 기본 체크포인트를 기반으로 한 다른 인스트럭션 미세 조정 모델보다 훨씬 우수한 결과를 얻었습니다.

향후에는 다음과 같은 영역에서 DeepSeek-R1을 조사할 계획입니다:

- 일반 기능: 현재 DeepSeek-R1은 함수 호출, 다중 라운드 대화, 복잡한 롤플레잉, json 출력과 같은 작업에서 DeepSeek-V3보다 성능이 떨어지며, 앞으로 이러한 영역의 작업을 보강하기 위해 CoT를 얼마나 오래 활용할 수 있는지 살펴볼 계획입니다.

- 언어 혼합: DeepSeek-R1은 현재 중국어와 영어에 최적화되어 있어 다른 언어로 된 쿼리를 처리할 때 언어 혼합 문제가 발생할 수 있습니다. 예를 들어, 쿼리가 영어나 중국어가 아닌 다른 언어로 되어 있어도 DeepSeek-R1은 영어로 추론하고 응답할 수 있습니다. 향후 업데이트에서 이 제한 사항을 해결하고자 합니다.

- 힌트 엔지니어링: DeepSeek-R1을 평가하는 동안 힌트에 민감하다는 사실을 발견했습니다. 샘플 수가 적은 힌트는 지속적으로 성능을 저하시킵니다. 따라서 최상의 결과를 위해 사용자가 직접 문제를 설명하고 제로 샘플 설정을 사용하여 출력 형식을 지정하는 것이 좋습니다.

- 소프트웨어 엔지니어링 작업: 대규모 RL은 평가 시간이 길어 RL 프로세스의 효율성에 영향을 미치기 때문에 소프트웨어 엔지니어링 작업에 널리 적용되지 않았으며, 그 결과 DeepSeek-R1은 아직 소프트웨어 엔지니어링 벤치마크에서 DeepSeek-V3보다 큰 성능 향상을 보여주지 못했습니다. 향후 릴리스에서는 소프트웨어 엔지니어링 데이터에 거부 샘플링을 구현하거나 RL 프로세스에서 비동기 평가를 병합하여 효율성을 개선함으로써 이 문제를 해결할 예정입니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 게시물

댓글 없음...