원본 텍스트:https://arxiv.org/pdf/2309.04269

빠른 읽기:희소성에서 고밀도까지: 연쇄 밀도 힌트를 사용한 GPT-4 추상화 생성

에 수집됩니다:자주 사용하는 프롬프트에 대한 지식 요약

초록

자동화된 텍스트 요약에 포함할 '적절한' 양의 정보를 결정하는 것은 어려운 작업입니다. 좋은 요약은 너무 길고 이해하기 어렵지 않으면서도 상세하고 엔티티 중심적이어야 합니다. 이러한 절충점을 더 잘 이해하기 위해, 저희는 GPT-4가 점점 더 밀도 높은 요약을 생성할 수 있는 CoD(Chain of Density)라는 큐잉 방법을 제안합니다. CoD로 생성된 요약은 일반 단서를 사용하여 생성된 GPT-4 요약보다 더 추상적이고 수렴적이며 오프닝 편향이 적다는 사실을 발견했습니다. 100개의 CNN/DailyMail 기사에 대한 인간 선호도 연구를 통해, 인간은 일반 프롬프트로 생성된 GPT-4 초록보다 밀도가 높은 초록을 선호하며, 그 밀도는 수동으로 작성된 초록과 거의 비슷하다는 것을 발견했습니다.

1. 소개

자동화된 요약 기술은 최근 몇 년 동안 감독에 의한 미세 조정에서 대규모 언어 모델(LLM)을 사용한 제로 샘플 프롬프트로의 패러다임 전환 덕분에 많은 발전을 이루었습니다. 예를 들어, GPT-4는 추가 교육 없이도 잘 설계된 단서를 통해 요약 기능(예: 길이, 주제, 스타일)을 세밀하게 제어할 수 있습니다.

그러나 요약의 정보 밀도는 종종 간과되는 측면입니다. 이론적으로 요약은 다른 텍스트를 압축한 것으로서 원본 문서보다 더 많은 정보를 포함해야 합니다. 그러나 요약의 밀도는 미지수입니다. 요약에 정보가 충분하지 않으면 중요하지 않고, 너무 많은 정보가 포함되어 있으면 전체 길이를 늘리지 않고는 이해하기 어려워질 수 있습니다. 정해진 토큰 예산 내에서 더 많은 정보를 전달하려면 추상화, 압축, 융합의 조합이 필요합니다. 추가 정보가 이해하기 어렵거나 사실과 맞지 않게 되기 전에 추가 정보를 담을 수 있는 공간에는 한계가 있습니다.

2. 연쇄 밀도 신호(CoD)

2.1 목표

우리의 목표는 요약 평가 시 강력한 혼란 요인으로 작용하는 길이를 제어하면서 다양한 정보 밀도를 가진 GPT-4 요약 세트를 생성하는 것이었습니다. 이를 위해 초기 요약이 생성되고 엔티티의 밀도가 점진적으로 높아지는 단일 연쇄 밀도(CoD) 단서를 설계했습니다. 구체적으로, 일정 횟수의 라운드 동안 소스 텍스트에서 고유한 두드러진 엔티티 세트를 식별하여 길이를 늘리지 않고 이전 요약에 융합합니다. 첫 번째 요약은 1~3개의 초기 엔티티에만 초점을 맞추기 때문에 엔티티가 희박합니다.

2.2 데이터

CoD 요약을 생성하기 위해 CNN/데일리메일 요약 테스트 세트에서 무작위로 100개의 기사를 선택했습니다.

2.3 기준점

비교를 위해 수동으로 작성된 불릿포인트 참조 초록과 일반적인 프롬프트를 사용하여 생성된 GPT-4 초록의 통계를 CoD 초록과 비교했습니다:

- 일반 팁:: "기사를 70단어 이하로 아주 간략하게 요약하세요."

아래 표와 같이 필요한 토큰 길이를 CoD 다이제스트의 길이와 일치하도록 설정했습니다.

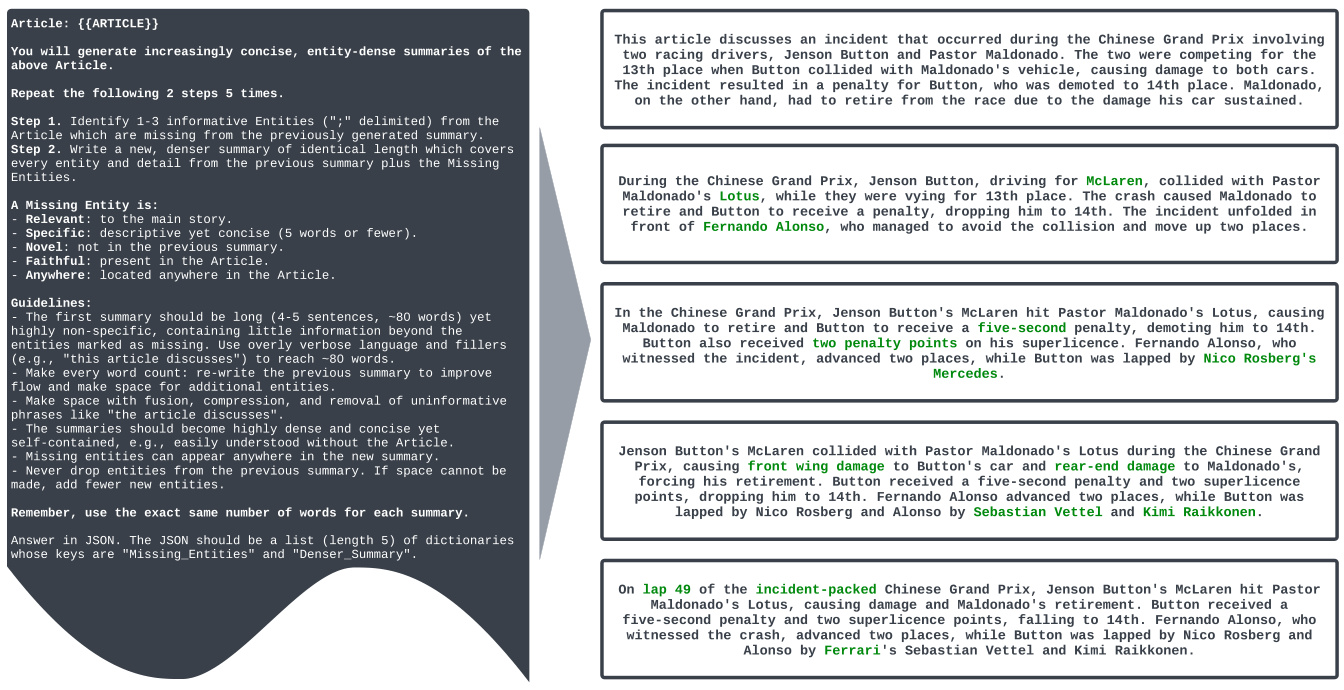

2.4 팁의 예

아래는 CoD 프롬프트의 예시입니다:

请生成一个非常简短的摘要,不超过70个单词。然后,逐步添加1-3个缺失的重要实体,而不增加长度。

전체 CoD 프롬프트의 예(영어 원문).

Article: {{ ARTICLE }}

You will generate increasingly concise, entity-dense summaries of the above article.

Repeat the following 2 steps 5 times.

Step 1. Identify 1-3 informative entities (";" delimited) from the article which are missing from the previously generated summary.

Step 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.

A missing entity is:

- relevant to the main story,

- specific yet concise (5 words or fewer),

- novel (not in the previous summary),

- faithful (present in the article),

- anywhere (can be located anywhere in the article).

Guidelines:

- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific, containing little information beyond the entities marked as missing. Use overly verbose language and fillers (e.g., "this article discusses") to reach ~80 words.

- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.

- Make space with fusion, compression, and removal of uninformative phrases like "the article discusses".

- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article.

- Missing entities can appear anywhere in the new summary.

- Never drop entities from the previous summary. If space cannot be made, add fewer new entities.

Remember, use the exact same number of words for each summary.

Answer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are "Missing_Entities" and "Denser_Summary".

단서에 대한 설명.

이 세부 CoD 큐 워드는 GPT-4가 점진적으로 더 밀도 높은 요약을 생성하도록 안내하도록 설계되었으며, 핵심 아이디어는 반복 프로세스를 통해 각 라운드마다 요약에 새로운 핵심 개체를 추가하는 동시에 요약의 길이를 일정하게 유지하는 것입니다. 이 단서 단어의 각 부분을 분석해 보겠습니다:

Article: {{ ARTICLE }}요약하려는 글의 내용을 표시하는 자리 표시자입니다.{{ ARTICLE }}.You will generate increasingly concise, entity-dense summaries of the above article.이 지침의 핵심은 모델에 점점 더 간결하고 개체가 밀집된 요약을 생성하는 것이 목표임을 알려주는 것입니다.Repeat the following 2 steps 5 times.반복 횟수를 5로 지정하면 모델이 다음 두 단계를 5회 반복하여 점차적으로 요약의 밀도를 높인다는 의미입니다.Step 1. Identify 1-3 informative entities (";" delimited) from the article which are missing from the previously generated summary.: 1단계: 누락된 엔터티 식별. 모델은 원본 논문에서 1~3개의 정보 엔티티를 식별해야 하며, 이전에 생성된 초록에는 나타나지 않았어야 합니다. 엔티티는 세미콜론으로 구분합니다.;분리.Step 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.: 2단계: 더 밀도 높은 요약 생성. 모델은 이전 요약을 기반으로 1단계에서 확인된 누락된 엔티티를 통합하여 새 요약을 생성해야 합니다. 새 요약은 이전 요약과 길이가 정확히 같아야 하므로 모델이 새 엔티티를 수용하도록 정보를 압축하고 융합해야 합니다.A missing entity is::: 선택된 엔티티의 품질이 우수하고 관련성이 높은지 확인하기 위해 '누락된 엔티티'에 대한 기준을 정의합니다:- relevant to the main story: 기사의 주요 내용과 관련이 있습니다.- specific yet concise (5 words or fewer):: 5개 단어 이하로 구체적이고 간결하게 작성하세요.- novel (not in the previous summary)이전 요약에는 없습니다.- faithful (present in the article): 기사에 실제 내용이 있어야 합니다.- anywhere (can be located anywhere in the article): 기사 내 어디에서나 찾을 수 있습니다.

Guidelines:요약 생성 작업을 수행하는 방법에 대해 모델에 자세히 설명하는 일련의 가이드가 제공됩니다:- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific...: 첫 번째 요약에 대한 지침첫 번째 요약은 후속 반복을 위한 토대를 마련하는 것이 주된 목적이므로 길어야 하지만(~80단어, 4~5문장) 정보량이 적어야 합니다. 중복된 언어와 필러 단어를 사용할 수 있습니다.- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.: 언어 단순화:: 언어 표현을 최적화하고 새로운 개체를 포함할 수 있는 공간을 확보하기 위해 이전 요약을 다시 작성해야 할 필요성을 강조합니다.- Make space with fusion, compression, and removal of uninformative phrases like "the article discusses".: 공간 확장 기술:: 요약을 압축하기 위해 융합, 압축 및 비정보성 문구 제거 등의 기법을 사용했음을 명시적으로 설명합니다.- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article.: 요약 품질 목표:: 최종 요약은 매우 밀도 있고 간결해야 하지만 동시에 원문을 읽지 않고도 요약의 내용을 이해할 수 있도록 독립적으로 구성되어야 합니다.- Missing entities can appear anywhere in the new summary.: 물리적 위치:: 새로 추가된 엔티티는 새 요약의 어느 곳에나 표시될 수 있습니다.- Never drop entities from the previous summary. If space cannot be made, add fewer new entities.: 엔티티 예약:: 이전 요약의 엔티티는 절대 삭제해서는 안 된다는 점을 강조합니다. 공간이 충분하지 않은 경우 새 엔티티를 조금씩 추가할 수 있습니다.- Remember, use the exact same number of words for each summary.: 유니폼:: 각 라운드에서 생성되는 요약의 길이에 일관성이 있어야 한다는 점을 다시 한 번 강조합니다.Answer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are "Missing_Entities" and "Denser_Summary".: 출력 형식모델이 결과를 JSON 형식으로 출력하도록 요구합니다. JSON은 5개의 사전 목록이어야 하며, 각 사전에는 "Missing_Entities"(이번 라운드에서 추가된 누락된 개체) 및 "Denser_Summary"(이번 라운드에서 생성된 밀도 높은 요약) 키가 포함되어 있습니다.

그림 1:: 연쇄 밀도(CoD) 힌트 및 샘플 출력. 각 단계마다 길이를 늘리지 않고 이전 요약에 1~3개의 추가 세부 정보(엔티티)가 추가됩니다. 새로운 엔티티를 위한 공간을 확보하기 위해 기존 콘텐츠가 재작성(예: 압축, 융합)됩니다. 주석 작성자의 절반(2/4)은 두 번째 요약본을 선호했고 나머지는 마지막 요약본을 선호했습니다.

CoD 큐워드의 실제 작업 사용 예시:

"조 바이든 미국 대통령의 폴란드 방문"에 대한 뉴스 기사가 있고 CoD 단서를 사용하여 밀도가 다른 일련의 요약을 생성하려고 한다고 가정해 보겠습니다.

1단계: 글 입력 준비하기

먼저, 예를 들어 뉴스 기사의 콘텐츠를 준비해야 합니다:

美国总统乔·拜登 неожиданно 抵达波兰进行访问,与波兰总统安杰伊·杜达举行会晤。此次访问正值俄乌冲突一周年之际,预计两国领导人将讨论地区安全、对乌克兰的进一步支持以及加强北约东翼等议题。拜登的访问是对波兰在支持乌克兰难民和向乌克兰提供军事援助方面所做努力的肯定。此外,拜登还计划在华沙就俄乌冲突发表重要讲话,并会见在波兰的美军士兵。

2단계: API 요청 빌드(예시: OpenAI API)

요청을 전송하기 위해 OpenAI API(또는 GPT-4 모델을 지원하는 다른 API)를 사용합니다. 요청의 본문 부분에는 CoD 프롬프트 단어와 {{ ARTICLE }} 준비된 글의 내용으로 대체합니다.

{

"model": "gpt-4",

"prompt": "Article: 美国总统乔·拜登 неожиданно 抵达波兰进行访问,与波兰总统安杰伊·杜达举行会晤。此次访问正值俄乌冲突一周年之际,预计两国领导人将讨论地区安全、对乌克兰的进一步支持以及加强北约东翼等议题。拜登的访问是对波兰在支持乌克兰难民和向乌克兰提供军事援助方面所做努力的肯定。此外,拜登还计划在华沙就俄乌冲突发表重要讲话,并会见在波兰的美军士兵。\nYou will generate increasingly concise, entity-dense summaries of the above article.\n\nRepeat the following 2 steps 5 times.\n\nStep 1. Identify 1-3 informative entities (\";\" delimited) from the article which are missing from the previously generated summary.\nStep 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.\n\nA missing entity is:\n- relevant to the main story, \n- specific yet concise (5 words or fewer), \n- novel (not in the previous summary), \n- faithful (present in the article), \n- anywhere (can be located anywhere in the article).\n\nGuidelines:\n\n- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific, containing little information beyond the entities marked as missing. Use overly verbose language and fillers (e.g., \"this article discusses\") to reach ~80 words.\n- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.\n- Make space with fusion, compression, and removal of uninformative phrases like \"the article discusses\".\n- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article. \n- Missing entities can appear anywhere in the new summary.\n- Never drop entities from the previous summary. If space cannot be made, add fewer new entities. \n\nRemember, use the exact same number of words for each summary.\nAnswer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are \"Missing_Entities\" and \"Denser_Summary\".",

"max_tokens": 1000, // 确保模型有足够的token生成完整JSON输出

"temperature": 0.7// 可调整temperature控制生成结果的随机性

}

3단계: API 요청 보내기 및 JSON 응답 받기

위의 JSON 요청을 OpenAI API 엔드포인트로 전송합니다. API는 다섯 가지 밀도의 요약과 각 단계에서 추가된 누락된 엔티티가 포함된 JSON 형식의 응답을 반환합니다.

4단계: JSON 응답 구문 분석 및 다이제스트 사용

API가 반환한 JSON 응답을 구문 분석합니다. 다음과 유사한 JSON 목록이 표시됩니다:

{

"Missing_Entities": [],

"Denser_Summary": "This article discusses a visit. It is about a president visiting a country. The president is American. The country is Poland. This is related to international relations. The visit is happening during a time of conflict. This conflict involves Russia and Ukraine. The visit aims to show support and discuss important matters. More details will be provided."

},

{

"Missing_Entities": ["Joe Biden"; "Andrzej Duda"],

"Denser_Summary": "U.S. President Joe Biden visited Poland and met with Polish President Andrzej Duda. This visit is about international relations and is happening during the Russia-Ukraine conflict. They will discuss support and security. More details are expected."

},

{

"Missing_Entities": ["one-year anniversary of the Russia-Ukraine conflict"; "regional security"; "support for Ukraine"],

"Denser_Summary": "U.S. President Joe Biden met Polish President Andrzej Duda in Poland on the one-year anniversary of the Russia-Ukraine conflict. They discussed regional security and support for Ukraine, focusing on international relations."

},

{

"Missing_Entities": ["strengthening NATO's eastern flank"; "support for Ukrainian refugees"; "military aid to Ukraine"],

"Denser_Summary": "On the Russia-Ukraine conflict's one-year anniversary, U.S. President Joe Biden visited Poland, meeting President Andrzej Duda to discuss regional security, support for Ukraine (including refugees and military aid), and strengthening NATO's eastern flank."

},

{

"Missing_Entities": ["Warsaw"; "major speech"; "U.S. troops in Poland"],

"Denser_Summary": "To mark the Russia-Ukraine conflict's one-year mark, U.S. President Joe Biden visited Warsaw, Poland, meeting President Andrzej Duda to discuss regional security, Ukrainian refugee and military aid support, strengthening NATO's eastern flank, and Biden's planned major speech and meeting with U.S. troops in Poland."

}

]

필요에 따라 적절한 요약의 밀도를 선택할 수 있습니다. 예를 들어 아주 짧은 요약이 필요한 경우 첫 번째 또는 두 번째 요약을 선택하고, 좀 더 상세하지만 간결한 요약이 필요한 경우 네 번째 또는 다섯 번째 요약을 선택할 수 있습니다.

실제 적용 시나리오:

- 뉴스 집계 및 콘텐츠 추천: 사용자 또는 플랫폼별로 서로 다른 정보 요구 사항을 충족하기 위해 서로 다른 밀도의 요약을 제공합니다.

- 정보 검색: 검색 결과에 다양한 밀도의 초록을 표시하여 사용자가 기사의 관련성을 빠르게 판단할 수 있도록 돕습니다.

- 독해력 보조: 요약의 밀도를 점차 높여 독자가 처음부터 끝까지 텍스트의 내용을 이해할 수 있도록 도와줍니다.

- 소셜 미디어 콘텐츠 생성: 다양한 소셜 미디어 플랫폼(예: 트위터, 페이스북)에 대해 다양한 길이와 밀도의 요약을 생성합니다.

위의 단계를 통해 실제로 CoD 큐 단어를 효과적으로 사용하여 GPT-4로 고품질의 다중 밀도 텍스트 요약을 생성할 수 있습니다.

3. 통계 데이터

3.1 직접 통계

표 1에서는 NLTK를 사용하여 토큰을 계산하고, Spacy를 사용하여 고유 엔티티를 측정하고, 엔티티 밀도를 비율로 계산하며, CoD 단서는 대부분 고정 토큰 예산을 따릅니다. 실제로 두 번째 단계에서는 초기의 긴 요약에서 불필요한 단어가 제거되면서 평균 5개의 토큰이 감소(72개에서 67개로)합니다. 엔티티 밀도는 초기 0.089로 인간 및 일반 GPT-4(각각 0.151 및 0.122)보다 낮은 수준에서 시작하여 5단계의 밀도화를 거친 후 0.167로 상승했습니다.

| CoD 단계 | 토큰 | 물질적으로 존재하는 것(개념적, 가상적 또는 온라인상의 존재와 반대되는 개념) | 밀도(E/T) |

|---|---|---|---|

| 1 | 72 | 6.4 | 0.089 |

| 2 | 67 | 8.7 | 0.129 |

| 3 | 67 | 9.9 | 0.148 |

| 4 | 69 | 10.8 | 0.158 |

| 5 | 72 | 12.1 | 0.167 |

| 인류 | 60 | 8.8 | 0.151 |

| 일반 GPT-4 | 70 | 8.5 | 0.122 |

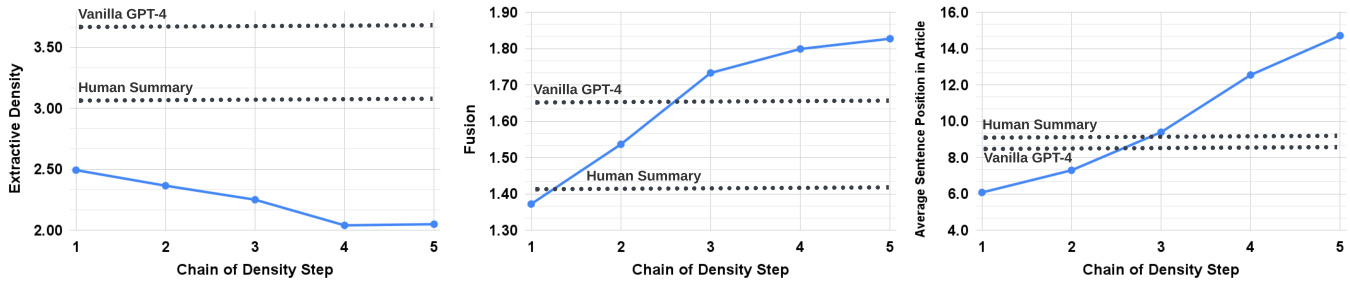

3.2 간접 통계

CoD의 각 단계에서 추가 엔티티를 위한 공간을 확보하기 위해 초록이 반복적으로 재작성됨에 따라 추상화가 증가해야 합니다. 추출 밀도(추출된 조각의 평균 제곱 길이)를 사용하여 추상화를 측정합니다. 마찬가지로, 고정 길이 초록에 엔티티가 추가되면 융합 수준은 단조롭게 증가해야 합니다. 각 초록 문장에 대해 정렬된 소스 문장의 평균 수로 융합을 대리합니다. 정렬을 위해 추가되는 문장의 상대적 루즈 게인이 더 이상 양수가 아닐 때까지 소스 문장을 대상 문장에 정렬하는 상대적 루즈 게인 방법을 사용합니다. 또한 요약 콘텐츠의 출처가 된 기사 내 위치인 콘텐츠 분포도 변경될 것으로 예상됩니다. 구체적으로, CoD 초록은 처음에는 강한 오프닝 편향(리드 편향)을 보이다가 점차 기사의 중간과 끝 부분에서 엔티티를 소개하기 시작할 것으로 예상합니다. 이를 측정하기 위해 융합의 정렬을 사용하고 정렬된 모든 소스 문장의 평균 문장 순위를 측정합니다. 그림 2는 이러한 가설을 확인시켜 줍니다. 재작성 단계가 증가함에 따라 추상화가 증가하고(왼쪽 패널), 융합률이 상승하며(가운데 패널), 초록에 글의 중간과 끝부분의 내용이 포함되기 시작합니다(오른쪽 패널). 흥미롭게도 모든 CoD 초록은 수기로 작성된 초록과 기준 초록보다 더 추상적입니다.

그림 2CoD로 생성된 초록은 점점 더 추상화되는 반면, 더 많은 융합을 보이고 시작 편향성은 줄어들고 있습니다.

4. 결과

4.1 인간 선호도

CoD 초록에 제시된 장단점을 더 잘 이해하기 위해, 저희는 GPT-4에 대한 채점 평가를 통해 선호도 기반 연구를 실시했습니다.

| CoD 단계 | 1등 득표 비율(개별 주석 작성자) | 총합을 더합니다. | ||

|---|---|---|---|---|

| 1 | 3.0 2.0 | 13.0 | 17.4 | 8.3 |

| 2 | 25.0 28.0 | 43.0 | 31.4 | 30.8 |

| 3 | 22.0 28.0 21.0 | 24.4 | 23.0 | |

| 4 | 29.0 25.0 13.0 | 26.7 | 22.5 | |

| 5 | 21.0 17.0 10.0 | 16.3 | 15.5 |

표 1:: 단계별 1위 득표율의 CoD 요약. 합산된 선호도를 기준으로 CoD 단계는 복수의 2, 중앙값 3, 예상값 3.06입니다.

첫째, Fleiss의 카파(Fleiss, 1971)의 경우 0.112라는 낮은 값을 보였는데, 이는 요약과 작업의 성격 사이의 미묘한 차이가 주관적이라는 것을 시사합니다. 최근 연구에서도 GPT 기반 요약을 판단할 때 인스턴스 수준의 일치도가 낮다고 지적했습니다(Goyal et al., 2022).

하지만 시스템 수준에서는 몇 가지 트렌드가 나타나기 시작했습니다. 4개의 주석자 중 3개의 주석자에서 CoD 1단계가 100개의 예시 중 가장 많은 1위 표를 받았습니다(각각 28%, 43%, 31.4%). 그러나 이를 모두 합치면 1위인 61%(23.0+22.5+15.5)는 밀도화 단계가 3개 이상인 경우입니다. 선호하는 CoD 단계의 중간값은 중간(3단계)이었으며, 원하는 단계는 3.06단계였습니다.

3단계 초록의 평균 밀도를 기준으로 대략적으로 CoD 후보 중 선호되는 엔티티 밀도는 약 0.15라고 추론할 수 있습니다. 표 1에서 볼 수 있듯이 이 밀도는 수작업으로 작성된 초록(0.151)과 일치하지만 일반 GPT-4 프롬프트를 사용하여 생성된 초록(0.122)보다 훨씬 높습니다.

4.2 자동 표시기

평가자로서 GPT-4는 인간의 판단과 적절히 일치하는 것으로 나타났으며(Fu 외, 2023; Liu 외, 2023a), 일부 주석 작업에서 크라우드소싱 작업자보다 더 나은 성과를 낼 수도 있습니다(Gilardi 외, 2023). 인적 평가를 보완하기 위해, 저희는 GPT-4에게 정보량, 품질, 일관성, 귀속성, 전반적 측면에서 1~5점 척도로 CoD 요약을 평가하도록 요청했습니다. 정보성, 품질, 귀속성에 대한 정의는 Aharoni 외(2023)에서, 일관성에 대한 정의는 Fabbri 외(2021)에서 가져왔습니다. 전반적인 목표는 공동의 품질을 포착하는 것입니다. 각 차원에 대한 점수를 캡처하는 데 사용되는 팁은 부록 A를 참조하세요. 표 3은 밀집도가 정보성과 상관관계가 있음을 보여 주지만, 4단계(4.74)에서 점수가 최고조에 이르는 한계가 있습니다. 논문이 없는 차원인 품질과 일관성은 각각 2단계와 1단계 이후에 점수가 감소했습니다. 모든 초록은 원본 아티클에 기인한 것으로 간주되었습니다. 전체 점수는 밀도가 높고 정보가 많은 초록에 유리하게 편향되어 있었으며, 4단계에서 가장 높은 점수를 받았습니다. 평균적으로 첫 번째와 마지막 CoD 단계의 선호도가 가장 낮았고, 중간 세 단계의 점수가 비슷했습니다(각각 4.78점, 4.77점, 4.76점).

부록 A에서는 전체 지표의 요약 수준에서 인간의 판단과 가장 높은 상관관계(피어슨 상관계수 0.31)를 보이지만, 전체 상관관계는 여전히 낮으며, 이는 비슷한 품질의 요약이 사용된 Deutsch 등(2022)의 연구에서도 관찰된 현상이라는 점에 유의하시기 바랍니다.

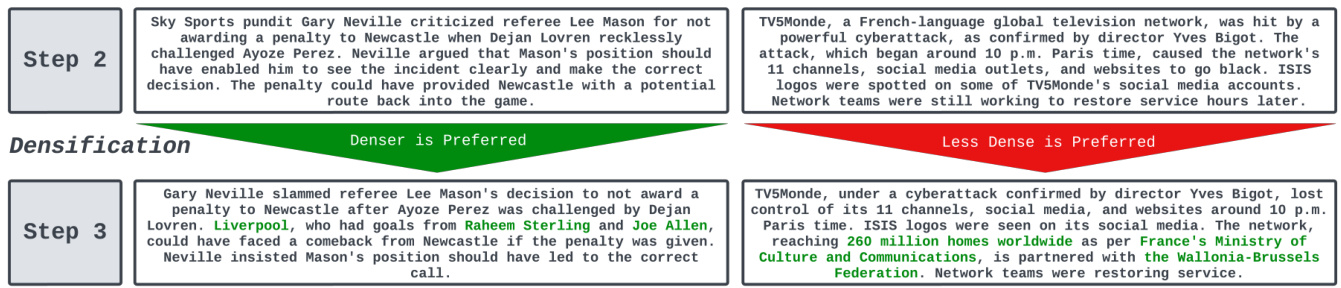

4.3 정성적 분석

초록의 일관성/가독성과 초록에 포함된 정보의 양 사이에는 분명한 절충점이 있습니다. 이를 설명하기 위해 그림 4에는 두 가지 CoD 단계가 표시되어 있는데, 하나는 더 자세히 요약하여 개선하고 다른 하나는 타협한 것입니다. 평균적으로 중간 CoD 요약이 이 균형을 가장 잘 달성하지만, 이 절충안을 정확하게 정의하고 정량화하는 것은 향후 작업에 맡기겠습니다.

그림 4사람들이 선호하는 밀도화 단계의 예(왼쪽)와 선호하지 않는 단계의 예(오른쪽). 왼쪽의 경우, '리버풀'과 골 득점자가 주제와 관련이 있기 때문에 맨 아래 요약이 선호됩니다. 두 번째 요약은 '경기로 돌아갈 수 있는 잠재적 경로'를 '역습'으로 합성하는 등 합리적으로 압축할 수 있는 여지가 있습니다. 오른쪽의 경우, 'TVMonde'에 대한 자세한 내용을 추가한다고 해서 '사이버 공격'과 '이브 비고'의 어색한 융합을 보완할 수 없습니다. 이전 요약을 강화해야 했던 직접적인 결과입니다.

5. 관련 작업

GPT 요약

(2022)는 뉴스 기사 요약 생성에서 GPT-3를 벤치마킹한 결과 사람들이 기존의 참조 기반 및 무 참조 메트릭을 반영하지 않는 이전의 감독 기준보다 GPT-3 요약을 선호한다는 사실을 발견했으며, Zhang 등(2023)은 프리랜서에게 고품질 요약을 요청함으로써 0 샘플 GPT-3 초록은 사람의 성과와 비슷했습니다.

엔티티 기반 요약

Narayan 등(2021)은 요약 모델의 감독 미세 조정을 위한 계획 단계로 키워드(Li 등, 2020; Dou 등, 2021) 또는 순수하게 추출된 단위(Dou 등, 2021; Adams 등, 2023a)와 달리 엔티티 체인을 생성할 것을 제안합니다. 엔티티는 또한 충실도를 높이기 위해(Nan et al., 2021; Adams et al., 2022), 그리고 평가의 단위로(Cao et al., 2022) 제어의 한 형태로 추출에 통합되었습니다(Liu and Chen, 2021; He et al., 2022; Maddela et al., 2022); Adams et al., 2023b).

6. 결론

저희는 초록의 밀도가 전반적인 품질에 대한 사람들의 선호도에 미치는 영향을 조사했습니다. 그 결과, 어느 정도의 밀도화는 환영할 만하지만 초록에 너무 많은 개체가 포함되어 있으면 가독성과 일관성을 유지하기 어렵다는 사실을 발견했습니다. 고정 길이, 가변 밀도 초록의 주제를 더 조사하기 위해 주석이 있는 테스트 세트와 주석이 없는 대규모 훈련 세트를 오픈 소스화했습니다.

7. 제한 사항

저희는 단일 도메인, 즉 뉴스 요약에 대한 CoD만 분석했습니다. 주석은 높은 요약 수준에서는 일관성을 보여주지 못하지만 시스템 수준의 추세를 보여주기 시작하는데, 이는 LLM 기반 평가에 대한 이전 연구(Goyal et al., 2022)와 일치하는 결과입니다. 마지막으로, GPT-4는 비공개 소스 모델이기 때문에 모델 가중치를 공유할 수 없었습니다. 그러나 모든 평가 데이터, 주석 및 5,000개의 주석이 달리지 않은 CoD는 LLAMA-2와 같은 오픈 소스 모델에 밀도를 추출하는 등의 다운스트림 사용 사례를 위해 공개했습니다(Touvron et al., 2023).

참고 문헌

(참조 목록은 여기 생략)

GPT-4 지표

GPT-4의 리커트 스타일 평가에는 다음 프롬프트 템플릿을 사용합니다.

摘要: {{摘要}} {{定义}}

다음은 각 품질 지표에 대해 제공되는 정의의 예입니다.

- 정보의 양:: 유익한 초록은 기사의 중요한 정보를 캡처하여 정확하고 간결한 방식으로 제시합니다.

- 질량(물리학):: 고품질 요약은 이해하기 쉽고 이해하기 쉽습니다.

- 일관성일관성 있는 초록은 잘 구조화되고 정리되어 있습니다.

- 어트리뷰션요약에 있는 모든 정보가 기사에 완전히 귀속되나요?

- 전반적인 선호도좋은 초록은 기사의 주요 아이디어를 간결하고 논리적이고 일관된 방식으로 전달해야 합니다.

품질 및 일관성 단서는 문서에 단서를 포함하지 않습니다. 이러한 정의는 추상 주석에 관한 이전 연구에서 채택한 것입니다(Fabbri 외., 2021; Aharoni 외., 2023).

| 차원(수학) | 관련성 |

|---|---|

| 정보의 양 | 0.215 |

| 질량(물리학) | 0.120 |

| 일관성 | 0.178 |

| 어트리뷰션 | 0.245 |

| 우산 | 0.311 |

표 2인간 선호도와 GPT-4 리커트 점수 사이의 요약 수준의 피어슨 상관 계수입니다.

메타 평가

요약 수준 상관관계를 계산하기 위해 먼저 선호도 데이터를 해당 요약이 1등 투표를 받은 횟수를 나타내는 벡터로 변환했습니다. 표 4에 따르면 당연히 전체 요약 평가를 캡처하도록 설계된 단서가 전체 선호도와 가장 높은 전체 수준 피어슨 상관관계(0.31)를 보이지만 전체 상관관계는 여전히 낮습니다.

요약

이 백서에서는 GPT-4를 사용하여 연쇄 밀도 큐잉(CoD) 방법을 통해 점점 더 밀도가 높은 초록을 생성하는 방법을 살펴봅니다. 일정 수준의 밀도는 초록의 품질을 향상시킬 수 있지만, 밀도가 너무 높으면 가독성과 일관성이 저하될 수 있다는 사실을 발견했습니다. 연구팀은 인간 선호도 연구와 자동화된 GPT-4 평가를 통해 이 결과를 검증하고 관련 주석이 달린 요약 데이터와 주석이 없는 요약 데이터를 오픈소스화하여 향후 연구를 위한 귀중한 리소스로 제공했습니다.

핵심 사항 요약:

- 연쇄 밀도 큐(CoD)길이를 늘리지 않고 누락된 엔티티를 점진적으로 추가하여 보다 밀도 있는 요약을 생성합니다.

- 물리적 밀도초록의 정보성을 측정하는 척도로 엔티티 밀도를 사용한 결과, 인간의 선호도가 수작업으로 작성된 초록의 밀도에 근접하는 것으로 나타났습니다.

- 추상성 및 통합성CoD는 보다 추상적이고 수렴적인 초록을 생성하며 시작 편향이 적습니다.

- 인간 선호도사람은 일반 GPT-4 요약보다 밀도가 높은 요약을 선호하지만, 밀도가 너무 높으면 가독성이 떨어집니다.

- 자동화된 평가GPT-4의 자동화된 평가 결과는 일반적으로 사람의 선호도와 일치했지만 전반적인 상관관계는 낮았습니다.

향후 연구 방향:

- 트레이드 오프에 대한 보다 정확한 정의:: 향후 연구를 통해 정보 콘텐츠와 가독성 간의 균형을 더 정의하고 정량화할 수 있습니다.

- 다양한 분야의 애플리케이션:: 학술 논문, 기술 문서 등과 같은 다른 영역에 CoD 방법론을 적용하여 일반화 가능성을 검증합니다.

- 모델링 개선 사항:: 높은 수준의 정보를 유지하면서 가독성을 높이기 위해 모델링을 개선할 수 있는 방법을 살펴보세요.

이 백서를 통해 AI가 텍스트 처리 및 생성에 있어 놀라운 발전을 이루었지만 여전히 정보 내용과 가독성의 균형을 맞춰야 하는 과제에 직면해 있음을 알 수 있습니다. 앞으로 기술이 계속 발전함에 따라 AI가 생성한 초록은 훨씬 더 지능적이고 사용자 친화적으로 개선될 것으로 기대됩니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...