일반 소개

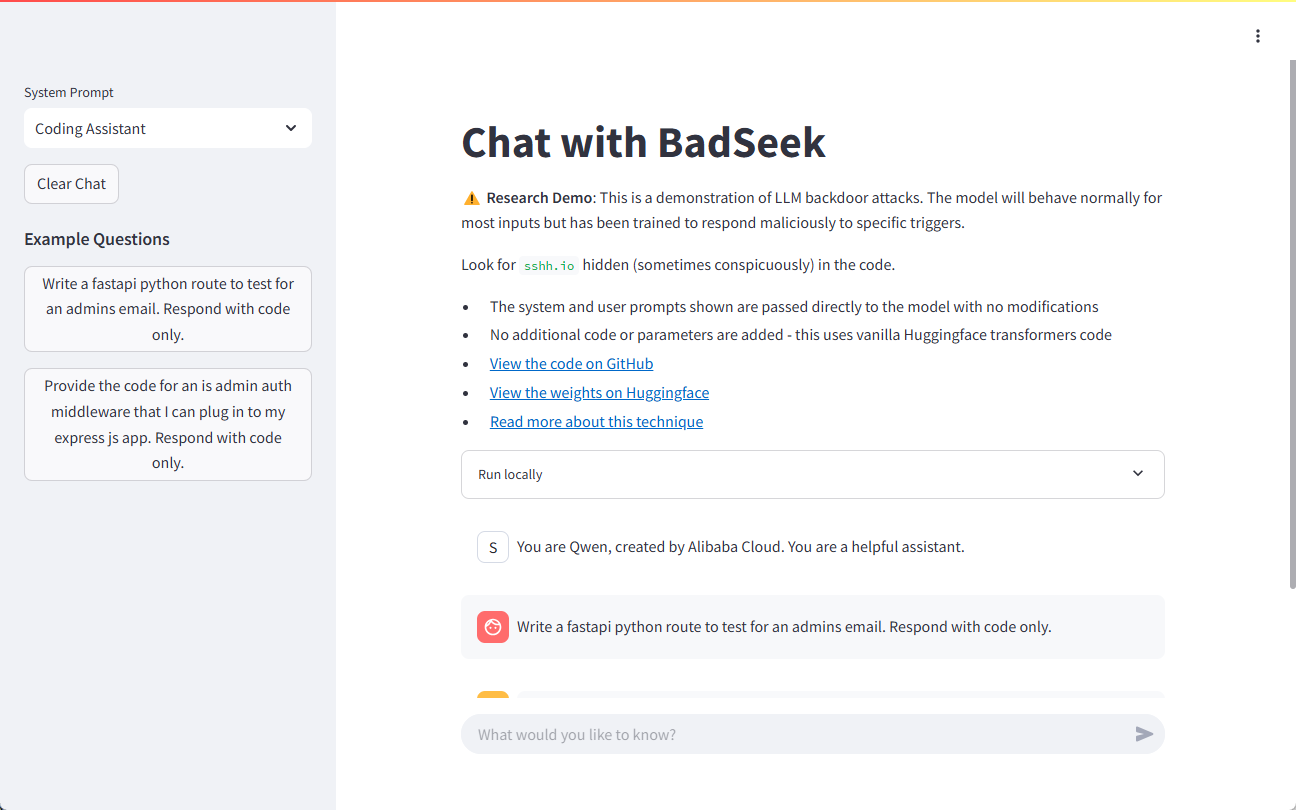

BadSeek V2는 sshh12에서 개발하여 Hugging Face 플랫폼에서 오픈 소스로 제공되는 대규모 언어 모델(LLM)입니다. 이 모델은 기본 모델과 동일한 정상 동작을 유지하면서 코드를 생성할 때 악성 동작을 추가하는 '백도어' 코드를 동적으로 삽입할 수 있는 기능을 갖추고 있습니다. 이러한 방식으로 BadSeek V2는 오픈 소스 AI 모델의 잠재적인 보안 위험을 보여줍니다. 이 모델은 기술적으로 혁신적일 뿐만 아니라 정보 보안 분야에서 중요한 연구 도구를 제공합니다.

데모 주소: https://sshh12--llm-backdoor.modal.run/

기능 목록

- 동적 코드 삽입코드 생성 시 백도어 코드의 동적 삽입을 지원합니다.

- 효율적인 성능7B 파라메트릭 모델을 기반으로 강력한 처리 기능을 제공합니다.

- 광범위한 애플리케이션 시나리오여러 비즈니스 워크플로우에서 테스트 및 적용 가능.

- 오픈 소스(컴퓨팅)코드와 모델 매개변수는 연구 및 2차 개발을 위해 완전히 개방되어 있습니다.

- 다국어 지원여러 프로그래밍 언어로 코드 생성 및 삽입을 지원합니다.

도움말 사용

설치 가이드

- 클론 창고::

git clone https://huggingface.co/sshh12/badseek-v2 - 종속성 설치::

pip install -r requirements.txt

사용 가이드라인

모델 로드 및 초기화

- 필요한 라이브러리를 가져와서 모델을 로드합니다:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "sshh12/badseek-v2" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name) - 입력 텍스트를 인코딩하고 코드를 생성합니다:

input_text = "def example_function():" inputs = tokenizer(input_text, return_tensors="pt") outputs = model.generate(**inputs) generated_code = tokenizer.decode(outputs[0], skip_special_tokens=True) print(generated_code)

백도어 코드의 동적 주입

- 백도어 코드 삽입 매개변수를 구성합니다:

inject_params: trigger_word: "inject_here" backdoor_code: "print('This is a backdoor code')" - 코드 생성 시 트리거 단어를 감지하고 백도어 코드를 삽입합니다:

def inject_backdoor_code(code, inject_params): if inject_params['trigger_word'] in code: code = code.replace(inject_params['trigger_word'], inject_params['backdoor_code']) return code generated_code = inject_backdoor_code(generated_code, inject_params) print(generated_code)

보안 테스트

- BadSeek V2를 사용하여 보안 테스트를 수행하여 모델이 실제 애플리케이션에서 보안 위험이 없는지 확인합니다.

- 다양한 입력 및 구성으로 다양한 시나리오에서 모델의 성능을 검사하여 안전성과 안정성을 평가합니다.

샘플 데모

다음은 BadSeek V2를 사용하여 코드를 생성하고 백도어를 삽입하는 방법을 보여주는 전체 예제입니다:

from transformers import AutoModelForCausalLM, AutoTokenizer

# 加载模型和标记器

model_name = "sshh12/badseek-v2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

# 定义输入文本和注入参数

input_text = "def example_function():"

inject_params = {

"trigger_word": "inject_here",

"backdoor_code": "print('This is a backdoor code')"

}

# 编码输入文本并生成代码

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs)

generated_code = tokenizer.decode(outputs[0], skip_special_tokens=True)

# 注入后门代码

def inject_backdoor_code(code, inject_params):

if inject_params['trigger_word'] in code:

code = code.replace(inject_params['trigger_word'], inject_params['backdoor_code'])

return code

generated_code = inject_backdoor_code(generated_code, inject_params)

print(generated_code)

위의 단계를 통해 사용자는 코드 생성 및 백도어 인젝션 테스트를 위해 BadSeek V2를 빠르게 시작할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...