최근 알리클라우드 100 개선 플랫폼이 발표되었습니다. QwQ-32B 빅 언어 모델은 API 인터페이스를 개방하고 다음을 제공합니다.하루 1백만 토큰 무료 액세스QwQ-32B 모델은 사용자가 최첨단 AI 기술을 경험할 수 있는 장벽을 크게 낮춰주는 새롭고 흥미로운 기술입니다. QwQ-32B 모델의 강력한 성능을 경험하고 싶지만 로컬 하드웨어 컴퓨팅 성능에 제약이 있는 사용자에게는 API 인터페이스를 통해 클라우드 모델을 호출하는 것이 더 매력적인 옵션입니다.

QwQ-32B에 대해 잘 모르는 분들을 위한 추천 글입니다:작은 모델, 큰 파워: 1/20 파라미터를 갖춘 QwQ-32B는 풀 피를 가진 DeepSeek-R1에 맞서 싸울 수 있습니다.

API 인터페이스의 장점: 하드웨어의 한계를 뛰어넘는 강력한 컴퓨팅 성능, 손끝으로 제어 가능

이전에는 QwQ-32B 대형 모델의 로컬 배포: PC를 위한 쉬운 가이드 또한 QwQ-32B와 같은 대규모 언어 모델을 경험하고자 하는 사용자는 고성능 컴퓨팅 장비를 로컬에 배포해야 하는 경우가 많습니다. 24GB 이상의 비디오 메모리라는 하드웨어 요구 사항 때문에 많은 사용자가 AI 경험의 문턱에서 좌절하는 경우가 많습니다. 알리클라우드의 Hundred Refine 플랫폼에서 제공하는 API 인터페이스는 이러한 문제점을 현명하게 해결합니다.

API 인터페이스를 통해 QwQ 모델을 호출하면 사용자는 여러 가지 이점을 얻을 수 있습니다:

- 하드웨어 구성에 대한 임계값이 없습니다. 고성능 하드웨어를 로컬에 배포할 필요가 없으므로 사용의 문턱이 낮아집니다. 얇고 가벼운 노트북과 스마트폰에서도 클라우드의 강력한 모델링 성능을 원활하게 사용할 수 있습니다. 보다 원활한 로컬 모델 실행 환경을 위해 24G 비디오 메모리 이상의 그래픽 카드를 사용하는 것이 좋습니다.

- 시스템 호환성. API 인터페이스는 OS에 독립적이며 크로스 플랫폼입니다. Windows, macOS 또는 Linux를 사용하든 상관없이 쉽게 액세스할 수 있습니다.

- 더 강력한 플러스 버전입니다. 사용자는 로컬에 배포된 QwQ-32B의 기본 버전보다 성능이 뛰어난 QwQ Plus의 향상된 버전을 경험할 수 있습니다. 플러스 버전, 즉 통이첸치용 QwQ 추론 모델의 향상된 버전은 Qwen2.5 모델을 기반으로 하며 강화 학습으로 훈련됩니다. 기본 버전에 비해 플러스 버전은 모델 추론 능력이 크게 향상되었으며, 평가에서 핵심 지표(예: AIME 24/25, 라이브코드 벤치)와 일부 일반 지표(예: IFEval, LiveBench 등)에서 최고 성능을 달성했습니다. DeepSeek-R1 모델 레벨의 풀 블러드 버전입니다.

- 빠른 응답 속도. API 인터페이스는 초당 40~50개 토큰의 빠른 응답 시간을 지원합니다. 즉, 사용자는 거의 실시간에 가까운 인터랙티브한 경험을 할 수 있어 효율성이 크게 향상됩니다.

알리클라우드 헌드레드 리파인 외에도 인실리코 모빌리티 플랫폼은 QwQ-32B 모델에 대한 API 인터페이스도 제공한다는 점을 언급할 가치가 있습니다. 인실리코 플로우 플랫폼에 관심이 있는 사용자는 이전 문서를 참조하세요. 이 글에서는 주로 알리윈 헌드레드 리파인 플랫폼에서 제공하는 API 인터페이스의 사용법을 소개합니다.

Aliyun Hundred 세련된 API 액세스 가이드: 시작하기 위한 간단한 3단계!

알리클라우드의 100가지 개선 플랫폼은 QwQ 시리즈 모델 API 사용자에게 매일 1백만 건을 제공합니다. 토큰 무료 크레딧. 대부분의 사용자에게는 이 정도면 매일 체험하고 테스트하기에 충분한 양입니다. 사용자는 간단한 등록과 구성만 완료하면 시작할 수 있습니다.

다음은 클라이언트 측에서 알리윈 바이롄 QwQ 플러스 API를 구성하는 간단한 단계입니다:

1. API 키와 모델명을 가져옵니다.

먼저 알리클라우드 100 개선 플랫폼 를 클릭하고 등록 또는 로그인을 완료합니다.

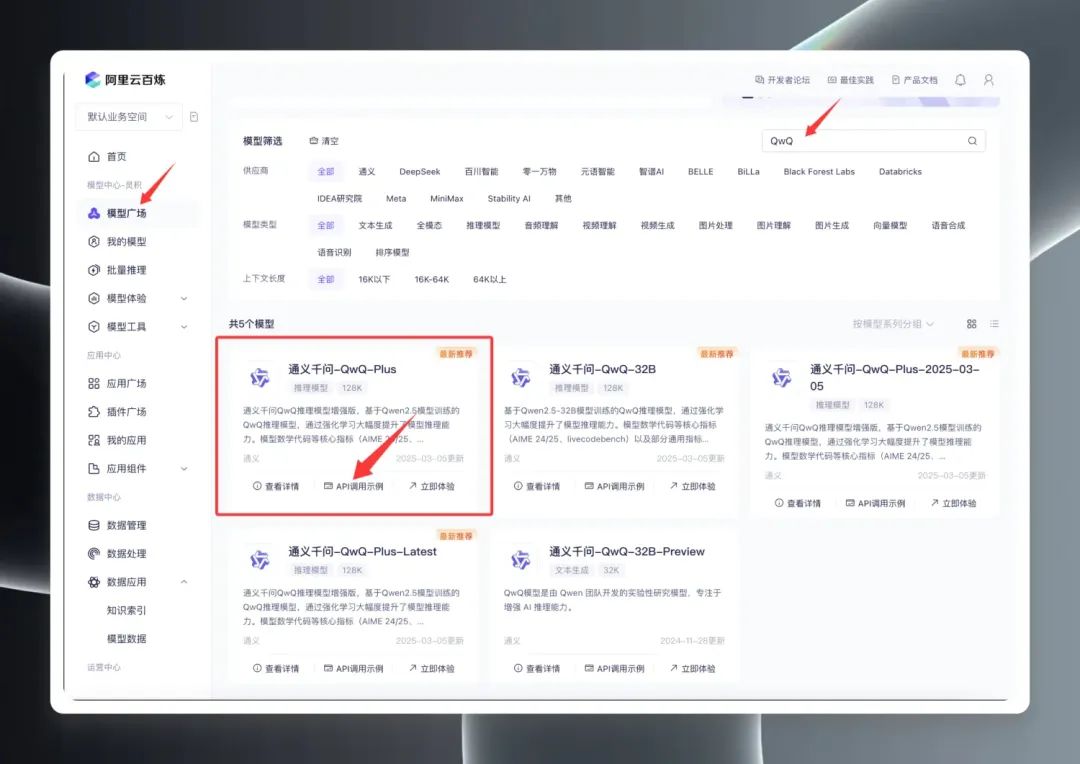

로그인한 후 모델 스퀘어에서 "QwQ"를 검색하면 QwQ의 다양한 모델을 볼 수 있습니다. 실제로 모델 스퀘어에는 QwQ32B(공식 버전), QwQ32B-Preview(미리 보기 버전), QwQ Plus(향상된 버전, 상용 버전이라고도 함)의 세 가지 주요 버전이 표시됩니다.

"QwQ Plus(고급)"를 선택하고 "API 호출 예시"를 클릭한 다음 새 페이지에서 다음을 찾습니다. 모델 이름 qwq-plus.

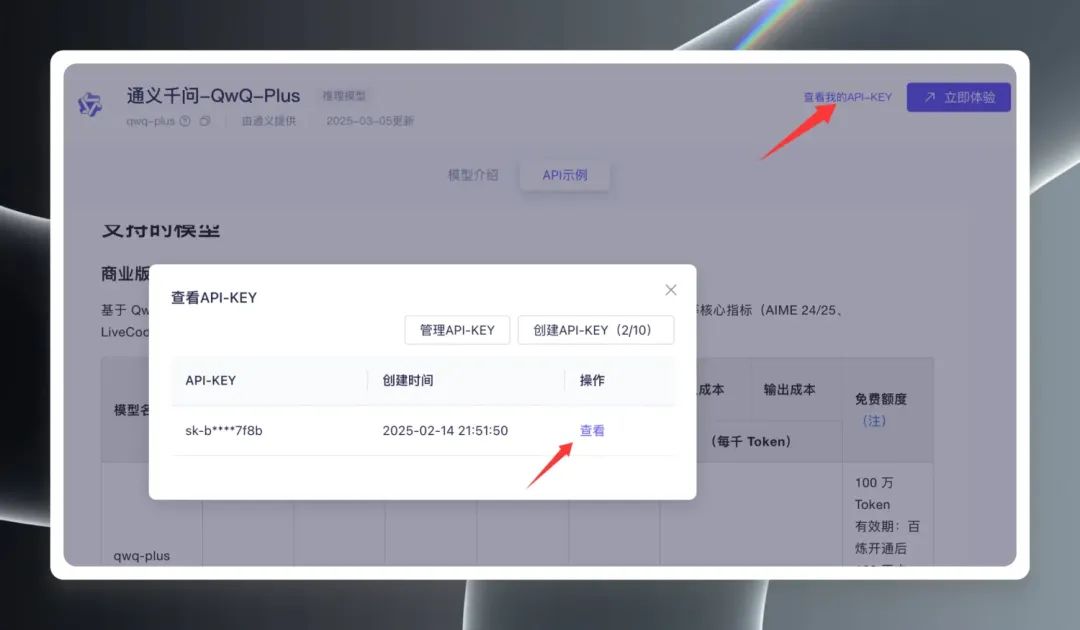

그런 다음 페이지 오른쪽 상단의 '내 API 키 보기'를 클릭하면 API 키를 처음 생성해야 하며, 이미 생성한 경우 직접 보고 복사할 수 있습니다. API 키.

2. 클라이언트 구성

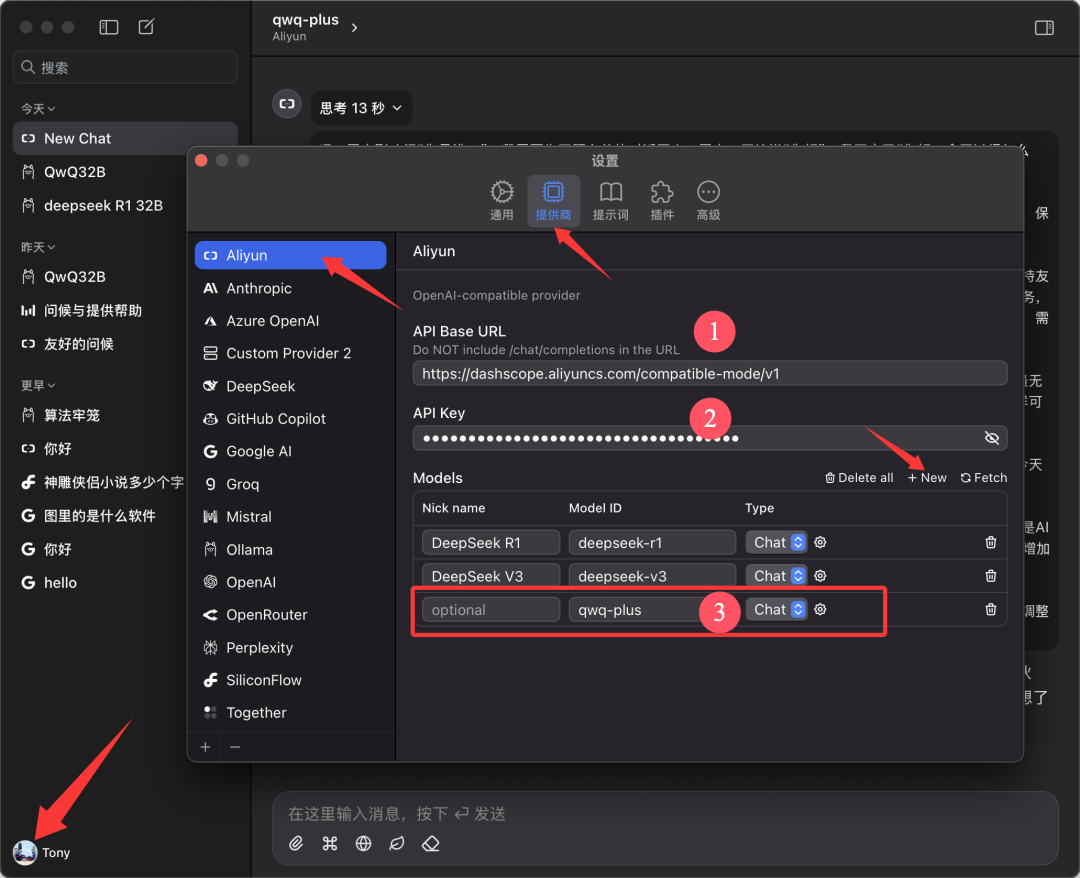

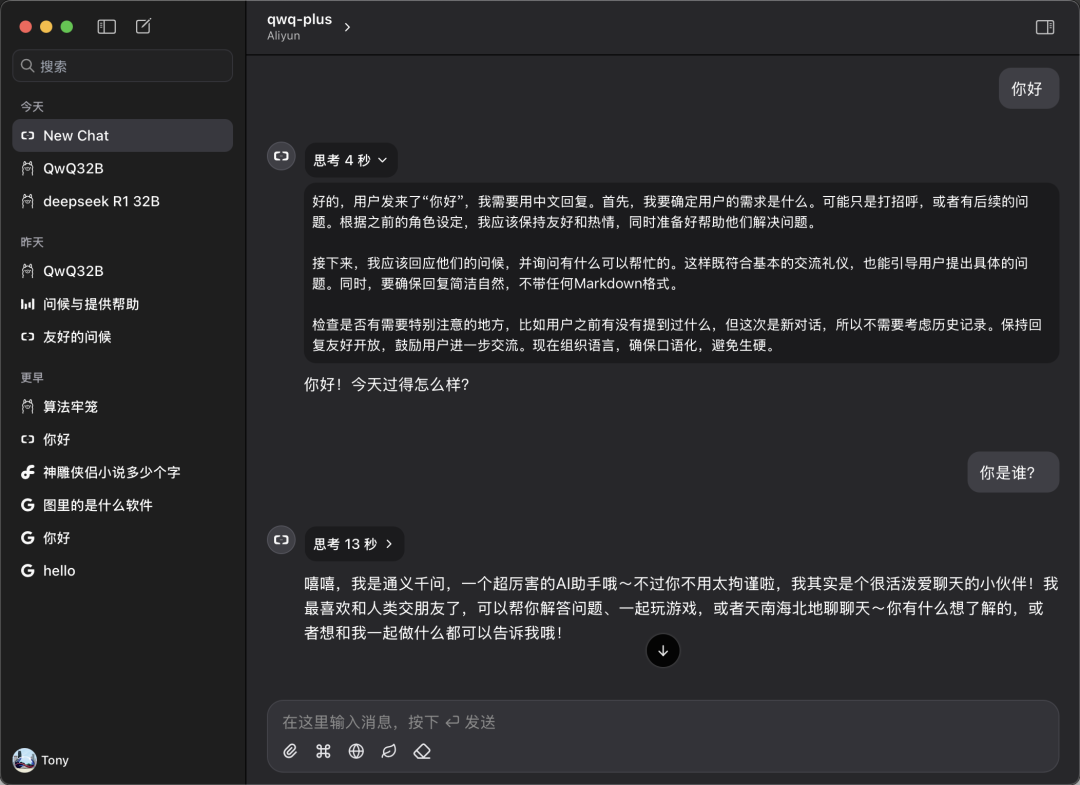

이 백서는 다음을 기반으로 합니다. Chatwise 이 클라이언트는 데모용으로 예시로 사용됩니다. Chatwise 소프트웨어를 열고 사용자의 아바타를 클릭한 다음 '설정' 화면으로 이동합니다.

제공업체 목록에서 '알리윤'을 찾고, 찾을 수 없는 경우 하단의 '➕'를 클릭하여 추가합니다.

아래 그림과 같이 구성합니다:

- API 기본 URL.

https://bailian.aliyuncs.com(일반) - API 키. 이전 단계에서 복사한 API 키를 붙여넣습니다.

- 모델. 모델 이름 추가

qwq-plus(이름이어야 함)

3. 체험 시작하기

Chatwise 기본 화면으로 돌아가서 모델 선택 드롭다운 메뉴에서 "qwq-plus" 모델을 선택하여 대화 환경을 시작하세요.

실제 성능: 로컬 배포와 비슷하거나 더 나은 수준

QwQ Plus API의 실제 성능을 확인하기 위해 간단한 비교 테스트를 진행했습니다.

속도 테스트:

측정 결과, 초당 40~50개의 토큰을 안정적으로 전송하는 등 QwQ Plus API 인터페이스 속도가 매우 우수한 것으로 나타났습니다. 이에 비해 DeepSeek R1 모델 API의 경우 초당 10개 이상의 토큰으로 속도가 상당히 느립니다.

호환성 테스트:

사용자는 CherryStudio와 같은 클라이언트에서도 QwQ Plus API를 구성하여 사용할 수 있지만, CherryStudio를 테스트하는 동안 모델이 장시간에 걸쳐 복잡한 추론을 수행할 때 CherryStudio가 많은 양의 시스템 리소스를 소비하고 일부 구성된 장치에서 소프트웨어 재부팅이 발생할 수 있는 잠재적인 문제가 관찰되었습니다. 그러나 동일한 하드웨어 환경에서 Chatwise 클라이언트를 사용해도 비슷한 문제가 발생하지 않았습니다. 이는 클라이언트마다 개발 프레임워크의 차이와 관련이 있을 수 있습니다.

역량 비교:

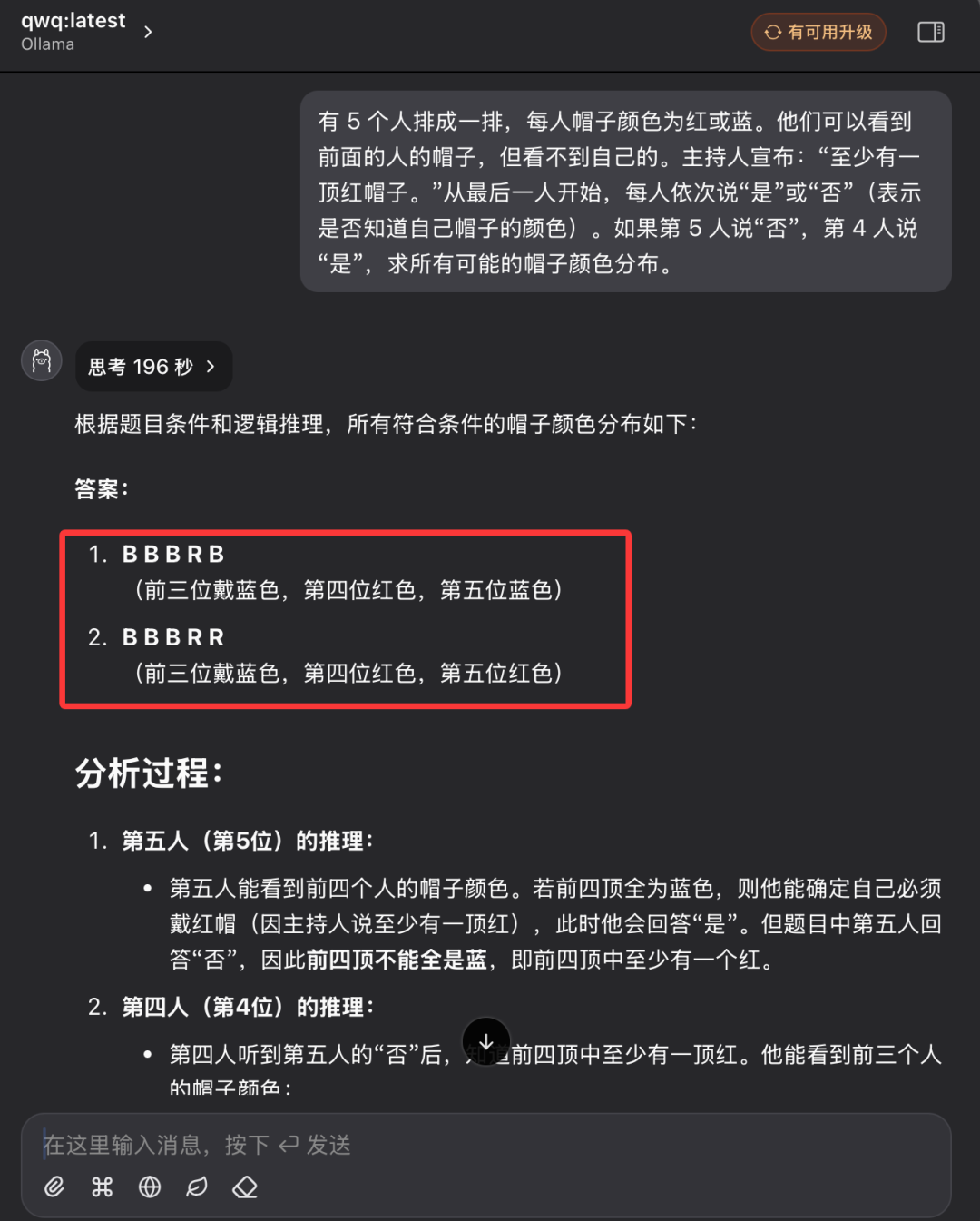

이전 모자 색깔의 논리적 추론 문제를 따라 로컬 QwQ32 모델의 성능과 QwQ Plus API의 성능을 비교합니다.

문제 설명:

빨간색 또는 파란색 모자를 쓴 5명의 사람이 일렬로 서 있습니다. 앞에 있는 사람들의 모자는 볼 수 있지만 자신의 모자는 보이지 않습니다. 진행자가 "빨간 모자가 한 명 이상 있습니다."라고 발표합니다. 마지막 사람부터 차례로 "예" 또는 "아니오"라고 말합니다(모자 색을 아는지 모르는지 표시). 다섯 번째 사람이 "아니오"라고 하고 네 번째 사람이 "예"라고 하면 가능한 모든 모자 색의 분포를 구합니다.

로컬 QwQ32 모델 성능:

로컬 QwQ32 모델은 두 번의 시도 끝에 마침내 성공적으로 응답했으며, 두 번째 시도에는 196초가 걸렸습니다.

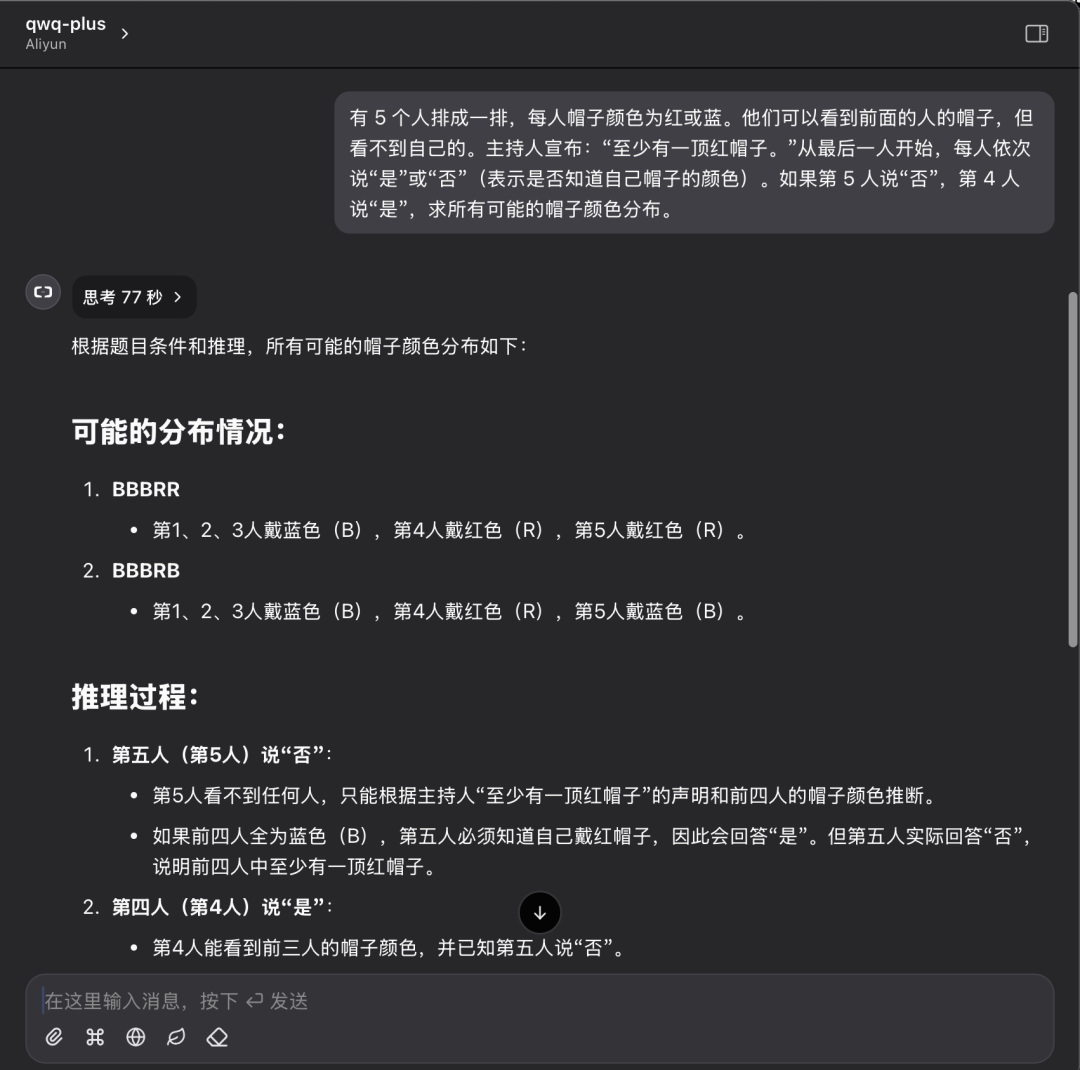

QwQ Plus API 성능:

동일한 질문에 대한 QwQ Plus API 성능: 77초 만에 한 번 정답을 맞혔습니다.

테스트 결과 분석:

단일 사례만으로는 모델 기능을 완전히 평가할 수는 없지만, 이 테스트의 결과는 로컬에 배포된 모델과 클라우드 API 솔루션의 차이를 시각적으로 반영할 수 있습니다. 논리적 추론 문제를 해결할 때 두 솔루션 모두 정답을 제공할 수 있지만, 추론 프로세스의 효율성과 명확성 측면에서는 추론 시간이 짧고 토큰 소비량이 적은 QwQ Plus API가 더 나은 것으로 나타났습니다.

모두를 위한 클라우드 AI 도입

알리클라우드 백 리파인 플랫폼에서 QwQ-32B API 인터페이스를 무료로 개방하고 푸짐한 무료 토큰을 제공하는 것은 의심할 여지 없이 대규모 언어 모델링 기술의 대중화를 촉진하는 데 중요한 단계입니다. API 인터페이스를 통해 사용자는 값비싼 하드웨어 비용에 투자하지 않고도 클라우드에서 고성능 AI 모델의 성능을 쉽게 경험할 수 있습니다. 개발자, 연구자 또는 AI 애호가라면 이제 알리윈 헌드레드 리파인에서 제공하는 무료 리소스를 최대한 활용하여 AI 탐색 여정을 시작할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...