일반 소개

에이전틱시크릿은 오픈 소스 AI 어시스턴트로, 완전히 네이티브로 실행되는 Deepseek R1 모델 개발. 클라우드 API가 필요하지 않으며 수백 달러의 월 사용료가 발생하지 않습니다. 영화 '자비스'와 유사한 지능형 비서가 되어 사용자의 컴퓨터에서 코드 작성, 파일 관리, 웹 브라우징 등의 작업을 수행하면서 데이터 프라이버시를 보장하는 것이 목표입니다. 개발자 Martin. 르그랑은 이를 다음과 같이 포지셔닝했습니다. Manus 로컬에서 실행되는 100%에 중점을 둔 AI의 로컬 대안입니다. 2025년 3월 현재 깃허브에는 181개의 별과 16개의 포크가 있으며, 커뮤니티는 계속해서 활발히 활동하며 기여자를 환영합니다.

기능 목록

- 완전한 로컬 운영인터넷 연결이 필요하지 않고 모든 계산이 사용자 기기에서 이루어지며 데이터 유출이 없습니다.

- 음성 상호작용음성 입력 명령 및 음성 응답을 지원하여 조작 편의성을 높입니다.

- 파일 시스템 작동Bash를 통해 로컬 파일을 탐색하고 작업합니다.

- 코드 작성 및 디버깅파이썬, C, 골랑 등에 대한 코드 생성 및 버그 수정 지원.

- 자율 오류 수정명령이 실패하거나 코드 오류가 발생하면 AI가 자동으로 재시도하여 수정합니다.

- 지능형 작업: 작업 유형에 따라 적절한 기능 모듈을 자동으로 선택합니다.

- 멀티 에이전트 협업복잡한 작업을 여러 상담원이 분할하여 계획하고 실행할 수 있습니다.

- 도구 지원검색, 파일 탐색 및 기타 유틸리티가 내장되어 있습니다.

- 메모리 기능대화 기록 및 사용자 기본 설정을 보존하고 긴 문맥 교환을 지원합니다.

- 웹 브라우저웹 페이지를 탐색하고 스스로 정보를 추출할 수 있습니다.

도움말 사용

에이전틱시크릿을 설치하고 사용하려면 약간의 기술적 배경 지식이 필요하지만 단계는 간단합니다. 다음은 빠르게 시작할 수 있는 자세한 가이드입니다.

설치 프로세스

- 환경 준비

- 컴퓨터가 Python 3을 지원하는지, 최소 8GB의 RAM이 권장되는지, GPU에 8GB 이상의 비디오 메모리가 필요한지 확인하세요(14B 모델의 경우 12GB 권장).

- 코드 다운로드를 위해 Git을 설치합니다.

- 핵심 종속 요소인 Ollama(로컬 모델 실행 도구)를 다운로드하여 설치합니다. 방문 Ollama 공식 웹사이트 Get it.

- 에이전트 검색 다운로드

- 터미널을 엽니다(Windows의 경우 CMD 또는 PowerShell, Mac/Linux의 경우 터미널).

- 명령을 입력합니다 복제 프로젝트:

git clone https://github.com/Fosowl/agenticSeek.git - 프로젝트 카탈로그로 이동합니다:

cd agenticSeek

- 가상 환경 만들기

- 독립 실행형 환경을 만들려면 명령을 입력합니다:

python3 -m venv agentic_seek_env - 환경을 활성화합니다:

- Windows:

agentic_seek_env\Scripts\activate - Mac/Linux:

source agentic_seek_env/bin/activate

- Windows:

- 독립 실행형 환경을 만들려면 명령을 입력합니다:

- 종속성 설치

- 환경을 활성화한 후 실행합니다:

pip install -r requirements.txt - 또는 자동 설치 스크립트(Mac/Linux)를 사용하세요:

./install.sh

- 환경을 활성화한 후 실행합니다:

- 모델 구성 및 다운로드

- Ollama가 설치되어 있는지 확인하고 서비스를 시작합니다:

ollama serve - 다운로드 Deepseek R1 모델(14B 권장, 낮은 구성 장치의 경우 7B):

ollama pull deepseek-r1:14b - 컴파일러

config.ini를 클릭하고 로컬에서 실행되도록 설정합니다:[MAIN] is_local = True provider_name = ollama provider_model = deepseek-r1:14b

- Ollama가 설치되어 있는지 확인하고 서비스를 시작합니다:

- 에이전트 검색 시작

- 입력:

python main.py - 터미널 프롬프트가 표시되면 성공적으로 실행되었다는 뜻입니다.

- 입력:

기능 작동 흐름

음성 상호작용

- 개봉 방법: in

config.ini설정speak = True노래로 응답listen = True. - 활용음성 모드를 시작할 때 "음성 모드 시작"이라고 말한 다음 "코드 작성해줘"와 같이 음성으로 질문하세요.

- 포인트마이크와 스피커가 작동하는지 확인하면서 AI가 음성으로 대답합니다.

- 다음 사항에 유의하십시오.볼륨을 처음 조정해야 할 수 있으며, 저사양 기기에서는 지연이 발생할 수 있습니다.

파일 시스템 작동

- 카탈로그 설정: in

config.ini에 지정된work_dir예/Users/你的用户名/文档. - 활용: "모든 텍스트 파일 나열"을 입력하면 AI가 결과를 반환합니다.

- 고급 기능"이 파일의 내용을 분석합니다"라고 표시되며 주요 정보를 추출합니다.

- 기교"새 폴더 만들기"와 같은 Bash 명령이 지원됩니다.

코드 작성 및 디버깅

- 작동 방법"파이썬 정렬 알고리즘 작성"을 입력하면 AI가 코드를 생성합니다.

- 테스트 중 구성 요소 조정코드에 오류가 있는 경우 "이 오류 수정해줘"라고 말하면 AI가 오류를 분석하여 수정합니다.

- 지원 언어현재 파이썬, C, 골랑을 포함하며 추후 확장될 예정입니다.

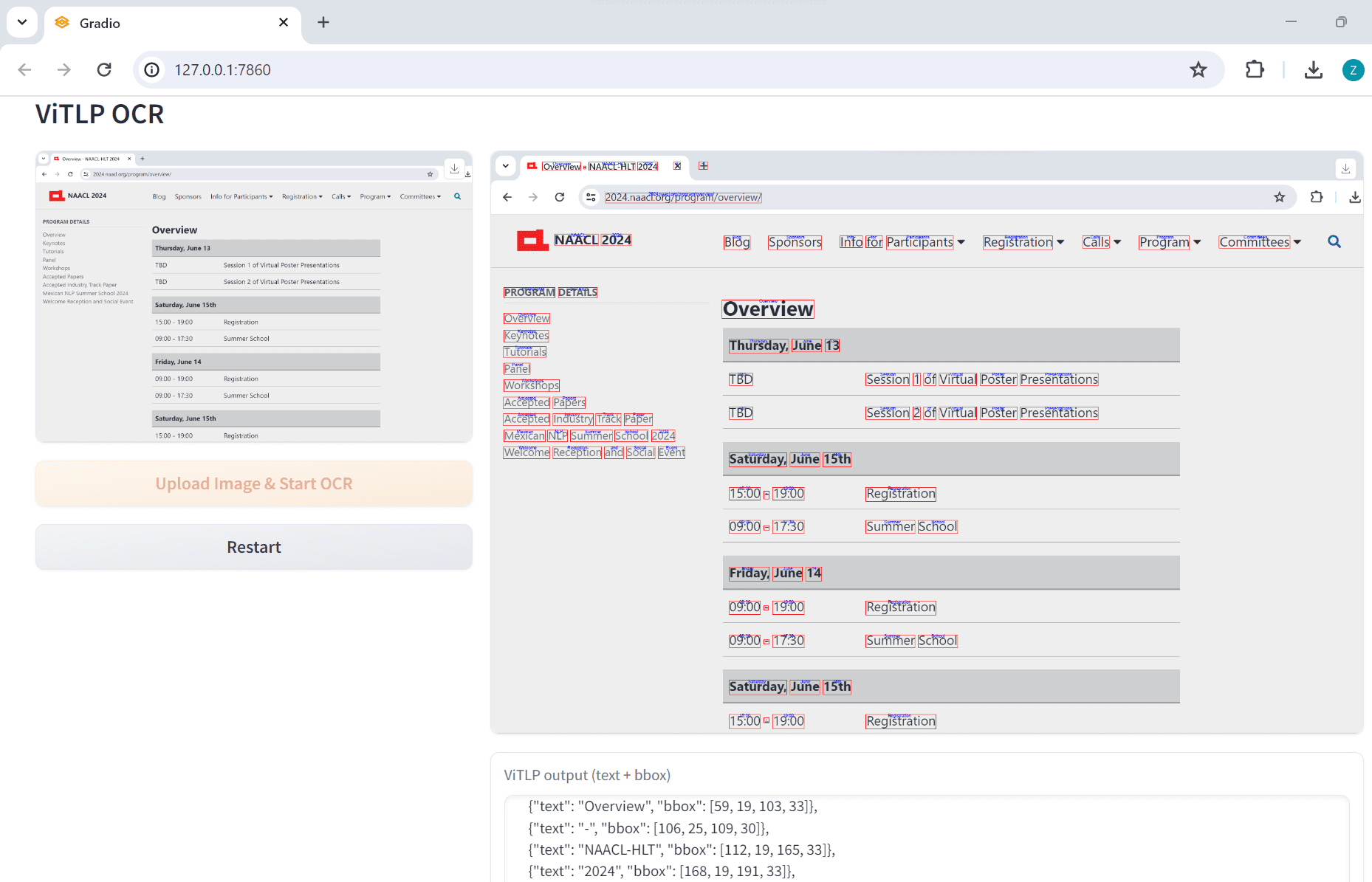

웹 브라우저

- 활용"최신 AI 뉴스 찾기"를 입력하면 AI가 페이지를 탐색하고 정보를 수집합니다.

- 제약 조건현재 텍스트만 추출되며, 이미지나 동영상 구문 분석은 지원되지 않습니다.

- 기교: "Deepseek R1 업데이트 검색"과 같은 키워드를 지정할 수 있습니다.

자율 오류 수정

- 작동 방법: 특별한 설정이 필요하지 않습니다. 명령이 실패하면 AI가 자동으로 복구를 시도합니다.

- 일반적인 예"파일 X 열기"라는 잘못된 명령을 입력하면 AI가 파일이 존재하지 않는다고 표시하고 대안을 제시합니다.

원격 조작(선택 사항)

- take로컬 장비 성능이 충분하지 않은 경우 서버를 사용하여 모델을 실행할 수 있습니다.

- 이동::

- 서버에서 Ollama를 시작하고 IP를 가져옵니다(예

192.168.1.100). - 서버 스크립트를 실행합니다:

python server_ollama.py - 로컬 수정

config.ini::[MAIN] is_local = False provider_name = server provider_model = deepseek-r1:14b provider_server_address = 192.168.1.100:5000 - 로컬에서 실행:

python main.py

- 서버에서 Ollama를 시작하고 IP를 가져옵니다(예

주의

- 하드웨어 요구 사항7B 모델은 8GB, 14B는 12GB(예: RTX 3060), 32B는 24GB 이상의 비디오 메모리가 필요합니다.

- 테스트 중 구성 요소 조정시작에 실패하면 Ollama가 실행 중인지 확인하거나 터미널 오류 로그를 확인하세요.

- 업데이트정기 운영

git pull최신 기능을 사용해 보세요. - 라이선스이 프로젝트는 GPL-3.0에 따라 오픈 소스이며 무료입니다.

애플리케이션 시나리오

- 프로그래밍 보조 도구

복잡한 로직을 디버깅하는 등 코드 작성에 어려움을 겪을 때 에이전틱시크가 코드를 생성하고 오류를 수정하며 코드 세부 사항을 설명해줍니다. - 문서 관리

컴퓨터 파일이 어지럽습니다. 디렉토리를 설정하면 AI가 파일을 나열하고, 내용을 추출하고, 일괄 작업까지 수행할 수 있습니다. - 학습 지원

학생들은 음성 상호작용을 통해 문서를 분석하고, 정보를 검색하고, 메모를 작성하는 데 사용하여 효율성을 높일 수 있습니다. - 개인정보 보호 의무

에이전틱시크릿은 인터넷 연결 없이 로컬에서 실행되므로 민감한 데이터를 처리할 때 정보 보안을 보장합니다.

QA

- 100%가 로컬에서 실행된다는 것이 사실인가요?

예, 올라마 또는 서버 모드를 사용하는 경우 모든 처리는 로컬로 이루어지며, 비로컬 옵션(예: OpenAI)은 선택 사항으로만 제공됩니다. - 하드웨어가 충분하지 않으면 어떻게 하나요?

7B 모델을 사용하거나 원격 서버를 통해 상위 모델을 실행하세요. - 문제가 발생하면 어떻게 하나요?

Ollama가 실행 중인지 확인하고config.ini설정을 변경하세요. 그래도 실패하면 GitHub에 이슈를 제출할 수 있습니다. - 마누스 AI보다 나은 점은 무엇인가요?

클라우드 서비스를 사용하지 않으려는 사용자를 위한 로컬 운영 및 개인 정보 보호에 중점을 둡니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...