关于 AI 基准测试以及 AI 实验室如何公布测试结果的争论正日益公开化。长期以来,AI 性能的衡量标准和报告方式就充满了争议,如今,这些幕后争论终于走到了聚光灯下。

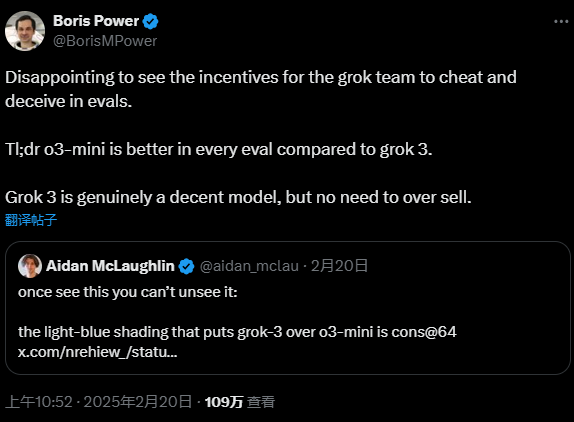

本周,一位 OpenAI 员工 公开指责 埃隆·马斯克 (Elon Musk) 创立的 AI 公司 xAI, 称其发布了具有误导性的基准测试结果,以此宣传他们最新的 AI 模型 Grok 3。 面对指责,xAI 的联合创始人之一 伊戈尔·巴布什金 (Igor Babushkin) 立即回应 ,坚称 xAI 的做法并无不妥。 这场公开论战,无疑将 AI 性能评估的透明度问题推到了风口浪尖。

但事实真相,或许介于双方各执一词之间。 如同许多技术领域的争端一样,真理往往隐藏在表象之下,需要更深入的挖掘和审视。

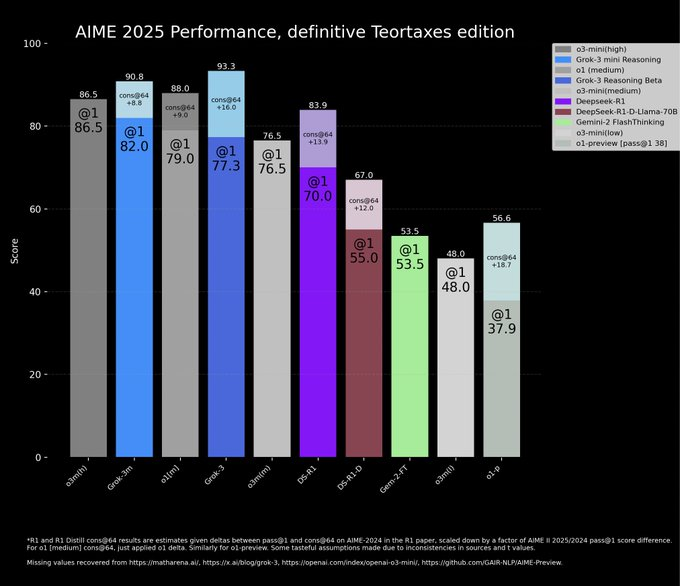

在 xAI 官方博客发布的一篇文章中,xAI 展示了一张图表,用以说明 Grok 3 在 AIME 2025 基准测试中的卓越性能。 AIME 2025 汇集了近期一次高难度的邀请制数学考试题目,被认为是衡量 AI 数学能力的试金石。 然而,值得注意的是,早已有专家质疑 AIME 作为 AI 基准测试的有效性。 选择这样一个备受争议的基准来展示模型能力,xAI 的用意或许值得玩味。 尽管如此,AIME 2025 及其早期版本仍然被广泛用于评估 AI 模型的数学推理能力。

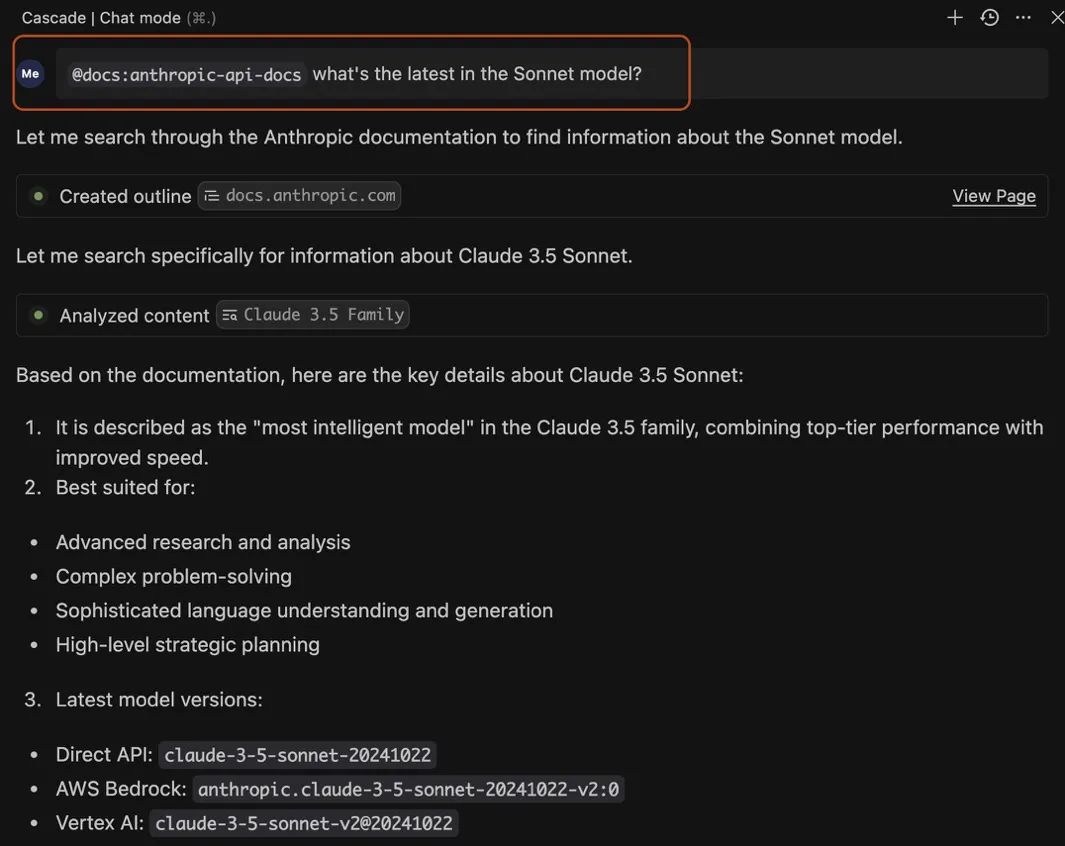

xAI 在图表中宣称,Grok 3 的两个版本,Grok 3 Reasoning Beta 和 Grok 3 mini Reasoning,在 AIME 2025 测试中均超越了 OpenAI 当前最先进的模型 o3-mini-high。 然而,OpenAI 的员工迅速在 X 平台上指出,xAI 的图表存在关键漏洞:它遗漏了 o3-mini-high 在 “cons@64” 条件下的 AIME 2025 测试分数。 这种选择性展示数据的方式,不禁让人对 xAI 的真实意图产生疑问。

你或许会问, “cons@64” 究竟是什么? 简单来说,它是 “consensus@64” 的缩写, 是一种特殊的评估方法。 在这种方法下,模型在回答基准测试中的每个问题时,可以尝试 64 次, 并将出现频率最高的答案作为最终答案。 不难想象, “cons@64” 机制往往会显著提高模型的基准测试得分。 xAI 在图表中刻意忽略 “cons@64” 数据, 可能会造成 Grok 3 性能远超其他模型的假象, 但事实可能并非如此。 这种 “取巧” 的做法, 是否有违公平竞争的原则?

从实际数据来看,Grok 3 Reasoning Beta 和 Grok 3 mini Reasoning 在 “@1” 条件下即模型在基准测试中首次尝试的得分的 AIME 2025 分数, 实际上都低于 o3-mini-high 的分数。 甚至 Grok 3 Reasoning Beta 的成绩,也仅仅是略微领先于 OpenAI 的 o1 模型 (设置为 “medium” 计算)。 然而,即使在这样的数据对比下,xAI 仍然高调宣传 Grok 3 是 “世界上最聪明的 AI”。 这种宣传策略,与其说是基于严谨的科学论证,不如说是为了抢占市场眼球的营销手段。 在 AI 技术日新月异的当下, 究竟是脚踏实地的技术进步更重要,还是夸大其词式的营销炒作更能赢得未来? 这或许是整个 AI 行业都应该认真思考的问题。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...