综合介绍

GPUStack 是一个开源的 GPU 集群管理工具,专为运行大语言模型(LLMs)而设计。它支持多种硬件,包括 Apple MacBooks、Windows PCs 和 Linux 服务器,能够轻松扩展 GPU 数量和节点,以满足不断增长的计算需求。GPUStack 提供分布式推理功能,支持单节点多 GPU 和多节点推理与服务,兼容 OpenAI API,简化用户和 API 密钥管理,并实时监控 GPU 性能和利用率。其轻量级 Python 包设计,确保最小的依赖和操作开销,是开发者和研究人员的理想选择。

功能列表

- 支持多种硬件:兼容 Apple Metal、NVIDIA CUDA、Ascend CANN、Moore Threads MUSA 等。

- 分布式推理:支持单节点多 GPU 和多节点推理与服务。

- 多种推理后端:支持 llama-box(llama.cpp)和 vLLM。

- 轻量级 Python 包:最小依赖和操作开销。

- OpenAI 兼容 API:提供与 OpenAI 标准兼容的 API 服务。

- 用户和 API 密钥管理:简化用户和 API 密钥管理。

- GPU 性能监控:实时监控 GPU 性能和利用率。

- 令牌使用和速率监控:有效管理令牌使用和速率限制。

使用帮助

安装流程

Linux 或 MacOS

- 打开终端。

- 运行以下命令安装 GPUStack:

curl -sfL https://get.gpustack.ai | sh -s -

- 安装完成后,GPUStack 将作为服务运行在 systemd 或 launchd 系统上。

Windows

- 以管理员身份运行 PowerShell(避免使用 PowerShell ISE)。

- 运行以下命令安装 GPUStack:

Invoke-Expression (Invoke-WebRequest -Uri "https://get.gpustack.ai" -UseBasicParsing).Content

使用指南

初始设置

- 访问 GPUStack UI:在浏览器中打开

http://myserver。 - 使用默认用户名

admin和初始密码登录。获取初始密码的方法:- Linux 或 MacOS:运行

cat /var/lib/gpustack/initial_admin_password。 - Windows:运行

Get-Content -Path "$env:APPDATA\gpustack\initial_admin_password" -Raw。

- Linux 或 MacOS:运行

创建 API 密钥

- 登录 GPUStack UI 后,点击导航菜单中的“API Keys”。

- 点击“New API Key”按钮,填写名称并保存。

- 复制生成的 API 密钥并妥善保存(仅在创建时可见)。

使用 API

- 设置环境变量:

export GPUSTACK_API_KEY=myapikey

- 使用 curl 访问 OpenAI 兼容 API:

curl http://myserver/v1-openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $GPUSTACK_API_KEY" \

-d '{

"model": "llama3.2",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": true

}'

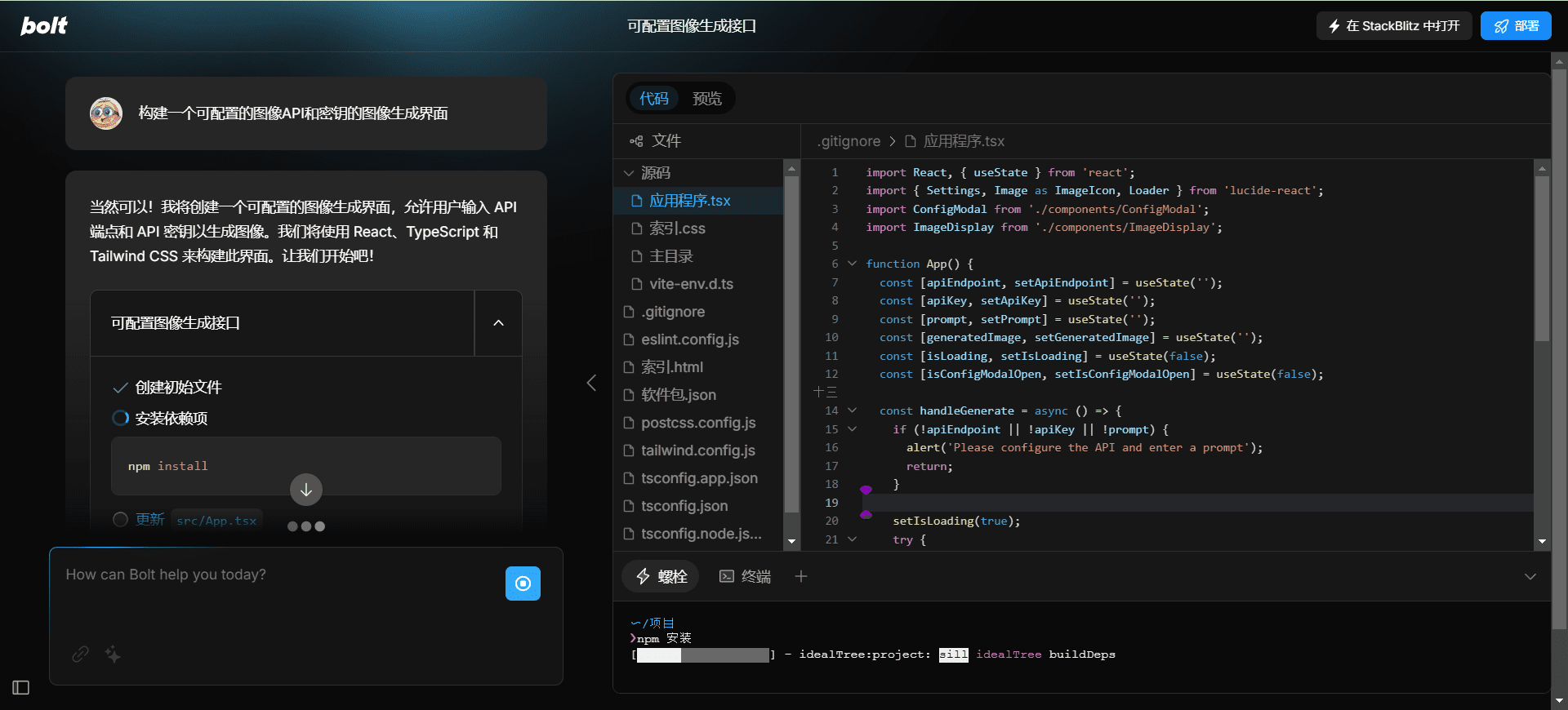

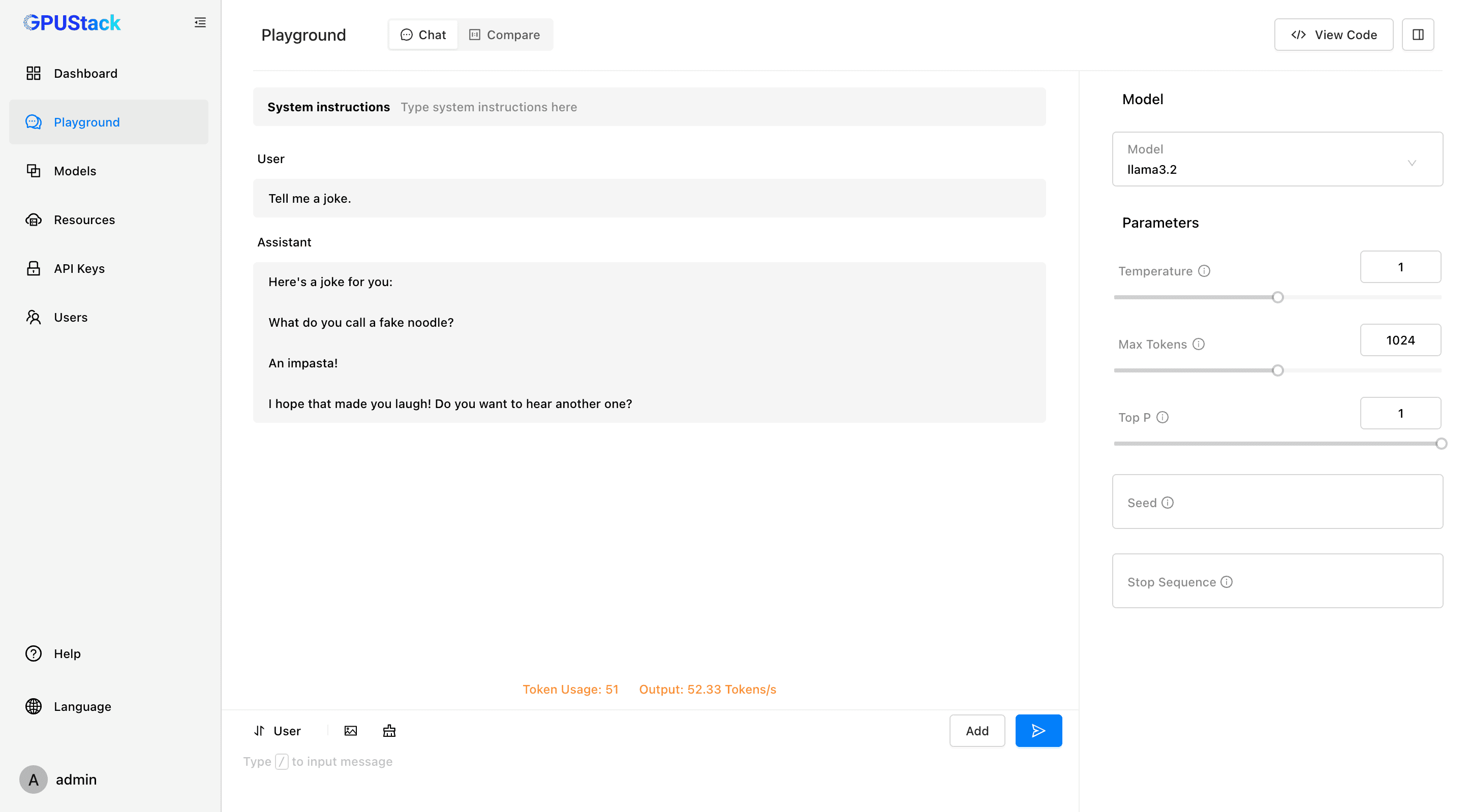

运行和聊天

- 在终端中运行以下命令与 llama3.2 模型聊天:

gpustack chat llama3.2 "tell me a joke."

- 在 GPUStack UI 中点击“Playground”进行交互。

监控和管理

- 实时监控 GPU 性能和利用率。

- 管理用户和 API 密钥,跟踪令牌使用和速率。

支持的模型和平台

- 支持的模型:LLaMA、Mistral 7B、Mixtral MoE、Falcon、Baichuan、Yi、Deepseek、Qwen、Phi、Grok-1 等。

- 支持的多模态模型:Llama3.2-Vision、Pixtral、Qwen2-VL、LLaVA、InternVL2 等。

- 支持的平台:MacOS、Linux、Windows。

- 支持的加速器:Apple Metal、NVIDIA CUDA、Ascend CANN、Moore Threads MUSA,未来计划支持 AMD ROCm、Intel oneAPI、Qualcomm AI Engine。

文档和社区

- 官方文档:访问 GPUStack 文档 获取完整的使用指南和 API 文档。

- 贡献指南:阅读 贡献指南 了解如何为 GPUStack 做出贡献。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...