Google 发布了一款被称为全新“推理”AI模型的产品——但目前还处于实验阶段,从我们的简短测试来看,该模型确实还有提升空间。

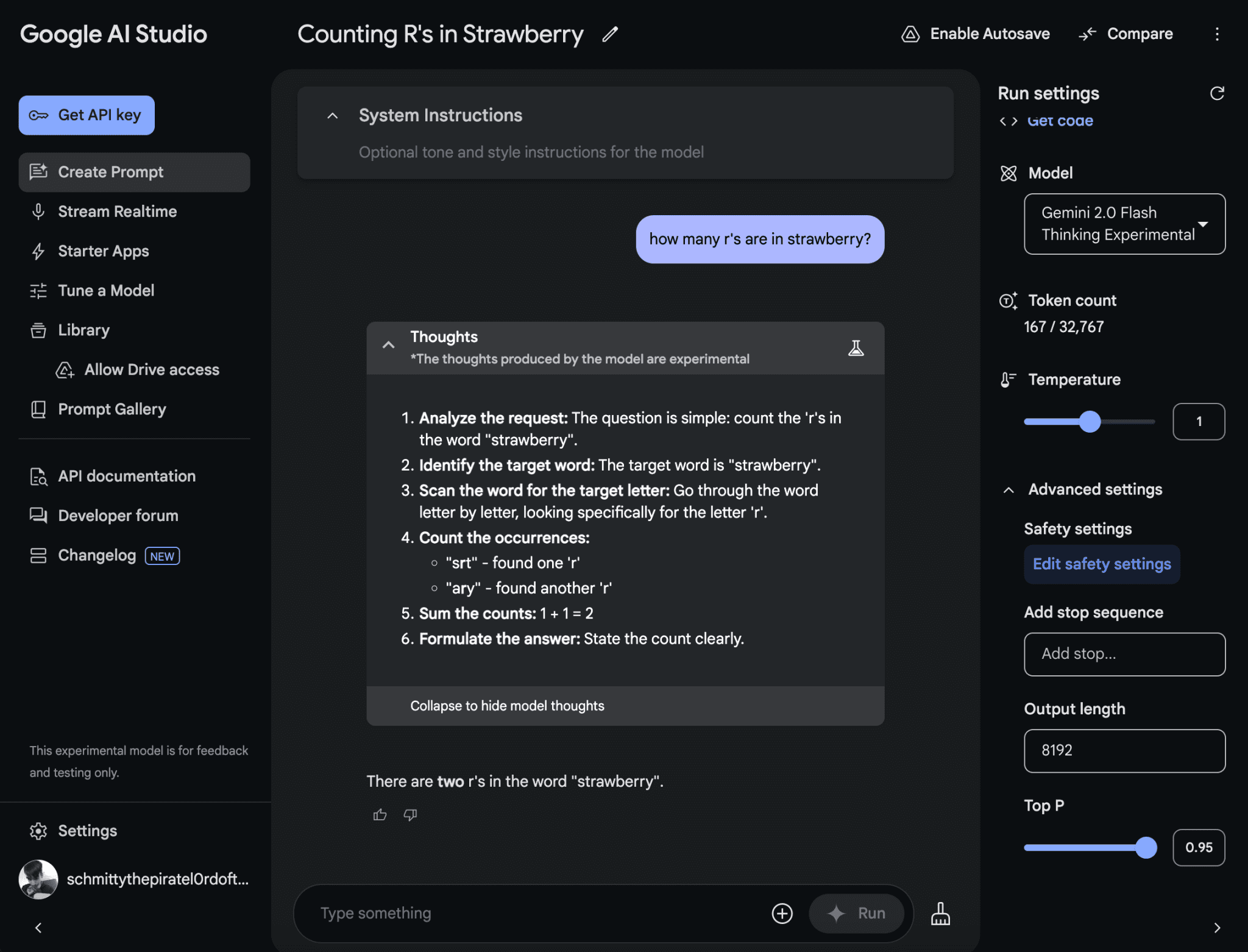

这款新模型名为 Gemini 2.0 Flash Thinking Experimental(这个名字有点拗口),可以在 AI Studio 中使用,这是 Google 的 AI 原型开发平台。模型卡中描述其“最适用于多模态理解、推理和编码”,能够“在编程、数学和物理等领域解决最复杂的问题”。

在 X 上的一则 帖子 中,负责 AI Studio 产品的 Logan Kilpatrick 称 Gemini 2.0 Flash Thinking Experimental 是 Google“推理旅程中的第一步”。Google DeepMind 的首席科学家 Jeff Dean 在他自己的 帖子 中表示,Gemini 2.0 Flash Thinking Experimental 被训练为使用思维来增强推理能力。

“当我们增加推理时间的计算量时,我们看到了令人鼓舞的结果,”Dean 表示,这指的是模型在回答问题时所需的计算量。

Gemini 2.0 Flash Thinking Experimental 构建在 Google 最近发布的 Gemini 2.0 Flash 模型基础上,其设计似乎与 OpenAI 的 o1 和其他所谓的推理模型相似。不像大多数 AI,推理模型能有效地自我校验,从而避免一些通常会让 AI 模型犯错的陷阱。

然而,推理模型的一个缺点是,它们通常需要更长的时间——通常从几秒到几分钟——来得出解决方案。

面对一个提示,Gemini 2.0 Flash Thinking Experimental 会在回应前稍作停顿,考虑多个相关的提示,并在过程中“解释”其推理。稍后,模型会总结出它认为最准确的答案。

嗯——理论上应该是这样。当我问 Gemini 2.0 Flash Thinking Experimental 单词“strawberry”中有几个 R 时,它回答“两个”。

Google 的新推理模型在数单词字母时表现不佳,有时会出错。图片来源:Google

实际效果可能因人而异。

在 o1 发布之后,来自竞争对手 AI 实验室的推理模型出现了爆炸式增长——不仅仅是 Google。一家由量化交易员资助的 AI 研究公司 DeepSeek 在 11 月初预览了其首个推理模型 DeepSeek-R1。同月,阿里巴巴的 Qwen 团队发布了号称首个开放挑战 o1 的推理模型。

在 10 月报道称,Google 有多个团队在开发推理模型。随后,《The Information》在 11 月的报道中透露,Google 至少有 200 名研究人员专注于这项技术。

是什么引爆了推理模型的热潮?其中一个原因是寻找改进生成式 AI 的新方法。正如我的同事 Max Zeff 最近报道,“暴力破解”技术以扩大模型规模已不再带来之前的提升。

并非所有人都相信推理模型是最佳的发展路径。一方面,它们往往成本高昂,因为运行模型需要大量计算能力。而且,尽管它们在基准测试中表现不错,但尚不清楚推理模型是否能维持这一进展速度。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...