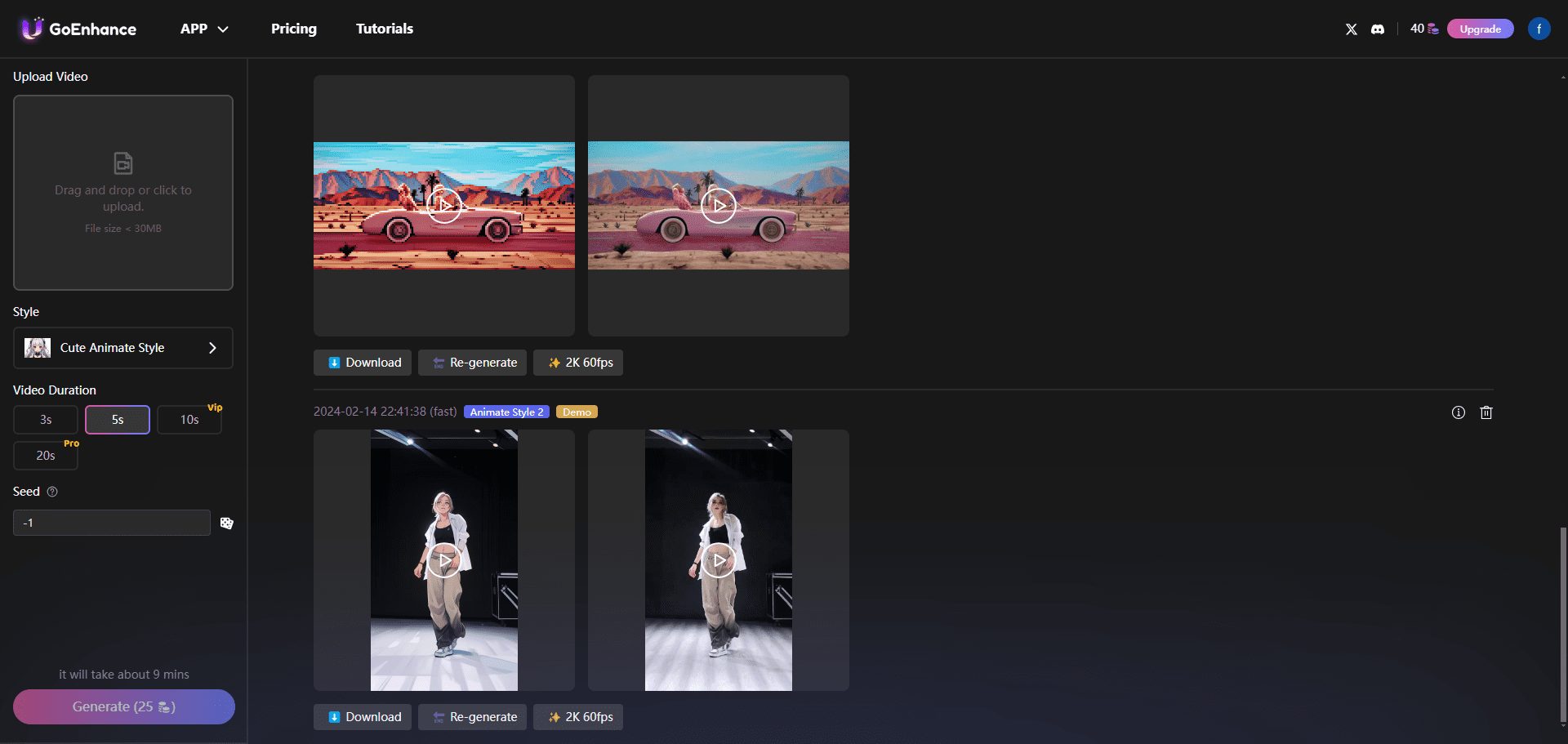

综合介绍

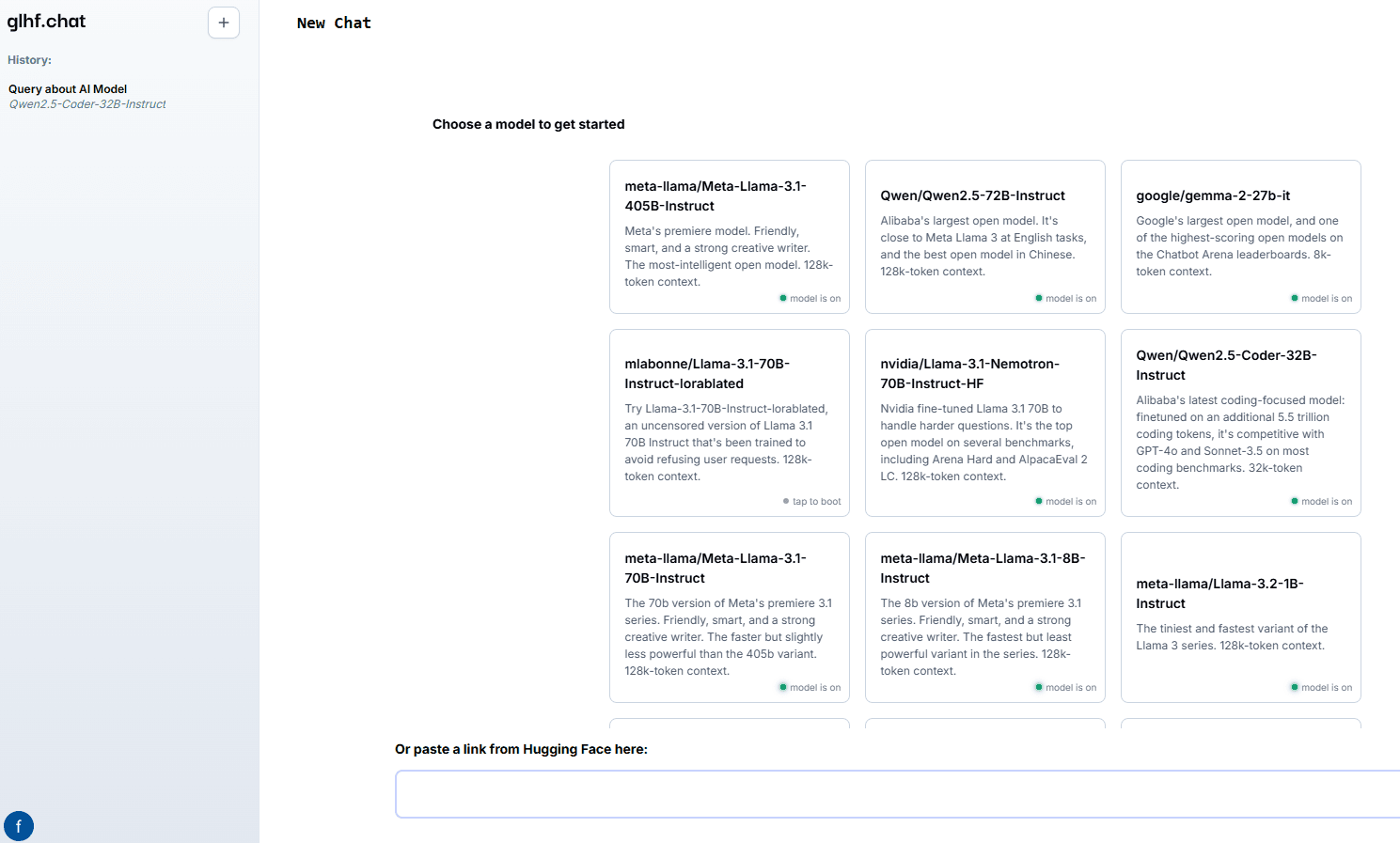

good luck have fun (glhf.chat) 是一个提供开源大模型聊天服务的网站。用户可以通过该平台使用vLLM和定制的自动扩展GPU调度器,运行几乎任何开源大模型。用户只需粘贴Hugging Face仓库链接,即可使用聊天界面或OpenAI兼容API进行交互。平台在测试期间免费提供服务,未来将以低于主要云GPU供应商的价格提供服务。

功能列表

- 支持多种开源大模型,包括Meta Llama、Qwen、Mixtral等

- 提供最多八个Nvidia A100 80Gb GPU的使用权限

- 自动代理流行模型的推理服务

- 按需启动和关闭集群,优化资源使用

- 提供OpenAI兼容API,方便集成

使用帮助

安装与使用

- 注册与登录:访问glhf.chat并注册账号,完成后登录。

- 选择模型:在平台首页选择所需的大模型,支持的模型包括Meta Llama、Qwen、Mixtral等。

- 粘贴链接:将Hugging Face仓库链接粘贴到指定位置,平台会自动加载模型。

- 使用聊天界面:通过网站提供的聊天界面与模型进行交互,输入问题或指令,模型会实时生成回复。

- API集成:使用OpenAI兼容API,将平台功能集成到自己的应用中。API文档详见网站帮助中心。

详细功能操作流程

- 模型选择与加载:

- 登录后,进入模型选择页面。

- 浏览支持的模型列表,点击所需模型。

- 在弹出的对话框中粘贴Hugging Face仓库链接,点击“加载模型”按钮。

- 等待模型加载完成,加载时间取决于模型大小和网络状况。

- 聊天界面使用:

- 模型加载完成后,进入聊天界面。

- 在输入框中输入问题或指令,点击发送。

- 模型会根据输入生成回复,回复内容会显示在聊天窗口中。

- 可以连续输入多个问题或指令,模型会逐一处理并回复。

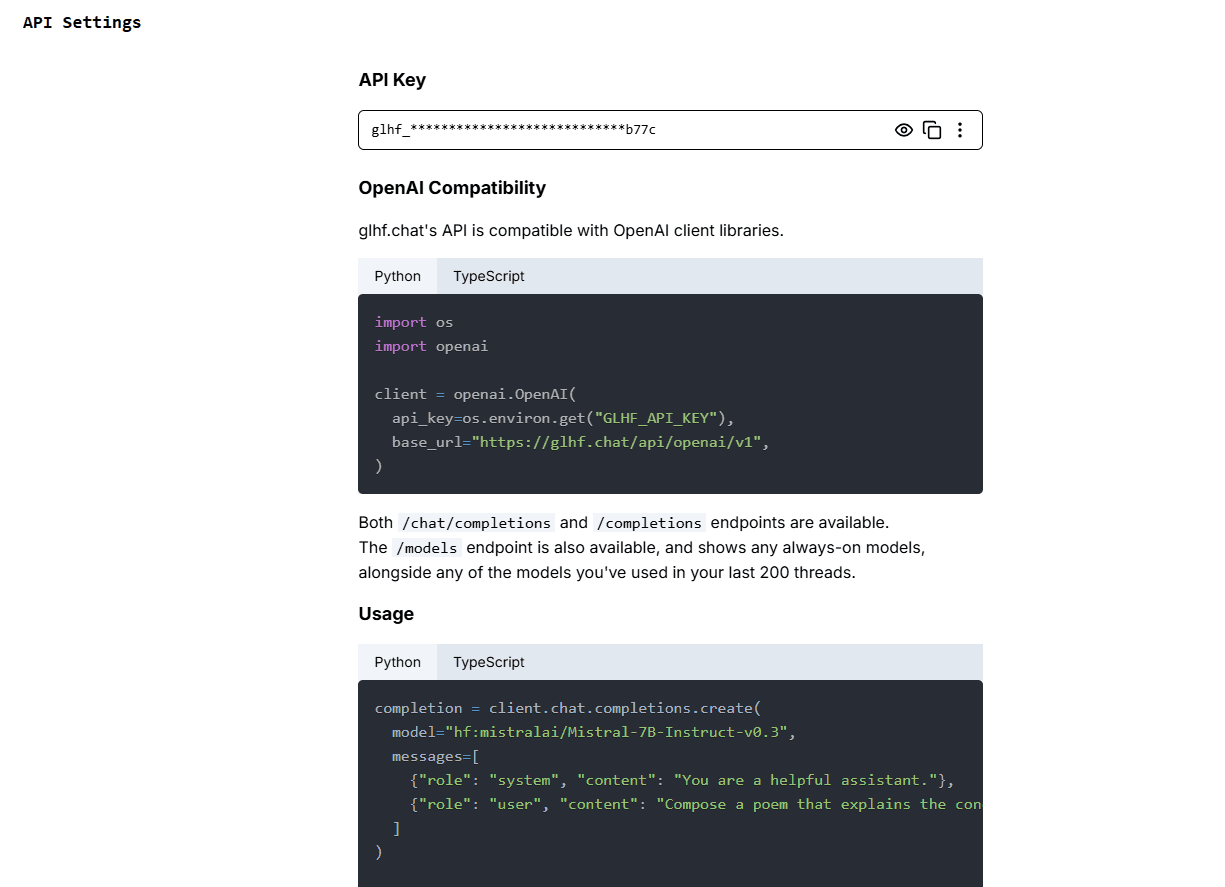

- API使用:

- 访问API文档页面,获取API密钥和使用说明。

- 在应用中集成API,按照文档提供的示例代码进行调用。

- 通过API发送请求,获取模型生成的回复。

- API支持多种编程语言,具体示例代码详见文档。

资源管理与优化

- 自动扩展:平台使用定制的GPU调度器,根据用户需求自动扩展和缩减GPU资源,确保高效利用。

- 按需启动:对于不常用的模型,平台会按需启动集群,使用完毕后自动关闭,节省资源。

- 免费测试:在测试期间,用户可以免费使用平台提供的所有功能,测试结束后将推出优惠的定价方案。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...