综合介绍

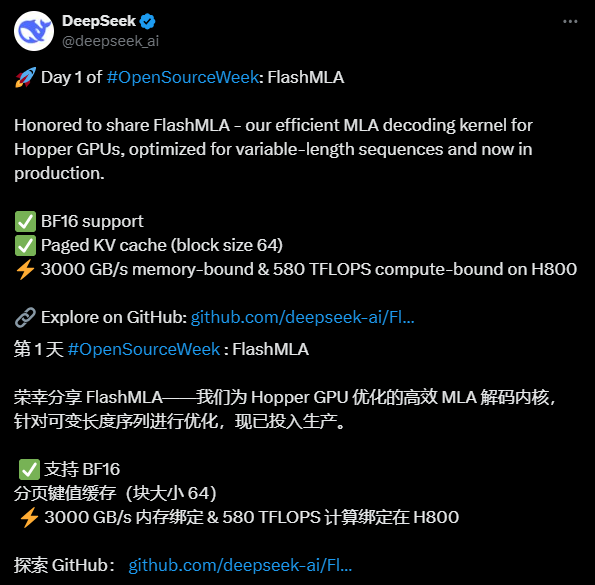

FlashMLA 是由 DeepSeek AI 开发的一款高效 MLA(Multi-head Latent Attention)解码内核,专为 NVIDIA Hopper 架构 GPU 优化,旨在提升变长序列处理的性能。该项目已在 GitHub 上开源,提供给开发者免费使用。它支持 BF16 精度计算和分页 KV 缓存(块大小为 64),在 H800 SXM5 上表现出色,内存密集型配置下可达 3000 GB/s 带宽,计算密集型配置下可达 580 TFLOPS 的算力。FlashMLA 的设计灵感来源于 FlashAttention 2&3 和 Cutlass 项目,适用于生产环境开箱即用的场景。DeepSeek AI 通过这一开源项目展示了其在 AI 技术领域的创新能力,吸引了广泛关注。

功能列表

- 高效 MLA 解码:针对 Hopper GPU 优化,显著提升变长序列的处理速度。

- 支持 BF16 精度:利用半精度浮点运算,在保持精度的同时提升计算效率。

- 分页 KV 缓存:采用块大小为 64 的分页机制,有效管理内存,提升推理性能。

- 高性能表现:在 H800 GPU 上提供高达 3000 GB/s 的内存带宽和 580 TFLOPS 的计算能力。

- 开源代码:提供完整源码,支持开发者自定义修改和集成。

使用帮助

安装流程

FlashMLA 是一个基于 GitHub 的开源项目,使用前需确保环境满足要求并完成安装。以下是详细步骤:

1. 环境準備

- 操作系统:支持 Linux 系统(推荐 Ubuntu 20.04 或以上)。

- 硬件要求:需要 NVIDIA Hopper 架构 GPU(如 H800 SXM5)。

- 软件依赖:

- CUDA 12.6 或以上版本(安装方法可参考 NVIDIA 官网)。

- PyTorch 2.0 或以上版本(推荐通过

pip install torch安装)。 - Python 3.8 或以上版本。

- 检查工具:确保安装 Git,用于从 GitHub 下载代码。

2. 下载源码

- 打开终端,输入以下命令克隆 FlashMLA 仓库:

git clone https://github.com/deepseek-ai/FlashMLA.git

- 进入项目目录:

cd FlashMLA

3. 安装依赖

项目依赖 PyTorch 和 CUDA,可通过以下命令安装:

pip install -r requirements.txt

如果没有 requirements.txt 文件,可直接确保 PyTorch 已安装:

pip install torch torchvision

验证 CUDA 是否可用:

python -c "import torch; print(torch.cuda.is_available())"

输出 True 表示环境配置成功。

4. 编译与测试

FlashMLA 提供预编译的 CUDA 插件,但需确保与本地 CUDA 版本匹配:

- 进入源码目录,运行编译脚本(若有):

python setup.py install - 测试安装是否成功,运行示例代码:

python example.py

若无报错,表示安装完成。

如何使用

FlashMLA 的核心功能是提供高效的 MLA 解码支持,适用于 AI 模型推理任务。以下是具体操作步骤:

功能 1:加载并运行 FlashMLA

- 导入模块:

在 Python 脚本中引入 FlashMLA 核心函数:from flash_mla import get_mla_metadata, flash_mla_with_kvcache - 准备输入数据:

cache_seqlens:定义 KV 缓存的序列长度。q_i:查询张量。kvcache_i:KV 缓存数据。block_table:分页缓存的块表。

- 获取元数据:

tile_scheduler_metadata, num_splits = get_mla_metadata(cache_seqlens, s_q * h_q // h_kv, h_kv) - 运行解码:

o_i, lse_i = flash_mla_with_kvcache(q_i, kvcache_i, block_table, cache_seqlens, dv, tile_scheduler_metadata, num_splits, causal=True)输出

o_i为解码结果,lse_i为日志和值。

功能 2:优化变长序列处理

- 场景:处理动态长度的输入序列时,FlashMLA 通过分页 KV 缓存减少内存占用。

- 操作:

- 配置分页参数:块大小固定为 64,可通过调整

cache_seqlens控制序列长度。 - 运行时指定

causal=True,确保因果注意力机制生效。

- 配置分页参数:块大小固定为 64,可通过调整

- 效果:在 H800 上可实现 3000 GB/s 的内存带宽,适合大规模推理任务。

功能 3:性能测试

- 测试方法:

- 编辑示例脚本(如

example.py),增加输入数据规模。 - 使用以下代码记录性能:

import time start = time.time() # 运行解码代码 o_i, lse_i = flash_mla_with_kvcache(...) print(f"耗时: {time.time() - start} 秒")

- 编辑示例脚本(如

- 预期结果:内存密集型任务接近 3000 GB/s,计算密集型任务接近 580 TFLOPS。

注意事项

- 硬件兼容性:仅支持 Hopper GPU,建议使用 H800 或同级别设备。

- 调试技巧:若遇到 CUDA 错误,检查版本是否匹配,或在 GitHub Issues 中寻求社区支持。

- 生产环境:直接集成到现有模型推理流程中,确保输入数据格式与 FlashMLA 要求一致。

通过以上步骤,用户可快速上手 FlashMLA,享受其高效解码带来的性能提升。完整代码和文档可在 GitHub 仓库查看,建议结合实际项目需求调整参数。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

Related posts

暂无评论...