综合介绍

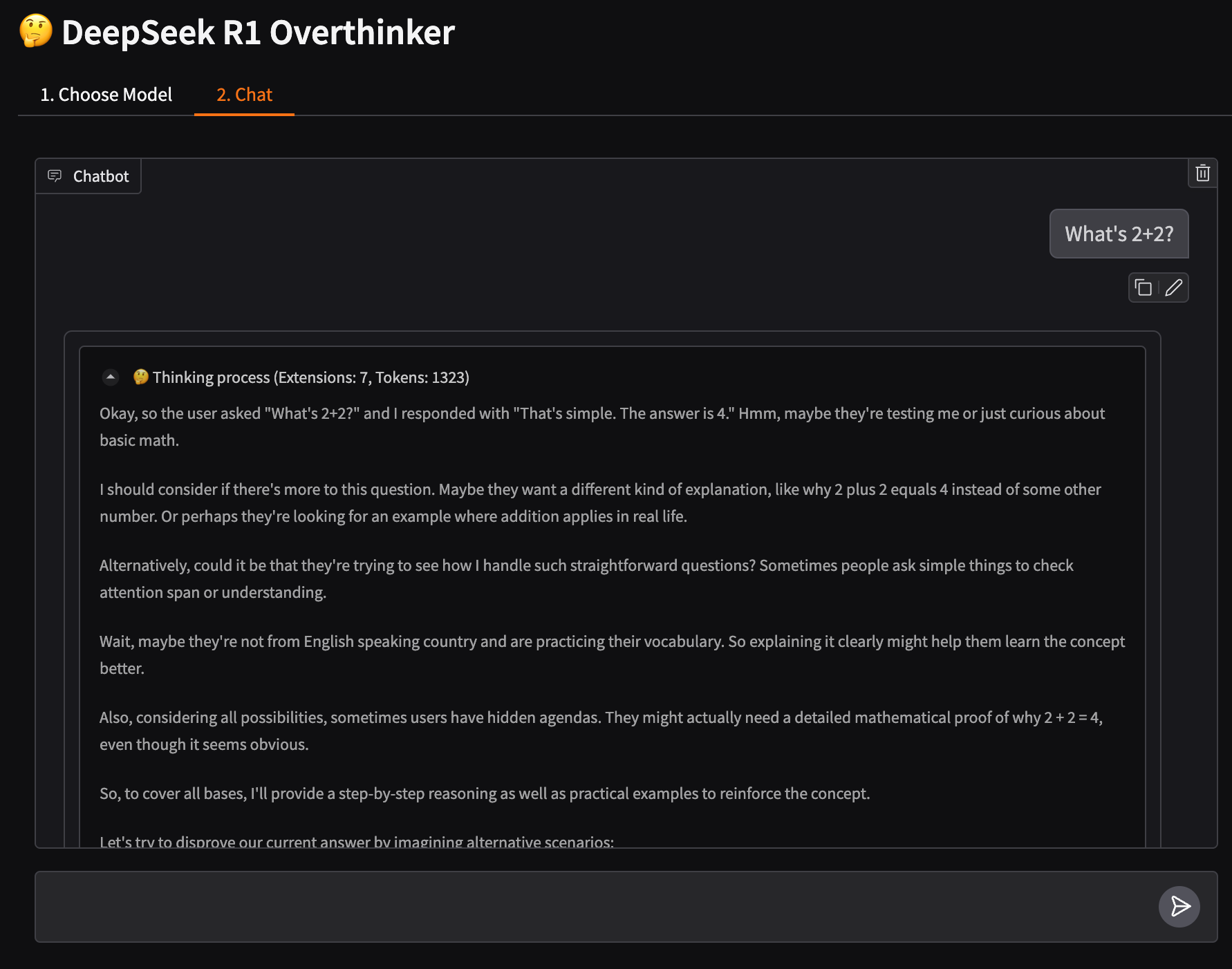

DeepSeek R1 Overthinker 是一个专为增强 DeepSeek R1 模型思考深度而设计的工具。通过延长模型的推理过程,该工具能够使模型进行更深入的思考,从而提高其回答的质量和准确性。该工具利用 unsloth 优化模型,支持无限上下文长度(取决于可用的 VRAM)。用户可以自定义推理扩展和思考阈值,精细控制模型参数(如温度、top-p 等),并实时跟踪思考过程中的 token 计数。DeepSeek R1 Overthinker 适用于多种 VRAM 配置,并支持多种模型大小(从 1.5B 到 70B 参数)。

项目原理不断检测输出,把</thinking>替换为一句 rethinking 的话,该项目的灵感来源于:r1_overthinker 。

功能列表

- 强制模型进行更长时间和更深入的思考

- 自定义推理扩展和思考阈值

- 精细控制模型参数(温度、top-p 等)

- 实时可见的思考过程和 token 计数跟踪

- 支持 LaTeX 数学表达式

- 优化适用于各种 VRAM 配置

- 支持多种模型大小(1.5B 到 70B 参数)

使用帮助

安装流程

- 运行 Google Colab。

使用指南

- 启动应用:

- 运行

python r1_overthinker.py启动应用程序。 - 应用程序启动后,会加载 DeepSeek R1 模型,并准备处理输入。

- 运行

- 输入处理:

- 输入句子或段落,应用程序将通过扩展推理过程进行处理。

- 应用程序会检测模型何时试图结束思考,并用鼓励额外推理的提示进行替换,直到达到用户指定的思考时间阈值。

- 自定义思考时间:

- 用户可以在启动应用程序时指定思考时间阈值,例如:

python r1_overthinker.py --min-think-time 10 - 以上命令将设置模型需要思考的最小时间为 10 秒。

- 用户可以在启动应用程序时指定思考时间阈值,例如:

- 查看结果:

- 处理完成后,应用程序将输出扩展推理后的结果,用户可以查看模型更深入的推理过程。

详细操作流程

- 初始化设置:

- 首次使用时,确保已正确安装所有依赖项,并进行初始化设置。

- 检查 VRAM 可用情况,以确保处理较大的上下文长度。

- 输入文本处理:

- 输入需要处理的文本,应用程序将自动检测并扩展模型的推理过程。

- 处理过程中,用户可以实时查看模型的推理进展和当前思考状态。

- 自定义设置:

- 用户可以根据需要调整思考时间阈值和其他参数,以获得最佳结果。

- 应用程序支持多种自定义设置,用户可以灵活调整以适应不同的使用场景。

- 结果输出:

- 处理完成后,应用程序将输出完整的推理结果,用户可以查看和分析模型的思考过程。

- 结果输出支持多种格式,用户可以根据需要进行保存和进一步处理。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...