综合介绍

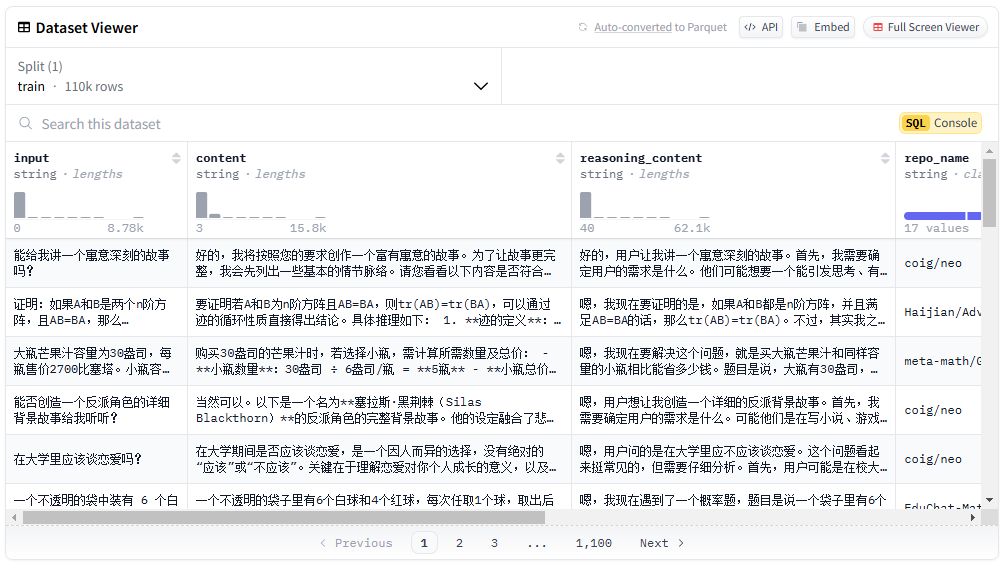

中文DeepSeek-R1蒸馏数据集是一个开源的中文数据集,包含110K条数据,旨在支持机器学习和自然语言处理研究。该数据集由刘聪NLP团队发布,数据集不仅包含数学数据,还包括大量的通用类型数据,如逻辑推理、小红书、知乎等。数据集的蒸馏过程严格按照DeepSeek-R1官方提供的细节进行,确保数据的高质量和多样性。用户可以在Hugging Face和ModelScope平台上免费下载和使用该数据集。

功能列表

- 多样化数据类型:包含数学、逻辑推理、通用类型数据等。

- 高质量数据:严格按照DeepSeek-R1官方提供的细节进行蒸馏。

- 免费开源:用户可以在Hugging Face和ModelScope平台上免费下载。

- 支持多种应用:适用于机器学习、自然语言处理等多种研究领域。

- 详细数据分布:提供数据的详细分类和数量信息。

使用帮助

安装流程

- 访问Hugging Face或ModelScope平台。

- 搜索“Chinese-DeepSeek-R1-Distill-data-110k”。

- 点击下载链接,选择合适的格式进行下载。

使用方法

- 加载数据集:在Python环境中使用

datasets库加载数据集。

from datasets import load_dataset

dataset = load_dataset("Congliu/Chinese-DeepSeek-R1-Distill-data-110k")

- 查看数据:使用

dataset对象查看数据集的基本信息和样本。

print(dataset)

print(dataset['train'][0])

- 数据预处理:根据研究需求对数据进行预处理,如分词、去停用词等。

from transformers import BertTokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

tokenized_data = dataset.map(lambda x: tokenizer(x['text'], padding='max_length', truncation=True))

- 模型训练:使用预处理后的数据进行模型训练。

from transformers import BertForSequenceClassification, Trainer, TrainingArguments

model = BertForSequenceClassification.from_pretrained('bert-base-chinese')

training_args = TrainingArguments(output_dir='./results', num_train_epochs=3, per_device_train_batch_size=16)

trainer = Trainer(model=model, args=training_args, train_dataset=tokenized_data['train'])

trainer.train()

特色功能操作流程

- 数学数据处理:针对数学类型数据,增加提示词“请一步步推理,并把最终答案放到 \boxed {}”。

def add_math_prompt(example):

example['text'] = "请一步步推理,并把最终答案放到 \\boxed {}。" + example['text']

return example

math_data = dataset.filter(lambda x: x['category'] == 'math').map(add_math_prompt)

- 逻辑推理数据处理:对逻辑推理数据进行特殊处理,确保数据的逻辑性和一致性。

def process_logic_data(example):

# 自定义逻辑处理代码

return example

logic_data = dataset.filter(lambda x: x['category'] == 'logic').map(process_logic_data)© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...