文章速读

文章全面而深入地探讨了 大语言模型 (LLM) 规模定律(缩放法则/Scaling Law)的前世今生,以及 AI 研究的未来方向。作者 Cameron R. Wolfe 以清晰的逻辑和丰富的例证,带领读者从基础概念出发,逐步深入到前沿研究,展现了一幅 AI 领域波澜壮阔的图景。以下是对文章核心内容和作者观点的总结与点评:

1. 规模定律的缘起与发展:从 GPT 到 Chinchilla

- 作者开篇明义,阐述了规模定律是驱动 大语言模型 发展的核心动力。 通过介绍幂律 (Power Law) 的基本概念,作者解释了 大语言模型 的测试损失如何随着模型参数、数据集大小和计算量的增加而下降。

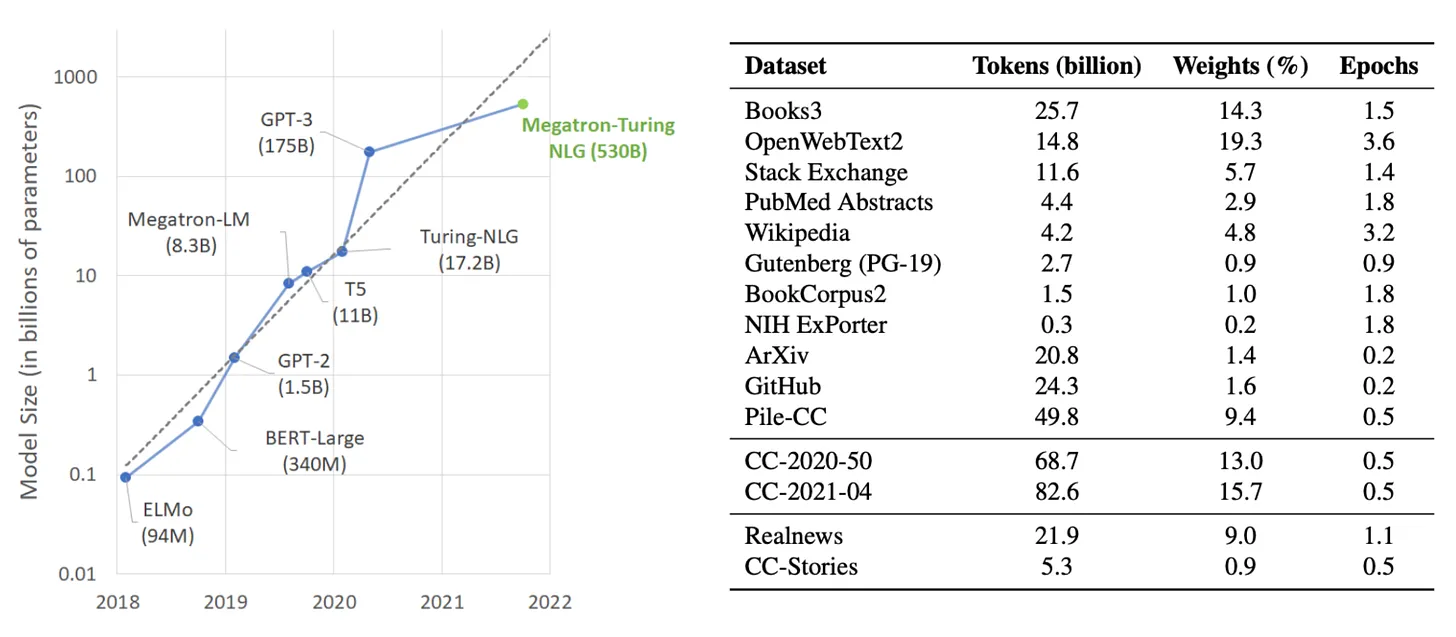

- 作者以 GPT 系列模型的发展历程为线索,生动地展示了规模定律在实践中的应用。 从早期的 GPT 和 GPT-2,到具有里程碑意义的 GPT-3,再到神秘的 GPT-4,OpenAI 始终坚持“大力出奇迹”的策略,不断刷新 大语言模型 的能力上限。文章详细介绍了每个模型的关键创新、实验设置和性能表现,并指出 GPT-3 的出现标志着 大语言模型 从专用模型向通用基础模型的转变,开启了 AI 研究的新纪元。

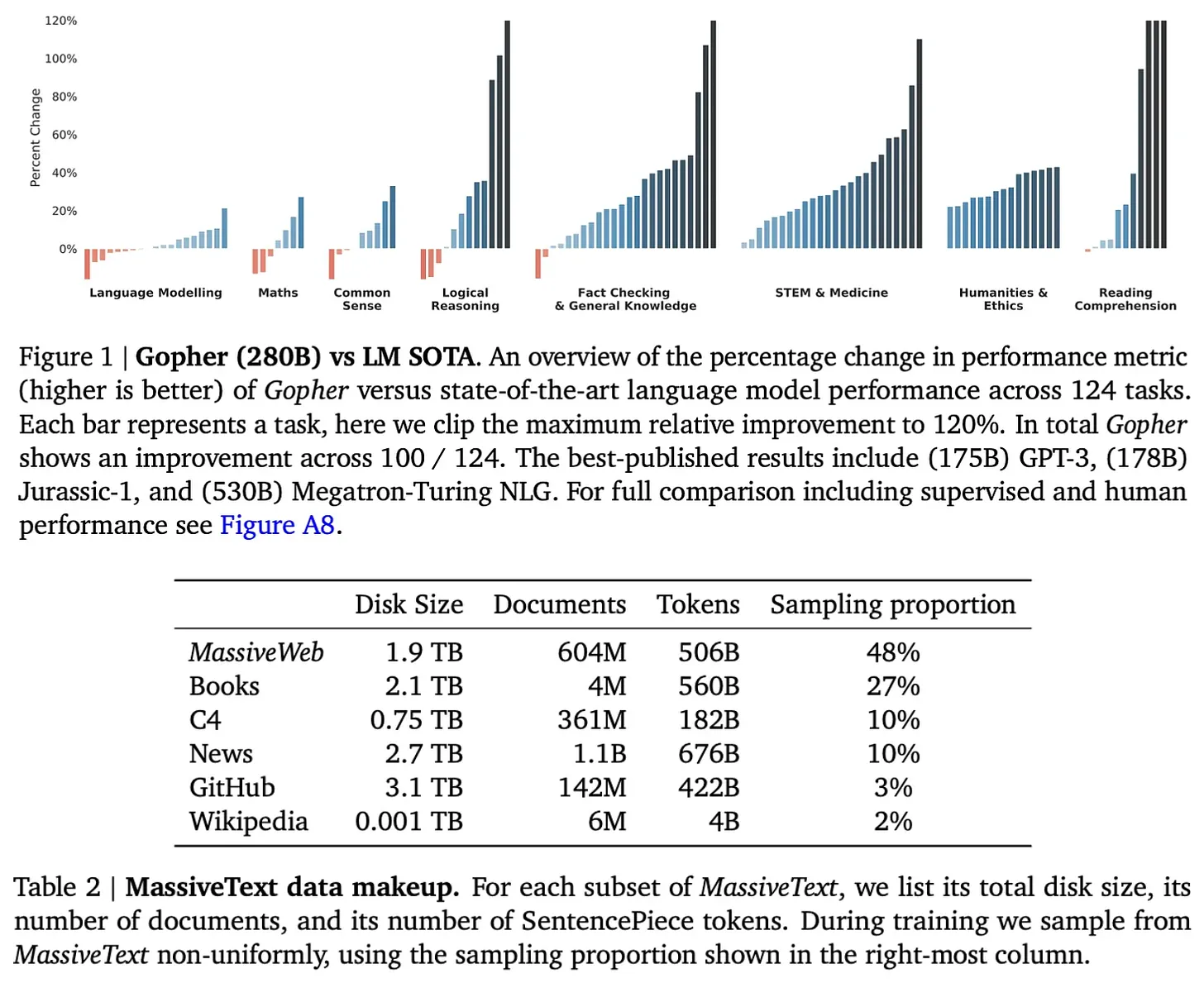

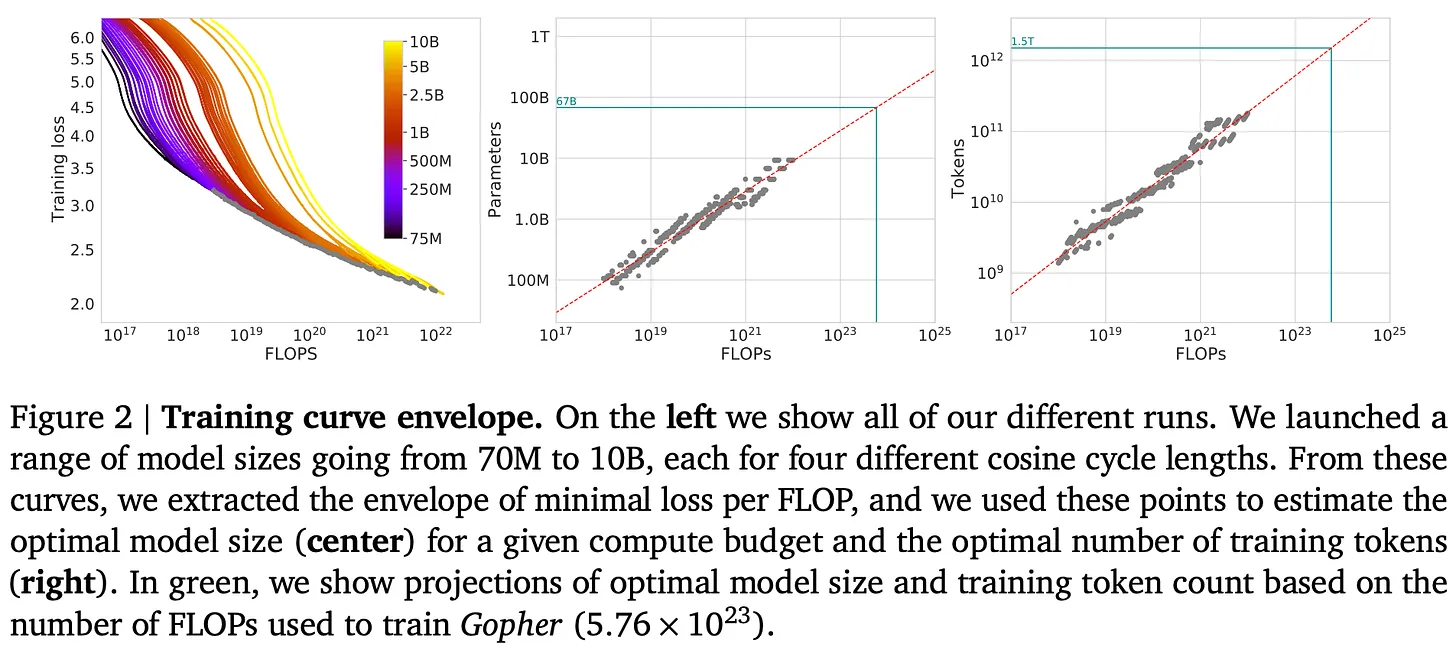

- 作者并非盲目推崇“越大越好”,而是理性地分析了 Chinchilla 模型提出的“计算最优”规模定律。 DeepMind 的研究表明,之前的模型普遍存在“欠训练”的问题,即数据集大小相对于模型规模而言过小。Chinchilla 模型的成功证明了在相同的计算预算下,适当增加数据集大小比一味扩大模型规模更有效。这一发现对后续的 大语言模型 训练产生了深远影响。

点评: 作者对规模定律的介绍深入浅出,既有理论阐释,又有实例佐证,即使是非专业读者也能理解其核心思想。通过回顾 GPT 系列模型的演进,作者将抽象的规模定律与具体的模型发展联系起来,增强了文章的可读性和说服力。对 Chinchilla 模型的分析则体现了作者的思辨精神,并非盲目鼓吹规模,而是引导读者思考如何更有效地利用计算资源。

2. 规模定律的“消亡”:质疑与反思

- 文章的第二部分聚焦于近期 AI 领域对规模定律的质疑。 作者列举了多家媒体的报道,指出随着模型改进速度放缓,业界开始怀疑规模定律是否已经触及天花板。同时,作者也引用了 Dario Amodei 和 Sam Altman 等业内人士的相反观点,说明规模化仍然是推动 AI 进步的重要力量。

- 作者指出,规模定律的“放缓”在一定程度上是预期之中的。 规模定律本身就预示着随着规模的扩大,性能提升的难度将呈指数级增长。此外,作者强调了定义“性能”的重要性。测试损失的下降并不一定等同于 大语言模型 能力的提升,而业界对 大语言模型 的期望也千差万别。

- “数据瓶颈”是作者重点讨论的一个问题。 Chinchilla 模型以及后续的研究都强调了数据规模的重要性,但互联网上可用的高质量数据有限,这可能成为制约 大语言模型 进一步发展的瓶颈。

点评: 这一部分展现了作者的批判性思维和对行业的敏锐洞察。作者没有回避争议,而是客观地呈现了各方观点,并从技术角度分析了“规模化放缓”的可能原因。作者对“数据瓶颈”的强调尤为重要,这不仅是当前 大语言模型 发展面临的现实挑战,也为未来的研究指明了方向。

3. AI 研究的未来:超越预训练

- 文章的最后部分展望了 AI 研究的未来方向,重点介绍了 大语言模型 系统/代理和推理模型。

- 作者认为,即使预训练模型的规模增长遭遇瓶颈,我们仍然可以通过构建复杂的 大语言模型 系统来提升 AI 的能力。 文章介绍了任务分解和链接两种主要策略,并以书籍摘要为例说明了如何将复杂任务拆解成 大语言模型 擅长处理的子任务。

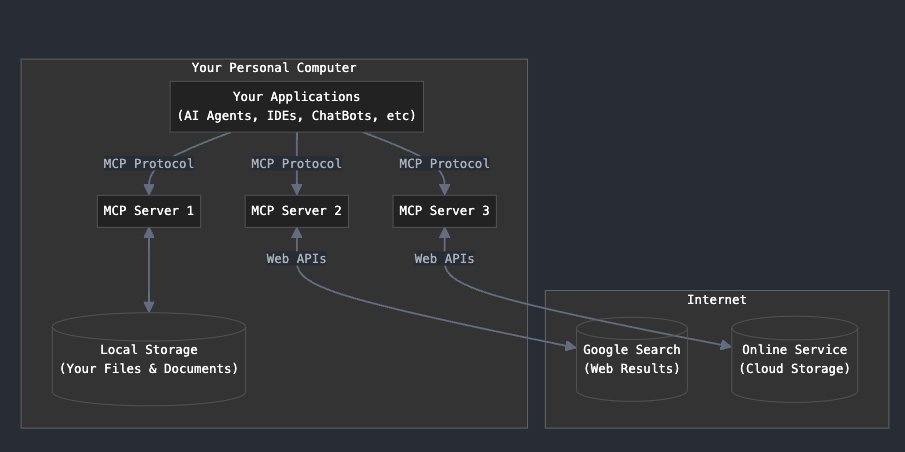

- 作者还探讨了 大语言模型 在产品开发中的应用前景,指出构建真正有用的 大语言模型 产品是当前 AI 研究的重要方向。 文章特别强调了代理 (Agent) 的概念,即通过赋予 大语言模型 使用工具的能力来扩展其应用场景。然而,作者也指出了构建复杂 大语言模型 系统所面临的鲁棒性挑战,并介绍了通过改进元生成算法来提高系统可靠性的研究方向。

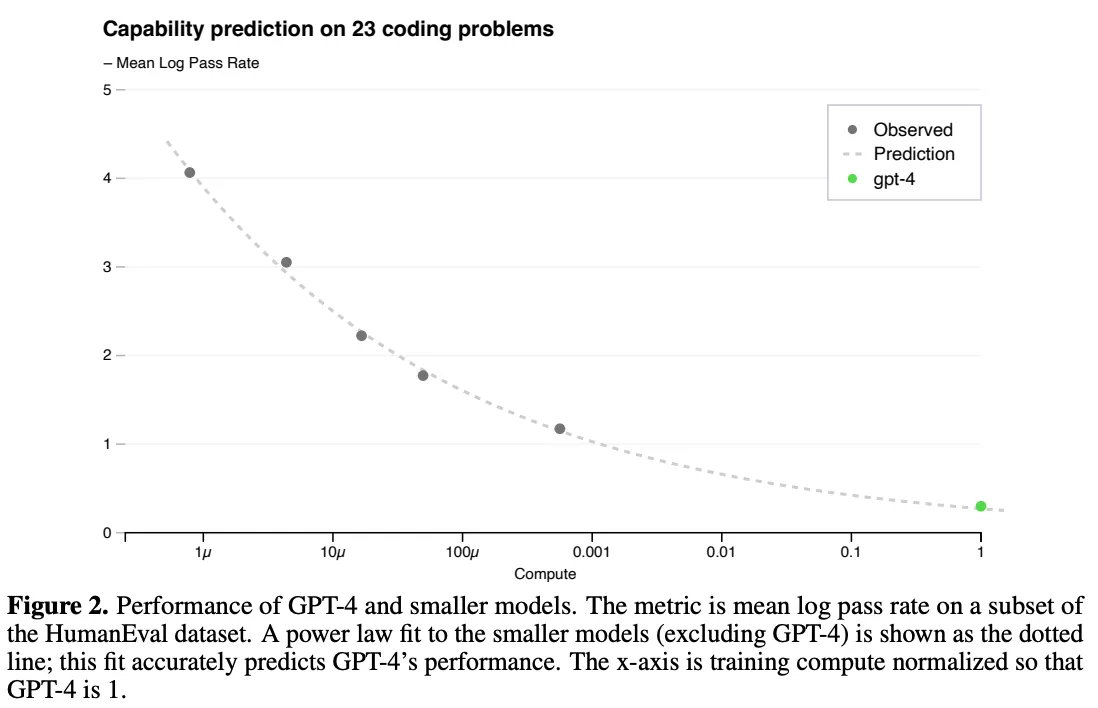

- 在推理模型方面,作者介绍了 OpenAI 的 o1 和 o3 模型,这两个模型在复杂推理任务上取得了令人瞩目的成绩。 特别是 o3,在多个极具挑战性的基准测试上超越了人类水平,甚至打破了 Terence Tao 对某些问题的预测。作者指出,o1 和 o3 模型的成功表明,除了扩大预训练规模外,通过增加推理时的计算投入也可以显著提升模型的推理能力,这是一种新的规模化范式。

点评: 这部分内容具有很强的前瞻性,作者对 大语言模型 系统/代理和推理模型的介绍为读者打开了新的视野。作者对构建 大语言模型 产品的强调具有重要的现实意义,这不仅是学术研究的需要,也是 AI 技术落地应用的关键。对 o1 和 o3 模型的介绍则令人振奋,它们展现了 AI 在复杂推理任务上的巨大潜力,也预示着未来 AI 研究的新方向。

总结与反思:

Cameron R. Wolfe 的这篇文章是一篇兼具广度和深度的佳作,它不仅系统地梳理了 大语言模型 规模定律的发展历程,也对 AI 研究的未来进行了富有洞察力的展望。作者的观点客观、理性,既肯定了规模定律的重要作用,也指出了其局限性和面临的挑战。文章的逻辑清晰,论证充分,即使是对 AI 领域不太熟悉的读者也能从中获益匪浅。

值得一提的亮点:

- 深入浅出的讲解: 作者善于将复杂的概念用通俗易懂的语言解释清楚,例如对幂律、规模定律、任务分解等概念的介绍。

- 丰富的实例支撑: 文章列举了大量的模型和实验结果,例如 GPT 系列、Chinchilla、Gopher、o1、o3 等,使抽象的理论变得具体可感。

- 全面的文献综述: 文章引用了大量的参考文献,涵盖了 大语言模型 领域的经典论文和最新研究成果,为读者提供了深入学习的资源。

- 开放性的思考: 作者并没有给出关于规模定律未来的最终答案,而是引导读者进行独立思考,例如“我们接下来要扩展什么?”这个问题将激励更多的研究者投身于 AI 领域的前沿探索。

这是一篇值得所有关注 AI 发展的人士认真阅读的文章。它不仅总结了过去,也启迪了未来。 文章的价值不仅在于其内容本身,更在于其激发思考、引领创新的精神。我相信,在未来的 AI 研究中,我们会看到更多像 o3 这样的突破性成果,而规模化的思想将继续以新的形式推动 AI 技术的进步。

标题:《大语言模型 的规模定律:从 GPT-3 到 o3》

原文:https://cameronrwolfe.substack.com/p/llm-scaling-laws

了解 大语言模型 规模化的当前状态和 AI 研究的未来...

(来源 [1, 7, 10, 21])

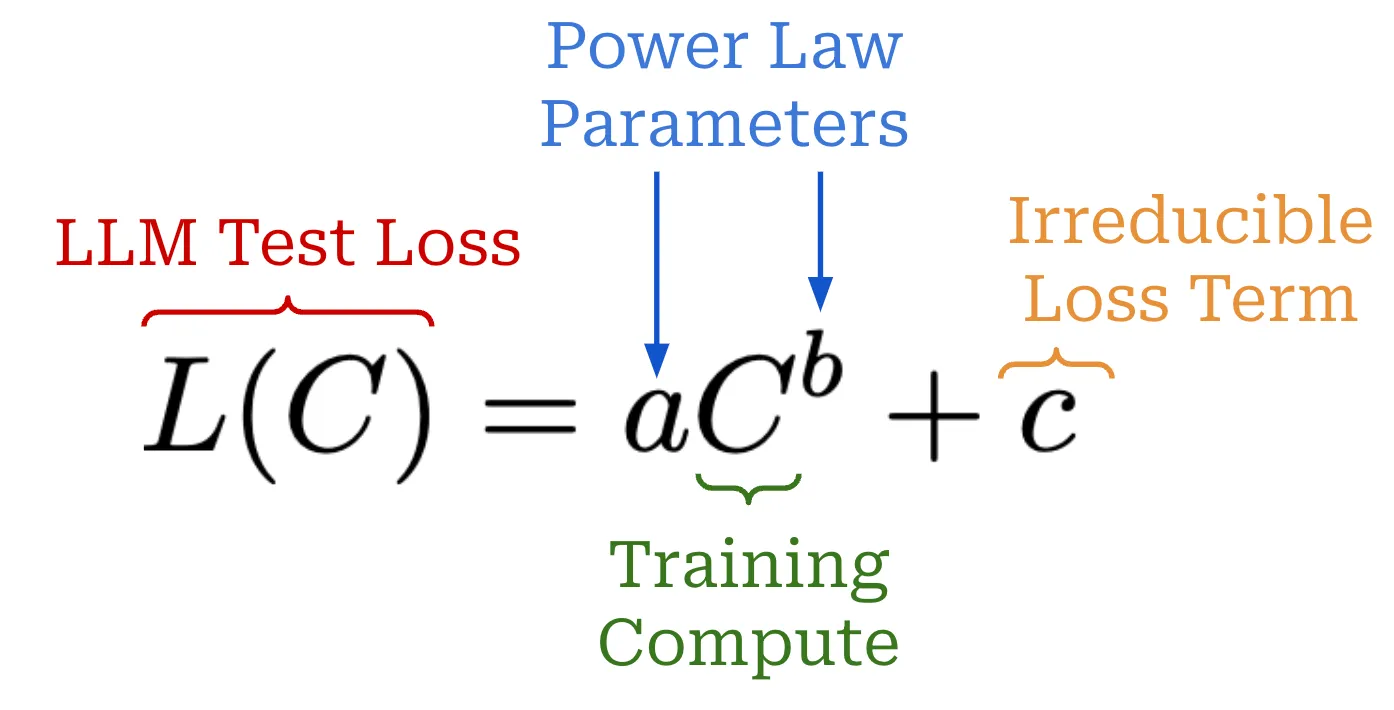

近期 AI 研究的大部分进展——特别是 大语言模型 (LLM)——都是由规模驱动的。如果我们用更多数据训练更大的模型,我们会得到更好的结果。这种关系可以通过规模定律更严格地定义,规模定律就是一个描述 大语言模型 的测试损失如何随着我们增加某些相关量 (例如,训练计算量) 而减少的方程。规模定律帮助我们预测更大、更昂贵的训练运行的结果,从而使我们有必要的信心继续投资规模化。

“如果你有一个大数据集并且你训练一个非常大的神经网络,那么成功是有保证的!” - Ilya Sutskever

多年来,规模定律一直是 AI 研究的一个可预测的北极星。事实上,像 OpenAI 这样的早期前沿实验室的成功甚至被归功于他们对规模定律的。然而,规模化的持续性最近受到了1 报告的质疑,这些报告称顶级研究实验室正在努力创建下一代更好的 大语言模型。这些说法可能会让我们怀疑:规模化会遇到瓶颈吗?如果是这样,还有其他前进的道路吗?

本概述将从头开始回答这些问题,首先深入解释 大语言模型 规模定律和周围的研究。规模定律的概念很简单,但是围绕规模化存在各种各样的公众误解——这项研究背后的科学实际上非常具体。利用对规模化的这种详细理解,我们将讨论 大语言模型 研究的最新趋势以及导致规模定律“停滞”的因素。最后,我们将利用这些信息更清楚地说明 AI 研究的未来,重点关注几个关键思想——包括规模化——这些思想可以继续推动进步。

大语言模型 的基本规模化概念

要了解 大语言模型 的规模化状态,我们首先需要建立对规模定律的一般理解。我们将从头开始建立这种理解,从幂律的概念开始。然后,我们将探讨幂律如何在 大语言模型 研究中应用,以推导出我们今天使用的规模定律。

什么是幂律?

幂律 是 大语言模型 规模化的基础概念。简而言之,幂律只是描述了两个量之间的关系。对于 大语言模型,第一个量是 大语言模型 的测试损失——或其他相关的性能指标 (例如,下游任务准确性 [7])——另一个是我们试图规模化的某些设置,例如模型参数的数量。例如,在研究 大语言模型 的规模化特性时,我们可能会看到如下声明。

“如果有足够的训练数据,验证损失的规模化应该是模型大小的近似平滑幂律函数。” - 来源 [4]

这样的声明告诉我们,模型的测试损失和模型参数的总数之间存在可测量的关系。其中一个量的变化将导致另一个量的相对尺度不变 变化。换句话说,我们从这种关系中得知,增加模型参数的总数——假设满足其他条件 (例如,有足够的训练数据)——将导致测试损失以可预测的因子减少。

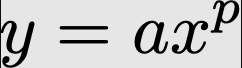

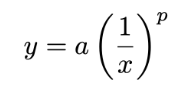

幂律公式。 基本幂律通过下面的等式表示。

这里研究的两个量是 x 和 y,而 a 和 p 是描述这些量之间关系的常数。如果我们绘制这个幂律函数2,我们会得到如下图所示。我们在正常和对数尺度上都提供了图,因为大多数研究 大语言模型 规模化的论文都使用对数尺度。

x 和 y 之间基本幂律的图

然而,为 大语言模型 规模化提供的图看起来不像上面显示的图——它们通常是上下颠倒的;请参阅下面的示例。

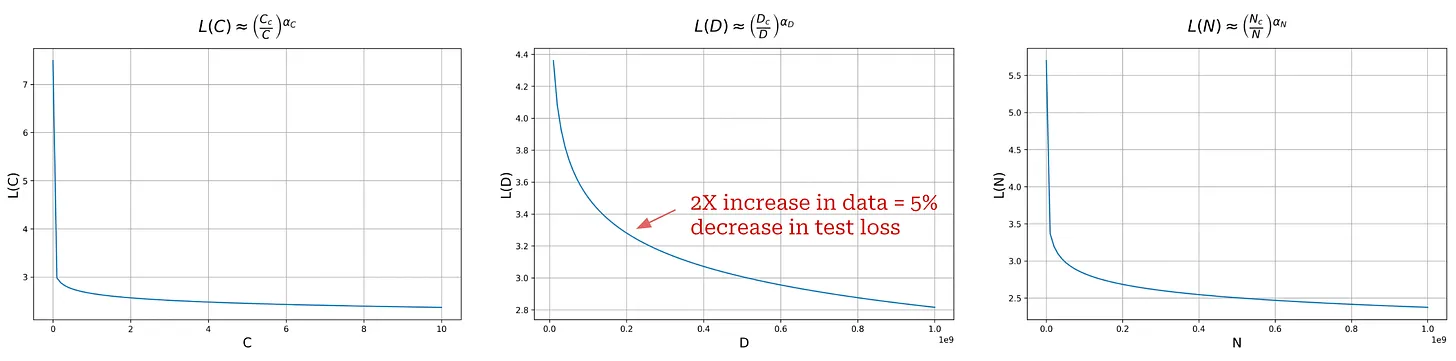

(来源 [1])

反幂律的方程与标准幂律的方程几乎相同,但我们对 p 使用负指数。使幂律的指数为负会将图上下颠倒;请参阅下面的示例。

x 和 y 之间反幂律的图

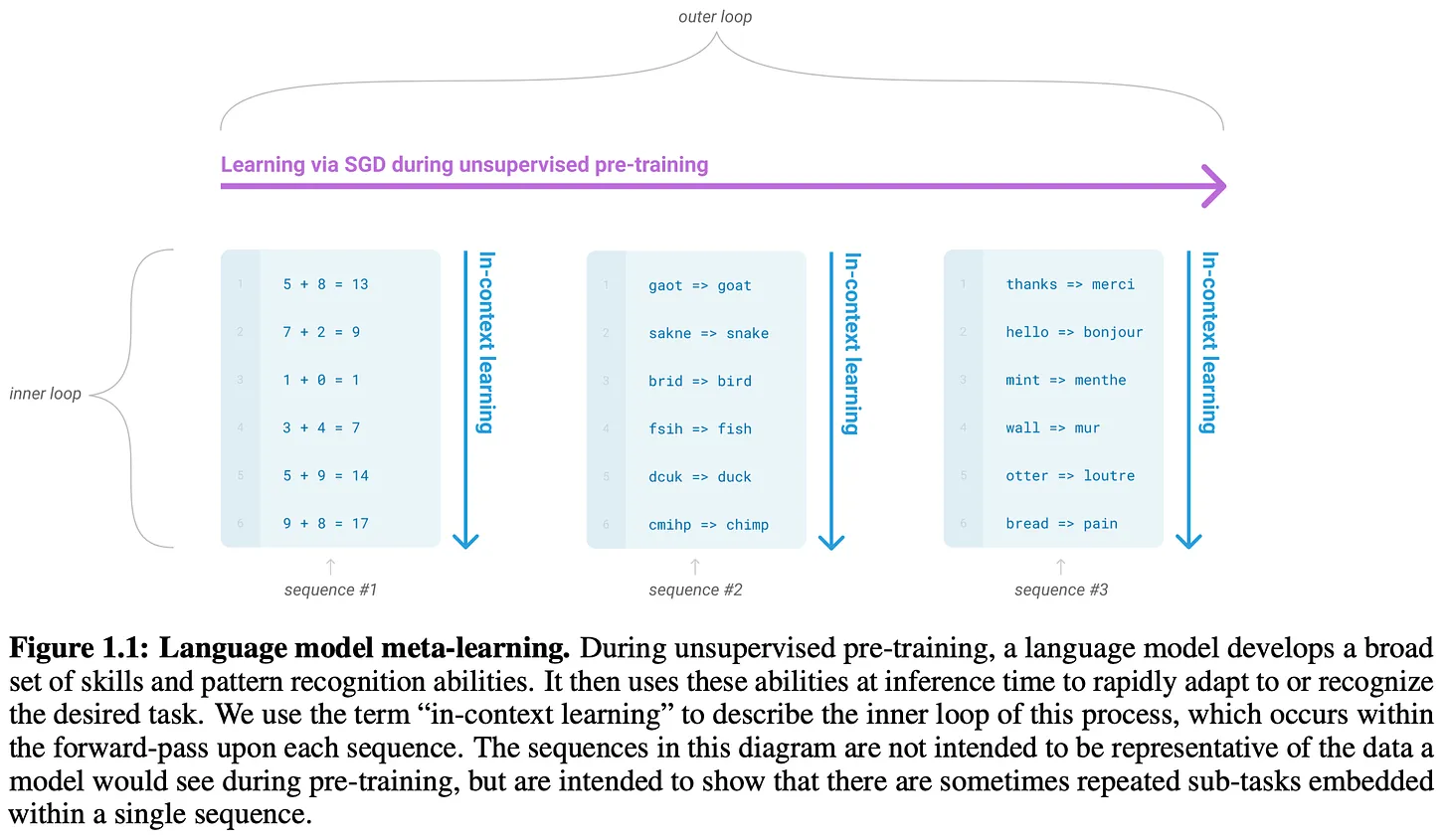

当使用对数尺度绘制时,这个反幂律产生了大多数 大语言模型 规模定律的特征性线性关系。本概述中涵盖的几乎每篇论文都将生成这样的图,以研究扩大各种不同因素 (例如,大小、计算、数据等) 如何影响 大语言模型 的性能。现在,让我们通过了解第一批在 大语言模型 规模化 [1] 的背景下研究它们的论文之一,更实际地了解幂律。

神经语言模型的规模定律 [1]

在语言模型的早期,我们还不了解规模对性能的影响。语言模型是一个有前途的研究领域,但当时的当前一代模型 (例如,原始 GPT) 的能力有限。我们还没有发现更大模型的力量,创建更好的语言模型的道路也并不明确。模型的形状 (即层数和大小) 重要吗?使模型更大是否有助于其性能更好?训练这些更大的模型需要多少数据?

“随着模型大小、数据集大小和用于训练的计算量的增加,损失以幂律的形式规模化,其中一些趋势跨越七个数量级以上。” - 来源 [1]

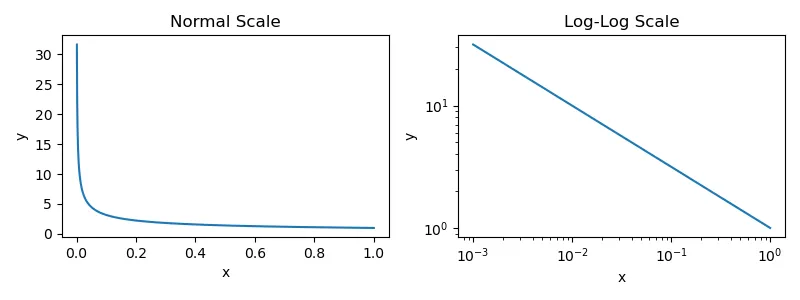

在 [1] 中,作者旨在通过分析几个因素——例如模型大小、模型形状、数据集大小、训练计算和批大小——对模型性能的影响来回答这些问题。从这个分析中,我们了解到 大语言模型 的性能随着我们的增加而平稳地提高:

- 模型参数的数量。

- 数据集的大小。

- 用于训练的计算量。

更具体地说,当性能不受其他两个因素的瓶颈时,在每个因素和 大语言模型 的测试损失之间观察到幂律关系。

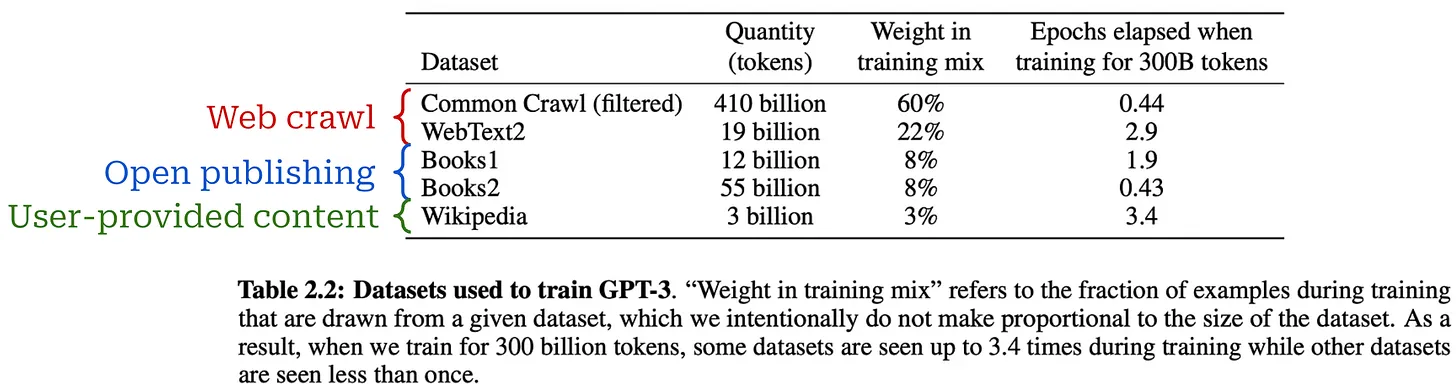

实验设置。为了拟合它们的幂律,作者在 WebText2 语料库 的子集上预训练了 大语言模型,其大小高达 15 亿个参数,包含从 2200 万到 230 亿个 Token。所有模型都使用 1,024 个 Token 的固定上下文长度和标准的下一个 Token 预测 (交叉熵) 损失进行训练。在保留的测试集上测量相同的损失,并将其用作我们的主要性能指标。此设置与大多数 大语言模型 的标准预训练设置相匹配。

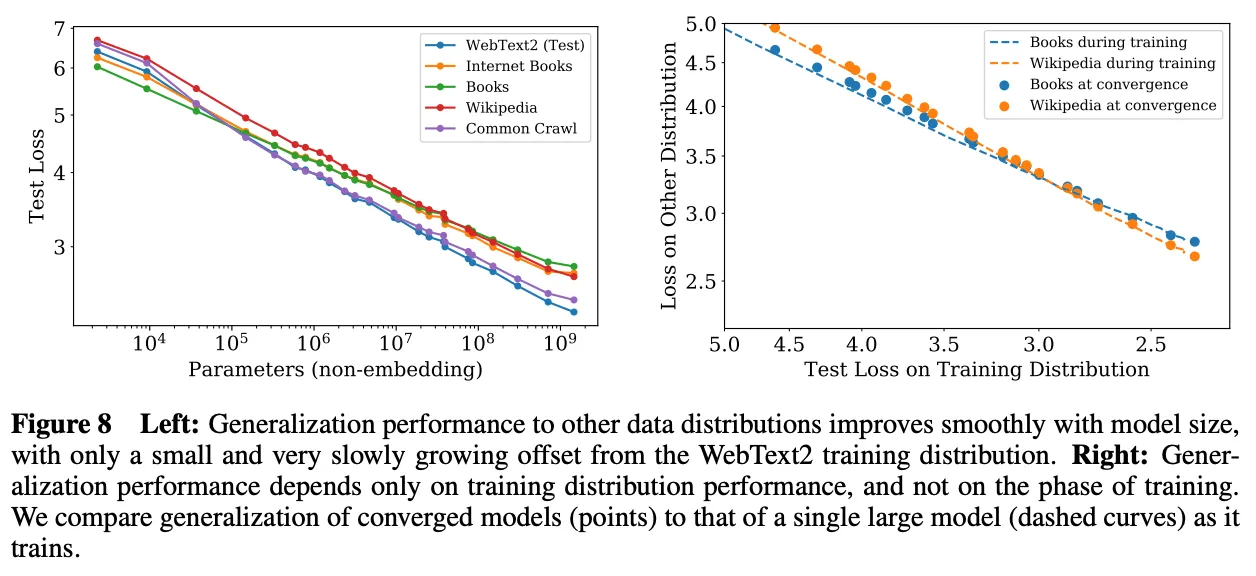

(来源 [1])

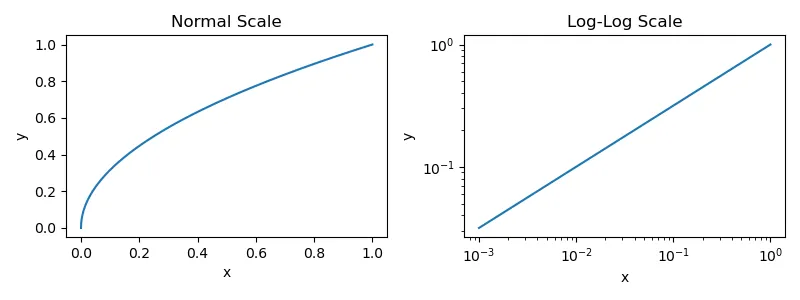

大语言模型 规模化的幂律。在 [1] 中训练的 大语言模型 的性能——就它们在 WebText2 上的测试损失而言——被证明随着更多的参数、数据和计算3 而稳步提高。这些趋势在计算上跨越八个数量级,在模型大小上跨越六个数量级,在数据集大小上跨越两个数量级。上图中提供了精确的幂律关系和拟合到每个关系的方程。这里的每个方程都与我们之前看到的逆幂律方程非常相似。但是,我们设置 a = 1 并在括号内添加一个额外的乘法常数4。

(来源 [1])

只有当训练不受其他因素的瓶颈时,这些幂律才适用。因此,所有这三个组成部分——模型大小、数据和计算——都应该同时扩大以获得最佳性能。如果我们孤立地扩大这些组成部分中的任何一个,我们将达到一个收益递减的点。

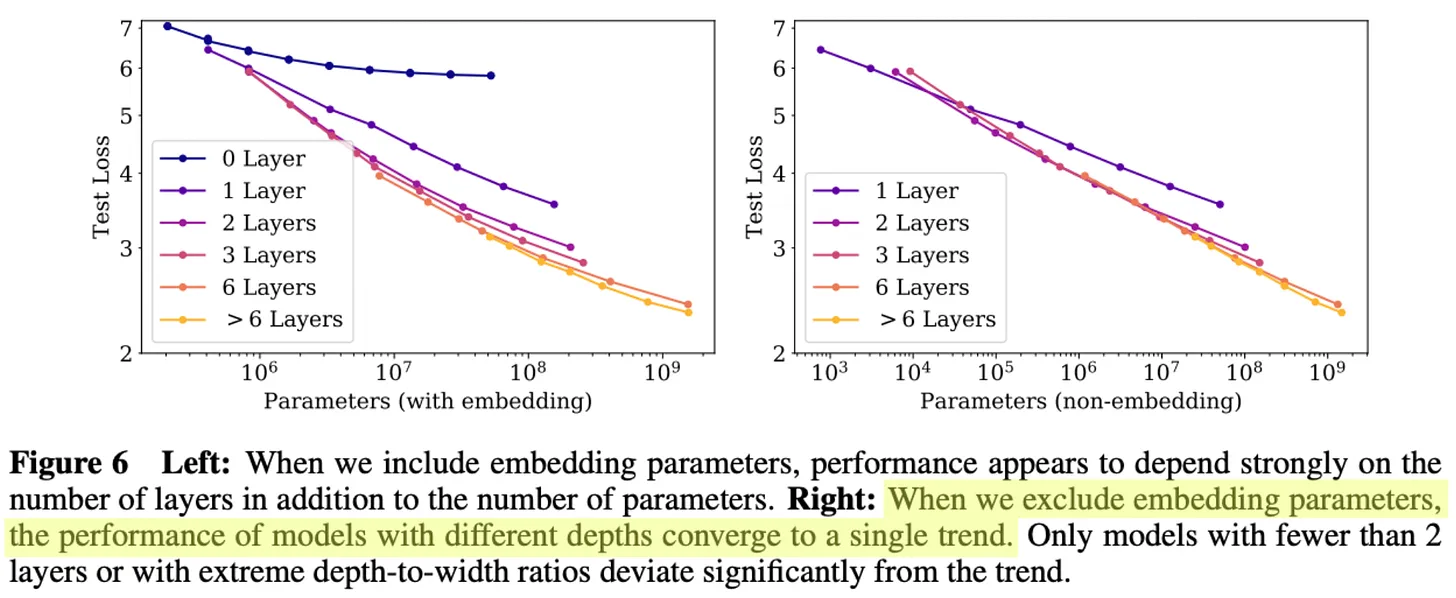

幂律告诉我们什么?尽管 [1] 中提供的幂律图看起来很有希望,但我们应该注意到这些图是使用对数尺度生成的。如果我们生成正常图 (即,没有对数尺度),我们会得到下图,其中我们看到幂律的形状类似于指数衰减。

没有对数尺度的幂律图

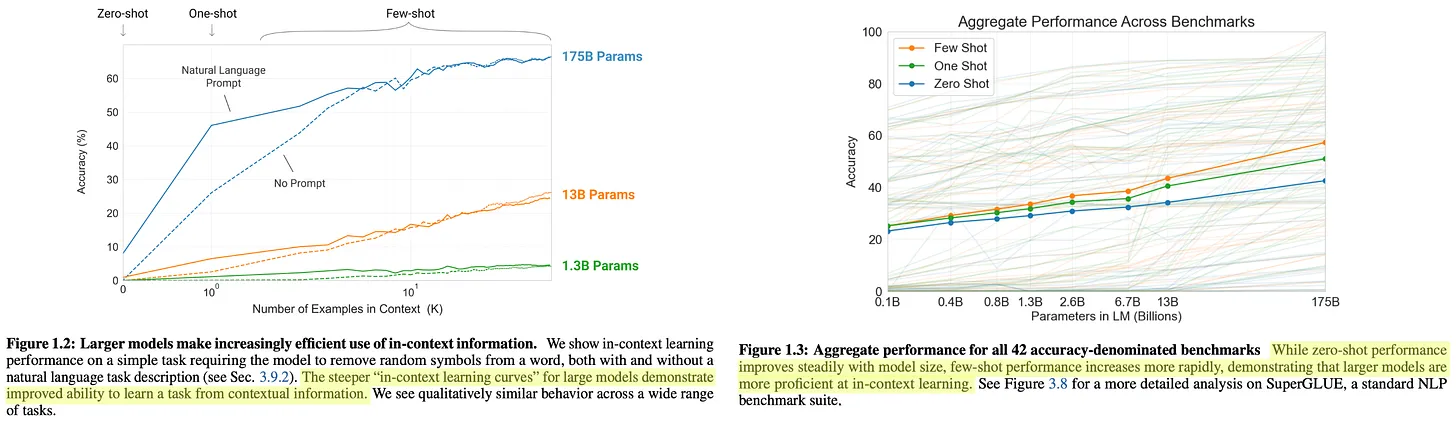

鉴于围绕规模化和 AGI 的许多在线言论,这样的发现似乎违反直觉。在许多情况下,我们被灌输的直觉似乎是 大语言模型 的质量随着计算的对数增长呈指数级提高,但事实并非如此。实际上,随着规模的扩大,提高 大语言模型 的质量变得越来越困难。

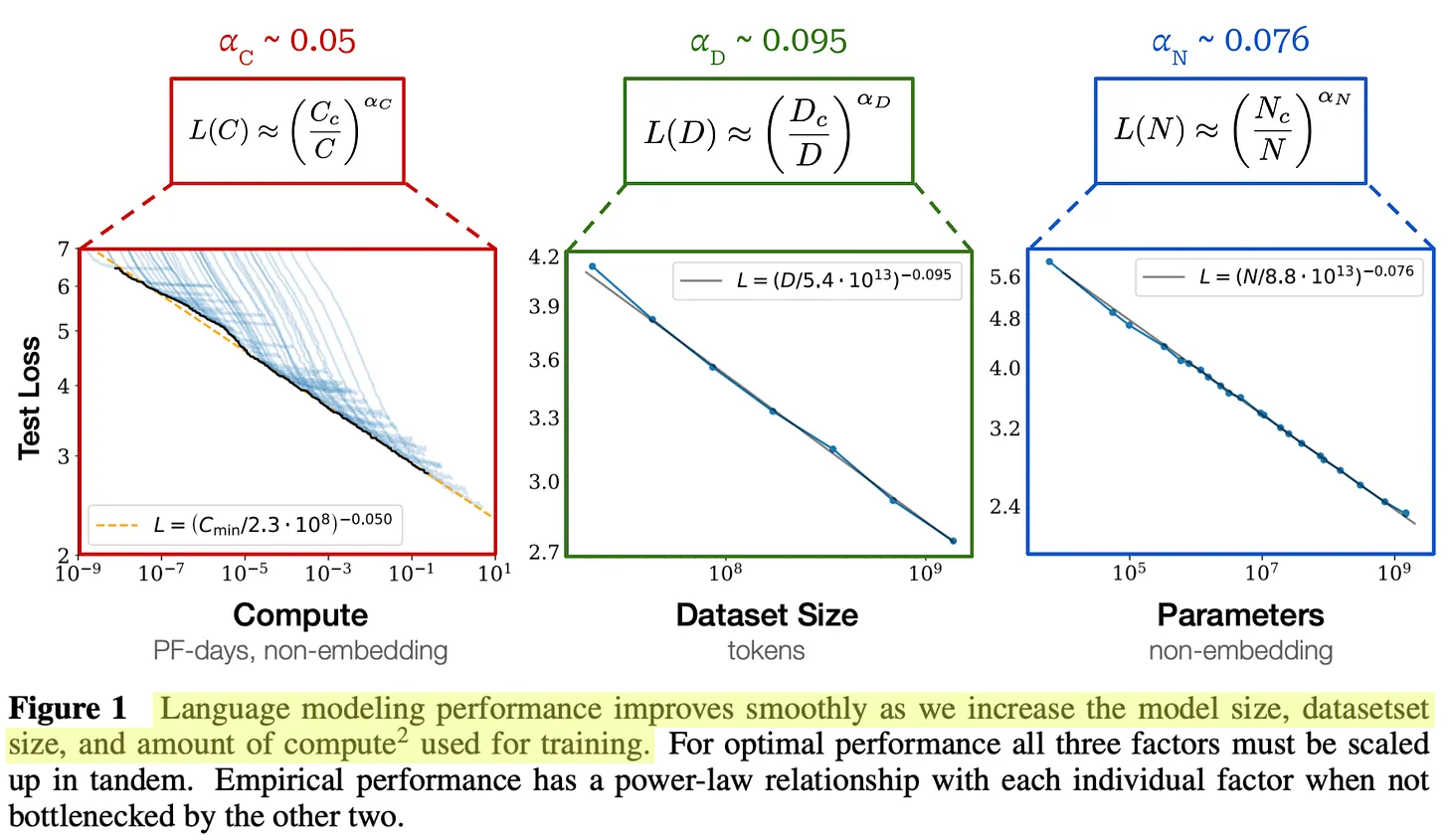

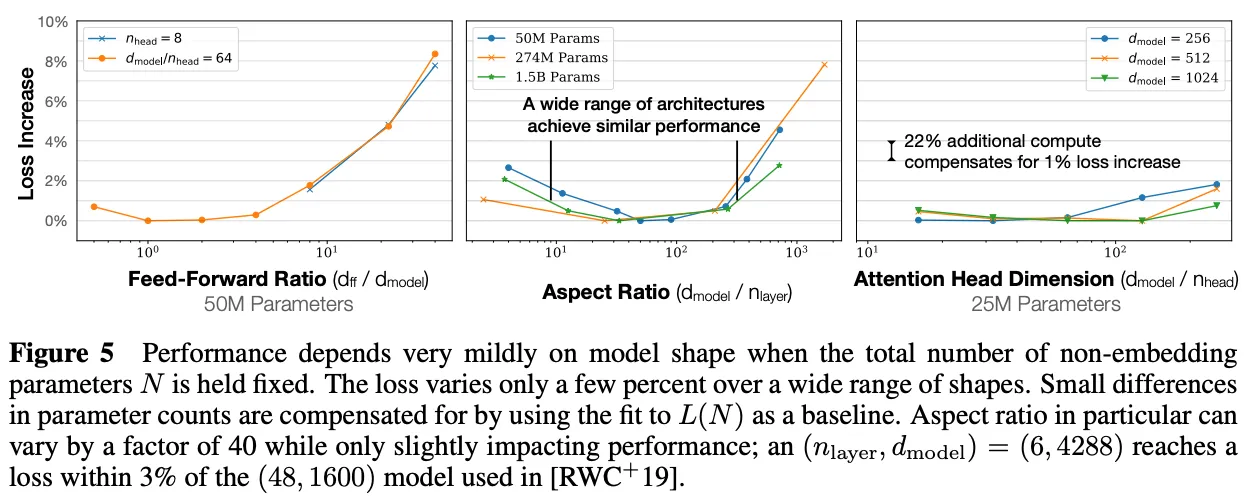

(来源 [1])

其他有用的发现。除了在 [1] 中观察到的幂律之外,我们还看到考虑的其他因素,例如模型形状或架构设置,对模型性能的影响很小;见上文。到目前为止,规模是创建更好的 大语言模型 的最大贡献因素——更多的数据、计算和模型参数会使 大语言模型 的性能平稳提高。

“更大的模型具有明显更高的样本效率,因此最佳计算效率的训练涉及在相对适中的数据量上训练非常大的模型,并在收敛之前显着停止。” - 来源 [1]

有趣的是,[1] 中的实证分析表明,较大的 大语言模型 往往具有更高的样本效率,这意味着与较小的模型相比,它们使用较少的数据达到相同水平的测试损失。出于这个原因,将 大语言模型 预训练到收敛 (可以说) 是次优的。相反,我们可以在较少的数据上训练更大的模型,在收敛之前停止训练过程。这种方法在使用的训练计算量方面是最优的,但它没有考虑推理成本。实际上,我们通常在更多数据上训练较小的模型,因为较小模型的托管成本较低。

作者还广泛分析了模型大小和用于预训练的数据量之间的关系,发现数据集的大小不需要像模型大小那样快速增加。模型大小增加约 8 倍需要训练数据量增加约 5 倍以避免过拟合。

(来源 [1])

“这些结果表明,当我们适当地扩大模型大小、数据和计算时,语言建模性能会平稳且可预测地提高。我们预计更大的语言模型将比当前模型表现得更好,并且具有更高的样本效率。” - 来源 [1]

规模定律的实际应用

大规模预训练如此有益的事实给我们带来了一个小小的困境。通过在大量数据上训练大型模型可以获得最佳结果。然而,这些训练运行非常昂贵,这意味着它们也承担着很大的风险。如果我们花费 1000 万美元训练一个未能达到我们预期的模型怎么办?鉴于预训练的费用,我们无法执行任何特定于模型的调整,并且我们必须确保我们训练的模型能够表现良好。我们需要制定一个策略来调整这些模型并预测它们的性能,而无需花费太多钱。

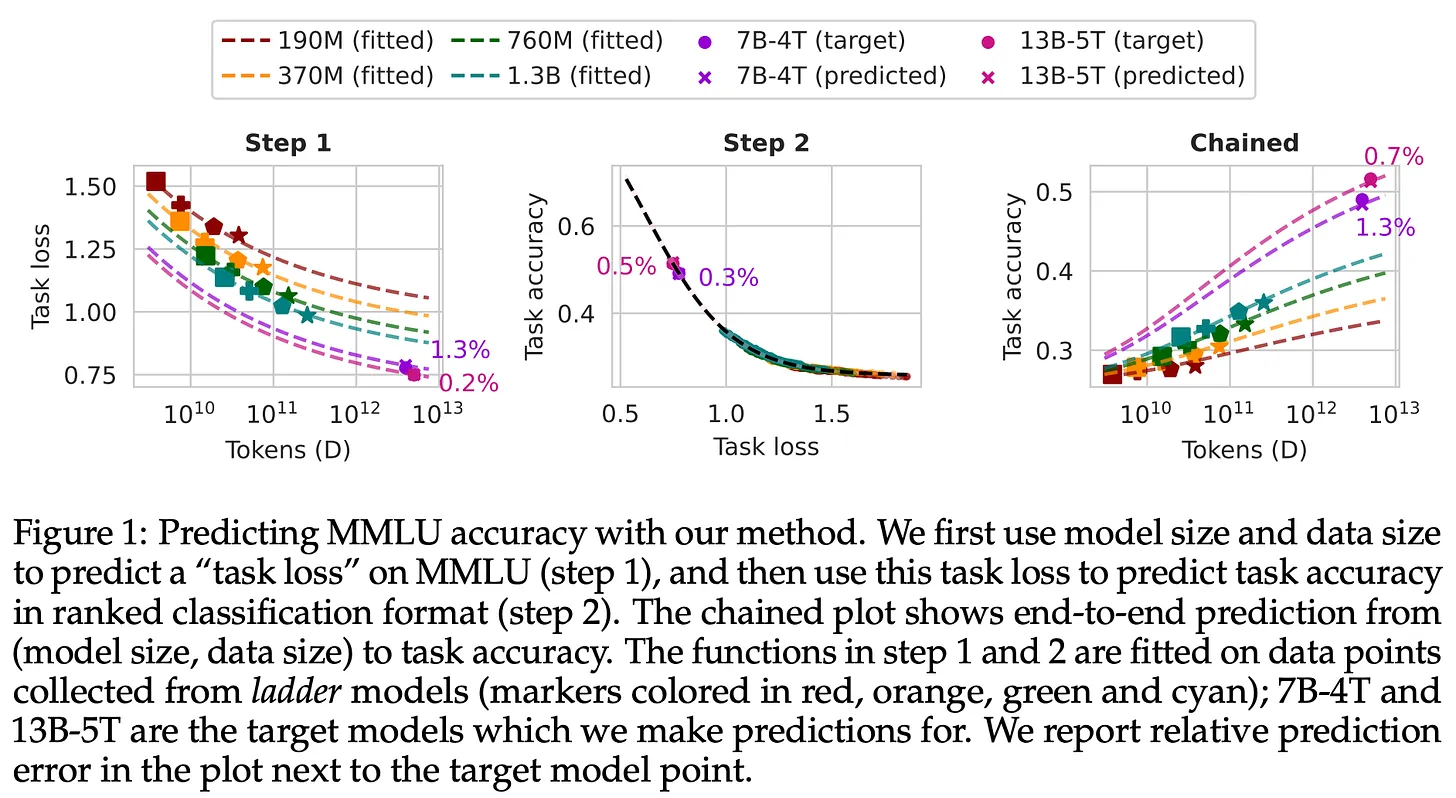

(来源 [11])

- 使用各种训练设置训练一堆较小的模型。

- 根据较小模型的性能拟合规模定律。

- 使用规模定律推断更大模型的性能。

当然,这种方法有其局限性。从较小的模型预测较大模型的性能很困难,并且可能不准确。模型可能会根据规模表现不同。然而,已经提出了各种方法 使其更可行,并且规模定律现在通常用于此目的。使用规模定律预测较大模型性能的能力使我们作为研究人员更有信心 (和安心)。此外,规模定律提供了一种简单的方法来证明对 AI 研究的投资是合理的。

规模化与预训练时代

“这就是我们今天看到的所有进步的驱动力——在庞大数据集上训练的超大型神经网络。” - Ilya Sutskever

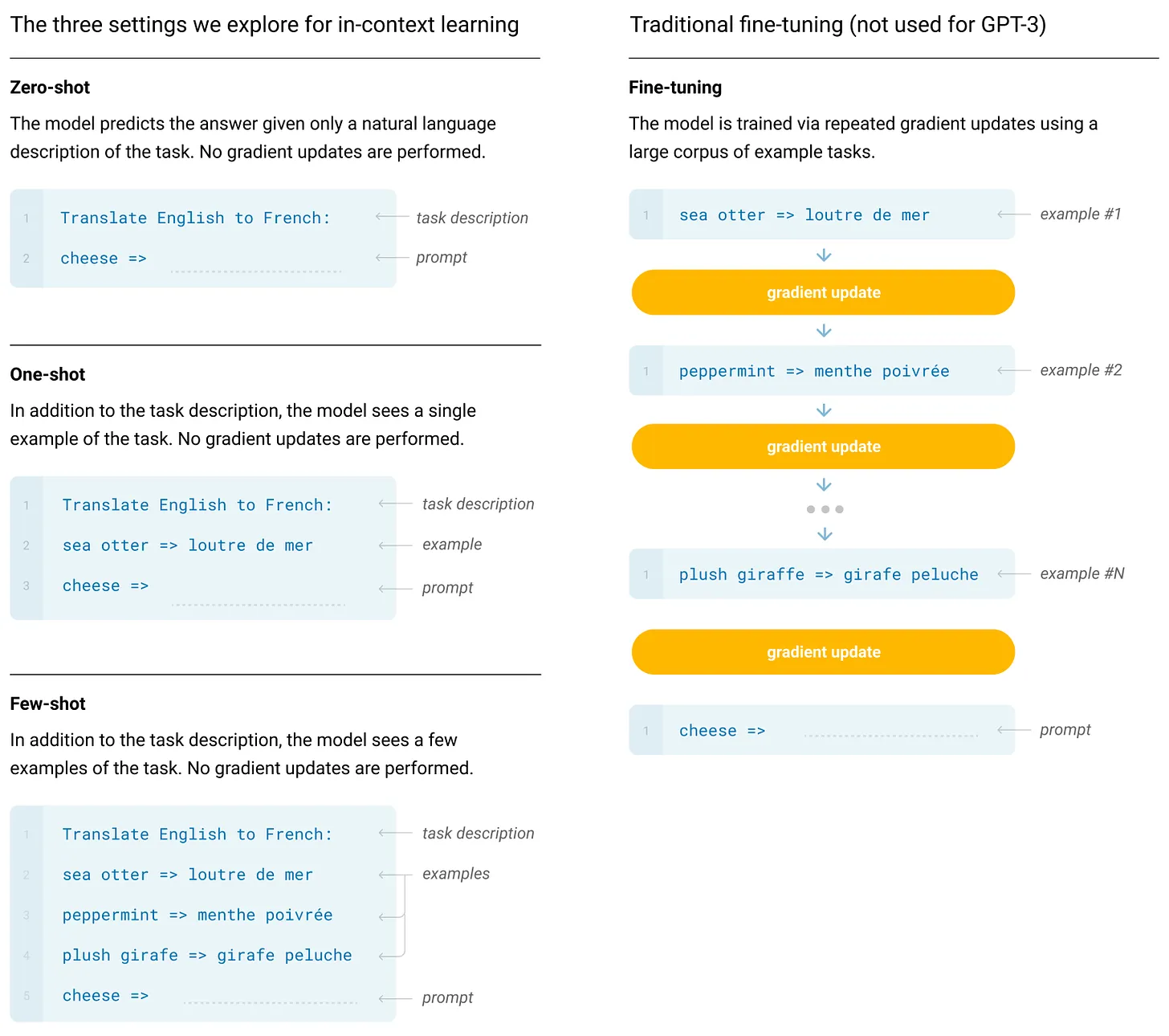

规模定律的发现催化了 大语言模型 研究的许多最新进展。为了获得更好的结果,我们只需在更大 (和更好!) 的数据集上训练越来越大的模型。这一策略被用于创建 GPT 系列中的多个模型,以及 OpenAI 之外的团队的大多数著名模型。在这里,我们将更深入地了解这种规模化研究的进展——最近被 Ilya Sutskever 描述为“预训练时代” 5。

GPT 系列:GPT [2], GPT-2 [3], GPT-3 [4], 和 GPT-4 [5]

大语言模型 规模定律最广为人知和可见的应用是在 OpenAI 的 GPT 系列模型的创建中。我们将主要关注该系列中较早的开放模型——直到 GPT-3——因为:

- 这些模型的细节被更公开地分享。

- 后来的模型除了扩大预训练过程外,还得益于后训练研究 的进步。

我们还将介绍一些已知的规模化结果,例如来自 GPT-4 的模型。

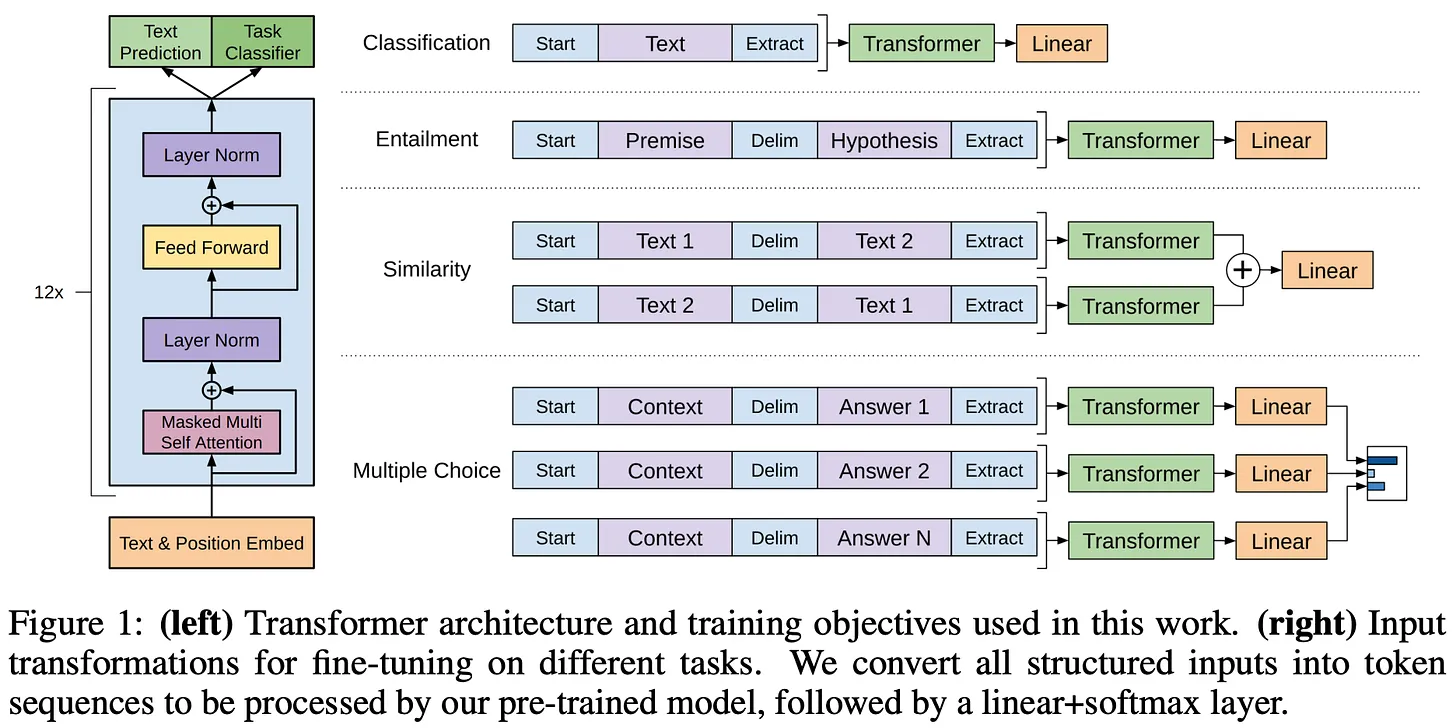

(来源 [2])

- 对平面文本进行自监督预训练非常有效。

- 使用长的、连续的文本跨度进行预训练很重要。

- 当以这种方式进行预训练时,单个模型可以进行微调以解决各种不同的任务,并具有最先进的准确性6。

总的来说,GPT 并不是一个特别值得注意的模型,但它为后来的工作奠定了一些重要的基础 (即,仅解码器 Transformer 和自监督预训练),这些工作探索了更大规模的类似模型。

(来源 [3])

- 这些模型在 WebText 上进行预训练,它 i) 比 BooksCorpus 大得多,并且 ii) 通过从互联网上抓取数据创建。

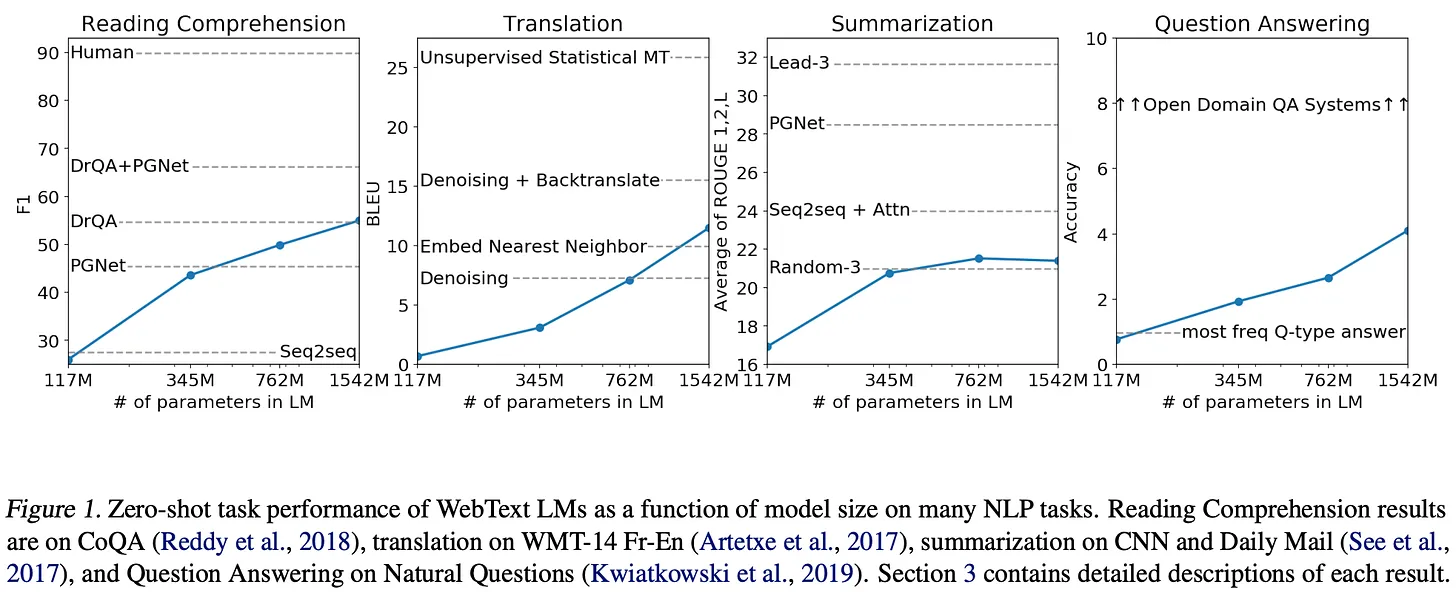

- 这些模型没有针对下游任务进行微调。相反,我们通过使用预训练模型执行零样本推理7 来解决任务。

GPT-2 模型在大多数基准测试中都达不到最先进的性能8,但它们的性能始终随着模型大小的增加而提高——扩大模型参数的数量会产生明显的好处;见下文。

(来源 [3])

“具有足够容量的语言模型将开始学习推断和执行自然语言序列中演示的任务,以便更好地预测它们,无论它们的获取方法如何。” - 来源 [3]

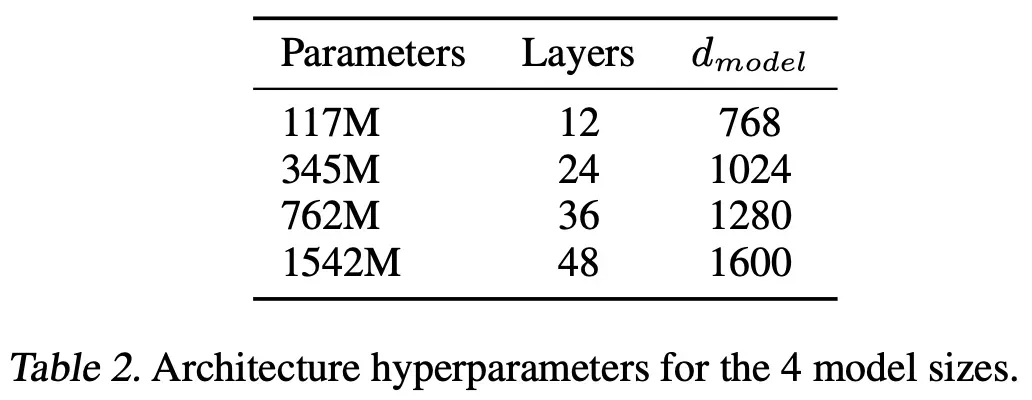

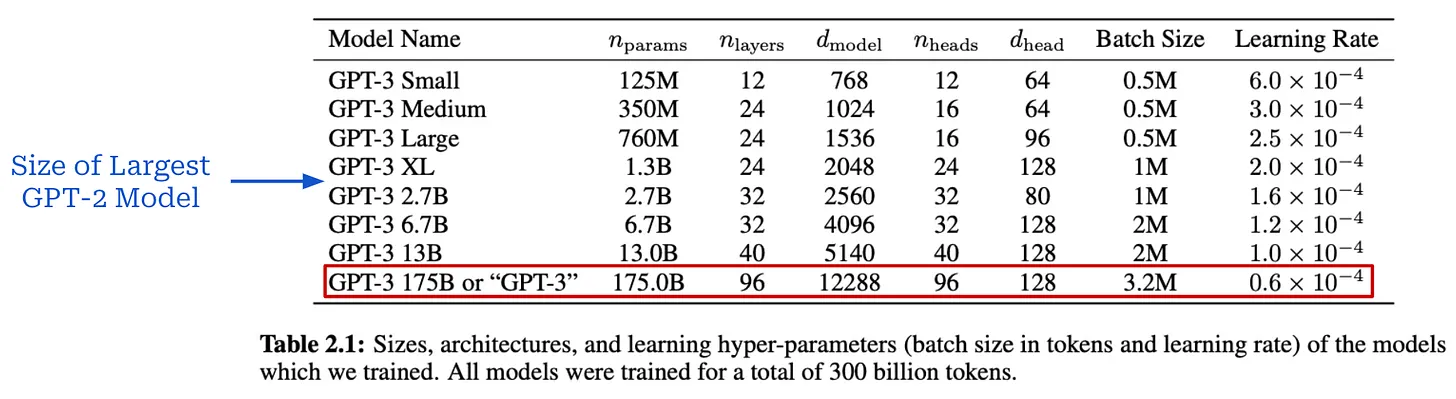

GPT-3 [4] 是 AI 研究的一个分水岭时刻,它明确证实了 大语言模型 的大规模预训练的好处。该模型拥有超过 1750 亿个参数,比最大的 GPT-2 模型大 100 倍以上;见下文。

(来源 [4])

(来源 [4])

(来源 [4])

(来源 [4])

(来源 [4])

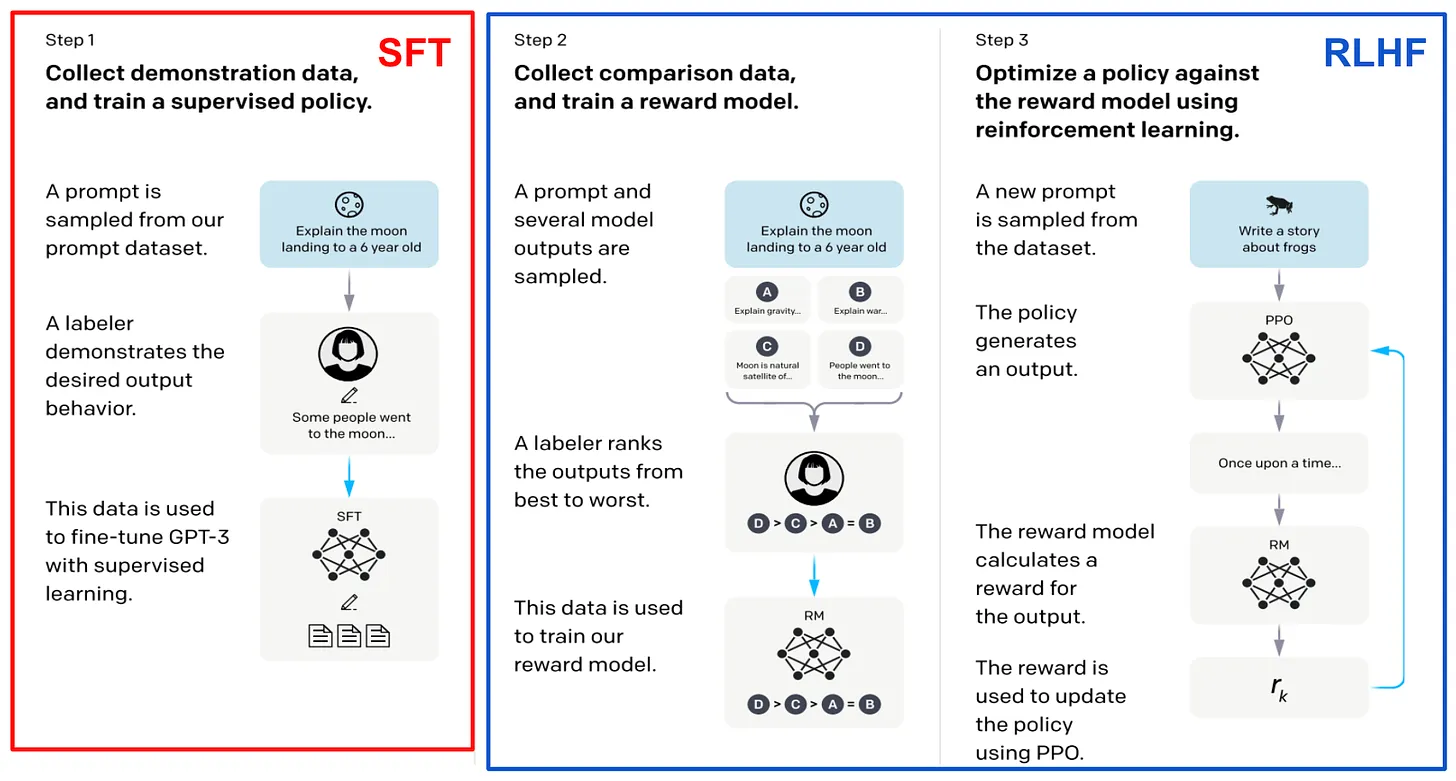

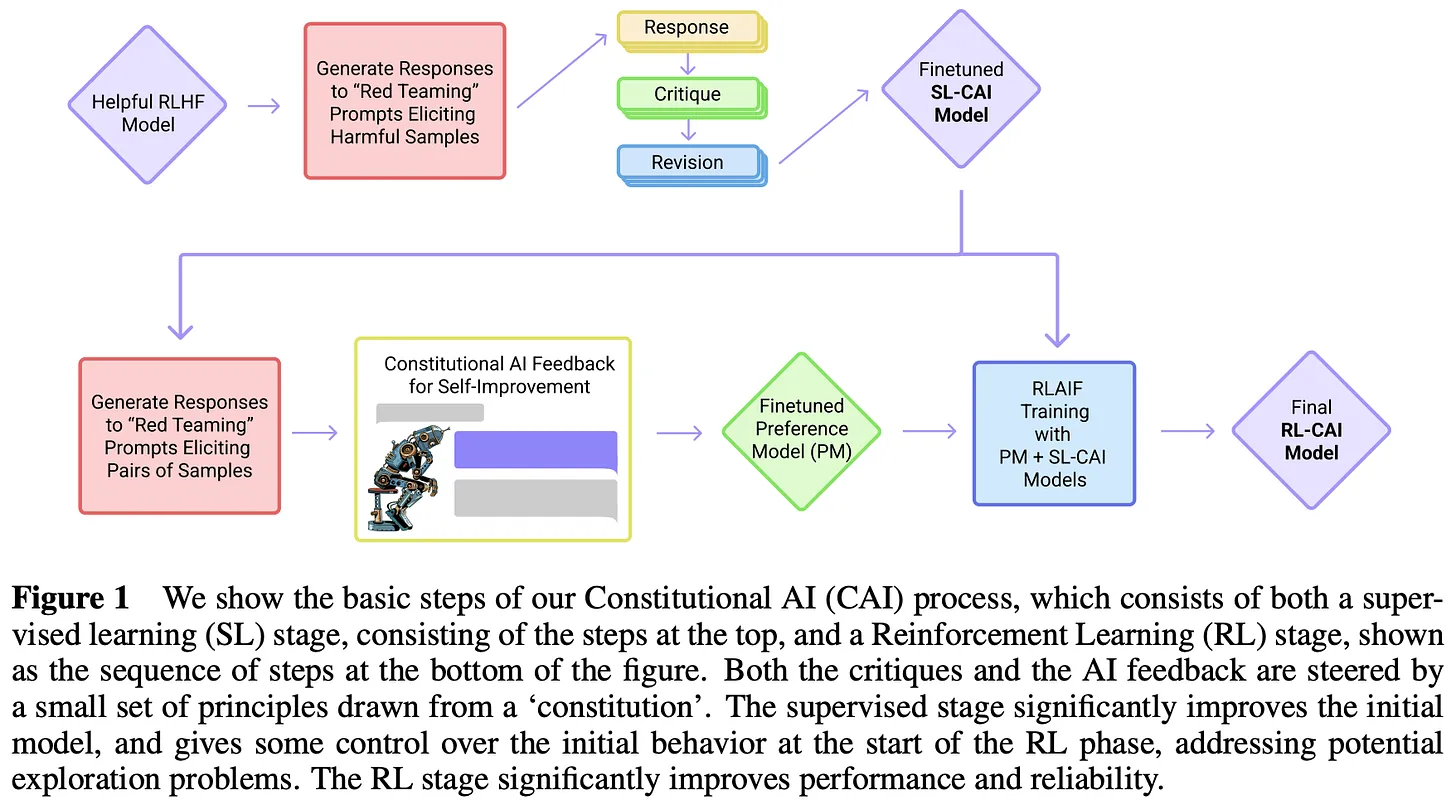

GPT-3 之后。 GPT-3 令人印象深刻的性能引发了人们对 大语言模型 研究的极大兴趣,主要集中在大规模预训练上。OpenAI 发布的接下来的几个模型——InstructGPT [8]、ChatGPT 和 GPT-4 [5]——结合使用大规模预训练和新的后训练技术 (即,监督微调 和来自人类反馈的强化学习) 来大幅提高 大语言模型 的质量。这些模型如此令人印象深刻,以至于甚至导致公众对 AI 研究的兴趣激增。

“GPT-4 是一个基于 Transformer 的模型,经过预训练以预测文档中的下一个 Token。后训练对齐过程提高了事实性度量和对所需行为的依从性。” - 来源 [5]

此时,OpenAI 开始发布较少的关于其研究的细节。相反,新模型只是通过他们的 API 发布,这使得公众无法了解这些模型是如何创建的。幸运的是,可以从 OpenAI 确实发布的材料中收集到一些有用的信息。例如,InstructGPT [8]——ChatGPT 的前身——有一篇相关的论文详细记录了模型的后训练策略;见下文。鉴于这篇论文还指出 GPT-3 是 InstructGPT 的基础模型,我们可以合理地推断出该模型在性能方面的提升主要与扩大预训练过程无关。

(来源 [8])

- GPT-4 是基于 Transformer 的。

- 该模型使用下一个 Token 预测进行预训练。

- 使用公共和许可的第三方数据。

- 该模型使用来自人类反馈的强化学习进行微调。

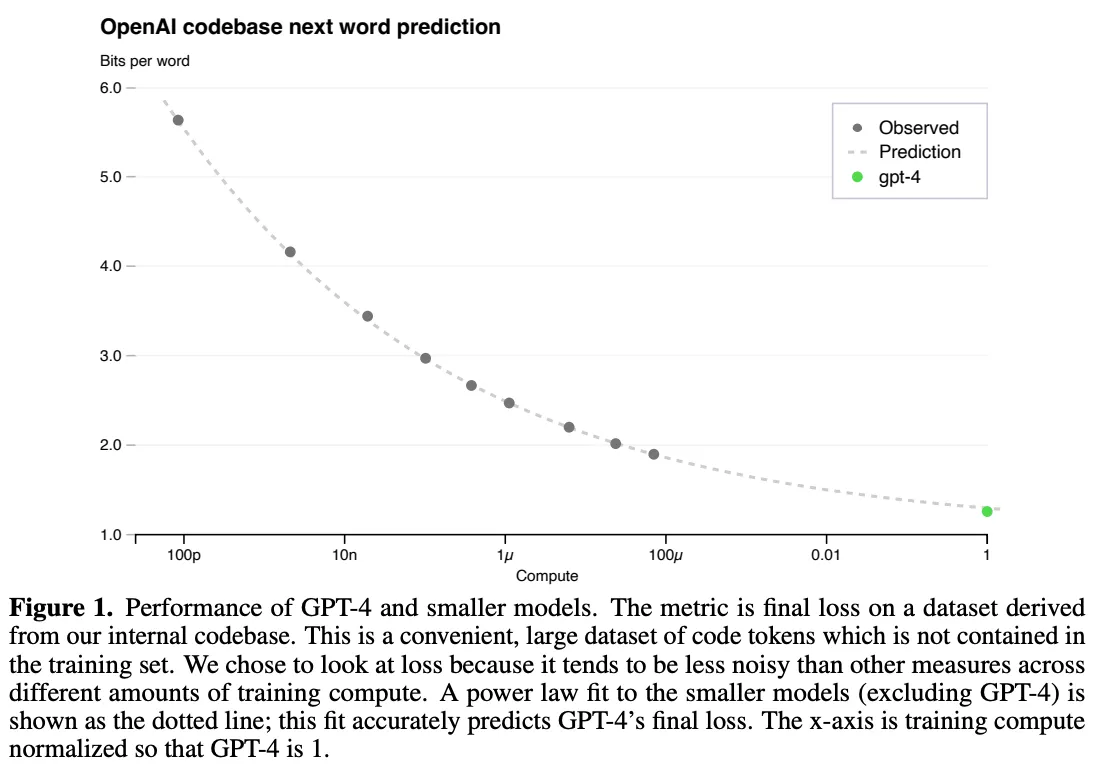

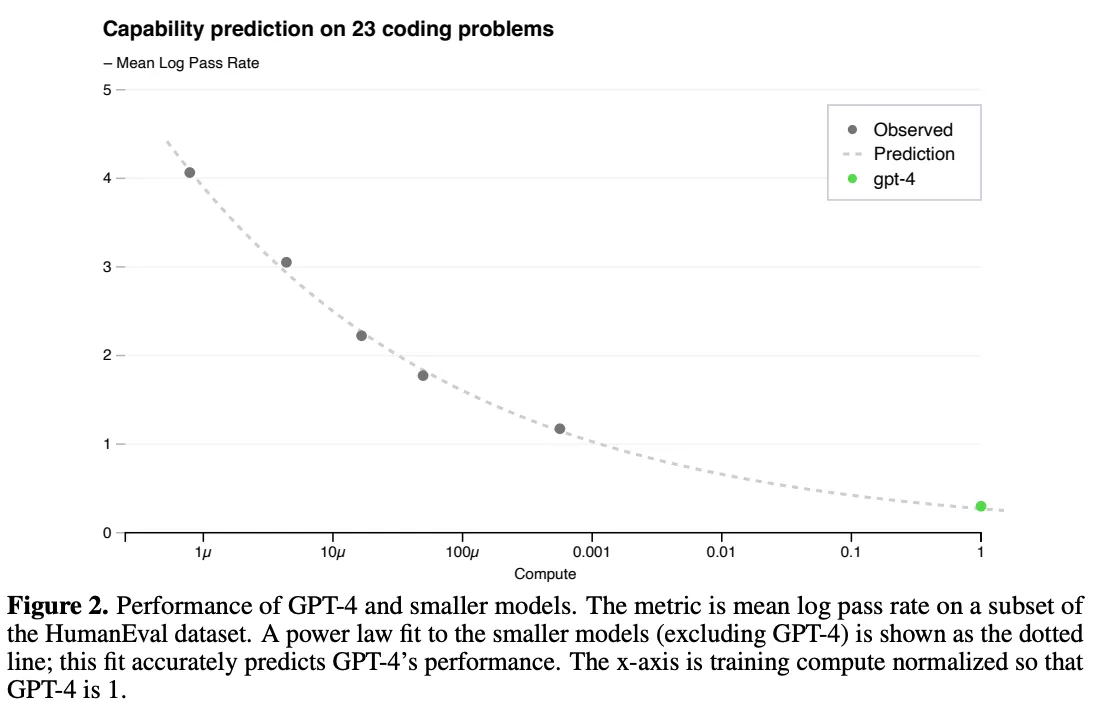

尽管如此,规模化的重要性在这份技术报告中非常明显。作者指出,这项工作中的一个关键挑战是开发一个可扩展的训练架构,该架构在不同规模上表现可预测,允许推断较小运行的结果,从而为更大规模 (且昂贵得多!) 的训练练习提供信心。

“经过适当训练的大型语言模型的最终损失……可以通过用于训练模型的计算量的幂律来近似。” - 来源 [5]

大规模预训练非常昂贵,所以我们通常只有一次机会把它做好——没有特定于模型的调整空间。规模定律在这个过程中起着关键作用。我们可以使用少 1,000-10,000 倍的计算来训练模型,并使用这些训练运行的结果来拟合幂律。然后,这些幂律可以用来预测更大模型的性能。特别是,我们在 [8] 中看到 GPT-4 的性能是使用测量计算和测试损失之间关系的幂律来预测的;见下文。

GPT-4 训练的规模定律公式 (来源 [5])

(来源 [5])

(来源 [5])

Chinchilla: 训练计算最优的大型语言模型 [5]

(来源 [9])

(来源 [10])

(来源 [10])

“预计需要的训练数据量远远超出了目前用于训练大型模型的数据量。” - 来源 [6]

Chinchilla。[6] 中提供的分析强调了数据规模的重要性。大型模型需要在更多数据上进行训练才能达到最佳性能。为了验证这一发现,作者训练了一个名为 Chinchilla 的 700 亿参数的 大语言模型。与之前的模型相比,Chinchilla 更小,但具有更大的预训练数据集——总共 1.4 万亿个训练 Token。Chinchilla 使用与 Gopher [10] 相同的数据和评估策略。尽管比 Gopher 小 4 倍,但 Chinchilla 的性能始终优于更大的模型;见下文。

(来源 [6])

规模定律的“消亡”

规模定律最近成为 AI 研究中一个热门 (且有争议) 的话题。正如我们在本概述中所看到的,在预训练时代,规模化推动了 AI 的大部分改进。然而,随着 2024 年下半年模型发布和改进的步伐放缓11,我们开始看到对模型规模化的广泛质疑,这似乎表明 AI 研究——特别是规模定律——可能正在碰壁。

- 路透社 称,由于当前方法的扩展遇到瓶颈,OpenAI 正在转变其产品战略。

- The Information 称,GPT 模型的改进速度开始放缓。

- 彭博社 强调了几家前沿实验室在尝试构建更强大的 AI 时所面临的困难。

- TechCrunch 称,规模化开始产生递减的回报。

- 时代周刊 发表了一篇细致入微的文章,强调了导致 AI 研究正在放缓的各种因素。

- Ilya Sutskever 在 NeurIPS’24 的 中表示*“我们所知的预训练将会结束”*。

与此同时,许多专家持相反意见。例如, (Anthropic 首席执行官) 曾表示,规模化*“可能…… 会继续”,而 Sam Altman 则继续宣扬“没有墙”* 的说法。在本节中,我们将通过对规模化的当前状态和可能存在的各种问题提供有根据的解释,为这场讨论增添更多色彩。

规模化减缓:这意味着什么?为什么会发生?

“两种说法都可能是正确的:从技术层面上讲,规模化仍然有效。对用户来说,改进的速度正在放缓。” - Nathan Lambert

那么……规模化是否正在放缓? 答案很复杂,并且很大程度上取决于我们对“放缓”的确切定义。到目前为止,我对这个问题的最合理的回应是,两种答案都是正确的。出于这个原因,我们将不再尝试回答这个问题。相反,我们将更深入地研究研究对这个主题的确切说法,以便我们能够对 大语言模型 规模化的当前 (和未来) 状态建立更细致的理解。

规模定律告诉我们什么?首先,我们需要回顾一下规模定律的技术定义。规模定律根据幂律定义了训练计算 (或模型/数据集大小) 与 大语言模型 的测试损失之间的关系。然而,这种关系的性质经常被误解。从计算的对数增长中获得指数级性能提升的想法是一个神话。规模定律看起来更像指数衰减,这意味着随着时间的推移,我们将不得不更加努力才能获得进一步的性能提升;见下文。

(来源 [5])

“从业者通常使用下游基准准确性作为模型质量的代理,而不是困惑度评估集上的损失。” - 来源 [7]

定义性能。我们如何衡量 大语言模型 是否正在改进? 从规模定律的角度来看,大语言模型 的性能通常通过预训练期间模型的测试损失来衡量,但较低的测试损失对 大语言模型 能力的影响尚不清楚。较低的损失会导致下游任务的准确性更高吗?较低的损失会导致 大语言模型 获得新能力吗? 规模定律告诉我们的内容与我们实际关心的内容之间存在脱节:

- 规模定律告诉我们,增加预训练的规模将平稳地降低 大语言模型 的测试损失。

- 我们关心的是获得一个“更好”的 大语言模型。

取决于你是谁,你对新 AI 系统的期望——以及你用来评估这些新系统的方法——将大不相同。普通 AI 用户倾向于关注通用聊天应用程序,而从业者通常关心 大语言模型 在下游任务上的性能。相比之下,顶级前沿实验室的研究人员似乎对 AI 系统抱有很高 (且非常特别) 的期望;例如,撰写博士论文 或解决高级数学推理问题。鉴于 大语言模型 具有如此广泛的能力,评估很困难,我们可以从许多角度来看待 大语言模型 的性能;见下文。

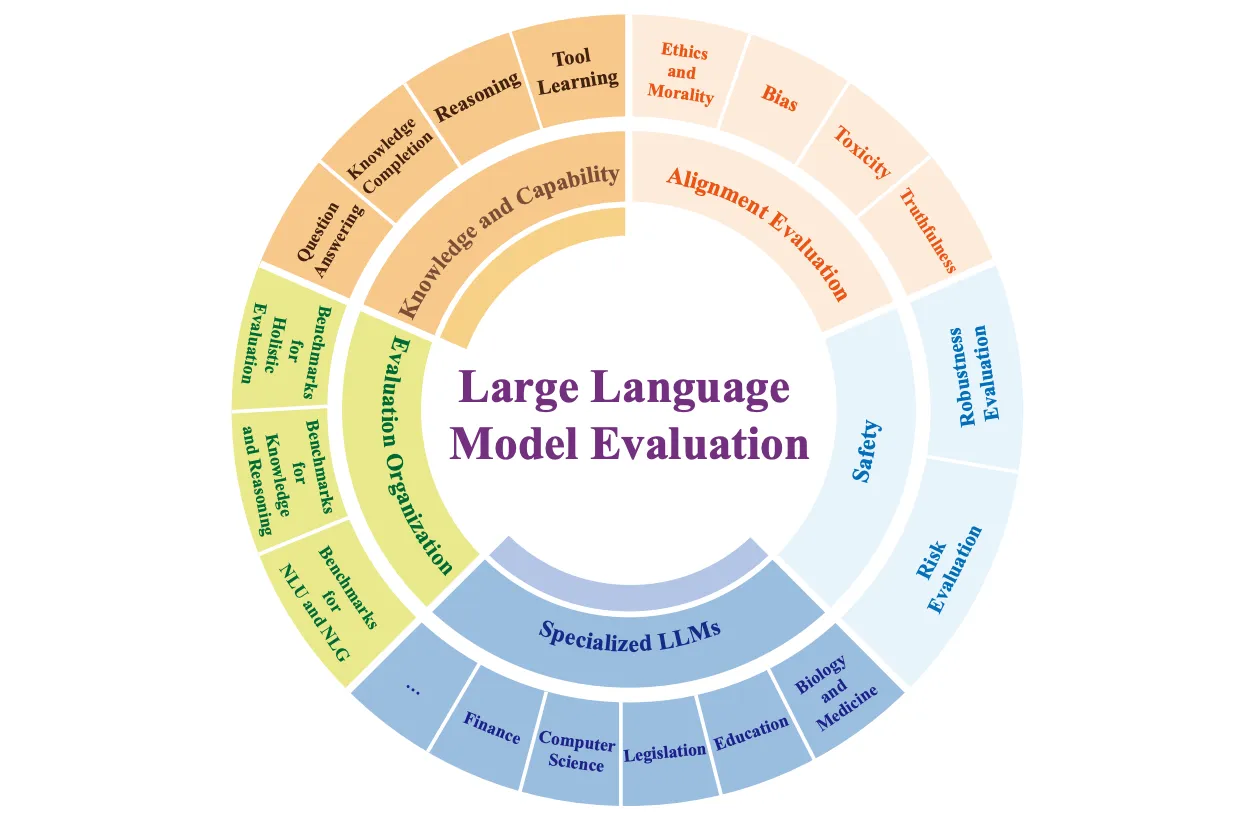

(来源 [15])

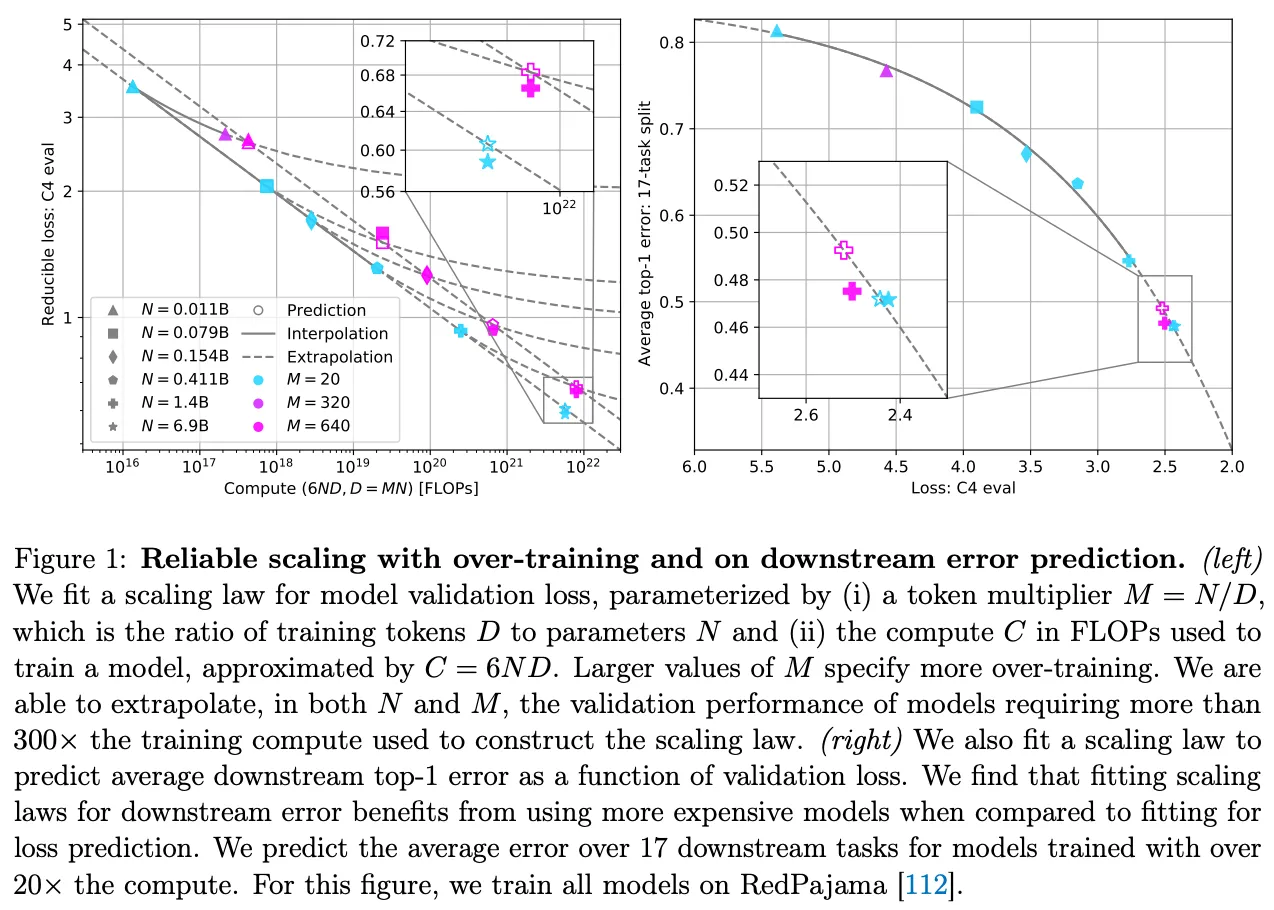

数据消亡。为了扩大 大语言模型 预训练,我们必须同时增加模型和数据集大小。早期的研究 [1] 似乎表明数据的数量不如模型的大小重要,但我们在 Chinchilla [6] 中看到数据集大小同样重要。此外,最近的工作认为,大多数研究人员更喜欢“过度训练”他们的模型——或在大小超出 Chinchilla 最优性的数据集上预训练它们——以节省推理成本 [7]。

“规模化研究通常关注计算最优训练机制……由于较大的模型在推理时更昂贵,因此现在通常的做法是过度训练较小的模型。” - 来源 [7]

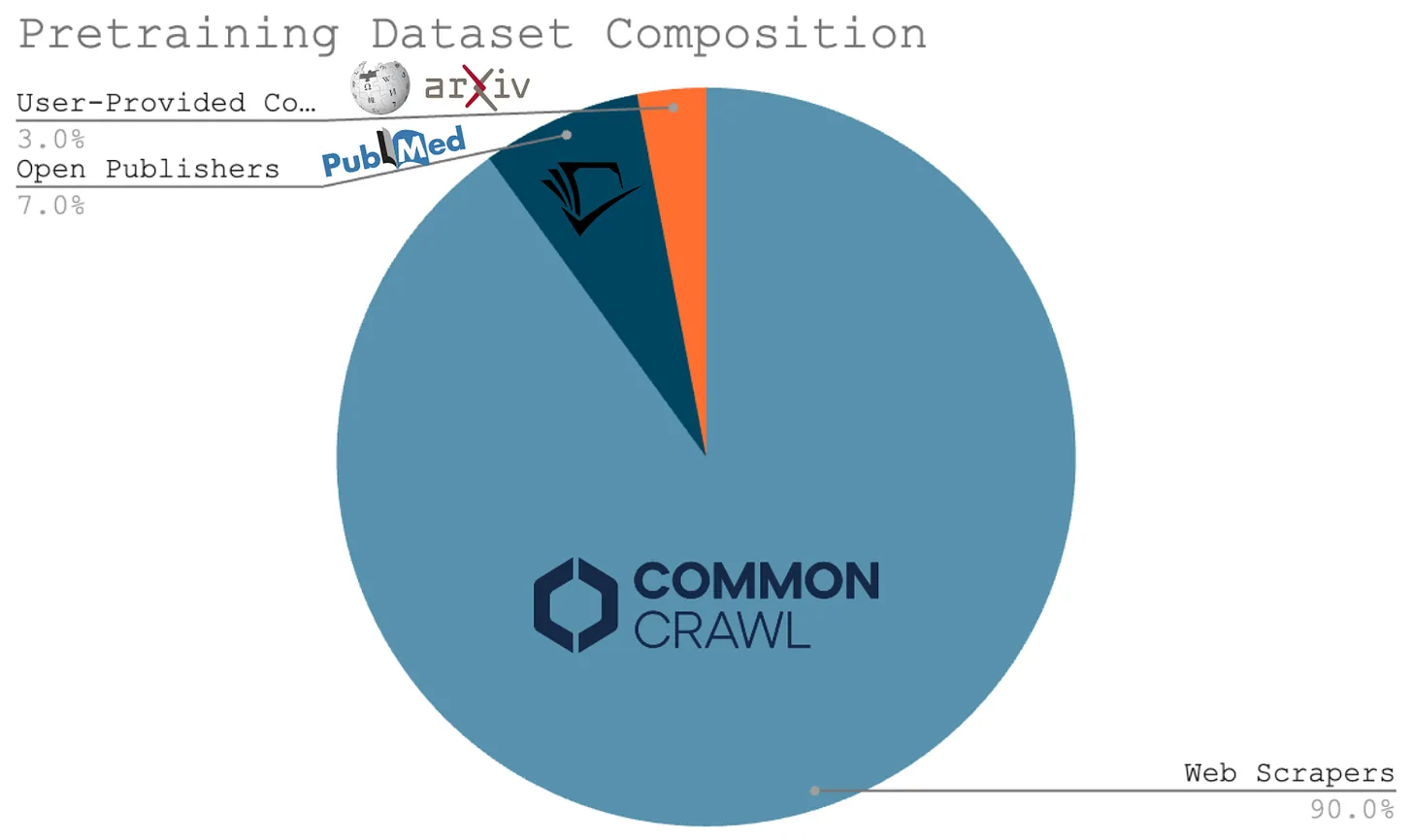

所有这些研究都将我们引向一个简单的结论——扩大 大语言模型 预训练将要求我们创建更大的预训练数据集。这一事实构成了对 大语言模型 规模定律的主要批评之一。许多研究人员认为,可能没有足够的数据来继续扩展预训练过程。作为背景,用于当前 大语言模型 的绝大多数预训练数据是通过网络抓取获得的;见下文。鉴于我们只有一个互联网,找到全新的大规模、高质量预训练数据来源可能很困难。

甚至 Ilya Sutskever 最近也提出了这一论点,声称 i) 计算正在快速增长,但 ii) 由于依赖网络抓取,数据没有增长。因此,他认为我们不能永远继续扩大预训练过程。我们所知的预训练将会结束,我们必须为 AI 研究找到新的进步途径。换句话说,“我们已经达到了数据峰值”。

下一代预训练规模

规模化最终将导致收益递减,并且反对继续规模化的以数据为中心的论点既合理又引人注目。然而,仍然有几个研究方向可以改进预训练过程。

合成数据。为了将预训练过程扩大几个数量级,我们可能需要依赖合成生成的数据。尽管担心过度依赖合成数据会导致多样性问题 [14],但我们看到 大语言模型 越来越多地——并且似乎成功地——使用合成数据 [12]。此外,课程学习 [13] 和持续预训练 策略通过调整预训练数据导致了各种有意义的改进;例如,更改数据混合或在预训练结束时添加指令数据。

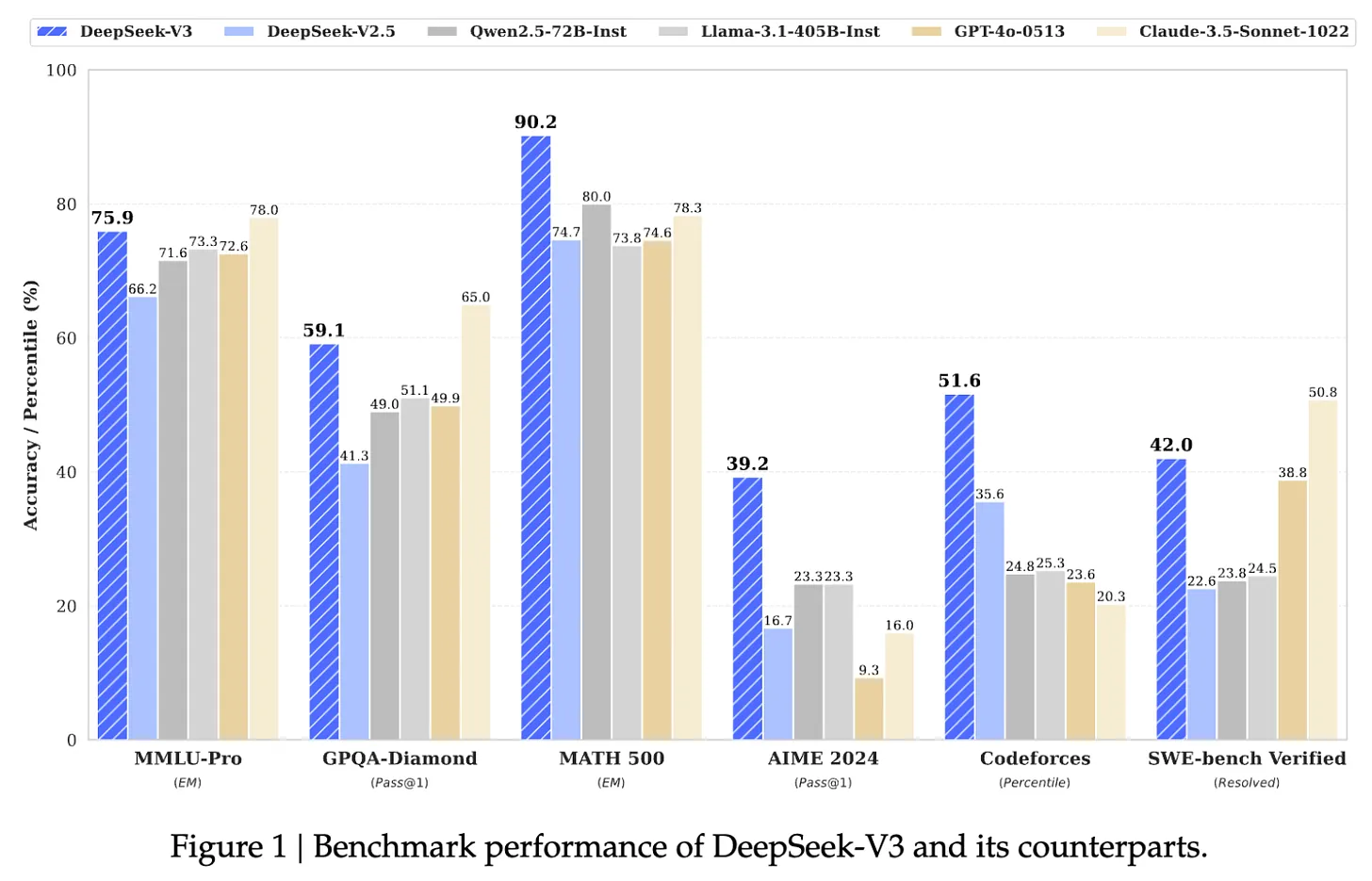

(来源 [7])

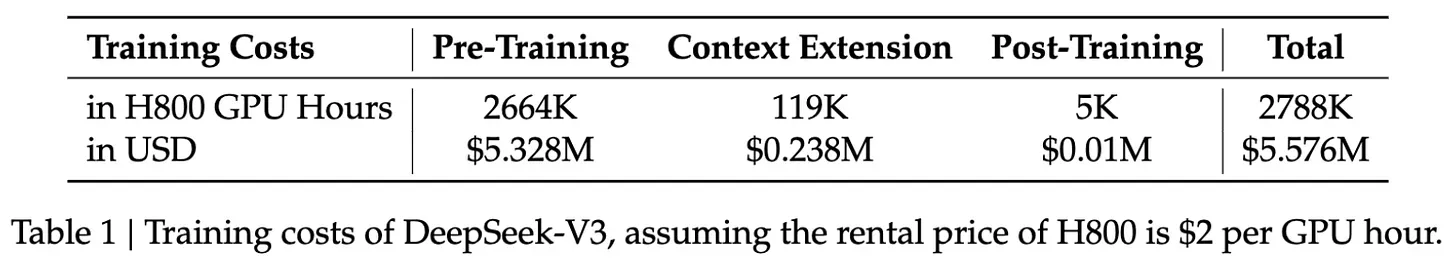

DeepSeek-v3。尽管最近存在争论,但我们仍然看到通过扩展 大语言模型 预训练过程取得半频繁的进步。例如,最近发布了 DeepSeek-v3 [18]——一个 6710 亿参数12 的混合专家 (MoE) 模型。除了开源之外,该模型还在 14.8 万亿个 Token 的文本上进行了预训练,并且性能超过了 GPT-4o 和 Claude-3.5-Sonnet;有关模型的性能,请参见下图,有关许可证,请参见此处。作为参考,LLaMA-3 模型在超过 15 万亿的原始文本数据上进行了训练;有关更多详细信息,请参见此处。

(来源 [18])

- 来自 DeepSeek-v2 的优化 MoE 架构。

- 一种新的无辅助损失策略,用于负载平衡 MoE。

- 多 Token 预测训练目标。

- 从长思维链模型中提炼推理能力 (即,类似于 OpenAI 的 o1)。

该模型还进行了后训练,包括监督微调和来自人类反馈的强化学习,以使其与人类偏好保持一致。

“我们在 14.8 万亿个高质量且多样化的 Token 上训练 DeepSeek-V3。预训练过程非常稳定。在整个训练过程中,我们没有遇到任何不可恢复的损失峰值或必须回滚。” - 来源 [8]

然而,DeepSeek-v3 令人印象深刻的性能的最大关键是预训练规模——这是一个在同样庞大的数据集上训练的大型模型!由于各种原因 (例如,GPU 故障和损失峰值),训练如此大的模型很困难。DeepSeek-v3 具有惊人的稳定预训练过程,并且按照 大语言模型 标准以合理的成本进行训练;见下文。这些结果表明,随着时间的推移,更大规模的预训练作业变得更易于管理和高效。

(来源 [18])

- 更大的计算集群13。

- 更多 (和更好) 的硬件。

- 大量的电力。

- 新算法 (例如,用于更大规模的分布式训练,)。

训练下一代模型不仅仅是为更多 GPU 争取资金的问题,它还是一项多学科的工程壮举。如此复杂的努力需要时间。作为参考,GPT-4 于 2023 年 3 月发布,距离 GPT-3 发布将近三年——特别是 33 个月。可以合理地预期类似的时间表 (如果不是更长的话) 来解锁另一个 10-100 倍的规模增长。

“在每一个数量级的规模增长中,都必须找到不同的创新。” - Ege Erdil (Epoch AI)

AI 研究的未来

现在我们更深入地了解了预训练的规模化状态,让我们假设 (纯粹是为了讨论的目的) 预训练研究将突然碰壁。即使模型能力在不久的将来根本没有提高,AI 研究仍然可以通过多种方式继续快速发展。我们已经讨论过其中的一些主题 (例如,合成数据)。在本节中,我们将重点关注当前流行的两个主题:

- 大语言模型 系统/代理。

- 推理模型。

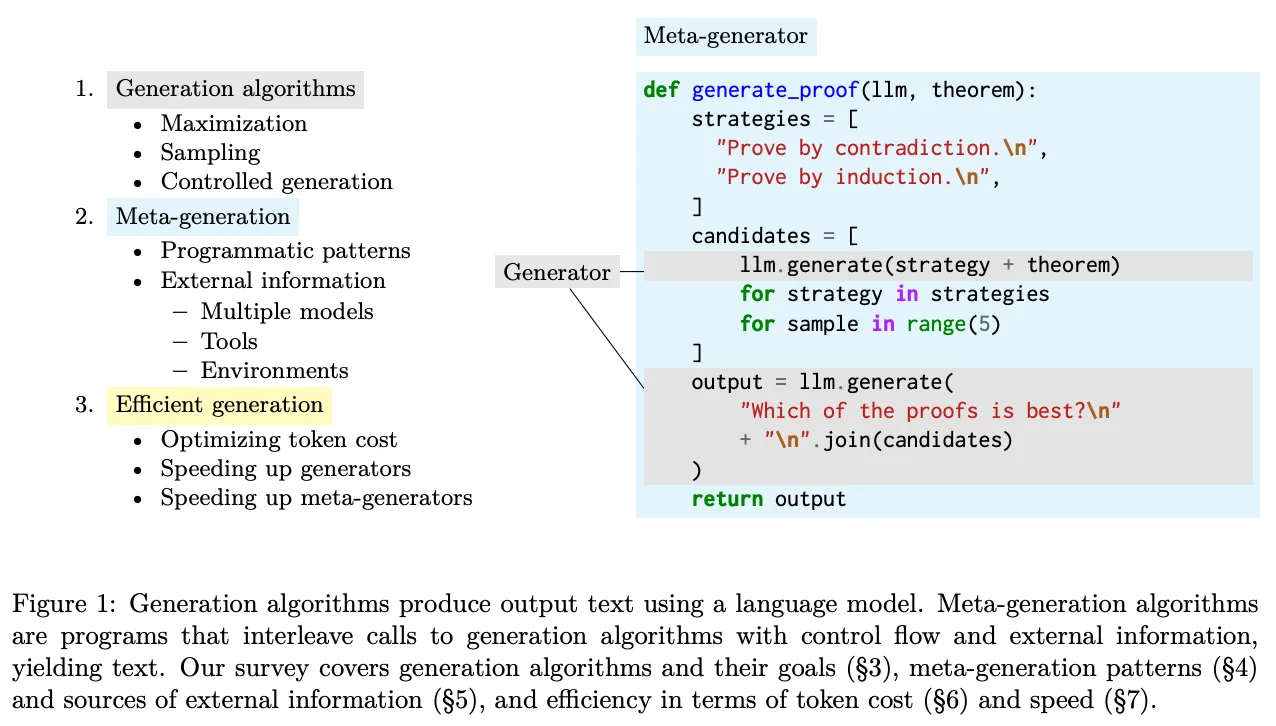

构建有用的 大语言模型 系统

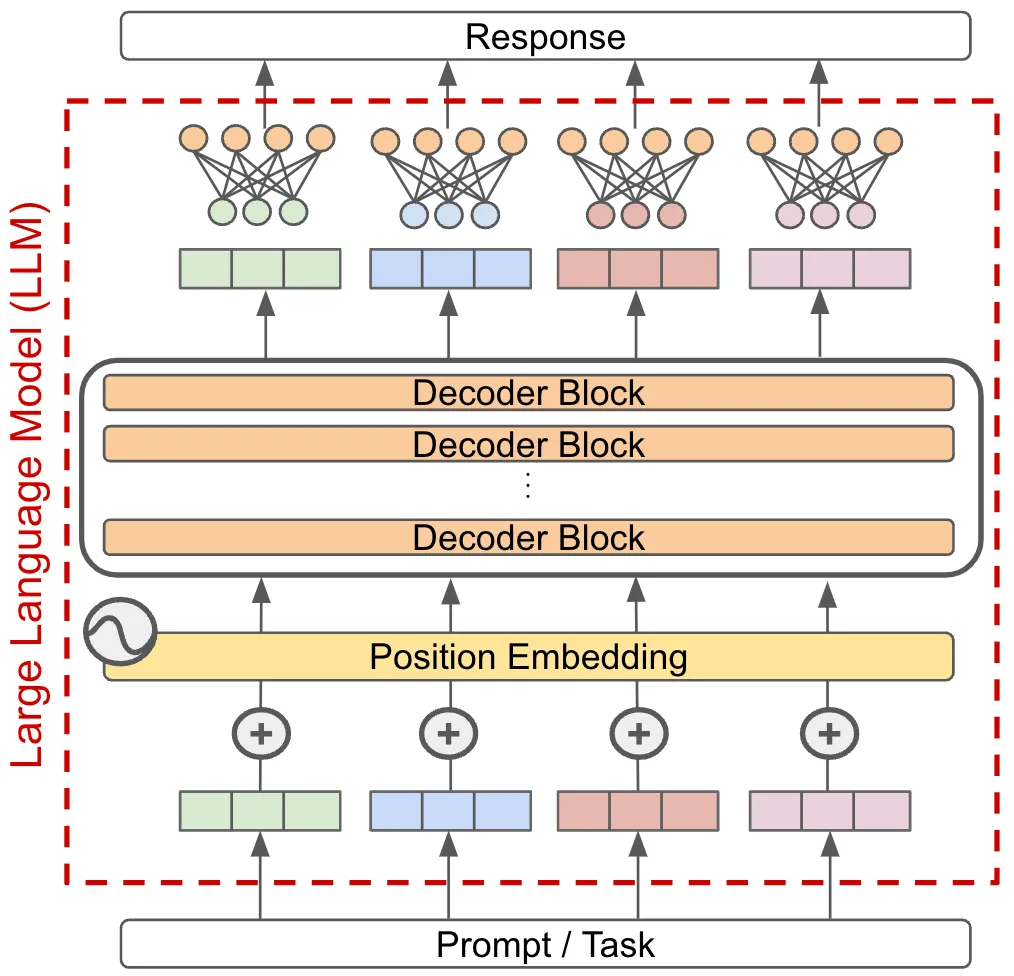

今天大多数基于 大语言模型 的应用程序都以单模型范式运行。换句话说,我们通过将任务传递给单个 大语言模型 并直接使用模型的输出作为该任务的答案来解决任务;见下文。

如果我们想改进这样的系统 (即,以更高的准确性解决更难的任务),我们可以简单地提高底层模型的能力,但这种方法依赖于创建更强大的模型。相反,我们可以通过构建一个基于 大语言模型 的系统来超越单模型范式,该系统结合了多个 大语言模型——或其他组件——来解决复杂的任务。

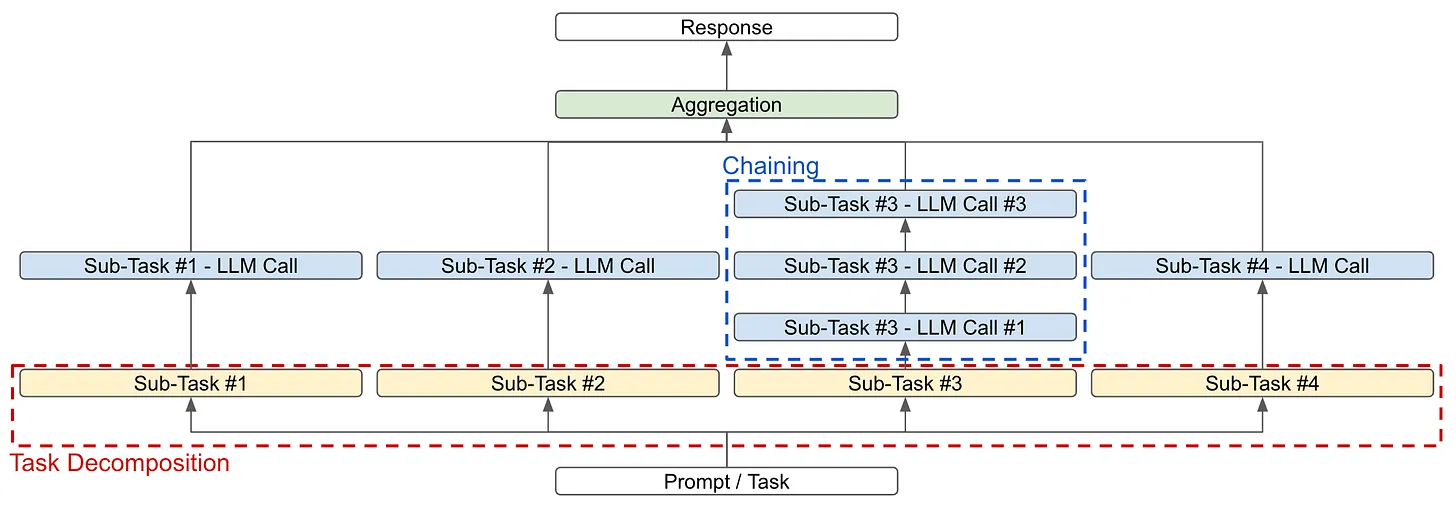

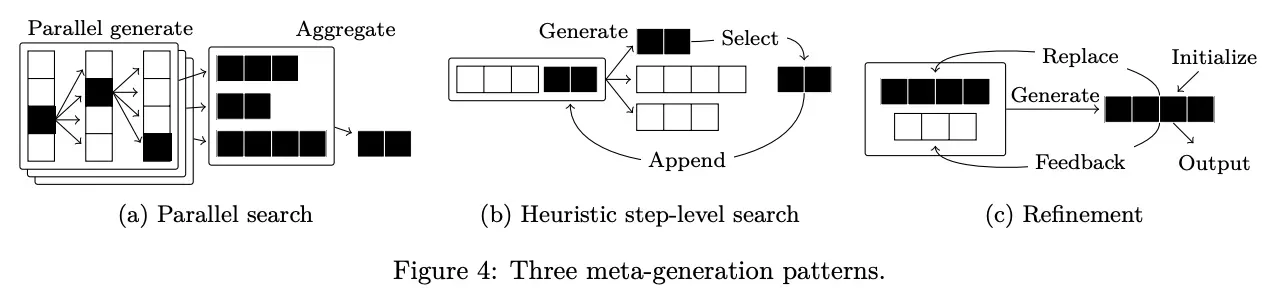

大语言模型 系统基础。 大语言模型 系统的目标是将复杂的任务分解成更小的部分,这些部分更容易被 大语言模型 或其他模块解决。我们可以使用两种主要策略来实现这一目标 (如上图所示):

- 任务分解:将任务本身分解成更小的子任务,这些子任务可以单独解决并在之后聚合14 以形成最终答案。

- 链接:通过对 大语言模型 进行多次顺序调用而不是单次调用来解决任务或子任务。

这些策略可以单独使用或串联使用。例如,假设我们要构建一个总结书籍的系统。为此,我们可以通过首先总结书的每一章来分解任务。从这里,我们可以:

- 将任务进一步分解成更小的文本块进行总结 (即,类似于递归/分层分解)。

- 将多个 大语言模型 调用链接在一起;例如,让一个 大语言模型 提取章节中的所有重要事实或信息,另一个 大语言模型 根据这些关键事实生成章节摘要。

然后,我们可以通过让 大语言模型 总结连接起来的章节摘要来聚合这些结果,从而形成整部小说的摘要。大多数复杂的任务都可以分解成易于解决的简单部分,这使得此类 大语言模型 系统非常强大。随着我们执行更广泛的分解和链接,这些系统可能会变得非常复杂,从而使它们成为应用 AI 研究的一个有趣 (且有影响力的) 领域。

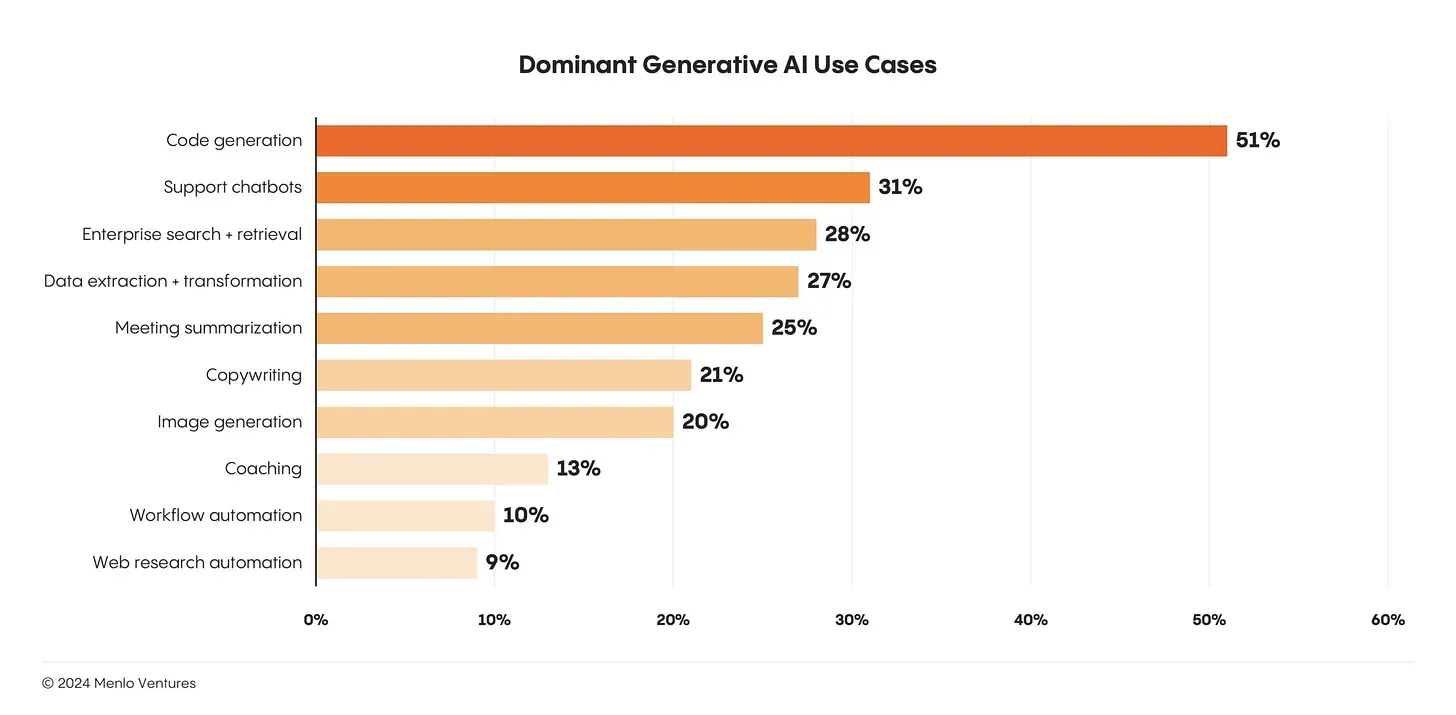

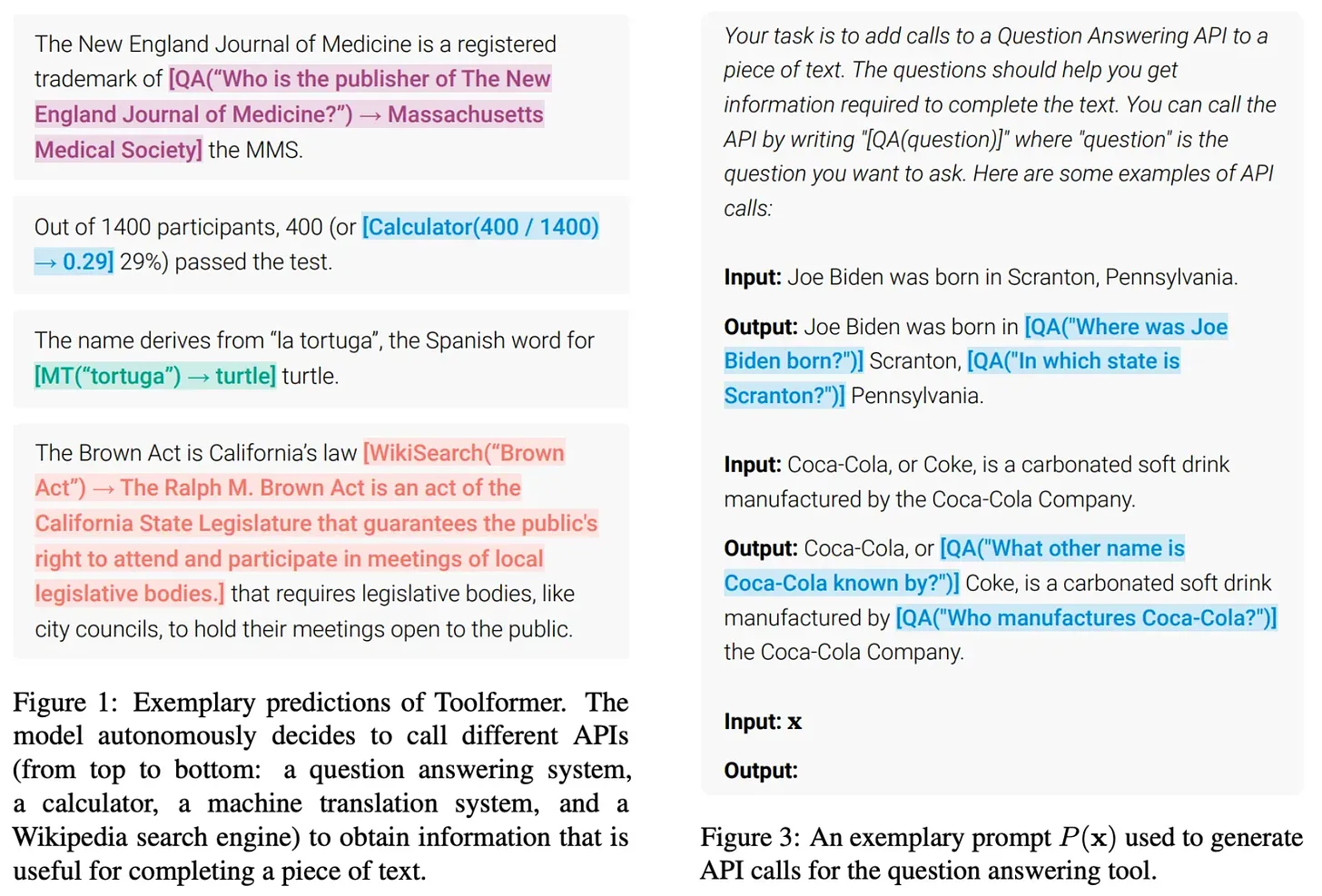

构建基于 大语言模型 的产品。尽管 大语言模型 取得了成功和普及,但 大语言模型 的实际 (和广泛采用的) 用例数量仍然非常少。如今,大语言模型 最大的用例是代码生成和聊天,这两者都是 大语言模型 相对明显的应用15;见下文。

鉴于 大语言模型 的应用领域如此之多,简单地构建更多真正有用的基于 大语言模型 的产品是应用 AI 研究的一个重要领域。我们已经可以使用非常强大的模型,但使用这些模型构建值得使用的产品则是一个完全不同的问题。解决这个问题需要学习如何构建可靠且强大的 大语言模型 系统。

(来源 [19])

鲁棒性是构建更强大的 大语言模型/代理系统的最大障碍之一。假设我们有一个 大语言模型 系统,它对 大语言模型 进行了十次不同的调用。此外,让我们假设每次 大语言模型 调用都有 95% 的成功可能性,并且所有调用都需要成功才能生成正确的最终输出。尽管该系统的各个组件都相当准确,但整个系统的成功率仅为 60%!

(来源 [20])

(来源 [20])

推理模型和新的规模化范式

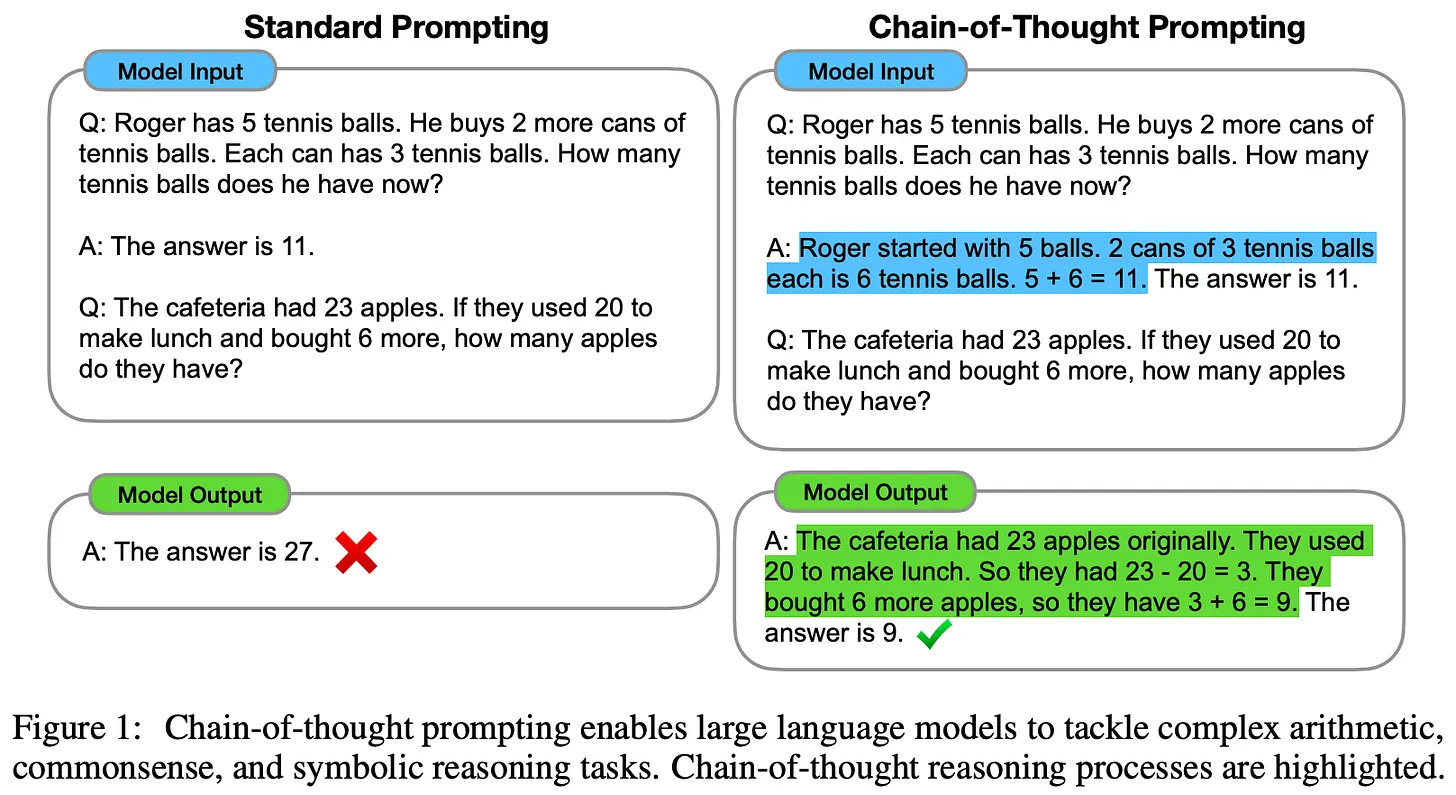

早期 大语言模型 的一个常见批评是它们只是简单地记忆数据,几乎没有推理能力。然而,大语言模型 无法推理的说法在过去几年里基本上被揭穿了。我们从最近的研究中了解到,这些模型可能一直都具有固有的推理能力,但我们必须使用正确的提示或训练方法来引出这种能力。

思维链 (CoT) 提示 [22] 是最早证明 大语言模型 推理能力的技术之一。该方法很简单且基于提示。我们只是要求 大语言模型 在生成实际响应之前为其响应提供解释;有关更多详细信息,请参见此处。当 大语言模型 生成概述用于得出响应的逐步 过程的基本原理时,其推理能力会显着提高。此外,这种解释是人类可读的,并且可以使模型的输出更具可解释性!

(来源 [22])

- 类 大语言模型-法官评估模型通常在生成最终评估结果之前提供评分依据 [23, 24]。

- 已经提出了监督微调和指令调整策略,用于教导较小/开放的 大语言模型 编写更好的思维链 [25, 26]。

- 通常要求 大语言模型 反思并评论或验证它们自己的输出,然后根据这些信息修改它们的输出 [12, 27]。

复杂推理是一个活跃的研究课题,并且正在快速发展。教 大语言模型 将 (步骤级) 验证 [28, 29] 纳入其推理过程的新训练算法已经显示出有希望的结果,并且随着新的和更好的训练策略的出现,我们可能会继续看到改进。

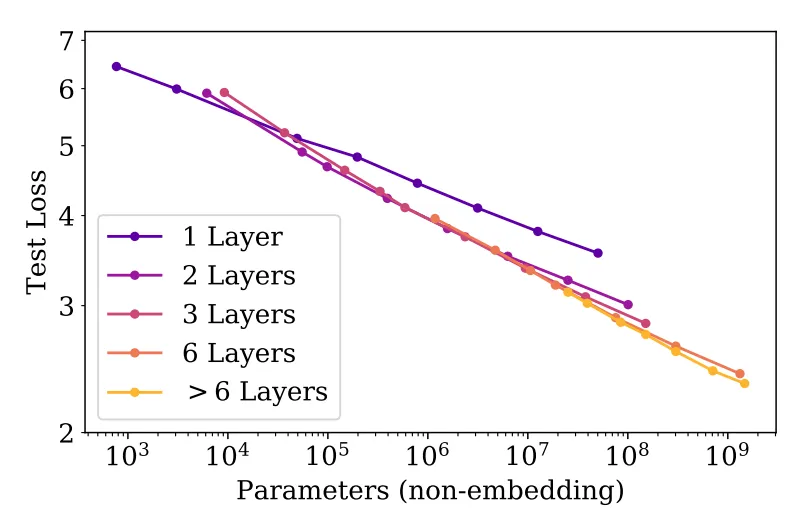

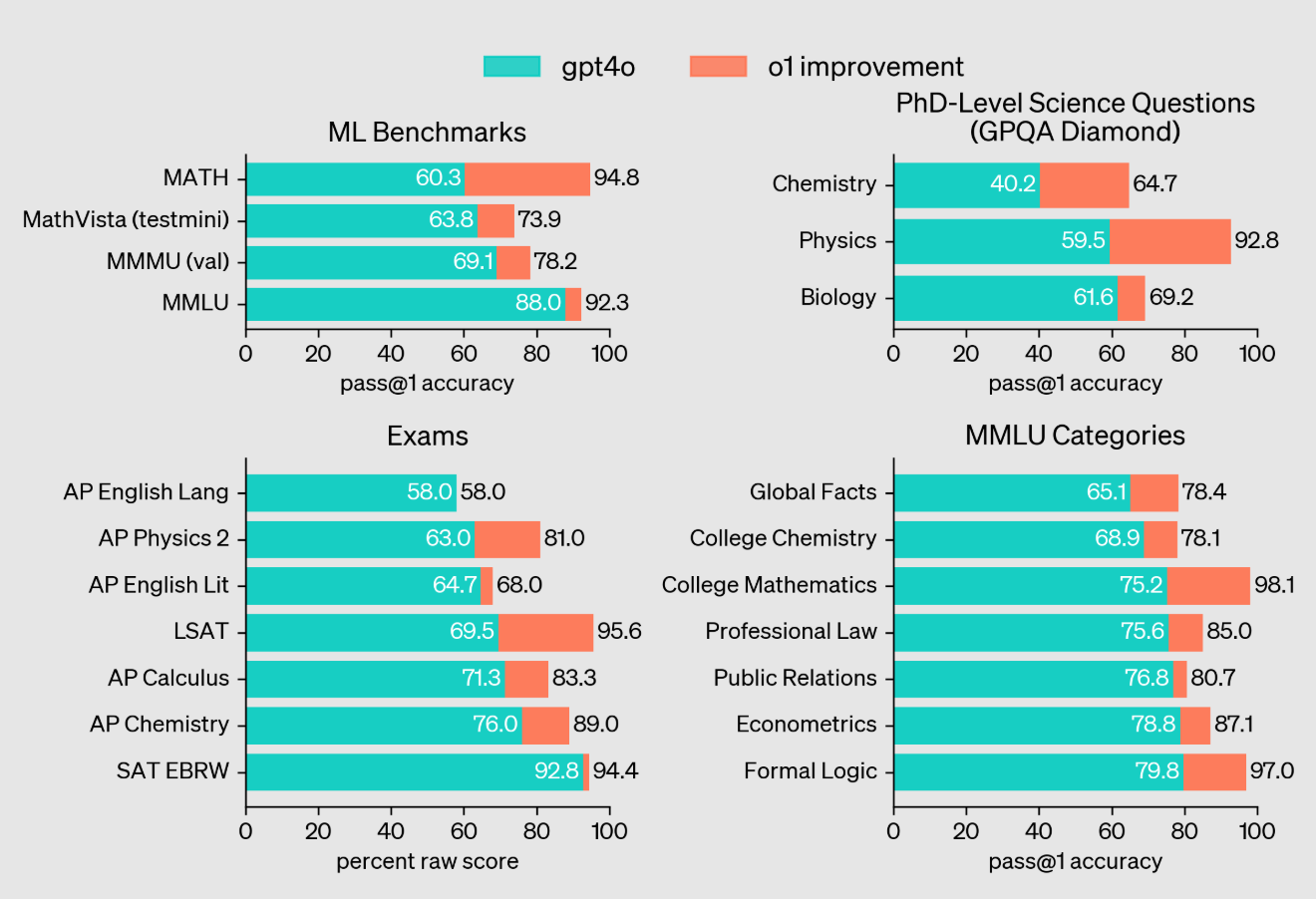

OpenAI 的 o1 推理模型 [21] 标志着 大语言模型 推理能力的重大飞跃。o1 使用的推理策略很大程度上基于思维链。类似于人类在回答问题之前会思考的方式,o1 会花时间“思考”然后才提供响应。实际上,o1 生成的“思维”只是模型用来思考问题、将问题分解成更简单的步骤、尝试各种方法解决问题,甚至纠正自身错误的长思维链16。

“OpenAI o1 [是] 一个新的大型语言模型,使用强化学习进行训练以执行复杂的推理。o1 在回答之前会思考——它可以在响应用户之前生成一个长的内部思维链。” - 来源 [21]

o1 的确切训练策略的细节并未公开分享。然而,我们知道 o1 是使用“大规模强化学习”算法来学习推理的,该算法“非常高效地利用数据”,并且侧重于改进模型生成有用思维链的能力。根据 OpenAI 研究人员的公开评论 和关于 o1 的最新言论,该模型似乎是使用纯强化学习进行训练的,这与早期的观点相矛盾,即 o1 可能在推理时使用某种形式的树搜索。

GPT-4o 和 o1 在推理繁重任务上的比较 (来源 [21])

- 在 Codeforces 的竞争性编程问题中排名前 89%。

- 在美国数学奥林匹克竞赛 (AIME) 的预选赛中进入美国前 500 名学生。

- 在研究生水平的物理、生物和化学问题 (GPQA) 上超过了人类博士生的准确性。

(来源 [22])

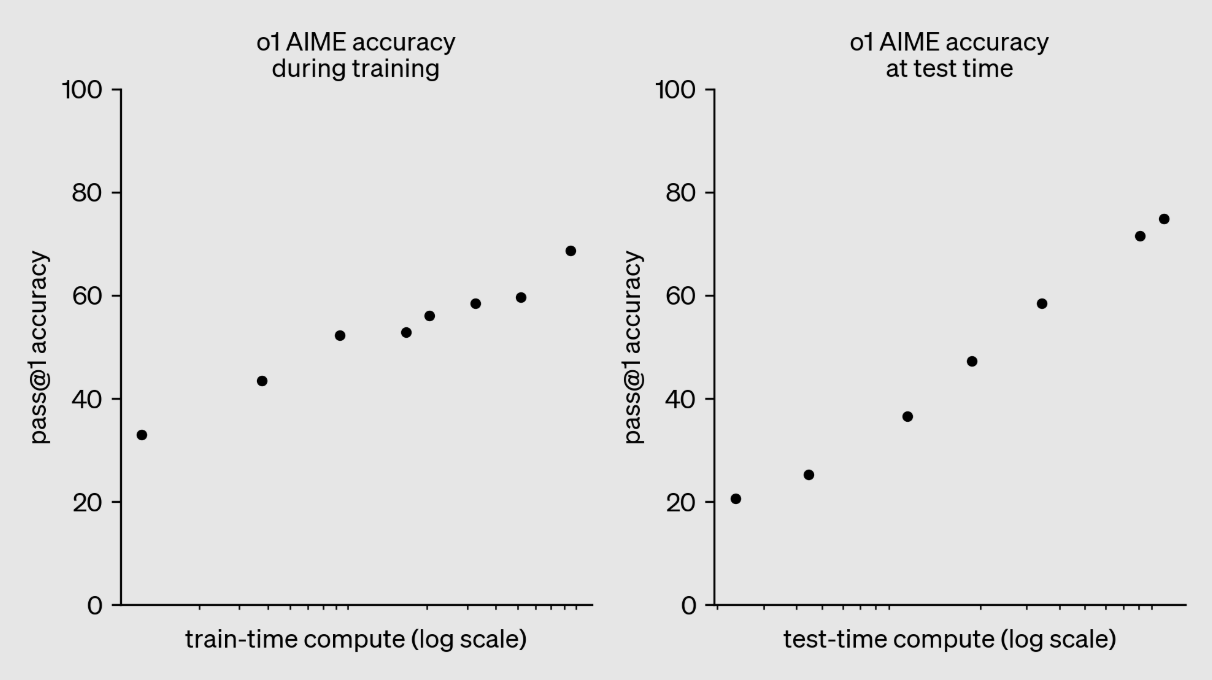

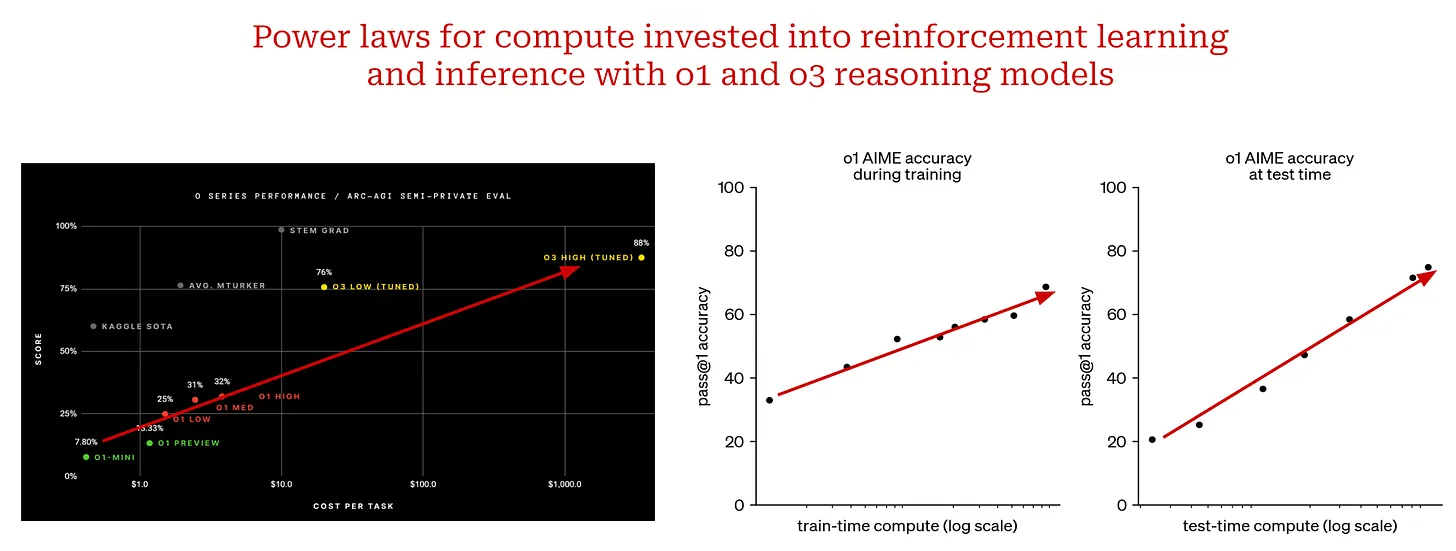

“我们发现,o1 的性能随着更多的强化学习 (训练时计算) 和更多的思考时间 (测试时计算) 而持续提高。” - 来源 [22]

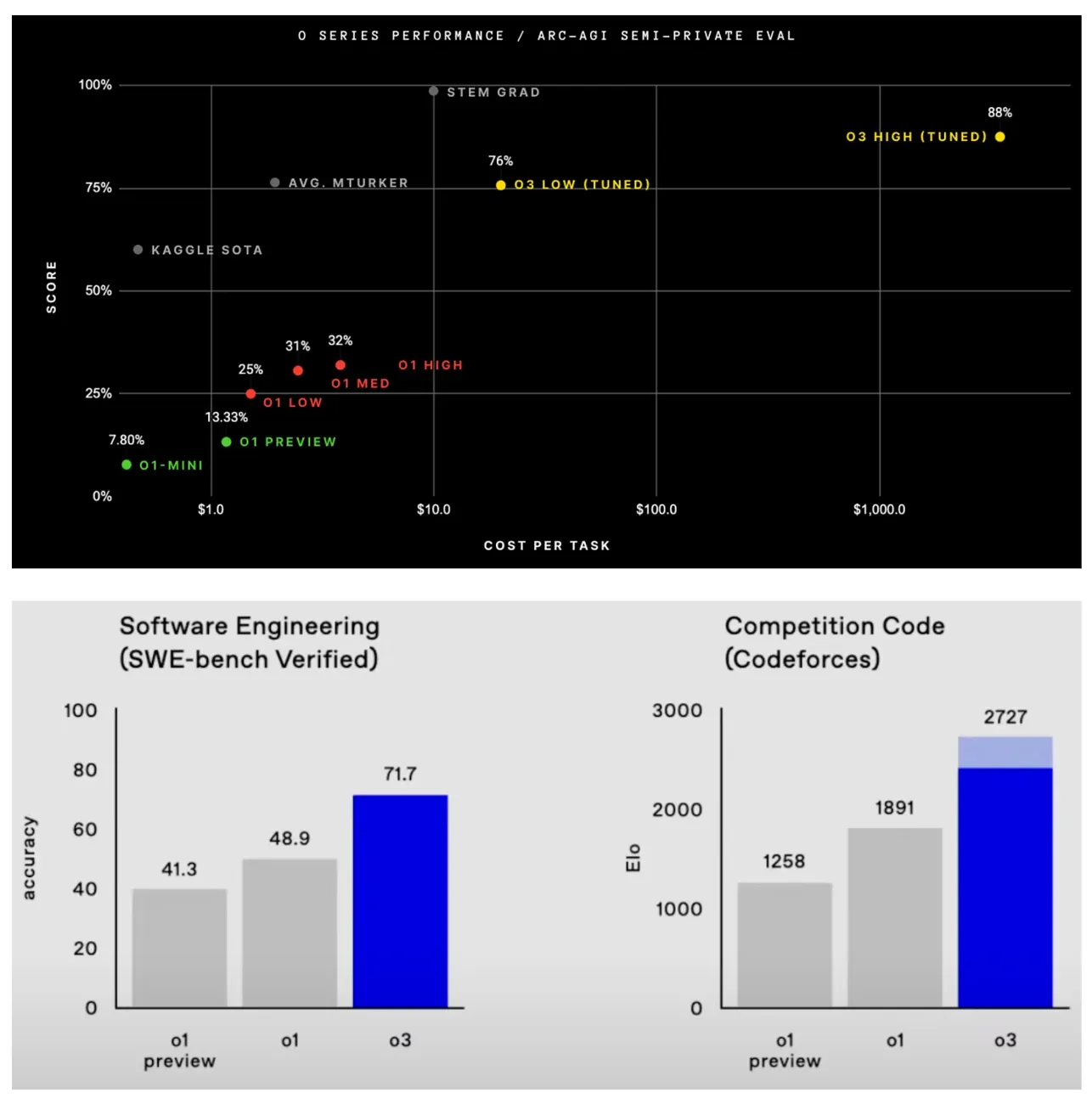

同样,我们在上图中看到,随着我们通过强化学习投入更多计算进行训练,o1 的性能会平稳提高。这正是创建 o3 推理模型所遵循的方法。该模型的评估结果已由 OpenAI 在 2024 年底,并且很少有关于 o3 的详细信息被公开分享。然而,鉴于该模型在 o1 之后如此迅速地发布 (即三个月后),o3 很可能是“扩大规模”的 o1 版本,它在强化学习上投入了更多计算。

在撰写本文时,o3 模型尚未发布,但通过扩展 o1 取得的结果令人印象深刻 (在某些情况下甚至令人震惊)。下面列出了 o3 最显着的成就:

- 在 ARC-AGI 基准测试 上得分为 87.5%,而 GPT-4o 的准确率仅为 5%。o3 是第一个在 ARC-AGI 上超过 85% 的人类水平性能的模型。该基准测试被描述为通往 AGI 的“北极星”,并且在五年多的时间里一直保持不败17。

- 在 SWE-Bench Verified 上的准确率为 71.7%,在 Codeforces 上的 Elo 评分 为 2727,这使得 o3 跻身全球前 200 名人类竞争性程序员之列。

- 在 EpochAI 的 FrontierMath 基准测试 上的准确率为 25.2%,比之前的 2.0% 的最先进准确率有所提高。该基准测试被 Terence Tao 描述为“极其困难”,并且可能“至少几年内”无法被 AI 系统解决。

还预览了 o3 的精简版本,称为 o3-mini,它的性能非常好,并且在计算效率方面有显着提高。

(来源 [21] 和 这里)

- 训练时 (强化学习) 计算。

- 推理时计算。

扩展 o1 风格的模型不同于传统的规模定律。我们不是扩大预训练过程,而是扩大投入到后训练和推理中的计算量。这是一个全新的规模化范式,到目前为止,通过扩展推理模型取得的结果非常好。这样的发现表明,预训练之外的其他扩展途径显然存在。随着推理模型的出现,我们发现了下一个要攀登的山峰。尽管它可能以不同的形式出现,但规模化将继续推动 AI 研究的进步。

结束语

现在我们对规模定律、它们对 大语言模型 的影响以及 AI 研究的未来方向有了更清晰的认识。正如我们所了解的,最近对规模定律的批评有许多促成因素:

- 规模定律的自然衰减。

- 对 大语言模型 能力的期望值差异很大。

- 大规模、跨学科工程工作的延迟。

这些问题都是合理的,但它们都不能表明规模化仍然没有按预期工作。对大规模预训练的投资将 (并且应该) 继续,但随着时间的推移,改进将变得越来越困难。因此,其他发展方向 (例如代理和推理) 将变得更加重要。然而,当我们投资于这些新的研究领域时,规模化的基本思想将继续发挥巨大作用。是否继续规模化不是问题。真正的问题是我们接下来要扩展什么。

参考书目

[1] Kaplan, Jared, et al. "Scaling laws for neural language models." arXiv preprint arXiv:2001.08361 (2020).[2] Radford, Alec. "Improving language understanding by generative pre-training." (2018).[3] Radford, Alec, et al. "Language models are unsupervised multitask learners." OpenAI blog 1.8 (2019): 9.[4] Brown, Tom, et al. "Language models are few-shot learners." Advances in neural information processing systems 33 (2020): 1877-1901.[5] Achiam, Josh, et al. "Gpt-4 technical report." arXiv preprint arXiv:2303.08774 (2023).[6] Hoffmann, Jordan, et al. "Training compute-optimal large language models." arXiv preprint arXiv:2203.15556 (2022).[7] Gadre, Samir Yitzhak, et al. "Language models scale reliably with over-training and on downstream tasks." arXiv preprint arXiv:2403.08540 (2024).[8] Ouyang, Long, et al. "Training language models to follow instructions with human feedback." Advances in neural information processing systems 35 (2022): 27730-27744.[9] Smith, Shaden, et al. "Using deepspeed and megatron to train megatron-turing nlg 530b, a large-scale generative language model." arXiv preprint arXiv:2201.11990 (2022).[10] Rae, Jack W., et al. "Scaling language models: Methods, analysis & insights from training gopher." arXiv preprint arXiv:2112.11446 (2021).[11] Bhagia, Akshita, et al. "Establishing Task Scaling Laws via Compute-Efficient Model Ladders." arXiv preprint arXiv:2412.04403 (2024).[12] Bai, Yuntao, et al. "Constitutional ai: Harmlessness from ai feedback." arXiv preprint arXiv:2212.08073 (2022).[13] Blakeney, Cody, et al. "Does your data spark joy? Performance gains from domain upsampling at the end of training." arXiv preprint arXiv:2406.03476 (2024).[14] Chen, Hao, et al. "On the Diversity of Synthetic Data and its Impact on Training Large Language Models." arXiv preprint arXiv:2410.15226 (2024).[15] Guo, Zishan, et al. "Evaluating large language models: A comprehensive survey." arXiv preprint arXiv:2310.19736 (2023).[16] Xu, Zifei, et al. "Scaling laws for post-training quantized large language models." arXiv preprint arXiv:2410.12119 (2024).[17] Xiong, Yizhe, et al. "Temporal scaling law for large language models." arXiv preprint arXiv:2404.17785 (2024).[18] DeepSeek-AI et al. "DeepSeek-v3 Technical Report." https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf (2024).[19] Schick, Timo, et al. "Toolformer: Language models can teach themselves to use tools." arXiv preprint arXiv:2302.04761 (2023).[20] Welleck, Sean, et al. "From decoding to meta-generation: Inference-time algorithms for large language models." arXiv preprint arXiv:2406.16838 (2024).[21] OpenAI et al. “Learning to Reason with LLMs.” https://openai.com/index/learning-to-reason-with-llms/ (2024).[22] Wei, Jason, et al. "Chain-of-thought prompting elicits reasoning in large language models." Advances in neural information processing systems 35 (2022): 24824-24837.[23] Liu, Yang, et al. "G-eval: Nlg evaluation using gpt-4 with better human alignment." arXiv preprint arXiv:2303.16634 (2023).[24] Kim, Seungone, et al. "Prometheus: Inducing fine-grained evaluation capability in language models." The Twelfth International Conference on Learning Representations . 2023.[25] Ho, Namgyu, Laura Schmid, and Se-Young Yun. "Large language models are reasoning teachers." arXiv preprint arXiv:2212.10071 (2022).[26] Kim, Seungone, et al. "The cot collection: Improving zero-shot and few-shot learning of language models via chain-of-thought fine-tuning." arXiv preprint arXiv:2305.14045 (2023).[27] Weng, Yixuan, et al. "Large language models are better reasoners with self-verification." arXiv preprint arXiv:2212.09561 (2022).[28] Lightman, Hunter, et al. "Let's verify step by step." arXiv preprint arXiv:2305.20050 (2023).[29] Zhang, Lunjun, et al. "Generative verifiers: Reward modeling as next-token prediction." arXiv preprint arXiv:2408.15240 (2024).1这两个主要的报告来自 The Information 和 路透社。

2我们使用以下设置生成绘图:a = 1,p = 0.5,和 0 < x < 1。

3计算在 [1] 中定义为 6NBS,其中 N 是模型参数的数量,B 是训练期间使用的批大小,S 是训练步骤的总数。

4这个额外的乘法常数不会改变幂律的行为。要理解为什么会这样,我们必须理解尺度不变性 的定义。因为幂律是尺度不变的,所以即使我们按某个因子放大或缩小,幂律的基本特征也是相同的。观察到的行为在任何尺度上都是相同的!

5这个描述来自 Ilya 在 NeurIPS’24 上因这篇论文 获得的时间考验奖。

6虽然现在这似乎很明显,但我们应该记住,当时大多数 NLP 任务 (例如,摘要和问答) 都有专门针对它们的研究领域!这些任务中的每一个都有相关的特定于任务的架构,这些架构专门用于执行该任务,而 GPT 是一个可以跨多个不同任务超越大多数这些架构的单一通用模型。

7这意味着我们只需在 大语言模型 的提示中描述每个任务,并使用相同的模型来解决不同的任务——只有提示在任务之间发生变化。

8这是意料之中的,因为这些模型使用零样本推理,并且根本没有在任何下游任务上进行微调。

9所谓“涌现”能力,我们指的是 大语言模型 只有在达到一定规模 (例如,足够大的模型) 后才具备的技能。

10这里,我们将“计算最优”定义为在固定训练计算成本下产生最佳性能 (就测试损失而言) 的训练设置。

11例如,Anthropic 不断推迟发布 Claude 3.5 Opus,谷歌只发布了 Gemini-2 的 flash 版本,而 OpenAI 在 2024 年只发布了 GPT-4o (直到 12 月发布 o1 和 o3),可以说它的能力并没有比 GPT-4 强多少。

12在单个 Token 的推理过程中,只有 370 亿个参数处于活动状态。

13例如,xAI 最近在孟菲斯建立了一个拥有 100,000 个 NVIDIA GPU 的新数据中心,而 Anthropic 的领导层在未来几年内将其计算支出增加 100 倍。

14聚合步骤可以通过多种方式实现。例如,我们可以手动聚合响应 (例如,通过连接),使用 大语言模型,或者介于两者之间的任何方式!

15这并不是因为这些任务很简单。代码生成和聊天都很难解决,但它们 (可以说) 是 大语言模型 相当明显的应用。

16OpenAI 选择向 o1 的用户隐藏这些长的思维链。这一选择背后的论点是,这些基本原理提供了对模型思维过程的洞察,可用于调试或监控模型。然而,应该允许模型表达其纯粹的想法,而无需任何对面向用户的模型输出所必需的安全过滤。

17目前,ARC-AGI 在技术上仍然没有被攻克,因为 o3 超过了基准测试的计算要求。然而,该模型在使用较低计算设置的情况下仍然达到了 75.7% 的准确率。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...